Конспект лекций ТВиМС_Соболева

advertisement

МИНИСТЕРСТВО ОБРАЗОВАНИЯ МОСКОВСКОЙ ОБЛАСТИ

ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ

ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ

СРЕДНЕГО ПРОФЕССИОНАЛЬНОГО ОБРАЗОВАНИЯ

МОСКОВСКОЙ ОБЛАСТИ

«КРАСНОГОРСКИЙ ГОСУДАРСТВЕННЫЙ КОЛЛЕДЖ»

КОНСПЕКТ ЛЕКЦИЙ

ПО УЧЕБНОЙ ДИСЦИПЛИНЕ

ЕН.03 ТЕОРИЯ ВЕРОЯТНОСТЕЙ И

МАТЕМАТИЧЕСКАЯ СТАТИТСТИКА

для специальности

230115 Программирование в компьютерных

системах

Красногорск

2013

1

ОДОБРЕНО

на заседании отделения специальности

230115 Программирование в

компьютерных системах

протокол № _____ от «____» ____ 2013 г.

Заведующий отделением, к.п.н.

_____________ Е.С. Трегубова

УТВЕРЖДАЮ

Заместитель директора

по учебной работе, к.т.н.

КГК

_____________ Е.В.Романова

«____» ____ 2013г.

Рассмотрена на заседании

методического совета КГК

протокол №_____ от «____» ____ 2013 г.

____________ к.э.н. Т.П.Дубровская

Разработчик: Соболева Ольга Анатольевна

специальных дисциплин, кандидат технических наук

–

преподаватель

2

Введение в дисциплину. Предмет теории вероятностей. Алгебра событий. ........................ 4

Случайные события. .................................................................................................................... 4

Алгебра событий.......................................................................................................................... 4

Классическое определение вероятности. .................................................................................. 7

Относительная частота. Статистическое определение вероятности. ..................................... 8

Основные формулы комбинаторики.......................................................................................... 9

Геометрические вероятности. .................................................................................................. 10

Теорема сложения вероятностей.............................................................................................. 11

Теорема умножения вероятностей. .......................................................................................... 13

Вероятность появления хотя бы одного события................................................................... 15

Формула полной вероятности и формула Байеса. .................................................................. 15

Формула Байеса (теорема гипотез). ......................................................................................... 16

Схема повторения испытаний. Формула Бернулли. .............................................................. 17

Приближение Пуассона для схемы Бернулли. ....................................................................... 17

Случайные величины. Математические операции над случайными величинами .............. 18

Закон распределения и функция распределения дискретной случайной величины. .......... 19

Дискретные случайные величины. .......................................................................................... 19

Функция распределения. ........................................................................................................... 20

Распределение Пуассона. .......................................................................................................... 23

Функция распределения и плотность распределения непрерывной случайной величины,

их взаимосвязь и свойства. ....................................................................................................... 23

Равномерный закон распределения. ........................................................................................ 25

Нормальный закон распределения вероятностей. .................................................................. 26

Показательное распределение .................................................................................................. 28

Функция надежности. ............................................................................................................... 28

Показательный закон надежности. .......................................................................................... 29

Моделирование случайных величин ....................................................................................... 29

Оценка математического ожидания ........................................................................................ 31

Оценка дисперсии...................................................................................................................... 32

Интервальные оценки ............................................................................................................... 34

Интервальная оценка математического ожидания при известной дисперсии ................... 39

Интервальная оценка математического ожидания......................................................... 41

при неизвестной диcперсии .............................................................................................. 41

Интервальная оценка дисперсии (среднего квадратичного отклонения) при известном

математическом ожидании ....................................................................................................... 42

Интервальная оценка дисперсии (среднего квадратичного отклонения) при

неизвестном математическом ожидании ........................................................................ 44

Статистическое моделирование ............................................................................................... 46

Метод Монте-Карло .................................................................................................................. 46

Схема использования метода Монте-Карло при исследовании систем со случайными

параметрами ........................................................................................................................... 50

Моделирование случайного события .................................................................................. 52

Моделирование полной группы несовместных событий .................................................. 54

Геометрический алгоритм интегрирования методом Монте-Карло ........................... 56

3

Введение в дисциплину. Предмет теории вероятностей.

Алгебра событий.

В различных разделах науки и техники нередко возникают ситуации, когда

результат каждого из многих проводимых опытов заранее предугадать

невозможно, однако можно исследовать закономерности, возникающие при

проведении серии опытов. Нельзя, например, точно сказать, какая сторона

монеты окажется сверху при данном броске: герб или цифра – но при

большом количестве бросков число выпадений герба приближается к

половине количества бросков; нельзя заранее предсказать результат одного

выстрела из данного орудия по данной цели, но при большом числе

выстрелов частота попадания приближается к некоторому постоянному

числу. Исследование вероятностных закономерностей массовых однородных

явлений составляет предмет теории вероятностей.

Случайные события.

Основным интуитивным понятием классической теории вероятностей

является случайное событие. События, которые могут произойти в

результате опыта, можно подразделить на три вида:

а) достоверное событие – событие, которое всегда происходит при

проведении опыта;

б) невозможное событие – событие, которое в результате опыта произойти

не может;

в) случайное событие – событие, которое может либо произойти, либо не

произойти. Например, при броске игральной кости достоверным событием

является выпадение числа очков, не превышающего 6, невозможным –

выпадение 10 очков, а случайным – выпадение 3 очков.

Алгебра событий.

Суммой А+В двух событий А и В называют событие, состоящее в том, что

произошло хотя бы одно из событий А и В. Суммой нескольких событий,

соответственно, называется событие, заключающееся в том, что произошло

хотя бы одно из этих событий.

Пример 1. Два стрелка делают по одному выстрелу по мишени. Если

событие А – попадание первого стрелка, а событие В – второго, то сумма

А+В – это хотя бы одно попадание при двух выстрелах.

Пример 2. Если при броске игральной кости событием Аi назвать выпадение

i очков, то выпадение нечетного числа очков является суммой событий

А1+А2+А3.

4

Назовем все возможные результаты данного опыта его исходами и

предположим, что множество этих исходов, при которых происходит

событие А (исходов, благоприятных событию А), можно представить в виде

некоторой области на плоскости. Тогда множество исходов, при которых

произойдет событие А+В, является объединением множеств исходов,

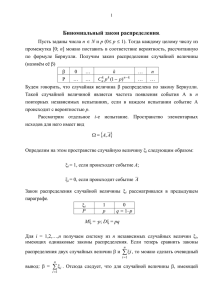

благоприятных событиям А или В (рис. 1).

А

В

А+В

Рис.1.

Произведением АВ событий А и В называется событие, состоящее в том,

что произошло и событие А, и событие В. Аналогично произведением

нескольких событий называется событие, заключающееся в том, что

произошли все эти события.

Пример 3. В примере 1 ( два выстрела по мишени) событием АВ будет

попадание обоих стрелков.

Пример 4. Если событие А состоит в том, что из колоды карт извлечена

карта пиковой масти, а событие В – в том, что из колоды вынута дама, то

событием АВ будет извлечение из колоды дамы пик.

Геометрической иллюстрацией множества исходов опыта, благоприятных

появлению произведения событий А и В, является пересечение областей,

соответствующих исходам, благоприятным А и В.

А

В

АВ

Рис.2.

Разностью А\B событий А и В называется событие, состоящее в том, что А

произошло, а В – нет.

5

Пример 5. Вернемся к примеру 1, где А\ В – попадание первого стрелка при

промахе второго.

Пример 6. В примере 4 А\В – извлечение из колоды любой карты пиковой

масти, кроме дамы. Наоборот, В \А – извлечение дамы любой масти, кроме

пик.

А

В

А-В

Рис.3.

Введем еще несколько категорий событий.

События А и В называются совместными, если они могут произойти оба в

результате одного опыта. В противном случае (то есть если они не могут

произойти одновременно) события называются несовместными.

Примеры: совместными событиями являются попадания двух стрелков в

примере 1 и появление карты пиковой масти и дамы в примере 4;

несовместными – события А1 – А6 в примере 2.

Замечание 1. Если изобразить графически области исходов опыта,

благоприятных несовместным событиям, то они не будут иметь общих

точек.

Замечание 2. Из определения несовместных событий следует, что их

произведение является невозможным событием.

Говорят, что события А1, А2,…,Ап образуют полную группу, если в

результате опыта обязательно произойдет хотя бы одно из событий этой

группы.

Замечание. В частности, если события, образующие полную группу, попарно

несовместны, то в результате опыта произойдет одно и только одно из них.

Такие события называют элементарными событиями.

Пример. В примере 2 события А1 – А6 (выпадение одного, двух,…, шести

очков при одном броске игральной кости) образуют полную группу

несовместных событий.

События называются равновозможными, если нет оснований считать, что

одно из них является более возможным, чем другое.

6

Примеры: выпадение любого числа очков при броске игральной кости,

появление любой карты при случайном извлечении из колоды, выпадение

герба или цифры при броске монеты и т.п.

Классическое определение вероятности.

При изучении случайных событий возникает необходимость количественно

сравнивать возможность их появления в результате опыта. Например, при

последовательном извлечении из колоды пяти карт более возможна

ситуация, когда появились карты разных мастей, чем появление пяти карт

одной масти; при десяти бросках монеты более возможно чередование

гербов и цифр, нежели выпадение подряд десяти гербов, и т.д. Поэтому с

каждым таким событием связывают по определенному правилу некоторое

число, которое тем больше, чем более возможно событие. Это число

называется вероятностью события и является вторым основным понятием

теории вероятностей.

Отметим, что само понятие вероятности, как и понятие случайного события,

является аксиоматическим и поэтому не поддается строгому определению.

То, что в дальнейшем будет называться различными определениями

вероятности, представляет собой способы вычисления этой величины.

Если все события, которые могут произойти в результате данного опыта,

а) попарно несовместны;

б) равновозможны;

в) образуют полную группу,

то говорят, что имеет место схема случаев.

Можно считать, что случаи представляют собой все множество исходов

опыта. Пусть их число равно п ( число возможных исходов), а при т из них

происходит некоторое событие А (число благоприятных исходов).

Вероятностью события А называется отношение числа исходов опыта,

благоприятных этому событию, к числу возможных исходов:

р ( А)

т

п

-

(1.1)

- классическое определение вероятности.

Свойства вероятности.

Из определения 1.8 вытекают следующие свойства вероятности:

Свойство 1. Вероятность достоверного события равна единице.

7

Доказательство. Так как достоверное событие всегда происходит в

результате опыта, то все исходы этого опыта являются для него

благоприятными, то есть т = п, следовательно, Р(А) = 1.

Свойство 2. Вероятность невозможного события равна нулю.

Доказательство. Для невозможного события ни один исход опыта не

является благоприятным, поэтому т = 0 и р(А) = 0.

Свойство 3. Вероятность случайного события есть положительное число,

заключенное между нулем и единицей.

Доказательство. Случайное событие происходит при некоторых исходах

опыта, но не при всех, следовательно, 0 < m < n, и из (1.1) следует, что 0 <

p(A) < 1.

Пример. Из урны, содержащей 6 белых и 4 черных шара, наудачу вынут

шар. Найти вероятность того, что он белый.

Решение. Будем считать элементарными событиями, или исходами опыта,

извлечение из урны каждого из имеющихся в ней шаров. Очевидно, что эти

события удовлетворяют всем условиям, позволяющим считать их схемой

случаев. Следовательно, число возможных исходов равно 10, а число

исходов, благоприятных событию А (появлению белого шара) – 6 (таково

количество белых шаров в урне). Значит,

р ( А)

т 6

0,6.

п 10

Относительная частота. Статистическое определение

вероятности.

Классическое определение вероятности применимо только для очень узкого

класса задач, где все возможные исходы опыта можно свести к схеме

случаев. В большинстве реальных задач эта схема неприменима. В таких

ситуациях требуется определять вероятность события иным образом. Для

этого введем вначале понятие относительной частоты W(A) события A как

отношения числа опытов, в которых наблюдалось событие А, к общему

количеству проведенных испытаний:

W ( A)

M

,

N

(1.2)

где N – общее число опытов, М – число появлений события А.

Большое количество экспериментов показало, что если опыты проводятся в

одинаковых условиях, то для большого количества испытаний

относительная частота изменяется мало, колеблясь около некоторого

постоянного числа. Это число можно считать вероятностью

рассматриваемого события.

8

Статистической вероятностью события считают его относительную

частоту или число, близкое к ней.

Замечание 1. Из формулы (1.2) следует, что свойства вероятности,

доказанные для ее классического определения, справедливы и для

статистического определения вероятности.

Замечание 2. Для существования статистической вероятности события А

требуется:

1) возможность производить неограниченное число испытаний;

2) устойчивость относительных частот появления А в различных сериях

достаточно большого числа опытов.

Замечание 3. Недостатком статистического определения является

неоднозначность статистической вероятности.

Пример. Если в задаче задается вероятность попадания в мишень для

данного стрелка (скажем, р = 0,7), то эта величина получена в результате

изучения статистики большого количества серий выстрелов, в которых этот

стрелок попадал в мишень около семидесяти раз из каждой сотни выстрелов.

Основные формулы комбинаторики.

При вычислении вероятностей часто приходится использовать некоторые

формулы комбинаторики – науки, изучающей комбинации, которые можно

составить по определенным правилам из элементов некоторого конечного

множества. Определим основные такие комбинации.

Перестановки – это комбинации, составленные из всех п элементов данного

множества и отличающиеся только порядком их расположения. Число всех

возможных перестановок

Рп = п!

(1.3)

Пример. Сколько различных списков (отличающихся порядком фамилий)

можно составить из 7 различных фамилий?

Решение. Р7 = 7! = 2·3·4·5·6·7 = 5040.

Размещения – комбинации из т элементов множества, содержащего п

различных элементов, отличающиеся либо составом элементов, либо их

порядком. Число всех возможных размещений

Апт п(п 1)( п 2)...( п т 1).

(1.4)

Пример. Сколько возможно различных вариантов пьедестала почета (первое,

второе, третье места), если в соревнованиях принимают участие 10 человек?

Решение. А103 10 9 8 720.

9

Сочетания – неупорядоченные наборы из т элементов множества,

содержащего п различных элементов (то есть наборы, отличающиеся только

составом элементов). Число сочетаний

С пт

п!

.

т!(п т)!

(1.5)

Пример. В отборочных соревнованиях принимают участие 10 человек, из

которых в финал выходят трое. Сколько может быть различных троек

финалистов?

Решение. В отличие от предыдущего примера, здесь не важен порядок

финалистов, следовательно, ищем число сочетаний из 10 по 3:

С103

10! 8 9 10

120.

3!7!

6

Геометрические вероятности.

Одним из недостатков классического определения вероятности является

то, что оно неприменимо к испытаниям с бесконечным количеством

исходов. В таких случаях можно воспользоваться понятием геометрической

вероятности.

Пусть на отрезок L наудачу брошена точка. Это означает, что точка

обязательно попадет на отрезок L и с равной возможностью может совпасть

с любой точкой этого отрезка. При этом вероятность попадания точки на

любую часть отрезка L не зависит от расположения этой части на отрезке и

пропорциональна его длине. Тогда вероятность того, что брошенная точка

попадет на отрезок l, являющийся частью отрезка L, вычисляется по

формуле:

p

l

,

L

(2.1)

где l – длина отрезка l, а L – длина отрезка L.

Можно дать аналогичную постановку задачи для точки, брошенной на

плоскую область S и вероятности того, что она попадет на часть этой

области s:

p

s

,

S

(2.1`)

где s – площадь части области, а S – площадь всей области.

В трехмерном случае вероятность того, что точка, случайным образом

расположенная в теле V, попадет в его часть v, задается формулой:

p

v

,

V

(2.1``)

где v – объем части тела, а V – объем всего тела.

Пример 1. Найти вероятность того, что точка, наудачу брошенная в круг, не

попадет в правильный шестиугольник, вписанный в него.

10

Решение. Пусть радиус круга равен R , тогда сторона шестиугольника тоже

равна R. При этом площадь круга S R 2 , а площадь шестиугольника

s

3 3 2

R . Следовательно,

2

p

S s

S

3 3 2

R

3 3

2

0,174.

2

2

R

R 2

Пример 2. На отрезок АВ случайным образом брошены три точки: С, D и М.

Найти вероятность того, что из отрезков АС, АD и АМ можно построить

треугольник.

Решение. Обозначим длины отрезков АС, АD и АМ через x, y и z и

рассмотрим в качестве возможных исходов множество точек трехмерного

пространства с координатами (х, у, z). Если принять длину отрезка равной 1,

то эти множество возможных исходов представляет собой куб с ребром,

равным 1. Тогда множество благоприятных исходов состоит из точек, для

координат которых выполнены неравенства треугольника: x + y > z, x + z >

y,

y + z > x. Это часть куба, отрезанная от него плоскостями x + y = z,

x + z = y, y + z = x

х

Рис.1.

(одна из них, плоскость x + y = z, проведена на рис.1). Каждая такая

плоскость отделяет от куба пирамиду, объем которой равен

1 1

1

1 .

3 2

6

Следовательно, объем оставшейся части

v 1 3

1 1

v 1

1

. Тогда p : 1 .

6 2

V 2

2

Теорема сложения вероятностей.

Теорема 2.1 (теорема сложения). Вероятность р(А + В) суммы событий А

и В равна

Р (А + В ) = р (А) + р (В) – р (АВ).

(2.2)

Доказательство.

Докажем теорему сложения для схемы случаев. Пусть п – число возможных

исходов опыта, тА – число исходов, благоприятных событию А, тВ – число

исходов, благоприятных событию В, а тАВ – число исходов опыта, при

которых происходят оба события (то есть исходов, благоприятных

произведению АВ). Тогда число исходов, при которых имеет место событие

11

А + В, равно тА + тВ – тАВ (так как в сумме (тА + тВ) тАВ учтено дважды:

как исходы, благоприятные А, и исходы, благоприятные В). Следовательно,

вероятность суммы можно определить по формуле (1.1):

р ( А В)

т А тВ т АВ т А тВ т АВ

р( А) р( В) р( АВ),

п

п

п

п

что и требовалось доказать.

Следствие 1. Теорему 2.1 можно распространить на случай суммы любого

числа событий. Например, для суммы трех событий А, В и С

Р(А + В + С) = р(А) + р(В) + р(С) – р(АВ) – р(АС) – р(ВС) + р(АВС)

(2.3)

и т.д.

Следствие 2. Если события А и В несовместны, то тАВ = 0, и, следовательно,

вероятность суммы несовместных событий равна сумме их вероятностей:

Р(А + В) = р(А) + р(В).

(2.4)

Противоположными событиями называют два несовместных события,

образующих полную группу. Если одно из них назвать А, то второе принято

обозначать А .

Замечание. Таким образом, А заключается в том, что событие А не

произошло.

Теорема 2.2. Сумма вероятностей противоположных событий равна 1:

р(А) + р( А ) = 1.

(2.5)

Доказательство.

Так как А и А образуют полную группу, то одно из них обязательно

произойдет в результате опыта, то есть событие А + А является

достоверным. Следовательно,

Р( А + А ) = 1. Но, так как А и А несовместны, из (2.4) следует, что Р(А + А ) =

р(А) + р( А ). Значит, р(А) + р( А ) = 1, что и требовалось доказать.

Замечание. В ряде задач проще искать не вероятность заданного события, а

вероятность события, противоположного ему, а затем найти требуемую

вероятность по формуле (2.5).

Пример. Из урны, содержащей 2 белых и 6 черных шаров, случайным

образом извлекаются 5 шаров. Найти вероятность того, что вынуты шары

разных цветов.

Решение. Событие А , противоположное заданному, заключается в том, что

из урны вынуто 5 шаров одного цвета, а так как белых шаров в ней всего

два, то этот цвет может быть только черным. Множество возможных

исходов опыта найдем по формуле (1.5):

п С85

8!

67 8

56,

5!3!

6

12

а множество исходов, благоприятных событию А - это число возможных

наборов по 5 шаров только из шести черных:

т А С65 6.

6

3

3 25

Тогда р ( А ) , а р( А) 1 .

56 28

28 28

Теорема умножения вероятностей.

Назовем условной вероятностью р(В/А) события В вероятность события В

при условии, что событие А произошло.

Замечание. Понятие условной вероятности используется в основном в

случаях, когда осуществление события А изменяет вероятность события В.

Примеры:

1) пусть событие А – извлечение из колоды в 32 карты туза, а событие В –

то, что и вторая вынутая из колоды карта окажется тузом. Тогда, если

после первого раза карта была возвращена в колоду, то вероятность

вынуть вторично туз не меняется: р( В) р( А)

4 1

0,125. Если же

32 8

первая карта в колоду не возвращается, то осуществление события А

приводит к тому, что в колоде осталась 31 карта, из которых только 3

туза. Поэтому р( В / А)

3

0,097.

31

2) если событие А – попадание в самолет противника при первом

выстреле из орудия, а В – при втором, то первое попадание уменьшает

маневренность самолета, поэтому р(В/А) увеличится по сравнению с

р(А).

Теорема 2.3 (теорема умножения). Вероятность произведения двух

событий равна произведению вероятности одного из них на условную

вероятность другого при условии, что первое событие произошло:

р (АВ) = р (А) · р (В/А).

(2.6)

Доказательство.

Воспользуемся обозначениями теоремы 2.1. Тогда для вычисления р(В/А)

множеством возможных исходов нужно считать тА (так как А произошло), а

множеством благоприятных исходов – те, при которых произошли и А, и В (

тАВ ). Следовательно,

р( В / А)

т АВ т АВ п

р( АВ) : р( А), откуда следует утверждение теоремы.

тА

п тА

13

Пример. Для поражения цели необходимо попасть в нее дважды.

Вероятность первого попадания равна 0,2, затем она не меняется при

промахах, но после первого попадания увеличивается вдвое. Найти

вероятность того, что цель будет поражена первыми двумя выстрелами.

Решение. Пусть событие А – попадание при первом выстреле, а событие В –

попадание при втором. Тогда р (А) = 0,2, р (В/А) = 0,4, р (АВ) = 0,2·0,4 = 0,08.

Следствие. Если подобным образом вычислить вероятность события ВА,

совпадающего с событием АВ, то получим, что р (ВА) = р (В) · р (А/В).

Следовательно,

р (А) · р (В/А) = р (В) · р (А/В).

(2.7)

Событие В называется независимым от события А, если появление события

А не изменяет вероятности В, то есть р (В/А) = р (В).

Замечание. Если событие В не зависит от А, то и А не зависит от В.

Действительно, из (2.7) следует при этом, что р (А) · р (В) = р (В) · р (А/В),

откуда р (А/В) = р (А). Значит, свойство независимости событий взаимно.

Теорема умножения для независимых событий имеет вид:

р (АВ) = р (А) · р (В) ,

(2.8)

то есть вероятность произведения независимых событий равна

произведению их вероятностей.

При решении задач теоремы сложения и умножения обычно применяются

вместе.

Пример. Два стрелка делают по одному выстрелу по мишени. Вероятности

их попадания при одном выстреле равны соответственно 0,6 и 0,7. Найти

вероятности следующих событий:

А – хотя бы одно попадание при двух выстрелах;

В – ровно одно попадание при двух выстрелах;

С – два попадания;

D – ни одного попадания.

Решение. Пусть событие Н1 – попадание первого стрелка, Н2 – попадание

второго. Тогда

А = Н1 + Н2, В =Н1 Н 2 Н1 Н 2 , С Н1 Н 2 , D H1 H 2 . События Н1 и Н2

совместны и независимы, поэтому теорема сложения применяется в общем

виде, а теорема умножения – в виде (2.8). Следовательно, р(С) = 0,6·0,7 =

0,42,

р(А) = 0,6 + 0,7 – 0,42 = 0,88,

р(B) = 0,6·0,3 + 0,7·0,4 = 0,46 (так как события Н 1 Н 2 и Н 1 Н 2 несовместны),

р(D) = 0,4·0,3 = 0,12. Заметим, что события А и D являются

противоположными, поэтому

р(А) = 1 – р(D).

14

Вероятность появления хотя бы одного

события.

Теорема 2.4. Вероятность появления хотя бы одного из попарно

независимых событий

А1, А2,…, Ап равна

р (А) = 1 – q1q2…qn ,

(2.9)

где qi – вероятность события Аi , противоположного событию Аi .

Доказательство.

Если событие А заключается в появлении хотя бы одного события из А1,

А2,…, Ап, то события А и А1 А2 ... Ап противоположны, поэтому по теореме 2.2

сумма их вероятностей равна 1. Кроме того, поскольку А1, А2,…, Ап

независимы, то независимы и А1 , А2 ,..., Ап , следовательно, р( А1 А2 ... Ап ) =

р ( А1 ) р( А2 )... р ( Ап ) q1 q 2 ...q n . Отсюда следует справедливость формулы (2.9).

Пример. Сколько нужно произвести бросков монеты, чтобы с вероятностью

не менее 0,9 выпал хотя бы один герб?

Решение. Вероятность выпадения герба при одном броске равна вероятности

противоположного события (выпадения цифры) и равна 0,5. Тогда

вероятность выпадения хотя бы одного герба при п выстрелах равна 1- (0,5)п

. Тогда из решения неравенства 1- (0,5)п > 0,9

следует, что п > log210 ≥ 4.

Формула полной вероятности и формула Байеса.

Пусть событие А может произойти только совместно с одним из событий Н1,

Н2,…, Нп, образующих полную группу несовместных событий. Тогда

события Н1, Н2,…, Нп называются гипотезами.

Теорема 3.1. Вероятность события А, наступающего совместно с гипотезами

Н1, Н2,…, Нп, равна:

n

р ( А) p ( H i ) p ( A / H i ),

(3.1)

i 1

где p(Hi) – вероятность i- й гипотезы, а p(A/Hi) – вероятность события А при

условии реализации этой гипотезы. Формула (3.1) носит название формулы

полной вероятности.

Доказательство.

Можно считать событие А суммой попарно несовместных событий АН1,

АН2,…, АНп. Тогда из теорем сложения и умножения следует, что

n

р( А) р( АН 1 АН 2 ... АН п ) р( АН 1 ) р( АН 2 ) ... р( АН п ) p( H i ) p( A / H i ),

i 1

что и требовалось доказать.

15

Пример. Имеются три одинаковые урны с шарами. В первой из них 3 белых

и 4 черных шара, во второй – 2 белых и 5 черных, в третьей – 10 черных

шаров. Из случайно выбранной урны наудачу вынут шар. Найти вероятность

того, что он белый.

Решение. Будем считать гипотезами Н1, Н2 и Н3 выбор урны с

соответствующим номером. Так как по условию задачи все гипотезы

1

3

равновозможны, то р( Н 1 ) р( Н 2 ) р( Н 3 ) . Найдем условную вероятность

3

7

2

1 3 1 2 1

5

р( А / Н 2 ) , р( А / Н 3 ) 0. Тогда р ( А) 0

0,238.

7

3 7 3 7 3

21

А при реализации каждой гипотезы: р( А / Н 1 ) ,

Формула Байеса (теорема гипотез).

Пусть известен результат опыта, а именно то, что произошло событие А.

Этот факт может изменить априорные (то есть известные до опыта)

вероятности гипотез. Например, в предыдущем примере извлечение из урны

белого шара говорит о том, что этой урной не могла быть третья, в которой

нет белых шаров, то есть р (Н3/А) = 0. Для переоценки вероятностей гипотез

при известном результате опыта используется формула Байеса:

р ( Н i / A)

p( H i ) p( A / H i )

.

p ( A)

Действительно, из (2.7) получим, что

следует справедливость формулы (3.2).

(3.2)

p( A) p( H i / A) p( H i ) p( A / H i ), откуда

Пример. После двух выстрелов двух стрелков, вероятности попаданий

которых равны 0,6 и 0,7, в мишени оказалась одна пробоина. Найти

вероятность того, что попал первый стрелок.

Решение. Пусть событие А – одно попадание при двух выстрелах, а

гипотезы: Н1 – первый попал, а второй промахнулся, Н2 – первый

промахнулся, а второй попал, Н3 – оба попали, Н4 – оба промахнулись.

Вероятности гипотез: р(Н1) = 0,6·0,3 = 0,18, р(Н2) = 0,4·0,7 = 0,28, р(Н3) =

0,6·0,7 = 0,42, р(Н4) = 0,4·0,3 = 0,12. Тогда

р(А/Н1) = р(А/Н2) = 1,

р(А/Н3) = р(А/Н4) = 0. Следовательно, полная вероятность р(А) = 0,18·1 +

0,28·1 + 0,42·0 + 0,12·0 = 0,46. Применяя формулу Байеса, получим:

р( Н 1 / А)

0,18 1 9

0,391.

0,46

23

16

Схема повторения испытаний. Формула

Бернулли.

Рассмотрим серию из п испытаний, в каждом из которых событие А

появляется с одной и той же вероятностью р, причем результат каждого

испытания не зависит от результатов остальных. Подобная постановка

задачи называется схемой повторения испытаний. Найдем вероятность

того, что в такой серии событие А произойдет ровно к раз (неважно, в какой

последовательности). Интересующее нас событие представляет собой сумму

равновероятных несовместных событий, заключающихся в том, что А

произошло в некоторых к испытаниях и не произошло в остальных п – к

испытаниях. Число таких событий равно числу сочетаний из п по к, то есть

С пк , а вероятность каждого из них: pkqn-k, где q = 1 – p – вероятность того, что

в данном опыте А не произошло. Применяя теорему сложения для

несовместных событий, получим формулу Бернулли:

p n (k ) C nk p k q n k .

(3.3)

Пример. Для получения приза нужно собрать 5 изделий с особым знаком на

этикетке. Найти вероятность того, что придется купить 10 изделий, если

этикетки с этим знаком имеют 5% изделий.

Решение. Из постановки задачи следует, что последнее купленное изделие

имеет особый знак. Следовательно, из предыдущих девяти эти знаки имели 4

изделия.

Найдем

вероятность

этого

по

формуле

Бернулли:

4

4

5

p9 (4) C 9 (0,05) (0,95) 0,0006092. Тогда

р = 0,0006092·0,05 = 0,0000304.

Приближение Пуассона для схемы Бернулли.

Формула Бернулли требует громоздких расчетов при большом количестве

испытаний. Можно получить более удобную для расчетов приближенную

формулу, если при большом числе испытаний вероятность появления А в

одном опыте мала, а произведение пр = λ сохраняет постоянное значение

для разных серий опытов ( то есть среднее число появлений события А в

разных сериях испытаний остается неизменным). Применим формулу

Бернулли:

nk

n(n 1)( n 2)...( n k 1) k

n(n 1)...( n k 1)

p n (k )

p (1 p) n k

1 .

k!

k!

n

n

Найдем предел полученного выражения при n :

n

k

1 2 k 1 n k k

k

k

p n (k )

lim 1 1 1 ...1

1

lim

1

1

e 1.

k! n n n

n n k! n n n

k!

k

Таким образом, формула Пуассона

17

p n (k )

k e

k!

(3.4)

позволяет найти вероятность к появлений события А для массовых (п

велико) и редких (р мало) событий.

Случайные величины. Математические операции над

случайными величинами

Прерывные случайные величины X и Y называются независимыми,

если независимы при любых i и j, события X=xi и Y=yj.

Пусть случайная величина X принимает x1, x2, x3, …, xn с вероятностями

p1, p2, p3 ,…, pn, соответственно, а Y-значения y1, y2, y3, …, ym, с

вероятностями q1, q2, q3, …, qm.

а) Суммой случайных величин X и Y называется новая случайная

величина Z=X+Y, которая принимает все значения вида zij=xi+yj(i=1,2,..n;

j=1,2,...,m) с вероятностями pij, причем pij=P(X=xi; Y=yj)=P(X=xi)*PX=xi(Y=yj).

Если случайные величины X и Y независимые, то pij= pi+ qj.

б) Разностью ( произведением) случайных величин X и Y называется

новая случайная величина Z=X-Y (Z=XY), которая принимает все значения

вида zij=xi-yj (zij=xiyj) с такими же вероятностями, с какими случайная

величина Z=X+Y принимает соответствующие значения, т.е. pij= pi+ qj.

в) Произведением kX случайной величины Х на постоянную величину k

называется новая случайная величина Z=kX, которая с теми же

вероятностями, что и Х, принимает значения, равные произведениям

значений случайной величины Х на k, т.е. =xi2.

г) Квадратом случайной величины Х, т.е. Х2, называется новая

случайная величина Z=X2, которая с теми же вероятностями, что и Х,

принимает значения, равные квадратам значений случайной величины Х, т.е.

zi=xi2.

пример:

Дана случайная величина Х

Х

-2

1

2

18

р

0,5

0,3

0,2

Найти закон распределения случайных величин:

а) Y = 3 X, б) Z = X 2

Закон распределения и функция распределения

дискретной случайной величины.

Наряду с понятием случайного события в теории вероятности используется

и более удобное понятие случайной величины.

Случайной величиной называется величина, принимающая в результате

опыта одно из своих возможных значений, причем заранее неизвестно, какое

именно.

Будем обозначать случайные величины заглавными буквами латинского

алфавита (Х, Y,Z,…), а их возможные значения – соответствующими малыми

буквами (xi, yi,…).

Примеры: число очков, выпавших при броске игральной кости; число

появлений герба при 10 бросках монеты; число выстрелов до первого

попадания в цель; расстояние от центра мишени до пробоины при

попадании.

Можно заметить, что множество возможных значений для перечисленных

случайных величин имеет разный вид: для первых двух величин оно

конечно ( соответственно 6 и 11 значений), для третьей величины множество

значений бесконечно и представляет собой множество натуральных чисел, а

для четвертой – все точки отрезка, длина которого равна радиусу мишени.

Таким образом, для первых трех величин множество значений из отдельных

(дискретных), изолированных друг от друга значений, а для четвертой оно

представляет собой непрерывную область. По этому показателю случайные

величины подразделяются на две группы: дискретные и непрерывные.

Случайная величина называется дискретной, если она принимает

отдельные, изолированные возможные значения с определенными

вероятностями.

Случайная величина называется непрерывной, если множество ее

возможных значений целиком заполняет некоторый конечный или

бесконечный промежуток.

Дискретные случайные величины.

Для задания дискретной случайной величины нужно знать ее возможные

значения и вероятности, с которыми принимаются эти значения.

19

Соответствие между ними называется законом распределения случайной

величины. Он может иметь вид таблицы, формулы или графика.

Таблица, в которой перечислены возможные значения дискретной

случайной величины и соответствующие им вероятности, называется рядом

распределения:

xi

pi

x1

p1

x2

p2

…

…

xn

pn

…

…

Заметим, что событие, заключающееся в том, что случайная величина

примет одно из своих возможных значений, является достоверным, поэтому

n()

p

i 1

i

1.

Пример. . Два стрелка делают по одному выстрелу по мишени. Вероятности

их попадания при одном выстреле равны соответственно 0,6 и 0,7. Составить

ряд распределения случайной величины Х – числа попаданий после двух

выстрелов.

Решение. Очевидно, что Х может принимать три значения: 0, 1 и 2. Их

вероятности найдены в примере, рассмотренном в лекции 3. Следовательно,

ряд распределения имеет вид:

хi 0

1

2

pi 0,12 0,46 0,42

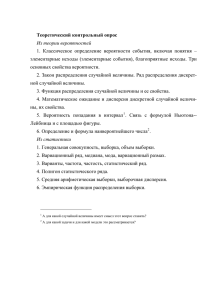

Графически закон распределения дискретной случайной величины можно

представить в виде многоугольника распределения – ломаной,

соединяющей точки плоскости с координатами (xi, pi).

x1 x2 x3 x4

x5

Функция распределения.

. Функцией распределения F(x) случайной величины Х называется

вероятность того, что случайная величина примет значение, меньшее х:

F

(x)

=

p

(X

<

x).

(4.1)

Свойства функции распределения.

20

1) 0

≤

F(x)

≤

1.

Действительно, так как функция распределения представляет собой

вероятность, она может принимать только те значения, которые

принимает вероятность.

2) Функция распределения является неубывающей функцией, то есть

F(x2) ≥ F(x1) при х2 > x1. Это следует из того, что F(x2) = p(X < x2) = p(X

< x1) + p(x1 ≤ X < x2) ≥ F(x1).

3) lim F ( x) 0, lim F ( x) 1. В частности, если все возможные значения Х

x

x

лежат на интервале [a, b], то F(x) = 0 при х ≤ а и F(x) = 1 при х ≥ b.

Действительно, X < a – событие невозможное, а X < b – достоверное.

4) Вероятность того, что случайная величина примет значение из

интервала [a, b], равна разности значений функции распределения на

концах интервала:

p ( a < X < b ) = F(b) – F(a).

Справедливость этого утверждения следует из определения функции

распределения (см. свойство 2).

Для дискретной случайной величины значение F(x) в каждой точке

представляет собой сумму вероятностей тех ее возможных значений,

которые меньше аргумента функции.

Пример. Найдем F(x) для предыдущего примера:

0, x 0

0,12, 0 x 1

F ( x)

0,12 0,46 0,58, 1 x 2

0,58 0,42 1, x 2

Соответственно график функции распределения имеет ступенчатый вид:

Биномиальное распределение.

Вернемся к схеме независимых испытаний и найдем закон распределения

случайной величины Х – числа появлений события А в серии из п

испытаний. Возможные значения А: 0, 1, …, п. Соответствующие им

вероятности можно вычислить по формуле Бернулли:

p( Х k ) C nk p k q n k

(4.2)

( p – вероятность появления А в каждом испытании).

Такой закон распределения называют биномиальным, поскольку правую

часть равенства (4.2) можно рассматривать как общий член разложения

бинома Ньютона:

21

( p q) n C nn p n C nn 1 p n 1 q ... C nk p k q n k ... C n0 q n .

Пример. Составим ряд распределения случайной величины Х – числа

попаданий при 5 выстрелах, если вероятность попадания при одном

выстреле равна 0,8.

р(Х=0) = 1·(0,2)5 = 0,00032; р(Х=1) = 5·0,8·(0,2)4 = 0,0064; р(Х=2) =

10·(0,8)2·(0,2)3 = 0,0512; р(Х=3) = 10·(0,8)3·(0,2)2 = 0,2048; р(Х=4) =

5·(0,8)4·0,2 = 0,4096; р(Х=5) = 1·(0,8)5 = 0,32768. Таким образом, ряд

распределения имеет вид:

х 0

1

2

3

4

5

р 0.00032 0.0064 0.0512 0.2048 0.4096 0.32728

22

Распределение Пуассона.

Рассмотрим дискретную случайную величину Х, принимающую только

целые неотрицательные значения (0, 1, 2,…, т,…), последовательность

которых не ограничена. Такая случайная величина называется

распределенной по закону Пуассона, если вероятность того, что она

примет значение т, выражается формулой:

р( Х т)

а т а

е ,

т!

(4.3)

где а – некоторая положительная величина, называемая параметром

закона Пуассона.

Покажем, что сумма всех вероятностей равна 1:

ат

р( Х т) е т! е

т 0

а

а

еа 1

т 0

(использовано разложение в ряд Тейлора функции ех).

Рассмотрим типичную задачу, приводящую к распределению Пуассона.

Пусть на оси абсцисс случайным образом распределяются точки, причем

их распределение удовлетворяет следующим условиям:

1) вероятность попадания некоторого количества точек на отрезок длины

l зависит только от длины отрезка и не зависит от его расположения на

оси ( то есть точки распределены с одинаковой средней плотностью);

2) точки распределяются независимо друг от друга ( вероятность

попадания какого-либо числа точек на данный отрезок не зависит от

количества точек, попавший на любой другой отрезок);

3) практическая невозможность совпадения двух или более точек.

Тогда случайная величина Х – число точек, попадающих на отрезок длины l

– распределена по закону Пуассона, где а – среднее число точек,

приходящееся на отрезок длины l.

Замечание. В лекции 3 говорилось о том, что формула Пуассона выражает

биномиальное распределение при большом числе опытов и малой

вероятности события. Поэтому закон Пуассона часто называют законом

редких явлений.

Функция распределения и плотность распределения

непрерывной случайной величины, их взаимосвязь и

свойства.

Определение и свойства функции распределения сохраняются и для

непрерывной случайной величины, для которой функцию распределения

можно считать одним из видов задания закона распределения. Но для

непрерывной случайной величины вероятность каждого отдельного ее

значения равна 0. Это следует из свойства 4 функции распределения: р(Х =

23

а) = F(a) – F(a) = 0. Поэтому для такой случайной величины имеет смысл

говорить только о вероятности ее попадания в некоторый интервал.

Вторым способом задания закона распределения непрерывной случайной

величины является так называемая плотность распределения (плотность

вероятности, дифференциальная функция).

Функция f(x), называемая плотностью распределения непрерывной

случайной величины, определяется по формуле:

f (x) = F′(x),

(5.1)

то есть является производной функции распределения.

Свойства плотности распределения.

1) f(x) ≥ 0, так как функция распределения является неубывающей.

x

2) F ( x)

f (t )dt , что следует из определения плотности распределения.

3) Вероятность попадания случайной величины в интервал (а, b)

b

р(а X b) f ( x)dx.

определяется формулой

a

Действительно, р(а X b) F (b) F (a)

b

a

b

a

f ( x)dx f ( x)dx f ( x)dx.

4)

f ( x)dx 1 (условие нормировки). Его справедливость следует из того,

что

f ( x)dx F (),

F ( x ) 1.

а xlim

f ( x) 0, так как F ( x) const при x .

5) xlim

Таким образом, график плотности распределения представляет собой

кривую, расположенную выше оси Ох, причем эта ось является ее

горизонтальной асимптотой при x (последнее справедливо только для

случайных величин, множеством возможных значений которых является все

множество действительных чисел). Площадь криволинейной трапеции,

ограниченной графиком этой функции, равна единице.

Замечание. Если все возможные значения непрерывной случайной величины

сосредоточены на интервале [a, b], то все интегралы вычисляются в этих

пределах, а вне интервала [a, b] f(x) ≡ 0.

Пример 1. Плотность распределения непрерывной случайной величины

задана формулой

f ( x)

C

, x .

1 x2

Найти: а) значение константы С; б) вид функции распределения; в) p(-1 < x

< 1).

Решение. а) значение константы С найдем из свойства 4:

24

С

1 х 2 dx Сarctgx

1

1

C C 1, откуда C .

2 2

x

1

1

б) F ( x)

dt arctg t

2

1 t

1

x

1

1

1

1

arctgx arctgx .

2

2

1

1

в) p(1 x 1)

dx arctgx

2

11 x

1

1

1

0,5.

4 4

Пример 2. Функция распределения непрерывной случайной величины имеет

вид:

0, x 2

x 2

F ( x)

, 2 x4

2

1, x 4.

Найти плотность распределения.

Решение.

0, x 2

0, x 2

x 2

f ( x)

, 2 x 4 0,5, 2 x 4

2

0, x 4.

1, x 4

Равномерный закон распределения.

Часто на практике мы имеем дело со случайными величинами,

распределенными определенным типовым образом, то есть такими, закон

распределения которых имеет некоторую стандартную форму. В прошлой

лекции были рассмотрены примеры таких законов распределения для

дискретных случайных величин (биномиальный и Пуассона). Для

непрерывных случайных величин тоже существуют часто встречающиеся

виды закона распределения, и в качестве первого из них рассмотрим

равномерный закон.

Закон распределения непрерывной случайной величины называется

равномерным, если на интервале, которому принадлежат все возможные

значения случайной величины, плотность распределения сохраняет

постоянное значение ( f(x) = const при a ≤ x ≤ b, f(x) = 0 при x < a, x > b.

Найдем значение, которое принимает f(x) при x [a, b]. Из условия

нормировки следует, что

b

b

f ( x)dx cdx c(b a) 1, откуда

a

a

f ( x) c

1

.

ba

25

Вероятность попадания равномерно распределенной случайной величины на

интервал [ , ] (a b) равна при этом

Вид

функции

распределения

1

b a dx

для

ba

.

нормального

закона:

0, x a

x a

F ( x)

, a xb

b a

1, x b.

Пример. Автобусы некоторого маршрута идут с интервалом 5 минут. Найти

вероятность того, что пришедшему на остановку пассажиру придется

ожидать автобуса не более 2 минут.

Решение. Время ожидания является случайной величиной, равномерно

1

5

распределенной в интервале [0, 5]. Тогда f ( x) , p(0 x 2)

2

0,4.

5

Нормальный закон распределения вероятностей.

Непрерывная случайная величина называется распределенной

нормальному закону, если ее плотность распределения имеет вид:

f ( x)

1

2

e

по

( x a )2

2 2

.

(6.1)

Замечание. Таким образом, нормальное распределение определяется двумя

параметрами: а и σ.

График плотности нормального распределения называют нормальной

кривой (кривой Гаусса). Выясним, какой вид имеет эта кривая, для чего

исследуем функцию (6.1).

1) Область определения этой функции: (-∞, +∞).

2) f(x) > 0 при любом х (следовательно, весь график расположен выше

оси Ох).

3) lim f ( x) 0, то есть ось Ох служит горизонтальной асимптотой графика

| x|

при x .

4) f ( x)

xa

3

2

e

( xa )2

2 2

0 при х = а; f ( x) 0 при x > a, f ( x) 0 при x <

a. Следовательно, a,

- точка максимума.

2

1

5) F(x – a) = f(a – x), то есть график симметричен относительно прямой х

= а.

26

6) f ( x)

1

e

2

3

( xa )2

2 2

( x a) 2

1

2

0

при

x a ,

то есть точки

1

a ,

являются точками перегиба.

2 e

Примерный вид кривой Гаусса изображен на рис.1.

х

Рис.1.

Найдем вид функции распределения для нормального закона:

x

F ( x)

f (t )dt

1

2

x

e

(t a )2

2 2

dt.

(6.2)

Перед нами так называемый «неберущийся» интеграл, который

невозможно выразить через элементарные функции. Поэтому для

вычисления значений F(x) приходится пользоваться таблицами. Они

составлены для случая, когда а = 0, а σ = 1.

Нормальное распределение с параметрами а = 0, σ = 1 называется

нормированным, а его функция распределения

х

1

Ф( х )

2

е

t2

2

dt -

(6.3)

- функцией Лапласа.

Замечание. Функцию распределения для произвольных параметров

можно выразить через функцию Лапласа, если сделать замену: t

xa

,

xa

тогда F ( х)

1

2

е

t2

2

dt .

Найдем вероятность попадания нормально распределенной случайной

величины на заданный интервал:

a

a

p( x ) F ( ) F ( )

.

(6.4)

Пример. Случайная величина Х имеет нормальное распределение с

параметрами а = 3, σ = 2. Найти вероятность того, что она примет

значение из интервала (4, 8).

Решение.

8 3

4 3

p(4 x 8) F (8) F (4)

. (2,5) (0,5) 0,9938 0,6915 0,3023.

2

2

27

Правило «трех сигм».

Найдем вероятность того, что нормально распределенная случайная

величина примет значение из интервала (а - 3σ, а + 3σ):

p(а 3 x а 3 ) 3 3 0,9986 0,0014 0.9973.

Следовательно, вероятность того, что значение случайной величины

окажется вне этого интервала, равна 0,0027, то есть составляет 0,27% и

может считаться пренебрежимо малой. Таким образом, на практике

можно считать, что все возможные значения нормально распределенной

случайной величины лежат в интервале (а - 3σ, а + 3σ).

Полученный результат позволяет сформулировать правило «трех сигм»:

если случайная величина распределена нормально, то модуль ее

отклонения от х = а не превосходит 3σ.

Показательное распределение.

Показательным (экспоненциальным) называют распределение

вероятностей непрерывной случайной величины Х, которое описывается

плотностью

0, x 0

f ( x) x

e , x 0.

(6.5)

В отличие от нормального распределения, показательный закон

определяется только одним параметром λ. В этом его преимущество, так

как обычно параметры распределения заранее не известны и их

приходится оценивать приближенно. Понятно, что оценить один

параметр проще, чем несколько.

Найдем функцию распределения показательного закона:

x

F ( x)

0

x

0

f (t )dt 0 dt e t dt 1 e x . Следовательно,

0, x 0

F ( x)

x

1 e , x 0.

Теперь

можно

найти

вероятность

попадания

распределенной случайной величины в интервал (а, b):

p(a x b) e a e b .

Значения функции е-х можно найти из таблиц.

(6.6)

показательно

(6.7)

Функция надежности.

Пусть элемент (то есть некоторое устройство) начинает работать в

момент времени t0 = 0 и должен проработать в течение периода времени

t. Обозначим за Т непрерывную случайную величину – время безотказной

28

работы элемента, тогда функция

F(t) = p(T > t) определяет

вероятность отказа за время t. Следовательно, вероятность безотказной

работы за это же время равна

R(t) = p(T > t) = 1 – F(t).

(6.8)

Эта функция называется функцией надежности.

Показательный закон надежности.

Часто длительность безотказной работы элемента имеет показательное

распределение, то есть

F(t) = 1 – e-λt .

Следовательно, функция надежности в этом случае имеет вид:

R(t) = 1 – F(t) = 1 – (1 – e-λt) = e-λt .

Показательным законом надежности называют функцию надежности,

определяемую равенством

R(t) = e-λt ,

(6.9)

где λ – интенсивность отказов.

Пример. Пусть время безотказной работы элемента распределено по

показательному закону с плотностью распределения f(t) = 0,1 e-0,1t при t ≥

0. Найти вероятность того, что элемент проработает безотказно в течение

10 часов.

Решение. Так как λ = 0,1, R(10) = e-0,1·10 = e-1 = 0,368.

Моделирование случайных величин

Как известно, моделирование проводится для определения тех или иных

характеристик системы (например, качества системы обнаружения

полезного сигнала в помехах, измерения ее параметров). Так как входные

воздействия представляют собой случайные процессы, то для получения

информации о параметрах системы необходимо провести определенное

количество (как правило, достаточно большое) экспериментов или опытов.

Прежде всего нужно отметить, что любое значение искомого параметра,

вычисленное на основе ограниченного числа экспериментов, всегда будет

содержать элемент случайности. Такое приближенное случайное значение

мы будем называть оценкой параметра. Например, оценкой для

математического ожидания может служить среднее арифметическое

наблюдаемых значений случайной величины в N независимых опытах. При

большом числе опытов среднее арифметическое будет с большой

вероятностью весьма близко к математическому ожиданию. Если же число

29

экспериментов N невелико, то замена математического ожидания средним

арифметическим приводит к ошибке. Эта ошибка в среднем тем больше, чем

меньше число экспериментов. Так же обстоит дело и с оценками других

неизвестных параметров. Любая из таких оценок случайна: при ее

использовании неизбежны ошибки. Желательно выбрать такую оценку,

чтобы эти ошибки были минимальны.

Сформулируем следующую общую задачу. Имеется случайная величина

X, функция распределения вероятности которой содержит неизвестный

параметр a. Требуется найти подходящую оценку для параметра a по

результатам N экспериментов, в каждом из которых величина Х принимает

определенное значение. Полученные значения можно рассматривать как N

независимых случайных величин X1, X2, …, XN, каждая из которых

распределена по тому же закону, что и случайная величина X. Обозначим

через

оценку параметра для параметра а. Любая оценка должна

представлять собой функцию величин X1, X2, …, XN и, следовательно, сама

является случайной величиной. Функция распределения

зависит, вопервых, от функции распределения величины Х, а во-вторых, от количества

экспериментов.

К оценке

, как правило, предъявляется несколько требований.

Естественно потребовать от оценки

, чтобы она при увеличении числа

экспериментов N приближалась (сходилась по вероятности) к параметру а.

Оценка, обладающая таким свойством, называется состоятельной.

Кроме того, желательно, чтобы, пользуясь величиной вместо а, мы не

делали систематической ошибки в сторону завышения или занижения, т.е.

выполнялось условие

M{

} = a,

где M{…} - обозначение математического ожидания.

удовлетворяющая такому условию, называется несмещенной.

Оценка,

Наконец, желательно, чтобы выбранная несмещенная оценка обладала

по сравнению с другими возможными оценками наименьшей дисперсией,

т.е.

D{

} = min.

Оценка, обладающая таким свойством, называется эффективной.

30

Оценка математического ожидания

Пусть имеется случайная величина Х с математическим ожиданием m и

дисперсией D, при этом оба эти параметра неизвестны. Над величиной Х

произведено N независимых экспериментов, в результате которых была

получена совокупность N численных результатов x1, x2, …, xN. В качестве

оценки математического ожидания естественно предложить среднее

арифметическое наблюдаемых значений

(1)

Здесь в качестве xi рассматриваются конкретные значения (числа),

полученные в результате N экспериментов. Если взять другие (независимые

от предыдущих) N экспериментов, то, очевидно, мы получим другое

значение

. Если взять еще N экспериментов, то мы получим еще одно

новое значение

. Обозначим через Xi случайную величину, являющуюся

результатом i-го эксперимента, тогда реализациями Xi будут числа,

полученные в результате этих экспериментов. Очевидно, что случайная

величина Xi будет иметь такую же плотность распределения вероятности,

что и исходная случайная величина Х. Также считаем, что случайные

величины Xi и Xj являются независимыми при i, не равном j (различные

независимые друг относительно друга эксперименты). Поэтому формулу (1)

перепишем в другом (статистическом) виде:

(2)

Покажем, что оценка является несмещенной:

Таким образом, математическое ожидание выборочного среднего

равно истинному математическому ожиданию случайной величины m. Это

достаточно предсказуемый и понятный факт. Следовательно, за оценку

математического ожидания случайной величины можно принять

выборочное среднее (2). Теперь возникает вопрос: что происходит с

дисперсией оценки математического ожидания при увеличении числа

экспериментов? Аналитические вычисления показывают, что

,

31

где

- дисперсия оценки математического ожидания (2), а D - истинная

дисперсия случайной величины X.

Из вышесказанного следует, что с ростом N (количества экспериментов)

дисперсия оценки уменьшается, т.е. чем больше мы суммируем независимые

реализации, тем ближе к математическому ожиданию мы получим оценку.

Оценка дисперсии

На первый взгляд наиболее естественной оценкой представляется

(3)

где

вычисляется по формуле (2). Проверим, является ли оценка

несмещенной. Формула (3) может быть записана следующим образом [1]:

.

Подставим в эту формулу выражение (2):

Найдем математическое ожидание оценки дисперсии:

(4)

Так как дисперсия случайной величины не зависит от того, какое

математическое ожидание у случайной величины, примем математическое

ожидание равным 0, т.е. m = 0.

Тогда

32

(5)

при

.

(6)

Последнее равенство следует из того, что эксперименты независимы, а

математическое ожидание случайной величины в каждом эксперименте

равно 0. Подставляя (5) и (6) в (4), получим:

Отсюда следует, что оценка

не является несмещенной - ее

математическое ожидание равно не D, а несколько меньше. Пользуясь

оценкой

вместо дисперсии D, мы получим систематическую ошибку.

Чтобы ликвидировать это смещение, достаточно ввести поправку, умножив

величину

на (N-1)/N. Такую исправленную статистическую дисперсию

мы и выберем в качестве оценки:

Таким образом, если в результате N экспериментов мы располагаем

набором N значений случайной величины

x1, x2, …, xN,

то для оценок математического ожидания и дисперсии необходимо

воспользоваться следующими формулами:

(7)

33

Интервальные оценки

В п.1 и п.2 мы рассмотрели вопрос об оценке неизвестного параметра a

одним числом. Такая оценка называется точечной. В ряде случаев требуется

не только найти для параметра а подходящее численное значение, но и

оценить его надежность и точность. Требуется знать - к каким ошибкам

может привести замена параметра а его точечной оценкой, и с какой

уверенностью можно ожидать, что ошибки не выйдут за известные пределы.

Чтобы дать представление о точности и надежности оценки

, в

математической статистике пользуются так называемыми доверительными

интервалами и доверительными вероятностями.

Рассмотрим в качестве примера задачу о доверительном интервале при

оценке математического ожидания.

Пусть для параметра а получена из ряда экспериментов несмещенная

оценка

. Мы хотим оценить возможную при этом ошибку. Назначим

некоторую достаточно большую вероятность (например,

), такую,

что событие с вероятностью можно считать практически достоверным, и

найдем такое значение e, для которого

P( |

(8)

-a|<e)=

Тогда диапазон практически наиболее вероятных значений ошибки,

возникающих при замене a на

, по модулю не будет превосходить е.

Большие по абсолютной величине ошибки будут появляться с малой

вероятностью

.

Равенство (8) означает, что с вероятностью

параметра а попадает в интервал

неизвестное значение

.

Необходимо отметить следующее обстоятельство. Ранее мы

рассматривали близость случайной оценки к истинному значению

оцениваемого параметра. Здесь ситуация несколько другая. Величина а не

случайна, зато случаен интервал I. И величину можно трактовать как

вероятность того, что случайный интервал I накроет истинное значение

параметра а. Вероятность называется доверительной вероятностью, I доверительным интервалом, а

34

называются доверительными границами. Перейдем теперь к нахождению

доверительных границ

несмещенная оценка

и

. Пусть для параметра а существует

. Если бы нам была известна функция распределения

случайной величины (или плотность распределения вероятности)

, то

задача нахождения доверительнего интервала была бы весьма проста:

достаточно было бы найти такое значение e, для которого выполняется

условие (8). Затруднение состоит в том, что функция распределения оценки

зависит от функции распределения величины Х и, следовательно, от

самого неизвестного параметра а.

В качестве другого примера рассмотрим задачу о доверительном

интервале для математического ожидания.

Пусть произведено N независимых опытов над случайной величиной Х,

характеристики которой (дисперсия D и математическое ожидание m)

неизвестны. Для этих параметров получены оценки:

,

.

Требуется построить доверительный интервал I, соответствующий

доверительной вероятности для математического ожидания m величины Х.

При решении этой задачи воспользуемся тем, что величина

представляет собой сумму N независимых случайных величин

, и,

согласно центральной предельной теореме, при достаточно большом N ее

закон близок к нормальному. Поэтому будем исходить из того, что величина

распределена по нормальному закону. Характеристики этого закона математическое ожидание и дисперсия - равны соответственно m и D/N.

Найдем такую величину е, для которой

(9)

Для нормальной случайной величины (с нулевым математическим

ожиданием и единичной дисперсией) функция распределения вероятности

С учетом этого формулу (9) запишем в виде:

35

где

Из уравнения

-

среднее

квадратическое

отклонение

оценки.

находим значение е:

(10)

где

- функция, обратная F(…), т.е. такое значение аргумента, при

котором нормальная функция распределения равна х.

Дисперсия D, через которую выражена величина

, нам в точности

неизвестна. В качестве ее ориентировочного значения можно

воспользоваться оценкой

или

и положить приближенно

.

Таким образом, решена задача построения доверительного интервала

где

е

определяется

формулой

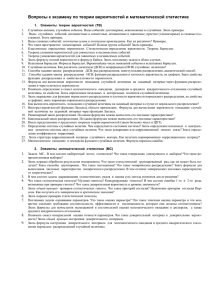

Для удобства в табл. 1 приведены значения величины

0.8

0.81

0.82

0.83

0.84

0.85

t

1.282

1.310

1.340

1.371

1.404

1.439

0.86

0.87

0.88

0.89

0.9

t

1.175

1.513

1.554

1.597

1.643

0.91

0.92

0.93

0.94

0.95

t

1.694

1.750

1.810

1.880

1.960

(10).

.

t

0.97

2.169

0.98

2.325

0.99

2.576

0.9973 3.000

0.999 3.290

Пример. Пусть в результате проведения 30 опытов были получены 30

значений случайной величины Х:

10.5, 10.8, 11.2, 10.9, 10.6, 11.0, 10.8, 11.0, 11.6, 10.9, 10.5, 11.8, 10.2, 9.2, 10.2,

11.2, 10.3, 11.1, 11.8, 10.3, 10.7, 10.8, 11.2, 10.9, 10.1, 11.7, 10.8, 11.3, 11.0,

36

11.9.

Требуется найти оценку

для математического ожидания m величины X и

построить доверительный интервал, соответствующий доверительной

вероятности

.

Вычисляем

= 0.49. Далее

= 10.87 ,

По табл. 1 находим:

= 0.12.

.

Тогда

;

доверительные границы:

доверительный интервал:

I = (10.71; 11.03).

При оценке вероятностных характеристик по ограниченному числу

опытов могут быть допущены ошибки, т. е. отклонения этой оценки от

истинного значения характеристики случайной величины.

Чтобы убедиться в том, что мы не допускаем чрезмерно грубой ошибки в

оценке какой-то вероятностной характеристики, в теории вероятностей и

математической статистике пользуются так называемыми доверительными

интервалами и доверительными вероятностями.

Интервальной называют оценку, которая определяется двумя числами

– концами интервала.

Допустим, что для изучения некоторой случайной величины X (признака

генеральной совокупности) необходимо по статистическим данным

произвести оценку неизвестного ее параметра θ (это может быть М(Х), D(Х)

или р) с определенной степенью точности и надежности, т. е. надо указать

границы, в которых практически достоверно лежит этот неизвестный

параметр θ.

Это означает, что надо найти такую выборочную оценку для искомого

параметра θ, при которой с наибольшей вероятностью (надежностью)

будет выполняться неравенство:

37

, 0.

Отсюда видно, что чем меньше

, тем точнее характеризуется

неизвестный параметр θ с помощью выборочной оценки . Следовательно,

число характеризует точность оценки параметра θ.

,

Надежность выполнения неравенства

оценивается числом

(α = 1 – γ), которое называют доверительной вероятностью:

= Р(

).

(1.11)

Итак, число характеризует точность оценки параметра θ; число –

характеризует надежность оценки параметра θ.

В практических задачах либо заранее задается надежность

(риск α) и

надо найти точность оценки, либо, наоборот, задается точность , а

требуется определить надежность оценки.

Как правило, доверительную вероятность

задают числом, близким к

единице: 0,95; 0,97; 0,99; 0,999.

Формула (1.11) означает, что с вероятностью

неизвестное значение

параметра θ находится в интервале I = ( – , + ).

Очевидно, чем больше требуется точность (т. е., чем меньше длина

интервала), тем меньше вероятность накрыть интервалом I искомый

параметр θ, и, наоборот, с уменьшением точности

(увеличением

длины интервала) увеличивается надежность накрыть интервалом I

параметр θ (рис. 1.5).

–

+

θ

I

θ

Доверительный интервал

Замечание. Если число

= 0,95, это означает, что в среднем в 95

случаях из 100 интервал I накроет параметр θ и в 5 случаях из 100 не

накроет его.

Оценка , будучи функцией случайной выборки, является случайной

величиной, ε также случайна: ее значение зависит от вероятности γ и, как

правило, от выборки. Поэтому доверительный интервал случаен и

выражение (1.11) следует читать так: «Интервал ( –ε, +ε) накроет

38

параметр θ с вероятностью γ», а не «Параметр θ попадет в интервал ( –ε,

+ε) с вероятностью γ».

В формуле (1.11) границы доверительного интервала симметричны

относительно точечной оценки . Однако не всегда удается построить

интервал, обладающий таким свойством. Для получения доверительного

интервала наименьшей длины при заданном объеме выборки п и заданной

доверительной вероятности γ в качестве оценки параметра θ следует брать

эффективную или асимптотически эффективную оценку.

Существует два подхода к построению доверительных интервалов.

Первый подход, если его удается реализовать, позволяет строить

доверительные интервалы при каждом конечном объеме выборки п. Он

,

основан на подборе такой функции

, называемой в дальнейшем

статистикой, чтобы

1) ее закон распределения был известен и не зависел от θ;

,

2) функция

была непрерывной и строго монотонной по θ.

Задавшись доверительной вероятностью γ, связанной с риском α

формулой γ = 1 – α, находят двусторонние критические границы и ,

отвечающие вероятности α. Тогда с вероятностью γ выполняется неравенство

,

.

(1.12)

Решив это неравенство относительно θ, находят границы доверительного

интервала

для

θ.

Если

плотность

распределения

статистики

,

симметрична относительно оси Оу, то доверительный интервал

симметричен относительно .

Второй подход, получивший название асимптотического подхода,

более универсален; однако он использует асимптотические свойства

точечных оценок и поэтому пригоден лишь при достаточно больших

объемах выборки.

Рассмотрим первый подход на примерах доверительного оценивания

параметров нормального распределения.

Интервальная оценка математического ожидания при

известной дисперсии

Итак, Х ~ N(а,σ) (случайная величина Х имеет нормальное распределение

с параметрами а и σ), причем значение параметра а не известно, а значение

дисперсии σ2 известно.

39

При X ~ N ( a , /

n ) эффективной оценкой параметра а является x , при

xa

/ n имеет распределение N(0; 1)

этом X ~ N ( a , / n ) . Статистика

независимо от значения параметра а и как функция параметра а непрерывна

и строго монотонна. Следовательно, с учетом неравенства (1.12) и

симметричности двусторонних критических границ распределения N(0; 1)

будем иметь:

Р(–uа < Z < uа) = 1 – α = γ.

xa

u

u

n

Решая неравенство

относительно а, получим, что с

вероятностью 1 – α выполняется неравенство

x u / n a x u / nu ,

(1.13)

Z

при этом

u / n .

(1.14)

Число uа находят по прил. 3 из условия Ф(uа) = γ/2.

Замечание. Если п велико, оценку (1.13) можно использовать и при

отсутствии нормального распределения величины Х, так как в силу

следствия из центральной предельной теоремы при случайной выборке

большого объема п

xa

Z

n

.

В частности, если Х = μ, где μ – случайное число успехов в большом

числе п испытаний Бернулли, то

/n p

Z

pq / n

,

и с вероятностью ≈1 – α для вероятности р успеха в единичном испытании

выполняется неравенство

/ n u pq / n p / n u pq / n .

1.15)

Заменяя значения р и q = 1 – р в левой и правой частях неравенства (1.15)

~

~

их оценками p / n и q 1 p , что допустимо при большом п, получим

приближенный доверительный интервал для вероятности р:

~

p u ~

pq~ / n < p < ~

p u ~

pq~ / n .

(1.16)

40

Пример. Фирма коммунального хозяйства желает на основе выборки

оценить среднюю квартплату за квартиры определенного типа с

надежностью не менее 99 % и погрешностью, меньшей 10 д. е. Предполагая,

что квартплата имеет нормальное распределение со средним квадратичным

отклонением, не превышающим 35 д. е., найдите минимальный объем

выборки.

Решение. По условию требуется найти такое п, при котором

P x a 10 0,99

, где а и x – генеральная и выборочная средние.

Приравняв γ = 0,99, α = 1 – γ, из прил. 3 найдем число uа, при котором

Ф(uа) = γ / 2 = 0,495; и0,01 = 2,6. При ε = 10 и σ = 35 из формулы (1.14)

2

u0,01

2

n

82,81

2

получим

. Но так как с ростом γ и уменьшением ε растет п,

то п ≥ 82,81 и nmin = 83 (конечно, при уменьшении верхней границы для σ

будет уменьшаться и nmin).

Интервальная оценка математического ожидания при неизвестной

диcперсии

Итак, Х ~ N(а,σ), причем числовые значения ни а, ни σ2 не известны. По

случайной выборке найдем эффективную оценку параметра а: x и оценку

2

1 n

S

Xi x

n 1 i 1

параметра σ2.

Построение интервальной оценки для а основано на статистике

xa

t n 1

S/ n ,

которая при случайной выборке из генеральной совокупности Х ~ N(а,σ)

имеет распределение Стьюдента с (п – 1) степенью свободы независимо от

значения параметра а и как функция параметра а непрерывна и строго

монотонна.

С учетом неравенства (1.12) и симметричности двусторонних

критических границ распределения Стьюдента будем иметь:

P t t n 1 t 1 .

2

Решая неравенство

X a

t

t

S/ n

относительно а, получим, что с вероятностью 1 – α выполняется неравенство

x t S / n a X t S / n ,

(1.17)

41

и ошибка оценки x при неизвестном значении параметра σ2

t S / n ,

(1.18)

где число t находят по прил. 4 при k = п – 1 и р = α.

Замечание. При k = n – 1 > 30 случайная величина t(k) имеет

распределение, близкое к N(0; 1), поэтому с вероятностью ≈γ

x u S / n a X u S / n ,

(1.19)

где Ф(uа) = γ/2.

Пример. Для отрасли, включающей 1200 фирм, составлена случайная

выборка из 19 фирм. По выборке оказалось, что в фирме в среднем работают

77,5 человек при среднем квадратичном отклонении s = 25 человек.

Пользуясь 95%-ным доверительным интервалом, оцените среднее число

работающих в фирме по всей отрасли и общее число работающих в отрасли.

Предполагается, что количество работников фирмы имеет нормальное

распределение.

Решение. При k = п – 1 = 18 и р = γ = 0,95, α = 0,05 найдем в прил. 4

t0,05 = 2,10. Доверительный интервал (1.17) примет вид: (65,5; 89,5). С

вероятностью 95 % можно утверждать, что этот интервал накроет среднее

число работающих в фирме по всей отрасли. Тогда доверительный интервал

для числа работающих в отрасли в целом таков: (1200 – 65,5;1200 + 89,5) или

(1134,5; 1289,5).

Интервальная оценка дисперсии (среднего

квадратичного отклонения) при известном

математическом ожидании

Эффективной оценкой дисперсии в этом случае является

1 n

2

D Xi a

n i 1

.

Используются два варианта интервальной оценки для σ2(σ).

1. Основу первого варианта составляет статистика

~

2 ( n ) nD / 2 ,

(1.20)

42

которая имеет распределение χ2 с п степенями свободы независимо от

значения параметра σ2 и как функция параметра σ2 > 0 непрерывна и строго

монотонна.

Следовательно, с учетом неравенства (1.12) будем иметь:

P 2 n 1

2

2

,

2