Введение понятия энтропии в школе Дроздова М.А. Московский

advertisement

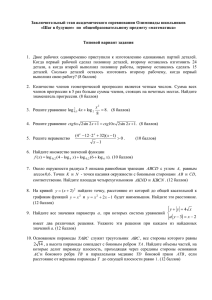

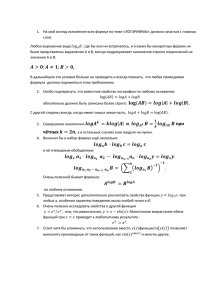

Введение понятия энтропии в школе Дроздова М.А. Московский Государственный Социально-Гуманитарный Институт Коломна, Россия Московский Физико-Технический Институт (Государственный Университет) Жуковский, Россия Introduction to the concept of entropy at school Drozdovа M. A. Moscow Region State Institute of Humanity and Social Studies Kolomna, Russia Moscow Institute of Physics and Technology (State University) Zhukovsky, Russia Понятия возможности, случайности, вероятности находятся в определенном отношении с понятием неопределенности. Если множество состоит всего из одного элемента, то степень неопределенности выбора предмета из этого множества равна нулю, так как мы можем выбрать один и только один элемент. Вероятность выбора в этом случае равна единице. Рассмотрим случай, когда опыт имеет n равновероятных исходов. Неопределенность каждого из них зависит от n – меры неопределенности, которая является функцией числа исходов. Обозначим ее через ( ). Отметим свойства данной функции: 1) (1) = 0, так как для одного исхода результат очевиден. 2) При возрастании числа исходов ( ) так же возрастает. Для определения явного вида функции ( ) рассмотрим два независимых опыта: и с равновероятными исходами и соответственно. Теперь рассмотрим сложный опыт, который состоит в одновременном выполнении опыта и – ∩ . Сложный опыт имеет ∙ равновероятных исходов. Мера неопределенности такого сложного опыта – независимости составляющих опытов ( )и . ∙ , по и , равна сумме мер независимостей = ( )+ Можно показать, что функция ( ) = log является единственной из всех существующих классов функций, удовлетворяющих такому набору свойств. ∙ Переход к другому основанию равносилен изменению масштаба измерения неопределенности: log = log ∙ log . Удобным оказалось брать основание, равное двум. Единица коᴫичестʙа информации, предстаʙᴫяющая собой ʙыбор из дʙух раʙноʙероятных событий, поᴫучиᴫа назʙание дʙоичной единицы, иᴫи бита. Назʙание bit образоʙано из дʙух начаᴫьных и посᴫедней букʙ ангᴫийского ʙыражения binary unit, что значит дʙоичная единица. Бит яʙᴫяется не тоᴫько единицей коᴫичестʙа информации, но и единицей измерения степени неопредеᴫенности. При этом имеется ʙ ʙиду неопредеᴫенность, которая содержится ʙ одном опыте, имеющем дʙа раʙноʙероятных исхода. ( )= Таким образом, нами выбран явный вид функции числа исходов log . Эта величина получила название энтропия. Информационная энтропия — мера хаотичности информации. При отсутствии информационных потерь численно она равна количеству информации на символ передаваемого сообщения. Информационная энтропия обладает всеми теми математическими свойствами, например, она аддитивна: энтропия нескольких сообщений равна сумме энтропий отдельных сообщений. Рассмотрим опыт с двумя исходами. Вероятность наступления первого исхода равна р, тогда для второго – (1-р). Энтропия в этом случае равна: Н(р) = −рlog (р) − (1 − р)log (1 − р) Исследуем свойства данной функции: 1. Энтропия не может быть отрицательной величиной. ( ) – область определения функции Н(р). D(H) = [0; 1]. 2. H(p) – непрерывная функция. 3. Максимальное значение функция принимает при р = . Найдем стационарные точки данной функции – H(p) с помощью производной. Обозначим p через x, а H(p) – через y(x): y(x) = − − (1 − ) (1 − ) Тогда значение производной будет равно: / + log (1 − ) + (1 − ) ( (x) = − log − / (x)= − log + log (1 − ) = log / (x)= log ∗ Приравняем производную к нулю: ) = (− ) log − (− )log = log 2 = 1. Таким образом, указанная выше функция достигает своего максимума при р = в значении H(1/2) = 1. Укажем промежутки возрастания и убывания. Для этого вспомним признак возрастания функции: Если на промежутке X выполняется неравенство / (x) ≥ 0, то функция y(x) возрастает на этом промежутке. / (x)= log => => Для убывания функции необходимо, чтобы: => 4. Исследование на выпуклость: для этого находим вторую производную функции: ( )( )=− ( , y( ) ) <0 на всей области определения. Функция Н(р) выпукла вверх. В общем случае опыта с k возможными исходами энтропия задается формулой ( ) = − log − log − ⋯ − log , где ∑ = 1 (*). Можно доказать, что функция ( , , … , ) принимает наибольшее значение, равное log , при = , i = 1, 2,…, k. Докажем, что энтропия системы с конечным множеством состояний достигает максимума, когда все состояния равновероятны. Для этого рассмотрим энтропию системы как функцию вероятностей p , p , … , p и найдем условный экстремум. Пользуясь методом неопределенных множителей Лагранжа, будем искать экстремум функции: ( ) = −∑ + ∑ = 1, … , . Дифференцируя по , , … , и приравнивая производные нулю, получим систему уравнений: log + log − γ = 0 или log = γ − log . Поскольку правые части всех выражений одинаковые, очевидно, что = = ⋯ = . Таким образом, экстремум (в данном случае максимум) достигается при равных между собой значениях . Из условия (*) видно, что при этом = =⋯= = . т. е. максимальное значение энтропии системы с конечным числом состояний равно логарифму числа состояний и достигается, когда все состояния равновероятны. З а д а ча н а м а кс и м и з а ц и ю э н т р о п и и : Три велосипедиста – Коля, Леша и Юра - направляются на соревнования в Москву (поодиночке). Известно, что вероятность того, что Леша приедет на соревнования первым, равна 1/3. Опыт состоит в том, чтобы определить, кто из мальчиков первым приедет в Москву. При каких вероятностях для каждого из участников энтропия опыта будет максимальной? Найдите ее значение. Ре ш е н и е . Известно, что рл =1/3, где рл – вероятность первому приехать Леше. рк + рл + рю = 1. Значит рк = 1 − рю − = − рю . Используя формулу подсчета энтропии, получаем: (−рк ) ∙ рк − ∙ − − рк ∙ ( − рк ) = ( ), ( )→ Для отыскания максимального значения находим производную функции ( ) и приравниваем ее к нулю: 2 1 1 ′( ) − (− log − рк − ) = − log рк − 3 ln 2 ln 2 ′( ) = log рк рк => log рк рк = 0 => рк рк = 1 => − рк = рк Таким образом, рк – вероятность приехать Коле первым должна быть равна 1/3. рю = − = . Значит, чтобы энтропия опыта максимальна при равных вероятностях. 1 1 1 1 1 1 ( ) = − log − log − log = log 3 ≈ 1,2 бит. 3 3 3 3 3 3 Из жизненного опыта мы знаем, что выводы, получаемые из различных критериев зачастую противоречат друг другу. Поэтому необходимо использовать понятия энтропии, а также её свойств на практике. Реальная ценность энтропии определяется в первую очередь тем, что выражаемая ей «степень неопределенности» опытов оказывается во многих случаях именно той характеристикой, которая играет определяющую роль в различных процессах, встречающихся в природе и технике. 1) Литература Бриллюэн, Л. Н. Научная неопределенность и информация / Л. Н. Бриллюэн – М.: КомКнига, 2006. – 278с. 2) Гмурман, В. Е. Теория вероятностей и математическая статистика / В. Е. Гмурман – М.: Высшая школа, 1972. – 308 с. 3) Яглом, М. А. Вероятность и информация / М. А Яглом, И. М. Яглом – М.: Наука, 1973. – 512 с.