условия Гаусса – Маркова

advertisement

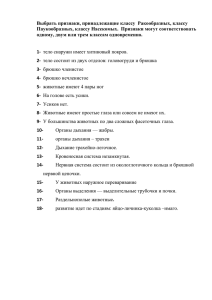

1. И снова о регрессионном анализе. 2. Классификация и кластерный анализ. Регрессионный анализ a11x1 a12 x2 ... a1n xn 1 y1 a21x1 a22 x2 ... a2n xn 2 y2 АX Y ... aN1x1 aN 2 x2 ... aNn xn N y N N S i2 i 1 S T S (T ) (Y AX )T (Y AX ) x x x T (Y Y X T AT Y Y T AX XAT AX ) 2 AT AX 2 AT Y x 1 T X ( A A) A h T Предпосылки использования МНК (условия Гаусса – Маркова) 00. Регрессионная модель корректно специфицирована (нет лишних регрессоров). 10. Случайное отклонение имеет нулевое математическое ожидание. 20. Дисперсия случайного члена постоянна. 30. Ошибки в разных наблюдениях независимы (некоррелированы) друг относительно друга. 40. Ошибки независимы (некоррелированы) с регрессорами. 50. Ошибки представляют собой слабый белый (гауссовский) шум. Условия Гаусса-Маркова Y = AX + 1. E( i) = 0 во всех наблюдениях Естественное требование, означающее несмещенность в среднем «наблюдаемых» значений зависимой переменной относительно «теоретических» Условия Гаусса-Маркова Дисперсия ошибки i одинакова во всех наблюдениях Нарушение – дисперсия ошибки i неодинакова в разных наблюдениях i i, j : 2 i 2 j Условия Гаусса-Маркова Отсутствие автокорреляции - ошибки в разных наблюдениях не связаны между собой Условия Гаусса-Маркова Y = АХ + А – детерминированная переменная (известна абсолютно точно) Требование детерминированности регрессоров упрощает анализ, но зачастую не выполняется Условия Гаусса-Маркова Y = АX + Нормальность ошибок: N 0 , I 2 Ошибки имеют совместное многомерное нормальное распределение Оценки максимального правдоподобия N Z(A1, ..., AN; Y1, ..., YN; X) = k ( Ak ;Yk ; X ) k 1 k – плотность вероятности k-го измерения ~ Yk f ( Ak , X ) ε k Yˆk ε k , k 1, 2, ..., N 1 2 1 1 ˆ k(Ak; Yk; Х) = σ 2π exp 2 exp 2 Yk Yk σ 1 N 2 ˆ Z(A1, ..., AN; Y1, ..., YN; X) = const* exp [Yk Yk ] 2 k 1 Функция правдоподобия 1 N L(A1, ..., AN; Y1, ..., YN; X) = [Yk Yˆk ]2 2 k 1 МНК! Свойство 1. Несмещенность E[ x̂ ] x Свойство 2. Эффективность: оценка с минимальной дисперсией по сравнению с другими оценками Свойство 3. Состоятельность lim x̂ N x N К проблеме мультиколлинеарности A X = (ATA)-1ATY = 0.3947 0.2290 3.7460 17.083 Интервальное оценивание параметров 2 T 1 cov(X ) s0 (A A) Параметр Стандартное отклонение X11 A 0,395 0,04 X A22 A33 X 0,23 0,42 3,75 1,30 X44 A -17 28 Cor(X) Проверка адекватности регрессионной модели Классификация Сравнительные размеры жуканосорога, взрослой мыши и мышонка Классификация с обучением Принадлежит ли образец к данному классу или нет? КЛАССЫ ИЗВЕСТНЫ! Цели классификации: 1) уменьшить число ошибочно ОТКЛОНЕННЫХ образцов (ошибка первого рода), т.е. таких, которые ошибочно отнесены к не членам определенного класса; 2) уменьшить число образцов, ошибочно ОПРЕДЕЛЕННЫХ как принадлежащие определенному классу (ошибка второго рода). Порог принадлежности к классу Чем выше порог, тем метод более требователен к отбору, и тем меньше образцов будут приписаны данному классу и наоборот. Порог снижается Дискриминатный анализ Как построить дискриминирующую функцию? Самый простой способ: найти опорные векторы (к сожалению, удается редко) 7.0 xi2 6.5 4 5 3 6.0 6 2 10 5.5 1 11 7 12 9 8 5.0 13 4.5 4.0 6.0 6.5 7.0 7.5 xi1 8.0 8.5 9.0