Теория вероятностей и случайные процессы

advertisement

ФЕДЕРАЛЬНОЕ АГЕНТСТВО ПО ОБРАЗОВАНИЮ РФ

ФГОУ ВПО «СИБИРСКИЙ ФЕДЕРАЛЬНЫЙ

УНИВЕРСИТЕТ»

Т. В. Крупкина, С. В. Бабенышев,

А. К. Гречкосеев, Е. С. Кирик

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

И СЛУЧАЙНЫЕ ПРОЦЕССЫ

Часть 1

Учебное пособие

СФУ 2007

УДК

ББК

000.000

22.17я73

К 84

Рецензенты

Т. В. Крупкина

К 84 Теория вероятностей и случайные процессы: учебное пособие / Т. В.

Крупкина, С. В. Бабенышев, А. К. Гречкосеев, Е. С. Кирик. Сибирский федеральный университет. Красноярск: 2007. 149 с.

ISBN 0-0000-0000-0

Учебное пособие посвящено курсу «Теория вероятностей, случайные процессы» и

соответствует первому семестру изучения. Включает в себя теоретическую основу курса и

контрольные вопросы. Предназначено для студентов математических направлений и специальностей.

Предназначено для студентов математических направлений и специальностей.

ISBN 0-0000-0000-0

c Сибирский федеральный университет, 2007

c Т. В. Крупкина, С. В. Бабенышев,

А. К. Гречкосеев, Е. С. Кирик 2007

Принятые обозначения и сокращения.

[x] — целая часть числа x.

exp x, exp{x} — экспонента аргумента x (exp x = exp{x} = ex ).

e — основание натурального логарифма, e = 2, 718 281 828 459 . . .

A, B, . . . , X — события.

A, B, . . . X — отрицания событий A, B, . . . , X.

B ⇔ C, B ⇐⇒ C — «из B следует C и из C следует B».

∃ x — «существует x».

∀ x — «для любого x».

@ x — «не существует x».

def

= — «равно по определению».

≡ — «тождественно равно».

J — начало решения.

I — конец решения.

n, m = n, n + 1, . . . , m при том, что n, m ∈ Z и n < m.

N — множество натуральных чисел.

Z — множество целых чисел.

R — множество вещественных чисел.

R+ — множество вещественных чисел.

3

Предисловие.

Представленное издание является второй частью пособия, предназначенного для

обеспечения самостоятельной работы студентов факультета математики и информатики

Сибирского федерального университета по изучению теоретического материала в курсе

«Теория вероятностей, случайные процессы». Курс занимает два семестра по 4 часа (2 часа

лекций и 2 часа практических занятий) в неделю.

Структура изложения определена структурой лекционных занятий: каждая часть

соответствует стандартному семестру (17 лекций), номер параграфа пособия соответствует

номеру лекции.

Часть 1, представленная в данном издании, охватывает модули «Случайные события» и «Случайные величины», изучаемые в 6 семестре, часть 2 посвящена модулям «Последовательности случайных величин» и «Случайные процессы», изучаемым в 7 семестре.

Модуль «Случайные события» состоит из трех разделов: «1. Введение в теорию вероятностей» (лекции 1, 2, 3); «2. Исчисление вероятностей» (лекции 4, 5); «3. Испытания» (лекции 6, 7). За основу построения теории вероятностей принята система аксиом

А. Н. Колмогорова. В разделе 1 излагаются краткие сведения по истории возникновения

и развития теории вероятностей, приводятся исторические методы решения классических

задач, вводятся понятия элементарного события, σ-алгебры, вероятностного пространства, рассматриваются эквивалентные системы аксиом и основные вероятностные пространства. В разделе 2 вводятся понятия условной вероятности, зависимости и независимости событий, доказывается закон 0 и 1 (лемма Бореля – Кантелли), выводятся основные

формулы исчисления вероятностей, непосредственно вытекающие из аксиом. В разделе 3

вводится прямое произведение вероятностных пространств, рассматриваются схемы испытаний, доказываются предельные теоремы для гипергеометрической схемы и для схемы

Бернулли.

Модуль «Случайные величины» состоит также из трех разделов: «4. Распределения случайных величин» (лекции 8, 9, 10, 11); «5. Числовые характеристики случайной величины» (лекции 12, 13); «6. Характеристики связи случайных величин» (лекции 14, 15,

16, 17). В этом модуле рассматриваются конечномерные случайные величины. Раздел 4

посвящен распределениям одномерных и многомерных случайных величин и их функций.

Вводятся понятия непрерывных и дискретных случайных величин, функции и плотности

распределения, обобщенной плотности, независимости случайных величин, σ-алгебр, порожденных случайными величинами. В разделе 5 на основе интеграла Лебега вводится понятие математического ожидания, изучаются основные свойства математического ожидания, рассматриваются прочие числовые характеристики одномерной случайной величины.

Раздел 6 посвящен изучению связи случайных величин. Вводятся понятия коррелированности, условных распределений, регрессии. Выводятся формулы для нахождения характеристик связи в двумерном и многомерном случаях. В качестве примера рассматривается

нормальное распределение.

Все разделы пособия включают широкий набор примеров и контрольных вопросов,

которые позволят закрепить и углубить теоретические знания и получить навыки практического использования вероятностных методов.

4

1. Введение в теорию вероятностей

Лекция 1

Введение в теорию вероятностей

План лекции: предмет теории вероятностей, история возникновения и развития, классическое определение вероятности, некоторые формулы комбинаторики.

1.1

Предмет теории вероятностей

Предмет теории вероятностей — математический анализ случайных явлений, то есть разработка и применение математического аппарата для изучения явлений, имеющих случайную природу. Основные объекты теории

вероятностей — случайные события, случайные величины, случайные процессы, то есть фактически весь окружающий нас мир.

В основе развития разумной жизни лежит способность замечать в

окружающем изменчивом мире «перманентности» — то, что является хотя бы приблизительно неизменным. Так, размеры и формы предметов,

причинно-следственные связи, физические законы представляют собой

перманентности. Такой же перманентностью, только гораздо менее очевидной, является частота, например, частота выпадения шестерки при бросании игральной кости. Хотя результат отдельного броска предсказать нельзя, частота выпадения шестерки для каждой кости при большом числе

бросков почти постоянна во времени. Это знали еще древние египтяне. Перманентность частот в событиях человеческой жизни была замечена гораздо

позже, при составлении таблиц смертности. Перманентности частот существуют и в функционировании сложных систем, однако чем сложнее система, тем труднее это обнаружить. Именно в этих случаях и используют вероятностные методы, позволяющие выделить закономерности среди массы

случайностей.

«Высшее назначение математики состоит в том, чтобы находить скрытый порядок в хаосе, который нас окружает», так писал Н. Винер1 , и это

в полной мере применимо к теории вероятностей, которую используют для

описания, изучения, прогнозирования поведения сложных систем. Нельзя

предсказать поведение отдельного человека или отдельной молекулы, но

можно предсказать поведение системы в целом. «Реальность такого рода

закономерностей не подлежит никакому сомнению», говорил А. Н. Колмогоров2 .

Теорию вероятностей и математическую статистику широко применяют в экономике, социологии, биологии, генетике, психологии. Вышепере1

Норберт Винер (англ. Wiener Norbert; 1894—1964) — американский учёный, один из создателей кибернетики.

2

Андрей Николаевич Колмогоров (1903—1987) — великий русский математик XX века.

5

1. Введение в теорию вероятностей

численные науки изучают живые организмы. Живые существа являются,

конечно, мощным источником случайностей. Но случайность существовала

и до появления жизни, истоки ее более глубоки. Случайно движение молекул. Статистическая физика, например, рассматривает макроскопическое

тело как систему из очень большого числа частиц, которую можно исследовать вероятностными методами.

Случайность всеобъемлюща. Но существует ли она на самом деле,

или мы используем это слово для маскировки нашего незнания причин?

Ученые-детерминисты Лаплас, Ньютон, Пристли считали, что в будущем,

когда наука установит все связи между причинами и следствиями, случайности не останется места. Если бы в некоторый момент были известны, говорили они, положения и импульсы всех молекул, можно было бы предсказать всю дальнейшую историю вселенной.

Лаплас3 выражал эту мысль так: «Ум, который знал бы все действующие в данный момент силы природы, а также относительное положение всех

составляющих ее частиц и который был бы достаточно обширен, чтобы все

эти данные подвергнуть математическому анализу, смог бы охватить единой

формулой движение как величайших тел природы, так и ее легчайших атомов; для него не было бы ничего неопределенного, он одинаково ясно видел

бы и будущее и прошлое.»

Однако в глубоких корнях случайности в природе убеждает фундаментальное положение квантовой механики, принцип неопределенности,

утверждающий, что нельзя одновременно точно измерить координату и импульс.

Большинство вероятностных школ признает объективное существование случайности, что, впрочем, не является необходимым для развития

теории вероятностей. Примером тому сам Лаплас, с именем которого связаны и принцип классического детерминизма, и замечательная работа «Аналитическая теория вероятностей» (1812 год), в предисловии к которой он

писал: «...нет науки, более достойной наших размышлений и результаты которой были бы более полезны.»

Теория вероятностей занимает в системе математических наук особое

3

Пьер-Симон Лаплас (фр. Pierre-Simon Laplace; 1749—1827) — французский математик, физик и астроном. Родился в бедной семье и попечительством соседей был устроен в школу Ордена Бенедиктинцев, из

которой, однако, вышел убежденным атеистом. Получив в 1771 году место профессора в Париже, он не покидал с тех пор этого города, пережив в нем Великую Французскую революцию, эпоху Наполеона и реставрацию Бурбонов. Вначале он был республиканцем, при Наполеоне — министром внутренних дел. Правда,

Лаплас вскоре был уволен с этого поста за то, что «...вносил слишком много бесконечно малых в дела государства». Однако ему были предоставлены другие почетные посты и титулы. Несмотря на это, в 1814 году

он проголосовал за низложение Наполеона и стал, после Реставрации, пэром и маркизом. Вклад Лапласа

в развитие теории вероятностей весьма велик. В его труде «Аналитическая теория вероятностей» основным

аппаратом служил математический анализ. Сразу после написания (1812 г.) курьер доставил книгу императору Наполеону в Витебск, император собирался посвятить изучению этой работы первые 3 месяца после

взятия Москвы. Эта работа трижды переиздавалась еще при жизни Лапласа.

6

1. Введение в теорию вероятностей

место. Она имеет множество приложений и в некотором смысле является

посредником между другими областями математики и действительностью.

С помощью вероятностных методов можно проверять адекватность математических моделей реальных явлений.

Однако при изучении теории вероятностей надо иметь в виду, что, как

и любая математическая наука, она не несет в самой себе никаких указаний

на возможные области и методы применений. Теоретические вероятностные

модели можно применять многими различными способами. Поэтому изучающему теорию вероятностей, кроме ознакомления с абстрактными моделями, требуется еще развивать вероятностную интуицию и технику приложений.

1.2

История возникновения и развития теории вероятностей

Развитие теории вероятностей как самостоятельной науки началось с середины семнадцатого столетия и связано с именами Ферма4 , Паскаля5 , Гюйгенса6 .

В 1654 г. шевалье де Мере7 задал Паскалю два вопроса, касающихся

азартных игр. Паскаль обсуждал эти вопросы в письмах к Ферма.

Первая задача де Мере состояла в следующем: сколько раз надо бросить две игральные кости, чтобы вероятность выпадения двух шестерок была больше половины? С этой задачей де Мере справился, и Паскаль, обсудив его решение, признал его правильным. Вторая задача оказалась более

сложной. Два игрока играют в азартную игру до n выигрышей. Как следует разделить между ними ставку, если игра прервана, когда первый игрок

выиграл a партий, а второй b партий, a, b < n?

Для решения этой задачи Паскаль ввел основные понятия теории вероятностей. Хотя отправным пунктом для исследований явились задачи,

связанные с азартными играми, он отчетливо сознавал важность новых по4

Пьер Ферма (фр. Pierre de Fermat; 1601—1665) — французский математик, один из создателей теории

чисел, где с его именем связаны две знаменитые теоремы: великая теорема Ферма и малая теорема Ферма.

5

Блез Паскаль (фр. Blaise Pascal; 1623—1662) — французский математик, физик, философ и писатель.

В двенадцать лет самостоятельно открыл геометрию Евклида, в шестнадцать был признан во Франции великим математиком, в двадцать три года изобрел вычислительную машину. Когда врачи запретили ему заниматься умственной работой, разрешив только переписку с друзьями, он посвящал эту переписку вопросам

математики. В возрасте тридцати одного года он принял монашество и отказался от научных занятий, но

до смерти, наступившей в 39 лет, занимался литературными и философскими трудами. Считается одним из

создателей французской классической прозы. Единица давления «паскаль», гидростатический «закон Паскаля», «треугольник Паскаля», «теорема о конических сечениях Паскаля», «распределение Паскаля» носят

его имя, а вот «улитка Паскаля» названа в честь его отца, тоже известного математика Э. Паскаля.

6

Христиан Гюйгенс (Xёйгенс) (нидерл. Huygens Christian; 1629—1695) — голландский механик, физик

и математик.

7

Антуан Гомбо, шевалье де Мере́ (фр. Antoine Gombaud, chevalier de Méré; 1607—1684) — французский писатель и математик.

7

1. Введение в теорию вероятностей

нятий. Это видно из письма Паскаля в Парижскую академию, где он, в частности, писал: «Это учение, объединяющее точность математических доказательств с неопределенностью случая и примиряющее эти, казалось бы,

противоречивые элементы, с полным правом может претендовать на титул — математика случайного, или теория вероятностей».

Первая книга, посвященная теории вероятностей, была написана в

1656 году Христианом Гюйгенсом. Она представляла из себя «рассуждение

о приложении теории вероятностей к азартным играм». Приводя изящные и

точные расчеты, Гюйгенс писал: «Читатель заметит, что имеет дело не только с игрой, но что здесь закладываются основы очень интересной и глубокой

теории».

Через полвека Якоб Бернулли8 написал книгу «Искусство предположений». Важнейшая часть в ней — изложение закона больших чисел,

утверждающего, что статистические характеристики, вычисленные на больших совокупностях, являются устойчивыми. Действительно, при единичных

наблюдениях проявляются индивидуальные особенности, при массовых наблюдениях они взаимокомпенсируются и выявляется сущность процесса.

Статистическая устойчивость средних была замечена давно. Однако Якоб

Бернулли не только сформулировал закон больших чисел, но и выработал условия, при которых суммарное поведение достаточно большого числа

случайных величин становится закономерным. Книга Якоба Бернулли была

издана через восемь лет после его смерти, в 1713 году. С этого времени теория вероятностей получила прочный базис для развития, который, однако,

в полной мере был использован только через сотню лет.

Конечно, нельзя сказать что работы в области теории вероятностей

прекратились. Большой вклад в нее внес Абраам де Муавр9 . В 1764 году

были посмертно опубликованы работы малоизвестного тогда, но очень известного сейчас Томаса Байеса10 , увековечившие его имя.

Бюффон11 расширил область применения теории, построив пример

геометрической вероятности, получивший название «игла Бюффона». Этот

пример позволял экспериментально определить число π, бросая иголку на

8

Якоб Бернулли (нем. Jakob Bernoulli; 1654—1705) — швейцарский математик, выходец из Голландии.

Старший из семьи швейцарских математиков Бернулли, в трех последовательных поколениях которой было восемь математиков (причём имена у них повторялись). Наиболее известен, кроме Якоба Бернулли, его

младший брат Иоганн, сотрудник Г. Лейбница в разработке дифференциального и интегрального исчислений.

9

Абрам (Абраа́м) де Муавр (фр. Abraham de Moivre; 1667—1754) — английский математик, француз по

происхождению. Будучи гугенотом, он покинул Францию после отмены Нантского Эдикта, чтобы избежать

религиозных преследований, и обосновался в Англии, зарабатывая на жизнь частными уроками. Является

не только автором известной всем формулы Муавра для комплексных чисел и исследований степенных рядов, но и соавтором формулы Стирлинга (асимптотическое представление n!). В теории вероятностей Муавр

доказал частный случай теоремы Лапласа (на полвека раньше Лапласа).

10

То́мас Ба́йес (Бейес; англ. Reverend Thomas Bayes; 1702—1761) — английский математик и священник.

11

Жорж-Луи Леќлерк Бюффо́н (фр. Georges-Louis Leclerc de Buffon; 1707—1788) — французский естествоиспытатель, автор знаменитой 36-томной «Естественной истории».

8

1. Введение в теорию вероятностей

плоскость, разграфленную параллельными прямыми, и подсчитывая частоту пересечений иголки с ними. При проведении многочисленных лотерей и

в работе страховых компаний накапливался статистический материал. Но

только в XIX веке теория вероятностей вновь привлекает внимание крупнейших современных математиков, первым из которых следует назвать Лапласа. Уже упоминавшаяся его работа «Аналитическая теория вероятностей» представляет из себя внушительный, богатый содержанием том. В

этом трактате разработан новый математический аппарат (производящие

функции, преобразование Лапласа и др.).

Среди современников Лапласа, оказавших значительное влияние на

развитие теории вероятностей, необходимо указать Гаусса12 и Пуассона13 ,

а во второй половине XIX века появилась блестящая плеяда русских математиков. Ведущими среди них были П. Л. Чебышёв14 , А. А. Марков15 ,

А. М. Ляпунов16 .

Профессор Петербургского университета Пафнутий Львович Чебышёв совершил в теории вероятностей переворот, выдвинув требование абсолютной строгости формулировок и доказательств теорем и получения

точных оценок отклонений от предельных закономерностей. П. Л. Чебышёв

нашел новый путь развития теории вероятностей — всестороннее изучение

последовательностей независимых случайных величин. Сам Чебышёв и его

ученики А. А. Марков и А. М. Ляпунов на этом пути получили фундаментальные результаты (закон больших чисел, предельные теоремы). Их трудами теория вероятностей стала достаточно строгой и разработанной областью науки.

Но еще в начале XX века большинство ученых не признавало ее равноправной ветвью математики. По выражению одного из них, теория вероятностей — нечто среднее между математикой, физикой и шаманством.

Причиной этого было отсутствие аксиоматического обоснования. В 1900

12

Карл Фридрих Гаусс (нем. Carl Friedrich Gauss; 1777—1855) — немецкий математик. Теория вероятностей находилась далеко не в центре научных интересов Гаусса. И все-таки он обогатил ее многими первоклассными результатами и повлиял на дальнейшее развитие ряда важных направлений. Наряду с Лапласом

Гаусс разрабатывал «теорию ошибок», и имя его навечно связано с нормальным распределением.

13

Симео́н-Дени́ Пуассо́н (фр. Siméon-Denis Poisson; 1781—1840) — французский физик, математик. В

теории вероятностей с именем Пуассона связано понятие распределения и процесса, носящих его имя, а

также закона больших чисел в форме Пуассона.

14

Пафнутий Львович Чебышёв (1821—1894) — величайший, наряду с Н. И. Лобачевским, русский математик XIX века. Математическая школа П. Л. Чебышёва, получившая название Петербургской, сыграла

выдающуюся роль в прогрессе математики не только в России, но и в мировом масштабе.

15

Андрей Андреевич Марков (1856—1922) — русский математик. На схеме «испытаний, связанных в

цепь» (цепи Маркова) установил ряд закономерностей, положивших начало всей современной теории марковских процессов.

16

Александр Михайлович Ляпунов (1857—1918) — русский механик и математик. А. М. Ляпунов опубликовал лишь две теоретико-вероятностные работы, но они оказали большое влияние на развитие теории

вероятностей; с его именем связаны «неравенство Ляпунова» и «теорема Ляпунова», для доказательства

которой был применен новый метод исследования — метод характеристических функций.

9

1. Введение в теорию вероятностей

году на Международном конгрессе математиков в Париже Гильберт17 составил список важнейших нерешённых проблем математики. В этот список он включил проблему аксиоматического обоснования теории вероятностей18 .

Наиболее интересные попытки решить эту задачу предпринимались

русским математиком Бернштейном 19 и эмигрантом из Германии Мизесом

20

, однако им не удалось построить удовлетворительную систему аксиом.

В двадцатых годах Э. Борель21 , А. Н. Колмогоров, Е. Е. Слуцкий 22 ,

А. Я. Хинчин23 и Поль Леви24 нашли тесную связь между теорией вероятностей и математическими дисциплинами, изучающими множества и общее

понятие функции (теорией множеств и теорией функций действительного

переменного). Открытие этой связи оказались чрезвычайно плодотворным,

и именно на этом пути советскому математику Андрею Николаевичу Колмогорову в 1933 году удалось решить проблему аксиоматического обоснования теории вероятностей.

«Поставив теорию вероятностей на теоретико-множественную основу, точнее, на фундамент теории множеств и теории мер, Колмогоров одним

махом дал не только логически удовлетворительное обоснование теории вероятностей, но и включил её в кровеносную систему современной математики, позволив тем самым использовать развитые её ветви для нужд теории

вероятностей. По простоте и естественности, а также упомянутым преимуществам теория Колмогорова быстро стала общепринятой и служит твёрдой основой для построения теории вероятностей на протяжении последних

30 лет», — писал в 1969 году А. Реньи25 .

Развитие физики и техники поставило перед теорией вероятностей

большое число совершенно новых проблем, касавшихся изучения процесса, то есть явления, протекающего во времени. Эти задачи не укладывались

в рамки классических схем.

Начало общей теории случайных процессов было положено фун17

Давид Гильберт (Хильберт; нем. David Hilbert; 1862—1943) — немецкий математик.

Подлинные слова Д. Гильберта, сказанные им при постановке проблемы № 6, таковы: «c исследованиями по основаниям геометрии близко связана задача об аксиоматическом построении по этому же образцу тех

физических дисциплин, в которых уже теперь математика играет выдающуюся роль: это в первую очередь —

теория вероятностей и механика.»

19

Сергей Натанович Бернштейн (1880—1968) — русский математик, разработал первую по времени аксиоматику (1917).

20

Рихард Мизес (нем. Richard Mises, 1883—1953) — немецкий математик и механик. В теории вероятностей Мизес ввёл в общее употребление интегралы Стилтьеса и первым подробно разъяснил значение теории

цепей Маркова для физики.

21

Феликс Эдуар Жюстен Эмиль Борель (фр. Félix Edouard Justin Borel Émile, 1871—1956) — французский математик, создатель нескольких отраслей современного математического анализа.

22

Евгений Евгеньевич Слуцкий (1880—1948) — русский математик, статистик и экономист.

23

Александр Яковлевич Хи́нчин (1894—1959) — русский математик.

24

Поль Пьер Леви́ (фр. Paul Pierre Levy; 1886—1971) — французский математик.

25

Альфре́д Ре́ньи (венг. Alfréd Rényi, 1921—1970) — венгерский математик.

18

10

1. Введение в теорию вероятностей

даментальными работами русских математиков А. Н. Колмогорова и

А. Я. Хинчина. Эта теория развивала введенные в первом десятилетии нашего века А. А. Марковым идеи изучения последовательностей зависимых

случайных величин, получивших название цепей Маркова.

С тех пор многие ученые (В. И. Романовский, Г. Адамар, М. Фреше,

Дж. Дуб, В. Феллер, Н. В. Смирнов, Б. В. Гнеденко, А. Н. Ширяев, А. А. Боровков и другие) внесли в теорию вероятностей и в теорию случайных процессов значительный вклад.

Теория вероятностей успешно продолжает развиваться.

1.3

Классическое определение вероятности

Рассмотрим некоторый опыт с конечным числом n взаимоисключающих

друг друга исходов, которые равновозможны. Пусть A — некоторое событие, связанное с этими исходами. Вероятность p (A) можно определить

как долю тех исходов, в результате которых это событие осуществляется:

n(A)

,

n

p (A) =

(1)

где n — число всех исходов, n(A) — число исходов, в результате которых

осуществляется событие A (благоприятных).

Пример 1.1 Какова вероятность, что при бросании игральной кости

выпадет нечетное число очков?

J Рассмотрим множество всех исходов {1, 2, 3, 4, 5, 6}. Исходы несовместны и равновозможны. Обозначим через A событие, состоящее в выпадении

нечетного числа очков: A = {1, 3, 5}. Очевидно, n = 6, n(A) = 3.

p (A) =

3 1

= .

6 2

I

Определение вероятности согласно (1) называется классическим

определением вероятности. Я.Бернулли формулировал его так: «...вероятность события есть отношение числа благоприятствующих случаев к числу всех возможных случаев, все случаи предполагаются равновозможными.» Заметим, что классическое определение вероятности на самом деле не

является определением. Оно дает лишь метод вычисления вероятностей в

простейших случаях, применяемый, однако, очень часто. При вычислении

числа исходов полезны формулы комбинаторики.

11

1. Введение в теорию вероятностей

1.4

Некоторые формулы комбинаторики

Ф.1. Число перестановок. Число перестановок n различных элементов

равно

Pn = n!

(2)

Пример 1.2 Карточки, на которых написано слово «АПЕЛЬСИН»,

перемешаны. Какова вероятность, что при случайном выкладывании их в ряд получится слово «СПАНИЕЛЬ»?

А П Е Л Ь С И Н

J Исходом испытания является любая перестановка карточек. Число всех

исходов n равно P8 = 8!, а слово «СПАНИЕЛЬ» действительно можно

сложить из карточек и, очевидно, единственным способом. Поэтому n(A) =

1.

n(A)

1

p (A) =

= .

n

8!

I

Ф.2. Составные наборы Пусть имеется r групп элементов, причем iя группа содержит ni элементов; i = 1, 2, . . . , n. Число способов, которыми

можно выбрать r элементов по одному из каждой группы, равно

N = n1 · n2 · · · · · nr .

(3)

Пример 1.3 Какова вероятность, что у случайно выбранного трехзначного числа все цифры различны?

J Чтобы найти общее число исходов n, надо сосчитать, сколько существует трехзначных чисел. Первую цифру можно выбрать 9 способами (любая цифра, кроме 0), вторую цифру 10 способами (любая цифра), третью

также 10 способами. По (3) общее количество трехзначных чисел равно

n = 9 · 10 · 10. Для нахождения числа благоприятных исходов надо сосчитать, сколько существует трехзначных чисел, все цифры которых различны. Первую цифру можно выбрать 9 способами (любая цифра, кроме

0), вторую цифру тоже 9 способами (любая цифра, кроме первой), для третьей цифры существует 8 вариантов (любая цифра, кроме первой и второй).

По (3) количество трехзначных чисел, все цифры которых различны, равно

n(A) = 9 · 9 · 8. Тогда искомая вероятность равна

p (A) =

n(A)

9·9·8

=

= 0, 72.

n

9 · 10 · 10

12

1. Введение в теорию вероятностей

I

Важное значение имеет частный случай Ф.2 при n1 = · · · = nr = n.

N = nr .

(4)

Эта формулу часто используют при повторении опытов.

Ф.3. Повторение опытов. Пусть испытание, имеющее n исходов,

независимо повторяется r раз. Число всех возможных наборов исходов

(Ai1 , Ai2 , . . . , Air ) равно

N = nr .

Пример 1.4 Три раза бросают игральную кость. Сколько различных

результатов может получиться?

J Три раза независимо повторяется испытание, имеющее 6 исходов, поэтому число всех возможных результатов равно N = 63 . I

Пример 1.5 Пусть r шаров случайно распределяются по n ящикам.

Какова вероятность того, что все шары попадут в первый ящик?

J n — число исходов испытания, r — число испытаний. Число всех возможных наборов исходов равно N = nr . Благоприятный исход, очевидно,

один.

n(A)

1

= r.

p (A) =

n

n

I

Следующие формулы применимы к схемам выбора. Необходимо

различать выбор с возвращением и выбор без возвращения.

Ф.4. Выбор с возвращением. Из n различных элементов выбирают

с возвращением r элементов, то есть каждый элемент регистрируют и возвращают обратно прежде, чем выбирают следующий. Число всех возможных выборок равно

N = nr .

Замечание 1.1 Это еще одна интерпретация формулы (4). Действительно, при повторении опытов исходы выбираются с возвращением.

Две следующие формулы описывают выбор без возвращения.

Рассмотрим выбор без учета порядка: два набора номеров исходов

считаются различными, если они отличаются составом. Наборы, отличающиеся лишь порядком следования номеров, считаются одинаковыми.

13

1. Введение в теорию вероятностей

Ф.5. Число сочетаний: выбор без возвращения и без учета порядка. Число способов, которыми можно выбрать m из n различных элементов,

равно

n!

Cnm =

(5)

.

m!(n − m)!

Пример 1.6 Из чисел 2, 3, 4, 5, 7, 8 выбирают два числа. Какова вероятность того, что составленная из этих чисел дробь сократима?

J Для того чтобы быть сократимой, дробь должна быть составлена из чисел

2, 4, 8. Число всех исходов равно

n = C62 =

6!

= 15.

2!(6 − 2)!

Число благоприятных исходов

n(A) = C32 =

p (A) =

3!

= 3.

2!(3 − 2)!

n(A)

3

1

=

= .

n

15 5

I

Теперь рассмотрим выбор с учетом порядка: два набора номеров

исходов считаются различными, если они отличаются составом или порядком номеров.

Ф.6. Число размещений: выбор без возвращения и с учетом порядка. Число способов, которыми можно выбрать и разместить по различным местам m из n различных элементов, равно

m

Am

n = Cn · m! =

n!

.

(n − m)!

(6)

Пример 1.7 На карточках написано слово

Ш К О Л А.

Одна за другой случайно вынимают и выкладывают в ряд три

карточки. Найти вероятность, что они лягут в таком порядке

К Л Ш

14

1. Введение в теорию вероятностей

J Число всех исходов равно

n = A35 =

5!

= 60.

(5 − 3)!

Число благоприятных исходов

n(A) = 1.

p (A) =

1

n(A)

= .

n

60

I

Ф.7. Число разбиений на группы.

Число способов, которыми можно разбить n различных элементов на

k групп, содержащих соответственно n1 , n2 , . . . , nk элементов, равно

N=

n!

.

n1 !n2 ! . . . nk !

(7)

Пример 1.8 Колода из 36 карт случайным образом делится на 4 равные части. Найти вероятность того, что тузы окажутся в разных

частях.

J Число способов разбиения 36 элементов на 4 группы по 9 элементов каждая, равно, согласно (7)

n=

36!

36!

=

.

9!9!9!9! (9!)4

Для подсчета числа благоприятных исходов найдем отдельно число n1 (A)

способов разбиения 4 тузов на 4 группы по 1 тузу и число n2 (A) способов

разбиения 32 карт, не являющихся тузами, на 4 группы по 8 карт:

n1 (A) =

4!

= 4!,

1!1!1!1!

n2 (A) =

По Ф.2

n(A) = n1 (A) · n2 (A) =

32!

32!

=

.

8!8!8!8! (8!)4

4! · 32!

.

(8!)4

4! · 94 · 32!

p (A) =

.

36!

I

15

1. Введение в теорию вероятностей

Замечание 1.2 Многие задачи удобно формулировать в терминах

урновой модели: есть урна, содержащая n пронумерованных шаров

определенного состава, мы выбираем из этой урны m шаров. Например, задача «Из чисел 2, 3, 4, 5, 7, 8 выбирают два числа. Какова вероятность того, что составленная из этих чисел дробь сократима?»

может быть переформулирована так: «В урне 3 белых и 3 черных

шара, из урны вынимают два шара, какова вероятность, что оба

они белые?». Очевидно, производится выбор без возвращения, и порядок не важен. Поэтому применяется формула (5).

1.5

Контрольные вопросы

1. Дайте определение классической вероятности.

2. Опишите урновую модель.

3. Сформулируйте в терминах урновой модели задачу: испытание

состоит в случайном выборе одной буквы из букв слова «ВЕРОЯТНОСТЬ»; необходимо найти вероятность события A =

{Вынута гласная буква, но не «Е»}.

4. Чему равно число всех

элементного множества?

k-элементных

подмножеств

n-

5. Чему равно число всех упорядоченных k-элементных подмножеств n-элементного множества?

6. Обоснуйте «правило суммы»: если объект a может быть выбран

m способами, а объект b — другими n способами, то выбор «либо

a, либо b» может быть осуществлен m + n способами.

7. Обоснуйте «правило произведения»: если объект a может быть

выбран m способами, а объект b можно выбрать n способами, то

выбор упорядоченной пары ha, bi может быть осуществлен m · n

способами.

8. Выведите формулы числа перестановок, числа размещений, числа сочетаний.

9. Каким числом способов можно переставить буквы слова «ЗАДАЧА»?

10. Выведите формулу числа перестановок с повторениями.

16

2. Основные понятия теории вероятностей

Лекция 2

Основные понятия теории вероятностей

План лекции: статистическое определение вероятности, пространство элементарных событий, операции над событиями, аксиоматическое определение вероятности, свойства вероятности,

σ-алгебры, свойство непрерывности.

2.1

Статистическое определение вероятности

Определение 2.1 Пусть рассматриваемый опыт можно повторять

многократно, и пусть n — число всех повторений опыта, а n(A) —

число тех из них, в которых осуществлялось событие A. Отношение

n(A)

n называется частотой события A в данной серии испытаний.

Практика показывает,что для многих событий частота n(A)

n

при больших n мало меняется, колеблясь около некоторого постоянного значения p∗ , которое можно назвать вероятностью события

A,

n(A)

p∗ (A) =

.

(8)

n

2.2

Пространство элементарных событий

Будем интерпретировать случайные события как множества. Пространство элементарных событий Ω = {ω} — постулируемое понятие. Элементарные события ω интерпретируют как взаимоисключающие исходы

опыта. Случайное событие A можно рассматривать как подмножество

Ω (интерпретация: A — набор исходов, при которых оно осуществляется),

A = {ωA } ⊆ Ω.

1. Достоверное событие, наступающее при любом исходе, обозначается Ω.

2. Невозможное событие обозначается ∅.

3. A1 = A2 , если A1 ⊆ A2 и A2 ⊆ A1 .

4. A1 и A2 называются несовместными, если множества элементарных исходов {ωA1 } и {ωA2 } не пересекаются.

Пример 2.1 Кость подбрасывают 2 раза.

Ω = {i, j},

Пусть A = {i + j 6 3},

1 6 i 6 6,

B = {j = 6},

1 6 j 6 6.

C = {j четно}.

J Тогда A = {(1, 1), (1, 2), (2, 1)}, B = {(i, 6)}, 1 6 i 6 6,

C = {(i, 2), (i, 4), (i, 6)},

17

1 6 i 6 6.

2. Основные понятия теории вероятностей

События A и B несовместны.I

2.3

Операции над событиями

Определение 2.2 Суммой или объединением A1 , A2 называется событие A, состоящее в осуществлении хотя бы одного из A1 , A2 :

A = A1 + A2 = A1 ∪ A2 ,

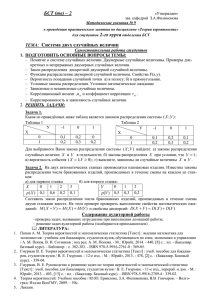

(закрашенная область на рис. 1).

A1

A2

Ω

Рис. 1. Объединение событий A1 ∪ A2

S

Аналогично определяется A =

k

Ak .

Определение 2.3 Произведением или пересечением событий A1 , A2

называется событие A, состоящее в осуществлении и A1 и A2 :

A = A1 A2 = A1 ∩ A2 ,

(закрашенная область на рис. 2).

A1

A2

Ω

Аналогично определяется

A=

\

k

18

Ak .

2. Основные понятия теории вероятностей

Рис. 2. Пересечение событий A1 ∪ A2

Определение 2.4 Разностью событий A1 , A2 называется событие A,

которое означает, что происходит A1 , но не происходит A2 :

A = A1 \ A2 ,

(закрашенная область на рис. 3).

A1

A2

Ω

Рис. 3. Разность событий A1 \ A2

Определение 2.5 Противоположным или дополнительным к событию A называется событие Ā, состоящее в том, что событие A

не происходит:

Ā = Ω \ A,

(закрашенная область на рис. 4).

A

Ā

Ω

Рис. 4. Противоположное событие Ā

Определение 2.6 Симметрической разностью событий A и B называется событие

A1 4A2 = A1 Ā2 + A2 Ā1 ,

(закрашенная область на рис. 5).

19

2. Основные понятия теории вероятностей

A1

A2

Ω

Рис. 5. Симметрическая разность событий A1 4A2

Итак, после того, как случайные события интерпретированы в виде

множеств, теоретико-вероятностные понятия, например, несовместимость

событий, их одновременная реализация, противоположное событие, невозможное событие, превратились соответственно в непересечение множеств,

их пересечение, дополнение множества, его пустоту. Тем самым аппарат основных операций над множествами применим к операциям над событиями.

Пример 2.2 Кость подбрасывают 2 раза.

Ω = {i, j},

Пусть A = {i + j 6 3},

1 6 i 6 6,

B = {j = 6},

1 6 j 6 6.

C = {j четно}.

JТогда

B + C = C,

AC = {(1, 2)},

C \ B = {(i, 2), (i, 4)},

C̄ = {(i, 1), (i, 3), (i, 5)},

1 6 i 6 6.

1 6 i 6 6.

I

2.4

Аксиоматическое определение вероятности

Определение 2.7 Вероятностью события называется числовая

функция p (A), удовлетворяющая аксиомам :

1. p (A) > 0.

2. p (Ω) = 1.

20

2. Основные понятия теории вероятностей

3. Для непересекающихся событий {Ai } справедливо:

p(

∞

[

Ai ) =

i=1

∞

X

p (Ai ).

(9)

i=1

Аксиома 3 называется аксиомой счетной аддитивности.

2.5

Свойства вероятности

1. p (∅) = 0.

2. A ⊂ B ⇒ p (A) 6 p (B).

3. p (Ā) = 1 − p (A).

4. p (A) 6 1.

Свойства легко доказать на основе определения. Докажем, например,

свойство 2:

Доказательство. A ⊂ B ⇒ B = A + B Ā. События A и B Ā несовместны, так как AB Ā = ∅. По аксиоме (3) p (A + B Ā) = p (A) + p (B Ā). По

аксиоме (1) p (B Ā) > 0, следовательно

p (B) = p (A + B Ā) = p (A) + p (B Ā) > p (A).

Замечание 2.1 Если пространство элементарных событий Ω = {ω}

счетно, то

X

p (A) =

p (ω)

(10)

ω∈A

и A может быть любым подмножеством Ω.

Если же Ω несчетно, не всякое подмножество Ω является событием. Здесь в качестве событий приходится выделять специальный

класс подмножеств.

2.6 σ-алгебры

Пусть F — некоторая система подмножеств множества Ω.

Определение 2.8 F называется алгеброй, если

1) Ω ∈ F,

2) A ∈ F, B ∈ F ⇒ A ∪ B ∈ F, A ∩ B ∈ F,

3) A ∈ F ⇒ A ∈ F.

21

2. Основные понятия теории вероятностей

Определение 2.9 F называется σ-алгеброй, если выполняются свойства 1, 3, а свойство 2) выполняется для любых счетных последовательностей:

∞

∞

[

\

∗

2 ) A1 , A2 , . . . , An . . . ∈ F ⇒

Ai ∈ F,

Ai ∈ F.

(11)

i=1

i=1

Таким образом, алгебра есть класс множеств, замкнутый относительно конечного числа операций дополнения, пересечения и объединения, а σалгебра — класс, замкнутый относительно счетного числа этих операций.

Рассмотрим некоторые примеры σ-алгебр.

1. {Ω, ∅}.

2. {Ω, A, Ā, ∅}, A — некоторое подмножество Ω.

3. Модель с конечным или счетным числом элементарных событий:

Ω = {ω1 , . . . , ωn },

число случайных событий равно 2n . Для каждого из этих примеров легко

проверить выполнение аксиом 1), 2∗ ), 3).

Множества из σ-алгебры F будем считать событиями. Остальные

подмножества Ω, не входящие в F, событиями не являются.

Выделение той или иной σ-алгебры обусловлено существом рассматриваемой задачи и природой множества F.

Наиболее часто используют борелевские σ-алгебры. Рассмотрим

множество B интервалов из R. Пересечение всех σ-алгебр, содержащих

B, и называется борелевской σ-алгеброй. Ее можно представить как совокупность множеств, полученных из интервалов посредством счетного числа

операций объединения, пересечения и дополнения.

Борелевская σ-алгебра на Ω = R1 содержит все интервалы с различными вариантами включения концов и все одноточечные множества, так как

\

1

1

{x} = {(x − , x + )}.

n

n

n

Пример 2.3 Пусть B∞ , B∈ — σ-алгебры подмножеств пространства

Ω. Являются ли σ-алгебрами классы множеств 1) B1 ∩ B2 ; 2) B1 ∪ B2 ;

3) B1 4 B2 ?

J 1) Да. B1 ∩ B2 замкнуто относительно счетного числа операций объединения, пересечения и дополнения.

2) Вообще говоря, нет. Например, если B1 = {Ω, A, Ā, ∅}, B2 =

{Ω, B, B̄, ∅}, то B1 ∪ B2 = {Ω, A, Ā, B, B̄, ∅} и, очевидно, не обязательно

является σ-алгеброй.

3) Нет. B1 4B2 не содержит Ω. I

22

2. Основные понятия теории вероятностей

Замечание 2.2 В дальнейшем, говоря о совокупности событий, мы будет предполагать (если противное не оговорено), что все они содержатся в одной и той же σ-алгебре F, следовательно, их счетные

объединения и пересечения тоже являются событиями.

Теперь мы можем доказать еще одно важное свойство вероятности.

2.7

Свойство непрерывности

Теорема 2.1 (Свойство непрерывности) Если A1 ⊆ A2 ⊆ · · · ⊆ An ⊆

. . . , то

[

(12)

p ( Ak ) = lim p (An ).

n→∞

k

Доказательство. Рассмотрим {Bn } :

B1 = A1 , B2 = A2 \ B1 . . . , Bn = An \

n−1

[

Bk ;

k=1

[

Ak =

k

n

[

Bk = An ,

[

p(

k=1

k

n

[

Bk .

Bk ) =

k=1

n

X

p (Bk ),

k=1

поскольку события Bk несовместны.

n

[

[

X

X

p ( Ak ) = p ( Bk ) =

p (Bk ) = lim

p (Bk ) = lim p (An ).

k

k

n→∞

k

k=1

n→∞

Теорема 2.2 (Эквивалентная формулировка свойства непрерывности)

Если A1 ⊇ A2 ⊇ · · · ⊇ An ⊇ . . . — монотонно убывающая последовательность событий, то

\

p ( Ak ) = lim p (An ).

(13)

n→∞

k

Доказательство. Перейдем к дополнительным событиям.

Ā1 ⊆ Ā2 ⊆ . . .

Тогда по предыдущему

\

[

p ( Ak ) = 1 − p ( Āk ) = 1 − lim p(Ān ) = lim (1 − p (Ān )) = lim p (An ).

k

k

n→∞

n→∞

23

n→∞

2. Основные понятия теории вероятностей

Этим свойством можно заменить аксиому счетной аддитивности (3) в

определении вероятности (2.7), то есть справедлива следующая теорема.

Теорема 2.3 В определении вероятности (2.7) аксиома счетной аддитивности (3) эквивалентна аксиомам конечной аддитивности

(3∗ ) и непрерывности (4∗ ):

(3∗ ). Для непересекающихся событий A1 , A2 , . . . An

p(

n

[

n

X

Ai ) =

i=1

p (Ai ).

i=1

(4∗ ). Если A1 ⊆ A2 ⊆ · · · ⊆ An ⊆ . . . — монотонно возрастающая

последовательность событий, то

[

p ( Ak ) = lim p (An ).

n→∞

k

Доказательство. Докажем, что из (3∗ ) и (4∗ ) следует (3). Пусть

Bn =

n

[

Ak .

k=1

Тогда

n

[

[

[

p ( Ak ) = p ( Bk ) = lim p (Bn ) = lim p ( Ak ) =

k

= lim

n→∞

2.8

n→∞

k

n

X

p (Ak ) =

k=1

n→∞

∞

X

p (Ak ).

k=1

k=1

Контрольные вопросы

1. Событие A = {Число четное}, событие B = {Число кратно 3}.

Опишите события A + B, AB, AB, A4B.

2. Обязаны ли совпадать события A и B, если B ⊆ A, A ⊆ B?

3. Верно ли равенство (A + B) \ B = A \ A B?

4. Пусть A ⊂ B. Чему равны A B и A + B?

5. Является ли операция симметрической разности коммутативной?

24

3. Вероятностное пространство

6. Является ли операция разности ассоциативной?

7. Опишите σ-алгебру подмножеств отрезка [0, 1], порожденную

множеством {[0; 0, 4], [0, 4; 1]}.

8. Может ли число всех элементов некоторой σ-алгебры равняться 14?

9. Сформулируйте отличия алгебры и σ-алгебры.

10. Приведите пример алгебры, не являющейся σ-алгеброй.

Лекция 3

Вероятностное пространство

План лекции: вероятностное пространство, классическое вероятностное пространство, геометрическое вероятностное пространство, дискретное и непрерывное вероятностное пространство.

3.1

Определение вероятностного пространства

Определение 3.1 Вероятностным пространством называется

тройка

(Ω, F, P),

где Ω — пространство элементарных событий, F — σ-алгебра подмножеств множества Ω, P — вероятностная мера, заданная на F.

Напомним аксиоматическое определение вероятности P (2.7): вероятностью события называется числовая функция p (A), удовлетворяющая

аксиомам:

1. p (A) > 0.

2. p (Ω) = 1.

3. Для непересекающихся событий {Ai } справедливо:

P(

∞

[

Ai ) =

i=1

∞

X

p (Ai ).

i=1

Рассмотрим пример построения вероятностного пространства.

Пример 3.1 Монету бросают до тех пор, пока она не выпадет два

раза подряд одной стороной. Описать вероятностное пространство. Найти вероятность того, что число подбрасываний будет

четным.

25

3. Вероятностное пространство

J Ω — множество всех конечных цепочек длины не менее 2, состоящих

из чередующихся Г, Р и заканчивающихся сочетанием ГГ или РР, а также бесконечных цепочек, состоящих из чередующихся Г, Р; F — совокупность всех подмножеств Ω. Вероятность цепочки длины n равна 21n . Вероятность того, что число подбрасываний будет четным, равна P (ГГ + ГРГГ +

ГРГРГГ + · · · + РР + РГРР + РГРГРР + . . . ) = 212 + 214 + 216 + · · · + 212 + 214 +

1

26

+ ··· = 2 ·

1

4

1− 14

= 23 . I

Рассмотрим в качестве примеров два важных вероятностных пространства.

3.2

Классическое вероятностное пространство

Ω = {ω1 , . . . , ωn }, исходы равновозможны;

F — совокупность всех подмножеств Ω,

A = {ωi1 , . . . , ωik };

kAk

k

= .

(14)

kΩk n

Это определение вероятности совпадает с классическим определением вероятности (1), поэтому примеры (1.1.1)–(1.1.6) по сути являются примерами использования классического вероятностного пространства.

p (A) =

3.3

Геометрическое вероятностное пространство

Эксперимент состоит в случайном выборе точки из ограниченного множества Ω — n-мерного евклидова пространства;

F — система подмножеств Ω, для которых имеет смысл понятие nмерного объема;

kAk

P(A) =

,

(15)

kΩk

где kAk — n-мерный объем множества A.

Рассмотрим более подробно задачи с использованием данного вероятностного пространства. При этом необходимо иметь в виду, что геометрическое определение вероятности (15) применяют только в тех случаях, когда

вероятность попадания точки в любую часть области пропорциональна мере этой части области и не зависит от ее расположения и формы.

Пример 3.2 Эксперимент состоит в случайном выборе точки из

квадрата [0, 1] × [0, 1]. Найти вероятность того, что точка отстоит от всех вершин квадрата не менее, чем на 12 .

26

3. Вероятностное пространство

J Ω — множество точек квадрата (рис. 6); F состоит из областей, для которых имеет смысл понятие площади; A — множество точек квадрата, отстоящих от всех вершин квадрата не менее, чем на 12 (на рисунке A заштриховано).

Y

1

1

2

1

0

X

Рис. 6.

P(A) =

kAk

kΩk

SA

SΩ ,

где SA — площадь области A.

2

π

π

1

SΩ = 1, SA = π ·

= , p (A) = .

2

4

4

=

I

Пример 3.3 На плоскости задан отрезок и рассматривается множество треугольников, у которых этот отрезок является наибольшей

стороной. Какова вероятность, что случайно выбранный из этого

множества треугольник — тупоугольный?

J Будем считать, что третья вершина треугольника находится в верхней полуплоскости (рис. 7).

Y

B

SΩ

SA

0

D

C X

Рис. 7.

Пусть длина отрезка равна 2a. Поскольку это — наибольшая сторона, третья вершина треугольника может располагаться только в криволинейном секторе OBC, ограниченном дугами окружностей радиуса 2a. Если третья вершина треугольника принадлежит полуокружности радиуса a с

27

3. Вероятностное пространство

центром в точке D, то треугольник прямоугольный, если она находится вне

полукруга — остроугольный, если внутри полукруга, то треугольник — тупоугольный. Таким образом, благоприятная область A — полукруг радиуса

a с центром в точке D.

SA =

πa2

,

2

SΩ найдем как

SΩ = S4 + 2(Sсект. − S4 ) = 2Sсект. − S4 .

√

2πa2

S4 = a 3, Sсект. =

.

3

√

2πa2

SΩ = 2 ·

− a2 3.

3

2

Тогда

P (A) =

p (A) =

SA

,

SΩ

πa2

2

2·

2πa2

3

3π

√ .

√ =

− a2 3 8π − 6 3

I

Пример 3.4 Испытание состоит в выборе на отрезке AB длиной l

двух случайных точек: C и D. Найти вероятность того, что длина

отрезка CD меньше 2l .

J Пусть x — длина отрезка AC, y — длина отрезка AD. Переменные x, y

могут принимать значения от 0 до l. Таким образом, можно считать, что

эксперимент состоит в случайном выборе точки из квадрата [0, l] × [0, l] и

Ω — множество точек этого квадрата. Обозначим через A описанное событие: A = {|CD| < 2l }. Запишем A с помощью введенных переменных:

A = {(x, y) : |y − x| < 2l } = {(x, y) : x − 2l < y < x + 2l }. В системе

координат XOY построим области Ω и A.

P(A) =

SΩ = l 2 ,

SA

= SA ,

SΩ

SA = l2 −

3

p (A) = .

4

I

28

l2

3l2

=

,

4

4

3. Вероятностное пространство

3.4

Дискретное и непрерывное вероятностные пространства

Рассмотрим общие определения дискретного и абсолютно непрерывного

вероятностных пространств (их примерами являются соответственно классическое и геометрическое пространства).

Определение 3.2 Пусть пространство элементарных исходов Ω —

счетное множество (Ω = {ω1 , . . . , ωn . . . }) или Ω — конечное множество (Ω = {ω1 , . . . , ωn }), F — множество всех подмножеств Ω, каждому элементарному исходу P

ωi поставлено в соответствие число

p (ωi ) из отрезка [0; 1], причем p (ωi ) = 1 и

i

P(A) =

X

p (ωi ).

(16)

i: ωi ∈A

Тогда (Ω, F, P) есть дискретное вероятностное пространство.

Определение 3.3 Пусть Ω = {(x1 , x2 , . . . , xn )} — n-мерное действительное евклидово пространство, ψ(x1 , x2 , . . . , xn ) — неотрицательная функция, интегрируемая в любой квадрируемой области из

Ω и такая, что

Z

Z

. . . ψ(x1 , x2 , . . . , xn ) dx1 dx2 . . . dxn = 1.

(17)

Ω

F — σ-алгебра, порожденная квадрируемыми областями из Ω,

Z

Z

P(A) = . . . ψ(x1 , x2 , . . . , xn ) dx1 dx2 . . . dxn .

(18)

A

Тогда (Ω, F, P) есть абсолютно непрерывное вероятностное

пространство.

Пример 3.5 Пусть Ω = (0, ∞), S — множество всех подмножеств

Ω, P — числовая функция на S :

X

p (A) =

2−k , A ∈ S,

k∈A∩N

где N = {1, 2, . . . }. Является ли (Ω, S, P ) вероятностным пространством?

J Ω задано; S — σ-алгебра как множество всех подмножеств Ω, остается

проверить выполнение аксиом для P .

1. p (A) > 0.

29

3. Вероятностное пространство

∞

P

2−k = 1.

k=1

S

P −k

P

3. Пусть A =

A

.

p

(A)

=

2

=

2−k =

i

i

k∈A∩N

k∈∩i Ai N

P P −k P

2 = p (Ai ). Следовательно, (Ω, S, P ) является вероятностным

2. p (Ω) =

i k∈Ai ∩N

i

пространством. I

3.5

Контрольные вопросы

1. Дайте определение вероятностного пространства.

2. В чем состоят отличия классического вероятностного пространства от общего дискретного вероятностного пространства?

3. Сформулируйте определение классического вероятностного

пространства как частный случай определения дискретного вероятностного пространства.

4. Испытание состоит в бросании правильной игральной кости.

Постройте классическое вероятностное пространство.

5. Испытание состоит в бросании игральной кости. Укажите хотя бы три способа построить пространство элементарных событий Ω.

6. Испытание состоит в бросании игральной кости, Ω = {A, B},

где A = {1}, B = {2, 3, 4, 5, 6}. Укажите хотя бы три способа построить σ-алгебру.

7. Испытание состоит в бросании игральной кости, Ω = {A, A},

где A = {1}, σ-алгебра F = {Ω, A, A, ∅}. Укажите хотя бы три

способа задать вероятностную меру и уточните, к каким моделям будут применимы полученные вероятностные пространства (кость может быть неправильной).

8. Дайте определение геометрического вероятностного пространства.

9. В чем состоят отличия геометрического вероятностного пространства от общего непрерывного вероятностного пространства?

30

4. Независимые события

10. Сформулируйте определение геометрического вероятностного

пространства как частный случай определения непрерывного

вероятностного пространства.

11. Сформулируйте различия понятий «элементарное событие» и

«случайное событие».

12. Обязательно ли элементарное событие является случайным событием?

13. Может ли в некотором вероятностном пространстве число

элементарных событий быть строго больше, чем число всех событий?

Лекция 4

Независимые события

План лекции: независимость двух событий, независимость попарная и в совокупности, условная вероятность, теорема умножения, лемма Бореля — Кантелли.

4.1

Независимость двух событий

Определение 4.1 События A и B называются независимыми, если

p (AB) = p (A)p (B).

(19)

Свойства независимых событий

1. Если A и B независимы, то независимы A и B̄, Ā и B, Ā и B̄.

2. Если A и B независимы, A и C независимы, BC = ∅, то независимы A и B + C.

Пример 4.1 Монету бросают n раз ( n > 1 ).

A = {герб выпадает не более одного раза},

B = { герб и решка выпадают не менее одного раза каждый }.

Исследовать зависимость событий A и B.

J

1

n

n+1

+

=

,

2n 2n

2n

1

1

1

p (B) = 1 − p (B̄) = 1 − [p (Г = 0) + p (Р = 0)] = 1 − n − n = 1 − n−1 ,

2

2

2

p (A) = p (Г = 0) + p (Г = 1) =

31

4. Независимые события

p (AB) = p (Г = 1, Р > 1) = p (Г = 1).

Поскольку n > 1, то

p (Г = 1, Р > 1) = p (Г = 1)

то есть

n

.

2n

События независимы, если p (AB) = p (A)p (B), то есть,

p (AB) = p (Г = 1) =

1

1

n

(n + 1)( )n · (1 − ( )n−1 ) = n ,

2

2

2

n + 1 = 2n−1 ,

что верно только при n = 3.

Таким образом, события независимы при n = 3, зависимы при остальных n. I

4.2

Независимость попарная и в совокупности

Определение 4.2 События A1 , . . . An называются независимыми (в

совокупности), если для всех 1 6 i1 < i2 < · · · < im 6 n, m 6 n,

p(

m

\

Aik ) =

k=1

m

Y

p (Aik ).

(20)

k=1

Замечание 4.1 Из попарной независимости событий не обязательно

следует независимость в совокупности.

Пример 4.2 Опыт состоит в случайном выборе одной из четырех

карточек:

1 2 3 123

Ai = {на выбранной карточке есть цифра i“}.

”

1

1

p (Ai ) = , i = 1, 2, 3; p (A1 A2 ) = p (A2 A3 ) = p (A1 A3 ) = .

2

4

Для любых i 6= j p (Ai Aj ) = p (Ai )p (Aj ), что означает попарную независимость.

Однако

1

p (A1 A2 A3 ) = 6= p (A1 )p (A2 )p (A3 ),

4

то есть события зависимы в совокупности.

32

4. Независимые события

4.3

Лемма Бореля — Кантелли

Эта лемма носит также название «Критерий 0 и 1». Она является частным

случаем так называемых законов нуля и единицы. Позднее мы познакомимся еще с некоторыми законами из этой большой группы теорем.

Теорема 4.1 (лемма Бореля — Кантелли)

тельность событий

A1 , A2 , . . . , An . . . ;

Если ряд

P

26

Рассмотрим последова-

pk = p (Ak ).

pk сходится, то с вероятностью 1 может произой-

k

ти лишь конечное число

P событий из последовательности событий

A1 , A2 , . . . , а если ряд

pk расходится и события A1 , A2 , . . . незавиk

симы, то с вероятностью 1 происходит бесконечное число событий

из последовательности A1 , A2 , . . . .

P

Доказательство. 1.Пусть pk < ∞. Обозначим

k

Bn =

[

Ak ,

B=

\

Bn =

\[

n k>n

n

k>n

Ak .

Событие B означает, что происходит бесконечное число событий из последовательности A1 , A2 , . . . .

[

Bn =

Ak , ⇒ B1 ⊇ B2 ⊇ . . .

k>n

По свойству непрерывности

p (B) = lim p (Bn ).

n→∞

Но, так как ряд

P

pk сходится,

k

p (Bn ) 6

X

pk → 0

k>n

при n → ∞.

Следовательно,

p (B) = lim p (Bn ) = 0.

n→∞

2.

B̄ =

[\

Āk .

n k>n

26

Франче́ско Па́оло Канте́лли (ит. Francesco Paolo Саntelli; 1875—1966) — итальянский математик.

33

4. Независимые события

Событие B̄ означает, что происходит конечное число событий из последовательности A1 , A2 , . . . .

n+m

\

\

Āk .

Āk ⊆

B̄n =

k=n

k>n

n+m

\

p (B̄n ) 6 p (

Āk ) =

n+m

Y

p (Āk ) = (1 − pn ) . . . (1 − pn+m ) 6

k=n

k=n

−pn

−pn+m

−

Pn+m

6 e ...e

= e k=n pk → 0.

P

P

(Поскольку ряд k pk расходится, n+m

k=n pk → ∞ при m → ∞.)

Тогда p (B̄n ) = 0 для любого n = 1, 2, . . .

p (B̄) 6

X

p (B̄n ) = 0,

n

p (B) = 1 − p (B̄) = 1.

4.4

Условная вероятность

Определение 4.3 Условной вероятностью события A при условии,

что произошло событие B, называется отношение

p (A/B) =

p (AB)

,

p (B)

(p (B) > 0).

(21)

Пример 4.3 Брошены три игральные кости. Какова вероятность того, что на всех костях выпали шестерки, если известно, что по крайней мере на одной кости выпала шестерка?

J Пусть

A = {на всех костях выпали шестерки},

B = {по крайней мере на одной кости выпала шестерка}.

Заметим, что A влечет B, поэтому AB = A.

p (AB)

p (A)

p (A/B) =

=

.

p (B)

p (B)

3

1

5

p (A) = 3 , p (B) = 1 −

.

6

6

1

p (A/B) = .

91

I

34

4. Независимые события

4.5

Теорема умножения

Теорема 4.2 (Теорема умножения) Пусть p (B) 6= 0. Тогда

(22)

p (AB) = p (A/B)p (B).

Эта теорема вытекает из определения (21). Теорему умножения можно

обобщить для n событий:

Теорема 4.3 (Теорема умножения для n событий) Пусть

p (A1 ) 6= 0, . . . , p (An−1 ) 6= 0. Тогда

p (A1 A2 . . . An ) = p (A1 )p (A2 /A1 ) . . . p (An /A1 A2 . . . An−1 ).

(23)

Доказательство. Для n = 1, 2 индуктивное предположение верно. Пусть

верно для n − 1. Обозначим

C=

n−1

\

Ai ;

A1 A2 . . . An = C ∩ An .

i=1

p (A1 A2 . . . An ) = p (C)p (An /C) =

= p (A1 )p (A2 /A1 ) . . . p (An /A1 A2 . . . An−1 ).

Замечание 4.2 Для независимых событий

p (A1 A2 . . . An ) =

n

Y

p (Aik ).

k=1

Пример 4.4 В компьютерной игре каждую секунду с вероятностью

p вылетает пчела, которая поражает игрока, если он находится в

опасной зоне. Вылеты пчелы — независимые события. Для пересечения зоны поражения требуются 3 секунды. Вылеты пчелы видны заранее, поэтому можно дождаться 3 безопасных секунд. Какова вероятность того, что игроку придется ждать 4 секунды?

J Ровно 4 секунды придется ждать в том случае, когда нельзя стартовать

в первые 4 секунды, а пятая, шестая и седьмая секунды будут безопасными. Рассмотрим первые 4 секунды. Заметим, что четвертая секунда не может быть безопасной, так как иначе можно было бы стартовать раньше. В

первые три секунды возможны различные варианты, кроме одного — трех

безопасных секунд. Обозначим

A = {Ждать придется 4 секунды},

35

5. Теоремы исчисления вероятностей

Ai = {Появление пчелы в i − ю секунду},

A = Ā1 Ā2 Ā3 A4 Ā5 Ā6 Ā7 .

p (A) = (1 − (1 − p)3 )p (1 − p)3 .

I

4.6

Контрольные вопросы

1. Может ли событие не зависеть от самого себя?

2. Независимы ли ∅ и любое событие A?

3. Независимы ли Ω и любое событие A?

4. Является ли транзитивным для событий отношение независимости?

5. Является ли транзитивным для событий отношение зависимости?

6. События несовместны. Что можно сказать о их зависимости?

7. События независимы. Что можно сказать о их совместности?

8. Приведите пример, показывающий, что из попарной независимости событий не обязательно следует независимость в совокупности.

9. Сформулируйте теорему умножения для 3 событий.

10. Сформулируйте теорему умножения для независимых событий.

11. Сформулируйте эквивалентное определение независимости

двух событий, использующее условную вероятность.

Лекция 5

Теоремы исчисления вероятностей

План лекции: теорема сложения, формула полной вероятности,

теорема Байеса.

36

5. Теоремы исчисления вероятностей

5.1

Теорема сложения

По аксиоме счетной аддитивности вероятность суммы несовместных событий равна сумме их вероятностей.

p (A1 + A2 + · · · + An ) = p (A1 ) + p (A2 ) + · · · + p (An ).

Но это соотношение справедливо лишь для несовместных событий. В случае совместных событий вероятность суммы событий можно найти с помощью теоремы сложения вероятностей. Рассмотрим вначале теорему сложения вероятностей для двух событий.

Теорема 5.1 (Теорема сложения для двух событий) Для любых событий A и B

p (A ∪ B) = p (A) + p (B) − p (AB).

(24)

Доказательство.

A = A · Ω = A(B + B̄) = AB + AB̄, B = BA + B Ā,

A ∪ B = AB + AB̄ + B Ā.

Все слагаемые в правых частях несовместны, поэтому

p (A) = p (AB) + p (AB̄), p (B) = p (AB) + p (ĀB),

p (A ∪ B) = p (AB) + p (AB̄) + p (ĀB).

Выразим p (AB̄) и p (ĀB) из предыдущих равенств и подставим в

p (A ∪ B) :

p (A ∪ B) = p (A) + p (B) − p (AB).

Пример 5.1 Найти вероятность того, что случайно выбранное натуральное число делится на 2 или на 3.

J Пусть

A = {число делится на 2},

B = {число делится на 3}.

1 1 1 2

p (A ∪ B) = p (A) + p (B) − p (AB) = + − = .

2 3 6 3

I

37

5. Теоремы исчисления вероятностей

Замечание 5.1 Разумеется, теорема (5.1) применима и для несовместных событий.

Пример 5.2 В урне находится 4 белых и 2 черных шара. Наугад вынимают 3 шара. Найти вероятность того, что среди них не меньше

двух белых.

J Пусть

A = {вынуто не меньше 2 белых},

B = {вынуто 2 белых, 1 черный шар},

C = {вынуто 3 белых}.

A = B + C, p (A) = p (B) + p (C) − p (BC),

но события B и C несовместны, поэтому p (BC) = 0 и

p (A) = p (B) + p (C).

Число всех исходов равно

n = C63 =

6!

= 20.

3!3!

Число благоприятных исходов для B:

4!

· 2 = 12.

2!2!

n(B) 12

p (B) =

=

= 0, 6.

n

20

Число благоприятных исходов для C:

4!

n(C) = C43 =

= 4.

3!1!

4

n(C)

=

= 0, 2.

p (C) =

n

20

p (A) = p (B) + p (C) = 0, 6 + 0, 2 = 0, 8.

n(B) = C42 · C21 =

.I

Теорема сложения вероятностей легко обобщается на случай n событий.

Теорема 5.2 (Теорема сложения для n событий) Для любых событий

A1 . . . An

p(

n

[

Ai ) =

i=1

+

X

n

X

p (Ai ) −

i=1

X

p (Ai Aj )+

16i<j6n

p (Ai Aj Ak ) − · · · + (−1)n−1 p (A1 . . . An ).

16i<j<k6n

38

(25)

5. Теоремы исчисления вероятностей

Доказательство. Для n = 1, 2 верно. Пусть верно для n − 1.

p(

n

[

Ai ) =

i=2

n

X

X

p (Ai ) −

i=2

X

p (Ai Aj ) +

26i<j6n

p (Ai Aj Ak ) − . . .

26i<j<k6n

+(−1)n−2 p (A2 . . . An ).

Применим эту формулу к A1 Ai :

p(

n

[

A1 Ai ) =

i=2

n

X

X

p (A1 Ai )−

i=2

X

p (A1 Ai Aj )+

26i<j6n

p (A1 Ai Aj Ak )−. . .

26i<j<k6n

+(−1)n−2 p (A1 . . . An ).

n

n

n

n

[

[

[

[

p ( Ai ) = p (A1 Ai ) = p (A1 ) + p ( Ai ) − p ( A1 Ai ).

i=1

i=2

i=2

Подставим полученные выражения для p (

n

S

Ai ) и p (

i=2

p(

n

[

Ai ) = p (A1

i=1

=

n

X

n

[

p (Ai )−

X

n

[

X

A1 Ai ) в p (

n

S

Ai ):

i=1

Ai ) − p (

i=2

p (Ai Aj )+

16i<j6n

i=1

n

S

i=2

Ai ) = p (A1 ) + p (

i=2

i=2

n

[

A1 Ai ) =

i=2

p (Ai Aj Ak )−· · ·+(−1)n−1 p (A1 . . . An ).

16i<j<k6n

Пример 5.3 (Задача о совпадениях) Случайным образом n писем

вкладываются в n подписанных конвертов. Найти вероятность

того, что хотя бы 1 письмо вложено правильно.

S

J Пусть Ak = {k-е письмо вложено в k-й конверт}, A = nk=1 Ak . По теореме сложения

p(

n

[

Ai ) =

i=1

n

X

X

p (Ai ) −

i=1

X

p (Ai Aj ) +

16i<j6n

p (Ai Aj Ak ) − . . .

16i<j<k6n

+(−1)n−1 p (A1 . . . An ).

Обозначим

p1 =

n

X

p (Ai ),

p2 =

i=1

p3 =

X

p (Ai Aj ),

16i<j6n

X

p (Ai Aj Ak ), . . . .

16i<j<k6n

39

5. Теоремы исчисления вероятностей

Найдем вероятность события Ak1 Ak2 . . . Akm . В наборе из n номеров

k1 , . . . , km фиксированы, а остальные n − m можно произвольно переставлять, поэтому

(n − m)!

.

p (Ak1 Ak2 . . . Akm ) =

n!

Число слагаемых в сумме, составляющей pm , равно числу способов

выбора m индексов среди n индексов, то есть Cnm , а каждое слагаемое равно

(n−m)!

n! . Ввиду этого

1

(n − m)!

=

.

pm = Cnm

n!

m!

Из теоремы сложения следует, что

n

[

p ( Ai ) = p1 − p2 + p3 − · · · + (−1)n−1 pn .

i=1

p (A) = 1 −

1

1

1

+ − · · · + (−1)n−1 .

2! 3!

n!

Легко видеть, что

p (A) → 1 − e−1 при n → ∞.

I

Пример 5.4 Доказать, что для произвольных случайных событий

A, B, C

p (ABC) > p (A) + p (B) + p (C) − 2.

J По теореме сложения для двух событий A и B

1 > p (A + B) = p (A) + p (B) − p (AB) ⇒ p (AB) > p (A) + p (B) − 1.

Применим теперь теорему сложения к событиям AB и C:

1 > p (AB + C) = p (AB) + p (C) − p (ABC) ⇒

p (ABC) > p (AB) + p (C) − 1 > p (A) + p (B) + p (C) − 2.

I

5.2

Формула полной вероятности

Теорема 5.3 (Формула полной вероятности) Пусть A — случайное

событие, H1 , H2 , . . . , Hn —

Snпопарно несовместные случайные события, p (Hi ) > 0 и A ⊂ i=1 Hi . Тогда справедлива формула полной

вероятности:

n

X

p (A) =

p (Hi )p (A/Hi ).

(26)

i=1

40

5. Теоремы исчисления вероятностей

Доказательство.

Используем

аксиому аддитивности и теорему умножения.

Sn

Sn

A = A ∩ ( i=1 Hi ) = i=1 AHi .

p (A) = p (

n

[

AHi ) =

i=1

n

X

p (Hi )p (A/Hi ).

i=1

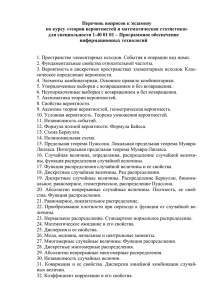

H2

H1

H3

A

H4

Ω

Рис. 8. Гипотезы Hi .

Пример 5.5 На сборку телевизоров поступают микросхемы от двух

поставщиков, причем 70% микросхем поставляет первый, а 30% —

второй. В продукции первого поставщика бракованные микросхемы

составляют 2%, в продукции второго — 3%. Какова вероятность

того, что взятая наудачу микросхема окажется бракованной?

J Пусть A = {Микросхема является бракованной},

H1 = {Микросхема поступила от первого поставщика},

H2 = {Микросхема поступила от второго поставщика}.

p (H1 ) = 0, 7,

p (H2 ) = 0, 3;

p (A/H1 ) = 0, 02,

p (A/H2 ) = 0, 03.

По формуле полной вероятности

p (A) = p (H1 )p (A/H1 ) + p (H2 )p (A/H2 ) =

0, 7 · 0.02 + 0, 3 · 0.03 = 0, 023.

I

Пример 5.6 (Задача о разорении) Игроки А и В ведут игру до полного разорения одного из них. Капитал первого равняется a, капитал

второго — b. Вероятность выигрыша каждой партии для игрока А

равна p, а для игрока В — q, (p + q = 1). В каждой партии выигрыш

одного (и проигрыш другого) равняется 1. Результаты отдельных

партий независимы. Найти вероятность разорения каждого из игроков при p = q = 21 .

41

5. Теоремы исчисления вероятностей

J Пусть P (x) — вероятность разорения первого игрока, имеющего капитал

x.

H1 = {Выигрыш им очередной партии},

H2 = {Проигрыш им очередной партии}, p (H1 ) = p,

p (H2 ) = q.

По формуле полной вероятности

P (x) = p · P (x + 1) + q · P (x − 1),

P (0) = 1,

P (a + b) = 0.

По условию p = q = 12 .

1

1

P (x) = P (x + 1) + P (x − 1),

2

2

P (x) − P (x + 1) = P (x − 1) − P (x) = c,

P (x + 1) = P (x) − c,

Отсюда

c=

c — const.

P (1) = 1 − c, . . . , P (a + b) = 1 − (a + b)c = 0.

a

b

1

иP (a) = 1 −

=

.

a+b

a+b a+b

I

Пример 5.7 В одной из двух урн, в каждой из которых 10 шаров, один

шар отмечен. С вероятностью 3/4 он находится в первой урне, с

вероятностью 1/4 — во второй. Играющий имеет право последовательно извлекать с возвращением 20 шаров из любой урны. Как следует распорядиться этим правом, чтобы вероятность извлечения

хотя бы один раз отмеченного шара была бы наибольшей?

J

H1 = {Отмеченный шар находится в первой урне},

H2 = {Отмеченный шар находится во второй урне},

A = {Извлечение хотя бы один раз отмеченного шара}.

p (H1 ) = 3/4,

p (H2 ) = 1/4.

Пусть из первой урны извлекают m шаров, а из второй — 20 − m. Тогда

p (A/H1 ) = 1 − (0, 9)m ,

p (A/H2 ) = 1 − (0, 9)20−m .

По формуле полной вероятности

p (A) = 3/4 · (1 − (0, 9)m ) + 1/4 · (1 − (0, 9)20−m ).

42

5. Теоремы исчисления вероятностей

Найдем m, максимизирующее p (A), то есть, минимизирующее y(m) :

y(m) = 3 · (0, 9)m + (0, 9)20−m .

y 0 (m) = (3 · (0, 9)m − (0, 9)20−m ) ln 0, 9.

20 1 ln 3

y 0 (m) = 0 ⇒ (0, 9)2m−20 = 1/3 ⇒ m =

− ·

.

2

2 ln 0, 9

y 00 (m) = (3 · (0, 9)m + (0, 9)20−m ) ln2 0, 9 > 0,

следовательно, это точка минимума y(m).

Таким образом, наибольшая вероятность p при вынимании m = 10 −

1

ln 3

2 · ln 0,9 ≈ 15, 26 ≈ 15 шаров из первой урны. I

5.3

Формула Байеса

Теорема 5.4 (формула Байеса) Пусть

A — случайное

событие,

H1 , HS2 , . . . , Hn попарно несовместны, p (Hi ) > 0, p (A) > 0 и

A ⊂ ni=1 Hi . Тогда справедлива формула Байеса:

p (Hi )p (A/Hi )

.

p (Hi /A) = Pn

p

(H

)p

(A/H

)

i

i

i=1

(27)

Доказательство.

p (AHi ) = p (A/Hi )p (Hi ) = p (Hi /A)p (A) ⇒

p (Hi /A) =

p (Hi )p (A/Hi )

p (Hi )p (A/Hi )

.

= Pn

p (A)

i=1 p (Hi )p (A/Hi )

Пример 5.8 В условиях примера (5.5) взятая наудачу микросхема

оказалась бракованной. Найти вероятность того, что микросхема

поступила от первого поставщика.

J По условию на сборку телевизоров поступают микросхемы от двух поставщиков, причем 70% микросхем поставляет первый, а 30% — второй. В

продукции первого поставщика бракованные микросхемы составляют 2%,

в продукции второго — 3%. Пусть

A = {Микросхема является бракованной},

H1 = {Микросхема поступила от первого поставщика},

H2 = {Микросхема поступила от второго поставщика}.

43

5. Теоремы исчисления вероятностей

p (H1 ) = 0, 7,

p (H2 ) = 0, 3;

p (A/H1 ) = 0, 02,

p (A/H2 ) = 0, 03.

По формуле Байеса

p (H1 )p (A/H1 )

.

p (H1 )p (A/H1 ) + p (H2 )p (A/H2 )

0, 7 · 0.02

p (H1 /A) =

.

0, 7 · 0.02 + 0, 3 · 0.03

0, 014

p (H1 /A) =

≈ 0, 609.

0, 023

p (H1 /A) =

I

Пример 5.9 В техникуме n студентов, из которых nk (k = 1, 2, 3)

человек учатся k-й год. Среди двух наудачу выбранных студентов

оказалось, что один из них учится дольше второго. Какова вероятность того, что этот студент учится третий год?

J Обозначим {i, j} событие,состоящее в том, что один студент учится i-й

год, а другой — j-й год.

H1 = {1, 2}, H2 = {2, 3}, H3 = {1, 3}, A = {(i, j) : i < j или j < i}.

Cn11 · Cn12

2n1 n2

p (H1 ) =

=

,

2

Cn

n(n − 1)

2n1 n3

2n2 n3

, p (H3 ) =

.

p (H2 ) =

n(n − 1)

n(n − 1)

p (A/Hi ) = 1, i = 1, 2, 3.

По формуле полной вероятности

2n1 n2 + 2n2 n3 + 2n1 n3

p (A) =

,

n(n − 1)

p ((H2 + H3 )/A) = p (H2 /A) + p (H3 /A).

По формуле Байеса

p (H2 /A) =

=

2n1 n3

n(n−1)

2n1 n2 +2n2 n3 +2n1 n3

n(n−1)

p (H2 )p (A/H2 )

=

p (A)

=

n2 n3

.

n1 n2 + n2 n3 + n1 n3

n2 n3 + n1 n3

p ((H2 + H3 )/A) =

=

n1 n2 + n2 n3 + n1 n3

I

44

1

n1

1

n1

+

1

n2

+

1

n2

+

1 .

n3

6. Схемы испытаний

5.4

Контрольные вопросы

1. Сформулируйте теорему сложения для 3 событий.

2. Сформулируйте теорему сложения для несовместных событий.

3. Приведите геометрическую интерпретацию теоремы сложения для 4 событий.

4. Приведите интерпретацию теоремы сложения для n событий

как формулы включений и исключений.

5. p (A1 ) = 0, 7, p (A2 ) = 0, 6. Каковы максимальное и минимальное

возможные значения p (A1 A2 )?

6. p (Ai ) = 0, 9, i = 1, 2, 3, 4. Каковы максимальное и минимальное возможные значения p (A1 A2 A3 A4 )?

7. Докажите формулу полной вероятности.

8. Сформулируйте и докажите формулу Байеса.

9. Предложите множество гипотез {Hi } для решения следующей

задачи.

«С вероятностью 0,6 учебник находится на одной из трех полок. После просмотра двух полок учебник не обнаружен. Какова

вероятность того, что учебник на третьей полке?»

10. Предложите множество гипотез {Hi } для решения следующей

задачи. «Два студента сдавали экзамен. Предварительная вероятность сдать экзамен на «отлично» у первого студента 0,9,

у второго 0,6. Известно, что только один из них сдал экзамен на

«отлично». Какова вероятность, что это второй студент?»

Лекция 6

Схемы испытаний

План лекции: независимые испытания, схема Бернулли, свойства биномиальных вероятностей, полиномиальная схема, пример зависимых испытаний, гипергеометрические вероятности,

предельные теоремы для гипергеометрических вероятностей.

45

6. Схемы испытаний

6.1

Независимые испытания

Определение 6.1 Рассмотрим

испытания

S1 , S2 , . . . , Sn ,

соответствующие им вероятностные пространства

и

(Ω1 , F1 , P1 ), (Ω2 , F2 , P2 ), . . . , (Ωn , Fn , Pn ),

а также составное испытание S с вероятностным пространством

(Ω, F, P), где

Ω = Ω1 × Ω2 × · · · × Ωn ,

(элементарное событие интерпретируется как цепочка исходов в n

последовательных испытаниях); F — σ-алгебра, порожденная прямым произведением

F = F1 × F2 × · · · × Fn .

Испытания S1 , S2 , . . . , Sn независимы, если ∀A

A = A1 × A2 × · · · × An ,

Ai ∈ Fi ,

i = 1, 2, . . . , n,

справедливо

p (A) = p1 (A1 ) · p2 (A2 ) · · · · · pn (An ) =