Часть 2. Классификация случайных процессов

advertisement

Часть 2

КЛАССИФИКАЦИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ

После введения вероятностного описания случайных процессов можно дать их классификацию с учетом тех или иных ограничений, которые

предъявляются к их вероятностным характеристикам.

2.1. СТАЦИОНАРНЫЕ СЛУЧАЙНЫЕ ПРОЦЕССЫ

Важным классом случайных процессов являются стационарные случайные процессы. Эмпирическое представление о стационарном случайном процессе можно получить, если наблюдать какие-либо флуктуации

параметра, характеризующего физический процесс, при неизменных макроскопических условиях. Другими словами, стационарный случайный

процесс является устойчивым во времени. В связи с этим вводят формальное определение стационарного процесса.

Случайный процесс (t ) называется стационарным в узком смысле,

если все конечномерные функции распределения любого порядка инвариантны относительно сдвига по времени, т. е. при любых n и t0 справедливо равенство

F ( x1, t1; , xn , tn )

F ( x1, t1 t0 ; , xn , tn t0 ) .

(2.1)

Это значит, что вероятностные характеристики стационарного случайного процесса (t ) не меняются при изменении начала отсчета времени наблюдения на произвольную величину t0 . Разумеется, что аналогичное равенство должно выполняться и для плотностей вероятностей

w( x1, t1; , xn , tn ) w( x1, t1 t0 ; , xn , tn t0 ) ,

(2.2)

а также для характеристических, моментных и корреляционных функций.

Из определения стационарности (2.2), в частности, следует:

(2.3.а)

w( x1, t1 ) w( x1, t1 t1 ) w( x1 ) , если t0 t1 ;

где

w( x1, t1; x2 , t2 ) w( x1, t1 t1; x2 , t2 t1 ) w( x1, x2 , ) ,

t2 t1 .

(2.3.б)

Соотношение (2.3.а) показывает, что одномерная плотность вероятности стационарного в узком смысле случайного процесса вообще не за21

висит от времени. Двумерный закон распределения для стационарного

процесса (2.3.б) зависит только от разности моментов времени, для которых выбраны ординаты случайных функций.

Из определения стационарности следует, что стационарный случайный процесс не имеет начала и конца. В противном случае, переместив

точку наблюдения t0 в начало или конец процесса, получим другое распределение вероятностей, что противоречит определению стационарности.

Математическое ожидание (среднее значение) стационарного в узком

смысле случайного процесса также не зависит от времени

m

M { (t )}

xw( x)dx .

(2.4)

Корреляционная и ковариационная функции зависят лишь от разности аргументов

t2 t1 :

K (t1 , t2 )

M { (t1 ) (t2 )}

x1 x2 w(x1 , x2 , )dx1dx2

K ( );

(2.5)

R (t1, t2 )

M {[ (t1 ) m ][ (t2 ) m ]}

( x1 m )( x2 m ) w( x1 , x2 , )dx1dx2 .

(2.6)

Причем

R( )

K ( ) m2 .

(2.7)

Дисперсия стационарного процесса постоянна и равна значению корреляционной функции при нулевом значении аргумента:

D

2

M {[ (t ) m ]2 } R (0)

( x m ) 2 w( x)dx

M { 2 (t )} m 2 .

(2.8)

Пример стационарного в узком смысле случайного процесса

Рассмотрим случайный процесс (t ) , представляющий гармоническое колебание, у которого амплитуда и частота постоянны, а фаза

–

случайная величина

22

(t )

A0 sin(

0t

), t [

, ].

(2.9)

Необходимым и достаточным условием стационарности в узком

смысле этого процесса является равномерное распределение фазы

w ( ) 12 ,0

2 .

Функция распределения процесса (2.9) полностью определяется распределением случайной фазы. Пусть t1 t t0 , тогда из (2.9) следует, что

(t1 )

где

0t0

1

A0 sin(

0t

1 ),

0.

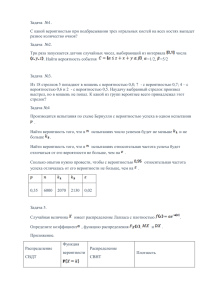

Плотность вероятности случайной фазы

фазы

1

(2.10)

процесса

процесса (t ) и случайной

(t1 ) после временого сдвига изображены на рис. 2.1.

Так как фазы, отличающиеся на 2 , не изменяют значений процесса, то

при их равномерном распределении справедливо равенство

w ( )

w 1( ),

т. е. равномерная плотность вероятности фазы инвариантна сдвигу процесса во времени.

w ( )

w

1

( )

0

1/2π

0

1/2π

2

0

0

2

0

Рис. 2.1. Плотности распределения начальной фазы

При неравномерном распределении фазы случайный процесс (2.9)

перестает быть стационарным, т. к. плотности w ( ) и w 1 ( ) не совпадают.

При решении некоторых практических задач (в рамках корреляционной теории) многомерные плотности вероятности не рассматривают, а

оперируют только математическими ожиданиями и корреляционной (ковариационной) функцией. В связи с этим вводится понятие стационарности в широком смысле.

23

Стационарный процесс (t ) с конечной дисперсией называется стационарным в широком смысле, если его математическое ожидание и корреляционная (ковариационная) функция инвариантны относительно сдвига во времени, т. е. математическое ожидание постоянно (не зависит от

времени), а корреляционная функция зависит только от разности аргументов

0:

t2 t1 и конечна при

m

const; K (t1 , t2 )

K (t1 t2 )

K ( ).

(2.11)

На основании (2.4) (2.6) заключаем, что случайные процессы, стационарные в узком смысле, всегда стационарны и в широком смысле. Однако обратное утверждение в общем случае неверно.

Для гауссовых стационарных процессов, плотности вероятности которых полностью определяются математическим ожиданием и корреляционной функцией, понятие стационарности в узком и широком смыслах

полностью совпадают.

2.2. ЭРГОДИЧЕСКИЕ СЛУЧАЙНЫЕ ПРОЦЕССЫ

До сих пор характеристики случайных процессов (плотности вероятности, моментные функция и др.) были определены через соответствующие статистические средние значения ("поперек процесса" ), т. е. средние

значения большого числа реализаций в ансамбле идентичных систем. Оказывается, что для многих стационарных случайных процессов указанные

характеристики можно получить путем усреднения соответствующих величин "вдоль процесса", т. е. по одной реализации достаточно большой

длительности. Такая возможность физически может быть оправдана тем,

что стационарный случайный процесс протекает однородно во времени.

Представим себе, что длинная реализация стационарного процесса разбита

на "куски" примерно одинаковой длительности. Для ряда стационарных

процессов каждый из таких "кусков" можно рассматривать в качестве

"полномочного представителя" отрезка реализации отдельного члена статистического ансамбля одинаковых систем. Стационарные случайные

процессы, для которых это справедливо, называются эргодическими или

говорят, что стационарный процесс обладает эргодическими свойствами.

Свойство эргодичности важно потому, что при его наличии имеют

место чрезвычайно существенные соотношения между функцией распределения и временем пребывания случайной функции (t ) в определенном

интервале значений, а также между статистическими средними и средними по времени.

24

Экспериментатор за данный промежуток времени Т чаще всего может получить лишь одну реализацию интересующего его случайного процесса и предпочитает поэтому усреднять по времени, пользуясь одной

реализацией (t ) . Спрашивается, в каком соотношении находятся эти

способы усреднения – по времени и по ансамблю?

Сформулируем в общем виде эргодическое свойство случайного процесса (не обязательно стационарного).

Имеем случайный процесс (t ) , для которого определены одномерная w( x, t ) и двумерная w( x, t; x , t ) плотности вероятности. Пусть

f [ (t )] – некая детерминированная функция от (t ) . Введем ее среднее

по времени за промежуток [0, T ] в виде

f [ (t )]

1

T

T

f [ (t )]dt ,

0

где f [ (t )] – случайная величина, различная для разных реализаций

(t ) на интервале [0, T ] .

Определение: Случайный процесс, для которого усреднения по ансамблю

и по времени дают одинаковые результаты, называется эргодическим.

Теорема 1. Необходимым и достаточным условием эргодичности случайного процесса (t ) является выполнение равенства

1

lim 2

T

T

где R f (t , t )

T T

R f (t , t )dtdt

0,

(2.12)

0 0

K f (t , t ) m f (t )m f (t )

TT

–

f ( x) f ( x )[ w( x, t ; x , t ) w( x, t ) w( x , t )]dxdx

ковариационная

0 0

функция случайного процесса

Доказательство:

f [ (t )] .

Так как f [ (t )] – случайная величина, то для нее справедливо неравенство Чебышева

P{ f ( ) M { f ( )}

}

25

D{ f ( )}

2

.

(2.13)

Вычислим математическое ожидание и дисперсию случайной величины f [ (t )] :

1

M { f ( )} M

1

T

T

T

1

f [ (t )]dt

T

0

T

M { f [ (t )]}dt

0

T

T

dt

f ( x) w( x, t )dx

f ( x)dx w( x, t )dt

0

0

f ( x) pT ( x)dx ,

1

где pT ( x)

T

(2.14)

T

w( x, t )dt –

(2.15)

0

эффективная плотность вероятности (средняя за время T);

2

D{ f ( )} M { f ( )} [ M { f ( )]

M

1

T

2

T

f ( )dt

0

M

1

T2

M

1

T

T2

f ( x)dt M

0

M

1

T

2

T

f ( )dt

0

TT

1

T

2

1

T

f ( x) f ( x )dtdt

0 0

T

f ( x )dt

0

TT

[ M { f ( x) f ( x )} M { f ( x)}M { f ( x )}]dtdt

0 0

1

T2

T T

R f (t , t )dtdt ,

(2.16)

0 0

где R f (t , t ) – функция ковариации процесса f ( ) , которая определена

выше.

Следовательно, если выполнимо (2.12), т. е. предел стремится к нулю,

то и дисперсия процесса D{ f ( )} тоже стремится к нулю. Тогда, в силу

26

неравенства Чебышева (2.13), условие (2.12) необходимо и достаточно для

сходимости по вероятности

p

f [ (t )]

M { f [ (t )]} ,

(2.17)

T

или в развернутой форме

1

T

T

p

f [ (t )] dt

f ( x) pT ( x)dx ,

T

0

(2.18)

где "эффективная" плотность вероятности pT (x) задается формулой (2.15).

Можно сказать, что это закон больших чисел в применении к непрерывному наблюдению.

Определение: Относительным временем пребывания процесса в интервале ( x, x dx) называется отношение суммарного времени, проведенного

процессом выше уровня x, но ниже уровня x dx к полной

продолжительности интервала T. То есть отношение суммы всех отмеченных на рис. 2.1 жирной линией отрезков оси абсцисс от момента 0 до момента T к полной продолжительности интервала T:

n

Tx , x

ti ;

dx

i 1

Tx, x

T

dx

– относительное время пребывания.

(t )

x+dx

x

Δt1

0

Δt2

Δt3

Δtn-1

Δtn

t

Рис. 2.1. Определение относительного времени пребывания

Теорема 2. Если процесс эргодичен (т. е. выполнено условие (2.12)), то

относительное время пребывания случайного процесса (t ) в промежутке

( x, x dx) сходится по вероятности при T

p ( x) lim pT ( x) .

T

27

к

p ( x)dx , где

Доказательство:

Возьмем в качестве функции

f [ (t )]

f [ (t )] функцию-фиксатор

1, если x

(t )

x dx

0, если (t ) вне ( x, x dx]

и вычислим среднее значение

1

f [ (t )]

T

T

T

1

[ (t )]dt

T

0

1 t , если x

dt, если x

(t )

x dx

0, если (t ) вне ( x, x

0

T

(t )

x dx

T 0, если (t ) вне ( x, x dx] 0

Tx , x

T

dx

dx]

.

С другой стороны, для малых dx имеем:

M { f [ (t )]}

1 pT ( x)dx, если x

f ( x) pT ( x)dx

(t )

x dx

x dx

pT ( x)dx pT ( x)dx .

0, если (t ) вне ( x, x dx]

Таким образом, учитывая (2.18), получаем

Tx , x

T

x

p

dx

pT ( x)dx ,

T

(2.19)

что и требовалось доказать.

Как изменятся полученные результаты, если свойством эргодичности обладает стационарный процесс (t ) ? В этом случае одномерная плотность распределения вероятности не зависит от вр емени

w( x, t ) w( x) , а двумерная зависит лишь от разности

t t , т. е.

w( x, t; x , t )

w( x, x , ) , и соответственно R f (t , t ) зависит лишь от

1

pT ( x)

T

,а

T

w( x)dt

w( x) .

0

В этом случае соотношения (2.18) и (2.19) принимают вид:

1

T

T

p

f [ (t )]dt

0

f ( x) w( x)dx ;

T

28

(2.20)

Tx , x

T

p

dx

w( x)dx ,

(2.21)

T

а необходимое и достаточное условие эргодичности (2.12) содержит только однократный интеграл от R f ( )

lim

T

1

T

R f ( )d

0.

(2.22)

0

Условие (2.22), необходимое и достаточное для эргодичности стационарного в широком смысле случайного процесса, носит название условия Слуцкого. Оно допускает, что R f ( ) не стремится к нулю при

,

а, например, содержит член вида a cos

1

T

. В этом случае

a sin T

,

T

R f ( )d

0

и условие (2.22) выполняется.

Достаточные условия эргодичности стационарного процесса можно

сформулировать как требование, чтобы

lim R f ( ) 0 .

Наиболее существенным результатом является то, что для стационарного процесса распределение pT (x) совпадает с одномерной фикцией

распределения w(x) , поскольку последняя не зависит от t. Тем самым

доказанные нами теоремы утверждают, что при условии эргодичности

имеем

p

f [ (t )]

M { f [ (t )]}

T

т. е. среднее по времени от f [

статистическому и, в частности,

(t )

p

1

T

(t )] сходится по вероятности к среднему

(t )dt

M { (t )} .

T

0

И наконец выражение (2.21) позволяет записать, что

M

Tx , x

dx

w( x)dx .

T

29

(2.23)

Соотношение (2.23) дает в руки экспериментатору, если он имеет дело со стационарным эргодическим случайным процессом, непосредственный метод измерения одномерной функции распределения. Вероятность

попадания (t ) на какой-либо интервал ( a, b) определяется относительным временем пребывания процесса

(t ) в этом интервале за достаточно

длинный промежуток времени Т.

До сих пор рассматривали условия эргодичности применительно к

временному среднему случайной функции f [ (t )] , т. е. функции, зависящей от значения (t ) в какой-то один момент времени (иногда это называют эргодичностью первого порядка). Эргодичность второго порядка

имеет дело с временными средними функций f [ (t ) (t )] . Ограничимся

в этом вопросе частным случаем стационарного процесса (t ) и функцией

f [ (t ) (t )]

(t ) (t ) .

В этом случае среднее по времени

(t ) (t

)

1

T

(t ) (t

)dt .

0

Среднее статистическое такой случайной величины будет равно

M { (t ) (t

1

)}

1

T

T

M { (t ) (t

)}dt

0

K ( )dt K ( ) .

0

Можно показать, что при выполнении условия Слуцкого (2.22) имеет

место сходимость по вероятности

p

1

T

(t ) (t

)dt

K ( ),

(2.24)

T

0

которая на практике позволяет измерять (вычислять) корреляционную

) по досфункцию путем временного усреднения произведения (t ) (t

таточно длинному промежутку времени Т.

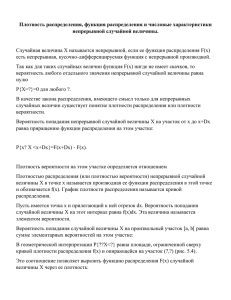

На рис. 2.3 приведен один из возможных видов классификации случайных процессов.

30

Случайные процессы

Стационарные

Эргодические

Нестационарные

Классификация

по типам

нестационарностей

Неэргодические

Рис. 2.3. Классификация случайных процессов

2.3. ДАЛЬНЕЙШАЯ КЛАССИФИКАЦИЯ СЛУЧАЙНЫХ

ПРОЦЕССОВ

Было показано, что знание многомерной плотности вероятности

wn ( x1, t1; x2 , t2 ;...; xn , tn ) полностью характеризует случайный процесс.

Однако многие физические процессы статистически не столь сложны,

чтобы для получения исчерпывающей информации о процессе было бы

необходимо знание всех wn ; часто бывает достаточно знать только

w1 ( x1, t1 ) или w2 ( x1, t1; x2 , t2 ) . Можно показать, что если эти плотности

содержат все возможные статистические данные, то по ним можно найти

многомерные плотности вероятности wn (n

) и заполнить всю их последовательность.

Значение классификации состоит в том, что при решении частных задач бывает необходимо знать, содержится ли в w1 или w2 на самом деле

вся информация о процессе или нет. Например, в теории броуновского

движения знания w1 ( r , r ) (где r – вектор перемещения, а r – скорость

тяжелой частицы в суспензии) недостаточно

для полного описания сто

хастического процесса. Кроме w1 (r , r ) необходимо знание совместной

двумерной плотности вероятности w2 (r1 , r1 ; r2 , r2 ; t 2

t1 ) .

2.3.1. Условные плотности вероятности

Расширим теперь понятие условной плотности вероятности, введенное ранее. Дадим следующее определение "простейшей" условной плотности вероятности случайного процесса (t ) : 2 ( x1 , t1 / x2 , t2 )dx2 равно

31

вероятности того, что если

(t ) имеет значение x1 в момент времени t1 ,

то в более поздний момент t2 он примет значение, лежащее в интервале

( x2 , x2 dx2 ) .

В этом разделе переменные, относящиеся к гипотезе, стоят раньше

аргументов функции, что отличается от использованных ранее обозначений. В первом случае величина, стоящая за наклонной чертой является

заданной или указывает на принятую гипотезу, а стоящая перед этой чертой является аргументом функции. Например, w( y / x) – x дано, y – аргумент функции. Второй способ противоположен первому. Первый вид

принят в математических трудах, а второй часто используется в физических (прикладных) работах.

Подобным же образом можно определить и многомерные условные

плотности вероятности: wn ( x1, t1; x2 , t2 ; ; xn 1, tn 1 / xn , tn )dxn – вероятность того, что если

(t ) имел значения x1, , xn 1 в моменты t1, , tn 1

соответственно, то в более поздний момент tn (tn tn 1, ) функция (t )

примет значение, лежащее в интервале ( xn , xn dxn ) . Из определений,

приведенных ранее, получаются следующие соотношения между условными и безусловными плотностями вероятностей:

(2.25)

w2 ( x1, t1; x2 , t2 ) w2 ( x1, t1 / x2 , t2 )w1 ( x1, t1 ) ;

w3 ( x1, t1; x2 , t2 ; x3 , t3 ) w3 ( x1, t1; x2 , t2 / x3 , t3 )w2 ( x1, t1; x2 , t2 )

w3 ( x1, t1; x2 , t2 / x3 , t3 )w2 ( x1, t1 / x2 , t2 )w1 ( x1, t1 )

и так далее для всех n 2 .

(2.26)

Условные плотности вероятности должны удовлетворять обычным

условиям для плотности:

wn ( x1, t1; x2 , t2 ; ; xn 1, tn 1 / xn , tn ) 0 ;

wn ( x1 , t1; x2 , t2 ; ; xn 1 , tn 1 / xn , tn )dxn 1 ;

( n 1)

wn 1 ( x1 , t1; x2 , t2 ; ; xn 1 , tn 1 )

wn ( x1, t1; x2 , t2 ; ; xn 1, tn 1 / xn , tn )dx1 dxn

1

w1 ( xn , tn ) .

Заметим, что все моменты времени упорядочены, а именно

t1 ... tn .

32

Существуют и иные плотности вероятности. Например, можно определить условную плотность вероятности вида

wm, n wm, n ( x1 , t1; ; xm , tm / xm 1 , tm 1; ; xn , tn ) .

Из соотношения (2.25) следует

lim w2 ( x1 , t1 / x2 , t2 )

t 2 t1

( x2

0

x1 )

и

lim w2 ( x1 , t1; x2 , t2 ) w1 ( x1 , t1 ) ( x2

t 2 t1

0

x1 ) ,

так как достоверно, что x2 x1 , т. е. заданному значению при совпадении

моментов наблюдения.

В другом крайнем случае

(2.27)

lim w2 ( x1 , t1 / x2 , t2 ) w1 ( x2 , t2 )

t 2 t1

и

lim w2 ( x1 , t1; x2 , t2 ) w1 ( x1 , t1 )w2 ( x2 , t2 ) .

t 2 t1

Для рассматриваемых здесь случайных процессов это равносильно

утверждению, что отсутствует "память" или статистическая связь между

значениями (t ) , наблюдающимися в двух различных моментах времени,

достаточно далеко отстоящих друг от друга.

2.3.2. Совершенно случайный процесс (шум)

Вернемся теперь к классификации. Процесс

(t ) называется совершенно случайным (шумом), если последовательные значения xi никак не

связаны, т. е. когда последовательные значения случайной величины не

зависят статистически от предыдущих значений (как бы малы ни были

промежутки между наблюдениями). Это можно выразить следующим образом:

wn ( x1, t1; x2 , t2 ; ; xn 1, tn 1 / xn , tn ) w1 ( xn , tn ) .

Подстановка (2.27) в (2.25) дает при n

венств:

(2.28)

2 последовательность ра-

w2 ( x1, t1; x2 , t2 ) w1 ( x1, t1 )w1 ( x2 , t2 ) ;

– – – – – – – – – – – – –

n

wn ( x1 , t1; ; xn , tn )

w1 ( xi , ti ) .

i 1

33

(2.29)

В этом случае можно утверждать, что x1,..., xn статистически независимы для любых значений ti

tk . Вся информация о процессе содержится

в одномерной плотности вероятности w1 , знание которой дает возможность, используя (2.29), полностью описать процесс. Это легко иллюстрировать на примере случайной последовательности, когда t принимает

только дискретные значения. Например, бросание монеты в заданные моменты времени. Однако при непрерывном t совершенно случайный процесс является только предельным случаем. Так как практически (t1) и

(t2 ) всегда коррелированны, если соответствующий промежуток времени t2 t1 конечен и мал. Обычно в реальных случаях именно причина и

степень этой корреляции и представляет особый интерес.

2.3.3. Простой марковский процесс

Следующий по сложности процесс получается, когда вся информация

содержится в двумерной плотности вероятности w2 ( x1, t1; x2 , t2 ) . Такие

процессы называются марковскими (по имени русского математика, впервые исследовавшего их). Они составляют очень важный класс процессов,

так как в большинстве случаев шумы и во многих случаях и сигналы являются в том или ином смысле такими процессами.

Простым марковским процессом называется такой стохастический

процесс (t ) , значение которого в моменты времени, входящие в любую

совокупность (t1,....,tk ,....,tn ) , зависят лишь от последнего известного

значения xn 1 из всех значений, которые случайный процесс (t ) принимает в моменты времени, входящие в любую совокупность предыдущих

моментов времени (t1,.....,tk ,....) . В этом случае условную плотность вероятности можно записать в виде

wn ( x1, t1; x2 , t2 ; ; xn 1, tn 1 / xn , tn ) w2 ( xn 1, tn 1 / xn , tn ) ,

(2.30)

где t1 t2 ...... tn .

Из определения условной плотности и соотношения (2.30) получаем

wk ( x1, t1; x2 , t2 ; ; xk , tk ) wk 1 ( x1, t1; ; xk 1, tk 1 )

w2 ( xk 1, tk 1 / xk , tk ) , k 2 ,

и соответственно имеем

34

wn ( x1 , t1; x2 , t2 ; ; xn , tn ) w1 ( x1 , t1 ) w2 ( x1 , t1 / x2 , t2 )

w3 ( x1 , t1; x2 , t2 / x3 , t3 ) w1 ( x1 , t1 ) w2 ( x1 , t1 / x2 , t2 )

w2 ( x2 , t2 / x3 , t3 ) w2 ( xn 1 , tn 1 / xn , tn )

n

w1 ( x1 , t1 )

w2 ( xk 1 , tk 1 / xk , tk ), n 2.

(2.31)

k 2

Получили, что процесс полностью охарактеризован в предположении,

конечно, что w1 и различные w2 ( xk 1, tk 1 / xk , tk ) существуют. Марковское условие (2.30) подразумевает также, что процесс (t ) может быть и

чисто случайный.

Учитывая (2.27), т. е.

lim

tk tk

w2 ( xk 1 , tk 1 / xk , tk )

w1 ( xk , tk )

1

и

lim

tk tk

w2 ( xk 1 , tk 1; xk , tk )

w1 ( xk 1 , tk 1 ) w1 ( xk , tk ) ,

1

получаем, что при tk tk 1

выражение wn в (2.31) приводится к

выражению (2.29) совершенно случайного процесса, когда все моменты

наблюдений tk (k 1, , n) бесконечно удалены друг от друга.

Подобным же образом, в другом крайнем случае, когда все tk одинаковы, можно преобразовать (2.31) к виду

n

lim

tn tn

1

t1

wn ( x1 , t1; ; xn , tn )

w1 ( x1 , t1 )

( xk

xk 1 ) .

k 2

В первом случае все последовательные значения статистически независимы, а во втором случае имеет место полная зависимость:

xn xn 1 x1 с вероятностью 1. Приведенные соотношения нужно

соответствующим образом изменить, если процесс содержит детерминированные составляющие.

2.3.4. Случайные процессы различных типов

В предыдущих лекциях мы рассматривали непрерывные случайные

процессы (t ) . Кроме непрерывных существуют и другие типы случайных процессов. Например, если стохастическая

35

x(t ) принимает контину-

ум значений, а значения параметра t выбираются из дискретного множества t1 , t 2 ,.... (которое может быть конечным или бесконечным), то x(t )

называется непрерывной случайной последовательностью (рис. 2.4 б).

Важным примером такого процесса является классическая задача о случайных блужданиях, где каждый "шаг" или "перемещение" может принимать значение xi (t k ) из непрерывного интервала (a x b) , но эти

шаги совершаются только в дискретные моменты t1 ,, tk и т. д.

а

б

xi(t)

b

0

xi(t)

x(t-3)

t-3

t

x(t-2)

t-2

a

x(t2)

t3

0

t1 t2

x(t3)

t

x(t-1)

в

г

xi(t)

b

t-2

t-3

x(t1)

t-1

xi(t)

t2

t-1

0

t1

t3

t

t-4

t-3 t-2

t-1 0

t1

t2 t3

t4 t

a

Рис. 2.4. Четыре вида случайных процессов:

а – непрерывный случайный процесс;

б – непрерывная случайная последовательность;

в – дискретная случайная последовательность;

г – дискретный случайный процесс

Третий тип процесса возникает, когда значения x выбираются также

из дискретного множества значений x(tk )1, x(tk )2 , – в дискретные моменты tk . Такие процессы часто называют дискретными случайными последовательностями (рис. 2.4 в), одним из примеров которых является

бросание монеты. Монета бросается в моменты tk ; два возможных значения x(tk )1, x(tk )2 соответствуют "гербу" или "решке".

Наконец, существует случай, когда x может принимать лишь множество дискретных значений, а множество значений t представляет континуум, что имеет место, например, на выходе релейной системы авторегулирования, счетчика и т. д. Здесь время изменяется непрерывно, а на

выходе подобных систем сохраняется одно из дискретного множества

36

возможных значений в течение периода различной длительности, которое

изменяется скачком. Эти процессы называются дискретными случайными

процессами (рис. 2.4 г).

Полезно заметить, что термины дискретный и непрерывный связаны

со стохастической величиной x , а термин процесс и последовательность

относятся к параметру t .

В большинстве приложений, рассматриваемых в настоящем пособии,

будут встречаться непрерывная случайная последовательность б и непрерывный случайный процесс а.

Процессы типа б не только дают полезную модель для детального

описания различных шумовых процессов, но также часто встречаются,

когда непрерывные данные квантуются (во времени) процедурами выборки. С другой стороны, непрерывный процесс полезен для макроскопического описания электрических шумов и других флуктуационных явлений

при их наблюдении в масштабе, лежащем значительно выше уровня, при

котором проявляется существенно дискретный характер физического процесса. Моделью непрерывного случайного процесса удобно пользоваться

также во многих задачах теории связи, когда непрерывные (и дискретные)

данные обрабатываются непрерывно, например, при линейной и нелинейной фильтрации, модуляции, детектировании и т. д. Более того, часто бывает необходимо рассматривать непрерывный случайный процесс как

предел непрерывной последовательности, например, при анализе оптимальных решающих систем для обнаружения и извлечения сигнала из

шумов.

2.3.5. Сигнал и шум

Интересным типовым примером является аддитивная смесь шума и

сигнала, реализация которой представляет принятое колебание во многих

связных задачах. Если сигнал представляет собой детерминированный

процесс, а шум, естественно, стохастический, то результирующий процесс

называют смешанным. Эта смесь бывает как аддитивной, так и мультипликативной (т. е. представляет произведение сигнала и шума). Например,

полезный сигнал может быть колебанием, которое модулировано шумом

n1 (t ) cos( 0t

)

и появляется на фоне шума n2 (t ) и т.д. В практических применениях

встречаются различные смешанные процессы.

37

Сигнал определяется, в общем, как любая полезная составляющая

переданного или принятого колебания, а шум – как сопровождающая

его вредная составляющая. Сигналы могут быть детерминированными

или чисто случайными, а шум, будучи обычно случайным, может во

многих случаях обладать детерминированными свойствами, которые

часто связаны с совокупностью сигналов.

Представим сигнал в виде

x(t )

A s(t , ) ,

где А – мера мощности (т. е. масштаб амплитуд) сигнала; s(t ) – нормированная форма колебания, которая характеризует зависимость от

времени и предполагается заданной; – основные параметры сигнала,

которые могут иметь, а могут и не иметь непрерывную или дискретную плотность вероятности.

Заметим, что параметры процесса (A, ) могут быть сами функциями времени или стохастическими величинами. Например, сигнал

может быть колебанием со случайным периодом (т. е. T0 имеет функцию распределения) или период может быть постоянным. Амплитуда

(масштаб) колебания может подвергаться случайным изменениям либо

от одной реализации к другой, либо от одного момента времени к другому (для данной реализации). Кроме этого, сигнал может иметь вид

s(t ) A n(t ) , где А заданно, а n (t ) – чисто случайный процесс. Ясно, что возможна любая комбинация случайной и детерминированной

составляющих. Точно такое же утверждение можно сделать относительно сопровождающего сигнал шума, хотя в большинстве рассмотренных ниже случаях предполагается, что шум не содержит детерминированных составляющих, по крайней мере, пока он не подвергается

обработке вместе с сигналом.