Применение динамической нейросетевой модели для

advertisement

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

Л.Л. БЕСЧАСТНЫЙ, О.А. МИШУЛИНА

Национальный исследовательский ядерный университет «МИФИ»,

Москва

lbeschastny@gmail.com, mishulina@gmail.com

ПРИМЕНЕНИЕ ДИНАМИЧЕСКОЙ НЕЙРОСЕТЕВОЙ

МОДЕЛИ ДЛЯ СЕГМЕНТАЦИИ ВРЕМЕННЫХ РЯДОВ

В БИОЛОГИЧЕСКИХ ЭКСПЕРИМЕНТАХ

Рассматривается задача автоматической сегментации поведения лабораторных животных на поведенческие акты как задача сегментации векторных временных рядов. Приводится формальная постановка задачи с

использованием переменных, характеризующих надежность принимаемых решений. Предлагается нейросетевое решение задачи сегментации

поведенческой последовательности с применением NARX-сетей. Обсуждаются результаты исследований с использованием данных биологических экспериментов.

Ключевые слова: поведение животных, NARX-модель, нейросетевая

структура, векторный временной ряд, сегментация

Введение

Для сравнительного анализа поведения животных в биологических

экспериментах или при изучении изменения поведения одного животного

в серии экспериментов необходимы объективные количественные показатели, отражающие значимую информацию для биологического исследования. В настоящее время общепринято использовать только качественное описание замеченных исследователем особенностей поведения или

результаты простейшей статистической обработки данных видеонаблюдения. При проведении биологических тестов анализируется, как правило,

лишь время решения животным той или иной задачи, но не учитывается

сам процесс достижения животным поставленной цели [1]. Для анализа

процесса решения поставленной задачи удобно представить поведение

животного как последовательность сменяющих друг друга актов поведе Работа выполнена при поддержке Федеральной целевой программы «Научные и научно-педагогические кадры инновационной России», проекты НИЯУ

МИФИ № П264 и № П1052.

УДК 004.032.26(06) Нейронные сети

123

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

ния, что позволяет свести анализ поведения к анализу строки конечного

алфавита. Акты поведения могут быть как элементарными (например,

“побежка”, “принюхивание”, “стойка с опорой” и т.п.), так и сложными,

включающими несколько элементарных действий [2].

Естественным способом сегментации поведения животного на поведенческие акты по данным видеозаписи является экспертная сегментация.

Однако такой подход требует от биолога больших затрат времени и практически не может быть применен при проведении серий экспериментов.

Альтернативой может быть автоматическая сегментация на акты поведения. В этом случае в качестве исходных данных могут выступать специально вычисляемые поведенческие признаки (например, скорость животного, расстояние до стенки арены и т.п.). Одним из подходов к решению

проблемы автоматической сегментации поведения животного является

применение нейросетевых моделей, обучаемых по результатам экспертной разметки на представительной выборке данных.

Постановка задачи автоматической сегментации фаз поведения

Пусть дан векторный временной ряд

(t ) = 1 (t )m (t ) m , t = 1,T ,

характеризующий поведение животного в процессе эксперимента. Компоненты ряда i (t ) – поведенческие признаки животного, t – дискретное

время с шагом дискретности dt . Предполагается, что возможные акты

поведения животного перенумерованы, а набор их номеров образует

множество = {1, , k} . Решение задачи сегментации векторного временного ряда (t ) состоит в том, чтобы для каждого такта дискретного

времени t определить текущий акт поведения животного, то есть построить временной ряд значений (t ) .

Перейдем от номеров фаз поведения (t ) , t = 1, T , к индикаторным

~ (t ) , t = 1, T , которые в дальнейшем более удобны для расвекторам

смотрения:

~ (t )

~ (1) (t ), ,

~ ( k ) (t ) {0,1} k ,

=

1,

(

t

)

=

i,

~ (i ) (t ) =

0, иначе.

(1)

УДК 004.032.26(06) Нейронные сети

124

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

~ (i ) (t ) – логическая переменная, указывающая на реализацию акта

Здесь

поведения с номером i . Учитывая неточность измерения поведенческих

признаков (t ) и, возможно, неполноту их состава, точное распознавание

~ (t ) , t = 1, T , не представляется возможным. В связи с этим

значений

~ (i ) (t ) и расвоспользуемся вероятностной интерпретацией переменных

смотрим новый векторный временной ряд:

(k )

k

(t ) = (1)

(t ) (t ) [0,1] ,

где

(i ) (t )

– степень уверенности в том, что в момент времени t реализо-

ван акт поведения i . В этом случае текущий акт поведения может быть

определен следующим образом:

(t ) = , = arg max α (i ) (t ).

(2)

i

Таким образом, задача сегментации поведения животного на акты сведена к расчету векторного временного ряда (t ) [0,1] k , характеризующего наше знание о текущем акте поведения животного в каждый момент

дискретного времени t , по заданному векторному временному ряду

(t ) m , t 1, T , поведенческих признаков. Для решения этой задачи

предлагается построить нейросетевую структуру обработки данных на

основе NARX-сетей.

Архитектура NARX-сети

В общем случае модель нелинейной авторегрессии с внешними входами (nonlinear autoregressive wits exogenous inputs model – NARX) описывается рекуррентным уравнением:

y(t 1) = ( x(t ) x(t nx ), y(t ) y(t ny )),

где x(t ) – входной сигнал; y(t ) – выходной сигнал; – некоторое нелинейное преобразование; nx и n y – максимальное число задержек по

входному и выходному сигналам соответственно. Одним из вариантов

реализации NARX-модели является NARX-сеть (рис. 1), использующая в

качестве нелинейного преобразования многослойный персептрон

[3–4].

УДК 004.032.26(06) Нейронные сети

125

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

NARX-сеть относится к классу рекуррентных нейронных сетей. Наличие обратных связей позволяет NARX-сети принимать решения, основываясь не только на входных данных, но и с учетом предыстории состояний

динамического объекта. Это свойство делает NARX-сеть удобной моделью для описания динамических процессов, например, смен актов поведения животного.

NARX-сеть

∆

x(t )

…

∆

∆

…

MLP

y (t )

∆

Рис. 1. Архитектура NARX-сети

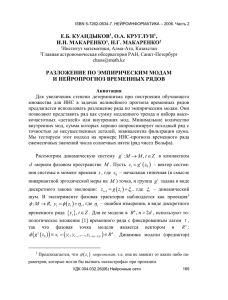

Нейросетевая структура для сегментации

векторного временного ряда

Нейросетевой обработчик данных (рис. 2) имеет модульную архитектуру и состоит из следующих блоков:

NARX i – NARX-сеть, оценивающая достоверность реализации i-го

акта поведения в текущий момент времени;

MF – медианные фильтры для подавления шумов и сглаживания результатов нейросетевых вычислений;

MLP – многослойный персептрон, используемый для принятия финального решения о текущем акте поведения.

УДК 004.032.26(06) Нейронные сети

126

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

Нейросетевой обработчик данных

NARX1

NARXk

MF

...

...

(t )

(1) (t )

( k ) (t )

M

L

P

(t )

MF

Рис. 2. Нейросетевая структура для сегментации векторного временного

ряда

На первом этапе работы оценивается каждый компонент векторного

ряда α (t ) при помощи отдельной NARX-сети:

(i ) (t ) = Fi ((t )(t d ), (i ) (t 1) (i ) (t d a )),

где d – число задержек по входу сети, d a – число задержек по выходу и

Fi – реализуемая сетью NARX i нелинейная функция [3-5]. Предполагается, что применяемые авторегрессионные нелинейные модели способны

адекватно отразить динамику смены актов поведения с учетом предыстории поведения и инерционности поведенческих признаков (t ) . NARXсеть обладает достаточно простой архитектурой и при этом не уступает в

вычислительной способности полносвязанной нейронной сети [4].

Сеть NARX i при распознавании акта поведения i должна выполнить

две задачи: распознать начало соответствующего ей акта поведения и

оставаться активной до его завершения.

Поскольку при обучении NARX-сети минимизируется среднеквадратичная ошибка, в процессе ее работы могут появляться кратковременные

выбросы, связанные с ошибочным распознаванием начала соответствующего акта поведения. Устранение таких выбросов происходит на втором

этапе. Для этого векторный временной ряд (t ) , составленный из выходов NARX-сетей (i ) (t ) , сглаживается покомпонентно при помощи медианного фильтра MF (рис. 1).

В процессе работы нейросетевого обработчика на одном такте дискретного времени t могут быть активны несколько NARX-сетей, соответУДК 004.032.26(06) Нейронные сети

127

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

ствующих разным фазам поведения. При этом разные NARX-сети в

составе нейросетевой структуры могут указывать на разную степень

уверенности в реализации соответствующих им актов поведения, что делает выходы (i ) (t ), i 1,2,...,k , неравноценными. Поэтому на третьем

этапе полученный векторный временной ряд (t ) подается на выходной

блок, в котором формируется итоговое решение (t ) . В текущей версии

нейросетевого обработчика в качестве выходного блока используется

многослойный персептрон.

Результатом работы нейросетевой структуры является векторный временной ряд (t ) , который в каждый момент времени характеризует распределение уверенности в реализации разных актов поведения животного.

Решение (t ) в пользу одного из них принимается с использованием

формулы (2). Для повышения качества сегментации из полученного векторного временного ряда (t ) следует удалить фазы поведения, продолжительность которых меньше некоторого порогового значения .

Обучение нейросетевой структуры обработки данных

Для обучения нейросетевого обработчика данных необходимо иметь

обучающую выборку, то есть сегментированный тем или иным способом

временной ряд поведенческих признаков ((t ), (t )) . При этом разметка

(t ) временного ряда (t ) может быть как экспертной, так и полученной

автоматически.

В соответствии с формулой (1) осуществляется переход от разметки

~ (t ) и формируется обучающая выбор (t ) к индикаторным векторам

~

ка вида ((t ), (t )) , которая используется для обучения всех NARX

сетей, входящих в нейросетевую структуру.

Далее выходы NARX-сетей j (t ) сглаживаются медианными филь~ (t )) обучается многотрами, после чего на полученной выборке ( (t ),

j

j

слойный персептрон.

Для оценки качества обучения модели введем следующий критерий:

УДК 004.032.26(06) Нейронные сети

128

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

T

N error

= i (t ),

t =1

(3)

~ (t ) = ˆ (t ),

0,

j

=

1, иначе,

ˆ j (t ) {0,1} – реальные выходы модели. Критерий показывает число

где

i (t )

тактов дискретного времени t , в которых модель ошиблась при распознавании фазы поведения. Для устранения зависимости от длины реализации

T введем нормированный критерий:

1

1 T

(4)

error = N error = i (t ),

T

T t =1

показывающий относительную ошибку распознавания акта поведения.

Обобщающая способность нейросетевой модели

Процесс обучения нейросетевой структуры должен быть организован

таким образом, чтобы обеспечивалась ее обобщающая способность [3]:

нейросетевая структура, обученная выделять акты поведения на некотором достаточно представительном векторном временном ряде (t ) поведенческих признаков, должна выделять эти фазы поведения на любом

другом входном ряде из той же генеральной совокупности. Обобщающая

способность делает возможным применение обученной нейросетевой модели для анализа данных других биологических экспериментов, выполненных в тех же условиях.

Экспериментальные исследования подтвердили способность разработанной нейросетевой структуры к обобщению данных.

Результаты обработки экспериментальных данных

Для проверки разработанного нейросетевого обработчика был проведен ряд экспериментов с использованием данных о поведении крысы в

водном лабиринте Морриса. В биологическом тесте животное должно

найти в круглом бассейне скрытую под водой неподвижную платформу [1]. В качестве поведенческих признаков для сегментации временного

ряда на акты поведения были взяты траекторные признаки, рассчитанные

по данным одноточечной видеорегистрации:

расстояние до стенки арены d (t ) ;

УДК 004.032.26(06) Нейронные сети

129

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

модуль вектора скорости || vt (t ) || ;

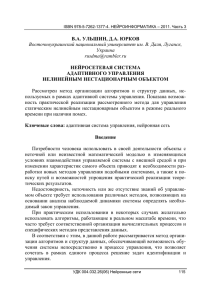

угловая скорость вектора скорости t (t ) (рис. 3);

направление движения относительно центра арены (vt , rc (t )) ;

расстояние до центра платформы || rp (t ) || ;

направление движения относительно центра платформы (vt , rp (t )) .

Здесь rc (t ) и rp (t ) – радиус-векторы положения животного в бассейне, проведенные из центра арены и центра платформы соответственно;

(,) – оператор вычисления угла между двумя векторами. Вычисление

траекторных признаков осуществлялось в “скользящем окне” ширины

2t .

Для проведения исследования были взяты три выборки данных по

трем различным биологическим экспериментам в водном лабиринте Морриса, для которых предварительно была произведена экспертная разметка

на акты поведения. Для вычисления траекторных признаков использовалось скользящее окно ширины 2t 50 тактов дискретного времени (2

секунды). Для каждой из трех выборок данных был построен отдельный

нейросетевой обработчик, причем каждая выборка была предварительно

разбита случайным образом на обучающую, тестовую и валидационную

части. При этом 67 % примеров относилось к обучающей выборке, 11 %

примеров – к тестовой и 22 % – к валидационной. Такой способ разбиения

данных связан с необходимостью обеспечить достаточную информативность обучающей части выборки.

УДК 004.032.26(06) Нейронные сети

130

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

r (t )

vt (t )

r (t t )

r (t t )

vt (t ) 2t dt

r (t )

r (t t )

t

r1 v t t t dt

2

2

r1 , r2 t (t ) t dt

t

r2 v t t t dt

2

2

r (t t )

Рис. 3. Определение вектора скорости и его угловой скорости на треке

животного

Следует подчеркнуть, что полученная в результате тестовая выборка

использовалась только для финального тестирования сети и никак не

участвовала в процессе обучения, в то время как обучающая выборка использовалась для настройки параметров модели, а валидационная – для

предотвращения переобучения.

Для всех NARX-сетей, входящих в модель (рис. 1), была выбрана

единая архитектура:

один скрытый слой из 7 нейронов с сигмоидальной активационной характеристикой;

линейная активационная характеристика в выходном нейроне;

две задержки по входу на 30 и 60 тактов соответственно;

две задержки по обратной связи на 1 и 2 такта соответственно.

Ширина окна для медианных фильтров была выбрана равной 7 тактам.

В качестве выходного блока был взят многослойный персептрон с

линейной активационной характеристикой в выходном слое и одним

скрытым слоем, содержащим 30 нейронов с сигмоидальной активационной характеристикой.

Для повышения качества сегментации из полученного на выходе обработчика временного ряда (t ) актов поведения были удалены все сегменты короче 7 тактов. Поскольку для определения текущей фазы повеУДК 004.032.26(06) Нейронные сети

131

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

дения использовалась только информация о предыдущих тактах времени,

неопределенные такты, возникшие в результате удаления слишком коротких сегментов, были отнесены к ближайшей будущей фазе поведения.

Обучение нейронных сетей, входящих в нейросетевую структуру, выполнялось по алгоритму Левенберга-Маркардта. В качестве критерия

останова использовалось максимальное число эпох обучения: для NARXсетей было задано ограничение в 25 эпох в режиме параллельных серий и

10 эпох в параллельном режиме обучения [5], для многослойного персептрона было задано ограничение в 50 эпох. В процессе обучения постоянно

контролировалась среднеквадратичная ошибка на валидационной выборке. Если в течение 6 эпох сети не удавалось снизить ошибку обучения на

валидационной выборке, то процесс обучения прекращался.

Чтобы избежать локальных минимумов при обучении модели, обучение всех нейронных сетей производилось 3 раза с разными начальными

значениями синаптических коэффициентов и смещений. Среди обученных сетей выбиралась лучшая, обеспечивающая минимальную ошибку на

валидационной выборке.

Результаты обработки данных представлены в таблице 1 (ошибки рассчитаны по формуле (4)).

Таблица 1

Результаты обучения нейросетевой структуры на данных экспертной

разметки трех биологических экспериментов в лабиринте Морриса

Номер эксперимента

Продолжительность, с

Число различных фаз поведения

Число смен фаз

Число примеров в обучающей выборке

Число примеров в валидационной выборке

Число примеров в тестовой выборке

Ошибка на обучающей выборке, %

Ошибка на валидационной выборке, %

Ошибка на тестовой выборке, %

1

122

7

34

2034

678

339

8,7

9,5

9,7

2

56

6

21

935

312

156

9,4

11,0

12,1

3

54

7

20

907

302

151

4,5

5,9

6,6

Приведенные в таблице 2 ошибки на тестовой выборке свидетельствуют о достижении достаточной обобщающей способности нейросети

УДК 004.032.26(06) Нейронные сети

132

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

на фрагменте данных того же эксперимента, из которого была взята

обучающая выборка.

Выводы

Предложена архитектура и способ обучения нейросетевой структуры

на основе NARX-сетей для автоматической сегментации векторных временных рядов поведенческих признаков животного. Предварительные

исследования на данных отдельных биологических экспериментов подтвердили перспективность предложенного подхода. Дальнейшие исследования будут проведены с использованием представительных выборок

данных, полученных во многих экспериментах и на разных животных.

Список литературы

1. Амикишиева А.В. Поведенческое фенотипирование: современные

методы и оборудование // Вестник ВОГиС. 2009. Т. 13. № 3. С. 529–542.

Fonio E., Benjamini Y., Golani I. Freedom of movement and the stability of

its unfolding in free exploration of mice // Proceedings of the National Academy of Sciences of the United States of America. 2009. Vol. 106. № 50.

P. 21335–21340.

Хайкин С. Нейронные сети. Полный курс. Издательство “Вильямс”.

2006. 1104 с.

Siegelmann H.T., Horne B.G., Giles C.L. Computational capabilities of recurrent NARX neural networks // IEEE Transactions on Systems, Man, and

Cybernetics. Part B: Cybernetics. 1997. Vol. 27. Iss. 2. P. 208–215.

Menezes J.M.P., Barreto G.A. Long-term time series prediction with the

NARX network: An empirical evaluation // Neurocomputing. 2008. Vol. 71.

Iss. 16–18. P. 3335–3343.

УДК 004.032.26(06) Нейронные сети

133