Full text - Высшая школа экономики

advertisement

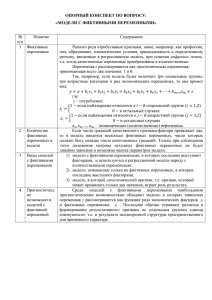

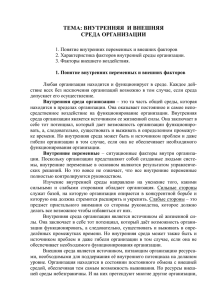

Сорокин Дмитрий Михайлович ПРЕДСКАЗАНИЕ ЗНАЧЕНИЯ ЭКОНОМИЧЕСКОЙ ВЕЛИЧИНЫ С ПОМОЩЬЮ МОДЕЛИ НЕЙРОННОЙ СЕТИ И РЕГРЕССИОННОЙ МОДЕЛИ (ВТОРАЯ ИТЕРАЦИЯ) SOROKIN Dmitriy Research University «Higher School of Economics» — Saint-Petersburg, Faculty of Economics, Lecturer of the Department of Institutional Economics E-mail: dsorokin@hse.spb.ru Abstract In this paper we will consider the construction of a neural network model for a hypothetical example of a production function with constant elasticity of substitution factors (CES-function), and also we will compare the results with those obtained by using a regression model based on the method of least squares. In previous work [Sorokin, 2012], the author constructed a neural network model, and showed that it is a better predictor of the value of economic value in terms of the sum of squared residuals, rather than the regression model based on the method of least squares. As part of this work the author wants a similar analysis on a different set of data, which are closer to reality, due to the fact that the amount of labor used now has a scale factor of 5 smaller. Аннотация В данной работе будет рассмотрено построение модели нейронной сети для гипотетического примера производственной функции с постоянной эластичностью замещения факторов (CES-функции), а также будет произведено сравнение полученных результатов с результатами, получаемыми при использовании регрессионной модели, основанной на методе наименьших квадратов. В предыдущей работе [Сорокин, 2012] автор построил модель нейронной сети и показал, что она лучше предсказывает значения экономической величины в плане суммы квадратов остатков, нежели регрессионная модель, основанная на методе наименьших квадратов. В рамках же данной работы автор собирается провести подобный анализ на другом наборе данных, которые более приближены к реальным, за счёт уменьшения в 5 раз размаха количества использованного труда. Ранее проведённый автором анализ [Сорокин, 2012] показал, что модель нейронный сети предсказывает значения выпуска, определяемого производственной функции с постоянной эластичностью замещения факторов (CES-функцией: 1 Y F K , L A K p Lp p , где 1 и p : p 0 или 0 p 1 ) в плане суммы квадратов остатков лучше, нежели регрессионная модель, основанная на методе наименьших квадратов (МНК). При этом если в модель включить лишние переменные, которые не используются при формировании итогового показателя выпуска ( Y ), то модель нейронной сети при любой их корреляции с исходными данными количества капитала и труда (коэффициенты корреляции: r 0 , r 0.3 , r 0.6 ) однозначно определяет, какие переменные являются лишними. Чего не сказать о регрессионной модели, основанной на МНК, которая при коэффициенте корреляции лишних переменных с исходными данными количества капитала и труда r 0.3 даёт точный ответ о том, что какие-то переменные являются лишними только после вычисления информационных критериев. При этом использовались следующие размахи исходных данных количества капитала и труда: K 0;1000 ; L0;1000 . Если говорить о капитале, то фирма спокойно может варьировать его количество в большом диапазоне для достижения желаемых целей. При этом количество труда она может варьировать только в ограниченном диапазоне, поскольку в противном случае массовое увольнение рабочих без веских на то оснований привлечёт внимание государственных органов, которые будут отстаивать интересы уволенных рабочих в суде: в большинстве случае эти судебные разбирательства завершаться в пользу рабочих, что для фирмы выльется в значительные штрафы. На основании выше изложенного автор сгенерировал новый набор исходных данных, который не отличается по своей структуре от использованного ранее [Сорокин, 2012], но более сопоставим с реальными экономическими данными. В него входят: Независимые (объясняющие) переменные: o количество имеющегося физического капитала ( K ); o количество имеющегося труда ( L ); Зависимая (объясняемая) переменная – значения выпуска ( Y ) при данных количествах физического капитала ( K ) и труда ( L ); Параметры: o A - общая производительность факторов; o - весовой коэффициент перед количеством физического капитала ( K ); o - весовой коэффициент перед количеством труда ( L ); o p - эластичность замещения факторов. Также как и в предыдущей работе [Сорокин, 2012] будут рассмотрены 3 спецификации модели нейронной сети и регрессионной модели, основанной на МНК, для гипотетического примера производственной CES-функции с целью определить, на сколько легко эти модели выявляют лишние переменные, которые не используются при формировании итогового показателя выпуска ( Y ): 2 лишние переменные, не коррелированны с независимыми (объясняющими) переменными: ни с количеством физического капитала ( K ), ни с количеством труда ( L ); 2 лишние переменные, коррелированны с независимыми (объясняющими) переменными с коэффициент корреляции r 0.3 : первая – с количеством физического капитала ( K ) , а вторая – с количеством труда ( L ); 2 лишние переменные, коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.6 : первая – с количеством физического капитала ( K ), а вторая – с количеством труда ( L ). Эти 3 пары переменных не имеют под собой никакой особой экономической интерпретации и созданы исключительно для того, чтобы посмотреть, будут ли нейронная сеть и регрессионная модель, основанная на МНК, использовать эти показатели при построении прогноза выпуска ( Y ) при заданных количествах физического капитала ( K ) и труда ( L ) и заданных значениях лишних переменных (в первом случае – Errors и Errors2 ; во втором - Errors _ 2 и Errors2 _ 2 ; и в третьем Errors _1 и Errors2 _1 ), и если будут, то на сколько сильно. Такого рода анализ позволит понять, исказит ли получаемые по модели нейронной сети и регрессионной модели, основанной на МНК, результаты включение лишних переменных, от которых объясняемая переменная никак не зависит. Этот вопрос стоит актуально, так как перед началом построения модели нейронной сети или регрессионной модели, основанной на МНК, исследователь зачастую однозначно не может сказать, какие из исходных данных, влияют на экономическую величину, значение которой он хочет предсказать, а какие – нет. Лишние переменные не коррелированны с независимыми (объясняющими) переменными Для построения нейронной сети для гипотетического примера производственной CES-функции в случая, когда лишние переменные не коррелированны с независимыми (объясняющими) переменными, также как на предыдущей итерации [Сорокин, 2012] с помощью программного продукта Microsoft Office 2007 случайным образом были сформированы значения: Переменных (5000 наблюдений): o K 0;1000 ; o L 400;600 ; o Errors 0;1000 ; o Errors2 400;600 ; Параметров, используемых при расчёте итогового показателя выпуска ( Y ) по производственной CES-функции: o A 9.7521; o 0.4207 ; o 1 1 0.4207 0.5793 ; o p 0.8011 . В итоге был получен набор данных для 5000 наблюдений, состоящий из 4 вышеприведенных независимых переменных и итогового показателя выпуска, рассчитанного по формуле CES-функции с использованием значений параметров A , , и p , представленных выше: Y 0;7444.0412 . Теперь построим нейронную сеть для гипотетического примера производственной CES-функции с лишними переменными, не коррелированными с независимыми (объясняющими) переменными. Для этого в дальнейшем будет использоваться программный продукт SPSS Statistics 17. Таблица 1 Информация о весах синоптических связей нейронов Так программный продукт приводит информацию о весах синоптических связей между всеми нейронами (см. табл. 1), которая говорит нам о том, что для всех связей любого из 2 нейронов скрытого слоя с лишними переменными ( Errors и Errors2 ) характерен малый их вес (от 0 до 2.108 105 ), что свидетельствует об отсутствии влияния эти переменные на формирование индуцированного локального поля в каждом из 2 нейронов скрытого слоя. Следовательно, эти лишние переменные и не влияют на выходной сигнал нейронной сети в целом и в дальнейшем их можно будет исключить из модели. Если же говорить про оставшиеся связи в этой модели, то они получились достаточно сильными ( 0.282 и от 0.038 до 0.52 ), что подтверждает связь итогового показателя выпуск ( Y ) с количеством физического капитала ( K ) и количеством труда ( L ). Таблица 2 Информация о важности каждой из независимых переменных Также программный продукт приводит таблицу с показателями важности всех независимых переменных при определении значения зависимой переменной (см. табл. 2). В данном случае видно, что при определении выпуска ( Y ) важны только количества физического капитала ( K ) и труда ( L ), важность которых составляет 78.6% и 21.3% , соответственно, а лишние переменные ( Errors и Errors2 ) не оказывают практически никакого влияния при определении выпуска ( Y ) (показатели важности – 0% ). Это ещё раз подтверждает, что можно исключить лишние переменные ( Errors и Errors2 ) из модели. Лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции 0.3 Теперь рассмотрим случай, когда лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.3 . В данном случае будут использованы некоторые данные, описанные выше: K 0;1000 ; L 400;600 ; Y 0;7444.0412 . Что же касается лишних переменных, то они теперь рассчитываются по другому, нежели при предыдущей спецификации: Первая лишняя переменная (формула относительно первой итерации [Сорокин, 2012] не изменилась) – Errors _ 2 K 1000 Rnd 2000 : Errors _ 2 0;2000 ; r 0.3113 ; Вторая лишняя переменная (формула относительно первой итерации [Сорокин, 2012] изменилась) – Errors 2 _ 2 L 300 Rnd 600 : Errors2 _ 2 100;900 ; r 0.3127 . В итоге снова был получен набор данных для 5000 наблюдений, состоящий из значений 4 независимых переменных и выпуска ( Y ). Снова построим модель нейронной сети для производственной CES-функции, но уже с 2 лишними переменными, которые коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.3 : Таблица 3 Информация о весах синоптических связей нейронов Таблица 4 Информация о важности каждой из независимых переменных Из первой таблицы (см. табл. 3) видно, что нейроны входного слоя, отвечающие за лишние переменные, опять же имеют незначительные веса синоптических связей с нейронами скрытого слоя (от 0.004 до 0.008 ) – это свидетельствует о том, что лишние переменные практически не играют никакой роли при определении выпуска ( Y ), что подтверждают данные второй таблицы (см. табл. 4): показатели важности Errors _ 2 и Errors2 _ 2 – 0.1% и 0.5% соответственно. Что же касается количеств физического капитала ( K ) и труда ( L ), то их важность также практически не изменилась и теперь равна: 78.4% и 21.1% , соответственно. Из всего выше сказанного можно сделать вывод, что в дальнейшем модель нейронной сети должна строить с использованием только независимых переменных количества физического капитала ( K ) и труда ( L ). Лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции 0.6 Теперь рассмотрим последний случай, когда 2 лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.6 . В данном случае снова будут использованы некоторые данные, описанные выше: K 0;1000 ; L 400;600 ; Y 0;7444.0412 . Что же касается лишних переменных, то они теперь рассчитываются по другому, нежели при предыдущих спецификациях: Первая лишняя переменная (формула относительно первой итерации [Сорокин, 2012] не изменилась) – Errors _1 K Rnd ; Errors _10;1000 ; r 0.6506 ; Вторая лишняя переменная (формула относительно первой итерации [Сорокин, 1 2012] изменилась) – Errors 2 _1 L Rnd 6 ; Errors2 _1 400;600 ; r 0.6325 . В итоге имеем набор данных для 5000 наблюдений, состоящий из значений 4 независимых переменных и выпуска ( Y ). Опять построим модель нейронной сети для производственной CES-функции, но уже с 2 лишними переменными, которые коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.6 : Таблица 5 Информация о весах синоптических связей нейронов Таблица 6 Информация о важности каждой из независимых переменных Из первой таблицы (см. табл. 5) опять же видно, что нейроны входного слоя, отвечающие за лишние переменные, имеют малые значения (от 0.016 до 0.007 ) весов синоптических связей с нейронами скрытого слоя по сравнению с нейронами входного слоя, отвечающими за независимые (объясняющие) переменные количества физического капитала ( K ) (от 0.468 до 0.342 ) и количества труда ( L ) (от 0.075 до 0.134 ) – это свидетельствует о незначимости переменных Errors _1 и Errors 2 _1 и, наоборот, значимости переменных количеств физического капитала ( K ) и труда ( L ), что подтверждают данные второй таблицы (см. табл. 6). В целом в данном случае опять же может сделать вывод о возможности исключения переменных Errors _1 и Errors2 _1 из модели нейронной сети. Лишние переменные отсутствуют Исходя из выше проведённого анализа, можно сделать вывод, что модель нейронной сети хорошо определяет независимые переменные, которые не влияют на величину исследуемой зависимой переменной. Так она придаёт нейронам входного слоя, отвечающим за эти переменные, меньшие значения весов синоптических связей с нейронами скрытого слоя, нежели нейронам входного слоя, отвечающим за переменные объёмов факторов. Данная способность нейронной сети выявлять лишние переменные сохраняется и для случаев, когда эти переменные коррелированны с независимыми (объясняющими) переменными, в том числе и при достаточно сильной корреляции (с коэффициентом корреляции r 0.6 ). То есть исследователю можно не опасаться включения в модель лишних независимых переменных (входов), поскольку модель нейронной сети при отстройке связей присвоит связям с этими переменными очень малые значения, что как раз и покажет, что данные переменные являются лишними. Получается, что если исследователь сомневается в наличии или отсутствии связи выхода с каким-то из входов, то ему имеет смысл включить этот вход в модель нейронной сети, а потом, посмотрев на получившиеся связи с ним, решить, нужен он или нет. Теперь снова построим модель нейронной сети для производственной CESфункции, но уже без лишних переменных: Таблица 7 Информация о весах синоптических связей нейронов Таблица 8 Информация о важности каждой из независимых переменных В данном случае одна из таблиц (см. табл. 7) показывает, что у всех нейронов входного слоя наблюдаются большие значения весов синоптических связей с нейронами скрытого слоя (от 0.279 до 0.672 ), что говорит, и другая таблица (см. табл. 8) это подтверждает, о важности независимых (объясняющих) переменных при определении выпуска ( Y ) в модели производственной CES-функции. Теперь было бы интересно посмотреть, что по этим же данным выдаст нам регрессионный анализ, основанный на МНК. Для этих целей в дальнейшем будет использован программный продукт Intercooled Stata 7.0 for Windows 98/95/NT. Так, при построении регрессионной модели, основанной на МНК, с использованием независимых (объясняющих) переменных и лишних переменных, которые не коррелированны с первыми, были получены следующие данные: Таблица 9 Информация о построенной регрессионной модели Можно заметить (см. табл. 9), что на уровне значимости 10% коэффициенты перед переменными Errors и Errors2 получились не значимыми, хотя уже на уровне значимости 10.7% коэффициент перед Errors2 становится значимым. Но это не мешает сделать вывод о возможности исключения переменных Errors и Errors2 из модели. Теперь рассмотрим случай, когда лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.3 : Таблица 10 Информация о построенной регрессионной модели В данном случае видно (см. табл. 10), что даже на уровне значимости 0.5% уже значимы все коэффициенты перед независимыми переменными, включёнными в модель, за исключением коэффициента перед независимой переменной Errors 2 _ 2 . Следовательно, попробуем исключить переменную Errors 2 _ 2 , из рассматриваемой модели: Таблица 11 Информация о построенной регрессионной модели Теперь (см. табл. 11) коэффициенты уже перед всеми независимыми переменными значимы даже на уровне значимости 0.5% , в том числе и перед переменной Errors _ 2 , что не даёт нам основания исключить её из модели. Однако посмотрим на информационные критерии с целью понять возможность исключения переменной Errors _ 2 из регрессионной модели: Таблица 12 Информация о значениях информационных критериев для 2 регрессионных моделей В данном случае (см. табл. 12) видно, что по всем информационным критериям лидирует (значения информационных критериев меньше) регрессионная модель с лишней переменной. На основании этой информации об информационных критериях для этих 2 моделей исследователь не может сделать вывод о возможности удаления переменной Errors _ 2 . И, наконец, посмотрим на случай, когда лишние переменные коррелированны с независимыми (объясняющими) переменными с коэффициентом корреляции r 0.6 : Таблица 13 Информация о построенной регрессионной модели Сейчас (см. табл. 13), как и в предыдущем случае, на уровне значимости 10% коэффициенты перед всеми независимыми переменными значимы, за исключением коэффициента перед переменной Errors 2 _1 , поэтому исследователь может исключить данную переменную из модели: Таблица 14 Информация о построенной регрессионной модели В таком случае (см. табл. 14) получим, что коэффициент перед переменной Errors _1 остался значим на уровне значимости 10%, что не даёт исследователю полной уверенности о возможности исключения данной переменной может быть исключена из модели. Посмотрим на значения информационных критериев: Таблица 15 Информация о значениях информационных критериев для 2 регрессионных моделей В данном случае (см. табл. 15) видно, что по большинству информационных критериев лидирует (значения информационных критериев меньше) регрессионная модель без лишних независимых переменных, что даёт исследователю возможность сделать вывод об исключении переменной Errors _1 из модели. Если из построенной регрессионной модели исключить лишние переменные, которые нам удалось выявить только в случаях, когда они коррелированны с исходными переменными количества физического капитала ( K ) и труда ( L ) с коэффициентами корреляции r 0 и r 0.6 , то получим: Таблица 16 Информация о построенной регрессионной модели Теперь (см. табл. 16) модель в целом и все её коэффициенты перед независимыми переменными уже значимы даже на уровне значимости 0.5% . Объясняющая способность ( R2 ) составляет 99.79% и говорит о хорошем качестве построенной модели. Однако теперь встаёт другой вопрос, какая модель лучше предсказывает выпуск ( Y ) при заданных количествах физического капитала ( K ) и труда ( L ). Чтобы ответить на этот вопрос посмотрим на сумму квадратов остатков в моделях, полученную при её минимизации. Модель, у которой этот показатель будет меньше, и будет лучшей в предсказании выпуска: Таблица 17 Сравнительная таблица качества предсказания значения выпуска в модели нейронной сети и в линейной регрессионной модели В данном случае (см. табл. 17) видно, что модель нейронной сети даёт меньшие ошибки предсказания, чем регрессионная модель, основанная на МНК. Заключение Вышеприведённый пример предсказания выпуска ( Y ), описываемого производственной функцией с постоянной эластичностью замещения факторов (CESфункции), при заданных количествах физического капитала ( K 0;1000 ) и труда ( L 400;600 ) показал: Из-за присутствия нелинейной функции активации нейронов скрытого слоя (гиперболический тангенс) модель нейронной сети может, хотя и в неполном объёме, учесть нелинейность производственной CES-функции. Чтобы регрессионная модель, основанная на МНК, могла учитывать нелинейность производственной CES-функции в её первоначальный набор исходных данных необходимо добавить независимые переменные, являющиеся степенями исходных. Так, как автором в предыдущем анализе [Сорокин, 2012] было показано, что добавление только квадратов количеств физического капитала ( K 2 ) и труда ( L2 ) в регрессионную модель уменьшает сумму квадратов остатков регрессионной модели, основанной на МНК, до 23234454.6 по сравнению с 27742682.95 у модели нейронной сети; Регрессионная модель, основанная на МНК, плохо определяет лишние переменные, когда те коррелированны с независимыми (объясняющими) переменными. Так при коэффициенте корреляции r 0.6 исследователь может сделать вывод о возможности исключения независимой переменной только используя анализ, связанный с информационными критериями. Если же коэффициент корреляции лишних независимых переменных с независимыми переменными количества физического капитала ( K ) и труда ( L ) составляет r 0.3 , то даже анализ информационных критериев не даёт достаточных оснований исследователю исключить данные лишние переменные из модели. Уменьшение размаха значений количества факторов приводит к тому, что регрессионная модель, основанная на МНК, начинает хуже выявлять лишние переменные при их корреляции с количествами факторов производства (например, при r 0.3 и r 0.6 ). Чего не сказать о модели нейронной сети, которая даже при небольшом размахе значений количеств факторов производства даёт однозначный ответ о возможности исключения некоторых независимых переменных как лишних. Подводя итоги, можно отметить, что если исследователь при построении модели не уверен в том, какие независимые переменные включать в модель, то на первоначальном этапе ему лучше включить все возможные независимые переменные и использовать модель нейронной сети, которая легко выявляет «лишние» переменные, а в дальнейшем – регрессионную модель с созданием дополнительных независимых переменных, являющихся степенями исходных. Список использованной литературы: 1. Сорокин Д. М. Предсказание значения экономической величины с помощью модели нейронной сети и регрессионной модели [Текст] / Д. М. Сорокин // Инновационная экономика: реалии и перспективы: научная конференция, СанктПетербург, 27 сентября 2011 года: сборник статей / отв. ред. А. В. Бутуханов // Санкт-Петербургский филиал Нац. Исслед. ун-та «Высшая школа экономики». – СПб.: Отдел оперативной полиграфии НИУ ВШЭ – Санкт-Петербург, 2012. – 210 с. – С. 194-202.