файл - Самарский Центр аналитической истории и

advertisement

А.Н. ПЕТРОВ

КОМПЬЮТЕРНЫЙ АНАЛИЗ ТЕКСТА: ИСТОРИОГРАФИЯ

МЕТОДА1

// Круг идей: модели и технологии исторической информатики. Труды

III конференции АИК / Ред. Л.И. Бородкин и И.Ф. Юшин. М., 1996. – [344 с.]

//

Сайт

Ассоциация

"История

и

компьютер".

URL:

http://kleio.asu.ru/?q=node/39 (дата обращения, – 7.03.2010)

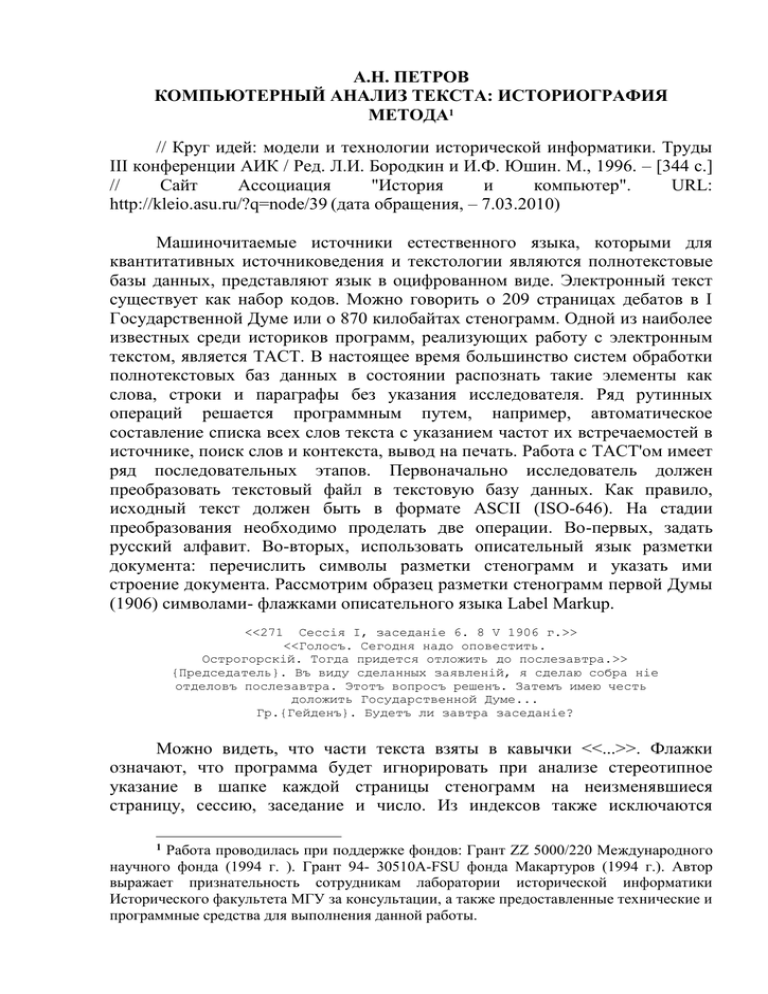

Машиночитаемые источники естественного языка, которыми для

квантитативных источниковедения и текстологии являются полнотекстовые

базы данных, представляют язык в оцифрованном виде. Электронный текст

существует как набор кодов. Можно говорить о 209 страницах дебатов в I

Государственной Думе или о 870 килобайтах стенограмм. Одной из наиболее

известных среди историков программ, реализующих работу с электронным

текстом, является TACT. В настоящее время большинство систем обработки

полнотекстовых баз данных в состоянии распознать такие элементы как

слова, строки и параграфы без указания исследователя. Ряд рутинных

операций решается программным путем, например, автоматическое

составление списка всех слов текста с указанием частот их встречаемостей в

источнике, поиск слов и контекста, вывод на печать. Работа с ТАСТ'ом имеет

ряд последовательных этапов. Первоначально исследователь должен

преобразовать текстовый файл в текстовую базу данных. Как правило,

исходный текст должен быть в формате ASCII (ISO-646). На стадии

преобразования необходимо проделать две операции. Во-первых, задать

русский алфавит. Во-вторых, использовать описательный язык разметки

документа: перечислить символы разметки стенограмм и указать ими

строение документа. Рассмотрим образец разметки стенограмм первой Думы

(1906) символами- флажками описательного языка Label Markup.

<<271

Сессiя I, заседанiе 6. 8 V 1906 г.>>

<<Голосъ. Сегодня надо оповестить.

Острогорскiй. Тогда придется отложить до послезавтра.>>

{Председатель}. Въ виду сделанных заявленiй, я сделаю собра нiе

отделовъ послезавтра. Этотъ вопросъ решенъ. Затемъ имею честь

доложить Государственной Думе...

Гр.{Гейденъ}. Будетъ ли завтра заседанiе?

Можно видеть, что части текста взяты в кавычки <<...>>. Флажки

означают, что программа будет игнорировать при анализе стереотипное

указание в шапке каждой страницы стенограмм на неизменявшиеся

страницу, сессию, заседание и число. Из индексов также исключаются

Работа проводилась при поддержке фондов: Грант ZZ 5000/220 Международного

научного фонда (1994 г. ). Грант 94- 30510A-FSU фонда Макартуров (1994 г.). Автор

выражает признательность сотрудникам лаборатории исторической информатики

Исторического факультета МГУ за консультации, а также предоставленные технические и

программные средства для выполнения данной работы.

1

реплика анонима и Острогорского на странице 271, которые не имеют

отношения к законодательству. При анализе эти части текста сохраняются в

полнотекстовой базе стенограмм, но слова из них не входят в словарь, то есть

не проиндексированы. Особенностью думской деятельности, как и

деятельности прочих законодательных органов представительного характера,

являлось смешение в ходе работы законодательства, текущих проблем

избирателей и процессуальных вопросов. Например, в перерывах для

подсчета результатов голосования о выборах в комиссии обсуждались планы

дальнейших заседаний, отчет комиссии по Белостокскому погрому и многое

другое. Довольно часто на одной странице стенографических отчетов

располагалось обсуждение нескольких несвязанных между собой вопросов.

Поэтому важной задачей при подготовке материалов законодательных

прений для анализа и управления является выделение нужной информации.

Для создания полнотекстовой базы первой Думы берутся страницы

стенографических отчетов с обсуждением законодательства. Попутные

законодательству дебаты размечаются так, чтобы они сохранялись для

просмотра, но исключались при анализе и управлении. Каждый из

законопроектов Государственной Думы преобразуется в отдельную базу

данных. Подобным образом возможно представить законотворчество как

развивавшийся во времени процесс.

Кроме флажков <<...>>, в данном случае можно видеть флажки {...}.

Имена ораторов: Председателя и Гейдена, - находятся в фигурных скобках

{...}. Такими флажками программе ТАСТ указывалось на введение фамилий.

Удобство способа разметки текста с помощью расстановки фигурных скобок

- флажков состоит в том, что можно быстро создать модель содержания

документа. В этом случае после образования базы из размеченного текста

стенограмм программа автоматически показывает список всех ораторов в

дебатах. При моделировании содержания стенограмм удобен язык Label

Markup, так как он позволяет быстрее других обрабатывать большие объемы

текста. В то же время, с его помощью нельзя дать широкое описание

размеченных элементов, как в случае с языками COCOA или BYU. В

конкретном

источниковедческом

исследовании

стенограмм

Думы

потребности в них не возникает, так как ораторы не были организованы

иерархически, а хронологические рамки заседаний единственной сессии

были узкими - 72 дня. Кроме создания модели текста на встречаемости имен

ораторов, для обработки стенограмм также определяется, какие элементы

будут для программы счетчиками концов слов и предложений. Как правило,

это точка, восклицательный и вопросительный знаки.

После создания полнотекстовой базы данных начинается управление и

анализ полученного машиночитаемого источника. Создание запросов к базе

имеет два этапа. Во-первых, можно выбрать слова из образованного

частотного словаря-индекса их встречаемостей в тексте - как вручную, так и

автоматически. Например, с использованием языка запросов к базе данных

задаются вопросы следующего рода: показать все случаи встречаемости

понятия "дворянство" рядом с оратором Гейденом (двор.*; when

2

оратор=Гейден) или показать случаи, когда Председатель употреблял слова

или выражения 37 и более раз (freq>=37; when оратор=Председатель).

Команды подобного рода в TACT'е строятся с помощью библиотеки так

называемого "языка операторов". Во-вторых, при запросе в одной из 5-ти

форм определяется демонстрация результатов обработки: полный текст,

KWIC2 с заданным контекстом, INDEX, график распределений, таблица

конфигураций слов. ТАСТ производит базы данных как из размеченных, так

и неразмеченных языком семантических маркеров текстов. В его состав

входит программа Collgen, которая позволяет автоматически находить в

тексте языковые клише из 2 и более слов 2 и более раз - в зависимости от

выдвинутой проблемы.

Подготовка объёмных нарративных источников, к которым относятся

отчеты Думы, для компьютерного моделирования обычно начинается с

получения оцифрованной версии документа. Этого можно достичь

использованием трех вариантов. Во-первых, применение технологии

сканирования и оптического распознания знаков. Ее весьма часто заменяют

обозначением OCR - Optical Character Recognition. Использование сканера

позволяет получать оцифрованное изображение документа. Оцифровка

анализируется с помощью алгоритмического распознания знаков, что дает

возможность преобразовывать исходный образ текста в машиночитаемый

вид. Проблема применения данного варианта ввода источников в компьютер

заключается в несовпадении результатов развития собственно сканирования,

с одной стороны, и распознания получаемых образов, с другой.

Сканирование, оптическая технология, как более доступные для разработки,

позволяют осуществлять практически все виды работ, связанные с

преобразованием лингвистических источников в машиночитаемые образы.

Дальнейшая

процедура

преобразование

образов

собственно

в

машиночитаемый текст сталкивается со сложностью задачи распознания. По

этой причине количество получаемых ошибок, в зависимости от качества

источника, может превышать разумный порог в 5-10%, что приводит к

необходимости

обращения

ко

второму

варианту

получения

машиночитаемого текста - вводу текста с клавиатуры. Данная альтернатива

OCR имеет широкое распространение в кругах источниковедов,

специалистов по исследованию текста. Наконец, кроме сканирования и ввода

текста с клавиатуры существует возможность использования уже

существующих машиночитаемых источников, подготовленных ранее для

других целей. Как правило, они содержатся в фондах текстовых архивов. К

числу наиболее известных относят International Computer Archive of Modern

English at University of Bergen (ICAME) и Oxford Text Archive, основанные на

коллекциях греческой, латинской и английской литературы. С 1976 года

оксфордский архив занимается распространением электронных текстов среди

2

KWIC - Key-Word-In-Context (Прим. ред.)

3

заинтересованных лиц и организаций3. В Америке такие архивы имеются, в

частности, в университетах Канзаса (MALIN), Маршалла (Byrd) и

Государственном университете Миссисипи.

Развитие международных коммуникаций 1990-х годов в рамках

Internet'а позволило историкам получить оперативный доступ в

компьютерных сетях России к архивам исторических текстов в других

государствах. Старейшим среди текстовых архивов, созданных для этой

цели, считается Исторический архив текстов университета Миссисипи в

США (The Historical Text Archive). В 1993 в Голландии возник Groningen

Historical Electronic Text Archive (GHETA), который также поставил целью

сделать машиночитаемые исторические тексты доступными через Internet.

GHETA связана с международной ассоциацией "History & Comruting",

голландским Архивом исторических данных, университетом Миссисипи,

текстовым архивом в Оксфорде и другими историческим архивами, что

позволяет получать данные из разных мест c помощью процедуры передачи

файлов File Transfer Protocol (FTP)4. Подавляющее большинство

западноевропейских

и

американских

исторических

организаций,

занимающихся архивированием машиночитаемых текстов, связаны частью

единой компьютерной сетью Internet'а под названием HNsource. Благодаря ей

существует, например, возможность работать с большими базами данных на

французском языке в рамках проекта ARTFL Чикагского университета. Его

полнотекстовые базы содержат 2000 французских текстов XVII-XX веков:

литературного, философского, научного характера, - а также коллекции

отсканированных документов.

***

Одной из интенсивно развивающихся отраслей использования

машиночитаемых письменных источников в целях хранения и обработки

является применение семантических языков разметки текста. Оно было

обзорно рассмотрено выше на примере стенограмм. Первоначально понятие

разметки текстов использовалось для описания ссылок и других отметок в

тексте как инструкция для наборщика или машинистки по правилам печати и

оформления. После того, как создание текстов было компьютеризовано,

понятие разметки было расширено для обозначения всех кодов, вставленных

в электронные тексты для управления форматированием, печатью и прочими

видами обработки. В этом смысле разметка является кодировкой для ясного

указания на то, как следует понимать текст. Удобство данного вида работы с

электронными текстами состоит в том, что можно изменять коды без

3

Burnard L.D. Tools and Techniques for Computer- assisted Text Processing // C.S.Butler (ed.) Computers and Written Texts. Oxford UK & Cambridge

USA. 1992. P.1-11.

4

A Comprehensive Guide to Software and Other Resources. Oxford. 1991. P.532-536.

4

изменения источника. Язык разметки указывает правила кодирования

документа, правила отличия знаков кода от знаков текста и что коды

означают. Все языки разметки основаны на трех основных положениях.

Во-первых, на самом примитивном уровне все тексты без исключения

состоят из линий символов. Например, из букв или байтов данных, пометок

на страницах или графики. Они получили название "явления". По сути, это

минимальная частица текста типа слова или точки, рассматриваемая вне

зависимости от структурной или категориальной классификации. В базе

данных из свободного текста "явления" представлены набором байтов для

хранения и обработки.

Во-вторых, на следующем уровне абстракции всякий текст

рассматривается как совокупность объектов различного свойства. Данные

объекты появляются в тексте закономерно в определенном отношении к

прочим объектам. Объекты могут включать друг друга, иметь связи или быть

последовательно представлены. На этом уровне описания текст составлен из

структурно определенных объектов, называющихся "элементами". Однако

тексты не являются простой чередой слов или байтов. Они содержат

примеры объектов, такие как параграфы, заголовки, имена, даты,

представленные последовательностью "явлений". Все схемы разметки

текстов, в большей или меньшей степени, направлены на описание этих

компонентов. Рассмотрение схем указывает по крайней мере три важных

аспекта текстовых объектов, которые нуждаются в распознании. Прежде

всего, это "протяжение" - позиции в текстовом потоке, на которых формы

объекта начинаются и заканчиваются; за ними следует "тип" - категория,

которой предназначены формы объекта, после которой возникает "контекст"

- связи текстовых объектов с формами другого объекта в документе.

Таким образом, и в-третьих, "тип документа" получается на основе

грамматики, определяющей правила объединения классов текста. Подобным

образом природа текста представляется как упорядоченная иерархия

объектов содержания. Различаются два основные типа языка разметки

текстов: процедурный и описательный. Процедурный язык состоит из знаков,

которые изначально ясно указывали на то, как размеченные элементы текста

должны быть распечатаны. Документы, размеченные процедурным языком,

обыкновенно имеют начальную секцию, заголовок, который иногда хранится

в отдельном файле. Заголовок определяет характер знаков, допущенных для

описания текста, и значки, указывающие на отличие знаков процедурного

языка от текста источника- оригинала. В подавляющем большинстве случаев

используются значки {...}, \...\, <...>. Заголовки также могут содержать

заданные пользователем условные символы, с помощью которых сложные

последовательности знаков процедурного языка могут сокращаться для

легкости использования. Подобная разметка текста требует специального

программного обеспечения, которое изначально разрабатывалось для

издательских целей. Различие между процедурным и описательным языками

заключается в том, что описательный язык определяет скорее элементы и

характерные черты документа, чем процедуры обработки. Задачей этого

5

языка является определение различных феноменов в тексте, например,

параграфов,

предложений,

действующих

лиц.

Данное

различие

описательного и процедурного языков рассмотрено в работах специалистов в

области лингвистики и компьютерных технологий, гипертекста, гипермедиа,

глобальных компьютерных сетей.

Остановимся несколько более подробно на выдвинутой общей теории

разметки текста. Всякий раз, когда автор пишет что-либо, он размечает текст.

К разметке относится промежутки между словами, отмечающие их границы,

запятые, отмечающие границы фраз или точки, отмечающие границы

предложений. Обыкновенно, автор постоянно использует два типа разметки

текста в рукописи: пунктуационный и презентационный. Под рукописью

будем понимать любой вид текста. Пунктуационный язык разметки текста,

например, указывает на концы предложений с помощью пробела.

Презентационный язык может содержать, для сравнения, нумерацию страниц

рукописи. Приведенные два типа разметки текста не могут быть

игнорированы из-за того, что на них построена вся система европейского

письма, русского в частности. Пунктуационный язык разметки текста

состоит из набора средств, обеспечивающих первичную синтаксическую

информацию о написанных высказываниях. Из-за относительной

стабильности пунктуации она доступна для большинства читателей. Однако

ее характеризуют сложность в использовании в зависимости от

стилистических вариаций авторов. Социальное разнообразие пунктуации

делает язык богаче, чем усложняет компьютерную обработку текста.

Презентационный язык, по сравнению с пунктуационным, имеет

подчиненный характер. С его помощью делается ясное представление текста.

Он включает в себя горизонтальные и вертикальные границы текста, номера

томов и страниц, цитат и примечаний, а также указания на концы страниц

или специальные символы. Пунктуационный и презентационный языки

относятся к разряду естественных. К разряду электронных языков разметки

отнесены языки описания полнотекстовых баз данных, хранящих

информацию в машиночитаемом виде: процедурный, описательный,

референциальный и метаязык. Разработчики теории семантических языков

делали ставку, прежде всего, на их создание и использование.

Упомянутый ранее процедурный язык в компьютерный системах

обработки текстов заменил презентационный. Процедурный язык часто стал

набором компьютерных команд, определяющих, каким образом следует

форматировать текст в конкретных программах. Принцип использования

описательного языка изложен выше. Остановимся на референциальном

языке. Он обращен к задаче замены пунктуации на ее описание, например

"точка" вместо "." или "тире" вместо "-". Это может упростить процедуру

компьютерную интерпретации текстов, отличающихся разнообразием

пунктуации. Референциальный язык также использует библиотеки замен,

хранимых в отдельном файле или другой компьютерной системе. Строго

говоря, в этом он сближается с описательным языком. Наконец, метаязык

6

предоставляет

пользователю

возможность

контролировать

и

интерпретировать все языки обработки текстов.

Для историков, имеющих целью анализ текста, более всего подходит

описательный язык. Документы, размеченные описательным языком, также

как и закодированные с помощью процедурного, имеют заголовок,

содержащий допущенные знаки описания5. Однако знаки разных

описательных языков могут отличаться от процедурного и между собой. Для

того, чтобы было возможно переформулировать тексты, размеченные

разными языками, существует метаязык Standard Generalized Markup

Language (SGML) - стандартный обобщенный язык разметки. В середине

1980-ых SGML как инструмент текстологии получил официальное признание

Международной Организацией Стандартов. В 1987 для простоты

использования электронных текстов в исследованиях возник международный

научный проект Text Encoding Initiative (TEI)6. Для стандартизация

обработки электронных источников TEI использует SGML7.

Среди разработчиков большинства программ обработки текстов

преобладали математики и лингвисты, из-за которых программное

обеспечение стало отвечать прежде всего задачам лингвистического и

литературного анализа8. Проблема историчности текстов разработчиками не

ставилась и не решалась. Поэтому конкретно историческое изучение

текстовых источников с помощью компьютерного контент-анализа обычно

сопровождается классической научной критикой: определением временных и

пространственных факторов, прямо и косвенно присутствующих в

документах, их социальной направленности, общественного контекста

возникновения источника, изменением смыслового содержания понятия во

времени, "эзопова языка", - то есть учетом совокупности факторов, лежащих

5

Coombs J.H. Markup Systems and the Future of Scholarly Text Processing in Communications of the ACM. Vol. 30. № 11 (November, 1987). P. 933-947; Katzeff C. System Demands on Mental Models for a Fulltext Database in International Journal of Man-Machine Studies. 1990. N32. P. 483- 509.

6 Computers and the Humanities. Vol. 29. № 1. 1995. The Text Encoding Initiative:

Background and Contexts.

7 International Standards Organization (ISO): 8879: Information Processing: Text and

Office Systems: Standard General Markup Language (SGML). Geneva. 1986; ISO/TR 9573: Information Processing - SGML Support Facilities - Techniques for Using SGML (ISO,1988);

C.M.Sperberg- MacQueen and L.D. Burnard (eds.) Guidelines for the Encoding and Interchange

of Machine-Readable Texts. Edn. P1. Oxford. 1990. Ch. 2; L.D. Burnard. What is SGML and

How Does it Help? // D.I. Greenstein. Modelling Historical Data. St. Katharinen. 1991. P. 65-80;

Goldfarb C. The SGML Handbook. Oxford. 1991; van Herwijnen E. Practical SGML. Kluwer.

1990.

8 The Computer & Literary Style: Introductionary Essays and Studies. Ed. by J. Leeds.

Kent. Ohio. 1966; Meadow C.T. Text Information Retrieval Systems. San Diego. 1992; Wood J.

European Directory of Text Retrieval Software. Aldershot. 1993; Sabourin C.F. Computational

Linguistics in Information Science: Information Retrieval (Full Text or Conceptual), Automatic

Indexing, Text Abstraction, Content Analysis, Information Extraction, Query Languages.

Bibliography. Montreal. 1994; Автоматизация обработки текста. НТИ. Сер.2. 1981. № 2.

7

за пределами вычислительной лингвистики. В этом случае большую роль

начинают играть исследования по теории и практике аргументации,

риторике, социальной семиотике, психолингвистике, лингвистической

семантике, прагмалингвистики и теории массовой коммуникации9. Разметка

текста языками семантических маркеров не может полностью решить задачи

анализа социальной информации. В исторической науке компьютерный

анализ текста развивается одновременно с источниковедением в области

машиночитаемых документов, основной проблемой которого следует назвать

правильное создание и использование формализованных данных, среди

которых интерес для текстологии представляют полнотекстовые базы

данных10. Понятие "анализ текста" в большинстве случаев использовалось

историками-клиометристами для обозначения всего, что не является просто

поиском в документе и проверкой правописания. Среди формальных методов

обработки исторических текстов на первом месте обычно упоминается

контент-анализ.

***

Обычно термин "контент-анализ" используется для обозначения двух

разных вещей: метода для автоматической классификации документов по

содержанию и метода для раскрытия значения слов и идей. Автоматическая

классификация документов в течение ряда лет используется в историкосоциальных науках и библиографических системах поиска. Текст, его резюме

или заголовок служат основными основами классификации. Напротив,

семантический контент-анализ нацелен на определение организации слов

вокруг идей или понятий в большей степени, чем на организации текста.

Суть подхода заключается в сведении изучаемого текста к ограниченному

набору определенных элементов, которые затем подвергаются счету и

анализу на базе фиксации частоты повторяемости символов и их корреляции

друг с другом. Слова в тексте при этом классифицируются в соответствии с

Брутян Г.А. Аргументация. Ереван. 1984.; Тартуский Государственный

Университет. Труды по знаковым системам. XVII. Вып. 641. Структура диалога как

принцип работы семиотического механизма...; Представление знаний и моделирование

процессов понимания. Новосибирск.1980; Павиленис Р.И. Проблема смысла.

Современный логико- философский анализ языка. М.,1983; Лурия А.Р. Язык и сознание.

М., 1979; Рациональность, рассуждения, коммуникация. Киев, 1987; Семиотика. М., 1983.

С. 37-89, 118-482, 488; Язык и мышление. М., 1967. С. 17, 18, 34, 35, 37, 65; Панфилов В.З.

Логика и грамматика. М., 1963. С. 3, 224, 232, 228; Семиотика, коммуникация, стиль. М.,

1983. С. 37-83, 91; Язык, идеология, политика. ИНИОН. М., 1982; Прагматика и

семантика. ИНИОН. М., 1991.

10 Clubb J.M. Computer Technology and the Source Materials of Social History in Social

Science History. 1986. № 10. P. 97-114; Greenstein D.I. Historians as Producers or Consumers

of Standard – Conformant, Full-Text Datasets? Some Sources of Modern History as a Test Case

in Greenstein. Modelling Historical Data. P. 179-194; Greenstein D.I. A Historian's Guide to

Computing. Oxford, 1994. P. 158-199; Zweig R.W. Virtual records and Real History // History

and Computing. 1992. № 4. P. 174-182.

9

8

их дистанционными связями между собой. Для этого используется

лингвистическая и статистическая техника, например кластерный анализ или

анализ связей. В распоряжении текстологов находится ряд программ

автоматизированного анализа для компьютеров IBM. Среди них назовем

ARRAS, TACT, TextPack V, SYREX, SATO11.

Контент-анализ в литературных и лингвистических расчетах начал

интенсивно развиваться в 1950-х годах. Он оказался приемлемым для

изучения широкого круга проблем гуманитарного знания и социальных

наук12. Контент-анализ нашел эффективное применение в исследованиях

этно-культурных, политических явлений, истории мысли 13. Социологи,

специализировавшиеся на исследованиях массовой коммуникации,

приступили к разработке контент-анализа в основном в США. В дальнейшем

при участии математиков его применили в политологии, философии,

лингвистике14. Применение контент-анализа в истории оказалось ограничено

потребностью в сильной классической традиции в значительно большей

степени, чем в эмпирической социологии или психологии, построенных на

методическом

фундаменте

непосредственных

наблюдений

и

15

экспериментов . Кроме того, контент-анализ, несмотря на видимую

интердисциплинарность, был разработан прежде всего в связи с

11

Lancashire I. (ed.) The Humanities Computing Yearbook. 1989/90. A Comprehensive

Guide to Software and Other Resources. Oxford, 1991. P. 489-497.

12 I. de Sola Pool (ed.). Trends in Content Analysis. Urbana. Ill. 1959; Holsti O. Content

Analysis for Social Science and Humanities Research. Reading. Mass. 1969; Jones A. and

Churchhouse R.F. (eds.) The Computer in Literary and Linguistic Studies (Proceedings of the

Third International Symposium). Cardiff, 1976; Weber R. Basic Content Analysis. Newbury

Park. Calif, 1990.

13 Carney T.F. Content Analysis. A Review Essay in Historical Methods Newsletter.

1971. № 4. P. 52-61; Merritt R.L. The Emergence of American Nationalism. A Quantitative Approach in American Quarterly, 1965. P. 319-335; Dautrey P. Les Declaration des droits de

l'homme. Une approche quantitative in L'Ordinateur et le metier d'historien. IVe Congres History

and Computing. Volume des actes. Bordeaux, 1990. P. 65-73; Tavernier P. L'Eritage de 1789 et

de 1848 dans la Declaration universelle de 1948 in Le droits de l'homme et la conquete des libertes. Grenoble, 1988; Olsen M. and Harvey L.-G. Computers in Intellectual History. Lexical Statistics and the Analysis of Political Discourse in Journal of Interdisciplinary History. 1988.

№ 18; Olsen M. The Language of Enlightened Politics. The Societe de 1789 in the French Revolution in Computer and the Humanities. 1989. № 23. P. 357-364.

14 Berelson B. Content Analysis in Communication Research. N.Y., 1952; Laswell H.D.,

I.Pool de Sola. The Comparative Study of Symbols. Stanford. Calif, 1952; The Analysis of

Communication Content. N.Y., 1969; Advances in Content Analysis. L., 1981; Smith B.L. et al.

Political Research Methods. Foundation and Techniques. Boston., 1976.

15 Sociology and History: Methods. L., 1968; Ядов В.А. Социологические

исследования: Методология, программа, методы. М., 1972; Проблемы контент-анализа в

социологии. М., 1970; Баранов А.В. Опыт текстового анализа газеты // Информационный

бюллетень ССА и ИКСИ АН СССР. 1966. № 9; Бородкин Л.И. Контент-анализ и

проблемы изучения исторических источников // Математика в изучении средневековых

повествовательных источников. М., 1986. С. 8-27.

9

потребностями социологических исследований содержания массовой

коммуникации. Социологи сформулировали общие теоретические принципы

формализации эмпирических данных, приемов анализа текстов, которые с

тех пор стали совокупно называться контент-анализом. Некоторые проблемы

применения данного типа анализа в истории оказались внешними

проявлениями ряда теоретико-методологических расхождений между

исторической наукой и социологией, как близких, но самостоятельных

социальных наук. Социологизированность контент-анализа – специфическая

черта – осложнилась прямой зависимостью результатов исследования от

того, что именно в тексте исследователь считает возможным подвергнуть

формализации, подсчету, а также какими теоретико-методологическим

принципами при этом он намерен воспользовался. В классической статистике

данная проблема решается на первом этапе составления формуляра для сбора

эмпирических данных. В текстологии ее решают в ходе анализа

эмпирического материала. Проблема формализации в текстологии более

сложна. Вопрос о корректности изучения формализованных текстов в

значительно большей степени открыт для критики по сравнению с методикой

в изучении хорошо структурированных источников типа переписей или

фабрично-заводской статистики. Однако проблема теоретического анализа,

проведенного до и после вычислений, остается общей. Моделирование в

политической и социально- экономической истории постоянно испытывает

ее влияние как результат фундаментальных объектно-субъектных отношений

в области эпистемологии.

В количественном анализе повествовательных источников интересный

вопрос также представляет теоретическая возможность выборочного

научного изучения материалов. В ряде случаев не представляется

возможным выработать универсальный критерий и метод отбора внутри

единого корпуса документов, то есть выборки из генеральной совокупности,

в отличие от ряда статистических данных, характеризующихся массовостью

и повторяемостью. Использование всеобщего принципа представительных

выборок не выдерживает критики в текстологии из-за отсутствия

однородности содержания документов единого корпуса. Теоретически

трудно исключить при правовом анализе документов аграрной политики,

например, какой-либо проект из единого портфеля законодательных реформ

Думы.

Методы контент-анализа привлекались при исследованиях различных

по времени и характеру повествовательных источников. Ближе всего к

социологическому фундаменту этого метода оказались исследования

исторической прессы. Именно для периодики контент-анализ был

разработан, и благодаря интересу к процессам массовой коммуникации

историки получили возможность формального анализа текстов.

Благодаря постоянному поиску методов текстологии, появились

исследования политического мышления с помощью когнитивного

картирования, преобразующего линейную аргументацию в иерархическое

10

древо16. Несмотря на ряд нерешенных проблем формализации рассуждений,

данные исследования сохранили методологическую значимость. Отход от

принципа линейности стал удобным способом перестройки информации в

дальнейших лингвистических, исторических, философских исследованиях,

разработках программного обеспечения для анализа письменных

источников17.

Вообще,

методологические

проблемы

применения

когнитивных методов в исследованиях заняли особое место среди

специалистов в области моделирования социального взаимодействия,

социальной психологии и политического мышления из-за того, что

формальный анализ в перечисленных социальных науках развивался под

определяющим влиянием американского математика Аксельрода и группы

исследователей во главе с Бонемом и Шапиро, увлекавшимся французским

структурализмом под влиянием Фуко.

Обращение к ментальным категориям основано на стремлении

объяснить процесс принятия решения с помощью методов понимания текста,

теоретически-игрового моделирования. Подробно проблемы когнитивного

картирования и операционного кодирования как взаимодополняющих

методов анализа процесса принятия решения рассматрены в статье известных

норвежских политологов Херадствейта и Нарвесена. Они разобрали ряд

методологических вопросов использования кодирования и картирования как

методов когнитивной репрезентации политического мышления при помощи

компьютера18. Ко времени написания статьи исследования по

компьютерному моделированию политического мышления носили

экспериментальный характер. Начало им положили работы профессора

Йельского университета Абельсона. Абельсон стал известен рядом

междисциплинарных работ по применению методов компьютерного

моделирования к изучению политического мышления и развитию

когитологии. Им была создана одна из первых иерархических моделей

понятийных структур. Работа Абельсона в области "когнитивного

диссонанса" положила начало сотрудничеству с Шенком, результатом

которого стала совместная книга и ряд систем интерпретации политических

Луков В.Б., Сергеев В.М. Опыт моделирования мышления исторических

деятелей: Отто фон Бисмарк. 1866-1876 // Вопросы кибернетики. Логика рассуждений и ее

моделирование. М., 1983. С.148-161.

17 Когнитивные исследования за рубежом. Методы искусственного интеллекта и

моделирования политического мышления. М., 1990; Когнитивная наука и

интеллектуальная технология. М., 1991; Системные исследования. 1983. Ежегодник. М.,

1983. С. 254-278; 1984. М., 1984. С. 116-129; 1985. М., 1986. С.83-102; 1986. М.1987. С.

262-282, 319-334, 398-425; 1987. М., 1988. С. 76-98, 420-456; Philip E. Tetlock. Integrative

Complexity of American and Soviet Foreign Police Rhetoric: A Time-Series Analysis // Journal

of Personality and Social Psychology. 1985. Vol. 49. № 6. P. 1565-1585.

16

Херадствейт Д., Нарвесен Д. Психологические ограничения на принятие решения

(обсуждение когнитивных подходов: операционный код и когнитивная карта) // Язык и

моделирование социального взаимодействия... С. 381-406.

18

11

текстов19. Впоследствии идеи Абельсона и Шенка были воплощены

Карбонелом в программе POLITICS.

Резюмируя, отметим, что компьютерный анализ исторических текстов

вобрал в себя достижения нескольких научных подходов. Выяснилось,

например, что при обработке и анализе текста для исследователей важное

значение имеет показ частоты встречаемости различных классов лексики

(concordances). Это позволяет точно определять значение конкретных слов и

фраз в контексте. Совместная встречаемость частей речи впервые была

использована на практике при изучении точного значения слов Бога и

пророков в библейских текстах. Первое компьютеризированное

исследование в данной гуманитарной области было проведено священником

Бузой для составления частотного словаря работ Фомы Аквинского. В

дальнейшем католические теологи, вставшие у истоков исторической

количественной

филологии,

создали

самостоятельную

школу

компьютеризированного анализа сакральной литературы с центром во

французском католическом университете г. Лувен. В 1968 при нем был

образован Центр электронной обработки документов CETEDOC20.

Подчеркнем, что совместная встречаемость, исследованная впервые

теологами, не является статистической мерой. Это реорганизация

текстологической информации для выделения контекста использования

определенных слов21. Компьютерный показ совместной встречаемости слов

является по существу самым старым и наиболее распространенным способом

применения компьютера в гуманитарной области. Начиная с 1950-х годов

большинство современных и старых европейских языков были подвергнуты

подобной обработке, что привело к включению анализа встречаемостей в

состав расхожих методов текстологии и исчезновению представления о нем

как о новом и экспериментальном22.

19

Shank R.C., Abelson R.P. Plans, Scripts, Goals and Understanding. Hillsdale. 1977;

Шенк Р. Обработка концептуальной информации. М., 1980.

20

Hockey S. An Historical Perspective in Rahts. Information technology in the Humanities. P. 22; Tombeur P. Research carried out at the Centre de Traitement Electronique des Documents of the Catholic University of Louvain // Aitken A.J. et al. (eds.) The Computer and Literary Studies. Edinburgh, 1973. P. 335-340; Hamesse J. Automatic Processing of Philosophical

Works at the Catholic University of Louvain in Ibid. P. 341-344.

21 Hockey S. A Guide to Computer Applications in the Humanities. London. 1980. P. 4149; Lancashire I. The Humanities Computing Yearbook. 1989/1990. P. 485; Slaby W.A. Concordances to the Greek New Testament and to the Bad Quartos to the Works of Shakespeare:

two Strategies for an Automatic Selection of Context in D.E. Ager, F.E. Knowles, Joan Smith.

Advances in Computer-aided Literary and Linguistic Research. Proceedings of the Fifth International Symposium on Computers in Literary and Linguistic Research. Birmingham, 1979. P.

117-127; Bedford E.G., Dilligan R.J. (eds.) A Concordance to the Poems of Alexander Pope. Detroit, 1974.

22 Parrish S.M. (ed.) A Concordance to the Poems of Matthew Arnold. Itaca. 1959; Bevan

E.D. (ed.) A Concordance to the Plays and Prefaces of Bernard Shaw, 10 vols. Detroit, 1971.

12

Одним из способов демонстрации совместной встречаемости может

являться перечень слов с указанием на местонахождения, причем ключевые

слова показываются справа или слева от контекста. В данном случае

перечень не может расцениваться как достаточная для историка перестройка

текста, при которой желательно демонстрировать семантическое окружение

для каждой встречаемости. Без этого исследователь, использующий

подготовленные результаты, не может избежать необходимости постоянного

обращения к оригиналу для проверки использования слова23. С подобной

формой изложения результатов на границе контекста связан формат

демонстрации совместной встречаемости KWOC - "ключевое слово без

контекста"

(keyword-out-of-context),

который

разрабатывался

для

24

исследования прозаических текстов .

Вместе с анализом прозы тесно развивалось изучение поэтического

языка с акцентом на демонстрирование контекста слов в поэтической строке

как основной единице произведения. Большинство исследований в создании

компьютерных программ для показа совместной встречаемости классов

лексики последовали данному принципу25. В результате специалисты

пришли к альтернативному KWOC'у формату - "ключевое слово в контексте"

KWIC (keyword-in-context). Вместо демонстрирования полного контекста

предложения, часто занимавшего несколько строк, как это было возможно

при принятии формата KWOC-формата, KWIC демонстрировал ключевые

слова в центре экрана компьютера с контекстом, умещающимся на одной

строке. В качестве примера использования KWIC'а может быть использована

демонстрация контекста термина "парламент" в стенограммах Думы,

приводимая ниже. При включении данных в исследования, организованные

на основе KWIC'а или KWOC'а, специалистами часто подчеркивается

отрицательное воздействие на результаты слабой критики источников,

предварявшей расчеты. Это выражается в неясности методики исследования,

ограниченности выводов, излишней детализации26.

В числе наиболее эффективных программ для исследования

совместной встречаемости в формате KWIC довольно часто упоминается

COCOA (COunt and COncordance Generation on Atlas), разработанная

23

Hancock L. (ed.) Word Index to James Joyce's Portrait of the Artist. Carbondale.

Southern Illinois University Press. 1967.

24 Jacobson S.C., Dilligan R.J. and Bender T.K. (eds.) A Concordance to Conrad's Heart

of Darkness. Carbondale. Southern Illinois University Press, 1973; Jacobson S.C., Dilligan R.J.,

Bender T.K., and Parins J.G. Report on the Project in Literary Applications of Computer Technology at the University of Wisconsin-Madison in Newsletter of the Special Interest Group on

Language Analysis and Studies in the Humanities, Association for Computing Machinery. 7.

June 1974. № 3. P. 12-14.

25 Crosland A.T. (ed.) A Concordance to the Complete Poetry of Stephen Crane. Detroit,

1975; Crosland A.T. (ed.) A Concordance to F.Scott Fitzgerald's The Great Gatsby. Detroit,

1975.

26 Reaver J.R. (ed.) An O'Neil Concordance. Detroit. 1969; W.Ingram. Concordances in

the Seventies in Computers and the Humanities. 1974. № 8. P. 273-277.

13

компьютерной лабораторией "Атлас" в Англии (Chilton Atlas Computer

Laboratory). Программа написана для демонстрации совместной

встречаемости слов и их подсчета британским ученым Расселом (D.B.Russell)

в 1967. СОСОА состояла из частотного профиля и трех таблиц, содержащих

список слов с указанием частоты их встречаемости в тексте, словаря и

порядка "графической рифмовки". Она была в состоянии показывать и

сортировать ключевые слова в контексте27. Заметим, что существует

возможность показа не только слов, но и букв в контексте - KLIC (key-letterin-context). Однако последние 30 лет автоматическое индексирование и

исследование конфигураций слов в формате KWIC показывало, главным

образом, частоту слов в тексте и списки ключевых слов в контексте28.

Программы реорганизовывали линейный текст "вертикально" таким образом,

что каждая форма каждого слова могла быть быстро найдена по

правописанию или словарной форме. Выгоды нелинейного представления

текста, использованные в когитологии, политологии и истории, были развиты

текстологами. Принципы СОСОА в KWIK'е оказались использованы в ряде

программ для IBM-совместимых компьютеров. Среди них часто

упоминаются Oxford Сoncordance Programm (OCP; Hockey, Martin, 1988:

переработана в Micro-OCP), WordCruncher (Jones, 1987), TACT (Bradley,

Presutti 1990), KAYE (Kaye, 1989), CLAN (MacWhinney, Snow, 1990). Они

позволили решать некоторые вопросы стилистического, лингвистического,

лексического анализа во много раз быстрее по сравнению с предыдущими

программами. В последние десять лет новое поколение программного

обеспечения использует эффективную обработку текста, опирающуюся на

"топографический" принцип реорганизации слов в тексте. Они представлены

в форме нелинейных гистограмм на основе их позиции в линейном тексте.

Программы WordCruncher и Tact позволили показать распределение

определенных слов в форме графика, на котором видно наличие или

отсутствие таких слов в частях текста29. Эти слова иногда называют

"плюсовыми" или "минусовыми", когда они встречаются более или менее

часто в одном месте, а не в другом.

***

Для иллюстрации этих возможностей обратимся к динамике появления

конфессиональной категории "мусульманство" в стенографических отчетах

первой Думы (законопроект "О гражданском равенстве"). Эта динамика

27

Berry-Rogghe G.L.M. and Crawford T.D. Developing a Machine-Independent Concordance Program for a Variety of Languages // Aitken A.J., Bailey R.W. and Hamilton-Smith

(eds.) The Computer and Literary Studies. Edinbourgh, 1973. P. 309-316.

28 Lancashire I. Back to the Future. Literary and Linguistic Computing 1968-1988 in Literary and Linguistic Research. Literary and Linguistic Computing. 1988. Ed. Y.Choueka. ParisGeneve, 1990.

29 Mark Hawthorne. The Computer in Literary Analysis: Using TACT with Students //

Computers and the Humanities. Vol. 28. № 1. 1994. P. 19-27.

14

отражена 10% интервалами, разбивающими весь текст дебатов на 10 равных

частей.

Текст отчетов Количество упоминаний о График распределения ключевых понятий

0-10%

0

10-20%

0

20-30%

0

30-40%

4

40-50%

0

50-60%

0

60-70%

0

70-80%

4

>>>>

80-90%

61

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

90-100%

19

>>>>>>>>>>>>>>>>>>>>

Всего:

88

>>>>

"Топографический" принцип демонстрации распределения терминов

говорит, что в первой трети текста и в промежутке 40-70% базы данных

категория "Мусульманство" была "минусовой", то есть не встречена. В

промежутках 30-40% и 70-100% категория стала "плюсовой", то есть в этих

местах появились упоминания о мусульманах.

Одной из возможностей "топографического" анализа стало изучение

ассоциаций слов и моделей словесных комбинаций. Они показывают в

табличной форме, какие конфигурации встречены с определенным словом

или словами внутри контекста. Данные пакеты обыкновенно имеют три этапа

работы: 1. разбивку текста на слова и фиксирование их к определенной

позиции в тексте; 2. сортировку слов в алфавитном порядке; 3. подсчет

частоты встречаемости каждого слова и их совместной встречаемости.

Большинство современных программ обработки текста, в том числе ТАСТ,

выделяют заданное исследователем слово, показывают в скобках количество

его нахождений в тексте (7), подсчитывают номер строки, на которой

встречено слово (1409) и заданную границу контекста - |. Перестройка текста

стенографических отчетов демонстрирует семантическое окружение

ключевого термина думских дебатов "парламент".

парламентъ (7)

(1409) существующее всюду, где | есть >парламентъ, правомъ какого

(1448) это известнымъ афоризмомъ: | >парламентъ все можетъ сделать,

(3026) | Тутъ указывалось на то, что>парламентъ не можетъ

(3028) | не сказалъ бы, что поэтому >парламентъ не можетъ уравнять

(3029) въ правахъ. Совершенно также >парламентъ мо-| жетъ уравнять

(3320) речь справедливымъ афоризмомъ:>парламентъ не можетъ прев-|

(3322) требуетъ | невозможнаго. Но всякiй>парламентъ не только можетъ,

Статистические методы анализа текстовых структур представлены в

сопряженном с демонстрацией совместной встречаемости методе анализа

комбинации слов (collocate analysis). Его задачей является определение слов

15

или совместной встречаемости слов, использованных в соединении с

определенными исследователем ключевыми словами в изучаемом тексте.

Для этого выбираются узловое слово или группа слов, которые объединены

идеей или объектом, затем собираются все слова вокруг каждой

встречаемости узловых слов. Собранный таким образом контекст образует

минитекст. Затем производится анализ частоты встречаемости слов в

минитексте. Он включает все комбинации узловых слов. После этого

производится сравнение ожидаемой частоты встречаемости комбинации в

минитексте с действительной частотой встречаемости, что является мерой

притяжения комбинации узла. Например, сила связи и комбинация слов

вокруг понятия "гражданин" в стенограммах Думы дает (в программе Tact)

нижеприведенную картину (без демонстрации промежуточных расчетов):

Совместная встречаемость

(Collocates)

Частота встречаемости

(Collocate Freq)

Частота типа

(Type Freq)

Сила связи

(Z-score)

равенстве

17

35

13.563

обоего

5

5

11.013

передъ

10

26

9.048

закономъ

10

27

8.842

пола

6

11

8.616

равны

6

12

8.193

правами

7

16

8.180

свободы

5

9

7.948

равноправiю

3

4

7.290

В первой колонке указываются слова-соседи понятия "гражданин". Во

второй колонке приводится частота употребления слова первой колонки

непосредственно с ключевым словом. Например, "равенстве", встречено 17

раз. Третья колонка указывает общую частоту появления слова "равенстве" в

тексте - 35. При дальнейшем анализе силы связи ключевого слова с

окружающей лексикой учитывается граница контекста ключевого слова, то

есть количество слов в необходимой фразе, окружении (span). Результатом

анализа частот в двух колонках таблицы является интегральный показатель

Z-score, который обеспечивает измерение значимости лексических

комбинаций. Максимальное значение Z-score в лексикометрии является

предельной силой связи слов. Чем выше значение, тем меньше вероятность,

что лексическая комбинация появляется вблизи ключевого слова случайно30.

30

Berry-Rogghe G.L.M. Computation of Collocations and their Relevance

in Lexical Studies in Aitken A.J. et al. (eds.) The Computer and Literary Studies.

Edinburgh, 1973. P. 103-112; Olsen and Harvey. Computers in Intellectual History. Ibid. P. 456-458.

16

Значение Z получило широкое распространение в квантитативной

лингвистике, контент-аналитических исследованиях. Введем его точный

смысл. Пусть:

Z - общее количество слов в тексте

A - заданная лексическая единица, встреченная в тексте Fn раз

B - другая лексическая единица, встреченная в тексте Fc раз

K - частота встречаемости B в контексте A

S - "длина контекста", т.е. количество слов вокруг A, рассматриваемых как

окружение A.

Вероятность встречаемости В в каком либо месте текста, где А не встречено, выражается

формулой:

р=Fc/(Z-Fn)(1)

Ожидаемое количество совместных встречаемостей A и B выражено в виде:

E=p.Fn.S(2)

При этом возникает проблема принятия решения о том, является ли

разница между наблюдаемой и ожидаемой частотами статистически

значимой (т.е. насколько уверенно можно отвергнуть гипотезу о случайности

совместной встречаемости A и B). Решение может быть найдено с помощью

вычисления так называемого "значения Z" или "Z- score" как нормальной

аппроксимации (приближения) биномиального распределения:

z=(K-E)/\|Eq ,q=1-p(3)*

Опыт анализа исторических текстов продемонстрировал возможность

получения интересных научных результатов при использовании простых

статистических методов. Например, стало возможно говорить о силе связи в

компьютерном контент-анализе. Если "значение Z" выше 2.75, то связь

категорий представляется достаточно сильной. Если же "значение Z"

превышает 4.0, имеет смысл обращать пристальное внимание на подобного

рода связь.

Вслед за простыми статистическими методами анализа текстологи

обратились к изощренному математическому аппарату от Хи-квадрата до

Фурье-анализа. Это привело к тому, что большинство специалистовгуманитариев

отошло

от

самостоятельного

применения

тонких

количественных методов. При этом стоит отметить, что идея применения,

скажем, Хи-квадрата в текстологии доступна для историков. Таким образом

тестируется статистическая гипотеза или теоретическая модель, где

необходимо сравнивать ожидаемые и наблюдаемые частоты номинальных

переменных. Тест показывает уровень соответствия математической модели

наблюдаемым данным, например, длине предложений. Впрочем, данные

теоретические выкладки из области лингвистической статистики могут

опускаться непосредственно при анализе. По этой причине у гуманитариев

*

Hoel P.G. Introduction to Mathematical Statistics. N.Y. 1962; C.Butler. Statistics in

Linguistics. Oxford, 1985; Butler C. Computers in Linguistics. Oxford, 1985.

17

широкое распространение получили программы, не требующие знаний

программирования, управления данными, статистики, однако позволяющие

получать результаты на основе простых баз и анализа. В их числе часто

называют Micro-OCP, WordCruncher и ТАСТ31.

***

К одному из наиболее используемых историками количественных

приемов исследования относится анализ стиля. В отличие от контентанализа, стилистическое исследование основано на классификации текста по

авторству, а не по предмету. Обыкновенно специалисты останавливаются на

статистическом описании частей речи, суффиксов, постфиксов, аффиксов,

префиксов, фраз, частей речи, предложений в работах различных авторов для

раскрытия индивидуальностей стиля или с целью отличия от других

писателей. История современной статистической стилистики восходит к 1851

году, когда де Морган высказал мнение, что длина слов могла бы быть

доказательством различия стилей писателей32. Стилометрические тесты

различных текстов и сравнение полученных результатов дают основания

исследователям

исторической

литературы

определять

авторство

неатрибутированных документов и выяснять влияние разных авторов друг на

друга. Одним из наиболее результативных подходов в стилометрии является

выяснение соотношения общего количества слов в тексте со словарным

запасом конкретного писателя: tokens vs types. Отношение словаря к общему

количеству слов в статистике определяется термином ratio, то есть

отношение между двумя значениями, определяемое частотой содержания

одного в другом. Значения ratio находятся между 0 и 1. Чем больше значение

ratio, тем богаче словарный состав, то есть определенное слово встречается

реже, чем в случае с меньшим ratio, когда бедность словаря приводит к

частой повторяемости одних и тех же слов.

Тонкость средств стилометрии требует осторожности в их применении.

Существенную роль может играть жанр источника анализа, что например

относится к периодике или стенограммам. Подшивка газетных статей,

стенограмма выступлений политика и его автобиография могут различаться

по стилю. В силу этого стилометрическому анализу должна предшествовать

типологическая критика источников.

31

David S. Miall. Beyond the Word: Reading and the Computer in The Digital Word:

Text-Based Computing in the Humanities. Cambridge. London, 1993. P. 328, 332; Text Retrieval: A Directory of Software. Ed. by R. Kimberley. Aldershot. Gower, 1990.

32 Bailey R.W. Statistics and Style: A Historical Survey in Statistics and Style. N.Y.,

1969. P. 217-236; Allan R.F. The Stylo-Statistical Method of Literary Analysis // Computers and

the Humanities. 1988. № 22. P. 1-10; Бородкин Л.И., Милов Л.В., Морозова Л.Е. К вопросу

о формальном анализе авторских особенностей стиля в произведениях Древней Руси //

Математические методы в историко-экономических исследованиях и историкокультурных исследованиях. М., 1977.

18

Несмотря на все проблемы использования, количественный анализ

текста представляет непреходящий интерес. Исследования русского языка

позволили американским диалектологам исследовать глубокие проблемы

различия между русским и немецким стилями33. Стилистический анализ

позволил продемонстрировать влияние учения Локка на личность

Джефферсона, проследить процесс проникновения идей шотландского

просвещения на американскую революционную мысль. Анализ стиля вместе

с контент-анализом использовался для создания родословной американского

радикализма и его влияния на политическую культуру дебатов на основе

сравнения революционных памфлетов с документами американских

политических партий и групп по интересам ХIХ-ХХ веков34. В ряде случаев

вопросы исторической науки решаются при привлечении лингвистического

анализа использования единого языка различными социальными и

региональными группами и взаимных заимствований лексики разными

языками. Техника таких исследований проливает свет на связи между

иммиграцией и изменением культуры и ценностей, в частности британской

Северной Америки. При изучении политических дебатов лингвистика

позволила выяснить степень независимости развития культуры и политики

рабочего класса от буржуазного влияния в ХIХ-ХХ веках35.

Феномен

использования

машинной

обработки

полученных

исследователями текстов часто связывается с "компьютерным критицизмом".

Он определяется как использование компьютера для решения двух задач. Вопервых, в целях автоматизированного сбора информации для критического

анализа и ее представления. Во-вторых, для применения аналитических

моделей к текстовой информации. Методологические основы критицизма

были статистически развиты в работе, посвященной творчеству В. Блейка36.

Решение первой задачи компьютерного критицизма не вызывает серьезной

критики, так как в результате даются неоспоримые характеристики слов,

например, частота встречаемости и позиции в тексте. То есть исследователь

33

Winter W. Styles as Dialects in Statistics and Stile. N.Y., 1969. P. 3-9.

Srinivasan S. Style in Syntax. A Computer Aided Quantitative Study // Lusignan S.,

North S. (eds.) Computing in the Humanities. Proceedings of the Third International Conference

on Computing in the Humanities. Waterloo. Ont., 1977. P. 85-97.

35 Hockey. A Guide to Computer Applications. P.79- 84; Kirk J. Word Maps of East Central Scots. A Computerised Package // Fenton A. (ed.) Third International Conference on the

Languages of Scotland. Edinburgh. 25-27 July 1991 (forthcoming); Kirk J., Munroe G. A Method for Dialectometry // Journal of English Linguistics. 1989. № 22. P. 97-110; Kirk J., Munroe

G., O'Kane M.D.J. Electronic Word Maps // Hockey S., Ide N. (eds.) Research // Humanities

Computing 2 (forthcoming); Fisher D.H. Albion's Seed. Four British Folkways in America. Oxford, 1989; Smith O. The Politics of Language. 1791-1819. Oxford, 1989; Stedman Jones G. Rethinking Chartism in G. Stedman Jones (ed.) The Languages of Class. Studies in English Working-Class History. 1832-1982. Cambridge, 1983. P. 90-178.

36 Smith J.B. Computer Criticism in Style. 12.4 (Fall 1978). P.339; Ide N.M. Meaning

and Method: Computer-Assisted Analysis of Blake // Literary Computing and Literary Criticism:

Theoretical and Practical essays on Theme and Rhetoric. Ed. R.G.Potter. Philadelphia. University of Pennsylvania. P., 1989. P. 123-141.

34

19

глядит на текст с критически нейтральной позиции. Ситуация меняется при

переходе к моделированию, которая сразу начинается с оценки или гипотезы.

В этом случае применение статистических тестов к частоте или месту

встречаемости данных в тексте приводит к их реорганизации. Получаемые

списки, графики и карты демонстрируют, с какой точностью данные

источника совпадают с моделью, то есть показывают "уровень значимости"

теории.

Из-за того, что компьютерный анализ рассматривает слова как квазиматериальные объекты и фундаментальные частицы текста, компьютерный

критицизм оформился в отдельную школу лингвистики, связанную со

структурализмом и марксизмом. Эти философские доктрины оказывают

влияние на многих специалистов в области машинного анализа при

выработке подхода к тексту37. Необходимость решения одновременно

нескольких философских, исторических и статистических проблем при

компьютерном критицизме привела к тому, что машинный контент-анализ и

сопутствующие ему количественные методы медленно развиваются в

системе гуманитарных дисциплин. Ряд специалистов рассматривают текст

как активный элемент в обществе, для которого он составлялся. В момент

взаимодействия текста с историей, а также другими формами передачи

информации (кино-, фото-, фонодокументы), он не может быть изучен

исключительно как закрытая система частиц. К тому же оценка результатов

анализа зависит не только от результатов исследования. Довольно типичной

является ситуация, когда ряд часто встречаемых слов не имеет

функционального значения, например: "когда", "который", "хотя". В то же

время редко встречаемые слова или феномен отсутствия класса лексики

может быть более значимым и исследователь приходит к выводу косвенно. В

качестве примера может быть приведено отсутствие в дебатах Думы критики

Николая II в результате действия процедурного запрета, который привел к

обострению полемики с министрами.

В подобных непростых ситуациях для обеспечения правильного

анализа резко возрастает необходимость в классической критике источников

и историко-философской рефлексии перед компьютеризированным

изучением текста. Результатом моделирования становится нахождение

устойчивых шаблонов в тексте, "семантических облаков", выявление

которых может быть повторено независимыми исследователями при

соблюдении единых правил. Машинная текстология - наука по-своему

точная. Точность объясняется своеобразием предметной области. Предметом

информатики становится оцифрованный текст. Однако не все в нем доступно

математическим методам исследования. В истории дело обстоит так, что

математической точности возможно достичь не во всех случаях. Точность

37

Lancashire I. Computer-Assisted Critical Analysis: A Case Study of Margaret Atwood's Handmaid's Tale in The Digital Word: Text-Based Computing in the Humanities. Cambridge. London, 1993. P. 293.

20

исследования зависит не только от уровня наших знаний, но также и от того,

в какой мере эту точность допускает сам предмет. Статистические

закономерности истории позволяют говорить о вещах на основании того, что

случается не всегда, а по большей части. Точность науки связана с ее

способностью абстрагироваться от привходящих дополнительных условий.

Она скрыта в объективной простоте объекта. Поэтому самыми неточными

оказываются науки, имеющие дело с тем, что по самой своей природе сложно

и внутренне противоречиво. Математика имеет дело с понятиями. Поэтому

она не может, несмотря на точность ее средств познания, служить методом

адекватного познания исторических явлений, осуществление которых

зависит от случайностей. Из-за этого количественная история изучающая

тексты, есть знание неточное, но оно есть знание неточного, а следовательно,

законное. К тому же исторический текст как источник безгранично

разнообразен. Перенесение принципов и методов одной частной науки в

другую совсем не обязательно требует сохранения всех элементов и создания

иерархии подчинения наук.

Подсчеты частот встречаемости различных классов лексики

(concordances), которые доминировали в квантитативной текстологии 1970-х

и позволяли точно определять значение конкретных слов и фраз в контексте,

по мнению критики, дали слабый эффект. Исследования, построенные лишь

на подсчете частоты встречаемости слов и их комбинаций, имеют тенденцию

к неясным или тривиальным выводам. Поэтому многие работы в области

компьютерного анализа текста оказались сконцентрированы скорее на

методологических вопросах, чем на проблемных результатах. Исходя из этой

критической посылки, при исследовании средневековой немецкой поэзии

использовался альтернативный метод построения тезаурусов, которые

позволяют более точно и результативно интерпретировать текст38. В

заключение следует отметить, что большинство специалистов подчеркивает

необходимость взаимополезной

связи

квантификации

и

теории

исследований. К тому же, в количественных исследованиях текста наметился

очередной рубеж. Период пристального внимание к вопросам методов, с

которым в истории науки устойчиво связывается кризис знания, привел к

идейным попыткам преодолеть застой. Текстологи получили общее описание

ряда подходов, которые пока не могут быть реализованы при возможностях

современной технологии. В основном речь идет о достижениях в области

искусственного интеллекта39.

38

Wittig S. The Computer and the Concept of Text // Computer and the Humanities.

1978. 11. P.211-215; Schmidt K.M. Conceptual Glossaries: A New Tool for Medievalists //

Computer and the Humanities. 1978. 12. P. 19-26.

39 Interpretation in the Humanities: Perspectives from Artificial Intelligence. Ed. R. Ennals and J.-C. Gardin. London, 1990; Text-Based Intelligent Systems: Current Research and

Practice in Information Extraction and Retrieval. Ed. by P.S. Jacobs. Hove and London, 1992;

Системные исследования. Методологические проблемы. Ежегодник. 1984. М., 1984.

С.116-129.

21

Подводя итог истории применения математических методов в

социальных науках, следует констатировать, что к середине 1990-х годов

пакеты текстового анализа по-прежнему не выдерживают конкуренции со

статистическими программами в области связывания воедино всестороннего

диапазона мер и аналитических процедур. Например, ТАСТ'у нельзя задать

вопрос на показ слов, встреченных в тексте максимальное количество раз. К

тому же, строение ТАСТ'а отличается от структуры интегрированных

пакетов, таких как Works, Exell, QuatroPro, SPSS. В них создание файлов и их

дальнейшая обработка соединены в одну оболочку с командной строкой.

ТАСТ, с этой точки зрения, является собранием отдельных программ. Он не

может выдержать конкуренции, например, с SPSS по набору статистических

мер. Фактически, ТАСТ предлагает только одну статистическую функцию

контент-анализа: Z-score (не считая простого подсчета встречаемостей слов в

разных промежутках текста, представленного в графической форме, и ratio).

В то же время SPSS предлагает на выбор исследователя несколько

статистических мер, многомерный статистический анализ, различные формы

графического представления результатов применения функций. Пакеты

текстового анализа предлагают сравнительно небольшие возможности. При

сохраняющемся разрыве между компьютерным изучением хорошо и слабо

структурированных источников исследователи ограничены в методах

анализа полнотекстовых баз данных. Сложность компьютерной обработки

исторических текстов с неизбежностью приводит к относительному

упрощению результатов работ и увеличивает время достижения достоверных

выводов.

Письменные источники – это документы, с которыми связана история

как наука. Документы истории и история документов тесно переплетены.

Надо отметить, что письменные источники, подобные стенограммам Думы,

возникли задолго до статистики, которая на пороге XXI века олицетворяет

прогресс компьютерных методов анализа в социальных науках. Нарративные

документы, отличающиеся большим разнообразием, широким временным

диапазоном и объемом сведений, на волне применения количественных

методов также превращаются в равноправные материалы для исторической

информатики. Автоматический контент-анализ, компьютерная обработка

исторических текстов обретают свое собственное место в мире методов

источниковедения и конкретно-исторического анализа.

22