раздел 2.1

advertisement

Глава 2

СТАТИСТИЧЕСКИЕ МЕТОДЫ

ПОСЛЕДОВАТЕЛЬНОЙ ОБРАБОТКИ ИНФОРМАЦИИ

2.1. РЕКУРРЕНТНЫЕ СХОДЯЩИЕСЯ АЛГОРИТМЫ

ПРИ ПОЛНОЙ АПРИОРНОЙ ИНФОРМАЦИИ

О ПОМЕХЕ

2.1.1. Метод стохастической аппроксимации

Метод стохастической аппроксимации был предложен в 1951 г.

Робинсоном и Монро [1] для решения скалярных стохастических

уравнений вида

(c, (i)) y(i) 0 , i 1,2,...,

(2.1.1)

где с — искомый параметр; (i) — случайная последовательность

с характеристиками

M {(i)} 0 , cov{(i), ( j )} 2 k (i j ) .

Для нахождения корня стохастического уравнения (2.1.1) было

предложено использовать рекуррентную последовательность

cˆi 1 cˆi i 1 ((cˆi ) y (i 1)) .

(2.1.2)

Задача состоит в подборе такого коэффициента i 1 , который

обеспечивал бы состоятельность оценки с в среднеквадратичном, а

именно:

lim M {(cˆi c) 2 } 0 .

i

73

(2.1.3)

Запишем математическое ожидание квадрата ошибки оценки на

(i + 1)-м шаге через математическое ожидание квадрата ошибки

оценки на i-м шаге:

M {(cˆi 1 c) 2 } M {[cˆi i 1 ((cˆi ) y (i 1)) c] 2 }

M {(cˆi c) 2 } M { i21 ((cˆi ) y (i 1)) 2 }

2M { i 1 (cˆi c)((cˆi ) y (i 1))} .

(2.1.4)

Введем обозначения:

i 1 M {(cˆi 1 c) 2 } ;

(2.1.5а)

i M {(cˆi c) 2 } ;

ei M {[ (cˆi ) y (i 1)]2 } ;

(2.1.5б)

d i M {(cˆi c)((cˆi ) y (i 1))} .

(2.1.5в)

Используя эти обозначения, запишем (2.1.4) в виде:

i 1 i i21ei 2 i 1d i .

(2.1.6)

Так как i , i 1 , e i больше нуля, то для того, чтобы ошибка

оценки на каждом шаге в принципе могла уменьшаться, необходимо выполнение условия:

i 1d i 0 .

(2.1.7)

В противном случае, оценка будет расходиться.

Условие (2.1.7) будет выполняться, если d i и i 1 имеют одинаковые знаки, т.е.:

i 1 0 при d i 0;

i 1 0 при d i 0.

74

Анализируя выражение (2.1.5в), можно заключить, что d i 0

при монотонно возрастающих функциях (c~ ) и d i 0 при монотонно убывающих (c~ ) .

Таким образом, учитывая вышесказанное, функция (c~ ) должна быть монотонной, по крайней мере на отрезке [cˆi , c] , в противном случае может наблюдаться расходимость метода.

Выражение (2.1.6) можно представить в виде сумм:

i 1

i 1

k 1

k 1

i 1 0 2k ek 1 2 k d k 1 .

Перепишем последнее выражение в ином виде:

i 1

1

i 1

k 1

k 1

k d k 1 2 0 i1 2k ek 1 .

Так как i 1 0 , то справедливо неравенство:

i 1

i 1

1

d

k k 1 2 0 2k ek 1 .

k 1

k 1

Возьмем предел по i от правой и левой частей неравенства:

i 1

1

i 1

k 1

k 1

k d k 1 2 0 ilim

2k ek 1 .

i

lim

(2.1.8)

Наложим на последовательность k условие

2k .

(2.1.7)

k 1

Тогда, при допущении, что ek 1 — конечна, по признаку Абеля

[6] сумма ряда 2k ek 1 — ограничена, т.е.

i 1

lim

2k ek 1 .

i k 1

75

Следовательно, справедливо неравенство

i 1

k d k 1 ,

i

lim

(2.1.10)

k 1

т.е. ряд k d k 1 сходится.

Если теперь на k наложим еще одно условие, а именно:

k ,

(2.1.11)

k 1

то, на основании признака Дирихле [6], необходимым и достаточным условием сходимости ряда (2.1.10) будет условие

lim d k 0 .

k

Таким образом, если k будет удовлетворять трем условиям:

1) k 0 при монотонно возрастающей (c~ )

~

или k 0 при монотонно убывающей (c ) ;

2)

k 1

3)

2k

(2.1.12)

;

k ,

k 1

то

lim d k 0 .

k

(2.1.13)

Покажем, что выражение (2.1.13) эквивалентно условию состоятельности в среднеквадратичном. Для этого подставим вместо d k

его выражение (2.1.5в). Тогда

lim M {((cˆk ) y(k 1))(cˆk c)} 0 .

k

76

(2.1.14)

Разложим (cˆ k ) в ряд Тейлора относительно истинного значения параметра, пренебрегая членами высшего порядка малости:

(c~ )

(cˆ k ) (c)

(cˆ k c) .

c~ ~

c c

Подставив последнее выражение в (2.1.14), получим:

d(c~)

ˆ

ˆ

lim M (c)

(

c

c

)

y

(

k

1

)

[

c

c

]

0.

k

k

~

dc c~ c

k

С точностью до случайного возмущения (i) можно считать,

что (c) y(k 1) , тогда

d (c~ )

lim M ~

(cˆ k c) 2 0 .

k

dc c~ c

(2.1.15)

(c~)

0 , и, следовательно, соотc~

ношение (2.1.15) эквивалентно выражению

Для монотонных функций

lim M {(cˆk c) 2 } 0 .

k

(2.1.16)

Последнее соотношение совпадает с условием состоятельности

оценки в среднеквадратичном. Таким образом, условие (2.1.13) эквивалентно состоятельности в среднеквадратичном с точностью до

введенных упрощений (отбросили члены высшего порядка малости

при разложении в ряд Тейлора и ввели допущение о монотонности

(c~ ) ).

Подводя итог вышесказанному, можно заключить, что оценка,

вычисляемая с помощью рекуррентной последовательности

cˆi 1 cˆi i 1 ((cˆi ) y (i 1))

(2.1.17)

будет состоятельной, если на коэффициент i наложены три условия:

77

1) i 0 при монотонно возрастающей (cˆ) ,

i 0 при монотонно убывающей (cˆ) ;

2)

2k ;

k 1

3)

k .

k 1

(2.1.18)

Очевидно, можно подобрать бесконечное количество последовательностей i , удовлетворяющих условиям (2.1.18). Возможным

видом такой последовательности является ряд

i

b

,

i

(2.1.19)

где b — любое положительное число.

Рассмотренная рекуррентная процедура (2.1.17) позволяет найти

состоятельную оценку скалярного параметра с. Для состоятельной

оценки векторного параметра c была впоследствии предложена

модификация метода стохастической аппроксимации, которая легла в основу рекуррентных методов идентификации параметров

объектов.

2.1.2. Обобщение метода стохастической аппроксимации

для решения задач идентификации

Рассмотрим, в общем случае, нелинейный объект, описание которого представлено в форме «вход-выход»:

y(i) (u (i), c ) (i) ,

(2.1.20)

M {(i)} 0 , cov{(i), ( j )} 2 k (i j ) ,

соответствующее уравнение модели имеет вид

~

~

y (i) (u (i), c ) .

78

(2.1.21)

~

Рассмотрим некоторую четную функцию F ((u (i), c )

(i) y(i)) — аналог функции потерь, которая достигает мини~

мума при c c .

Тогда c является корнем стохастического векторного уравнения:

~

F ((u (i), c ) (i) y(i))

(2.1.22)

0.

~

~

c

c c

Принципиально векторное уравнение (2.1.22) ничем не отличается от стохастического скалярного уравнения (2.1.1). Причем, по

крайней мере для линейных систем, уравнение (2.1.22) — монотонно возрастающее.

По аналогии с решением скалярных уравнений, составим рекуррентную последовательность для решения векторного уравнения

(2.1.22):

~

F ((u (i 1), c ) y (i 1))

. (2.1.23)

сˆi 1 cˆi i 1

~

~ ˆ

c

c ci

~

Так как выражение (u (i 1), c ) y(i 1)) представляет собой

~

невязку (i 1, c ) между выходом модели и объекта, то можно записать:

~

F ((i 1, c )

,

(2.1.24)

cˆi 1 cˆi i 1

~

~ ˆ

c

c ci

где i 1 — матрица коэффициентов усиления, диагональные элементы которой удовлетворяют условиям:

1) j ,i 1 0 , j 1, m ;

2)

i 1

3)

2j ,i 1

, j 1, m ;

j,i1 ,

j 1, m .

i 1

79

(2.1.25)

Одним из возможных видов матричной последовательности

i 1 , удовлетворяющей условию (2.1.24), является матричный ряд

i 1

,

i 1

(2.1.26)

где В — некоторая положительно определенная матрица.

2.1.3. Асимптотическая скорость сходимости

рекуррентных алгоритмов

Рассмотрим след ковариационной матрицы ошибки оценки на

i-м шаге рекуррентного процесса оценивания:

tr var {cˆi c} tr M (cˆi c )(cˆi c ) т .

В предыдущем разделе было показано, что при правильно выбранной матрице i оценка будет состоятельной:

lim tr var {cˆi c } 0 .

i

При этом могут быть различные способы задания матрицы i 1 .

Кроме того, не накладывалось никаких дополнительных условий

~

(кроме условия четности) на функцию потерь F ((i, c )) . Однако

различные способы задания матрицы i 1 и различные функции

~

потерь F ((i, c )) будут давать различные скорости сходимости

оценок к истинным значениям параметра.

В качестве меры скорости сходимости алгоритмов в теории

оценивания принято использовать асимптотическую матрицу ковариаций ошибок оценки (АМКО) [3]:

V lim i var {cˆ c }

i

i

lim iM (cˆi c )(cˆi c ) т

i

80

.

(2.1.27)

Очевидно, чем меньше АМКО, тем быстрее скорость сходимости алгоритма. Так как ĉi функционально зависит от вида функции

потерь F () и от вида матрицы i , то и АМКО является функционалом от F () и i .

В дальнейшем несколько упростим задачу и будем задавать i

в виде

B

(2.1.28)

i ,

i

где В, как указывалось ранее, некоторая положительно определенная матрица. Поставим себе целью найти такую матрицу B * и такую функцию потерь F * () , которые обеспечивают минимум

АМКО. При этом будем считать, что известна плотность распределения помехи f () . Вначале найдем оптимальную матрицу B * ,

такие алгоритмы будем называть оптимальными [3]. Затем найдем

оптимальную функцию потерь F * () — абсолютно оптимальные

алгоритмы.

Найдем уравнение, которому удовлетворяет АМКО. Приводимый далее вывод этого уравнения носит эвристический характер и

не претендует на строгость. Запишем рекуррентный алгоритм

(2.1.24), используя в качестве матрицы i формулу (2.1.28):

~

B F ((i, c ))

cˆi cˆi 1

.

~

~

i

c

c cˆi 1

(2.1.29)

Запишем это выражение относительно ошибки i cˆi c :

i i 1

~

B F ((i, c ))

.

~

~

i

c

c cˆi 1

81

(2.1.30)

~

F ((i, c ))

Разложим

в ряд Тейлора относительно истин~

~

c

c cˆi 1

ного значения параметра:

~

F ((i, c ))

~

~

c

c cˆ

i 1

~

F ((i, cˆ ))

F ((i, c ))

ˆ

~

~

~т

~ (ci 1 c ) .

~

c

c

c

c c

c c

Подставляя последнее выражение в формулу для ошибки

(2.1.30), получим:

i i 1

~

2 F ((i, c ))

B F ((i, cˆ ))

~

i 1 .

~ ~т

i

~

c

~

c

c

c c

c c

Перепишем последнее выражение в виде:

~

B 2 F ((i, c~))

B F ((i, c ))

.

i I

i 1

~

~ ~т

~

i

i

c

~

c

c

c

c

c c

Домножим обе части этого уравнения на

~

F ((i, c ))

ния: i i ei ;

i ;

~

~

c

c c

i и введем обозначе-

B 2 F ((i, c~))

~

ei 1 i B i .

ei I

~

~

т

i

i 1

~

i

c c

c c

1

,тогда,

2i

i 1

пренебрегая членами высшего порядка малости, можно записать:

При достаточно больших i выражение

i

1

~

1 B 2 F ((i, c ))

e B .

ei I I

i 1

i

~

~

2i i

~

i

c c т

c c

82

(2.1.31)

Обращаясь к формуле (2.1.27) для АМКО, нетрудно заметить,

что

(2.1.32)

(2.1.33)

i

где

V lim Vi lim M ei , eiт ,

i

Vi M ei , eiт

.

Подставляя (2.1.31) в формулу (2.1.33) и производя кропотливые, но несложные преобразования, получим рекуррентную формулу для нахождения Vi [3]:

2 F ((i, c~ ))

1

Vi Vi 1 BM

c~c~ т

i

~

c c

~

2 F ((i, c ))

Vi 1 M

~ ~т

~

c c

c c

1

I V

2 i 1

т 1

т

B I BR i B ,(2.1.34)

2

т

где

~

~

т

F ((i, c )) F ((i, c ))

.

Ri M

~

~

c

c

c~ c

Рассмотрим более подробно матрицу R i . Так как функция потерь является сложной функцией, то, применяя правила дифференцирования сложных функций, можно записать:

~

~

2

dF () (i, c ) (i, c )

.

R i M

~

~

т

d

c

c

~

c c

83

~

~

~

Учитывая, что (i, c ) (u (i), c ) y(i) , а y (i ) не зависит от c ,

запишем:

~

2

т ~

dF () (i, c ) (i, c )

. (2.1.35)

R i M

~

~

d c

c

~

c c

Для систем с аддитивной помехой случайные величины, входящие в (2.1.35), статистически независимы. Поэтому выражение

(2.1.35) можно представить в виде:

~

2

т ~

dF ()

(i, c ) (i, c )

. (2.1.36)

R i M

M

~

~

d ~

c

c

c~ c

c c

Очевидно, второй сомножитель в (2.1.36) представляет собой

нормированную информационную матрицу. Таким образом,

2

dF ()

2

R i M

A (c , ) .

d c~ c

(2.1.37)

Вернемся к уравнению (2.1.34). Оно представляет собой рекуррентный алгоритм решения матричного стохастического уравнения:

~

2

1

BM F ((i, c ))

I Vi 1

~

~

т

2

~

c

c

c c

~

2

1

F ((i, c ))

т

Vi 1 M

B I BR i B т . (2.1.38)

~

~

т

c c

2

~

c c

По правилу дифференцирования сложных функций, имеем:

~

2 F ((i, c ))

d 2 F ( )

~ ~

~

c c т

d 2 c~ c

c c

~

~

((i, c )) ((i, c ))

~

~

~

c

c т

c c

84

2 (i, c~)

dF ()

.

d c~ c c~c~ т ~

c c

(2.1.39)

Будем считать, что модель объекта составлена таким образом,

что [3]

~

(2.1.40)

(i) c~ c y(i) (i, c ) ~ (i) .

c c

Для линейных объектов при использовании оптимальной

настраиваемой модели справедливость соотношения (2.1.40) была

доказана в разд.1.2 (часть I). Для нелинейных объектов с простой

аддитивной помехой это соотношение очевидно. В дальнейшем

будем считать, что соотношение (2.1.40) выполняется всегда. Таким образом, можно записать:

~

~

~

(i, c ) (i, c )

2 F ((i, c ))

d 2 F ( )

~ ~

~ т ~

c~

2

~

c c т

d

c

c c

c c

(i )

~

dF ()

2 (i, c )

.

d (i ) c~c~ т ~

c c

Применим операцию математического ожидания к правой и левой частям последнего выражения. Учитывая статистическую независимость случайных функций, входящих в правую часть, запишем:

2 F ((i, c~))

2

M

M F ()A c ,

~ ~т

~

c c

c c

~

2

(i, c )

M F () M ~ ~

.

c c т ~

c c

dF ()

Покажем, что M

0.

d (i )

85

По определению:

M F ()

F () f ()d .

Так как F () — четная функция, то F () — нечетная; f ()

при M {} 0 — четная функция, и, следовательно, F () f () —

нечетная.

Интеграл от нечетных функций на одинаковых, но противоположных по знаку пределах равен 0, т.е.

M {F ()} 0 .

(2.1.41)

Таким образом, учитывая (2.1.41), имеем:

2 F ((i, c~))

2

M

M F ()A c , .

~ ~т

~

c c

c c

(2.1.42)

Подставляя формулу для R i (2.1.37) и выражение (2.1.42) в

(2.1.38), получим:

1

2

2

т 1

BM F ()A c , 2 I V V M F ()A c , B 2 I

BM F 2 () A c , 2 B т .

(2.1.43)

Полученное матричное уравнение представляет собой сложную

функциональную зависимость АМКО V от матрицы В и функции

потерь F () . В общем случае невозможно в явном виде разрешить

это уравнение относительно АМКО.

2.1.4. Оптимальные рекуррентные алгоритмы идентификации

Как уже отмечалось в предыдущем разделе, оптимальными рекуррентными алгоритмами будем называть алгоритмы, которые

используют матрицу B * — оптимальную в смысле минимума

АМКО при заданной функции потерь F () .

86

Представим матрицу В в виде:

B B * B ,

(2.1.44)

где B * — искомая оптимальная матрица, B — вариация матрицы В, — параметр.

Обозначим:

() V(B * B) ,

G M F ()A c , 2 .

(2.1.45)

(2.1.46)

Тогда уравнение (2.1.43) для АМКО запишется в виде

(B * B) M F 2 ()Ac , 2 B *т B т .

1

1

т

т

т

(B * B)G 2 I() ()G B * B 2 I

(2.1.47)

Условие минимума АМКО можно представить в виде

d ( )

0 , B .

d 0

Дифференцируя обе части уравнения (2.1.47) по и полагая

= 0, получим:

(0)G т B * M F 2 ()A c , 2 B т 0 .

B G(0) M F 2 () A c , 2 B * т

Нетрудно видеть, что последнее условие будет выполняться для

любых В только при обращении в нуль выражений, стоящих в

квадратных скобках, т.е.

G(0) M F 2 () A c , 2 B *т 0 .

87

Подставляя выражение (2.1.46) для G и учитывая, что

(0) V * , получим:

M F ()A c , 2 V * M F 2 () A c , 2 B *т 0 .

Разрешим полученное уравнение относительно V * , тогда будем иметь:

V*

M F 2 ()

B *т .

M {F ()}

(2.1.48)

Для определения оптимальной матрицы В* подставим полученное выражение для V* в уравнение АМКО (2.1.43); тогда после несложных преобразований находим:

B*

1

A 1 c , 2 ,

M {F ()}

(2.1.49)

или, раскрывая операцию математического ожидания, будем

иметь:

B*

1

A 1 c , 2 .

F () f ()d

Используя формулу интегрирования по частям, можно получить

F () f ()d F () f ()d .

(2.1.50)

Тогда последнее выражение перепишем в виде

1

B*

A 1 c , 2 .

F () f ()d

88

(2.1.51)

Для нахождения оптимальной АМКО подставим (2.1.49) в

(2.1.48) и получим:

V(B*)

A 1 c , 2

M F 2 ()

(2.1.52)

[ M {F ()}] 2

или

F

2

() f ()d

V(B*)

A 1 c , 2 .

2

F () f ()d

Используя замену (2.1.50), запишем эквивалентную формулу

для АМКО:

F

2

() f () d

V(B*)

A 1 c , 2 .

2

F () f ()d

Как видно, полученная АМКО является функционалом от функции потерь F () и плотности распределения f () . В дальнейшем

АМКО, оптимальную относительно матрицы В, будем обозначать

V( F , f ) , т.е.

F

V( F , f )

2

() f ()d

F () f ()d

89

2

A 1 c , 2 d .

(2.1.53)

Подставляя матрицу В* в рекуррентный алгоритм (2.1.29), получим:

~

1

1

2 F ((i, c ))

ˆc cˆ 1

.

A c ,

~

i

i 1

~ ˆ

i

c

c

c

i 1

F () f ()d

Очевидно, полученный алгоритм невозможно реализовать, так

как в формулу для нормированной информационной матрицы входит оцениваемый параметр c . Эту трудность можно обойти, использовав вместо c оценку параметра на (i – 1)-м шаге. Таким образом, реализуемый рекуррентный алгоритм будет иметь вид:

1

cˆi cˆi 1

i

1

F () f ()d

dF ()

A 1 cˆi 1 , 2

d y (i ) (i ,cˆ )

i 1

~

(i, c )

.

~

~

c

c cˆi 1

(2.1.54)

Полученная рекуррентная формула является наиболее общей и

может быть использована для идентификации параметров нелинейного объекта при произвольной функции потерь F () .

Существенным недостатком данного алгоритма является необ-

ходимость рассчитывать, а затем обращать матрицу A c , 2 .

Предлагаемая ниже процедура [3] позволяет обойти эти трудности.

Заменим матрицу A c , 2 ее выборочной или эмпирической оценкой:

A c , 2

~

~

1 i ( j , c ) т ( j , c )

~ 2

A c , ~

.

~

~

~

c cˆi 1

i j 1 c

c

c cˆ

j

90

Тогда матрица коэффициентов усиления (i) примет вид:

i

~ т

~

1

1 ( j , c ) ( j , c )

(i )

~

~

~

i j 1 c

c

c cˆ j

i F () f ()d

~

~

i

( j , c ) т ( j , c )

F () f ()d

~

~

c

c

~

~

j

1

c c j

1

1

.

Воспользуемся леммой об обращении квадратных матриц. Если

квадратная матрица имеет вид

i

T(i ) t ( j )t т ( j ) U

j 1

1

,

где — скаляр, t ( j ) — вектор, U — постоянная симметричная

матрица той же размерности, то справедливо следующее рекуррентное соотношение:

T(i ) T(i 1)

T(i 1)t (i )t т (i )T(i 1)

1 t т (i )T(i 1)t (i )

T ( 0 ) U 1 .

Полагая T(i) (i) ; T(i 1) (i 1) ;

F () f ()d ; , U 0 ,

получим для коэффициента усиления:

(i) (i 1)

91

,

(i 1)

~

~

(i, c )

т (i, c )

(i 1)

~

~

c c~ cˆ

c

~ ˆ

c ci 1

i 1

F () f () d

1

.(2.1.55)

~

~

(i, c )

(i, c )

(

i

1

)

~

~

c

c c~ cˆ

~

c cˆi 1

i 1

т

В качестве начального приближения принимают матрицу

(0) I ,

(2.1.56)

где — большое число.

Таким образом, оптимальный рекуррентный алгоритм будет состоять из двух вычисляемых формул

~

(i, c )

cˆi cˆi 1 (i ) F ((i, cˆ (i 1)))

,

~

c c~ cˆ

i 1

(2.1.57)

где (i) вычисляется на каждом шаге рекуррентного процесса по

формуле (2.1.53) при начальных условиях (2.1.56). Начальное приближение ĉ0 может быть задано любым вектором соответствующей размерности.

В заключение данного раздела запишем рекуррентный оптимальный алгоритм для линейного динамического объекта:

n

y(i) a j y(i j )

j 1

n

n

k 0

l 0

bk u(i k ) d l (i l ) .

Как известно, оптимальная настраиваемая модель, соответствующая данному объекту, имеет вид:

n

~

y (i) a~ j y(i j )

j 1

92

n

~

bk u(i k )

k 0

~

dl ~

~ ( y (i l ) y (i l ))

l 1 d 0

n

или, используя введенные в части I обозначения (1.42),

~

~

y (i ) z (i ) т c .

Тогда

~

(i, c )

~ z (i) .

c

(2.1.58)

Подставляя (2.1.58) в рекуррентные соотношения (2.1.55),

(2.1.57), получим:

cˆ (i) cˆ (i 1) (i) F ((i, cˆ (i 1))) z (i) ;

(2.1.59а)

(i 1) z (i) z т (i)(i 1)

(i) (i 1)

,

1

F () f ()d z т (i)(i 1) z (i)

~

(i, c (i 1)) y (i ) z т (i )cˆ (i 1) ,

(2.1.59б)

где ĉ (0) — любой вектор, (0) I , — большое число.

2.1.5. Оптимальная функция потерь

В предыдущем разделе получили формулу для АМКО (2.1.53),

оптимальной по матрице В:

F

2

() f ()d

V * ( F , f )

A 1 c , 2 .

2

F () f ()d

93

Будем считать, что плотность распределения ошибок измерений

известна. Тогда поставим задачу подобрать такую функцию потерь

F * () , которая обеспечит минимальное значение АМКО. Для решения этой задачи рассмотрим изменение АМКО при варьировании оптимальной функции потерь F * () :

() V( F * () F (), f ) ,

где — параметр, F — произвольная вариация функции потерь.

Условие экстремума АМКО имеет вид:

() 0 0 .

Рассмотрим, что представляет собой матрица ():

() V( F * F , f )

2

2

2

f () F * ()d 2 f () F * ()F ()d f ()F ()d

2

f () F * ()d 2 f () F * ()d f ()F ()d

2 f ()F ()d

2

1

A 1 c , 2 .

Тогда

2

() 0 2 f () F * ()F ()d f () F * ()d

2 f () F * ()d f ()F () f () F * 2 ()d

94

4

f () F * ()d

1

A 1 c , 2 0 .

Откуда следует, что

f () F * ()F ()d

f () F * ()d

f ()F ()d

f () F *

2

()d .

Преобразуя последнее выражение, получаем:

f ()F ()d

f () F * ()F () d

f () F *

2

f

() d

0.

() F0* () d

Так как F () может быть любой функцией, то

f () F * ()

f () F *

2

f ()

,

(2.1.60)

f () F * ()d

()d

или, после умножения обеих частей (2.1.60) на F * () :

f () F * 2 ()

f () F *

2

f () F * ()

.

(2.1.61)

f () F * ()d

()d

Нетрудно заметить, что (2.1.61) представляет собой равенство

нормированных функций. Это равенство справедливо только в том

95

случае, если сами функции пропорциональны. Таким образом, получаем:

f () F * 2 () k1 f () F * () ,

где k1 — коэффициент пропорциональности. Отсюда следует, что

F * () k1

т.е.

F * () k1

f ()

,

f ()

f ()

k1{ln f ()} .

f ()

И, следовательно, оптимальная функция потерь определяется

соотношением:

F * () k1 ln f () k 2 .

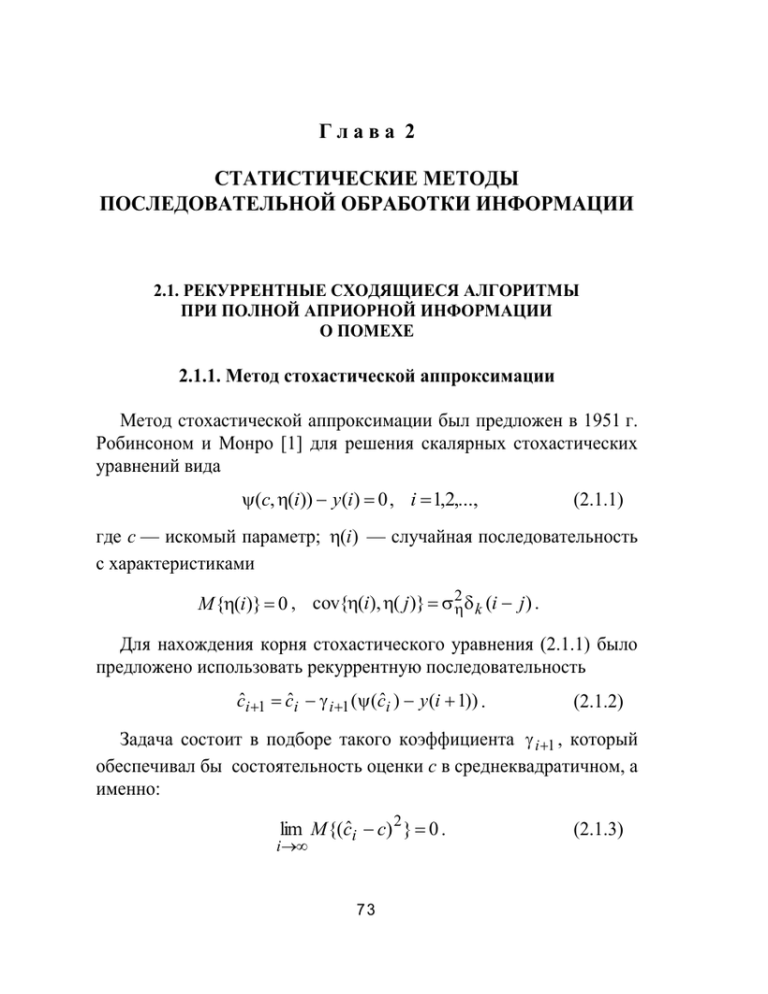

В последнем выражении неопределенными оказываются коэффициенты k1 и k 2 . Для их определения рассмотрим графики

(рис.2.1.1) плотности распределения и логарифма плотности распределения шума .

а

б

Рис.2.1.1. Типичный вид плотности распределения (а)

и логарифма плотности распределения шума (б)

96

Как правило, это уже не раз использовалось, плотность распределения f () является четной функцией, а логарифм плотности

распределения — четная убывающая функция, имеющая максимальное значение при = 0. Таким образом, для того, чтобы

f ()

имела смысл функции потерь, т.е. имела миниF * () k1

f ()

мум при = 0, необходимо условие k1 0 (рис.2.1.2).

Рис.2.1.2. График зависимости

функции потерь от невязок

при k1 0 и k 2 0

Что же касается параметра k 2 , то он определяет минимальное

значение F * (0) . При k 2 k1 ln f (0) всегда выполняется неравенство F * () 0 .

Таким образом, оптимальная функция потерь не единственна, а

зависит от параметров k1 и k 2 . Этот факт является следствием того, что АМКО зависит не от F () , а от F () .

Для задач идентификации конкретные значения этих параметров несущественны. Удобно принять k1 1 , а k 2 0 . Таким образом, оптимальная функция потерь равна логарифму плотности

распределения помех с обратным знаком:

F * () ln f () .

(2.1.62)

Сравним полученный результат с оптимизируемым критерием в

методе максимума правдоподобия при аддитивной помехе. Приведем примеры оптимальных функций потерь и их производных.

97

1. Нормальная (гауссова) плотность распределения помех:

f ()

1

2

exp 2 / 2 2 N (0, ) .

Функция потерь, согласно (2.1.18), будет иметь вид:

F * () 2 / 2 2 ln 2 , F * () / 2 . (2.1.63)

Поскольку положение экстремума не зависит от постоянных

слагаемых и множителей, то можно записать следующий оптимизируемый критерий:

N

~

J (c ) ( y (i) y (i )) 2

i 1

~

~

~

или в векторной форме: J (c ) ( y y ) т ( y y ) .

Таким образом, при нормальном законе распределения использование оптимальной функции потерь эквивалентно применению

метода наименьших квадратов.

2. Экспоненциальная (лапласова) плотность распределения помех

1

f ()

exp[ / ] L(0, ) .

2

Для функции потерь получаем:

F * () / ln 2 , F * () sign / .

(2.1.64)

В данном случае получили модульную функцию потерь. Использование метода наименьших квадратов дает худшие асимптотические свойства оценок.

3. Дробная (Коши) плотность распределения помех:

f ()

1

1

C (0, ) .

1 ( / ) 2

В этом случае имеем:

F * () ln( 2 2 ) ln / , F * () 2 /( 2 2 ) .(2.1.65)

Эти и некоторые другие виды функций потерь и их производные приведены в табл.2.1.1 [3].

98

Таблица 2.1.1

Оптимальные функции потерь и их производные

Плотность

распределения f()

N (0, 2 )

1

2 2

e

1

L(0, s)

e

2s

c(0, s)

Функция потерь F()

Производная функции

потерь F()

2 / 22 ln 2 2

/ 2

2 / 2 2

s

1

1

s 2

1

s

/ s ln 2 s

ln( s 2 2 ) ln

s

99

1 / s sign

2 /( s 2 2 )

2.1.6. АМКО при оптимальной функции потерь

Найдем, чему равна асимптотическая матрица ковариаций при

оптимально выбранной функции потерь, т.е.

F * () ln f () .

(2.1.66)

Подставив выражение (2.1.66) для оптимальной функции потерь

в формулу для АМКО (2.1.53), получим:

f () F *

2

()d

V( F *, f )

A 1 c , 2

2

f () F * ()d

f ()[( ln f ())]

2

d

A 1 c , 2

2

f ()( ln f ()) d

f ()[ f () / f ()]

2

d

A 1 c , 2 .

f ()[ f () / f ()]d

Приводя подобные члены, окончательно получаем:

V( F *, f ) V( f )

A 1 c , 2

[ f ()]

2

.

(2.1.67)

/ f ()d

Выражение, стоящее в знаменателе (2.1.67), называется фишеровской информацией:

100

[ f ()]

I F ( f ())

2

/ f ()d .

(2.1.68)

Очевидно, справедливо следующее неравенство:

V( F , f ) V( F *, f ) ,

(2.1.69а)

где F () ln f () , F * () ln f () . Или, раскрывая V( F , f ) и

V( F *, f ) , получим:

F

2

() f ()d

F () f ()d

(2.1.69б)

2

A 1 c , 2

1

f

2

A 1 c , 2 .

() / f ()d

Важно отметить, что, если нормированная асимптотическая

матрица не зависит от c и 2 (регрессионный объект), то неравенство (2.1.69б) можно упростить:

F

2

() f ()d

F () f ()d

1

f 2 ()

d

f ()

.

(2.1.70)

Получившееся значение АМКО совпадает с нижним пределом,

которое устанавливается неравенством Крамера — Рао:

V( F0 , f )

A 1 c , 2

[ f ()]

2

/ f ()d

lim N M c ln p( y / c )( c ln p( y / c ))1 ,

N

101

где p( y / c ) p( y(1), y(2),..., y( N ) / c ) — совместная плотность распределения выходов объекта, имеющего вектор параметров c .

Таким образом, знание плотности распределения помехи f ()

позволяет определить оптимальную функцию потерь. При этом

оценка cˆ (i ) обладает максимальной асимптотической скоростью

сходимости.

2.1.7. Абсолютно оптимальные рекуррентные алгоритмы

Запишем абсолютно оптимальный рекуррентный алгоритм для

нелинейного объекта

~

y(i) (i, c ) (i) .

Для этого подставим в рекуррентные соотношения (2.1.55),

(2.1.57) оптимальную функцию потерь (2.1.62), а именно:

F * () ln f () .

(2.1.71)

Тогда получим:

~

1

(i, c )

сˆ (i ) cˆ (i 1) (i )

f ()

,(2.1.72а)

~

f ()

(i ,c~ (i 1)) c c~ c~ (i 1)

~

~

(i, c )

т (i, c )

(i 1)

~

~

c с~ cˆ (i 1)

c

~ ˆ

c c (i 1)

,(2.1.72б)

(i ) (i 1)

~

т

(

i

,

c

)

( I F ) 1 ~

(i 1)

~

c ~ ˆ

c c~ cˆ (i 1)

(i 1)

c c (i 1)

сˆ (0) сˆ0 , (0) I , 1 , ĉ0 — любой вектор соответствующей

размерности, I F — фишеровская информация, рассчитываемая по

формуле:

102

IF

( f ()) 2

d .

f ()

(2.1.73)

В табл.2.1.2 приведены значения фишеровской информации для

наиболее распространенных распределений.

Таблица 2.1.2

Фишеровская информация

№

Распределение

1

Нормальное

2

Лапласа

3

Коши

Фишеровская

информация

s

2s

2 1

2 1

2 1

В случае линейного РАР объекта

~

(i, c )

определяется форму~

c

~

(i, c )

~ z (i) .

c

Тогда, подставляя последнее выражение в рекуррентные соотношения (2.1.72а,б), получим:

лой (2.1.58), а именно:

1

сˆ (i ) cˆ (i 1) (i )

f ()

z (i ) , (2.1.74а)

f ()

(i,c~ (i 1))

(i ) (i 1)

(i 1) z (i ) z т (i )(i 1)

( I F ) 1 z т (i )(i 1) z (i )

,

(2.1.74б)

сˆ (0) с0 , (0) I , 1 .

В заключение настоящего раздела запишем оптимальные рекуррентные алгоритмы для различных плотностей распределения,

приведенных в табл.2.1.2.

103

1. Нормальная плотность распределения помехи:

f ()

1

exp

2 .

2 2

1/ 2

22

1

Введем обозначения: H (i) (i) / 2 .

Тогда в новых обозначениях рекуррентный алгоритм для нормального распределения запишем в виде

(2.1.75а)

,

(2.1.75б)

cˆ (i ) cˆ (i 1) H (i ) z (i ) y (i ) z т (i )cˆ (i 1) ,

cˆ (0) c0 ;

H (i ) H (i 1)

H (i 1) z (i ) z т (i ) H (i 1)

1 z т (i ) H (i 1) z (i )

H (i) I , 1 .

Сравнивая (2.1.75а, б) с рекуррентными соотношениями (2.64),

(2.67), (2.68), можно сделать вывод, что рекуррентная форма метода наименьших квадратов полностью совпадает с абсолютно оптимальным алгоритмом для нормального распределения помехи.

Алгоритм (2.1.75а) называется линейным алгоритмом. Как видим, линейный оптимальный алгоритм не зависит от дисперсии

помехи.

2. Лапласова плотность распределения помехи.

Принимая во внимание значение плотности распределения

Лапласа и соответствующую фишеровскую информацию (см.

табл.2.1.2), оптимальный рекуррентный алгоритм (2.1.74а, б) запишем в виде:

cˆ (i) cˆ (i 1) H (i) z (i)sign y(i) z т (i)cˆ (i 1) , (2.1.76а)

cˆ (0) c0 ;

104

H (i) H (i 1)

H (i 1) z (i ) z т (i ) H (i 1)

H (0) I , 1 , H (i 1)

(2.1.76б)

,

s 2 z т (i) H (i 1) z (i)

(i 1)

.

s

Данный алгоритм называется релейным.

3. Плотность распределения помехи Коши.

В этом случае, подставляя в формулы (2.1.74а, б) плотность

распределения и фишеровскую информацию (см. табл.2.1.2), соответствующие распределению Коши, получим нелинейный оптимальный алгоритм:

y (i ) z т (i )cˆ (i 1)

с(i ) c(i 1) 4 H (i ) z (i )

s 2

т

y (i ) z (i )cˆ (i 1)

2

, (2.1.77а)

cˆ (0) c0 ;

H(i) H(i 1)

H(i 1) z (i) z т (i)H(i 1)

s 2 z т (i)H(i 1) z (i )

,

(2.1.77б)

G(i)

.

2

Приведенные абсолютно оптимальные алгоритмы идентификации РАР — объектов с простой помехой, как было показано в

предыдущем разделе, обладают предельно возможной скоростью

сходимости, определяемой нижней границей неравенства Крамера — Рао. Их АМКО равна:

H(0) I , 1, H(i)

V( F , f )

1

A 1 c , 2 ,

IF ( f )

105

(2.1.78)

где

IF ( f )

f 2 ()

d —

f ()

фишеровская

информация,

A c , 2 M z , z т — нормированная информационная матрица

системы.

2.1.8. Пример использования абсолютно оптимальных

рекуррентных алгоритмов для идентификации параметров

линейного регрессионного объекта

Для оценки эффективности использования абсолютно оптимальных алгоритмов рассмотрим задачу идентификации параметров линейного регрессионного объекта вида

(2.1.79)

y(i) 0,6 1,1u(i) 2,1u(i) 4,2u(i) (i) .

Шум измерений (i) имеет распределение Коши:

f ()

1

1

.

s (1 (2 / s ) 2 )

Для оценки эффективности абсолютно оптимальных рекуррентных алгоритмов проводилось сравнение нелинейного (абсолютно

оптимального алгоритма) и линейного алгоритмов для идентификации линейного регрессионного объекта вида (2.1.79) при различных значениях параметра распределения Коши — s.

На рис.2.1.3, 2.1.4 приведены графики интегральной скользящей

ошибки оценки, вычисляемой по формуле:

10

n

a~k (i j ) a k

ск (i )

j 0 k 0

10

; i 10, 11,... .

в зависимости от номера измерений i.

Из рисунков видно, что использование абсолютно оптимального

алгоритма обеспечивает существенно меньшую ошибку оценки

даже при больших значениях параметра распределения — s.

106

Рис.2.1.3. График зависимости сглаженной ошибки оценки от номера измерений

при использовании линейного (а) и абсолютно оптимального (б) алгоритмов при

s=2

Рис.2.1.4. График зависимости сглаженной ошибки оценки от номера измерений

при использовании линейного (а) и абсолютно оптимального (б) алгоритмов при

s=7

107