Проверка случайности, независимости, однородности

advertisement

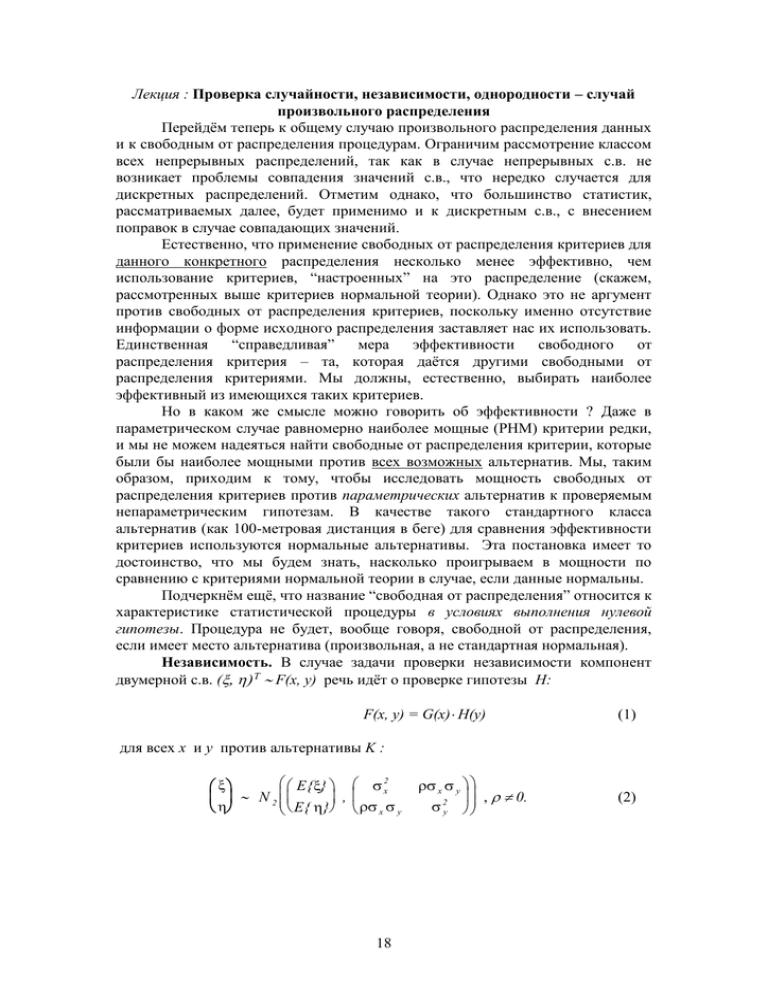

Лекция : Проверка случайности, независимости, однородности – случай

произвольного распределения

Перейдём теперь к общему случаю произвольного распределения данных

и к свободным от распределения процедурам. Ограничим рассмотрение классом

всех непрерывных распределений, так как в случае непрерывных с.в. не

возникает проблемы совпадения значений с.в., что нередко случается для

дискретных распределений. Отметим однако, что большинство статистик,

рассматриваемых далее, будет применимо и к дискретным с.в., с внесением

поправок в случае совпадающих значений.

Естественно, что применение свободных от распределения критериев для

данного конкретного распределения несколько менее эффективно, чем

использование критериев, “настроенных” на это распределение (скажем,

рассмотренных выше критериев нормальной теории). Однако это не аргумент

против свободных от распределения критериев, поскольку именно отсутствие

информации о форме исходного распределения заставляет нас их использовать.

Единственная

“справедливая”

мера

эффективности

свободного

от

распределения критерия – та, которая даётся другими свободными от

распределения критериями. Мы должны, естественно, выбирать наиболее

эффективный из имеющихся таких критериев.

Но в каком же смысле можно говорить об эффективности ? Даже в

параметрическом случае равномерно наиболее мощные (РНМ) критерии редки,

и мы не можем надеяться найти свободные от распределения критерии, которые

были бы наиболее мощными против всех возможных альтернатив. Мы, таким

образом, приходим к тому, чтобы исследовать мощность свободных от

распределения критериев против параметрических альтернатив к проверяемым

непараметрическим гипотезам. В качестве такого стандартного класса

альтернатив (как 100-метровая дистанция в беге) для сравнения эффективности

критериев используются нормальные альтернативы. Эта постановка имеет то

достоинство, что мы будем знать, насколько проигрываем в мощности по

сравнению с критериями нормальной теории в случае, если данные нормальны.

Подчеркнём ещё, что название “свободная от распределения” относится к

характеристике статистической процедуры в условиях выполнения нулевой

гипотезы. Процедура не будет, вообще говоря, свободной от распределения,

если имеет место альтернатива (произвольная, а не стандартная нормальная).

Независимость. В случае задачи проверки независимости компонент

двумерной с.в. ( T F(x, y) речь идёт о проверке гипотезы H:

F(x, y) = G(x) H(y)

(1)

для всех x и y против альтернативы K :

E {} 2x

N 2

,

E { } x y

18

x y

, 0.

2y

(2)

x1 x 2

Для проверки используется выборка объема n пар наблюдений , ...,

y1 y 2

xn

. Тогда рассмотрение функции правдоподобия для альтернативы K

yn

приводит ([3], стр. 634–635) к тому же критерию, основанному на выборочном

коэффициенте корреляции r , что и в нормальном случае :

n

1 n

(

x

x

)(

y

y

)

x y xy

i

i

n i 1 i i

i 1

r n

,

(3)

1/ 2

n

s*x s*y

2

2

( xi x ) ( yi y )

i 1

i 1

где, например,

1 n

( s x* ) 2 ( xi x ) 2

n i 1

– оценка дисперсии 2x . Т.е. H отвергается в пользу K’ с > 0, если r велико;

в пользу K” с < 0, если r << 0, и в пользу K с отсутствием независимости,

если | r | велико. Можно показать [3], что асимптотически при n >> 2 с.в.

1/ 2

n2

St n - 2 (z)

(4)

t r

2

1 r

при H. Однако при малых объёмах выборки 3 < n < 10 вычисление точного

распределения r ( и t ) практически невозможно, потому что оно зависит от

наблюдаемых значений (x, y), а это суть с.в. Хотелось бы придумать новые

величины (X, Y), которые не зависели бы от фактических значений (x, y), но

отражали бы порядковые соотношения между наблюдёнными значениями x и

y, ибо нас интересует зависимость между этими с.в. Так, если x и y

коррелированны положительно и компонента y в выборке упорядочена по

возрастанию (для неё построен вариационный ряд

y (1) y (2) ... y (n) ), то с

вероятностью больше 1/2 большой величине x соответствует большое значение

y , так что малые x и y скапливаются на левом краю, а большие – на правом.

Картина будет обратная, если корреляция x и y отрицательна.

Таким образом, приходим к рассмотрению функций от рангов x и y.

Определим ранг наблюдения y j как его номер в вариационном ряду y(1) y(2)

... y(n) , т.е.

rank{ y(i)} = i .

(5)

Любое монотонное преобразование переменных оставляет ранги неизменными

(или, если преобразование монотонно убывающее, инвертирует ранги). Любое

такое преобразование оставляет инвариантной также гипотезу независимости, а

потому естественно использование функций от рангов. Самая простая и

очевидная процедура – использование непосредственно самих рангов1 .

В своём изложении я буду следовать в основном [3], гл.31 . См. также [2], гл.9 (стр.315–347).

Помимо этих рекомендованных книг интересующиеся могут также посмотреть:

Гаек Я., Шидак З. Теория ранговых критериев. М.: Наука. 1971 (последовательное и полное

изложение теории ранговых критериев, но по уровню изложения это весьма трудная книга ...)

1

19

При проверке независимости важно взаимное расположение рангов

между компонентами x и y. Поэтому без потери общности упорядочим n пар (x,

y) в выборке так, чтобы ранги Y были расположены в естественном порядке 1,

2, ..., n . Если обозначить через Xi ранг x, отвечающий значению Y = i , и

составить ранговый аналог r , получим ранговый коэффициент корреляции

Спирмена

1 n

1

2

n iX i { 2 ( n 1 )}

i 1

,

R

1 2

( n 1)

12

(6)

ибо выборочное среднее для рангов равно

1 n

1 n

1 n( n 1 ) n 1

X Xi Y i

,

n i 1

n i 1

n

2

2

(7’)

а выборочная дисперсия

2

2

1 n

n 1

1 n 2

1 n

n 1

2

i n

DX = ( X i X ) = DY = i

n i 1

2

n i 1

n i 1

2

1 n( n 1 )( 2n 1 ) n( n 1 )( n 1 ) n 2 1

.

(7”)

n

6

4

12

Если гипотеза независимости H верна, то ( [3], стр. 639) E{R} = 0, Var{R} = (n –

1) – 1.

Ранговый коэффициент корреляции – наиболее простая функция рангов

X и Y . Другая часто используемая функция – статистика критерия Кендалла,

Пусть по-прежнему ранги Y расположены в естественном порядке 1, 2, ..., n , а

соответствующие ранги x1 , x2 , ..., xn равны X1 , X2 , ..., Xn . Вычислим меру

беспорядка X-рангов, т.е. число отклонений от порядка 1, 2, ..., n как число

инверсий между ними.

1.2 2.4 0 .7

Пример 1. Пусть при n = 4 была получена выборка , , ,

2.2 1.5 3.8

2.4 1.2 0 .7 3.9

3.9

. Упорядочим её по второй компоненте: , , , .

.

.

1.5 2.2 3.8 47

47

Заменяя теперь значения их рангами, будем иметь:

3 2

1 4

Хеттманспергер Т.П. Статистические выводы, основанные на рангах. М.: 1987 (систематическое

изложение, основанное на теории меры и интеграла Лебега. Однако книга много проще, чем

Гаек и Шидак ...)

Холлендер М., Вулф Д.А. Непараметрические методы статистики. М.: 1983 (Это довольно

подробный справочник методов с примерами, деталями реализации, ссылками. Для

практических целей это наиболее полезная книга, но нужно иметь в виду, что, в отличие от двух

названных выше книг, изложение имеет форму рецептов , а теория методов не излагается).

20

1,2, 3,4.

Таким образом, по первой компоненте имеем ранжировку {3 2 1 4}. Число

инверсий для получения “правильной” ранжировки {1 2 3 4} равно трём: 3 – 2, 3

– 1, 2 – 1.

В общем случае число инверсий Q может изменяться в пределах от 0 до

n/2(n - 1), причём крайние значения отвечают X– ранжировкам 1, 2, ...,(n – 1), n

и n, (n – 1), ..., 2, 1 (в случае последней X– ранжировки для ранга n потребуется n

– 1 инверсий, для значения ранга n – 1 нужно n – 2 инверсий, и т.д., вплоть до

ранга 2, так что общее число инверсий Q равно

n

Q=

i2

(i 1)

( n 1) n

( n 1) n

1 ( n 1)

2

2

).

Критерий Кендалла определяется как

4Q

.

(8)

n( n 1 )

Нетрудно сообразить, что если гипотеза независимости H верна, то

симметрично распределена на (-1, +1) (рассмотреть инверсию второй

компоненты yi - yi и убедиться, что Pr{Q = r} = Pr{Q = n(n-1)/2 - r}).

Следовательно, при верности H имеем E{} = 0 . В [3], стр. 646 приводится

асимптотическое выражение для дисперсии (если H верна): Var{} 4/(9n);

можно показать, что точная дисперсия в этом случае есть

= 1

Var{} =

2 ( 2 n 5)

.

9 n ( n 1)

Критическими являются большие значения | R | и | | . Эти статистики

затабулированы (см. Большев и Смирнов “Таблицы математической

статистики”) и имеются в статистических пакетах программ STATGRAPHICS,

BMDP, SAS и др. Для примера 1 статистика равна 0 (а статистика R = 0.25 /

(15/12) = 0.2 ).

Случайность. Мы уже говорили, что проверка гипотезы случайности H:

для независимых с.в. x i Fi (z) имеем F1 (z) = F2 (z) = ... Fn (z) для всех z , когда

наблюдения x1 , x2 , ..., x n упорядочены согласно значениям некоторой

переменной y , сводится к проверке независимости и (= y). Поэтому можно

использовать ранговые критерии независимости. Манн (1945) предложил

использовать ранговую корреляцию R для проверки H против альтернативы

тренда вниз

K : F1 (z) < F2 (z) < ... < Fn (z) для всех z

(в отличие от нормальных данных, для произвольного непрерывного

распределения м.о. E{x} может и не существовать, как в случае распределения

Коши), причём наблюдения x i остаются независимыми при K. Можно также

применять .

Оказывается, что статистики R и сильно коррелированы, и с точки

зрения их эффективности оба критерия обладают одинаковыми свойствами.

Эффективность критериев, основанных на R и , против нормальных

21

альтернатив велика. Так, для проверки независимости

АОЭ1 ( ) = (3/) 2

0.9 (по сравнению с обычным критерием, основанным на статистике r (3)), а для

проверки случайности против альтернативы линейного тренда с нормальными

ошибками: xi = 0 + 1i + i , где i N(0, 2), получается АОЭ() = (3/) 1 / 3

0.98 (по сравнению со стандартным критерием МНК, основанном на оценке b1

коэффициента 1). Однако можно построить свободные от распределения

критерии с АОЭ = 1 в случае нормальной альтернативы, если использовать не

сами ранги, а подходящие их функции. Дело в том, что при ранжировке

теряется информация о значениях наблюдаемых величин.

Следует ожидать, что оптимальная эффективность сохранится, если мы

заменим значения с.в. функциями от их рангов, которые асимптотически

полностью коррелированны со значениями случайной величины. Для этого

рассмотрим для выборки объёма n из стандартного нормального N(0, 1)

распределения w(i) – порядковые статистики (w(1) w(2) ... w(n) ) и их

математические ожидания E{w(i)} = m i – нормальные метки (normal scores).

Для фиксированного n набор нормальных меток вполне определён, не случаен,

и был впервые табулирован в 1938 г. Р.Фишером и Ф.Иэйтсом (можно

посмотреть сокращённую таблицу Х нормальных меток в [2]). Смысл их

использования в том, что при n корреляция этих чисел со значениями с.в.

стремится к 1 (это следует из теоремы Гёфдинга1 , см. гл.31 книги [3]), и мы

1

Что такое АОЭ (Асимптотическая Относительная Эффективность) ? Объяснение по книге [3],

гл. 25: для сравнения эффективности критериев рассматривают возможность варьировать объем

выборки n . Пусть критерию W

(1)

размера

определённой мощности, а другому критерию W

требуется n1

(2)

наблюдений для достижения

размера требуется n2 наблюдений для

достижения той же мощности. Тогда относительная эффективность второго критерия для

достижения указанной мощности против заданной альтернативы определяется как n1 / n2 .

Однако эта относительная эффективность есть функция трёх параметров: размера

критерия , расстояния (скажем, для случая единственного проверяемого параметра

разность | –

0

это

|) между проверяемой гипотезой и альтернативой, и объёма выборки n1 для

критерия W (1). Если просто устремить n1 , а расстояние между гипотезой и альтернативой

оставить неизменным, то для любого состоятельного критерия его мощность стремится к 1 при

0 , а потому относительная эффективность любых двух критериев была бы равна 1 при

таком определении. Поэтому Питмэн предложил рассматривать асимптотическое поведение

относительной эффективности критериев при n1 , когда альтернативное значение параметра

приближается к проверяемому значению 0 (это так для состоятельных критериев). Таким

образом, можно уподобить относительную эффективность отношению приращений в анализе, а

АОЭ – производной в точке 0 в дифференциальном исчислении.

Эта аналогия не надуманна: можно показать ([3], гл. 25), что в большинстве случаев

(точнее, когда первые производные функций мощности в точке 0 отличны от 0) АОЭ критерия

просто равна квадрату отношения производных функций мощности.

Теорема Гёфдинга <Hoeffding, W. (1953) Ann. Math. Statist., 24, pp. 93 - 100> : Предположим,

что с.в. F(x) – такая, для которой

1

22

получаем оптимальный ранговый критерий против нормальных альтернатив. По

аналогии с (3) и (6) статистика критерия имеет вид:

1 n

1

1 n

im

(

n

1

)

m

n i 1 Xi 2

n i 1 Xi

1 2

1 n

1 n

2

( n 1 ) { mXi mX j }

n i 1

n j 1

12

,

1/ 2

(9)

где Xi = rank(xi). Пренебрегая в (9) постоянными, получаем эквивалентную

статистику нормальных меток

n

c

im

i 1

Xi

,

(10)

которая имеет АОЭ = 1 при проверке независимости или случайности против

нормальных альтернатив. При справедливости гипотезы независимости H

имеем: E{c} = 0,

1 n

Var{c} =

( mi ) 2

n 1

i1

2

.

Пример 2 . Воспользуемся выборкой объёма n = 4 из примера 1. Мы

получили ранжировку

3 2 1 4

1,2, 3,4.

Используя таблицу Х нормальных меток из [2], видим, что при n = 4

нормальные метки равны -1.029, -0.297, +0.297, +1.029, так что c = 10.297 + 2(0.297) + 3(-1.029) + 41.029 = 0.732. Критическими являются значения | c | >> 0,

| x | dF ( x )

<,

и пусть g(y) – вещественная непрерывная функция, такая, что |g(y)| h(y), где h(y) – выпуклая

функция, и

h( y) dF ( y)

<.

Пусть x1, x2 , …, xn – выборка реализаций с.в. , а zn1 zn2 … znn – вариационный ряд для

неё.

Тогда

1

n n

lim

n

g(E{z nj })

j 1

=

g( x ) dF ( x ) .

Следствие. Применяя теорему к функциям g1 (x) = cos xt и g 2 (x) = sin xt (они ограничены

выпуклой функцией h(x) 1), доказываем, что предельная х.ф. для E{znj } (интегрирование

проводится по эмпирической ф.р.; см. раздел "Критерии согласия, основанные на эмпирической

ф.р." в следующей теме !) совпадает с х.ф. распределения F(x), равной E{cos t + i sin t}.

Отсюда по теореме Леви следует (асимптотическая) статистическая эквивалентность E{znj } и ,

и, следовательно, их 100% - ная коррелированность.

23

так что полученное c не противоречит гипотезе независимости (это можно

установить точнее, если воспользоваться таблицей критических значений

статистики c из [2]).

Задача о двух выборках (однородность). Имеем x1 , x2 , ..., xn F1 (z) и

y1 , y2 , ..., ym F2 (z), в общем случае n m . Обозначим для краткости N = n + m.

Проверяется гипотеза

H: F1 (z) = F2 (z) для всех z .

(11)

В качестве альтернативы можно рассмотреть альтернативу сдвига

К: F1 (z) = F2 (z - ) для всех z , 0 .

(12)

Тогда можно записать Н в терминах параметра сдвига :

Н: = 0 .

(11’)

Для нормальных выборок для проверки сдвига двух выборок

рассматривалось отношение разности средних x y к дисперсии или к

выборочной дисперсии. Составим из x1 , x2 , ..., xn и y1 , y2 , ..., ym объединённую

совокупность v1 , v2 , ..., vn , v n+1 , ..., v n+m , и пусть соответствующие x1 , x2 , ..., xn

ранги в этой объединённой совокупности будут V1 , V2 , ..., Vn , а y1 , y2 , ..., ym

отвечают ранги V n+1 , Vn+2 , ..., VN . Тогда можно рассмотреть вместо x y

ранговый аналог вида

1 n

1 m

W = Vi

V .

n i 1

m j 1 n j

Но

m

N

n

j 1

l 1

i 1

V n j V l V i

N (N 1) n

V i . Отсюда статистика

2

i 1

W = C1 + C2

1 n

V (C1 и C2 – постоянные) эквивалентна

n i 1 i

n

S=

V

i 1

(13)

i

— сумме рангов первой выборки (статистика Уилкоксона, 1945). Более удобна

для вычислений статистика Манна-Уитни (1947)

n

U=

m

h

i 1 j 1

ij

,

(14)

где

1, если xi y j ;

h ij

0 , если xi y j ,

(14’)

т.е. статистика Манна-Уитни считает общее число случаев, в которых элемент

первой выборки превосходит элемент второй выборки. Имеет место тождество

U = S - n(n+1)/2 ,

(15)

24

которое вытекает из

m

h

j 1

ij

Vi i для i = 1, 2, ..., n

(16)

(тогда, суммируя соотношение (16) по i от 1 до n, получим (15)). В свою

очередь, (16) доказывается по индукции. Прежде всего, нам несущественна

нумерация иксов внутри выборки x1 , x2 , ..., xn . Тогда занумеруем их так, что x1

< x2 < ...< x n (так как мы ограничились классом непрерывных с.в., совпадение

значений исключается). Тогда V1 = rank(x1 ) в объединённой (упорядоченной)

совокупности. До него в объединённой совокупности стоят “игреки” в числе V1

- 1 штук. Тем самым (16) доказано в случае i = 1. Рассмотрим i = 2; имеем V2 =

rank(x2 ). Значению x2 предшествуют V2 - 1 членов объединённой совокупности,

среди них есть один “икс” – x1 , а все остальные – игреки. Следовательно, для i

= 2 левая часть (16) равна V2 - 1 - 1 = V2 - 2 , т.е. мы доказали (16) для i = 2 .

На дом: осуществить индуктивный переход i - 1 i .

Найдём первые два момента статистики S (или, как это сделано в [2] ,

эквивалентной статистики U), если Н верна. Поскольку при этом любые ранги

членов первой выборки равновероятны, то

P{Vi = l} = (m + n) - 1 , l = 1, …, m + n = N .

(17)

Тогда имеем

E{Vi } =

1

N

N

l

= (N + 1)/2 .

l 1

Отсюда

n

n

E{S} = E Vi = E {Vi } = n(N + 1) / 2 ,

i 1

i 1

Аналогично, если Н верна, получим при i i ‘, j j’ :

(18)

P{Vi = j , Vi’ = j’ } = N - 1 (N - 1) - 1 ,

N 2 N

N

N

1

1

j l 2

откуда E{Vi Vi’} =

=

j j'

N (N 1) j 1 j ' 1 , j ' j

N (N 1) j 1

l 1

1

1

1 2

=

N (N 1) 2 N (N 1)( 2N 1) = (3N + 2)(N + 1) / 12 ,

N (N 1) 4

6

а также имеем

E{Vi 2} =

и

1

N

N

j 2 (N + 1)(2N + 1) /6 ,

j 1

E{S 2 } = nE{Vi 2} + n(n - 1) E{Vi Vi’} = n(N + 1) [ N + n(3N + 2) ] / 12

Var{S} = E{S 2 } - (E{S}) 2 =

mn(m n 1)

.

12

(19)

Величина S может изменяться от n(n + 1)/2 до mn + n(n + 1)/2.

Поскольку при справедливости Н любая перестановка имеет одинаковую

25

вероятность с перестановкой, дающей обратную последовательность значений,

то вероятности принять значения S = n(n + 1) /2 + r и S = n(n + 1) /2 + mn r одинаковы:

P{ S = n(n + 1) /2 + r } = P{ S = n(n + 1) /2 + mn - r }

(20)

(пусть выборки x1 , x2 , ..., xn и y1 ,y2 , ..., ym упорядочены (внутри себя) по

возрастанию, и значение S в левой части (20) соответствует рангам первой

выборки V1 , V2 , …Vn ; при инверсии выборок – рассмотрении -x1 , -x2 , ..., -xn и y1 ,-y2 , ...,-ym ранги первой выборки станут (N + 1) - V1 , (N + 1) - V2 , …(N +1) Vn , и, просуммировав их по i от 1 до n, получим значение S в правой части (20);

но, если Н верна, вероятность не должна измениться при инверсии), и

распределение S симметрично. Если m, n , но n / m = const, где 0 < const <

1 , то

n

S (m n 1)

2

w=

(21)

1 / 2 N(0, 1) .

mn

12 (m n 1)

Из изложенных свойств статистики Уилкоксона следуют замечания по

практическому применению критерия:

1. Если m, n велики (скажем, больше 60), то используется нормальная

асимптотика (21).

2. Если же m и n – малых или средних размеров, то при вычислении

критических значений статистики S (или U ) используется симметричность

постановки задачи, если Н верна. Критические значения даются только для

случая n m (см. таблицу У в [2]), а если нужно рассмотреть выборки с n > m ,

то просто считают y1 , y2 , ..., ym первой выборкой, а x1 , x2 , ..., xn – второй.

3. Точно так же можно ограничиться случаем малых критических

значений, т.е. случаем S « E{S}, так как противоположное критическое

значение для S » E{S} получается из соображений симметрии

распределения S.

Подробные таблицы критических значений для критерия Уилкоксона

приведены в книге: Большев, Смирнов “Таблицы математической статистики”,

1965, менее подробные – в [2]. Интересующихся принципами вычисления

критических значений статистик S и U я отсылаю к книге [4, вып. 2, стр. 110 111]. На ЭВМ можно использовать программы вычисления статистики критерия

Манна-Уитни-Уилконсона и проверки гипотезы о сдвиге распределений; см.,

например, функцию ranksum (критерий Уилкоксона) в Statistics Toolbox пакета

MATLAB; функцию MW_Utest (критерий Манна-Уитни) в STATISTICA;

функцию wilcox.test в S-PLUS.

Питмэн показал (см. [3], разделы 31.59 - 31.60) что, если для с.в. ,

порождающей выборки, ф.п.в. равна f(x), то АОЭ статистики Уилкоксона по

сравнению с критерием нормальной теории для проверки равенства средних

26

xy

1 1

s

m n

t=

равна Au, t =

2

2

2

=12 2 { f ( x )} dx = 12 2 f ( x ) f ( x )dx = 12 2 [ E{f()}] 2 .

(22)

В частном случае нормальных выборок E{f()} =

=

1

E{exp[-1 / 2 (( - ) / ) 2 ] } =

2

1

( 1 2it )1 / 2

2

i t 1 / 2

и тогда в нормальном случае

2

1

E exp it

2

i t = -1/2

= (4 2) - 1 / 2 ,

Au, t = 3 / 0.95 .

(23)

В [3] , стр. 666 показано, что

inf Au, t = 108 /125 = 0.864 ,

и он реализуется в случае параболического распределения.

По аналогии с выражением для статистики Уилкоксона (13) строится

статистика нормальных меток – сумма нормальных меток для первой выборки

(нормальные метки берутся для объединённой совокупности объёма N = n + m)

n

c1 =

m

i 1

Vi

,

(24)

и она имеет АОЭ = A c1 , t = 1 против нормальной альтернативы. Если гипотеза

отсутствия сдвига между распределениями и F1(z) и F2(z) верна, то ([3], стр.

670) E{c1 } = 0, Var{c1 } =

mn

(N 1) N

N

(m l ) 2 .

l 1

Пример 3. Возвращаясь к примеру 1 этой главы, рассмотрим {xi } и {yi }

как две независимые выборки равных объёмов m = n = 4, так что

x = (1.2, 2.4, 0.7, 3.9)T , а y = (2.2, 1.5, 3.8, 4.7)T

Объединённая совокупность v1 , v2 , ..., vn , v

построения вариационного ряда) такой:

n+1

, ..., v

n+m

будет (после

0.7, 1.2, 1.5, 2.2, 2.4, 3.8, 3.9, 4.7

(полужирным шрифтом выделены xi ) . Тогда ранги первой выборки равны

V1 = 1, V2 = 2, V3 = 5, V4 = 7 ,

27

значение статистики Уилкоксона S = 15, в то время как E{S} = 18, Var{S} = 12,

так что найденное значение S укладывается в E{S} Var{ S } . Из таблицы

критических значений для S в книге “Таблицы математической статистики”

Большева и Смирнова находим, что для n = m = 4 и объёма критерия = 0.05

нижнее критическое значение равно 11, так что нет оснований для отклонения

Н. Если рассмотреть статистику c1 , то из таблицы Х [2] имеем значения

нормальных меток для объединённой совокупности объёма m + n = 8 :

-1.424, -0.852, -0.473, -0.153, 0.153, 0.473, 0.852, 1.424 ,

так что

c1 = - 1.424 - 0.852 + 0.153 + 0.852 = -1.271 .

Так как я не мог воспользоваться таблицей критических точек статистики c1 ,

пришлось довольно грубо оценить, не противоречит ли вычисленное значение

c1 гипотезе Н отсутствия сдвига в выборках. За основу были взяты значения

м.о. и дисперсии статистики c1 ( [3] , стр. 668 – 670) . Значение c1 не

противоречит гипотезе Н .

28