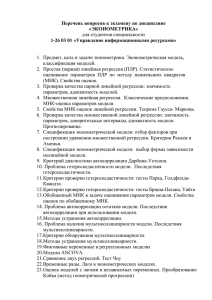

1. Оценка параметров линейной модели множественной регрессии

На любой экономический показатель чаще всего оказывает влияние не

один, а несколько факторов. Например, спрос на некоторое благо определяется

не только ценой данного блага, но и ценами на замещающие и дополняющие

блага, доходом потребителей и многими другими факторами. В этом случае

вместо парной регрессии рассматривается множественная регрессия

(1)

y f x1 , x2 ,..., x p .

Множественная регрессия широко используется в решении проблем

спроса, доходности акций, при изучении функции издержек производства, в

макроэкономических расчетах и в ряде других вопросов экономики. В настоящее время множественная регрессия - один из наиболее распространенных методов в эконометрике. Основной целью множественной регрессии является

построение модели с большим числом факторов, а также определение влияния

каждого фактора в отдельности и совокупного их воздействия на моделируемый показатель.

Множественный регрессионный анализ является развитием парного регрессионного анализа в случаях, когда зависимая переменная связана более

чем с одной независимой переменной. Большая часть анализа является непосредственным расширением парной регрессионной модели, но здесь также появляются и некоторые новые проблемы, из которых следует выделить две.

Первая проблема касается исследования влияния конкретной независимой переменной на зависимую переменную, а также разграничения её воздействия и

воздействий других независимых переменных. Второй важной проблемой является спецификация модели, которая состоит в том, что необходимо ответить

на вопрос, какие факторы следует включить в регрессию (1), а какие - исключить из неё. В дальнейшем изложение общих вопросов множественного регрессионного анализа будем вести, разграничивая эти проблемы. Поэтому вначале будем полагать, что спецификация модели правильна.

Самой употребляемой и наиболее простой из моделей множественной регрессии является линейная модель множественной регрессии:

y=α'+β1'x1+ β2'x2+…+ βp'xp+ε

(2)

По математическому смыслу коэффициенты β'j в уравнении (2) равны частным производным результативного признака у по соответствующим факторам:

y

y

y

1'

; 2'

; …, p'

.

x1

x2

x p

Параметр а' называется свободным членом и определяет значение у в случае, когда все объясняющие переменные равны нулю. Однако, как и в случае

парной регрессии, факторы по своему экономическому содержанию часто не

могут принимать нулевых значений, и значение свободного члена не имеет

экономического смысла. При этом, в отличие от парной регрессии, значение

каждого регрессионного коэффициента β'j равно среднему изменению у при

увеличении xj на одну единицу лишь при условии, что все остальные факторы

остались неизменными. Величина ε представляет собой случайную ошибку регрессионной зависимости.

Попутно отметим, что наиболее просто можно определять оценки параметров β'j, изменяя только один фактор xj, оставляя при этом значения других факторов неизменными. Тогда задача оценки параметров сводилась бы к последовательности задач парного регрессионного анализа по каждому фактору. Однако такой подход, широко используемый в естественнонаучных исследованиях, (физических, химических, биологических), в экономике является неприемлемым. Экономист, в отличие от экспериментатора - естественника, лишен

возможности регулировать отдельные факторы, поскольку не удаётся обеспечить равенство всех прочих условий для оценки влияния одного исследуемого

фактора.

Рассмотрим три метода расчета параметров множественной линейной

регрессии.

1. Матричный метод. Представим данные наблюдений и параметры модели в матричной форме.

Y=[y1, y2,…,yn]'- п-мерный вектор - столбец наблюдений зависимой переменной;

В=[a, b1, b2, … bp]' - (р+1)-мерный вектор - столбец параметров уравнения регрессии (3);

e=[e1, e2, … en]' - n-мерный вектор - столбец отклонений выборочных

значений

уi ,

от

значений

получаемых

по

уравнению

уi ,

y a b1 x1 b2 x2 ... b p x p .

Для удобства записи столбцы записаны как строки и поэтому снабжены

штрихом для обозначения операции транспонирования.

Наконец, значения независимых переменных запишем в виде прямоугольной матрицы размерности n·(p+1):

1 х11

1 x 21

Х

... ...

1 x

n1

х12

x 22

...

xn2

... х1 p

... x 2 p

... ...

... x np

Каждому столбцу этой матрицы отвечает набор из п значений одного из

факторов, а первый столбец состоит из единиц, которые соответствуют значениям переменной при свободном члене.

В этих обозначениях эмпирическое уравнение регрессии выглядит так:

Y=XB+e

(3)

Отсюда вектор остатков регрессии можно выразить таким образом:

e=Y-XB

(4)

Таким образом, функционал Q ei2 , который, собственно, и минимизируется по МНК, можно записать как произведение вектора – строки e' на вектор – столбец e:

Q=e’·e=(Y-XB)’·(Y-XB)

(5)

В соответствии с МНК дифференцирование Q по вектору B приводит к

выражению:

Q

2 X ' Y 2( X ' X ) B ,

B

(6)

которое для нахождения экстремума следует приравнять к нулю. В результате

преобразований получаем выражение для вектора параметров регрессии:

B’=(X’·X)-1·(X’·Y) (10)

Здесь (X’X)-1 - матрица, обратная к X' Х.

Регрессионная модель в скалярном виде:

𝑆̆=a+b1X1+b2X2+…+bpXp.

(7)

2. Скалярный метод. При его применении строится система нормальных уравнений, решение которой и позволяет получить оценки параметров регрессии:

an b1 x1 b2 x2 ... b p x p y;

2

a x1 b1 x1 b2 x2 x1 ... b p x p x1 yx1 ;

..................................................................................;

a x p b1 x1 x p b2 x2 x p ... b p x 2p yx p .

(8)

Решить эту систему можно любым подходящим способом, например,

методом определителей или методом Гаусса. При небольшом количестве

определяемых параметров использование определителей предпочтительнее.

Обратите внимание, что коэффициенты в левой части системы нормальных уравнений совпадают с соответствующими элементами матрицы X’X.

3. Регрессионная модель в стандартизированном масштабе

Уравнение регрессии в стандартизированном масштабе имеет вид:

(9)

t y 1t x 2t x ... p t x

1

2

p

где t y ; t x ; t x ;...; t x - стандартизированные переменные, такие, что:

1

ty

y y

y

2

p

; tx

j

xj xj

x

, где j=1, 2, …, n,

(10)

j

для которых среднее значение равно нулю: t y t x t x ... t x 0 , а сред1

2

p

нее квадратическое отклонение равно единице: t t 1 , j=1, 2, …, n.

y

xj

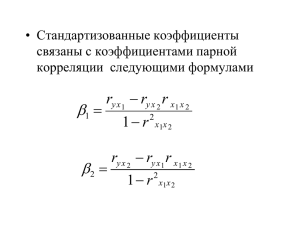

βj - стандартизированные коэффициенты регрессии, или β–коэффициенты (не следует путать их с параметрами уравнения (2)).

Применяя МНК к уравнению (9), после соответствующих преобразований получим систему нормальных уравнений:

1 2 rx2 x1 3 rx3 x1 ... p rx p x1 ryx1 ;

r r ... r r ;

2

3 x3 x2

p x p x2

yx2

1 x1x2

(11)

........................................................;

1rx1x p 2 rx2 x p 3 rx3x p ... p ryx p .

В этой системе ryx j ; rxi x , где i=1; 2; 3; …; n и j=1; 2; 3; …; n - элементы

j

расширенной матрицы парных коэффициентов корреляции или, другими словами, коэффициенты парной корреляции между различными факторами или

между факторами и результативным признаком. Имея измеренные значения

всех переменных, вычислить матрицу парных коэффициентов корреляции на

компьютере не составляет большого труда, используя, например, табличный

процессор MS Excel или программу Statistica.

Решением системы (11) определяются β-коэффициенты. Эти коэффициенты показывают, на сколько значений с.к.о. изменится в среднем результат,

если соответствующий фактор xj изменится на одну с.к.о. при неизменном

среднем уровне других факторов. Поскольку все переменные заданы как центрированные и нормированные, β-коэффициенты сравнимы между собой.

Сравнивая их друг с другом, можно ранжировать факторы по силе их воздействия на результат. В этом основное достоинство стандартизованных коэффициентов регрессии в отличие от коэффициентов обычной регрессии, которые

несравнимы между собой.

В парной зависимости стандартизованный коэффициент регрессии есть

не что иное, как линейный коэффициент корреляции r. Подобно тому, как в

парной зависимости коэффициенты регрессии и корреляции связаны между

собой, так и во множественной регрессии коэффициенты «чистой» регрессии

bj связаны с β-коэффициентами:

bj j

y

x

(12)

j

Это позволяет от уравнения регрессии в стандартизованном масштабе:

(13)

t y 1t x 2t x ... p t x

переходить к уравнению регрессии в натуральном масштабе (4). Параметр а определяется так:

a y b1 x1 b2 x2 ... bp x p

(14)

Свободный член в уравнении (13) отсутствует, поскольку все стандартизованные переменные имеют нулевое среднее значение.

Рассмотренный смысл стандартизованных коэффициентов регрессии

позволяет использовать их при отсеве факторов - из модели исключаются факторы с наименьшим значением βj.

Компьютерные программы построения уравнения множественной регрессии в зависимости от использованного в них алгоритма решения позволяют получить либо только уравнение регрессии для исходных данных, либо,

кроме того, уравнение регрессии в стандартизованном масштабе.

1

2

p

2. Обобщенный метод наименьших квадратов

Получение оценок параметров α׳, 1’, 2’, …, p уравнения регрессии

y=α'+β1'x1+ β2'x2+…+ βp'xp+ε - одна из важнейших задач множественного регрессионного анализа. Самым распространенным методом решения этой задачи является метод наименьших квадратов (МНК). Его суть состоит в минимизации суммы квадратов отклонений наблюдаемых значений зависимой

переменной у от её значений у, получаемых по уравнению регрессии. Поскольку параметры а', 1’, 2’, …, p являются неизвестными константами, вместо теоретического уравнения регрессии (2), оценивается так называемое эмпирическое уравнение регрессии, которое можно представить в виде:

(1)

y а b1 x1 b2 x2 ... bp x p e

Здесь a, b1, b2, ..., bp - оценки теоретических значений α', β1', β2'',…, βр',

или эмпирические коэффициенты регрессии, е - оценка отклонения ε. Тогда

расчетное выражение имеет вид:

(2)

y a b1 x1 b2 x2 ... b p x p

Пусть имеется п наблюдений объясняющих переменных и соответствующих им значений результативного признака:

(3)

xi1 , xi 2 ,..., xip , yi , i 1.n

Для однозначного определения значений параметров уравнения (2)

объем выборки п должен быть не меньше количества параметров, т.е.

п≥р+1. В противном случае значения параметров не могут быть определены

однозначно. Если п=р+1, оценки параметров рассчитываются единственным образом без МНК простой подстановкой значений (3) в выражение (2).

Получается система (р+1) уравнений с таким же количеством неизвестных,

которая решается любым способом, применяемым к системам линейных алгебраических уравнений (СЛАУ). Однако с точки зрения статистического

подхода такое решение задачи является ненадежным, поскольку измеренные значения переменных (3) содержат различные виды погрешностей. Поэтому для получения надежных оценок параметров уравнения (2) объём выборки должен значительно превышать количество определяемых по нему

параметров. Практически, как было сказано ранее, объём выборки должен

превышать количество параметров при xj в уравнении (2) в 6-7 раз.

Для проведения анализа в рамках линейной модели множественной регрессии необходимо выполнение ряда предпосылок МНК. В основном это

те же предпосылки, что и для парной регрессии, однако здесь нужно добавить предположения, специфичные для множественной регрессии:

1. Спецификация модели имеет вид y=α'+β1'x1+ β2'x2+…+ βp'xp+ε.

2. Отсутствие мультиколлинеарности: между объясняющими переменными отсутствует строгая линейная зависимость, что играет важную роль в

отборе факторов при решении проблемы спецификации модели.

3. Ошибки εi, i 1.n , имеют нормальное распределение (εi ~ N(0, σ)). Выполнимость этого условия нужна для проверки статистических гипотез и

построения интервальных оценок.

При выполнимости всех этих предпосылок имеет место многомерный

аналог теоремы Гаусса - Маркова: оценки a, b1, b2, ..., bp, полученные по

МНК, являются наиболее эффективными (в смысле наименьшей дисперсии)

в классе линейных несмещенных оценок.

При нарушении гомоскедастичности и наличии автокорреляции ошибок

рекомендуется традиционный метод наименьших квадратов заменять обобщенным методом наименьших квадратов (ОМНК).

Обобщенный метод наименьших квадратов применяется к преобразованным данным и позволяет получать оценки, которые обладают не только

свойством несмещенности, но и имеют меньшие выборочные дисперсии.

Остановимся на использовании ОМНК для корректировки гетероскедастичности.

Рассмотрим ОМНК для корректировки гетероскедастичности.

Будем предполагать, что среднее значение остаточных величин равно

нулю М(еi)=0 , а дисперсия пропорциональна величине Ki, т.е.

e2 Ki 2 , где e2 – дисперсия ошибки при конкретном i-м значении

фактора; σ2 – постоянная дисперсия ошибки при соблюдении предпосылки о

гомоскедастичности остатков; Ki – коэффициент пропорциональности, меняющийся с изменением величины фактора, что и обусловливает неоднородность дисперсии.

При этом предполагается, что σ2 неизвестна, а в отношении величин Ki

выдвигаются определенные гипотезы, характеризующие структуру гетероскедастичности.

В общем виде для уравнения yi=a+bxi+ei модель примет вид:

yi a bxi K i ei .

В ней остаточные величины гетероскедастичны. Предполагая в них отсутствие автокорреляции, можно перейти к уравнению с гомоскедастичными

остатками, поделив все переменные, зафиксированные в ходе i-го наблюдения,

на K i . Тогда дисперсия остатков будет величиной постоянной, т. е. e2 2 .

Иными словами, от регрессии y по x мы перейдем к регрессии на новых

i

i

i

x

. Уравнение регрессии примет вид:

K

x

y1

a

b i i ,

Ki

Ki

Ki

переменных:

y

и

K

а исходные данные для данного уравнения будут иметь вид:

y

y1

K1

y2

K2 , x

...

yp

K p

.

K p

x1

K1

x2

K2

...

xp

По отношению к обычной регрессии уравнение с новыми, преобразованными переменными представляет собой взвешенную регрессию, в которой переменные y и x взяты с весами

1

.

K

Оценка параметров нового уравнения с преобразованными переменными приводит к взвешенному методу наименьших квадратов, для которого необходимо минимизировать сумму квадратов отклонений вида

p

S (a, b)

i 1

1

( yi a bxi ) 2 .

Ki

Соответственно получим следующую систему нормальных уравнений:

x

y

1

a

b i i ;

Ki

Ki

Ki

b

2

a xi b xi xi yi

Ki

Ki

Ki

1

K

( xi x) ( yi y )

i

.

1

K ( xi x)

i

Т.е. коэффициент регрессии b при использовании обобщенного МНК с

целью корректировки гетероскедастичности представляет собой взвешенную

величину по отношению к обычному МНК с весом

1

.

K

Если преобразованные переменные x и y взять в отклонениях от средних

уровней, то коэффициент регрессии b можно определить как

1

b

K x y

1

K x2

.

При обычном применении метода наименьших квадратов к уравнению

линейной регрессии для переменных в отклонениях от средних уровней коэффициент регрессии b определяется по формуле: b

x y

x

2

.

Аналогичный подход возможен не только для уравнения парной, но и

для множественной регрессии.

Для применения ОМНК необходимо знать фактические значения дисперсий отклонений e2 . На практике такие значения известны крайне редко.

Поэтому, чтобы применить ВНК, необходимо сделать реалистические предположения о значениях e2 . В эконометрических исследованиях чаще всего предполагается, что дисперсии отклонений пропорциональны или значениям xi,

или значениям xi2 , т.е. e2 xi 2 или e2 xi2 2 .

Если предположить, что дисперсии пропорциональны значениям фактора x, т.е. e2 xi 2 , тогда уравнение парной регрессии yi=a+bxi+ei преобразуется делением его левой и правой частей на xi :

i

i

i

i

i

y

a

yi

x

e

a

b xi vi .

b i i или i

xi

xi

xi

xi

xi

xi

ei

Здесь для случайных отклонений vi

xi

выполняется условие го-

москедастичности. Следовательно, для регрессии применим обычный МНК.

Следует отметить, что новая регрессия не имеет свободного члена, но зависит

от двух факторов. Оценив для неё по МНК коэффициенты а и b, возвращаемся

к исходному уравнению регрессии.

Если предположить, что дисперсии e2 xi2 2 , то соответствующим

преобразованием будет деление уравнения парной регрессии yi=a+bxi+ei на xi:

i

yi

e

a

b i

xi xi

xi

vi

ei

xi

или

yi

a

b vi , если переобозначить остатки как

xi x i

.

Здесь для отклонений vi также выполняется условие гомоскедастичности.

В полученной регрессии по сравнению с исходным уравнением параметры поменялись ролями: свободный член а стал коэффициентом, а коэффициент b – свободным членом. Применяя обычный МНК в преобразованных

переменных yi*

yi

1

; zi получим оценки параметров, после чего возвращаxi

xi

емся к исходному уравнению.

3. Построение линейной регрессионной модели в условиях гетероскедастичности

Одной из ключевых предпосылок МНК является условие постоянства дисперсий случайных отклонений для любых наблюдений. Выполнимость данной

предпосылки называется гомоскедастичностью; невыполнимость данной

предпосылки называется гетероскедастичностью.

В качестве примера реальной гетероскедастичности можно привести то,

что люди с большим доходом не только тратят в среднем больше, чем люди с

меньшим доходом, но и разброс в их потреблении также больше, поскольку

они имеют больше простора для распределения дохода.

При гетероскедастичности последствия применения МНК будут следующими:

1. Оценки параметров останутся по-прежнему несмещенными и линейными.

2. Оценки не будут эффективными, т.е. не будут иметь наименьшую дисперсию по сравнению с другими оценками данного параметра. Они не будут

даже асимптотически эффективными. Увеличение дисперсии оценок снижает

вероятность получения максимально точных оценок.

3. Дисперсии оценок параметров будут рассчитываться со смещением.

4. Все выводы, получаемые на основе соответствующих t и F-статистик, а

также интервальные оценки будут ненадежными. Вполне вероятно, что стандартные ошибки коэффициентов будут занижены, а t-статистики завышены.

Это может привести к признанию статистически значимыми коэффициентов,

которые таковыми на самом деле не являются.

В ряде случаев, зная характер исходных данных, можно предвидеть гетероскедастичность и попытаться устранить её ещё на стадии спецификации.

Однако значительно чаще эту проблему приходится решать после построения

уравнения регрессии.

Графическое построение отклонений от эмпирического уравнения регрессии позволяет визуально определить наличие гетероскедастичности. В этом

случае по оси абсцисс откладываются значения объясняющей переменной хi,

(для парной регрессии) либо линейную комбинацию объясняющих переменных:

yi a b1 xi1 ... bp xip , i 1, n

(для множественной регрессии), а по оси ординат либо отклонения ei либо их

квадраты ei2 , i 1, n .

Если все отклонения ei2 находятся внутри горизонтальной полосы постоянной ширины, это говорит о независимости дисперсий ei2 от значений объясняющей переменной и выполнимости условия гомоскедастичности.

В других случаях наблюдаются систематические изменения в соотноше

ниях между значениями y i и квадратами отклонений ei2 :

Такие ситуации отражают большую вероятность наличия гетеросхедастичности для рассматриваемых статистических данных.

В настоящее время для определения гетероскедастичности разработаны

специальные тесты и критерии для них.

Тест ранговой корреляции Спирмена. При использовании данного теста

предполагается, что дисперсия отклонений будет либо увеличиваться, либо

уменьшаться с увеличением значений х. Поэтому для регрессии, построенной

по МНК, абсолютные величины отклонений |еi| и значения хi, будут коррелированы. Затем определяется коэффициент ранговой корреляции:

d

rx ,e 1 6

2

i

(53)

,

nn 2 1

где di - разность между рангами хi, и |еi,|, п - число наблюдений. Например,

если х20 является 25-м по величине среди всех значений х, а е20 является 32-м,

то d20 = 25 - 32 = -7.

Доказано, что при справедливости нуль - гипотезы H0 : rx,e = 0 статистика

r n2

(54)

t x ,e

2

1 rx ,e

имеет распределение Стьюдента с числом степеней свободы (n-2). Поэтому,

если наблюдаемое значение статистики (54) превышает критическое t(α; n -2),

вычисленное по таблице критических точек распределения Стьюдента (двусторонних), то гипотезу о равенстве нулю коэффициента корреляции (53) следует отклонить и признать наличие гетероскедастичности. В противном случае нуль - гипотеза, которая соответствует отсутствию гетероскедастичности,

принимается.

В модели множественной регрессии проверка нуль - гипотезы может осуществляться с помощью t - статистики по каждому фактору отдельно.

Тест Голдфелда-Квандта. В данном случае предполагается, что стандартное отклонение пропорционально значению переменной хj, т.е. i2 2 x 2ji ,

i 1, n . Предполагается, что остатки имеют нормальное распределение и отсутствует автокорреляция остатков.

Тест состоит в следующем:

1. Все п наблюдений упорядочиваются по величине хj.

2. Вся упорядоченная выборка разбивается на три подвыборки размерностей k, n-2k и k соответственно.

3. Оцениваются отдельные регрессии для первой подвыборки (k первых

наблюдений) и для третьей подвыборки (k последних наблюдений). Если предположение о пропорциональности дисперсий отклонений значениям xj верно,

то остаточная СКО по первой регрессии:

k

s1 ei2

i 1

будет существенно меньше остаточной СКО по третьей регрессии:

s3

n

e

i n k 1

2

i

.

4. Для сравнения соответствующих дисперсий выдвигается нуль - гипотеза

в виде:

H 0 : 12 22 ... n2 ,

которая предполагает отсутствие гетероскедастичности. Для проверки нуль - гипотезы

строится следующая статистика

Fт абл

s3 / k p 1 s3

s1 / k p 1 s1

(55)

которая при справедливости нуль - гипотезы имеет распределение Фишера с

(k-p-1, k-p-1) степенями свободы.

5. Если Fнабл Fкр Fтабл ; k p 1; k p 1,

то гипотеза об отсутствии гетероскедастичности отклоняется на уровне значимости α.

По рекомендациям специалистов, объем исключаемых данных k должен

быть примерно равен четверти общего объёма выборки п.

Этот же тест может быть использован и при предположении об обратной

пропорциональности между дисперсией и значениями объясняющей переменной. В этом случае статистика Фишера принимает вид:

s

(56)

F 1

s3

При установлении гетероскедастичности возникает необходимость преобразования модели с целью устранения данного недостатка. Вид преобразования зависит от того, известны или нет дисперсии отклонений i2 .

В случае, если дисперсии отклонений известны для каждого наблюдения,

применяется метод взвешенных наименьших квадратов (ВНК). Гетероскедастичность устраняется, если разделить каждое наблюдаемое значение на

соответствующее ему значение дисперсии.

Рассмотрим для простоты ВНК на примере парной регрессии:

yi=a+bxi+εi.

(57)

2

Разделим обе части (57) на известное i i :

yi

x

1

(58)

a b i i

i

i

i

i

Сделаем замены переменных:

y

x

1

yi i ; xi i ; zi ; i i ;

(59)

i

i

i

i

получим уравнение регрессии без свободного члена, но с двумя факторами

и с преобразованным отклонением:

yi azi bxi i .

(60)

Можно показать, что для νi выполняется условие гомоскедастичности. Поэтому для модели (60) выполняются все предпосылки МНК, и оценки, полученные но МНК, будут наилучшими линейными несмещенными оценками.

Таким образом, наблюдения с наименьшими дисперсиями получают

наибольшие «веса», а наблюдения с наибольшими дисперсиями - наименьшие

«веса». Поэтому наблюдения с меньшими дисперсиями отклонений будут более значимыми при оценке параметров регрессии, чем наблюдения с большими дисперсиями. При этом повышается вероятность получения более точных оценок.

Полученные по МНК оценки параметров модели (60) можно использовать

в первоначальной модели (57).

Для применения ВПК необходимо знать фактические значения дисперсий

отклонений i2 . На практике такие. значения известны крайне редко. Поэтому,

чтобы применить ВПК, необходимо сделать реалистические предположения о

значениях i2 . Чаще всего предполагается, что дисперсии отклонений пропорциональны или значениям хi, или значениям xi2 .

Если предположить, что дисперсии пропорциональны значениям фактора

х, т.е.

(61)

i2 2 xi ,

тогда уравнение (57) преобразуется делением его левой и правой частей на

xi :

yi

x

a

b i i

xi

xi

xi

xi

или

yi

1

(62)

a

b xi i .

xi

xi

Здесь для случайных отклонений i i / xi выполняется условие гомоскедастичности. Следовательно, для регрессии (62) применим обычный

МНК. Следует отметить, что регрессия (62) не имеет свободного члена, но зависит от двух факторов. Оценив для (62) по МНК коэффициенты a и b, возвращаемся к исходному уравнению регрессии.

Если в уравнении регрессии присутствует несколько объясняющих переменных, вместо конкретной переменной хj, используется исходное уравнение

множественной регрессии

y a b1 x1 b2 x2 ... bp x p .

т.е. фактически линейная комбинация факторов. В этом случае получают следующую регрессию:

xip

yi

xi1

i

1

a

b

...

b

1

p

.

yi

yi

yi

yi

yi

(63)

Если предположить, что дисперсии i2 пропорциональны xi2 , то соответствующим преобразованием будет деление уравнения регрессии (57) на хi:

yi a

b i

xi xi

xi

или, если переобозначить остатки как i i / xi :

yi

1

(64)

a b i.

xi

xi

Здесь для отклонений vi также выполняется условие гомоскедастичности.

Применяя обычный МНК к регрессии (64) в преобразованных переменных

yi

1

; zi ,

xi

xi

получим оценки параметров, после чего возвращаемся к исходному уравнению (57). Отметим, что в регрессии (64) по равнению с исходным уравнением

параметры поменялись ролями: свободный член а стал коэффициентом, а коэффициент b - свободным членом.

yi

4. Построение линейной регрессионной модели с автокоррелированными остатками

Важной предпосылкой построения качественной регрессионной модели по

МНК является независимость значений случайных отклонений εi от значений

отклонений во всех других наблюдениях. Отсутствие зависимости гарантирует отсутствие коррелированности между любыми отклонениями, т.е. cov(εi,

εj) i ≠ j и, в частности, между соседними отклонениями (cov(εi-1, εi)=0).

Автокорреляция (последовательная корреляция) остатков определяется как корреляция между соседними значениями случайных отклонений во

времени (временные ряды) или в пространстве (перекрестные данные). Она

обычно встречается во временных рядах и очень редко - в пространственных

данных. В экономических задачах значительно чаще встречается положительная автокорреляция (cov(εi-1, εi,)> 0), чем отрицательная автокорреляция

(cov(εi-1, εi,)<0).

Чаще всего положительная автокорреляция вызывается направленным постоянным воздействием некоторых не учтенных в регрессии факторов. Например, при исследовании спроса у на прохладительные напитки в зависимости

от дохода х на трендовую зависимость накладываются изменения спроса в летние и зимние периоды. Аналогичная картина может иметь место в макроэкономическом анализе с учетом циклов деловой активности.

Отрицательная автокорреляция фактически означает, что за положительным отклонением следует отрицательное и наоборот. Такая ситуация может

иметь место, если ту же зависимость между спросом на прохладительные

напитки и доходами рассматривать не ежемесячно, а раз в сезон (зима-лето).

Применение МНК к данным, имеющим автокорреляцию в остатках, приводит к таким последствиям:

1. Оценки параметров, оставаясь линейными и несмещенными, перестают

быть эффективными. Они перестают быть наилучшими линейными несмещенными оценками.

2. Дисперсии оценок являются смещенными. Часто дисперсии, вычисляемые по стандартным формулам, являются Сниженными, что влечет за собой увеличение t - статистик. Это может привести к признанию статистически значимыми факторов, которые в действительности таковыми не являются.

3. Оценка дисперсии регрессии является смещенной оценкой истинного

значения σ2, во многих случаях занижая его.

4. Выводы по t- и F - статистикам, возможно, будут неверными, что ухудшает прогнозные качества модели.

Для обнаружения автокорреляции используют либо графический метод,

либо статистические тесты. Рассмотрим два наиболее популярных теста.

Метод рядов. По этому методу последовательно определяются знаки отклонений et , t 1, n от регрессионной зависимости. Например, имеем при 20

наблюдениях

(-----)(+++++++)(---)(++++)(-).

Ряд определяется как непрерывная последовательность одинаковых знаков. Количество знаков в ряду называется длиной ряда. Если рядов слишком

мало по сравнению с количеством наблюдений, то вполне вероятна положительная автокорреляция. Если же рядов слишком много, то вероятна отрицательная автокорреляция.

Пусть п - объём выборки, п1 - общее количество положительных отклонений; п2 - общее количество отрицательных отклонений; k - количество рядов.

В приведенном примере n=20, п1=11, п2=5.

При достаточно большом количестве наблюдений (п1>10, п2>10) и отсутствии автокорреляции СВ k имеет асимптотически нормальное распределение,

в котором

2п n

M k 1 2 1;

n1 n2

2п n 2n n n1 n2

Dk 1 2 12 2

n1 n2 n1 n2 1

Тогда, если

M(k)-ua/2·D(k)<k<M(k)+ua/2·D(k),

по гипотеза об отсутствии автокорреляции не отклоняется. Если k ≤. M(k)ua/2·D(k), то констатируется положительная автокорреляция; в случае k ≥

M(k)+ua/2·D(k) признается наличие отрицательной автокорреляции.

Для небольшого числа наблюдений (n1<20, n2<20) были разработаны таблицы критических значений количества рядов при п наблюдениях. В одной

таблице в зависимости от n1 и n2 определяется нижняя граница k1 количества

рядов, в другой - верхняя граница k2. Если k1<k<k2 то говорят об отсутствии

автокорреляции. Если k≤k1, то говорят о положительной автокорреляции. Если

k≥k2, тo говорят об отрицательной автокорреляции. Например, для приведенных выше данных k1=6, k2=16 при уровне значимости 0,05. Поскольку

k=5<k1=6, определяем положительную автокорреляцию.

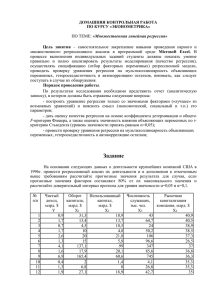

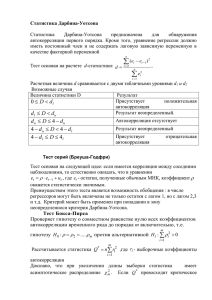

Критерий Дарбина-Уотсона. Это наиболее известный критерий обнаружения автокорреляции первого порядка. Статистика ZW Дарбина-Уотсона

приводится во всех специальных компьютерных программах как одна из важнейших характеристик качества регрессионной модели.

Сначала по построенному эмпирическому уравнению регрессии определя

ются значения отклонений et yt yt , t 1, n . Рассчитывается статистика

n

DW

e

t 2

et 1

2

t

.

n

e

(65)

2

t

t 1

Далее по таблице критических точек Дарвина-Уотсона определяется два

числа d1 и dи и осуществляются выводы по правилу:

0≤DW≤d1

- положительная автокорреляция;

d1<DW<du

- зона неопределенности;

du≤DW≤4-du

- автокорреляция отсутствует;

4-du<DW<4-d1

- зона неопределенности;

4-d1≤DW≤4

– отрицательная автокорреляция.

Можно сказать, что статистика DW тесно связана с коэффициентом автокорреляции первого порядка:

n

rt 1et

e

e

t 1 t

t 2

n 1

.

n

(66)

e e

t 1

2

t

t 2

2

t 1

Связь выражается формулой:

(67)

DW 21 ret 1et .

Отсюда вытекает смысл статистического анализа автокорреляции. Поскольку значения r изменяются от -1 до +1, DW изменяется от 0 до 4. Когда

автокорреляция отсутствует, коэффициент автокорреляции равен нулю, и статистика DW равна 2. DW=O соответствует положительной автокорреляции,

когда выражение в скобках равно нулю (r=1). При отрицательной автокорреляции (r= -1) DW=4, и выражение в скобках равно двум.

Ограничения критерия Дарбина-Уотсона:

1. Критерий DW применяется лишь для тех моделей, которые содержат

свободный член.

2. Предполагается, что случайные отклонения определяются по итерационной схеме

et pet 1 t ,

(68)

называемой авторегрессионой схемой первого порядка AR(1). Здесь νt- случайный член.

3. Статистические данные должны иметь одинаковую периодичность (не

должно быть пропусков в наблюдениях).

4. Критерий Дарбина - Уотсона не применим к авторегрессионым моделям

вида:

(69)

yt a b1 xt1 ... bp xtp cyt 1 et ,

которые содержат в числе факторов также зависимую переменную с временным лагом (запаздыванием) в один период.

Для авторегрессионых моделей предлагается h - статистика Дарбина

n

(70)

h

,

1 nDc

где β - оценка коэффициента автокорреляции первого порядка (66), D(c) - выборочная дисперсия коэффициента при лаговой переменной yt-1, п - число

наблюдений.

При большом п и справедливости нуль - гипотезы Н0:р=0 h~N(0,1). Поэтому при заданном уровне значимости определяется критическая точка из

условия

1

,

Фи / 2

2

и h - статистика сравнивается с иα/2. Если |h|> иα/2, то нуль - гипотеза об отсутствии автокорреляции должна быть отклонена. В противном случае она не отклоняется.

Обычно значение p рассчитывается по формуле p 1 DW / 2, a D(c)

равна квадрату стандартной ошибки тс оценки коэффициента с. Следует отметить, что вычисление h - статистики невозможно при nD(c)>1.

Автокорреляция чаще всего вызывается неправильной спецификацией модели. Поэтому следует попытаться скорректировать саму модель, в частности,

ввести какой-нибудь неучтенный фактор или изменить форму модели (например, с линейной на полулогарифмическую или гиперболическую). Если все

эти способы не помогают и автокорреляция вызвана какими-то внутренними

свойствами ряда {еt}, можно воспользоваться преобразованием, которое называется авторегрессионой схемой первого порядка AR(1).

Рассмотрим AR(1) на примере парной регрессии:

y=a+bx+e.

(71)

Тогда соседним наблюдениям соответствует формула:

yt=a+bxt+et,

(72)

yt-1=a+bxt-1+et-1.

(73)

Если случайные отклонения определяются выражением (68), где коэффициент р известен, то можем получить

yt - pyt-1=a(1- p)+b(xt -pxt-1)+(et –pet-1).

(74)

Сделаем замены переменных

(75)

yt yt pyt 1 ; xt xt pxt 1 ; a a1 p

получим с учетом (68):

(76)

yt a bxt t .

Поскольку случайные отклонения vt удовлетворяют предпосылкам МНК,

оценки a* и b будут обладать свойствами наилучших линейных несмещенных

оценок. По преобразованным значениям всех переменных с помощью обычного MНK вычисляются оценки параметров а* и b, которые затем можно использовать в регрессии (71).

Однако способ вычисления преобразованных переменных (75) приводит к

потере первого наблюдения, если нет информации о предшествующих наблюдениях. Это уменьшает на единицу число степеней свободы, что при больших

выборках не очень существенно, однако при малых выборках приводит к потере эффективности. Тогда первое наблюдение восстанавливается с помощью

поправки Прайса-Уинстена:

x1 1 p 2 x1

(77)

y1 1 p 2 y1

Авторегрессионое преобразование может быть обобщено на произвольное

число объясняющих переменных, т.е. использовано для уравнения множественной регрессии.

Для преобразования АR(1) важно оценить коэффициент автокорреляции р.

Это делается несколькими способами. Самое простое - оценить р на основе

статистики DW:

(78)

r 1 DW / 2,

где r берется в качестве оценки р. Этот метод хорошо работает при большом

числе наблюдений.

Существуют и другие методы оценивания р, например, метод Кокрена Оркатта и метод Хилдрета - Лу. Они являются итерационными, и их рассмотрение выходит за рамки данного конспекта лекций.

В случае, когда есть основания считать, что автокорреляция отклонений

очень велика, можно использовать метод первых разностей. В частности, при

высокой положительной автокорреляции полагают р=1, и уравнение (74) принимает вид

yt yt 1 b xt xt 1 et et 1

или

yt bxt t ,

(79)

где yt yt yt 1 , xt xt xt 1 .

Из уравнения (79) по МНК оценивается коэффициент b. Параметр а здесь

не определяется непосредственно, однако из МНК известно, что a y bx.

В случае р=-1, сложив (72) и (73) с учетом (68), получаем уравнение регрессии:

yt yt 1 2a b xt xt 1 t

или

yt yt 1

x xt 1

ab t

t .

2

2

5. Структурная и приведенная форма систем эконометрических

уравнений

Объектом статистического изучения в социальных науках являются сложные системы. Построение изолированных уравнений регрессии недостаточно

для описания таких систем и объяснения механизма их функционирования.

Изменение одной переменной, как правило, не может происходить без изменения других. Поэтому важное место занимает проблема описания структуры

связей между переменными и системой так называемых одновременных

уравнений. Так, если изучается модель спроса как отношение цен и количества потребляемых товаров, то одновременно для прогнозирования спроса

необходима модель предложения товаров, в которой рассматривается также

взаимосвязь между количеством и ценой предлагаемых благ. Это позволяет

достичь равновесия между спросом и предложением.

Системы уравнений здесь могут быть построены по-разному.

Возможна система независимых уравнений, когда каждая зависимая переменная у рассматривается как функция одного и того же набора факторов х:

y1 a11x1 a12 x2 a1m xm 1

y a x a x a x

1

21 1

22 2

2m m

2

(1)

y1 an1 x1 an 2 x2 anm xm n

Набор факторов xj в каждом уравнении может варьироваться. Каждое уравнение может рассматриваться самостоятельно. Для нахождения его параметров используется МНК. По существу, каждое уравнение этой системы является уравнением регрессии.

Наибольшее распространение в эконометрических исследованиях получила система одновременных (совместных, взаимозависимых) уравнений.

В ней одни и те же зависимые переменные в одних уравнениях входят в левую

часть, а в других уравнениях - в правую часть:

b1n yn

a11x1 a1m xm 1

y1 b12 y2 b13 y3

y b y b y b y

a21x1 a2 m xm 2

2

21 1

23 3

2n n

(2)

yn bn1 y1

bn 2 y2

bn,n1 yn1

an1 x1

anm xm

n

В эконометрике эта система уравнений называется также структурной

формой модели. Для нахождения параметров каждого уравнения традиционный МНК неприменим, здесь используются специальные методы оценивания.

В этом случае каждое из уравнений не может рассматриваться самодеятельно.

Структурная и приведенная формы модели

Система одновременных уравнений (т.е. структурная форма модели)

обычно содержит эндогенные и экзогенные переменные.

Эндогенные переменные - это зависимые переменные, число которых

равно числу уравнений в системе. Они обозначаются через у

Экзогенные переменные - это предопределенные переменные, влияющие

на эндогенные переменные, но не зависящие от них. Они обозначаются через

х.

Простейшая структурная форма модели имеет вид:

y1 b12 y 2 a11x1 1

y2 b21 y1 a22 x2 2

где у1, y2 эндогенные переменные, х1,х2 - экзогенные.

Классификация переменных на эндогенные и экзогенные зависит от теоретической концепции принятой модели. Экономические переменные могут выступать в одних моделях как эндогенные, а в других - как экзогенные переменные. Внеэкономические переменные (например, климатические условия) входят в систему как экзогенные переменные. В качестве экзогенных переменных

можно рассматривать значения эндогенных переменных за предшествующий

период времени (лаговые переменные). Например, потребление текущего года

yt может зависеть также и от уровня потребления в предыдущем году уt-1.

Структурная форма модели позволяет увидеть влияние изменений любой

экзогенной переменной на значение эндогенной переменной. Целесообразно в

качестве экзогенных переменных выбирать такие переменные, которые могут

быть объектом регулирования. Меняя их и управляя ими, можно заранее иметь

целевые значения эндогенных переменных.

Коэффициенты bi при эндогенных и аj - при экзогенных переменных называются структурными коэффициентами модели. Все переменные в модели

могут быть выражены в отклонениях (х - х ) и (у - у ) от среднего уровня, и тогда свободный член в каждом уравнении отсутствует.

Использование МНК для оценивания структурных коэффициентов модели

дает смещенные и несостоятельные оценки. Поэтому обычно для определения

структурных коэффициентов модели структурная форма преобразуется в приведенную.

Приведенная форма модели представляет собой систему линейных функций эндогенных переменных от экзогенных:

y1 11x1 1m xm

y x x

2

21 1

2m m

(3)

yn n1 x1 nm xm

δij — коэффициенты приведенной формы модели.

По своему виду приведенная форма модели ничем не отличается от системы независимых уравнений. Применяя МНК, можно оценить δij, а затем

оценить значения эндогенных переменных через экзогенные.

Приведенная форма позволяет выразить значения эндогенных переменных

через экзогенные, однако аналитически уступает структурной форме модели,

т.к. в ней отсутствуют оценки взаимосвязи между эндогенными переменными.

6. Косвенный МНК

Коэффициенты структурной модели могут быть оценены равными способами в зависимости от вида системы одновременных уравнений. Наибольшее

распространение получили два метода оценивания коэффициентов структурной модели: косвенный МНК и двухшаговый МНК.

Косвенный МНК (КМНК) применим в случае точно идентифицируемой

структурной модели. Процедура следующая:

1. Структурная модель преобразуется в приведенную форму.

2. Для каждого уравнения приведенной формы обычным МНК оцениваются коэффициенты δij

3. Коэффициенты приведенной модели трансформируются в параметры

структурной модели.

Рассмотрим применение КМНК для модели:

y1 b12 y2 a11x1 1

y2 b21 y1 a22 x2 2

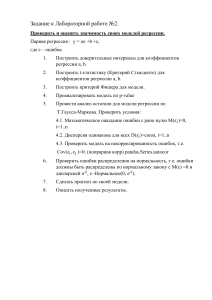

Для построения модели имеем таблицу:

№ п/п

y1

y2

x1

x2

1

2

5

1

3

2

3

6

2

1

3

4

7

3

2

4

5

8

2

5

5

6

5

4

6

Средние

4

6,2

2,4

3,4

Приведенная форма модели имеет вид:

y1 11x1 12 x2 u1

y2 21x1 22 x2 u2

где и1, и2 —случайные ошибки приведенной формы модели.

Для каждого уравнения приведенной формы применим традиционный

МНК и определим

δ - коэффициенты. Для простоты работаем в отклонениях, т.е. уу - у ,

хх - х . Тогда система нормальных уравнений для первого уравнения системы составит:

11 x12 12 x1 x2 y1 x1

2

y1 x2

11 x1 x2 12 x2

Для приведенных данных система составит:

5.2 11 4.2 12 6

4.2 11 17.2 12 10

Отсюда получаем первое уравнение (и аналогично второе):

0.373 x2

u1

y1 0.852 x1

y2 0.072 x1 0.00557 x2 u2

Перейдем к структурной форме следующим образом: исключим из первого

уравнения приведенной формы х2, выразив его из второго уравнения приведенной формы и подставив в первое уравнение:

0.072 x1 y2

x2

.

0.00557

Первое уравнение структурной формы:

0.072 x1 y2

y1 0.852 x1 0.373

66.966 y2 3.97 x1.

0.00557

Аналогично исключим из второго уравнения x1 выразив его через первое

уравнение и подставив во второе:

y 0.373 x2

y 0.373 x2

y2 0.072 1

0.00557 x2 ;

x1 1

;

0.852

0.852

y2 0.085 y1 0.026 x2 - второе уравнение структурной формы.

Структурная форма модели имеет вид:

y1 66.966 y2 3.97 x1 1

y2 0.085 y1 0.026 x2 2

Эту же систему можно записать, включив в нее свободный член уравнения,

т.е. перейти от переменных в виде отклонений от среднего к исходным переменным y и x:

A01 y1 b12 y2 a11x1 428 .717

A02 y1 b21 y1 a22 x2 6.451

Тогда структурная модель имеет вид:

y1 428.717 66.966 y2 3.97 x1 1

6.451

0.085 y1 0.026 x2 2

y2

Если к каждому уравнению структурной формы применить традиционный

МНК, то результаты могут сильно отличаться. В данном примере будет:

y1 1.09 0.364 y2 1.192 x1 1

y2 5.2 0.533 y1 0.333 x2 2