Регуляторные сигналы

advertisement

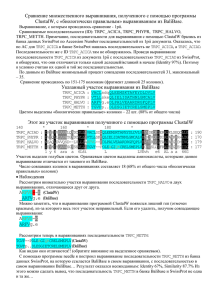

Поиск сигналов А.Алексеевский, по мотивам презентаций М. С. Гельфанда, Е.О.Ермаковой, Д.А.Равчеева, В.Ю.Макеева, И.И. Артамоновой Слайды, помеченные РГМ, заимствованы из презентации для y12, осень 2013г. 1 План 1. Что такое сигнал, и как устроены сигналы 2. Теория поиска сигналов 3. Технология поиска сигналов 4. Базы данных и сервисы 2 1. Сигналы – специальные короткие последовательности ДНК или РНК • Сигналы узнаются белками для выполнения функции • Промоторы – сайты посадки сигма-субъединицы РНК-полимеразы. • Терминаторы. Прокариоты: Rho-зависимые, rho-независимые • Сайты посадки рибосомы • Регуляторные сигналы • Много-много-много разных других • Сигналы одного типа в разных местах генома или в геномах родственных организмов не обязаны быть гомологичными (но могут быть) • Задача биоинформатики – выделять сигналы из экспериментальных данных, предсказывать их в новых контекстах и новых геномах 3 Белки узнают нужные им сигналы лучше, чем самые крутые биоинформатики! 4 2. Теория Поиск сигналов при наличии обучающей выборки Пример задачи. Вход: в геноме бактерии известно несколько сайтов связывания определенного транскрипционного фактора X. Требуется: 1) в геноме найти ВСЕ сайты связывания X; 2) и все гены, регулируемые этим фактором - регулон; 3) в геномах родственных бактерий найти все то же самое: ортолога транскрипционного фактора, его сайты и регулон 5 • Выравнивание по сигналам • Оценка сигнала – слабый или сильный • Построение профиля выравнивания • Поиск новых сигналов по профилю • Ревизия результатов • Итерация все процедуры Слайд6 Оценка сигнала 7 Выравнивание окрестностей сайтов связывания PurR E. coli cvpA purM purT purL purE purC purB purH purA1 purA2 guaB purR1 purR2 CCTACGCAAACGTTTTCTTTTT GTCTCGCAAACGTTTGCTTTCC CACACGCAAACGTTTTCGTTTA TCCACGCAAACGGTTTCGTCAG GCCACGCAACCGTTTTCCTTGC GATACGCAAACGTGTGCGTCTG CCGACGCAATCGGTTACCTTGA GTTGCGCAAACGTTTTCGTTAC TTGAGGAAAACGATTGGCTGAA TTTAAGCAAACGGTGATTTTGA TAGATGCAATCGGTTACGCTCT TAAAGGCAAACGTTTACCTTGC AACGAGCAAACGTTTCCACTAC Источник: РГМ 8 Частота буквы в колонке и псевдокаунты - число букв в колонке - число последовательностей ; может быть нулем - подправленная частота буквы в колонке , где - псевдокаунт для буквы - коэффициент, подбираемый для задачи 9 Информационное содержание колонки и выравнивания • Минимум I(j) равен 0 => минимум I равен 0 • Максимум I(j) равен 2 если все pb = ¼; равен (– log2 pb) для минимального pb • Значит: •минимум I выравнивания равен 0 •максимум I выравнивания равен 2m (m – длина выравнивания) если все pb = ¼; 10 Диаграмма Лого (Logo) информационное содержание колонки Сайты связывания PurR E. coli Упражнение: вычислите информационное содержание выравнивания PurR из предыдущих слайдов Источник: РГМ Слайд11 Поиск сигналов при наличии выравнивания 12 Вес выравнивания профиля и последовательности cvpA purM purT purL purE purC purB purH purA1 purA2 guaB purR1 purR2 Профиль (W(A,7) = 1.1) A C G T Последовательность Вес выравнивания A T A A A A A G A A A A G C C C C C C C C G A T G A G G G G G G G G G G G G G C C C C C C C C A C C C C A A A A A A A A A A A A A A A A A A A A A A A A A A A A A A C A T A A A T A A C C C C C C C C C C C C C G G G G G G G G G G G G G T T T G T T G T A G G T T T T T T T G T T T T T T T T T T T T T T T T G T T T T G T T T G A T G A A A C C C C C C C C C G T C C C T T G G C G C G C T G C A T T T T T T T T T T C T C 1.1 -0.3 -1.1 -0.6 1.4 1.4 1.1 -1.1 -1.1 -0.6 -1.1 -1.1 0.2 -1.1 -0.6 -1.1 -1.1 0.8 -1.1 1.3 -1.1 -1.1 -0.6 1.4 -1.1 -1.1 -1.1 -1.1 -0.6 1.2 0.2 -0.3 -0.3 -0.3 1.4 -1.1 -1.1 -1.1 -1.1 -1.1 1.4 0.2 -0.6 -0.6 -0.1 -0.6 0.4 -1.1 -0.6 -0.6 -1.1 -1.1 -1.1 -1.1 -0.3 -1.1 -1.1 0.8 1.3 1.3 0.4 -0.6 -0.1 1.2 A C С C A A A C G T A T T C T T 1.1 0.8 -1.1 1.3 1.4 1.4 1.1 -1.4 1.4 0.8 -1.1 1.3 0.4 1.2 -0.1 1.2 S(b1…bk) = i=1…k W(bi , j) = 9.7 13 Классическая формула веса (log odds) Вес буквы в колонке : - подправленная частота буквы в колонке - число последовательностей - число букв , где в колонке - псевдокаунт для буквы - коэффициент, подбираемый для задачи 14 Логарифм отношения правдоподобия (logodds) • Дана последовательность , выровненная с профилем. • (1) Предположим, буквы в последовательности выбирались случайно с базовыми вероятностями. Тогда вероятность получить эту последовательность равна • (2) Предположим, буквы в последовательности выбирались в соответствии с профилем частот. Тогда вероятность получить эту последовательность равна • Выберем то предположение, для которого вероятность больше! “Принцип максимального правдоподобия” • Удобно использовать логарифм отношения • Если L > 0, то принимаем предположение (2), если L<0 – то (1) • L равно классическому весу 15 Полусекретная формула веса А.А.Миронова с соавт. (встречается в презентациях) Вес буквы в колонке : псевдокаунт нормировка частоты буквы на среднее геометрическое частот 4х букв в колонке, а не на базовую частоту; Упражнение. Проверьте справедливость этого утверждения! 16 Совсем секретная формула веса А.А.Миронова с соавт. (встречается только в коде программы GenomeExplorer) Вес буквы -мат.ожидание в колонке : в колонке - среднее квадратичное отклонение по всему выравниванию Формула отличается от предыдущей умножением на константу, свою для каждого выравнивания 17 Z-score наблюдения 18 Сравнение весов на примерах • Signals.xlsx • Классический вес может ставить большие отрицательные штрафы за редкую букву в консервативной позиции. Очень зависим от размера псевдокаунта. 19 Позиционная весовая матрица (профиль) a m G A A A a C G k T T w C w T 10 0 2 1 2 8 2 1 0 0 13 0 1 12 0 0 13 0 0 0 13 0 0 0 10 1 0 2 0 13 0 0 0 0 13 0 1 0 4 8 0 0 1 12 0 0 1 12 4 1 3 5 0 11 1 1 1 4 5 3 0 2 0 11 1.1 -1.1 orthodox -0.3 -0.6 -0.3 0.8 -0.3 -0.6 -1.1 -1.1 1.4 -1.1 -0.6 1.3 -1.1 -1.1 1.4 -1.1 -1.1 -1.1 1.4 -1.1 -1.1 -1.1 1.1 -0.6 -1.1 -0.3 -1.1 1.4 -1.1 -1.1 -1.1 -1.1 1.4 -1.1 -0.6 -1.1 0.2 0.8 -1.1 -1.1 -0.6 1.3 -1.1 -1.1 -0.6 1.3 0.2 -0.6 -0.1 0.4 -1.1 1.2 -0.6 -0.6 -0.6 0.2 0.4 -0.1 -1.1 -0.3 -1.1 1.2 1.5 -0.9 mironov -0.1 -0.5 -0.2 1.0 -0.2 -0.6 -0.7 -0.7 2.0 -0.7 -0.3 1.8 -0.8 -0.8 2.0 -0.7 -0.7 -0.7 2.0 -0.7 -0.7 -0.7 1.5 -0.5 -0.9 -0.1 -0.7 2.0 -0.7 -0.7 -0.7 -0.7 2.0 -0.7 -0.5 -1.0 0.4 1.1 -0.8 -0.8 -0.3 1.8 -0.8 -0.8 -0.3 1.8 0.2 -0.7 0.0 0.5 -0.9 1.6 -0.4 -0.4 -0.7 0.2 0.5 0.0 -0.8 0.0 -0.8 1.7 j A C G T Слайд20 Теория Поиск de novo • Область вероятного нахождения сигнала • Алгоритм • M EM E - EM • Gibbs sampler 21 Входные данные 22 Входные данные Результат 23 Expectation Maximization 1. Берем случайный фрагмент в каждой последовательности, строим выравнивание 2. Берем базовые частоты букв из дополнения 3. Строим PWM по этому выравниванию 4. По PWM Находим наилучший фрагмент в каждой последовательности 5. Повторяем 2-4 пока не сойдется (т.е. следующее выравнивание совпадет с предыдущим) 24 Multiple EM for motif Elicitation • Повторить EM много раз и выбрать заказанное число лучших мотивов 25 Gibbs Sampling • Первый шаг такой же, как в MEME: выбор выравнивания A из случайных фрагментов • Шаг состоит в удалении одного фрагмента и замене его случайным фрагментом из той же последовательности => новое выравнивание B • Если I(B) > I(A), то берем B • Если I(B) < I(A), то с вероятностью P = exp [ (I(B) – I(A)) / T ] берем B, иначе оставляем A • В начале “температура” T большая => почти все замены на худшее выравнивание B принимаются; с каждым шагом температура понижается, так что все более жесткие условия на то, чтобы взять B. • “Тепловой отжиг” 26 Теория Недостатки PWM и других подходов с весом выравнивания • Предположение о независимости букв в колонках. (Есть работы о том, что часто это близко к реальности) • Учет колонок даже тех, в которых фактически нет значимого сигнала (есть работа, в которой предлагается способ уменьшить их роль) 27 3.Технология поиска (регуляторных?) сигналов (прокариот?) Составление обучающей выборки для искомого сигнала • Определение области поиска сигнала • промоторы прокариот: перед старт-кодоном 1го гена оперона (<100 п.н.?) • участки связывания рибосом : перед стартовым кодоном (<20 п.н.) • сайты сплайсинга : экзон-интронные границы • Поиск примеров • По статьям • По аннотациям баз данных: Genbank, Refseq, ENA и специализированных …… EcoCyc, RegDB 28 Выравнивание и уточнение сигналов • Ревизия выборки • Скачивание последовательностей с фланками из геномов • Проверка и удаление ошибочных последовательностей • Удаление дубликатов, т.к. методы очень чувствительны к перепредставленности почти одинаковых последовательностей • Выравнивание обучающей выборки по аннотациям сигналов • Выделение сигнала в скользящем окне (ранее найденные сигналы могут оказаться меньше или больше) • Составление профиля, поиск по профилю в выборке – пока не сойдется 29 4. Сервисы и базы данных • MEME – сервис со многими возможностями и локальная программа (стоит на kodomo) • The Gibbs Motif Sampler (http://ccmbweb.ccv.brown.edu/gibbs/gibbs.html) • Регуляторные сигнал прокариот – проект по описанию регуляции транскрипции (Д.Родионов и Co) • RegPrecise – коллекция транскрипционных факторов, сайтов и регулонов прокариот • RegPredict – средства для поиска сигналов Регулон – совокупность генов, регулируемых одним транскрипционным фактором 30 Другие • Transfac • VISTA • rVISTA • EDP и EDPnew – эукариотические подтвержденные промоторы • PePPER – прокариотические промоторы • EcoCyc • WebGeSTer, FindTerm – поиск Rho-независимых терминаторов прокариот 31 Конец 32 Не вошедшее в лекцию … 33 Как учесть зависимость позиций сигнала? Предложение: при поиске de novo найти слова, в т.ч. вырожденные, которые встречаются чаще, чем ожидалось бы в соответствии со статистической моделью Если удается найти правильные слова, то придумать правило как их использовать для поиска 34 Как найти слова под отбором? • Например, встречается ли слово GATC в геноме бактерии чаще или реже чем ожидается? • Два варианта: • Z_score: Z(GATC) = (N_obs – N_exp)/sigma_exp служит для оценки достоверности отличия иногда используется как мера отличия зависит от размера генома • Контраст: K = N_obs/N_exp можно применять при условии достоверности отличия от 1 отражает предположение о равномерности давления отбора вдоль ДНК иногда используется как мера отличия Слайд 35 Как определить ожидаемое число сайтов? • Есть разные статистические модели • Метод С.Карлина (см. след. слайд) • Для случайного независимого выбора букв Kr ≈ 1 • Если Kr > 1, то слово встречается чаще ожидаемого, Kr < 1 – реже ожидаемого. • Интерпретация затруднена. При расчете ожидаемого числа слов учитываются частоты всех его подслов, в том числе, разрывных – формула хорошо сбалансирована. • Нет хорошей статистической оценки достоверности отличия Kr от 1. 36 Оценка контраста сайта Слайд37 Алгоритм поиска коротких сигналов • Установим ограничение на длину сигнала • например, 7 • s – слово, возможно, вырожденное (например, GNNTC) • Для каждого слова s найдем базовую частоту p_s • Для каждого слова s найдем частоту f_obs(s) в области поиска • Найдем ожидаемую частоту f_exp(s) по методу С.Карлина • Оценим достоверность отличия f_obs(s) от f_exp(s) • Среди достоверно отличных s найдем слова с максимальным отношением f_obs(s)/f_exp(s) 38