Эволюционирующие искусственные нейронные сети

advertisement

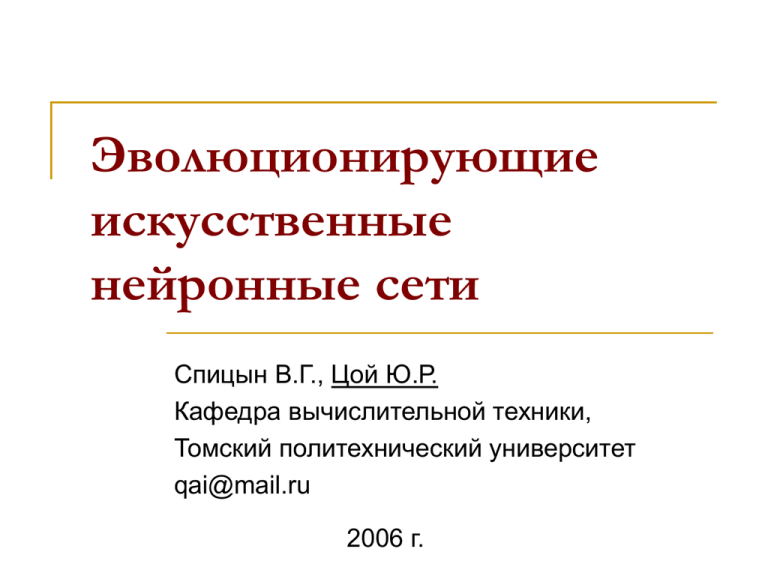

Эволюционирующие

искусственные

нейронные сети

Спицын В.Г., Цой Ю.Р.

Кафедра вычислительной техники,

Томский политехнический университет

qai@mail.ru

2006 г.

Содержание

1.

2.

3.

4.

5.

6.

7.

8.

9.

Введение

Искусственные нейронные сети (ИНС)

Эволюционные вычисления (ЭВ)

Нейроэволюционный (НЭ) подход

Задачи с качественной оценкой ИНС

Пример применения НЭ для обработки

изображений

Перспективы НЭ подхода

Конференции и журналы

Интернет-ресурсы

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

1. Введение

Многие задачи можно в общем виде

рассматривать как задачи построения

отображения: X Y, где X и Y –

соответственно пространства входных и

выходных параметров.

Примеры:

1.

Управление и принятие решений. По имеющимся данным (X)

необходимо выбрать одно из возможных действий (Y).

2.

Классификация и распознавание. Зная входные признаки (X)

объекта нужно определить принадлежность этого объекта к

одному из известных классов (Y).

3.

Аппроксимация и моделирование. Необходимо определить с

заданной погрешностью значение выходного сигнала (Y) по

имеющимся входным сигналам (X).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

2. Искусственные нейронные

сети (ИНС) (1/2)

Формальный нейрон:

x0

x1

xn

w0

w1

...

w

2

S

f

x

Сумматор

Примеры функций активации:

y

Преобразователь

y f ( S ) f ( wi xi )

i

f () – функция активации нейрона

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

2. Искусственные нейронные

сети (ИНС) (2/2)

Пример многослойной ИНС:

Выходной сигнал

(в векторной форме):

Y Y ( 2 ) f (S( 2 ) ) f ( W ( 2 ) Y (1) )

f ( W ( 2 ) f ( W (1) X ))

X

Y

Y( 2)

W( 1)

(1)

W( 2 )

ИНС может аппроксимировать любую

непрерывную функцию, если функции

активации будут нелинейными

(Колмогоров, 1956, 1957; Арнольд,

1957; Горбань, 1998).

Основные параметры

ИНС:

Структура.

Веса связей.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

3. Эволюционные вычисления (1/2)

Эволюционные вычисления (ЭВ) используют для работы

принципы наследственности, изменчивости и

естественного отбора.

Задача оптимизации:

1. «Стандартный» подход. Имеется точка в пространстве возможных

решений (пространство поиска). По некоторому правилу

координаты точки последовательно изменяются, чтобы

приблизиться к локальному (либо глобальному) экстремуму

оптимизируемой функции.

2. Эволюционный подход. Имеется n точек (популяция). В

соответствии с определенной стратегией выбирается часть этих

точек (родительские особи) и их координаты (хромосомы)

используются для генерации n новых точек (потомки).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

3. Эволюционные вычисления (2/2)

Основное преимущество ЭВ:

Представляют универсальный проблемно-независимый

подход к поиску оптимальных и субоптимальных решений.

Основные разновидности ЭВ:

1. Генетический алгоритм.

2. Эволюционное программирование.

3. Эволюционные стратегии.

4. Генетическое программирование.

Сложность настроенного эволюционного алгоритма часто имеет

порядок O(NlnN) - O(N2lnN).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(1/6)

Нейроэволюционный подход = Эволюционные

вычисления + Искусственные нейронные сети

Некоторые задачи:

- настройка весов связей ИНС;

- настройка структуры ИНС;

- одновременная настройка структуры и весов связей

ИНС;

- настройка параметров алгоритма обучения ИНС;

- фильтрация данных для обучения ИНС.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(2/6)

Настройка весов связей ИНС

X

Y

Y( 2)

W( 1)

(1)

(1)

w00

w01

…

(1)

W( 2 )

(1)

( 2)

( 2)

( 2)

wnm

w00

w01

w02

Хромосома

…

( 2)

wmk

Плюсы:

+ независимость от структуры и

параметров ИНС;

+ отсутствие необходимости в

обучающей выборке.

Минусы:

- трудность «тонкой» настройки весов;

- требования к объему памяти;

- проблема конкурирующих решений.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(3/6)

Проблема конкурирующих

решений (competing

conventions problem, Whitley et

al., 1990)

Также известна как проблема

перестановок (permutations problem,

Saravanan, Fogel, 1995).

Считается, что случайная

рекомбинация идентичных ИНС

приведет к разрушению имеющихся

«хороших» НС.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(4/6)

Настройка структуры ИНС

Плюсы:

+ возможность автоматического поиска

топологии ИНС;

+ независимость от характеристик

функции активации нейронов.

Структура ИНС

Хромосома

Минусы:

- сложность оценки структуры ИНС;

- сложность организации поиска

топологии ИНС.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(5/6)

Настройка структуры ИНС (продолжение)

Способы кодирования информации о структуре ИНС:

1. Прямое кодирование (direct encoding). Пример: список связей,

матрица смежности и др.

2. Косвенное кодирование (indirect encoding).

2.1. Кодирование параметров (например, количество слоев и

нейронов).

2.2. Использование специализированных грамматик.

2.2.1. Эволюция грамматических правил.

2.2.2. Эволюция последовательности использования правил.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

4. Нейроэволюционный подход

(6/6)

Одновременная настройка весов и

структуры ИНС

X

Y

Y( 2)

W( 1)

(1)

w00

…

(1)

(1)

( 2)

wnm

w00

…

W( 2 )

( 2)

wmk

структура

Хромосома*

* Хромосома представлена схематично

Плюсы:

+ независимость от структуры и

параметров ИНС;

+ отсутствие необходимости в

обучающей выборке;

+ возможность автоматического поиска

топологии ИНС.

Минусы:

- трудность «тонкой» настройки весов;

- требования к объему памяти.

- сложность организации поиска

топологии ИНС.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

5. Задачи с качественной оценкой

ИНС (1/4)

НС преобразование:

Y F (X )

«Стандартное» обучение ИНС с учителем использует обучающую

выборку: множество пар векторов ( X , Y ) . Для подстройки

весов связей ИНС используется информация о расхождении

реального Y и требуемого Y выходных сигналов.

1

Типичная оценка ИНС: E

N

N

2

(

Y

Y

)

i i

i 1

Некоторые проблемы использования обучающей выборки:

1.

Необходимость переформулирования исходной задачи.

2.

Сложность определения компонент «эталонных» выходных

векторов Y .

3.

Большинство обучающих алгоритмов предполагают

дифференцируемость функции оценки ИНС.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

5. Задачи с качественной

оценкой ИНС (2/4)

Предлагается использование приближенной, интегральной

оценки ИНС, отражающей внешние, качественные аспекты ее

функционирования.

Будем называть оценку ИНС качественной неполной оценкой

или, коротко, качественной оценкой, если эта оценка

позволяет с требуемой точностью оценить качество

функционирования ИНС, но при этом ее значения

недостаточно для подстройки весов связей ИНС с

использованием градиентных алгоритмов.

Примеры качественной оценки:

1.

Время поддержания стабильности системы управления.

2.

Успешность действий интеллектуального агента.

3.

Качество (информативность и т.д.) обработанных данных.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (1/5)

Используется локально-адаптивный подход:

Каждый пиксель изображения обрабатывается в

соответствии с характеристиками пикселей в его

окрестности.

Преобразование яркости в векторном виде:

L* T (Ω),

Ω {Zij }, i 1,2,..., n, j 1,2,..., m,

Zij – вектор характеристик пикселя на

пересечении i-й строки и j-го

столбца изображения

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (2/5)

Рассматривается попиксельная обработка изображений.

m( x , y )

D( x , y )

ИНС

mG

Вход ИНС (обучение):

L* ( x, y ) - средняя яркость в окрестности 3х3;

- дисперсия в окрестности 3х3;

- средняя яркость на всем изображении.

Оценка ИНС: средняя оценка качества обработанных изображений.

L( x , y )

~

D( x , y )

~

m

( x, y )

ИНС

Вход ИНС (тестирование):

- яркость пикселя (x,y);

L* ( x, y )

- приближенная дисперсия локальной яркости;

- приближенное среднее локальной яркости.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (3/5)

Двухэтапная обработка изображений:

1 этап. НС обработка с использованием локальных характеристик

(среднее и дисперсия яркости).

2 этап. Автовыравнивание уровней.

Пример:

Исходное изображение

1 этап, окрестность 5х5

2 этап

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (2/5)

Сравнение различных алгоритмов для 1-го этапа обработки:

Исходное изображение

Автоконтраст

НС обработка

Нижнее исходное изображение взято из работы Woodell G.A., Jobson D.J., Rahman Z., Hines G.D. Enhancement of

imagery in poor visibility conditions // Sensors, and Command, Control, Communications, and Intelligence (C3I)

Technologies for Homeland Security and Homeland Defense IV, Proc. SPIE 5778, 2005. Далее (Woodell et al., 2005).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (4/5)

Сравнение с алгоритмом Multi-Scale Retinex (MSR) (Woodell et al., 2005):

Двухэтапная

обработка с

локальными

характеристиками

Multi-Scale

Retinex

(MSR)

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

6. Пример применения НЭ для

обработки изображений (5/5)

L( x , y )

~

D( x , y )

~

m

( x, y )

Некоторые из обученных ИНС могут использоваться в качестве

детектора края с сохранением части тоновой информации

12,367

*

при точном вычислении локальных характеристик. Усиление

L ( x, y )

0,211

границ достигается посредством настройки параметра а

функции активации нейронов:

-13,033

f (S )

a = 2,

окрестность 3х3

1

1 exp( aS )

a = 5,

окрестность 3х3

Исходные изображения взяты из работы (Woodell et al., 2005).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

7. Перспективы НЭ подхода (1/2)

НЭ является унифицированным подходом к

решению широкого спектра задач классификации, аппроксимации, управления,

моделирования, диагностики, распознавания и др.

Использование НЭ подхода целесообразно,

если существующие аналитические методы не позволяют получить приемлемое

решение при разумных затратах ресурсов.

Развитие НЭ подхода во многом зависит от полученных

результатов в области ИНС, эволюционных вычислений,

нечеткой логики, теории сложных систем, биологии и ряда

других направлений исследований.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

7. Перспективы НЭ подхода (2/2)

Некоторые задачи, которые потенциально можно решить с

использованием НЭ:

1.

Создание универсальных адаптивных обучающихся

систем обработки данных.

2.

Исследование развития интеллектуальных способностей

агентов в моделях искусственной жизни и эволюционном

моделировании.

3.

Синтез таблицы правил клеточных автоматов для

моделирования и предсказания нелинейных процессов с

хаотической динамикой.

4.

Разработка новых концепций и подходов к созданию

интеллектуальных систем через их (само)развитие

(например, на основе концепции нейродарвинизма Дж.

Эдельмана).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

8. Конференции и журналы (1/2)

Конференции:

IEEE International Joint Conference on Neural Networks (IJCNN)

(http://www.wcci2006.org).

IEEE Congress on Evolutionary Computation (CEC)

(http://www.wcci2006.org).

International Conference on Artificial Neural Networks (ICANN)

(http://www.icann2006.org).

Genetic and Evolutionary Computation Conference (GECCO)

(http://www.sigevo.org/).

Parallel Problems Solving from Nature (PPSN)

(http://ppsn2006.raunvis.hi.is).

Нейроинформатика (http://ni.iont.ru/).

Национальная конференция по искусственному интеллекту (КИИ)

(http://www.raai.org/).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

8. Конференции и журналы (2/2)

Журналы:

IEEE Transactions on Neural Networks

(http://ieee-cis.org/pubs/tnn/).

IEEE Transactions on Evolutionary Computation

(http://ieee-cis.org/pubs/tec/).

Evolutionary Computation (http://www-mitpress.mit.edu).

«Нейрокомпьютеры: разработка и применение»

(http://www.radiotec.ru/catalog.php?cat=jr7).

Электронный журнал «Нейроинформатика»

(http://ni.iont.ru/Journal/Polojenie.htm).

«Интеллектуальные системы»

(http://intsys.msu.ru/magazine/).

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

9. Интернет-ресурсы (1/2)

IEEE Computer Intelligence Society:

http://ieee-cis.org/

Special Interest Group for Genetic and Evolutionary

Computation (SIGEVO):

http://www.sigevo.org/

Российская ассоциация нейроинформатики:

http://ni.iont.ru/

Российская ассоциация искусственного интеллекта:

http://www.raai.org/

Neural Networks Research Group:

http://nn.cs.utexas.edu/

Страница З. Яо (Xin Yao):

http://www.cs.bham.ac.uk/~xin

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

9. Интернет-ресурсы (2/2)

Страница В.Г. Редько:

http://www.iont.ru/staff/rvg/index_rus.php

Страница С.А. Терехова:

http://alife.narod.ru/

Citeseer:

http://citeseer.ist.psu.edu/

(БНБ) Большая Научная Библиотека:

http://sci-lib.com/full.php

Библиотека ДВО СО РАН:

http://chaos.dvo.ru/lib.htm

Поиск книг:

http://www.poiskknig.ru/

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

Спасибо за внимание!

http://qai.narod.ru/Publications/talk.pps

По материалам статьи:

http://ni.iont.ru/Journal/N1/TsoySp.pdf

Использованы карикатуры с сайта

http://www.elkin.ru

Приложение 1. Оценка качества

изображений.

Оценка качества обработанного изображения:

256

a * b m 256 exp( H )

f

, H li log li ,

a *b

192

i 1

m – количество пикселей на краях на обработанном

изображении, a и b – соответственно ширина и

высота изображения в пикселях, li – доля пикселей

обработанного изображения с i-м уровнем яркости.

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.

Приложение 2. Приближенное

вычисление локальных характеристик

изображения

Рассматривается прямоугольная окрестность пикселя (x,y),

ограниченная точками (j1 ; i1) и (j2 ; i2), причем i2 i1, j2 j1. .

Предполагая плавное изменение яркости на изображении, а также

малый размер окрестности, можно свести вычисления локальных

характеристик по всем пикселям окрестности к вычислению по

произвольной строке или столбцу окрестности.

Для более точных вычислений используются следующие формулы:

~

m

xy

~ (y ) m

~ ( x ) mG

m

x

y

3

~

Dxy

~

~

Dx ( y ) D y ( x )

2

.

где mG - средняя яркость на всем изображении, y [i1; i2 ], x [ j1 ; j2 ]

Спицын В.Г., Цой Ю.Р. Эволюционирующие искусственные нейронные сети.

IV Всероссийская конференция «Молодежь и современные ИТ», Томск, 28 февраля – 2 марта, 2006.