КОЛИЧЕСТВО ИНФОРМАЦИИ КАК МЕРА УМЕНЬШЕНИЯ НЕОПРЕДЕЛЕННОСТИ ЗНАНИЯ

advertisement

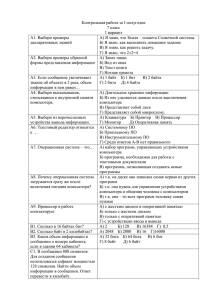

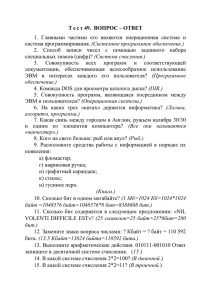

КОЛИЧЕСТВО ИНФОРМАЦИИ КАК МЕРА УМЕНЬШЕНИЯ НЕОПРЕДЕЛЕННОСТИ ЗНАНИЯ 1-й подход Неизмеряемость информации в быту (информация как новизна) КАК ЕЁ ИЗМЕРИТЬ? Вы получили какое - то сообщение, например, прочитали статью в любимом журнале. В этом сообщении содержится какое-то количество информации. Как оценить, сколько информации Вы получили? Другими словами, как измерить информацию? Можно ли сказать, что чем больше статья, тем больше информации она содержит? ЧТО ЗНАЛ ДО ЭТОГО? Разные люди, получившие одно и то же сообщение, по-разному оценивают его информационную ёмкость, то есть количество информации, содержащееся в нем. Это происходит оттого, что знания людей о событиях, явлениях, о которых идет речь в сообщении, до получения сообщения были различными. Поэтому те, кто знал об этом мало, сочтут, что получили много информации, те же, кто знал больше, могут сказать, что информации не получили вовсе. Количество информации в сообщении, таким образом, зависит от того, насколько ново это сообщение для получателя. СУБЪЕКТИВНОСТЬ В таком случае, количество информации в одном и том же сообщении должно определяться отдельно для каждого получателя, то есть иметь субъективный характер. Но субъективные вещи не поддаются сравнению и анализу, для их измерения трудно выбрать одну общую для всех единицу измерения (к примеру, критерий оценивания знаний). Таким образом, с точки зрения информации как новизны, мы не можем однозначно и объективно оценить количество информации, содержащейся даже в простом сообщении. Что же тогда говорить об измерении количества информации, содержащейся в научном открытии, новом музыкальном стиле, новой теории общественного развития. ИНФОРМАЦИЯ, КАК НОВИЗНА Когда информация рассматривается как новизна сообщения для получателя, не ставится вопрос об измерении количества информации. 2-й подход (ВЕРОЯТНОСТНЫЙ) Измерение информации в теории информации (информация как снятая неопределенность) Информация в сообщении Информацию, которую получает человек, можно считать мерой уменьшения неопределенности знаний. Если некоторое сообщение приводит к уменьшению неопределенности наших знаний, то можно говорить, что такое сообщение содержит информацию. УМЕНЬШЕНИЕ НЕОПРЕДЕЛЁННОСТИ ЗНАНИЯ Пусть у нас имеется монета, которую мы бросаем на ровную поверхность. С равной вероятностью произойдет одно из двух возможных событий – монета окажется в одном из двух положений: «орёл» или «решка». Возможные события Произошедшее событие События равновероятны, если при возрастающем числе опытов количества выпадений «орла» и «решки» постепенно сближаются. Перед броском существует неопределённость нашего знания (возможны два события), а после броска наступает полная определённость. Неопределённость нашего знания уменьшается в два раза, так как из двух возможных равновероятностных событий реализовалось одно. из какой трубы упадут шары: из А или В? Эти события равновероятны! Существует неопределенность В А ? ШАР ВЫПАЛ ИЗ ТРУБЫ НАСТУПИЛА ПОЛНАЯ ОПРЕДЕЛЕННОСТЬ: ШАР ВЫПАЛ ИЗ ТРУБЫ «А» - получили количество информации, равное 1 биту За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность знания в два раза. Эта единица называется БИТ А В БИТ и БАЙТ бит (англ. binary digit - двоичная цифра); байт (byte - байт ); УМЕНЬШЕНИЕ НЕОПРЕДЕЛЁННОСТИ ЗНАНИЯ При бросании равносторонней четырехгранной пирамиды существуют 4 равновероятных события. При бросании шестигранного игрального кубика существует 6 равновероятных событий. КАК ПРОИЗНОСИТЬ Обычная форма родительного падежа (нет числительного): битов, байтов, килобайтов, (пример из другой системы – килограммов) Счетная форма используется в сочетании с числительными: 8 байт, 16 килобайт (пример из другой системы – 16 килограмм) Счетная форма является разговорной А А если имеются три трубы? Количество возможных событий равно 3 ? С В Чему будет равно количество информации в сообщении о том, что шар выпал из какой либо трубы? А Необходимо установить связь между Количеством возможных событий и количеством информации ? С В СВЯЗЬ МЕЖДУ КОЛИЧЕСТВОМ ВОЗМОЖНЫХ РАВНОВЕРОЯТНЫХ СОБЫТИЙ И КОЛИЧЕСТВОМ ИНФОРМАЦИИ Для нашего случая, когда шар выпал из трубы «А», сообщение об этом содержит количество информации Где: N – количество возможных событий, I – количество информации. Ральф Винтон Лайон Хартли Научный подход к оценке сообщений был предложен в 1928 году I = log2 N – формула Хартли КОЛИЧЕСТВО ВОЗМОЖНЫХ СОБЫТИЙ И КОЛИЧЕСТВО ИНФОРМАЦИИ Задача. В рулетке общее количество лунок равно 128. Какое количество информации мы получим в зрительном сообщении об остановке шарика в одной из лунок. Дано: N = 128 i-? Решение: 2i = N 2i = 128 27 = 128 i = 7 бит Ответ: i = 7 бит Формула Шеннона По этой формуле вычисляется количество информации для событий с различными вероятностями Клод Э́лвуд Ше́ннон N – количество возможных событий - вероятности отдельных событий ПРИМЕР В закрытом ящике имеется 8 черных шаров и 24 белых. Рассчитать вероятность взятия шаров и количества полученной при этом информации. РЕШЕНИЕ: 3-й подхлд (Алфавитный) Человек по-разному может оценить количество информации, полученное в сообщении. Это зависит от меры незнания (неполноты знания). С получением информации неполнота знания уменьшается. Ее называют неопределенностью Измерим неопределенность – измерим информацию Если научиться измерять неопределенность, то количество информации I, содержащееся в сообщении, можно будет определить по формуле: I=N–K Где: N – начальная неопределенность; K – конечная неопределенность Алфавит, как средство хранения и передачи информации Алфавит русского языка содержит 32 символа m = 32 m – объём алфавита Количество сообщений зависит от длины слов алфавита При длине слова в два символа количество сообщений (возможных комбинаций) N равно 32² = 1024 Это выражение неудобно использовать, т.к при двух независимых источниках сообщений общее количество информации будет равно: N= * Общее количество информации Оно должно состоять из суммы количеств информации и быть прямо пропорционально числу символов в сообщении (длине слова). Поэтому за количество информации берут логарифм числа возможных сообщений Если все символы в алфавите встречаются одинаково часто Тогда один символ такого алфавита несет максимальную информацию, равную I max = log232 = 5 (бит) НА ПРАКТИКЕ ВСЕ НЕ ТАК Во всех разговорных языках одни буквы встречаются часто, другие реже К примеру, на 1000 букв приходится следующее количество повторений: Русский язык Английский язык О 110 E 131 Е 87 T 105 А 75 F 86 И 75 O 80 Т 65 N 71 Н 65 R 68 Андрей Андреевич Марков Всемирно известный ученый в области математического анализа и теории вероятности; Математический аппарат марковских случайных процессов и марковской цепи играет важную роль при исследовании многих явлений в науке и технике. Шахматист, фотограф, конструктор, математик, литературовед. Автор автоспуска – устройства в фотоаппарате «МАРКОВСКАЯ» ЦЕПЬ Это «марковский» процесс, рассматриваемый как последовательность случайных событий, вероятности в котором не зависят от того, как данный процесс протекал в прошлом. СЛЕДСТВИЕ ИЗ «МАРКОВСКИХ» ЦЕПЕЙ Поскольку использование различных элементов сообщения не равновероятно, то количество информации в сообщении уменьшается, причем это уменьшение будет тем более быстрым, чем большее число элементов будет охватываться. Для одного элемента количество информации будет равно 4,39 бита Для двух – 3,52 бита Для трех – 3,05 бита При восьми – 2,0 бита И далее остается неизменным Таким образом, реальные сообщения при одинаковой информативности обладают избыточностью в элементах по сравнению с оптимальными сообщениями. Коэффициент избыточности русского языка составляет 0,6 Избыточность приводит: - К увеличению времени передачи; - позволяет восстанавливать отдельные слова и фразы; - Повышает надежность каналов передачи информации (увеличивается помехоустойчивость) . ABBYY FineReader Professional Edition 8.0 Cистема оптического распознавания текста. Она использует алгоритм марковских цепочек, позволяющий создавать довольно длинные "осмысленные" фразы из «разрушенного» текста Технический подход Информация как сообщения в форме знаков или сигналов, хранимые, передаваемые и обрабатываемые с помощью технических устройств Исходное сообщение на языке в машинном представлении (КОИ - 8) Количество информации в символах в битах в байтах рим 11110010 11101001 11101101 3 24 3 мир 11101101 11101001 11110010 3 24 3 миру мир! 11101101 11101001 11110010 11110101 00100000 11101101 1110101 11110010 00100001 9 72 9 (** */ 00101000 00101010 00101010 00100000 00101010 00101111 6 48 6 КОМПЬЮТЕРНЫЙ ПРАКТИКУМ Перевод единиц измерения количества информации Задание 2.1. (стр. 108) С помощью программы Advanced Converter 2.9.5 выполнить перевод единиц измерения количества информации . КОМПЬЮТЕРНЫЙ ПРАКТИКУМ Перевод единиц измерения количества информации Задание 2.2. (стр. 110) С помощью программы Wise Calculator выполнить перевод единиц измерения количества информации . _ байт = байт _ бит;= _______ бит; а) 5 Кбайт = _______ _ КбайтКбайт = _ байт = 12 288 б) ______ = _____ байтбит; = 12 288 бит; _ КбайтКбайт = _ байт = 213 бит; в) ______ = ______ байт = 213 бит; _ Гбайт = 1536 Мбайт = _= Кбайт; г) ___ Гбайт = 1536 Мбайт ______ Кбайт; 2_ байт =байт 2_ бит. д) 512 Кбайт = 2______ = 2______ бит.