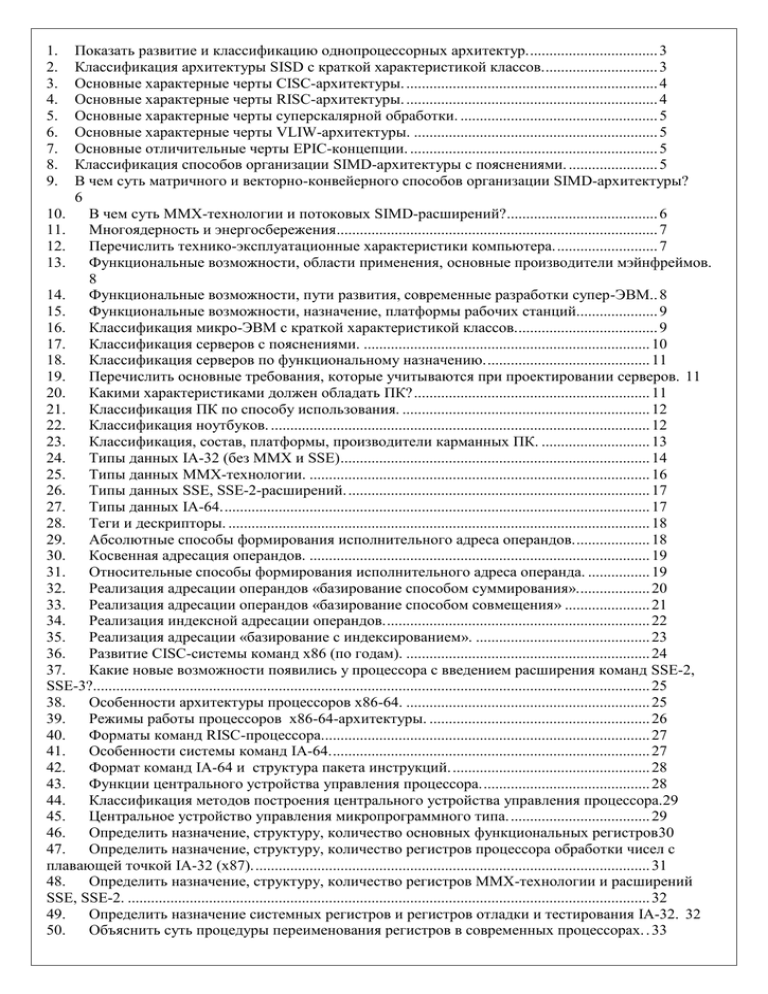

Шпоры(новые)

advertisement