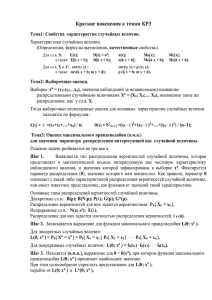

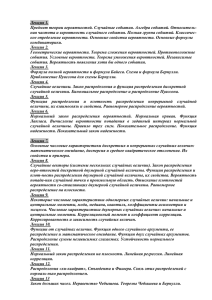

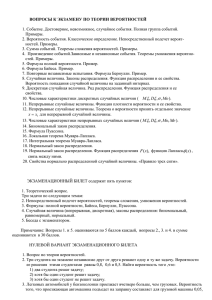

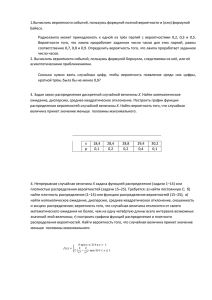

Методичекские рекомендации по дисциплине Б2.Б.5 ТЕОРИЯ ВЕРОЯТНОСТЕЙ И МАТЕМАТИЧЕСКАЯ СТАТИСТИКА по направлению

advertisement