Практика 3

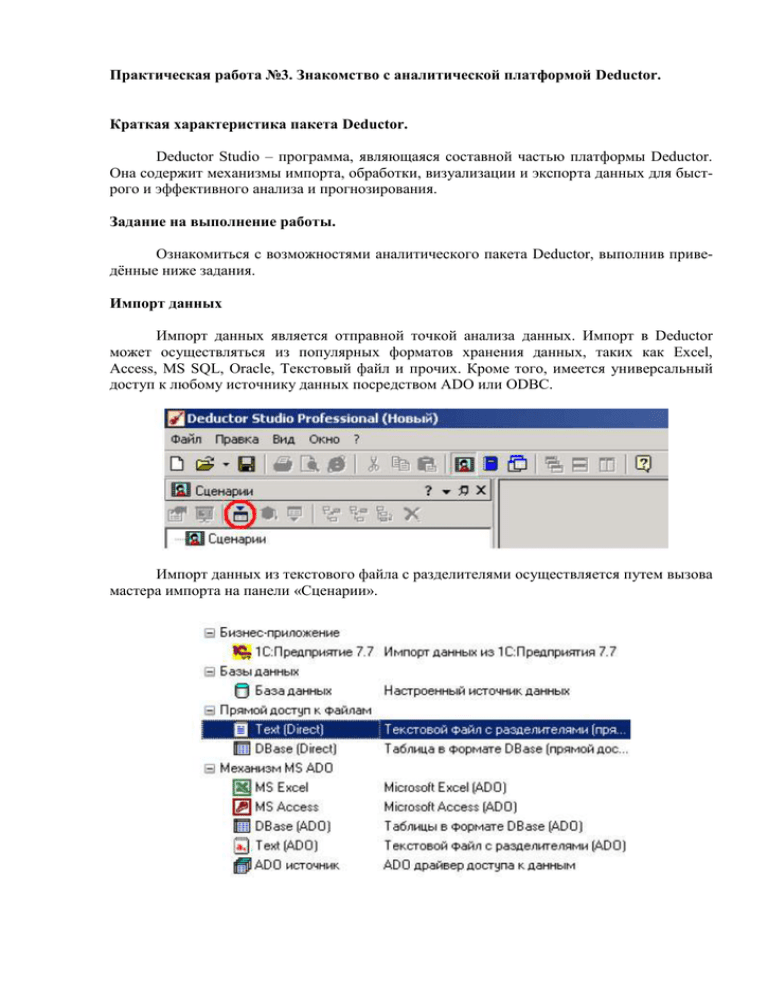

advertisement