Функция конкурентного сходства

advertisement

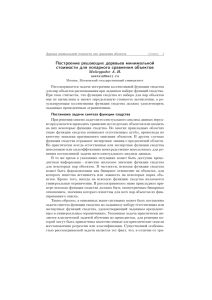

42 ФУНКЦИЯ КОНКУРЕНТНОГО СХОДСТВА В РАСПОЗНАВАНИИ ОБРАЗОВ1 Загоруйко Н.Г.2, Борисова И.А. 2, Дюбанов В.В. 2, Кутненко О.А. 2 2Институт Математики СО РАН. Пр. Коптюга, 4, г. Новосибирск, 630090, Россия Предлагается единый подход к построению методов Интеллектуального анализа данных (ИАД) или Data Mining. Он основан на использовании человеческих способов оценки сходства и различия. Кратко описаны методы ИАД, основанные на этом подходе. Приводятся примеры решения модельных и реальных задач этими методами. Введение При решении задач распознавания образов часто используются решающие правила, основанные на сравнении степени «похожести» контрольного объекта на эталоны конкурирующих образов. В литературе описаны десятки различных мер сходства [1]. Как правило, в этих мерах сходство носит абсолютный характер и зависит только от расстояний до эталонов. Но легко убедиться, что человеческое восприятие похожести носит относительный и конкурентный характер. Чтобы ответить на вопросы типа «близко-далеко», «похож не похож» нужно знать ответ на вопрос «По сравнению с чем?». Мало вероятно, что при решении разных задач распознавания человек переходит от одной основы к другой. Скорее всего, он пользуется некоторой универсальной психофизиологической функцией, отвечающей за его ориентацию в окружающей среде. В данной работе мы предлагаем рассмотреть следующую гипотезу: Основная функция, используемая человеком при решении задач распознавания, состоит в определении сходств и различий. Покажем, что мера, воспроизводящая человеческий механизм оценки сходства, позволяет строить единообразные алгоритмы распознавания, инвариантные к степени обусловленности и к виду распределений объектов в пространстве характеристик. Функция конкурентного сходства В правиле ближайшего соседа (kNN) расстояния r1и r2 до эталонов двух ближайших образов сравниваются в шкале порядка. Мы предлагаем меру конкурентного сходства в абсолютной шкале: F=(r2-r1)/(r2+r1) (1) и называем ее функцией конкурентного сходства или FRiS-функцией (от Function of Rival Similarity). Значение FRiSфункции F меняется в пределах от +1 до -1. Если контрольный объект Z совпадает с эталоном первого образа, то r1=0 и F=1. При расстояниях r1=r2 значения F=0, что указывает на границу между образами. При решении задачи распознавания в условиях, когда есть возможность оценивать дисперсии di и dj распределений конкурирующих образов, нужно пользоваться нормированными расстояниями до их эталонов: Ri=ri/di и Rj=rj/dj. В результате нормированная функция конкурентного сходства имеет следующий вид: Fi=(Rj-Ri)/(Rj+Rj) (2) Дополнительно отметим, что человек оценивает сходство и различие по нелинейному закону. При малых изменениях свойств объектов он считает, что объекты одинаковы, затем при увеличении изменений человек начинает замечать эти различия, и при достижении некоторого порога различий считает объекты разными. Чтобы придать FRiS- ____________________________________________ 1 Работа выполнена при поддержке РФФИ, Грант 05-01-00241 43 функции такие нелинейные свойства, преобразуем формулу (2) к следующей форме: F=1 – 2x, where x=R1(R1+R2) (3) Добавив к функции F величину w=bSin(4πx), получим: F=1-2x+w (4) Ограничим изменения коэффициента b пределами (0-0,14). При b=0 мы будем иметь зависимость, описываемую формулой (2). Если взять b> 0,14 величина сходства может выйти за пределы от +1 до -1, что не приемлемо. На рис.1 показаны варианты функции сходства при разных значениях параметров b и d. 1 0,8 0,6 0,4 Ряд1 0,2 Ряд2 0 1 0, 9 0, 8 0, 7 0, 6 0, 5 0, 4 0, 3 0, 2 0 -0,4 Ряд3 0, 1 -0,2 Ряд4 -0,6 -0,8 -1 Рис.1. Вид функции сходства при разных значениях параметров b и d. Ряд 1: b=0, d1=d2. Ряд 2: b=0.14, d1=d2. Ряд 3: b=0, d2=3d1. Ряд 4: b=0.14, d2=3d1. состав первого кластера и из дальнейшего рассмотрения исключаются. На остальных объектах первого образа выполняются те же процедуры. В итоге все объекты первого образа разделятся на кластеры со своими эталонами. Затем таким же способом формируются кластеры и для всех других образов. Итогом работы алгоритма FRiS-Stolp является решающее правило в виде списка эталонов (столпов), которые описывают каждый образ. Первыми выбираются столпы, расположенные в центрах локальных сгустков . По этой причине при нормальных распределениях в первую очередь будут выбраны столпы, расположенные в точках математического ожидания. Если распределения полимодальны, столпы будут стоять в центрах мод. С ростом сложности распределения число столпов k будет увеличиваться. Процесс распознавания с опорой на столпы очень прост и состоит в оценке функций конкурентного сходства объекта Z со всеми столпами и выбора образа, чей столп получил максимальное значение F (см. Рис. 2). Опыт работы с FRiS-функцией показал, что она может использоваться в качестве базового элемента для решения различных задач распознавания. Построение решающих правил (алгоритм FRiS-Stolp) Для распознавания образов необходимо выбрать объекты-эталоны, c которыми будут сравниваться контрольные объекты. Выбор эталонов (столпов) делается с помощью алгоритма FRiS-Stolp. Его идея состоит в том, что все объекты первого образа по очереди назначаются эталонами. Для каждого эталона определяется сумма функций сходства F всех объектов образа с этим эталоном в конкуренции со всеми объектами других образов. Первым эталоном первого образа становится объект, набравший максимальную сумму F. Объекты, сходство которых с этим эталоном превышает заданный порог F*, входят в Рис. 2. Распознавание принадлежности объекта Z к одному из конкурирующих образов, разделенных на кластеры. Выбор информативных признаков (алгоритм FRiS-GRAD) При выборе признаков в качестве критерия информативности обычно используется количество ошибок (U) распознавания обучающей выборки в режиме скользящего экзамена. Мы предлагаем использовать в качестве критерия среднее значение функции сходства (Fs) объектов с эталонами своих образов. Преимущества этого критерия иллюстрируется результатами их экспериментального сравнения. Исходные данные состояли из 200 44 объектов двух образов в 100-мерном пространстве. Признаки генерировались так, чтобы они обладали разной информативностью. Дополнительно эта исходная таблица искажалась шумами разной интенсивности и при каждом уровне шума (от 0,05 до 0,3) алгоритмом GRAD [2] выбирались наиболее информативные подсистемы размерности n (от 1 до 22). При этом для обучения случайно выбиралось по 35 объектов каждого образа. На контроль предъявлялись остальные 130 объектов. Результаты сравнения критериев Fs и U показаны на рис. 3. 1,05 1 U 0,95 0,9 Q 0,85 Q 0,8 0,75 U 0,7 0,65 0,6 0,05 0,1 0,15 0,2 0,25 0,3 Рис. 3. Результаты обучения и распознавания по критериям U и Q при разных уровнях шумов. Тонкие линии – обучение, жирные – контроль. Результаты контроля показывают, что критерий Q обладает существенно более высокими прогностическими свойствами и помехоустойчивостью по сравнению с критерием U. В 1933 году А.Н. Колмогоров опубликовал работу [3], в которой обратил внимание на то, что, если количество потенциальных предикторов сравнимо или превышает количество наблюдаемых объектов, можно обнаружить «псевдоинформативный» набор из шумовых предикторов. Вопрос А.Н. Колмогорова о том, как отличить «пригодную» систему признаков от непригодной, не теряет своей актуальности. Использование критерия Fs позволило решить проблему Колмогорова А.Н. о пригодности признаков По обучающей таблице N*M определяется значение Fs для наилучшей подсистемы из n* признаков. Затем формируется серия случайных таблиц такого же размера N на M, и по ним находятся значения Fs для «лучших» подсистем той же размерности n*. Если величина Fs для исходной таблицы попадает в пределы значений Fs для случайных таблиц, то можно считать, что X выбранные признаки «псевдоинформативны». Они не пригодны для дальнейшего использования. Построение классификаций (алгоритм FRiS-Class) Условия использования функции сходства в задаче построения классификации отличаются тем, что принадлежность объектов выборки к тому или иному классу неизвестна. Все объекты, как-бы, принадлежат одному образу. В связи с этим, на первом этапе вводится виртуальный образ-конкурент, ближайший столп которого удален от каждого объекта выборки на фиксированное расстояние, равное R2*. В результате мы будем использовать модификацию функции сходства, которая для любого объекта ai будет равна Fi=(R2*-R1)/(R2*+R1). (5) Автоматическая классификация объектов делается с помощью алгоритма FRiSClass [4]. Его работа состоит из двух этапов. На первом этапе (FRiS-Cluster) выбираются объекты, находящиеся в центрах локальных плотностей объектов. Такие объекты становятся эталонами (столпами) кластеров. На втором этапе (FRiS-Tax) происходит процедура укрупнения кластеров в классы путем объединения некоторых соседних кластеров в один класс. Это позволяет создавать классы произвольной формы, не обязательно линейно разделимые. Каждый вариант кластеризации оценивается средним значением (Fs) функции сходства объектов со своими эталонами (столпами). При увеличении количества кластеров k значение Fs изменяется, образуя при некоторых значениях k* локальные максимумы. Оказалось, что лучшие варианты классов получаются при объединении именно k* кластеров. Это позволяет автоматизировать выбор наилучшего количества классов. 45 FRiS-Tax, который объединяет несколько кластеров в один таксон произвольной формы. Выводы Рис. 4. Примеры результатов работы алгоритма FRiSClass. Эффективность предложенного алгоритма при работе с пространствами большой размерности в сравнении с существующими алгоритмами таксономии проверялись на прикладных задачах (см. рис. 5). K-means 0,9 0,8 0,7 1. Предложенная функция конкурентного сходства может использоваться в качестве универсального ядра для алгоритмов, решающих основные задачи распознавания с любой степенью обусловленности и при любом характере распределения. 2. Использование FRiS-функции в качестве критерия информативности признаков повышает точность оценки ожидаемого риска и позволяет решать такие новые задачи, как оценка пригодности признакового пространства и автоматическое определение числа кластеров. 3. Качество решений известных задач распознавания образов с помощью FRiSфункций не уступает качеству, получаемому существующими методами. FRiS-Cluster Kmeans 0,6 Литература Forel Scat 0,5 FRiS-Tax 0,4 0,3 2 3 4 5 6 7 8 9 10 11 12 13 14 15 Рис. 5. Результаты сравнения алгоритма алгоритмов классификации. Всего в тестировании участвовало 5 алгоритмов, оперирующих понятием центра таксона. Это следующие алгоритмы: - самый популярный на западе k-means [7,8]; - Forel, делающий таксоны сферической формы [1]; - Scat, который из сферических таксонов конструирует таксоны более сложной формы [1]; FRiS-Cluster, который обеспечивает построение линейно разделимых кластеров и Ю.А. Воронин. Начала теории сходства. Изд. Вычислительного Центра СО АН СССР., Новосибирск, 1989. 120 с.. 2. Zagoruiko N.G., Kutnenko O.A., Ptitsyn A.A. Algorithm GRAD for selection a informative genetic features // Proc. International Moscow Conference on Computational Molecular Biology. June 2005, Moscow, Russia. pp. 8-9. 3. Колмогоров А.Н. К вопросу о пригодности формул прогноза, полученных статистическим путем. // Заводская лаборатория. 1933. №1. сс. 164-167. 4. Борисова И.А. Таксономия с использованием функции конкурентного сходства. Научные труды НГТУ, Новосибирск. 2007.(в печати). 5. М.И. Шлезингер. О самопроизвольном разделении образов. Изд. «Наукова думка», Киев, 1965. СС. 46-61. 6. J. MacQueen. Some methods for classification and analysis of multivariate observations.// Proceedings of the 5th Berkley Symposium on Mathematical Statistic and Probability, Vol. 1,University of California Press, 1967, pp. 281297. 7. Загоруйко Н.Г. Прикладные методы анализа данных и знаний. Изд. ИМ СОРАН, Новосибирск, 1999. 273с. 1.