О распознающей способности нейросети на нейронах с

advertisement

Доклады АН, сер. мат.физика, т. 383, №3, с.318-321, 2002.

УДК 621.391.1

Б.В.Крыжановский, академик А.Л.Микаэлян

О РАСПОЗНАЮЩЕЙ СПОСОБНОСТИ НЕЙРОСЕТИ НА НЕЙРОНАХ С

ПАРАМЕТРИЧЕСКИМ ПРЕОБРАЗОВАНИЕМ ЧАСТОТ

Реферат

Проведен анализ распознающей способности нейросети, способной хранить и

обрабатывать

информацию,

закодированную

в

виде

частотно-фазовой

модуляции.

Информативные сигналы в рассматриваемой сети передаются по межсвязям в виде

квазимонохроматических импульсов на

n

разных частотах. За основу такой сети принят

"параметрический" нейрон – обладающий кубической нелинейностью элемент, способный к

преобразованию и генерации частот в процессах параметрического четырехволнового смешения.

Показано, что с ростом числа несущих частот помехозащищенность рассматриваемой

ассоциативной памяти резко возрастает. Одновременно резко возрастает и объем нейросетевой

памяти, которая в n2 раз больше аналогичной величины в стандартной сети Хопфилда. Число

образов, которые способна сохранять такая нейросеть, может во много раз превышать число

нейронов.

На сегодня достаточно развита теория нейронных сетей [1-8], базирующихся на

формальных нейронах Маккаллока-Питса [1] и предназначенных для обработки бинарных

сигналов. Целью настоящей работы является анализ распознающей способности нейросети,

способной обрабатывать информацию, закодированную в виде частотно-фазовой модуляции.

Информативные сигналы в рассматриваемой нами сети передаются по межсвязям в виде

n

квазимонохроматических импульсов на n разных частотах { } {

k

1

, 2 , ... , n } .

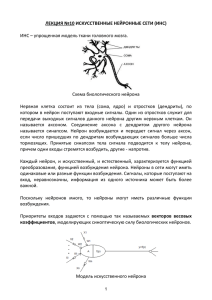

За основу такой сети принят "параметрический" нейрон – обладающий кубической

нелинейностью элемент, способный к преобразованию и генерации частот в процессах

параметрического четырехволнового смешения [9]. Схематически

i

j

k

r

предлагаемую модель нейрона можно представить как устройство, состоящее из сумматора

n

входных сигналов, набора из n идеальных частотных фильтров { } , блока сравнения

k

n

сигналов по амплитуде и n генераторов квазимонохроматических сигналов { } . Работа

k

такого нейрона осуществляется в следующей последовательности: входные сигналы

2

суммируются; суммарный сигнал пропускается через

n

параллельно соединенных

частотных фильтров; выходные сигналы с фильтров сравниваются по амплитуде; сигнал с

максимальной амплитудой инициирует генерацию выходного импульса, частота и фаза

которого совпадают с частотой и фазой инициирующего сигнала.

Имеется ряд стимулов к такого рода анализу. Во-первых, решение поставленной

задачи позволит отказаться от искусственной адаптации оптической нейросети к

амплитудно-модулированным сигналам и в полной мере использовать преимущества

оптической обработки сигналов. Во-вторых, передача по межсвязям сигналов на n разных

частотах (аналог уплотнения канала) позволит в n

2

раз уменьшить число межсвязей, т.е.

решить проблему огромного числа соединений-межсвязей, возрастающего с ростом числа

нейронов N как N

2

(в стандартных нейросетевых структурах межсвязи занимают до 98%

площади нейрокристалла). В-третьих, можно считать установленным фактом, что базовыми

функциональными элементами, отвечающими за высокоуровневую деятельность коры

головного мозга, являются так называемые корковые колонки: сильно связанные группы

нейронов, обладающие коллективными свойствами и, в принципе, способные к смешению

частот и обработке частотно-модулированных сигналов (см. библиографию в [7]).

Отдельный же нейрон генерирует единичные импульсы или пачки таких импульсов.

Поэтому нейрофизиологи задаются вопросом – как происходит обмен информацией в коре

головного мозга, на основе частотно-фазовой или амплитудно-импульсной модуляции?

Рассматриваемая здесь задача не даст ответ на этот вопрос, однако проводимый анализ

позволит оценить некоторые параметры нейросети и для случая

частотно-фазовой

кодировки сигналов. Уточним, что рассматриваемый нами "параметрический нейрон"

фактически представляет собой ансамбль тесно связанных нейронов и до некоторой степени

моделирует функционирование корковой колонки в целом, а не работу отдельного живого

нейрона.

Рассмотрим полносвязную нейронную сеть, построенную на параметрических

нейронах подобно обычной сети Хопфилда [3]. Сеть предназначена для хранения и

распознавания некоторого множества векторов {x

( m)

} , компоненты которых представляют

собой квазимонохроматические импульсы длительностью :

( m)

xj

exp(imj t i mj ) ,

j 0, N , m 0, M

(1)

3

где

mj

- фаза, обусловленная транспортными задержками в межсвязях или синаптическими

задержками, а

m j - одна из собственных частот параметрического нейрона, т.е.

n

m j {k } . Для простоты примем, что - величина, кратная всем периодам собственных

колебаний нейрона

k 2 / k , причем

k , а собственные частоты нейрона

n

i j d {k }

подчиняются условию:

только при i=d или j=d . Будем

полагать, что синаптические межсвязи также являются динамическими и организованы по

правилу Хебба [2] :

Tij

M

(m)

xj

m 1

(m)*

xj

(2)

Рассмотрим алгоритм функционирования нейрона более детально, полагая обратную

связь отсутствующей ( T

ii

0 ). Поступающие на вход i-го нейрона сигналы от других

нейронов ( X , j 0, N ) суммируются с весами T

j

ij

NETi

, образуя суммарный входной сигнал

N

Tij X j

(3)

j 0

который подается на n частотных фильтров нейрона. Амплитуда отфильтрованного сигнала

на выходе k-го фильтра этого i-го нейрона ( k 1, n ) описывается выражением:

(i )

Sk

Амплитуды S

(i )

k

NETi (t

0

) exp( i k t ) dt /

(4)

сравниваются по абсолютной величине. Решающее правило для генерации

отклика таково: если максимальное значение имеет выход с фильтра под номером k k

( k 1, n ), то нейрон испускает импульс с несущей частотой в фазе с величиной S

k

0

0

(i )

k0

0

.

Пусть нейронная сеть возбуждается неким вектором X , который в точности совпадает

с одним из записанных в память сети векторов {x

его искаженным образом:

( m)

(0)

} , например X x , или является

4

(0)

(0)

(0)

X ( 0 x0 , 1 x1 ,..., N x N )

(5)

где - последовательность независимых одинаково распределенных случайных величин,

j

принимающих значения -1 и +1 с вероятностями p и

1 p соответственно. Тогда на

следующем такте работы нейросети входной сигнал (3) на i-м нейроне будет иметь вид:

(0)

NETi xi

j

j i

M

(m)

xi

j i m 1

(m)*

xj

(0)

(0) *

x j xi

(6)

Интегрируя это выражение в соответствии с (4) для амплитуд отфильтрованных сигналов

получим:

M

(i )

(0)

(k )

S k xi (k , 0 i ) j 0 mij 0 mij exp[i (k 0 i ) ]

j i

j i m1

где ( a , b )

ab

(7)

- дельта-символ Кронекера-Капелли и введены обозначения

0 m ij i exp[i ( m i m j 0 j 0 i )]

(k )

0 mij

1, mi mj 0 j k

0, mi mj 0 j k

(8)

Анализ распознающей способности описанной выше нейросети проведем на примере

рандомизированного множества хранимых в памяти векторов {x

( m)

} полагая, что частоты

m j - статистически независимые случайные величины, с вероятностью 1 / n принимающие

одно из значений { , ,..., } , а

1

2

n

mj

- также независимые случайные величины, с

равной вероятностью принимающие значения 0 или .. В этом случае величина

(k )

0 m ij

3

принимает отличное от нуля значение с вероятностью q ( 2n 1) / n , а случайная

величина

0 m ij

с вероятностью ½ принимает значения 1. Таким образом, двойную сумму

в (7) следует рассматривать как сумму

NM

случайных независимых одинаково

распределенных величин , r 1, MN , принимающих значения: 0 с вероятностью 1 q ;

r

5

1 с вероятностями q / 2 . С учетом сказанного, из (7) для величин отфильтрованных

сигналов получим:

(0) N

xi j

1

(i )

Sk

(i )

Sk

MN

r

1

MN

r

1

в канале, где

k

0 i

(9)

exp(i k i i ) в каналах, где k 0 i

Для правильного распознавания образа i-й нейрон должен выдать сигнал x

(10)

(0)

i

. Как

видно из (9)-(10), правильный отклик нейрона может быть инициирован только сигналом из

канала (9), частота которого совпадает совпадает с частотой

инициировать только неверный отклик с отличной от

0i

(остальные каналы могут

частотой). Поэтому, первое

0i

необходимое условие для правильного распознавания состоит по определению в том, что

величина (9) должна быть больше по абсолютной величине любой из величин (10): в этом

случае канал (9) подавит все остальные каналы (10) и инициирует генерацию выходного

сигнала нейрона с “верной”частотой

0i

. Второе необходимое условие, заключается в том,

что величина в квадратных скобках (9) должна быть больше нуля: в этом случае и фаза

генерируемого сигнала совпадет с фазой величины x

(0)

i

. При одновременном выполнении

этих двух условий нейрон правильно распознает компоненту x

(0)

i

, во всех остальных

случаях произойдет ошибка распознавания. С учетом этого вычислим верхнюю границу

вероятности ошибки распознавания отдельной компоненты P . Для этого воспользуемся

i

известной техникой Чебышева-Чернова [10], согласно которой для любого

z0

справедливо соотношение:

MN

N

MN

N

Pi P j r exp z r j

1

1

1

1

qe

1

2

z

z

12 qe (1 q)

pe

MN

z

(1 p)e

z

N

(11)

6

где черта означает осреднение по ансамблям и . Минимизируя правую часть (11) по

j

r

z 0 находим, что минимум Pi достигается при z , удовлетворяющем уравнению:

pq( M 1)e

4z

2 p (1 q )e

3z

q (1 p )( M 1)e

2z

z

2(1 p )(1 q )e q (1 p )( M 1) 0

(12)

В наиболее интересном случае M 1 корень (12) можно представить в виде разложения по

степеням величины M

1

. Подставляя соответствующее выражение в (11) и ограничиваясь

только первым членом разложения по M

1

в пределе N 1 для вероятности ошибки

распознавания вектора получим:

N

2

P N exp

(1 2 p )

2 qM

Положив

k

(13)

0 для всех k 1, n мы переходим к хорошо исследованому случаю

биполярной сети Хопфилда, поскольку в этом случае

q 1

и

(m)

xi

{1,1} , и

выражение (13) совпадает с известными в литературе (см. [4-8] и ссылки в них).

Проведенное выше рассмотрение представляет интерес при n 2 . В этом случае

величину q 1 можно с достаточной для оценок точностью заменить на

1

2

2

n . Тогда

выражение (13) перепишется в виде:

Nn 2

2

2

P N exp

(1 2 p ) (1 p 0 )

4 M

(14)

Здесь, опустив промежуточные выкладки, мы учли еще и искажения частотных

характеристик, где 0 p

0

1

2

- вероятность сбоя частоты компонеты распознаваемого

вектора. Как следует из (14), нейросеть в более чувствительна к сбоям фазы, чем к сбоям

частоты. Полученное неравенство устанавливает верхнюю границу для средней вероятности

ошибки в рассматриваемой нами нейронной сети с параметрами ( N ; M ; n; p; p ) . С

0

ростом N эта граница сходится к нулю всякий раз, когда величина M как функция от N растет

медленнее, чем

7

2

M Nn

2

(1 2 p ) (1 p 0 )

2

(15)

4 ln N

Согласно [4-5] это дает основание рассматривать величину (15) как асимптотически

достижимую мощность ассоциативной памяти анализируемой нами нейронной сети.

Как видим, с ростом n помехозащищенность рассматриваемой ассоциативной памяти

резко возрастает. Одновременно резко возрастает и объем нейросетевой памяти, которая в

2

n раз больше аналогичной величины в стандартной сети Хопфилда. Более того, в отличие

от сети Хопфилда, число образов M, которые способна хранить в себе такая нейросеть,

может во много раз превышать число нейронов. Отмеченные свойства обусловлены

достаточно сложной структурой нейрона, на котором построена сеть. Действительно,

подавляющее

большинство

шумовых

компонент,

возникающих

в

результате

параметрического смешения частот на входе нейрона, имеет частоты, отличные от

собственных частот динамического нейрона, и подавляется при фильтрации. В каждом из

каналов шум подавляется приблизительно в

n

2

раз, что и нашло отражение в

вероятностном распределении .

r

Резюмируем полученные выше результаты: а). введение частотных характеристик для

компонент обрабатываемых образов приводит к значительному повышению объема

нейросетевой памяти и уменьшению ошибки распознавания; б). число межсвязей в

2

результате «уплотнения каналов» можно уменьшить в n раз, не уменьшив при этом объема

памяти и не увеличив ошибки распознавания, т.е. в определенной мере решить проблему

2

N . Конечно, усложнение нейрона влечет за собой увеличение количества локальных

соединений внутри него самого. Однако, более важно то, что при этом уменьшается

количество дальних межсвязей к другим нейронам.

Работа выполнена при поддержке РФФИ (проект 01-07-90308) и программы

"Интеллектуальные компьютерные системы" (проект 4.5).

Литература:

1. McCulloch W.S.and Pitts W. //Bull.Math.Biophys.. 1943. V.5. P.115-133.

2. Hebb D.O. The Organization of Behavior. New York: Wiley, 1949.

3. Hopfield J.J. //Proc.Nat.Acad.Sci.USA. 1982. V.79. P.2554-2558.

4. McEllise R.J., Posner E.C., Rodemich E.R., Venkatesh S.S. //IEEE Trans. Inf. Theory. 1987. V.33. N.4. P. 461-482.

5. Kuh A. and Dickson B.W. //IEEE Trans. Inf. Theory. 1989. V.35. N.1. P.59-68.

8

6. Kiselev B.S., Kulakov N.V., Mikaelian A.L., Shkitin V.A.//Intern.Journ.of Opt. Computing. 1990. V.1. N.1. P.89-92.

7. Hoppensteadt F.C., Izhikevich E.M. //IEEE Tras. on Neural Nets. 2000. V.11, N3, P.734-738.

8. Kryzhanovsky B.V., Koshelev V.N., Mikaelian A.L., Fonarev A. //Optical Memory and Neural Networks. 2000.

V.9, №4, P.267-276.

9. Райтжес Д. Нелинейные оптические параметрические процессы. М.: Мир, 1987.

10. Chernov N. //Ann. Math. Statistics. 1952. V.23. P.493-507.