Количественный анализ информации в содержательных математических высказываниях Виноградова Юлия

advertisement

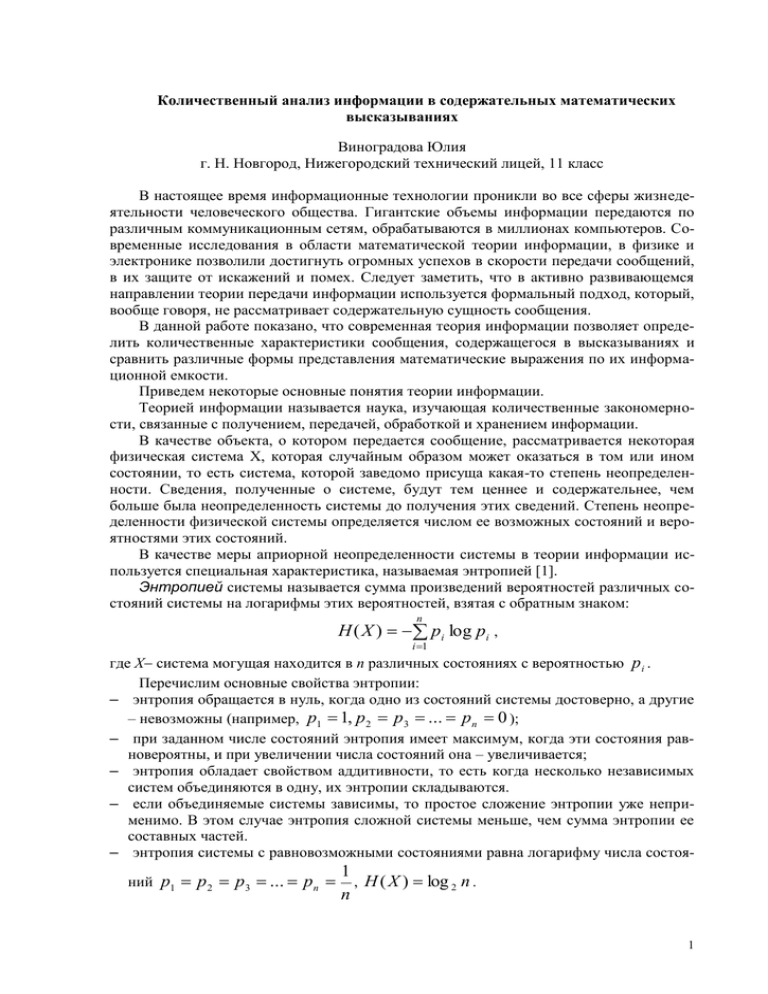

Количественный анализ информации в содержательных математических высказываниях Виноградова Юлия г. Н. Новгород, Нижегородский технический лицей, 11 класс В настоящее время информационные технологии проникли во все сферы жизнедеятельности человеческого общества. Гигантские объемы информации передаются по различным коммуникационным сетям, обрабатываются в миллионах компьютеров. Современные исследования в области математической теории информации, в физике и электронике позволили достигнуть огромных успехов в скорости передачи сообщений, в их защите от искажений и помех. Следует заметить, что в активно развивающемся направлении теории передачи информации используется формальный подход, который, вообще говоря, не рассматривает содержательную сущность сообщения. В данной работе показано, что современная теория информации позволяет определить количественные характеристики сообщения, содержащегося в высказываниях и сравнить различные формы представления математические выражения по их информационной емкости. Приведем некоторые основные понятия теории информации. Теорией информации называется наука, изучающая количественные закономерности, связанные с получением, передачей, обработкой и хранением информации. В качестве объекта, о котором передается сообщение, рассматривается некоторая физическая система Х, которая случайным образом может оказаться в том или ином состоянии, то есть система, которой заведомо присуща какая-то степень неопределенности. Сведения, полученные о системе, будут тем ценнее и содержательнее, чем больше была неопределенность системы до получения этих сведений. Степень неопределенности физической системы определяется числом ее возможных состояний и вероятностями этих состояний. В качестве меры априорной неопределенности системы в теории информации используется специальная характеристика, называемая энтропией [1]. Энтропией системы называется сумма произведений вероятностей различных состояний системы на логарифмы этих вероятностей, взятая с обратным знаком: n H ( X ) pi log pi , i 1 где Х система могущая находится в n различных состояниях с вероятностью p i . Перечислим основные свойства энтропии: – энтропия обращается в нуль, когда одно из состояний системы достоверно, а другие – невозможны (например, p1 1, p 2 p3 ... p n 0 ); – при заданном числе состояний энтропия имеет максимум, когда эти состояния равновероятны, и при увеличении числа состояний она – увеличивается; – энтропия обладает свойством аддитивности, то есть когда несколько независимых систем объединяются в одну, их энтропии складываются. – если объединяемые системы зависимы, то простое сложение энтропии уже неприменимо. В этом случае энтропия сложной системы меньше, чем сумма энтропии ее составных частей. – энтропия системы с равновозможными состояниями равна логарифму числа состояний p1 p 2 p3 ... p n 1 , H ( X ) log 2 n . n 1 Заметим, что в качестве основания логарифма входящего в выражение энтропии удобно взять двойку. Пусть в некоторый начальный момент времени неопределенность состояния системы Х описывается энтропией H 0 , затем было получено некоторое сообщение, уточняющее состояние системы и было определено новое значение энтропии H 1 . Тогда в качестве меры количества информации содержащейся в сообщении может быть взята величина I H 0 H1 . Покажем возможность применения данного понятия информации для анализа количества информации в содержательных математических высказываниях. В качестве системы Х с множеством вероятностных состояний рассмотрим человека (ученика), обладающего некоторыми математическими знаниями. Перед ним ставится математическая задача, он может решить ее, используя свои знания. Наблюдатель, например школьный учитель, имея представления о математических знаниях ученика, может вычислить информационную энтропию его состояния. После проведения занятия, т.е. после получения дополнительных сведений энтропия ученика изменится. Количество информации полученной учеником за урок будет определяться разностью энтропии. Рассмотрим конкретный пример. Пусть есть человек, который умеет считать до 100, но не умеющий складывать числа, например пятилетний ребенок. Ему предлагается следующая задача 6+8. Его ответ будет любое известное ему число. Пространство элементарных исходов опыта (ответов этого ребенка) Ω = 1,2,100. Будем полагать, что испытуемый может назвать любое число с равной вероятностью, тогда энтропия, соответствующая его знаниям будет равна 100 1 1 0 log log 2 100 6, 64 . 2 100 1 100 Предположим, что кто-то сказал ему, что эта сумма будет меньше 20, т.е. он получил некоторую информацию. Энтропия нового состояния будет определяться новым пространством элементарных исходов Ω1= 1,2...,20, 20 1 1 1 log log 20 4,32 . 2 2 20 1 20 Следовательно, количество информации, содержащейся в сообщении 0 1 log 2 100 log 2 20 log 5 2,32 . 2 Полученное количество информации носит относительный характер. Действительно для человека знающего таблицу сложения информация в проведенном сообщении равна нулю. Неправильные ответы, а, следовательно, и появления неопределенности в результатах могут быть связаны с внешними обстоятельствами. Например, человек находится в стрессовом состоянии на экзамене, в этом случае можно предположить, что пространство его ответов будет иметь вид Ω = 12, 13, 14 , 15, 16 и каждое событие происходит с некоторой вероятностью, например p12 p16 0,02, p13 p15 0,2, p14 0,56 . Энтропия в этом случае будет равна Е = 1,6229. Можно видеть, что информация о том, что сумма чисел меньше двадцати не влияет на состояние системы. 2 Заметим, что в первом случае энтропия связана с субъективными характеристиками конкретной личности, ее математическими знаниями, умениями проводить вычислений и т.д., во втором случае энтропия связана с устойчивостью работы человека при наличии помех. Ошибки, совершаемые в этом случае, будут носить случайный характер. Существует еще один вид неопределенности присутствующий при выполнении математических операций это неопределенность, связанная с погрешностью вычисляемых результатов. При численном решении задач приходится сталкиваться с тремя основными видами погрешностей [2] 1. Погрешности в исходной информации. Эти погрешности возникают в результате измерений и ими, как правило, определяется точностью результатов вычислений. 2. Погрешность ограничения метода. Существуют множество методов решений различных математических задач, которые позволяют найти точный результат за бесконечное число операций. На практике приходится ограничивать число операций, что приводит к соответствующей погрешности. 3. Погрешности округления. Эти погрешности связаны с тем, что все вычисления на компьютерах с вещественными числами выполняются с числами, имеющими конечную мантиссу, т.е. на каждом этапе вычислений компьютер округляет полученный результат. При анализе результатов любых вычислений всегда встает вопрос об оценке погрешности. В классическом подходе к этой проблеме оценивается, как правило, только величина интервала возможного изменения погрешности. Однако, известно, что реальное значение погрешности носит случайный характер [3] и, следовательно, требуется, вообще говоря, определить ее статистические характеристики: математическое ожидание, дисперсию и энтропию. Известно, что искомая величина определяется математическим ожиданием измеряемой или вычисляемой величины, дисперсия характеризует величину интервала разброс значений, а энтропия степень неопределенности результата. Из теории погрешностей известно, что при изменении порядка вычислений меняется оценка интервала погрешности. Естественно задать вопрос как при этом меняется энтропия результата. Рассмотрим изменение энтропии, связанное с погрешностью при выполнении арифметических операций. Пусть имеется число а , полученное при измерении некоторой величины с погрешностью а , а . Известно, что погрешность определяется с точностью до половины деления шкалы измерительного прибора. Можно предположить, что значение погрешности равномерно распределено на одном минимальном делении шкалы и может принимать значения 10 n 0, 1, 2,, 9, где n – задается шкалой измерительного прибора. Математическое ожидание дискретной случайной величины (среднее значение) [4] определяется выражением М Х n xi pi , где i 1 p i – вероятность по- явления случайной величины xi . В нашем случае М 4 ,5 . Дисперсия дискретной случайной величины (математическое ожидание квадрата разности между случайной 3 n величиной и ее математическим ожиданием) запишется в виде D X xi M 2 p i 1 i и n D 3,9 . Энтропия системы E pi log pi равна Е log 2 10 3,32 . i 1 Определим величину погрешности и вероятностные характеристики двух выражеВ2 а b , которые при b a тождественны с точки зрения элеменний В1 2 а тарной математики. Очевидно, что погрешность первого выражения будет В1 2 а . Число В1 можно представить в виде В1 В1 В 1 , где погрешность В1 случайная величина В1 2 а , 2 а . Математическое ожидание этой случайной величины равно М В 1 4 ,5 , дисперсия D В 3,9 , энтропия E В E a 3, 32 . 1 1 Для второго выражения оценка погрешности, также будет равна В2 2 а . Представляя второе число в виде В2 В2 В2 , получим В2 а в При сложении двух равномерно распределенных дискретных случайных величин получим следующее распределение: Рис. 1 В этом случае математическое ожидание равно М В 9 , дисперсия случайной 2 величины D B 7 ,8 и энтропия результата E B 2 ,11 . 2 2 Можно видеть, что степень неопределенности выражения B 2 меньше, чем степень неопределенности выражения B1 ( E B E В ), то есть выражение B2 содержит 2 1 больше информации о результате, чем выражение B1 . Поясним полученный результат на примере решения геометрической задачи. Дан прямоугольный треугольник (Рис.2), в котором величина катета а определена с некоторой абсолютной погрешностью а . Это условие можно записать в виде a a a, a a , то есть значение длины катета это случайная величина, которая равномерно распределена на заданном интервале. Пусть в треугольнике задан еще угол . Найти площадь этого треугольника, определить энтропию погрешности измерений. 4 Рис. 2 Погрешность измерения определяется шкалой используемой линейки и принимается равной половине деления этой шкалы. В соответствии с теорией младшего разряда [2] будем полагать, что значение погрешности может принимать с равной вероятностью любое значение из этого интервала 10 n 0, 1, 2,, 9. Тогда математическое ожидание дискретной случайной величины М 4 ,5 , дисперсия равна D 3,9 , энтропия E 3 , 32 . Второй катет прямоугольного треугольника можно найти по формуле b a tg или b a tg a tg . Площадь треугольника будет равна: 0 S 2 a b а0 а а0 tg a tg a0 tg a0 a tg a0 a tg a 2 tg 2 2 2 a0 2 tg 2 a0 a tg a 2 tg 2 2a0 atg a 2 tg . 2 Полагая a 2 a , то есть, пренебрегая величиной а 2 , получим S1 a0 atg Погрешность измерения площади S1 и для математического ожидания погрешности, имеем М 9 a0 tg , дисперсия равна D 7 ,8 а 2 tg 2 , энтропия результата Е 3,96 . Найдем площадь треугольника с помощью другой процедуры. Измерим второй катет линейкой и получим b b 0 b . Площадь треугольника в этом случае будет равна: S2 a b а0 а b0 b a0 b0 a0 b b0 a a b . 2 2 2 Погрешность измерения площади a b b0 a a b a0 b b0 a . S2 0 2 2 Значение а b a, b будет мало, поэтому при вычислении погрешности из мерения площади треугольника его можно не учитывать. Полагая угол , полу4 чим, что погрешность представляет собой сумму двух независимых случайных величин и ее энтропия будет равна ES2 2,11 . Проведенный анализ показывает, что площадь треугольника получается более определенной, если при ее вычислении используется два измерения. Интересно заметить, что полученный результат соответствует практике измерений величин. Действительно для того, чтобы повысить точность результатов измерения не- 5 которой величины и ее определенность измерения или вычисления проводят несколько раз. На основании проведенного анализа можно сделать предположение о том, что при выполнении любых формул сокращенного умножения, возведения в степень и т.д. энтропия результата будет выше по сравнению с их развернутой формой. Литература 1. Яглом А.М., Яглом И.М. Вероятность и информация. – М, 1973. 2. Ляхов А. Ф. Элементарная теория погрешностей. – М. Математическое образование №3-4, 1998, с.82-104. 3. Хемминг Р. В. Численные методы. – М. Наука, 1968; 4. Лютикас В.С. Факультативный курс по математике. Теория вероятностей. – М. 1999. 6