нейросетевая

advertisement

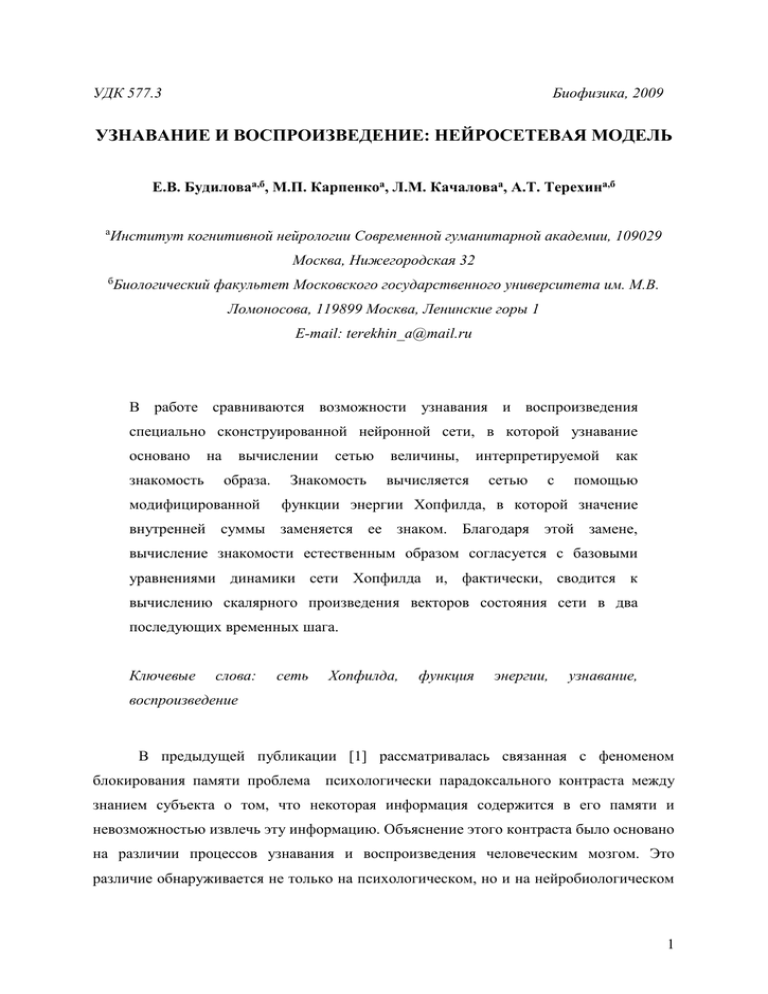

УДК 577.3 Биофизика, 2009 УЗНАВАНИЕ И ВОСПРОИЗВЕДЕНИЕ: НЕЙРОСЕТЕВАЯ МОДЕЛЬ Е.В. Будиловаа,б, М.П. Карпенкоа, Л.М. Качаловаа, А.Т. Терехина,б а Институт когнитивной нейрологии Современной гуманитарной академии, 109029 Москва, Нижегородская 32 б Биологический факультет Московского государственного университета им. М.В. Ломоносова, 119899 Москва, Ленинские горы 1 E-mail: terekhin_a@mail.ru В работе сравниваются возможности узнавания и воспроизведения специально сконструированной нейронной сети, в которой узнавание основано знакомость на вычислении образа. модифицированной сетью Знакомость величины, вычисляется интерпретируемой сетью с как помощью функции энергии Хопфилда, в которой значение внутренней суммы заменяется ее знаком. Благодаря этой замене, вычисление знакомости естественным образом согласуется с базовыми уравнениями динамики сети Хопфилда и, фактически, сводится к вычислению скалярного произведения векторов состояния сети в два последующих временных шага. Ключевые слова: сеть Хопфилда, функция энергии, узнавание, воспроизведение В предыдущей публикации [1] рассматривалась связанная с феноменом блокирования памяти проблема психологически парадоксального контраста между знанием субъекта о том, что некоторая информация содержится в его памяти и невозможностью извлечь эту информацию. Объяснение этого контраста было основано на различии процессов узнавания и воспроизведения человеческим мозгом. Это различие обнаруживается не только на психологическом, но и на нейробиологическом 1 уровне. Наблюдения над пациентами с нарушениями медиальной теменной доли (энторинальная, периринальная и парагиппокампальная кора) и/или гиппокампа приводят к выводу о том, что медиальная теменная доля в большей степени ответственна за узнавание, а гиппокамп – за воспроизведение [2, 3]. Эти наблюдения позволяют сделать и более определенное заключение о центральной роли конкретно периринальной коры в процессе узнавания знакомых образов – визуальных, слуховых, вербальных и др. [4, 5]. В опытах на обезьянах было показано, что примерно четверть нейронов периринальной коры активно отвечают на предъявление нового образа и очень слабо и кратко на предъявление уже знакомого [6]. Модель Для объяснения этого явления была построена нейросетевая модель узнавания и воспроизведения, основанная на использовании модифицированной функции энергии сети Хопфилда [7, 8], которую мы назвали «знакомостью» и определили для сети из N нейронов формулой N E ( X t ) xi (t )sign wij (t ) x j (t ) i 1 j 1 * N (1) где xi (t ) и wij (t ) - состояние нейрона i и значение синаптического веса между нейронами i и j в момент времени t . Динамика самой сети определяется правилом Мак-Каллока и Питтса [9] n xi (t 1) sign wij (t ) x j (t ) j 1 (2) а динамика синаптических весов для всех j i - правилом Хебба [10] wij (t 1) wij (t ) xi (t ) x j (t ) (3) После применения формулы (2) формула (1) приобретает вид N E * ( X t ) xi (t )xi (t 1) (4) i 1 2 т.е. знакомость равна просто скалярному произведению векторов состояний нейронов в два последующих временных шага. В [1] (см. также [11]) предложена архитектура нейронной сети, вычисляющей знакомость на основе формулы (4) и направляющей результат на дополнительный (N+1)-ый «узнающий» нейрон. При построении данной сети были сделаны два предположения относительно функционирования узнающего нейрона: (1) значения предыдущих весов связей от входных нейронов к этому нейрону забываются; и (2) нейрон N+1 находится в активном состоянии при формировании новых весов. Второе предположение можно сформулировать и иначе – вес связи от нейрона j к нейрону N+1 увеличивается, если нейрон находится в активном состоянии (независимо от состояния нейрона N+1), т.е. формула (3) для узнающего нейрона модифицируется следующим образом wN 1, j (t 1) x j (t ) (5) Следует, однако, подчеркнуть, что вопрос о существовании в реальной нейронной сети мозга вообще и в периринальной коре в частности такого типа нейронов, т.е. нейронов, обучающихся по модифицированному правилу Хебба (5), выходит за рамки данной работы. В данной работе сравниваются возможности узнавания и воспроизведения сети, предложенной в [1]. В Приложении приведены программы на языке Matlab, реализующие необходимые нейросетевые вычисления. Узнавание полностью предъявленного неискаженного образа Для каждого значения P вычисляются средние Mf и Mn и среднеквадратичные * отклонения Sf и Sn значений знакомости E для знакомых (f = familiar) и незнакомых (n = novel) образов и строится график зависимости Mf, Mn , Mf - 2.33Sf и Mn + 2.33Sn от * P. Пересечение 99% нормальных границ Mf - 2.33Sf и Mn + 2.33Sn отклонений E от средних Mf и Mn определяет максимальное значение , при котором ошибка узнавания не превосходит 1% – из рис. 1 следует, что Pmax 9000 . 3 600 500 400 Mf - 2. 33 300 *S f 200 Mf M n + 2.33Sn 100 0 Mn 0 2000 4000 6000 8000 10000 12000 P Рис. 1. Зависимость средних Mf и Mn и 99% нормальных границ Mf -2.33Sf и Mn +2.33Sn от P для сети из 700 нейронов. Результаты расчетов по программе 2 приведены в таблице 1. Таблица 1 N Pmax 100 150 200 250 300 350 400 450 500 550 600 650 700 750 800 173 459 774 1218 1667 2387 2987 3912 4677 5587 6657 7842 9087 10406 11599 На рис. 2 эти результаты представлены в виде графика вместе с регрессионной кривой Pmax=0.0185N2, аппроксимирующей зависимость Pmax от N. 4 12000 10000 Pmax 8000 6000 4000 2000 0 100 200 300 400 500 600 700 800 N Рис. 2. Зависимость Pmax от N (аппроксимирующая кривая задана формулой Pmax=0.0185N2). Узнавание искаженного образа Возникает еще один важный вопрос связанный с возможностями сети, предложенной в [1]. Выше было сказано, что ее емкость узнавания 0.0185 N 2 при больших N гораздо больше ее емкости воспроизведения 0.145 N . Однако при этом речь шла о предъявлении полного образа. Как хорошо сеть будет узнавать образ, если он предъявлен не полностью? В таблице 2 для N =700, P =100 и K =10 приведены результаты расчетов для серии значений cue, показывающих, что для узнавания с ошибкой не более 1% достаточно правильно предъявить сети примерно 15.5% информации об образе. Таблица 2 a b c d error cue 861 139 8 992 0.074 0.10 904 96 6 994 0.051 0.11 948 52 11 989 0.032 0.12 5 974 26 7 993 0.017 0.13 983 17 5 995 0.011 0.14 983 17 7 993 0.012 0.15 995 5 10 990 0.008 0.16 997 3 10 990 0.007 0.17 999 1 7 993 0.004 0.18 1000 0 8 992 0.004 0.19 1000 0 8 992 0.004 0.20 Однако при увеличении P до 4500 (т.е. до примерно половины емкости памяти узнавания сети из 700 нейронов), как видно из таблицы 3, рассчитанной при N =700 и K=1, для получения ошибки узнавания в 1% требуется правильно предъявлять около 70% образа. Таблица 3 a b c d error cue 3785 715 35 4465 0.083 0.50 4341 159 33 4467 0.021 0.60 4468 32 40 4460 0.008 0.70 4499 1 37 4463 0.004 0.80 4500 0 35 4465 0.004 0.90 4500 0 41 4459 0.005 1.00 И, наконец, при увеличении P до 9000 (т.е. почти до полной емкости памяти узнавания сети из 700 нейронов), как видно из таблицы 4, для ошибки в 1% требуется предъявлять образ практически полностью. Таблица 4 a b c d error cue 4121 4879 80 8920 0.276 0.50 5940 3060 85 8915 0.175 0.60 7393 1607 65 8935 0.093 0.70 8277 723 76 8924 0.044 0.80 8699 301 86 8914 0.022 0.90 8898 102 97 8903 0.011 1.00 6 Воспроизведение искаженного образа Для сравнения, для той же сети из 700 нейронов, были вычислены возможности воспроизведения полного образа при предъявлении его искаженного варианта. Для этого была использована программа 4, реализующая сеть Хопфилда, т.е. обучаемая в соответствии с формулой (2) и релаксирующая к аттракторному состоянию в соответствии с формулой (1). Максимальное число итераций ограничено константой Relax. В таблице 5 приведены результаты расчетов для N = 700, K = 10 и P = 10, 20, …, 120. Для каждого значения числа предъявляемых образов P и каждого значения неискаженной доли предъявляемого образа, cue = 0, 0.1, 0.2, …, 1.0, распознавания вычислялись предъявленных четыре K×P характеристики образов: доля успешности полностью воспроизведенных образов; доля образов, воспроизведенных на 99%; доля образов, воспроизведенных на 95%; доля случаев достижения аттрактора (независимо от точности воспроизведения образа) не более, чем за 15 шагов. Таблица 5 P 10 10 10 10 10 10 10 10 10 10 cue 100% 99% 95% r<16 0 0.04 0.04 0.03 0.96 0.1 0.56 0.56 0.72 0.98 0.2 0.98 0.98 1 1 0.3 1 1 1 1 0.4 1 1 1 1 0.5 1 1 1 1 0.6 1 1 1 1 0.7 1 1 1 1 0.8 1 1 1 1 0.9 1 1 1 1 P 40 40 40 40 40 40 40 40 40 40 cue 100% 99% 95% r<16 0 0 0 0 0.04 0.1 0.04 0.04 0.05 0.07 0.2 0.58 0.59 0.57 0.6 0.3 0.97 0.98 0.98 0.98 0.4 0.99 1 1 1 0.5 1 1 1 1 0.6 1 1 1 1 0.7 0.98 1 1 1 0.8 1 1 1 1 0.9 0.99 1 1 1 7 10 20 20 20 20 20 20 20 20 20 20 20 30 30 30 30 30 30 30 30 30 30 30 70 70 70 70 70 70 70 70 70 70 70 80 80 80 80 80 80 80 80 80 80 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0.02 0.4 0.97 1 1 1 1 1 1 1 1 0 0.16 0.82 1 1 1 1 1 1 1 1 0 0 0.09 0.18 0.47 0.59 0.62 0.65 0.61 0.64 0.64 0 0 0 0.04 0.19 0.36 0.41 0.37 0.38 0.4 1 0.02 0.41 0.97 1 1 1 1 1 1 1 1 0 0.16 0.82 1 1 1 1 1 1 1 1 0 0 0.02 0.28 0.74 0.93 0.95 0.99 0.97 0.99 0.99 0 0 0 0.07 0.39 0.73 0.87 0.85 0.93 0.92 1 0.02 0.4 0.95 1 1 1 1 1 1 1 1 0 0.14 0.83 1 1 1 1 1 1 1 1 0 0 0.02 0.28 0.79 0.97 1 1 1 1 1 0 0 0 0.09 0.51 0.82 0.97 0.99 0.99 1 1 0.41 0.57 0.97 1 1 1 1 1 1 1 1 0.1 0.21 0.82 1 1 1 1 1 1 1 1 0.01 0.02 0.03 0.3 0.77 0.97 0.99 1 0.99 0.99 1 0.01 0.02 0.02 0.11 0.46 0.82 0.95 0.93 0.96 0.95 40 50 50 50 50 50 50 50 50 50 50 50 60 60 60 60 60 60 60 60 60 60 60 100 100 100 100 100 100 100 100 100 100 100 110 110 110 110 110 110 110 110 110 110 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 0.99 0 0.01 0.23 0.85 0.94 0.93 0.94 0.94 0.97 0.94 0.97 0 0 0.07 0.47 0.79 0.81 0.82 0.84 0.84 0.81 0.85 0 0 0 0 0.01 0.03 0.05 0.08 0.06 0.08 0.1 0 0 0 0 0 0.01 0.01 0.02 0.02 0.03 1 0 0.01 0.26 0.89 0.99 1 1 1 1 1 1 0 0 0.1 0.57 0.96 0.99 0.99 1 1 1 1 0 0 0 0 0.02 0.12 0.27 0.39 0.44 0.54 0.62 0 0 0 0 0 0.03 0.07 0.16 0.23 0.31 1 0 0.02 0.29 0.88 0.99 1 1 1 1 1 1 0 0 0.08 0.57 0.96 1 1 1 1 1 1 0 0 0 0 0.04 0.27 0.59 0.76 0.83 0.85 0.9 0 0 0 0 0 0.07 0.26 0.46 0.59 0.65 1 0.02 0.03 0.28 0.89 0.99 1 1 1 1 1 1 0.02 0.02 0.12 0.58 0.96 1 1 1 1 1 1 0.01 0.01 0.01 0.01 0.07 0.24 0.49 0.63 0.69 0.72 0.84 0.01 0.01 0.01 0.01 0.03 0.08 0.21 0.36 0.49 0.58 8 80 90 90 90 90 90 90 90 90 90 90 90 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0.42 0 0 0 0.01 0.05 0.14 0.17 0.16 0.19 0.19 0.18 0.95 0 0 0 0.01 0.14 0.38 0.59 0.64 0.72 0.78 0.78 1 0 0 0 0.03 0.18 0.59 0.87 0.93 0.95 0.97 0.97 0.99 0.01 0.02 0.01 0.03 0.2 0.55 0.78 0.82 0.87 0.88 0.94 110 120 120 120 120 120 120 120 120 120 120 120 1 0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 0.03 0 0 0 0 0 0 0 0 0 0 0.01 0.35 0 0 0 0 0 0 0.02 0.03 0.07 0.12 0.2 0.68 0 0 0 0 0 0.01 0.08 0.19 0.33 0.4 0.48 0.6 0 0 0.01 0.01 0.01 0.02 0.06 0.12 0.24 0.31 0.41 Был проведен численный эксперимент по воспроизведению. На вход сети, обученной на P образах, предъявлялись те же образы с разной степенью случайного искажения с целью определения влияния степени искажения на возможность воспроизведения исходного образа. Из таблицы 5 Приложения видно, что полное воспроизведение образа в 99% случаев возможно при первоначальном запоминании сетью не более 50 образов, причем при запоминании 10 образов необходимо предъявить сети примерно 20% правильной информации об образе, при запоминании 20 образов – 25%, при запоминании 30 – 30%, при запоминании 40 – 40%, а при запоминании 50 – почти 100%. При большем числе первоначально запомненных образов значительная часть предъявленных даже полностью правильных образов воспроизводятся сетью с искажениями. Например, при P = 100 лишь 10% предъявленных неискаженных образов воспроизводятся полностью правильно, а при P = 120 – ни одного. 9 Если требовать, чтобы образ воспроизводился в 99% случаев лишь с точностью в 99%, то из таблицы 5 видно, что при полном предъявлении образа это возможно примерно при 75 первоначально запомненных образах, а воспроизведение с точностью в 95% возможно при 85. Таким образом, можно сделать вывод, что удовлетворительное воспроизведение искаженного образа сетью Хопфилда из 700 нейронов возможно при запоминании ею примерно половины образов, соответствующих максимальной емкости памяти воспроизведения этой сети ( 0.145 N 100 ). Например, чтобы при 50 запомненных образах образ воспроизводился в 99% случаев с точностью в 99% требуется предъявить лишь 40% правильной информации об образе (заметим, что снижение требования точности воспроизведения до 95% не позволяет, как видно из таблицы 5, далее снизить требования к точности предъявляемого образа). Поскольку ранее мы видели, что удовлетворительное узнавание искаженных образов также возможно при запоминании сетью примерно половины образов, соответствующих ее максимальной емкости памяти узнавания (половина от 0.0185 N 9000 ), то следует сделать вывод 2 о том, что и в условиях предъявления искаженных образов память узнавания значительно превосходит память воспроизведения. Отметим еще одну особенность процесса узнавания по сравнению с процессом воспроизведения образа - узнавание осуществляется всегда за два шага работы сети. На первом шаге входной образ X преобразуется в образ Y, а на втором - образ Y сравнивается с исходным образом X. Если Y достаточно близок к X, то это означает, что состояние X близко к одному из аттракторов сети, т.е. к одному из запомненных образов (конечно, при условии что число запомненных образов не превосходит 0.0185 N 2 при предъявлении неискаженного образа и хотя бы раза в два меньше этой границы при предъявлении искаженного образа). Напротив, воспроизведение образа, как правило, требует большего числа шагов – трех-шести для неискаженных знакомых образов и гораздо большего, даже неопределенно большого, числа для незнакомых (или сильно искаженных) образов. Можно даже предположить наличие в нейронной сети мозга механизмов, блокирующих дальнейший поиск в памяти предъявленного образа (и, наоборот, стимулирующих запоминание) в случае его неузнавания через два шага после предъявления. 10 Узнавание части образа До сих пор речь шла об узнавании полного образа. Однако при блокировании обычно речь идет лишь о части образа, например, фамилии человека, относительно которой есть уверенность, что она знакома, но не удается ее вспомнить. Для описания этой ситуации можно ввести понятие частичного узнавания с помощью следующей модификации формулы для знакомости (5): E * ( X t , N1 , N 2 ) N2 xi (t )xi (t 1) (8) i N1 В Приложении приведена программа 5, реализующая вычисления по этой формуле. Сеть из 700 нейронов была обучена на 50 образах по правилу Хэбба (2), после чего ей были предъявлены эти же образы со случайно искаженными значениями последних 350 нейронов и для каждого из них был получен аттракторный образ, т.е. образ, к которому сходилась сеть, эволюционирующая в соответствии с уравнением динамики (1). Затем для каждого предъявленного образа и соответствующего ему аттрактора были вычислены частичные знакомости для первой, второй, третьей и четвертой четвертей составляющих сеть нейронов. Результаты вычислений приведены в таблице 6 Приложения. Значения частичной знакомости для первых двух (неискаженных) четвертей предъявленного образа колебались вокруг величины, равной примерно 1655, а для последних двух (искаженных) – вокруг величины 515. Отсюда можно заключить, что значение частичной знакомости, т.е. знакомости, вычисленной для части образа по формуле (8), может служить надежным критерием для узнавания части образа. Что касается значений частичной знакомости для аттракторных образов, то для всех четырех частей они колебались вокруг величины 1655, т.е. все восстановленные сетью искаженные части образа имели примерно те же значения знакомости, что и неискаженные, т.е. величина знакомости может также служить критерием успешности узнавания. В таблице 5 приведены результаты расчетов по программе 4 для N = 700, K = 10 и P = 10, 20, …, 120. Для каждого значения числа предъявляемых образов P и каждого значения неискаженной доли предъявляемого образа, cue = 0, 0.1, 0.2, …, 1.0, вычислялись четыре характеристики успешности распознавания предъявленных K×P образов: доля полностью воспроизведенных образов; доля образов, воспроизведенных 11 на 99%; доля образов, воспроизведенных на 95%; доля случаев достижения аттрактора (независимо от точности воспроизведения образа) не более, чем за 15 шагов. Следующая программа предназначена для вычисления частичной знакомости, задаваемой формулой (8). В программе 5 Xfamerr – это матрица размера N Q , первые N cue строк которой совпадают с соответствующими строками матрицы Xfam, а остальным элементам случайно с равной вероятностью присвоены значения –1 или 1. В программе для каждого столбца-образа p= 1, 2, …, P матрицы Xfamerr, обозначенного X, находится соответствующий аттракторный образ Y, а затем вычисляются значения знакомости EX и EY для исходного и конечного образа, а также частичные знакомости EX1, EX2, EX3, EX4 и EY1, EY2, EY3, EY4 для исходного и конечного образа для первой, второй, третьей и четвертой частей образа. Результаты расчетов по программе 5 приведены в таблице 6. В последней строчке этой таблицы приведены также средние m и среднеквадратичные отклонения s значений знакомостей по всем образам. ЛИТЕРАТУРА 1. Будилова Е.В., Карпенко М.П., Качалова Л.М., Терехин А.Т. // Биофизика, 2008. 2. Aggleton J.P., Brown M. W. // Behavioral and Brain Science. 1999. V. 22. P. 425. 3. Norman K. A., O'Reilly R.C. // Psychological Review, 2003. V. 110. P. 611. 4. Brown M.W., Aggleton J.P. // Nat. Rev. Neurosci., 2001. V. 2. P. 51. 5. Bogacz R., Brown M.W. // Hippocampus, 2003. V. 13. P. 494. 6. Xiang J.Z., Brown M.W., // Neuropharmacology. 1998. V. 37. P. 657. 7. Hopfield J.J. // Proc. Natl. Acad. Sci. USA. 1982. V. 79. P. 2554. 8. Amit D.J. // Modelling Brain Functions, Cambridge, MA: Cambridge Univ. Press. 1989. 9. McCulloch, W. S. and Pitts, W. // Bull. Math. Biophys. 1943, V. 5. P. 115. 10. Hebb D.O. // The Organization of Behavior. New York: Wiley. 1949. 11. Bogacz R., Brown M.W., Giraud-Carrier C. // J. of Computational Neuroscience, 2001. V. 10. P. 5. 12 ПРИЛОЖЕНИЕ. Matlab-программы, реализующие нейросетевые вычисления. В программах 1- 3 использованы следующие обозначения: N – число нейронов в сети Хопфилда; P – число образов, предъявленных для обучения, а затем для узнавания; Q – число случайных образов, предъявленных только для узнавания; Xfam – матрица размера N P , состоящая из P столбцов – случайно сформированных образов, предъявленных сначала (на шаге t=0) для обучения, а затем (на шаге t=1) для узнавания; Xnov – матрица размера N Q , состоящая из Q столбцов - случайных образов, предъявленных (на шаге t=1) только для узнавания; W – матрица размера N N , вычисленная (на шаге t=0) в соответствии с правилом Хебба (2) по P образам Xfam; Yfam – матрица размера N P , состоящая из P столбцов – образов, полученных (на шаге t=1) из P образов Xfam путем преобразования в соответствии с правилом (1); Ynov – матрица размера N Q , состоящая из Q столбцов – образов, полученных (на шаге t=1) из Q образов Xnov путем преобразования в соответствии с правилом (1). В программе 3 дополнительно использованы обозначения: a – число знакомых образов, правильно отнесенных к знакомым; b – число знакомых образов, ошибочно отнесенных к незнакомым; c – число незнакомых образов, ошибочно отнесенных к знакомым; d – число незнакомых образов, правильно отнесенных к незнакомым; error – доля ошибочных узнаваний, равная сумме b и c, деленной на общее число предъявленных образов; cue – неискаженная доля информации при предъявлении искаженных знакомых образов, хадаваемых матрицей Xfamerr; 13 Xfamerr – матрица размера N Q , N P cue случайно выбранных элементов которой совпадают с соответствующими элементами матрицы Xfam, а остальные элементы сгенерированы случайно; K – число повторений серий узнавания (K желательно брать больше 1 при малых P для получения более надежной оценки ошибки error; * Программа 1. Вычисляются значения знакомости E (t ) на шаге t=1 для каждого из P + Q предъявленных знакомых и новых образов Xfam и Xnov для N =700 и P =500, 1000, 1500, …, 12000 (Q полагается равным P). N=700; i=0; for P=500:500:12000 i=i+1; Xfam=sign(rand(N,P)-.5); Xnov=sign(rand(N,P)-.5); W=Xfam*Xfam'-P*eye(N); Yfam=sign(W*Xfam); Ynov=sign(W*Xnov); for p=1:P Efam(p)=Xfam(:,p)'*Yfam(:,p); Enov(p)=Xnov(:,p)'*Ynov(:,p); end; PP(i)=P; Mf(i)=mean(Efam); Sf(i)=std(Efam); Mn(i)=mean(Enov); Sn(i)=std(Enov); end; plot(PP,Mf,PP,Mf-2.33*Sf,PP,Mn,PP,Mn+2.33*Sn); Программа 2. для 15 значений N =100, 150, 200, …, 800 методом последовательного деления отрезка пополам находит соответствующие значения Pmax(N) – корни уравнения M f - 2.33S f M n 2.33S n . n=0; for N=100:50:800 14 n=n+1; Pmin=N; Pmax=round(N^2/30); P=round((Pmin+Pmax)/2); while Pmax-Pmin>2 P=round((Pmin+Pmax)/2); Xfam=sign(rand(N,P)-.5); Xnov=sign(rand(N,P)-.5); W=Xfam*Xfam'-P*eye(N); Yfam=sign(W*Xfam); Ynov=sign(W*Xnov); for p=1:P Efam(p)=Xfam(:,p)'*Yfam(:,p); Enov(p)=Xnov(:,p)'*Ynov(:,p); end; Mf=mean(Efam); Mn=mean(Enov); f= Mf-2.33*std(Efam)- Mn-2.33*std(Enov); if f>0 Pmin=P; else Pmax=P; end; end; NN(n)=N; PP(n)=P; end; format short g; disp([NN',PP'); Программа 3. Программа предназначена для расчетов помехоустойчивости узнавания образа сетью. N=700; P=100; K=10; s99=80; for cue=0:0.01:0.2; a=0; b=0; c=0; d=0; for k=1:K Xfam=sign(rand(N,P)-.5); Xfamerr=Xfam; Xnov=sign(rand(N,P)-.5); for i=1:N for j=1:P if rand>cue Xfamerr(i,j)=sign(rand-.5); 15 end; end; end; W=Xfam*Xfam'-P*eye(N); Yfamerr=sign(W*Xfamerr); Ynov=sign(W*Xnov); for p=1:P Efamerr(p)=Xfam(:,p)'*Yfamerr(:,p); Enov(p)=Xnov(:,p)'*Ynov(:,p); if Efamerr(p) > s99 a=a+1; end; if Efamerr(p) <= s99 b=b+1; end; if Enov(p) > s99 c=c+1; end; if Enov(p) <= s99 d=d+1; end; end; end; % end of k-cycle format short g; error=(b+c)/(2*K*P); disp([a b c d error cue]); end; % end of cue-cycle Familiarity Recognition and Recollection: a Neural Network Model E.V. Budilovaa,b, M.P. Karpenkoa, L.M. Kachalovaa, A.T. Teriokhina,b a Institute of Cognitive Neurology, Modern University for Humanities, 32 Nizhegorodskaya, Moscow 109029, Russia b Department of Biology, Moscow Lomonosov State University, 1 Leninskiye gory, Moscow119899, Russia E-mail: terekhin_a@mail.ru We compare the performances in familiarity recognition and in recollection of a particular neural network which uses for recognizing some quantity interpreted as familiarity. The familiarity is calculated using a modified Hopfield energy function in which the value of the inner sum is replaced by the sign of this value. This replacement makes the calculation of familiarity compatible with the basic dynamic equations of the Hopfield network and is reduced actually to the calculating of the scalar product of the neural network state vectors at two successive time steps. Key words: Hopfield network, energy function, familiarity recognition, recollection 16