Теория вероятностей и математическая

advertisement

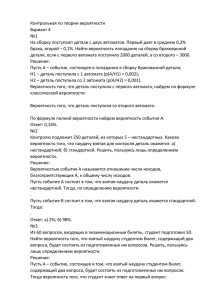

Теория вероятности

и математическая статистика

Лекции

Авторский текст:

проф. Семёнычев Валерий Константинович

Самара, 2007 г.

I. ТЕОРИЯ ВЕРОЯТНОСТИ

Моделирование – прогнозирование – принятие решений

Модели

Детерминированные

Вероятностные

Нечеткой логики

«Случайность» - непознанная закономерность

«Пирог познания»

Более сложная вероятностная модель

Более сложная детерминированная модель

Простая вероятностная модель

Простая детерминированная модель

Теория вероятностей – наука о закономерностях массовых случайных явлений (Лаплас, Пуассон, Гаусс, Бернулли, П.Л.Чебышев,

А.М.Ляпунов, А.А.Марков, А.Н.Колмогоров и др.)

Теория вероятностей математическая статистика

Курсы в ВУЗах, использующие теорию вероятности и матстатистику:

социально - экономическая статистика;

многомерные статистические методы;

эконометрика; эконометрическое моделирование;

методы социально-экономического прогнозирования;

страхование и актуарные расчеты;

теория риска и моделирования рисковых ситуаций;

маркетинг; теория массового обслуживания;

технический и фундаментальный анализ,

теория планирования эксперимента; теория надежности; теория информации

(статистическая радиотехника), статистическая физика; выборочный контроль качества и др.

Предмет теории вероятностей – явления, события, случайные величины

(одномерные, многомерные)

2

Наблюдаемые явления (результат испытаний)

Достоверные

Невозможные

Случайные

Условия: t=200 C, P- норм.

Условия t=200 C,

Испытание -

Р – норм

бросание

монеты

Вода в сосуде – жидкая

Вода в сосуде – твердая

(герб или цифра)

События A, B, C ,... несовместные, если появление одного из них исключает появление других событий в одном и том же испытании.

События образуют полную группу событий, если в результате испытаний появится хотя бы одно из них.

Испытание. Бросание монеты: A – герб, B – цифра;

Испытание. Выстрел: A - попадание, A – промах (противоположное событие).

A и A - образуют полную группу событий при одном выстреле.

Испытание. Покупают 23 лотерейных билета: событие А – выигрыш выпал на

первый билет, отсутствие выигрыша на втором; событие B – выигрыш не на первом, а на

втором билете; событие С – выигрыш обоих билетов; событие D – выигрыш не выпал ни

на один билет.

Данные события образуют полную группу событий, если проверяются два билета.

А при проверке трех билетов, что образует полную группу событий?

Испытание - игральная кость: событие A – появление числа 1, событие B 2, событие C 3, D 4, E 5, F 6. События равновероятны? (если…).

Вероятность – мера объективной возможности появления события

Классическое определение вероятности:

P( A) m

n

,

где m – число исходов испытания, которое благоприятствует появлению события A , n – общее число исходов испытания.

3

Свойства вероятности:

n

n

1. Вероятность достоверного события равна 1: P( A) 1.

0

n

2. Вероятность невозможного события равна 0: P( A) 0.

3. Вероятность случайного события есть положительное число, заключенное

между 0 и 1: P( A)

m

, 0 m n, 0 Р( А) 1.

n

«Судебная машина» Лапласа. Парадокс кавалера де Грие. Аксиоматика Колмогорова.

Теоретико-множественный подход к определению вероятности

- некоторое пространство элементарных событий, в котором с ис-

ходами испытаний связывают точки i пространства. Каждому i ставят в

соответствие pi .

Пример. Для игральной кости: i 1, 2, 3, 4, 5, 6. Событие A – подмножество пространства элементарных событий - появление четного числа (событие): A {2, 4, 6}.

Недостатки классического определения вероятности

1.Неприменимость при бесконечном числе исходов (n ).

Выход находят путем введения геометрической вероятности: как отношение мер

длин, площадей. Примеры: рулетка, попадание точки в отрезок длиной l на отрезке длиной L :

P ( A)

L

l

.

L

0

l

2. Априори трудно представить результат испытаний в виде совокупности

элементарных событий, еще труднее указать основание, позволяющее считать элементарные события равновозможными.

Тогда вводят статистическую (апостериорную) вероятность

р ( А) m ,

n

m – число исходов, в которых событие появилось, n – общее число исходов

p

P*( A)

P( A).

n

4

Алгебра событий

1.Суммой двух событий A и B называют событие ( A B) , состоящее в появлении или A , или B , или обоих (если они совместны).

Пример. Для двух выстрелов сумма событий: A – попадание при первом выстреле, B

попадание

при

втором

выстреле,

–

AB

попадание

при

обоих

выстрелах,

т.е. A B A B A B

Суммой нескольких событий называют событие, заключающееся в появлении хотя бы одного из них. A B C A B C AB AC BC ABC .

При несовместных событиях: A B A B, A B C A B C .

Диаграммы Эйлера-Венна

А

P( A B) P( A) P( B) P( AB)

В

P( A B) P( A) P( B)

Пример. В урне 30 шаров: 10 красных, 5 синих, 15 белых. Найти вероятность появления цветного шара при вынимании из урны одного шара. С появлением цветного шара

свяжем или событие A - вынимание красного шара, или событие B вынимание синего

шара. Р( А В) Р( А) Р( В) Р( А)

10

5

1 1 1

, Р( В)

Р( А В) .

30

30

3 6 2

Сумма вероятностей событий A1, A2 ,..., An , образующих полную группу,

равна 1 (условие полноты группы событий).

Р( А1 ) Р( А2 )

Р( Аn ) 1.

2.Противоположными называют два единственно возможных события,

образующих полную группу.

Р( А) Р( А) 1,

А

Ω

Р( А) 1 Р( А).

А

5

3.Произведением двух событий A и B называют событие A B , состоящее в

совместном появлении этих событий.

Пример: A – деталь годна, B – деталь окрашена A B – деталь годная и окрашенная.

Произведением нескольких событий называют событие, состоящее в совместном появлении всех этих событий.

Пример: событие A – появление герба при первом броске монеты, B - появление герба при втором броске, C - появление герба при третьем броске, A B C – появление герба при всех трех бросках.

4.Условной вероятностью Р ( А | B ) (или РВ ( А) ) называют вероятность

события A , вычисленную в предположении, что событие B наступило.

Пример. В урне 3 белых шаров и 3 черных шара. Из урны дважды вынимают по одному шару, не возвращая обратно. Найти вероятность появления белого шара, при втором

испытании (событие B ), если при первом испытании (событие A ) был извлечен черный

шар. P( B | A) 3 / 5, P( B) 1/ 2 P( B | A) P( B) .

События A и B в этом примере зависимые.

P( B) - безусловная вероятность, а P ( B | A) - условная вероятность.

5.Формула вероятности произведения двух зависимых событий.

Р( АВ) Р( А) Р( В | А) P ( B ) P ( A | B ) Р( В | A)

P( AB)

P( AB)

и P( A | B)

.

P( A)

P( B)

5. Формула вероятности произведения двух независимых событий:

Р( АВ) Р( А) Р ( В ) Условие независимости: Р( АВ) Р( А) Р( В) .

6.Формула вероятности произведения нескольких зависимых событий:

Р( А1, A2 , A3 ,

, An ) P( A1 ) P( A2 | A1 ) P( A3 | A1 A2 )

P( An | A1 A2

An1 ) .

Пример. В урне 5 белых шаров, 4 черных и 3 синих шара. Наудачу извлекают по одному шару, не возвращая обратно. Найти вероятность того, что при первом испытании

появится белый шар (событие А), при втором – черный (событие В), при третьем–синий

(событие С).

P( A) 5 /12, P( B | A) 4 /11, P(C | AB) 3 /10 P( A B C ) (5 /12)(4 /11)(3 /10) 1/ 22.

6

Замечания: 1.Порядок, в котором расположены события, может быть выбран любым,

т.е. безразлично какие события можно считать первыми, вторыми и т.д.

2.Независимость событий взаимна: если A не зависит от B , то и B не зависит от A .

7.Формула вероятности произведения нескольких независимых событий:

Р( А1, А2 , А3

Аn ) P( A1 ) P( A2 )

P( An ) , P( ABC ) P( A) P( B) P(C ).

Пример 1.Вероятности появления каждого из трех событий A , A , A равны:

1 2 3

Р( А1 ) p1 , Р( А2 ) p2 , Р( А3 ) p3 . Найти вероятность появления только одного из этих

событий.

В1 А1 А2 А3 , В2 А1 А2 А3 , В3 А1 А2 А3 , Р( В1 В2 В3 )

Р( В1 ) Р( В2 ) Р( В3 ) p1 (1 p2 )(1 p3 ) (1 p1 ) Р2 (1 p3 ) (1 p1 )(1 p2 ) p3 .

Пример 2. Вероятности попадания в цель при стрельбе из трех орудий равны: p1 0,8; p2 0, 7; p3 0,9. Найти вероятность хотя бы одного попадания (событие А)

при одном залпе из всех орудий. Событие A – попадание первым орудием, A – попа1

2

дание

вторым

орудием,

А3

–

попадание

третьим

орудием.

P( A ) 0,8; P( A2 ) 0,7; P( A3 ) 0,9 . Прямое событие

1

А А1 А2 А3 А1 А2 А3 А1 А2 А3 А1 А2 А3 А1 А2 А3 А1 А2 А3 А1 А2 А3 ,

Обратное событие А (не попал ни разу) определится следующей алгеброй А А1 А2 А3 ,

и вероятностями Р( А) (1 p1 )(1 p2 )(1 p3 )

(1 0,8)(1 0, 7)(1 0,9) 0, 006; Р( А) 1 Р( А) 1 0, 006 0,994.

Пример 3. Вероятность того, что при одном выстреле стрелок попадает в цель, равна

0,4. Сколько выстрелов должен произвести стрелок, чтобы с вероятностью не менее 0,9

попал в цель хотя бы один раз. Пусть событие A – при n – выстрелах стрелок попадает в

цель хотя бы один раз.

P( A) 1 (1 P) n ,

Р( А) 0,9; n ?

P( A) 0,9;

1 (0, 6) n 0,9;

(0, 6) n 0,1

n 4,5; n 5.

Вывод: стрелок должен произвести не менее пяти выстрелов.

7

Доказательство теоремы о сложении вероятностей совместных

событий

Р( А В) Р( А) Р( В) - для несовместных событий

Р( А В) Р( А) Р( В) Р( АВ) - для совместных событий

Доказательство:

Так как события А и В считаются совместными, то событие A B наступит, если произойдет хотя бы одно из трех следующих несовместных событий: А В АВ АВ АВ.

Тогда Р( А В) Р( АВ) Р( АВ) Р( АВ),

(1)

Событие A можно определить следующей алгеброй событий А АВ АВ

и вероятностью Р( А) Р( АВ) Р( АВ) , откуда

Р( АВ) Р( А) Р( АВ),

(2)

Аналогично для события B получим

В АВ АВ, Р( В) Р( АВ) Р( АВ),

Р( АВ) Р( В) Р( АВ).

(3)

Подставляя (2) и (3) в (1), будем иметь:

Р( А В) Р( А) Р( АВ) Р( В) Р( АВ) Р( АВ) Р( А) Р( В) Р( АВ).

Замечание. Совместные события A и B могут быть зависимыми или независимыми.

Для независимых и совместных событий:

Р( А В) Р( А) Р( В) Р( А) Р( В), где Р( АВ) Р( А) Р( В).

Для зависимых и совместных событий:

Р( А В) Р( А) Р( В) Р( А) Р( B / A), Р( АВ) Р( А) Р( B / A).

Пример. Вероятность попадания в цель при стрельбе первого и второго орудий соответственно равны: p 0,7, p 0,8 . Найти вероятность попадания при одном залпе (из

1

2

двух орудий) хотя бы одним из орудий. Обозначим через A – попадание первого орудия,

а через B – попадание второго орудия.

Отметим, что в данном случае

Р( АВ) Р( А) Р( В) .

Искомая

A

и

B

– независимые события, тогда

вероятность

будет

равна

Р( А В) Р( А) Р( В) Р( АВ) 0, 7 0,8 0, 7 0,8 0,94.

8

Формула полной вероятности

Пусть событие A может наступить при условии появления одного из

несовместных событий H1, H 2 ,..., H n , называемых гипотезами и образующих полную группу событий. При этом вероятности P( Hi ) и p( A | Hi ) будем

считать известными.

n

Тогда справедлива формула полной вероятности Р( А) Р( Нi ) Р( А | Нi ).

i1

Формула полной вероятности – «удобная схема» (форма) расчета вероятности событий.

Пример 1. Имеются 2 набора деталей. Вероятность того, что деталь первого набора

стандартна, равна 0,8, а второго – 0,9. Найти вероятность того, что взятая наудачу деталь

из наудачу взятого набора – стандартна. Обозначим, через A событие – извлеченная деталь стандартна. В качестве гипотез удобно принять события H - взята деталь из перво1

го набора, H

2

- взята деталь из второго набора. Эти события несовместны (берут деталь

один раз), образуют полную группу событий (деталь берут) и, в данном случае, равновероятны (набор выбирается наудачу): Р( Н1 )

1

1

, Р( Н 2 ) , Р( Н1 ) Р( Н 2 ) 1. Выбор то2

2

го или иного набора – условие. В различных наборах вероятность извлечения стандартной детали различна: Р( А | Н1 ) 0,8; Р( А | Н 2 ) 0,9. Тогда рассмотрим сумму двух событий, каждое из которых, в свою очередь, состоит из произведения, т.е. формулу полной вероятности Р( А) Р( Н1 ) Р( А | Н1 ) Р( Н 2 ) Р( А | Н 2 )

1

1

0,8 0,9 0,85.

2

2

Пример 2. В первом наборе 20 деталей и из них 18 - стандартны. Во втором наборе

10 деталей и из них 9 - стандартны. Из второго набора наудачу взята деталь и переложена

в первый. Найти вероятность того, что деталь, наудачу извлеченная из первого набора,

будет стандартна. Введем обозначения для событий: A – из первого набора извлечена

стандартная деталь, H – из второго набора извлечена стандартная деталь, H – из вто1

2

рого набора извлечена нестандартная деталь. Можно ли H и H - считать гипотеза1

2

9

1

19

18

, Р ( Н 2 ) , Р ( А | Н1 ) , Р ( А | Н 2 )

10

10

21

21

ми?

9 19 1 18

Р( А) Р( Н1 ) Р( А | Н1 ) Р( Н 2 ) Р( А | Н 2 ) 0,9.

10 21 10 21

Р ( Н1 )

9

Формула вероятности гипотез

До сих пор рассматривалась - априорная, безусловная вероятность гипотез Р( Н i ) . Опытные данные (реальные события) могут уточнить априорную характеристику объекта анализа, определить P( Hi | A) - условную (апостериорную) вероятность гипотезы. По формуле произведения вероятности событий можем записать:

P( AHi ) P( A) P( H i | A) P( H i ) P( A | H i ).

Откуда выразим условную апостериорную (условие - событие A произошло) вероятность

Р ( Н i | A)

Р( Н i ) P( A | H i )

.

P ( A)

Знаменатель раскроем по формуле полной вероятности и получим формулу вероятности гипотез (формулу Байеса, лежащую в основе известного «байесовского подхода» в уточнении гипотез):

P( H i | A)

P( H i ) P( A | H i )

P ( H1 ) P ( A | H1 )

.

. Например, P( H1 | A)

P( H i ) P( A | H i )

P( H i ) P( A | H i )

i

i

Пример. Детали, изготовленные цехом, попадают для проверки на стандартность к

одному из контролеров. Вероятность того, что деталь попадет к первому контролеру,

равна 0,6, а ко второму – 0,4. (Их загрузка или производительность). Вероятность того,

что годная деталь будет признана стандартной первым контролером – 0,94, а вторым –

0,98 (второй имеет лучшую квалификацию). Годная деталь при проверке была признана

стандартной. Найти вероятность того, что годную деталь проверил первый контролер.

Введем обозначения: A – деталь признана стандартной (событие произошло); гипотезы: H - деталь проверил первый контролер, H – деталь проверил второй контролер:

1

2

Р( Н1 ) 0,6; Р( Н 2 ) 0, 4.

Р( Н1 / А)

Условные

вероятности

Р( А / H1 ) 0,94; Р( А / H 2 ) 0,98 .

0, 6 0,94

0,59. Сравним априорную и апостериорную ве0, 6 0,94 0, 4 0,98

роятности гипотез

Р( Н1 ) 0, 6; Р( Н1 | А) 0,59 Р( Н ) Р( Н | A) .

1

1

10

Формула Бернулли

Часто практике соответствует схема независимых испытаний Бернулли:

проводятся испытания, в которых вероятность появления события A («успеха») одна и та же, а исходы независимы друг от друга.

Задача: определить вероятность того, что при n испытаниях событие A

произойдет k раз (не произойдет n k раз). При этом не требуется, чтобы

событие A повторялось ровно k раз в определенной последовательности.

Например, при n 4 один «успех» может быть реализован следующим образом

АААА, АААА, АААА, АААА .

Для общего случая вероятность k «успехов» из n испытаний равна

Рn (k ) Сnk p k q nk ,

n!

где Cn k - число сочетаний из n по k , Cnk

; q 1 p.

k !(n k )!

Пример. Вероятность того, что операционные расходы фирмы в течение 1 месяца не

превысят установленный бюджет, равна 0,75. Найти вероятность того, что в ближайшие

6 месяцев операционные расходы в течение 4-х месяцев из них не превысят норму.

6!

р 0, 75; q 1 p 1 0, 75 0, 25; Р6 (4) С64 р 4 q 2

0, 754 0, 252 0,30 .

4!(6 4)!

Замечание. Формула Бернулли требует больших вычислений при больших значениях n .

Локальная формула Лапласа

Используется в схеме испытаний Бернулли для более простого асимптотического определения вероятности k успехов из n – испытаний, если

n : Pn (k )~

1

npq

( x),

2

x

k np

где ( x)

e 2 , x

нормированная и

2

npq

1

центрированная случайная (стандартная) величина, функция ( x ) табулирована.

Пример. Найти вероятность того, что событие A появится ровно 80 раз в 400 испытаниях, если вероятность события в каждом испытании равна 0,2.

p 0, 2; n 400; k 80; P400 (80) ?

x

80 400 0, 2

400 0, 2 08

0, P400 (80)

1

400 0, 2 0,8

0,3989 0, 04986 .

11

Интегральная формула Лапласа

Имеем вновь схему испытаний Бернулли, но требуется вычислить вероятность того, что событие A появится в n испытаниях от k1 до k2 раз (не

менее k1 и не более k2 раз). Эта задача распространена в прикладных вопросах теории вероятностей:

Рn (k1, k2 )

2

k np

k np

x z

, x 2

,

e 2 dz, x 1

npq

npq

2 x

1

2

z2

z2

x z

1 0 2

1 x 2

2

Рn (k1, k2 )

e

dz

e

dz

e

dz

2 x

2 x

2 0

z2

z2

1 x 2

1 x 2

dz

dz ( x ) ( x ),

e

e

2 0

2 0

1

где (x) - табулированная функция.

Пример. В страховой компании 10 000 клиентов. Страховой взнос – 2 000 руб. Вероятность страхового случая p 0, 005. Страховая выплата – 200 000 руб. Определить

размер прибыли стразовой компании с вероятностью p 0,9.

Прибыль R (20 0, 2k ) млн. руб., где k - число страховых случаев. Найдем такое

N , чтобы P10000 ( N k 10 000) 0,1 . x

Из

0,5 (

таблицы

найдем

N np

npq

N 50

10000 9950

, x

1411,34 .

7, 05

npq

( x) 0,5

при

x 5.

N 50

N 50

N 50

) 0,1 (

) 0, 4 из таблиц

1, 28 N 60 . Оконча7,05

7,05

7, 05

тельно R 20 0, 2 60 8 млн. руб.

12

Случайные одномерные величины

А

В

0

А

X

В случайные события, Y случайные величины (с.в.)

С

Z

x

y значения (в том числе и отрицательные) с.в. на числовой оси.

z

Случайной называют величину, которая в результате испытания примет одно и только одно возможное значение, априори неизвестное и независящее от случайных причин, которые заранее не могут быть учтены.

С.в. может быть непрерывной (аналоговой) или дискретной (прерывистой).

Пример непрерывной с.в.: расстояние, которое пролетает снаряд из орудия, зависит от большого количества факторов (ветра, t0, угла прицела, изменений количества и

состояния пороха и т.д.), точности измерений (шаги, метры, микроны и т.д.). Имеет место

и «эллипс» рассеяния (влево-вправо).

l

Непрерывная с.в. имеет бесконечное число значений и несчетна. Вероятность отдельного конкретного значения случайной величины равна 0

(но это событие возможно). Можно говорить о вероятности диапазона значений непрерывной с.в.

13

Дискретная с.в. может быть конечной или бесконечной, но она счетна

(ей можно поставить в соответствие натуральный ряд чисел).

Примеры дискретной случайной величины:

1.Число родившихся мальчиков из 100 новорожденных случайно: 0, 1, 2, 3, ... 100.

Однако оно всегда дискретно и устойчиво больше, чем число родившихся девочек. С

возрастом соотношение выравнивается, затем становится меньше.

2. Вероятность числа «успехов» в схеме Бернулли.

Характеристики с.в.: 1.Графики, таблицы.

2.Аналитические функции (интегральная и

дифференциальная функция распределения), функционалы от них (числовые характеристики), квантили.

Распределения вероятностей дискретной случайной величины

X xi

P( xi ) pi

n

, где i 1, n; pi 1 - условие полноты группы

i1

событий (нормировки)

x

p

x1

x

2

...

xn

ряд распределения, если наложено

p

1

p2 ...

pn

условие, xi1 xi => вариационный ряд

P2

P1

Pn

x1

x2

…

xn

x

График: многоугольник или

полигон распределения

Пример. В денежной лотерее выпущены 100 билетов. При этом могут быть 1 выигрыш по 50 руб., 10 выигрышей по 1 руб. Найти закон распределения. Пусть x – величина возможного выигрыша при покупке 1 билета. x1 =50 руб. p1 =1/100;

x

0

p

0,89 0,1

1

50

0,01

x1 =10 руб. p1 =10/100;

x1 =0 руб. p1 =89/100.

14

Известно более 100 аналитических распределений

1.Биноминальное распределение _(схема испытаний Бернулли)

Pn k Cnk p k q nk

Пример. Монета брошена 2 раза. Определить закон распределения числа выпадения

герба. Пусть x – появление «герба». Тогда p 1/ 2; g 1/ 2.

2

2

P2 0 C20 q 2 1 1/ 2 0, 25 ; P2 1 C12 pq 2 1/ 2 0,5;

2

2

P2 2 C22 p 2 1 1/ 2 0, 25;

Pi 1 .

i0

2.Распределение Пуассона

Схема испытаний Бернулли формула Бернулли. При дополнительном

условии n локальная теорема Лапласа. При дополнительных условиях p 0 , np . вероятность k «успехов» из n испытаний определится

асимптотической формулой Пуассона:

Pn k

k

K!

e .

Формула Пуассона широко используется в теории массового обслуживания и в теории надежности, где - имеет смысл интенсивности отказов.

очередь

λ=λ(t)

λ

t

заявки

аппарат

обслуживания

Начальный

режим работы

Стационарный

режим работы

Пример. Поставщик отправил дистрибъютеру 5000 товаров. Вероятность того, что единица товара выйдет из строя 0,0002. Найти вероятность того, что у дистрибъютера выйдут из строя 3 единицы товара.

n 5000; p 0, 0002 .

n

13 1

np 1 P5000 3 e 0, 06 .

p 0

3!

15

Основные формулы комбинаторики, используемые для определения

вероятностей алгебры событий

Комбинаторика изучает количество комбинаций, подчиненных определенным условиям для элементов конечного множества.

1. Перестановками называют комбинации, составленные из одних и тех

же элементов множества, отличающихся только порядком расположения Рn n! .

Пример. Сколько трехзначных чисел можно составить из цифр 1, 2, 3, если каждая

цифра входит в число один раз. Р3 n!

n3

3! 6.

n называются комбинации, составленные из n – раз2. Размещениями Am

личных элементов по m – элементам, которые отличаются либо составом

элементов,

Аnm n(n 1)(n 2)

либо

(n (m 1)) n(n 1)(n 2)

их

порядком.

(n m 1) .

Пример. Сколько сигналов можно составить из 6 букв: A, B, C, D, E, F по 2 элемента?

AB, AC, AD, AE, AF

BA, BC, BD, BE, BF

CA, CB, CD, CE, CF

DA, DB, DC, DE, DF

EA, EB, EC, ED, EF

FA, FB, FC, FD, FE

А 2 6 5 30.

6

3. Сочетаниями называют комбинации, составленные из n- различных

элементов по m – элементам, которые отличаются хотя бы одним элементом.

Сnm

n!

m !(n m)!

Пример. Сколькими способами можно выбрать 2 детали из ящика, содержащего 10

деталей?

С10

2

10!

45 .

2!8!

Аnm Pm Cnm - связь числа размещений, перестановок и сочетаний.

16

Функция (интегральный закон) распределения с.в.

F ( x ) – является универсальной характеристикой и для непрерывных и

для дискретных одномерных с.в. и описывает вероятность события P( X x) :

F ( x) P( X x) .

0

x

X

Пример. Пусть случайная величина Х задана таблицей распределения (т.е. Х –

дискретная случайная величина).

х

1

р

0,3 0,1 0,6

4

8

Р

1

0,6

0,1

0,3

0

1

4

8

х

Р( X 1) 0; P( X 4) 0,3; P( X 8) 0, 4; P( X 9) 1 ; P( X 10) 1. Pi 1 .

i

Свойства функции распределения

1.

2.

3.

4.

5.

0 F ( x) 1 ;

F () P( x ) 1 ;

F () P( x ) 0 ;

P( X x) 1 F ( x) - вероятность противоположного события;

P(a x b) F (b) F (a) - вероятность попадания в интервал значений.

0

а

в

х

6. x2 x1 F ( x2 ) F ( x1 )

17

Плотность вероятности

(дифференциальный закон) распределения непрерывной с.в.

f ( x) F / ( x) lim

x0

F ( x x) F ( x)

x

Свойства плотности вероятности

1. f ( x) 0 ;

2.

f ( x)dx 1 - условие нормировки (единичная площадь под кривой распре-

деления, полнота группы событий);

x

3. F ( x) f (t )dt - выражение функции распределения через плотность;

b

4. P(a x b) f ( x)dx F (b) F (a) - вероятность попадания в интервал знаa

чений.

Функции F ( x) , f ( x) , ряды распределения

pi

исчерпывающим образом

описывают одномерную с.в., однако они довольно сложны, а информация,

содержащаяся в них, зачастую избыточна, поэтому широко используют числовые характеристики.

18

Числовые характеристики распределения с.в.

1. Математическое (безусловное) ожидание с.в.

xi pi

i

, где pi - вероятность, а f ( x)dx dp - элемент веM х mx

xf ( x)dx

роятности (вероятность попадания в dx ),

M . - оператор математического ожидания

f x

mx

0

150

x

mx

x mx

180

x

рост человека

mx - центр группирования, «среднее значение»,

центр тяжести плоской фигуры, ограниченной кривой f ( x) .

Свойства математического ожидания

1. M x c 1 c;

2. M cx cmx ;

3. M x y mx m y ;

4. M ax b amx b ;

5. M xy mx m y если x и y независимые с.в.

xi Pi

i

k [ x]

- начальный момент k – того порядка

x k f ( x )dx

0 1

1 [ x ] m x

19

2. Дисперсия (безусловная) с.в.

( x m )2 P

x

i

i i

Dx D[ x]

( x mx )2 f ( x)dx

0

xi mx x - центрированная с.в.;

Dx - мера разброса (рассеяния) вокруг матожидания (в квадратных единицах), D[.] - оператор дисперсии

Свойства дисперсии

1. D[c] (c c)2 1 0

2. D[cx] c 2 Dx

3. D[ xy] Dx Dy

4. D[ax b] a 2 D x

x Dx - среднее квадратическое отклонение (в линейных единицах)

x

- коэффициент вариации (изменчивости) (в относительных единицах)

mx

Замечание. Коэффициент вариации применяют при анализе риска инвестирования.

kв

Удобная формула расчета дисперсии: D[ X ] M [( x mx )2 ]

M [ x 2 2 xmx mx 2 ] M [ x 2 ] 2mx M [ x] mx 2 M [ x 2 ] m x2 .

0 k

( x ) p

i

i

k [ x] i

- центральный момент k – того порядка

0

k

( x) f ( x) dx

2 [ x] Dx

[ x]

3. k A 3 - коэффициент асимметрии

x3

4. E x - эксцесс (коэффициент островершинности)

0

A

нормальное (Гауссово) распределение выступает в качестве

Ex 0

k

меры (эталона):

20

f x

kA 0

kA 0

mx

x

f x

Ex 0

Ex 0

Ex 0

mx

x

5.Квантили распределения

x p - квантиль уровня (вероятности) p определяется как корень уравне-

ния F x p p или, соответственно, P( X x p ) p

Квантили:

x

е ; квартили; децили;

1/ 2

процентили.

(медиана)

f(x),

F(x)

S=1/2

x

1/2

mx

х

21

Квартили

f x

1/4

1/4

S 1/ 4

1/4

x

1/4

x

3/ 4

x

1/2

x

Квартили - x1/ 4 , x2/ 4 , x3/ 4 ;

Децили - x1/10 , x2/10 , , x9/10

Процентили - x1/100 , x2/100 , , x99/100 .

Квантили широко используется в робастной статистике:

;

178; 187; 1655, 175; 178 mx 474, 6 . Наблюдение 1655 – выброс (промах).

175; 178; 178; 187; 1655 е 178

6. Мода распределения - о arg max f ( x)

f (x)

0

х

Одномодальное (унимодальное) распределение

f(x)

f(x)

h=1/b-a

µо1

µо2

µо3

а

b

x

Амодальное распределение

х

Полимодальное распределение

Пример использования моды: размеры одежды, перепись населения.

f (x)

a

b

х

Антимодальное распределение

22

Нормальное (Гауссово) распределение

f(x)

mx, µо, µe

f ( x)

1

x 2

e

( xmx )2

2 x2

х

(t mt )2

x

2 t2

1

, F ( x)

e

dt

x 2

f ( x) f ( x, mx , x ) - двухпараметрическое распределение,

x ~ N (mx , x ) - обозначение с.в., имеющей нормальная распределение

u ~N (0,1) -

mx 0

- обозначение с.в., имеющей нормированное

x 1

(стандартное) нормальное распределение

Операции нормирования и центрирования:

x mx

x

x mx

1

M

M x mx 0 ;

x x

x mx

1

2

D

2 x 1

x x

Правило 3-х сигм

P x mx x , mx x 0, 68

P x mx 2 x , mx 2 x 0,95

P x mx 3 x , mx 3 x 0,99

f(x)

mx-2σx

mx-3σx

mx-σx

mx

x

mx 3 x - зона практического рассеивания

23

Функция Лапласа

u2

t2

x mx

1 2

1 u 2

u

, f (u )

e

, F (u )

dt - стандартное нормальное

e

x

2

2

распределение с.в. от до u . Проще рассматривать случай, когда u 0 .

F(u)

F(u)

1/2

Ф(u)

0

u

u≥0

Ф(u ) F (u ) 1/ 2

t2

1 u 2

dt

e

2 0

- табулированная функция Лапласа, широко используемая для определения вероятности попадания в диапазон значений:

P ( a x b) (

b mx

x

) (

a mx

x

) .

Роль нормального распределения. Теоретики и практики («мифы»).

Центральная теорема: Сумма конечного числа нормальных с.в. есть

нормальная с. в.

Центральная предельная теорема: Сумма бесконечного числа с.в. с

любыми законами распределения, но с примерно одинаковыми дисперсиями, имеет нормальное распределение.

Многие экономические показатели имеют нормальный или близкий к

нормальному закон распределения: доход населения, прибыль фирмы в отрасли и др.

Пример. В результате длительных наблюдений определено, что дивиденды X и Y

по акциям фирм A и B являются нормальными с. в.: X ~ N (5;5) ; Y ~N (15;15) . Стоимость каждой акции равна 100$. Инвестор хочет приобрести акции на 1000 $.

а)Какие законы распределения имеют доходы X, Y от вложения всей суммы в акции

фирмы А или В? б)Каков закон распределения имеет доход Z от покупки акций в пропорции 2/3? в)Построить графики функций случайных величин X, Y, Z. г)Какова вероятность того, что полученный доход Z от вложения будет лежать в пределах от 110$ до

150$?

а) X 10 X X ~ N (50; 102 25 50 ) или Y 10Y Y ~ N (150, 102 125 150 );

24

б) Z 4 X 6 Y Z ~ N (mz=4 5+6 15=110, σz= 16 25 36 225 92, 2 );

в) При построении графиков целесообразно пользоваться правилом 3-х сигм и обязательно соблюдать условие нормировки (площадь под кривой распределения одна и та же равна единице).

f(x)

f(y)

f(z)

1

2 92, 2

f(z)

1

2 50

1

2 150

f(x)

f(y)

х

50 110 150

г)Р(110≤Z≤150)=Ф(0,43)-Ф(0)=0,16 (используются таблицы функции Лапласа).

Равномерное (равновероятное, прямоугольное)

распределение

1

a

x 1

xa

F ( x)

dt 0dt

dt

;

ba

b a

aba

1

,a x b

f ( x) b a

0,

bxa

mx

ab

2

Dx

mx e,

k

A

(b a)2

,

12

0.

f(x)

h=1/b-a

F(x)

а

b

x

1

а

b

x

25

Показательное (экспоненциальное) распределение

0, x 0

f ( x)

x , x 0

e

f(x)

0

F(x)

x

1

x

0

x

0

x

1

F ( x) e x dt 0dt e t dt 1 e x , mx e x xdx

0

0

1

1

1

1

Dx M [( x )2 ] ( x )2 f ( x)dx e x ( x ) 2 dx

0

0

2

x

1

mx - характеристическое свойство показательного распределения

Приложение - функция надежности. Пусть объект анализа начинает функционировать в момент времени t 0 и по истечении t выходит из строя. Обозначим через T

время безотказной работы. Тогда, вероятность отказа за время t равна:

P(T t ) 1 F (t ), F (t ) P (T t ) .

Для оценки вероятности безотказной работы («накапливающиеся отказы») часто

используется экспоненциальное распределение. При этом параметр распределения λ=λ(t)

является функцией времени. Технические системы, в демографии – смертность.

λ

λ(t)

Период

приработки

Период нормальной

эксплуатации

t

Период старения и

износа

«Внезапные отказы» - Гамма – распределение.

26

Распределение χ2

n

Сумма квадратов n нормальных с.в. ui ~ N (0,1) 2 ui 2 является с.в.

i 1

и имеет табулированное распределение χ2 с n m числом степеней свободы. Здесь m – число наложенных связей: обязательно - условие нормировки, и связи,

связанные с расчетом тех или иных центральных или начальных моментов. Аналитическое

выражение

не

приводится

(сложное),

распределение

табулировано.

M [ 2 ] ; D[ 2 ] 2 ; 2 ~ N ( , )

f(x)

ν =1

ν =6

ν =10

х

0

t - распределение (Стьюдента)

Если u ~ N (0,1), а V ~χ2 с степенями свободы, то

f(t)

2

с.в. t u /

имеет распределение Стьюдента с

ν=6

степенями

M [T ] 0 ; D[T ]

ν=2

t

свободы.

2

. t ~ N ( , ) . Основное

распределение малых выборок (до 15 -17 – ти наблюдений).

Распределение табулировано

F - распределение (Фишера)

Если W и V – независимые случайные величины, распределенные по

закону χ2 с степенями свободы m и n , соответственно, то с.в.

f

V /m

имеет распределение Фишера (табулировано).

W /n

В статистике широко используют прием введения некоторой случайной величины,

распределение которой не зависит от числовых характеристик исходного анализируемого

распределения. Такие величины имеют распределение Стьюдента, Фишера и 2 .

27

Двумерные с.в. («проклятие размерности»)

Уже было для событий и одномерных с.в.:

p(Y y j ) p j

B P( B) y

f ( y)

p( x ) pi

A P( A) x i

;

f ( x)

P( A B) P( A) P( B | A) P( B | A)

0

P( A B)

;

P( A)

X

x1

f ( x)

F ( x) P( X x);

dF ( x)

; F ( x) f (t )dt.

dx

P( X x; Y y ) F ( x, y )

- двумерные функция и ряд распределения

( X ,Y )

P( X xi ; Y y j ) pij

x

2

…

xn

p11

p

12

p

21

p

22

…

…

pn1

pn 2

…

p1n

…

p2n

…

…

…

pnn

x1

Y1

Y

2

…

Yn

Y

(x,y)

X

Pij 1 - условие нормировки,

i j

2 3

2

Pij ( Pi1 Pi 2 Pi3 ) P11 P21 P12 P22 P13 P23

i 1 j 1

i1

f ( x, y )

2 F ( x, y )

;

xy

x

F ( x, y )

y

f (u, v)dudv ; f ( x, y ) – поверхность, f ( x, y ) ≥ 0

F ( x, y ) – неубывающая функция двух переменных, поверхность.

f ( x, y )dx f 2 ( y ) ; f ( x, y)dy f1( y) - получение одномерных плотностей

f ( x, y )dxdy 1 - условие нормировки (единичный объем)

f ( x, y ) f1 ( x) f ( y | x);

f ( x, y) f1( x) f 2 ( y) - для независимых с.в.

28

f ( y | x)

f ( x, y )

f1 ( x)

f ( x, y )

-условные вероятности двумерной с.в.

f ( x, y ) dy

f ( x | y)

f ( x, y )

f2 ( y)

f ( x, y )

(сечения поверхности f ( x, y ) )

f ( x, y ) dx

Регрессия – линия

условного мат- ожидания

Вес чел.

f(y/175)

сечение

164

175

Рост чел.

Двумерный закон распределения является исчерпывающей характеристикой, но сложен, поэтому используют числовые характеристики:

x k y l P

i j i j ij

k ,l [ X , Y ]

x k yl f ( x, y )dxdy

- начальный смешанный момент

порядка k l

0 k 0 l

( xi ) ( y j ) Pij

k ,l [ X , Y ] i j

- центральный смешанный момент

(0x) k (0y )l f ( x, y )dxdy

порядка k l

Корреляционный (взаимокорреляционный, кросскорреляционный)

момент (ковариация)

11[ X Y ] M [ X Y ] mx my K xy xy

rxy

K xy

x y

;

1 rxy 1

- коэффициент корреляции характеризует

степень тесноты линейной связи.

29

y

y

y=kx+b

rxy>0

rxy<0

х

х

y

rxy ≈0

х

Свойства

1) rxy ryx ; 2) rxx 1 ;

3)если x и y независимы, то rxy 0; но

если rxy 0, то это не означает, что x и y независимы;

4) rxy x y ;

5)если rxy 1 Y kx b - имеем детерминированную (функциональную) зависимость.

Замечание: Из некоррелированности нормально распределенной двумерной случайной величины следует независимость переменных:.

Eсли rxy 0, то

f ( x, y )

1

2 x y

1 r2

exp(

xy

1

2 1 r 2 xy

)

2

( x mx ) 2 ( y m y )

( x mx )( y mx )

[

2rxy

] f1 ( x) f 2 ( y ),

2

2

x

y

x y

При rxy 0 возможен другой (нелинейный) вид регрессии (стохастической связи), например, Y ax2 bx c, Y Ae x , .

30

Условные математические ожидания (регрессии)

y j P ( y j | x )

P( y j , x)

P( y j , x)

j

M [Y | x]

; P( y j | x)

;

P( x)

j P( x, y j )

yf ( y | x)dy

xi p( xi | y )

i

.

M [ X | y]

xf ( x | y )dx

Пример1. Дискретная двумерная с. в. задана таблицей распределения: Найти условное математическое ожидание с.в. Y при значении с.в. X 1: т.е. M [Y | x 1] .

1

y 3

1

y 6

2

x 1

1

x2 3

x3 4

x4 8

0,15

0,3

0,06

0,1

0,25

0,03

0,04

0,07

2

P[ x1 ] P( x1 , y j ) 0.45; P( y1 | x1 )

j 1

P( x1 , y1 ) 1

P( x1 , y2 ) 2

; P( y2 | x1 )

;

P( x1 )

3

P( x1 )

3

2

M [Y | x1 1] y j P(Y j | x1 ) 5.

j 1

Пример регрессии X на Y. Условное математическое ожидание веса человека в

функции от роста.

Регрессия X на Y

Вес чел.

f(y|175)

75 кг

сечение

164

175

Рост чел.

Пример регрессии Y на X. Расчет среднего роста человека при массе (весе) 75 кг.

Задавая разные веса и рассчитывая средние статистические значения роста человека при

данных весах получить стохастическую зависимость роста от веса.

Генеральная совокупность – одномоментно измеряют рост всего населения Земли

(кто и как измеряет?). «Практические измерения – выборки – статистика».

31

II. МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

Задачи математической статистики:

1)Указать способы сбора, группировки статистических методов, полученных в результате наблюдений или специально поставленных экспериментов.

2)Разработка методов анализа статистических характеристик в зависимости от цели исследования: оценка вероятности распределения, функции

распределения, параметров функции распределения, зависимости случайной

величины от одной или нескольких случайных величин.

Большинство решений по методам обработки статистических данных

принимают до начала исследований, реже – в ходе исследования - «последовательный анализ» (примеры – приемочный контроль качества, статистическая физика).

Основные понятия статистики

Генеральная совокупность - объемом N . Выборка – объемом n (количество

наблюдений для «разумного» результата). Репрезентативность (представительность)

выборки.

Построение эмпирической (статистической) функция распределения

Вероятность pi

m

- неслучайная величина

n

F ( xi ) P( X xi ) - неслучайная функция.

В статистике частота pi

m

n

- с.в.

Сходимость частоты по вероятности к вероятности:

p

pi

n pi

lim P( pi pi ) 1, 0

n

n

F ( x) p ( X x) x - случайная функция,

n

где n - объем выборки, nx - число значений наблюдаемой выборки < x .

p

F x

n F ( x)

lim p( F ( x) F ( x) ) 1, 0.

n

32

Свойства эмпирической функции распределения

1) 0 F ( x) 1 ;

2) F x - неубывающая функция;

3) если x1 - наименьшая варианта, F x 0, x x1 ;

4)если xn - наибольшая варианта, F x 1, x xn .

Пример. Построим эмпирическую функцию распределения для данного вариационного

ряда:

xi

2

6

10

ni

pi

12

18

30

0,2

0,3

0,5

3

3

n ni 60; pi 1,

i 1

i 1

x2

0;

0, 2; 2 x 6 ;

F ( x)

0,5; 6 x 10

1;

x 10

F (x)

1

0,5

0,2

x

2

6

10

Пример. Построение полигона для следующего вариационного ряда:

p

xi

1,5

3,5

5,5

7,5

pi

0,1

0,2

0,4

0,3

Полигон

i

Гистограмма

0,4

0,3

0,2

0,1

f(x)

1,5

3,5

5,5

xi

a

b

33

Пример. Построим гистограмму для выборки. Разбиваем интервал (b a ) , в котором

находятся все наблюдаемые значения, на несколько интервалов с шагом h

ba

. В обk

щем случае h может быть различным. Подсчитываем ni - число значений выборки, попавших в i - ый интервал (в случае попадания на границу интервала относят по 1/ 2 влево и вправо). Подсчитываем частоты с.в. в i -ом интервале: pi

ni

. Строим прямоn

pi

угольники, у которых высоты равны li

; а площади равны Si h li pi .

h

Проверяем гипотезу о виде плотности распределения вероятностей (критерий

Пирсона χ2).

Для проверки гипотезы о виде интегральной функции распределения – используют критерии Романовского, Ястремского, Колмогорова.

Первым и необходимым этапом построения эмпирической функции

распределения, гистограммы и расчета выборочных числовых характеристик распределения является обеспечение однородности выборки (устранение аномальных наблюдений).

Под аномальными наблюдениями понимают те отдельные наблюдения, которые не отвечают потенциальным возможностям исследуемой экономической (социально-экономической) системы и которые, оставаясь в выборке, оказывают существенное

влияние на статистические характеристики выборки.

Возможные причины: ошибки при агрегировании и дезагрегировании экономических показателей, при передаче, при записи информации и т.д.

За показатель ошибочности отдельного наблюдения принимают значения

его отклонения от остальных наблюдений: методы Ирвина, проверки разностей средних

уровней, Фостера – Стьюдента, простой скользящей средней и экспоненциального сглаживания.

Методы обеспечения однородности обычно используют t распределение.

Наибольшее сомнение обычно вызывают несколько крайних значений

вариационного ряда (левая и правая варианты).

34

Статистические оценки параметров распределения

Оценка математического ожидания (выборочной средней):

N

Неслучайное математическое ожидание: mx xi pi - генеральная средняя

i 1

С.в. - оценка матожидания mx X

k 1

1 k

xi mi xi mi

n i1

i1 n

p

Так как Pi*

n Pi

X

1 n

x - выборочная средняя

n i1 i

k

* m частота отдельных значений

*

xi Pi , где Pi

n

i1

p

X

n mx

Оценка выборочной дисперсии:

2

1 n

2 1 k x X 2 m k 1 x X 2 m k x X 2 P*

D

x

X

S

x

i i

i i

i

n i1 i

n i1 i

1 n i

1 i

x S - стандарт (выборочное стандартное –среднеквадратическое отклоне-

ние).

Удобная формула оценки дисперсии через оценку второго начального момента

2

1 n

S 2 ( 2 ) * ( X ) 2 xi ( X ) 2

n i1

Аналогично рассчитываются и другие выборочные оценки распределения

Точечные оценки точности оценок (статистик) генеральных числовых

характеристик x

{x1 , x2 ,

, x N } x ; {x11 , x21,

, xn1} x*1;

{x12 , x22 ,

, xn2 } x*2 ;

{x , x ,

1k 2k

, x } * .

nk

xk

-оценки статистических характеристик

* - с.в., характеризуемая законами распределения и числовыми харак xi

теристиками распределения (обычно математическим ожиданием и дисперсией).

35

Можно говорить о распределении оценки матожидания, о матожидании оценки матожидания, о дисперсии оценки матожидания и т.д.

f x

f mx

дельта-функция

f X

f X

f x

0

X

Разброс X

x

mx

m*x X

1. Оценка называется состоятельной, если она сходится по вероятности к

P( i ) 1, 0 .

оцениваемой характеристике nlim

2.Оценка называется несмещенной, если M [i* ] .

M [i* ] - смещение, систематическая погрешность (от смещенности)

Асимптотически несмещенная оценка lim M [ i ] 0.

n

3.Оценка называется эффективной, если при используемом методе ее расчета выполняется условие

D[i* ] min .

Пример1. Оценка X является несмещенной, а ее дисперсия уменьшается при

усреднении в n раз:

1 n 1

M X M xi nmx mx .

n i 1 n

D[ X ] D[

D

1 n

1

nDx x .

xi ]

n i1

n

n2

Если x ~ N (mx , x ) X - эффективная оценка.

В прикладной статистике и в эконометрике, наибольшее внимание уделяют обеспечению эффективности и несмещенности оценок.

36

2

1 n

Пример 2. Оценка дисперсии D*x S 2 M xi X является смещенной:

n i 1

2 n 1

1 n

Доказано, что S 2 M xi X

Dx - т.е. данный алгоритм дает смеn

n i1

щенную оценку дисперсии:

Dx

. Исправленная (несмещенная) оценка дисперсии

n

2

nD*x

1 n

2

.

Sиспр

xi X

.

n 1

n 1 i1

На практике исправленной оценкой дисперсии пользуются при n 30.

Интервальная оценка точности (надежность) генеральных

математического ожидания и дисперсии

Доверительный интервал - интервал значений, в котором с заданной доверительной вероятностью (обычно назначают 0,9; 0,95; 0,99 ) находится истинное значение оцениваемой статистической характеристики x :

P[| * | ] P( * * ) .

Доверительный

интервал

*

*

0

*

Нижняя

Верхняя

граница

граница

t

t

* ,

Радиус доверительного интервала равен:

n

n

t - аргумент, соответствующий значению функции Лапласа, равной / 2 :

Ф (t ) / 2 ;

*

- среднеквадратическое отклонение x (его оценка).

Доверительный интервал случаен (зависит от конкретных выборок):

случайно его положение на числовой оси и случайна его длина.

При n 0 , а при 1 .

37

Доверительный интервал для оценки математического ожидания

P ( X mx X ) Ф(

Ф

X

Ф

X

X m

x

2Ф

x

X ) Ф(

X m

x

X)

n

t

x

X

t x

n

.

Здесь t рассматривается как аргумент табулированной функции распределения

Лапласа (нормальной !), при котором она равна значению

: Ф(t )

.

2

2

Значение генерального среднеквадратического отклонения x редко

известно, поэтому обычно в формуле используют оценку среднеквадратического отклонения, т.е. *x S

2

1 n

.

xi X

n 1 i 1

Пример: X ~ N x;3 Найти доверительный интервал для оценки неизвестного m x ,

при выборочном среднем X , если объем выборки n=36, а 0,95 .

2Ф(t ) 0,95 Ф(t ) 0, 475 t 1,96.

t x

n

1,96 3

0.98 X 0,98; X 0.98 .

6

Замечание. Практически важной может быть задача определения объема выборки,

t 2 x2

которая обеспечит заданный радиус доверительного интервала: n

.

2

Более точные результаты при малых объемах выборки n и неизвестном

x

t

дает использование распределения Стьюдента: для переменной

-

X mx

, имеющей распределение Стьюдента с k n 1 степенями свободы отклоS

n

нение ( X ~ N mx ; x ) Тогда доверительный интервал при неизвестном среднеквадратическом

отклонении

определяется

следующим

образом:

t S

t S

, где t аргумент табулированного распределения

P X

mx X

n

n

Стьюдента.

38

Доверительные интервалы оценки среднеквадратического отклонения

Пусть вновь x ~ N (mx , x ) , и x - неизвестно, а S

P( x ) S x S ,

2

1 n

xi X . Тогда

n 1 i1

S 1 q x S 1 q ,

где q

.

S

Доказано, что q имеет табулированное распределение 2 , независящее от параметров mx и x исходного распределения, но зависящее от объема выборки и доверительной вероятности. Вычислив по выборке S , находим по таблице q , определяем границы доверительного интервала.

Методы оценки параметров известного распределения

Пусть X - с.в.; x1, x2 ,..., xn - выборка; f ( x, Q) - известный вид распределения с.в., Q Q1 , Q2 ,..., Ql - неизвестные параметры. Например,

f x

f x

1

2 x

( xmx )2

2 x

e

Q mx , x ;

1

Q b, a .

ba

Существуют два основных метода оценки параметров (параметризации):

1.Метод моментов (Пирсона)

Метод исходит из того, что оценки начального и центрального моментов распределения являются состоятельными оценками соответствующих

начальных и центральных моментов. Это дает право приравнять соответствующие эмпирические и теоретические моменты, для точечной оценки

параметров, например:

число

1 x X

1 n

x параметру

n i 1 i

xf x dx 1 Q

1 x n

x p

i 1 i i

39

02

x f x dx Q

2

2 x

2

x

m

x pi

i i

2 x S 2 параметру

число

При этом надо получить не менее, чем L уравнений для определения

L параметров распределения. Выбор начальных или центральных моментов должен

производиться исходя из простоты вычислений эмпирических моментов и простоты аналитического выражения теоретических моментов.

Пример 1. f x e x ; Q .

1 x

X

1

1 n

x dx x e x dx 1

xi X 1 x x e

n i 1

0

1

X

2

Пример 2. f x

1

x 2

e

X mx

2 x

; Q mx , x .

1 n

X

x 1 x mx

n i 1 i

2

n

S 2 1

xi X x x 2 .

2

n i 1

Достоинство метода моментов – простота.

2. Метод максимального правдоподобия (Фишера)

На основе выборки составляется функция правдоподобия:

L x1, x2 ,..., x , Q p x1, Q p x2 , Q ... p xn , Q ,

l

где p x1, Q - есть вероятность того, что первое наблюдение равно x , при векто1

ре параметров Q , а p x2 , Q - вероятность того, что второе наблюдение равно x , при

2

векторе параметров Q и т.д.

В качестве точечной оценки вектора параметров Q принимают такое

его значение Q Q1 , Q2 ,..., Ql , при котором функция правдоподобия достигает максимума.

40

Чаще для удобства вычислений берут вместо функции правдоподобия

ее логарифм: ln L x1, x2 ,..., xn , Q ln p (xi ,Q ) - логарифмическая функция

n

i1

правдоподобия.

И функция правдоподобия, и логарифмическая функция правдоподобия достигают максимума при одном и том же значении вектора параметров

Q.

Последовательность действий при реализации метода максимального

правдоподобия:

1. L...;

2. ln L...;

3.

4.

d ln L ...

dQ

0 Q - уравнение правдоподобия; Q - корень уравнения.

d 2 ln L ... 0 max

.

2

0

min

d Q

Достоинства метода максимального правдоподобия:

1.оценки состоятельны;

2.оценки распределены асимптотически нормальны (при n закон

распределения оценок стремится к нормальному);

3.оценки имеют наименьшую дисперсию по сравнению с другими

асимптотически нормальными оценками (эффективность является

важнейшим свойством оценок в экономике).

4. Метод наиболее полно использует данные выборки об оцениваемом

параметре, поэтому он особенно полезен в случае малых выборок.

Недостатки метода максимального правдоподобия:

1.сложность вычислений;

2.возможна смещенность оценок параметров распределения.

41

Парная линейная регрессия

yi p ( yi | x )

i

M Y | X

- парная регрессия

yf ( y | x)dy

y 0 1x - генеральная ( N ) линейная регрессия X на Y ,

- 0 , 1 - неслучайные величины;

y b0 b 1 x - выборочная ( n ) линейная регрессия X на Y ,

- b0 ,b1 - с.в., характеризующиеся распределением и числовыми

характеристиками (матожиданием и дисперсией);

x 0 1 y - парная линейная регрессия Y на X

Если число объясняющих переменных велико, то говорят о множественной регрессии.

Если условное ожидание объясняемой переменной нелинейно зависит

от объясняющих переменных, то говорят о криволинейной регрессии.

y b0 b1x

y

ej

x , y

j

Y

j

y b0 b1 x

yiмод xi

ei

xi , yi

yiреал xi

0

X

x

yiмод b b xi

0 1

реал

yiмод yi

b b xi yi ei

0 1

- невязка

42

1. ei - не может выступить в качестве метрики (компенсация знаков)

i

2. ei k ei 2 - метод наименьших квадратов (МНК) (>200 лет)

i

i

3. ei - метод наименьших модулей (МНМ)

i

2

ei Q b0 , b1

i

- квадратическая функция потерь (зависит от выбора пара-

метров b0 , b1 ), неотрицательна, ограничена снизу.

Система нормальных уравнений:

Q

b 0

0

- необходимое условие существования экстремума двух переменных

Q 0

b1

приводит к системе линейных алгебраических уравнений (СЛАУ)

второго порядка

n

Q

2

i 1

2 b0

n

Q b , b yi b b xi ;

0 1 i 1

0 1

n

Q 2

b

i 1

1

yi b0 b1xi 0

yi b0 b1xi xi 0

n

n

1

1

yi nb0 b1 xi 0

yi b0 b1 xi 0

i 1

n i

n i

i 1

b0 , b1

n

n

n 2

y x b x b x 0 1 y x b 1 x b 1 x 2 0

i 1 i i 0 i 1 i 1i 1 i

n i i i 0 n i i 1 n i i

b Y b X;

0

1

b1

S xy

X Y X Y S xy

; rxy

; 1 rxy 1;

2

2

Sx S y

2

S

x

X X

S

b rxy x .

1

Sy

43

МНК дает оптимальные (эффективные, состоятельные, несмещенные)

оценки 0 , 1 (т.е. b0 , b1 ) при соблюдении следующих условий (условий

Гаусса-Маркова):

1. M e 0 - невязка является центрированной с.в.;

2. D e const - при выполнении этого условия невязка гомоскедастична,

в противном случае – гетероскедастична);

Гетероскедастичность (неравноточность оценок по оси аргумента) является одним из наиболее нежелательных и, силу этого, специальными приемами обеспечиваемых свойств в прикладной статистике и в эконометрике.

Потребление

0

доход

3. M ei e j 0 - некоррелированность невязок;

4. e ~ N (0, S )

M b

0

0

D b0 min;

M b1 1

- несмещенность, эффективность оценок

D

b

min;

1

44

Множественная линейная регрессия

Y b0 b1x1 b2 x2 ... b j x j ... b x ,

k k

где x j - факторы (объясняющие переменные); Y - показатель (объясняемая

переменная); b j j 1, k - коэффициенты регрессии, определяемые при помощи МНК (через СЛАУ – k 1 - порядка).

Коэффициенты b j имеют разную размерность и поэтому не сравнимы

друг с другом. Для сравнения степени влияния различных факторов испольS

зуют стандартизированный коэффициент регрессии j : j b j x .

Sy

x y

Коэффициент эластичности j b j

y

говорит о том, что при откло-

нении данного фактора от средней величины на 1% (при постоянстве других

факторов), параметр Y отклоняется от своего среднего значения на j %.

Возможна точечная и интервальная оценки точности b j .

Пример. Анализируется деятельность 16 с/х предприятий.

Валовой доход

Затраты

Доля

Надой

руб./га

труда че-

пашни,

молока

ловек,

%,

на 1

корову

день/га

кг

Y

x1

x

2

x3

1

704

265

451

3422

2

…

…

…

…

…

…

…

…

…

16

1138

267

38,8

5526

45

yiмодель b0 b1 x1i d 2 x2i b3 x3i ;

n 2

n

i

i

i 2

еi Q (b0 , b1 , b2 , b3 ) ( yi b0 b1 x1 b2 x2 b3 x3 ) ;

i 1

i 1

Q

b 0

0

Y 5, 26 x1 4,31 x2 0,166 x3 240

...

Q

b

b

b

b

0

1

2

3

0

b

3

;

Величина валового дохода на 1 га с/х угодий:

-в среднем увеличилась на 5,26 руб. при увеличении затрат на 1чел.ден/га;

-уменьшается в среднем на 4,31 руб. при увеличении доли пашни в угодьях на 1%;

-увеличивается на 0,166 руб. при росте надоя молока на 1 корову на 1 кг.

Отрицательное значение b сигнализирует о неблагополучии в экономике изуча2

емых хозяйств, где растениеводство убыточно, а прибыльно только животноводство.

Свободный член b выполняет роль доводки соотношения между средними вели0

чинами и экономического смысла не имеет. Самое сильное влияние на величину валового дохода оказывает фактор x3 - продуктивность коров.

Стандартизированные коэффициенты регрессии j и коэффициенты эластичности i для данной задачи равны сведены в следующую таблицу

i

i

x1

0,352

0,816

x

2

-0,206

-0,385

x3

669

0,996

Мера тесноты связи факторов - корреляционная матрица, используемая для предварительного отбора факторов для включения их в уравнение

регрессии

46

Y

x1

…

xj

…

x

k

Y

1

rx y

1

…

rx y

j

…

rx y

k

x1

ry x

1

1

…

rx x

j1

…

rx x

k 1

…

…

…

…

…

…

…

xj

ryx

j

rx x

1 j

…

1

…

rx x

k j

…

…

…

…

…

…

…

x

k

ryx

k

rx x

1k

…

rx x

j k

…

1

Не рекомендуется включать в уравнение регрессии факторы, слабо

связанные с показателем Y (в качестве критерия можно использовать неравенство | rxy | 0,5 ), но тесно связанные с другими факторами.

Например, мы имеем ryx 0,8 , ryx 0, 65, rx x 0,88 . Тогда фактор x

2

1

2

12

включать

не

следует,

т.к.

он

тесно

связан

(коллинеарен)

с

фактором

x1 :

x1 ax2 (a 0,88) .

Мультиколлинеарность – явление линейной связи между собой нескольких факторов. Если ее не устранить, то МНК не дает решения или решение неустойчиво. Неустойчивость означает существование изменения результатов решения при малом изменении выборки.

Коэффициент детерминации регрессий

Для линейной парной регрессии вводят критерий точности модели:

коэффициент детерминации

n 2

ei

i 1

где

ei Yi Y модел

модел

2

Y

b b x R 1 n

,

i

0 1

2

(Yi Y )

i 1

0 R 2 1. .

-

невязка;

47

Содержание R 2 : показывает отношение части вариации объясняемой

переменной за счет воздействия вариации факторов, входящих в уравнение

регрессии, к общей вариации объясняемой переменной относительно математического ожидания.

Для множественной линейной регрессии коэффициент детерминации

показывает степень тесноты связи всех входящих в уравнение регрессии

факторов с определяемой переменной Y .

*

2

, где

R

ryx ryx

ryx

0

1

2

k

1

1 rx x

ryx

ryx

12

1

k

rx x

rx x 1 rx x

ryx , 2 1

21

2 k

2

rx x

1k

rx x

2 k

1 ryx

k

rx x

1k

rx x

12

1

rx x

21

r

x xk

1

rx x

1k .

1

При помощи данной формулы можно определить R 2 , не вычисляя значений

Yi

модел

. При этом, если величина R 2 не удовлетворяет исследованию, то можно пре-

кратить вычисления Yi

модел

. Данное обстоятельство имеет значение, если выборка ве-

лика (сотни и тысячи наблюдений).

Для случая двух факторов коэффициент множественной детерминации

2 r 2 2r r r

ryx

yx

yx yx x x

2

2

2

1 2 12; .

вычисляется по формуле: R R yx x 1

2

12

1 rx x

12

Если R 2yx x 0.5765 - то, за счет вариации факторов x1, x2 объясняется

12

57,65% вариации Y .

Известны и более тонкие характеристики связи:

Используется коэффициент раздельной детерминации:

d 2j rx y j ,

j

где rx y - коэффициент парной корреляции, j - стандартизированный коэфj

фициент детерминации.

48

Например, если d 2 0.687 0.352 0.2418; d 2 0.355 (0.206) 0.0731;

1

2

d 2 0.878 0.664 0.5830, то можно утверждать, что за счет вариации x объясняется

3

1

24,18% вариации Y , а за счет вариации x - 7,31%, за счет вариации x - 58.3%.

3

2

k 2

2

dj R .

j 1

Применяют и коэффициент частной детерминации с корректируемым

коэффициентом детерминации.

Кроме количественных факторов могут рассматриваться и неколичественные (качественные).

Например, рассмотренная выше зависимость потребления (спроса на благо) может

определяться не только доходом потребителей, но и вкусами, национальными, религиозными особенностями, полом, наличием образования и т.д.

Фиктивные переменные

Фиктивная (искусственная, двоичная) переменная (индикатор):

1 фактор действует

u

..

0 фактор недействует

Можно ввести и несколько фиктивных переменных при возможности

градации качественных факторов.

Пример: Пусть имеется 3 количественных фактора урожайности x2 , x3 и 3 природных зоны, которые существенно влияют на урожайность. Уравнение регрессии можно

представить в виде: Y a b1x1 b2 x2 b3 x3 b4u1 b5u2 .

Фиктивные пе-

Зоны

Опреде-

урожай-

ляемые

ности

факторы

x1

x

2

x3

u1

u

2

y1

x

11

x21

x31

0

0

y2

x12

x

11

x

11

0

0

1

Факторы

ременные

49

2

3

…

…

…

…

…

…

yn

1

x1n

1

x2n

1

x3n

1

0

0

yn 1

1

x

1(n 1)

1

x

2(n 1)

1

x

3(n 1)

1

1

0

…

…

…

…

…

…

yn n

1 2

x

1(n n )

1 2

x

2(n n )

1 2

x

3(n n )

1 2

1

0

yn n 1

1 2

x1(

n n 1)

1 2

x2(

n n 1)

1 2

x3(

n n 1)

1 2

0

1

…

…

…

…

…

…

yn n n

1 2 3

x

1(n n n )

1 2 3

x

2(n n n )

1 2 3

x

3(n n n )

1 2 3

0

1

Уравнения регрессии для зон: 1. Y a b x b x b x ;

11 2 2 3 3

2. Y a b1x1 b2 x2 b3 x3 b4u1 ;

3. Y a b x b x b x b u b5u .

11 2 2 3 3 4 1

2

Величина коэффициента b означает, что все единицы второй зоны при тех же

4

значениях количественных факторов, что и в первой зоне, будет иметь среднее значение

Y на b единиц > (<), чем в первой зоне.

4

Число фиктивных переменных должно быть на единицу меньше числа

градации факторов.

В ряде случаев статистическая связь может показывать так называемую «ложную корреляцию», когда и объясняемые переменные, и объясняющие переменные испытывают общее влияние от некоторого фактора,

например времени.

Пример «ложной корреляции»: Количество санаториев со временем

растет, как и количество студентов. rxy 0,98 какой правильный вывод

можно сделать?

50

Литература

1. Гмурман В.Е. Теория вероятностей и математическая статистика.

М.Высшая школа. 2003

2. Теория статистики/ Р.А. Шмойлова и др. М.: Финансы и статистика.

2004.

3. Елисеева И.И., Юзбашев М.М. Общая теория статистики. М.: Финансы и статистика. 2004.

4. Вентцель Е.С. Теория вероятности. (Любой год издания) И. Грекова.

Дамский мастер и др.

51