ТЕОРИЯ ВЕРОЯТНОСТЕЙ И МАТ. СТА- ТИСТИКА

advertisement

ТЕОРИЯ ВЕРОЯТНОСТЕЙ И МАТ. СТАТИСТИКА

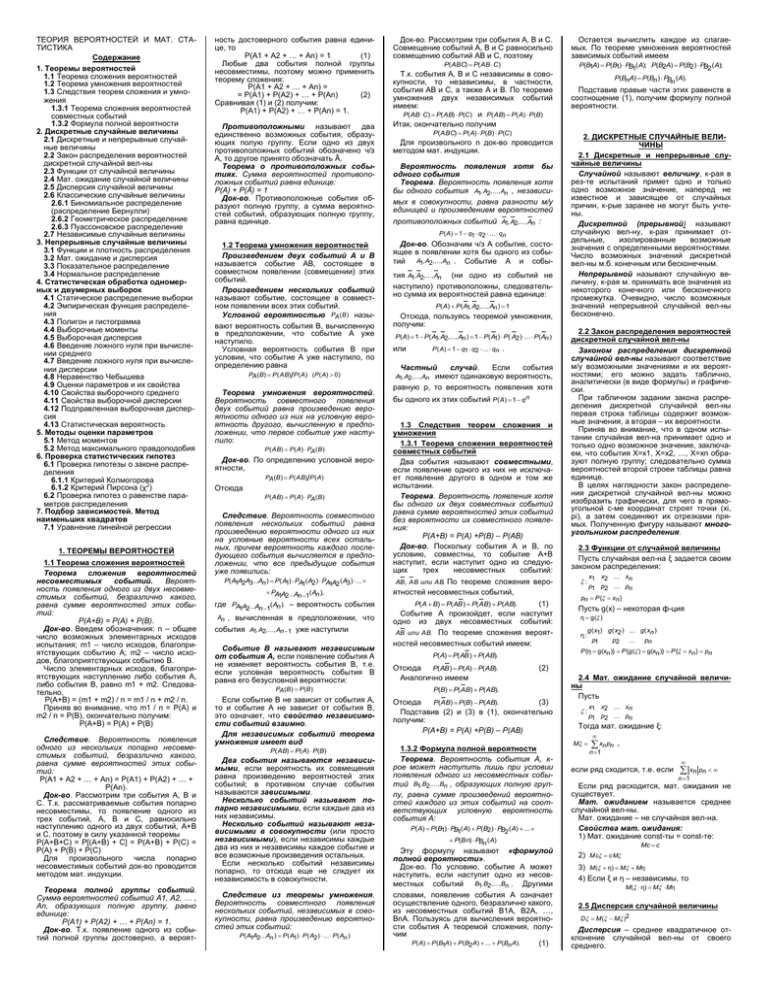

Содержание

1. Теоремы вероятностей

1.1 Теорема сложения вероятностей

1.2 Теорема умножения вероятностей

1.3 Следствия теорем сложения и умножения

1.3.1 Теорема сложения вероятностей

совместных событий

1.3.2 Формула полной вероятности

2. Дискретные случайные величины

2.1 Дискретные и непрерывные случайные величины

2.2 Закон распределения вероятностей

дискретной случайной вел-ны

2.3 Функции от случайной величины

2.4 Мат. ожидание случайной величины

2.5 Дисперсия случайной величины

2.6 Классические случайные величины

2.6.1 Биномиальное распределение

(распределение Бернулли)

2.6.2 Геометрическое распределение

2.6.3 Пуассоновское распределение

2.7 Независимые случайные величины

3. Непрерывные случайные величины

3.1 Функции и плотность распределения

3.2 Мат. ожидание и дисперсия

3.3 Показательное распределение

3.4 Нормальное распределение

4. Статистическая обработка одномерных и двумерных выборок

4.1 Статическое распределение выборки

4.2 Эмпирическая функция распределения

4.3 Полигон и гистограмма

4.4 Выборочные моменты

4.5 Выборочная дисперсия

4.6 Введение ложного нуля при вычислении среднего

4.7 Введение ложного нуля при вычислении дисперсии

4.8 Неравенство Чебышева

4.9 Оценки параметров и их свойства

4.10 Свойства выборочного среднего

4.11 Свойства выборочной дисперсии

4.12 Подправленная выборочная дисперсия

4.13 Статистическая вероятность

5. Методы оценки параметров

5.1 Метод моментов

5.2 Метод максимального правдоподобия

6. Проверка статистических гипотез

6.1 Проверка гипотезы о законе распределения

6.1.1 Критерий Колмогорова

6.1.2 Критерий Пирсона (χ2)

6.2 Проверка гипотез о равенстве параметров распределения

7. Подбор зависимостей. Метод

наименьших квадратов

7.1 Уравнение линейной регрессии

1. ТЕОРЕМЫ ВЕРОЯТНОСТЕЙ

1.1 Теорема сложения вероятностей

Теорема сложения вероятностей

несовместимых

событий.

Вероятность появления одного из двух несовместимых событий, безразлично какого,

равна сумме вероятностей этих событий:

P(A+B) = P(A) + P(B).

Док-во. Введем обозначения: n – общее

число возможных элементарных исходов

испытания; m1 – число исходов, благоприятствующих событию A; m2 – число исходов, благоприятствующих событию B.

Число элементарных исходов, благоприятствующих наступлению либо события A,

либо события B, равно m1 + m2. Следовательно,

P(A+B) = (m1 + m2) / n = m1 / n + m2 / n.

Приняв во внимание, что m1 / n = P(A) и

m2 / n = P(B), окончательно получим:

P(A+B) = P(A) + P(B)

Следствие. Вероятность появления

одного из нескольких попарно несовместимых событий, безразлично какого,

равна сумме вероятностей этих событий:

P(A1 + A2 + … + An) = P(A1) + P(A2) + … +

P(An).

Док-во. Рассмотрим три события A, B и

C. Т.к. рассматриваемые события попарно

несовместимы, то появление одного из

трех событий, A, B и C, равносильно

наступлению одного из двух событий, A+B

и C, поэтому в силу указанной теоремы

P(A+B+C) = P[(A+B) + C] = P(A+B) + P(C) =

P(A) + P(B) + P(C)

Для произвольного числа попарно

несовместимых событий док-во проводится

методом мат. индукции.

Теорема полной группы событий.

Сумма вероятностей событий A1, A2, … ,

An, образующих полную группу, равно

единице:

P(A1) + P(A2) + … + P(An) = 1.

Док-во. Т.к. появление одного из событий полной группы достоверно, а вероят-

ность достоверного события равна единице, то

P(A1 + A2 + … + An) = 1

(1)

Любые два события полной группы

несовместимы, поэтому можно применить

теорему сложения:

P(A1 + A2 + … + An) =

= P(A1) + P(A2) + … + P(An)

(2)

Сравнивая (1) и (2) получим:

P(A1) + P(A2) + … + P(An) = 1.

Противоположными называют два

единственно возможных события, образующих полую группу. Если одно из двух

противоположных событий обозначено ч/з

A, то другое принято обозначать Ā.

Теорема о противоположных событиях. Сумма вероятностей противоположных событий равна единице:

P(A) + P(Ā) = 1

Док-во. Противоположные события образуют полную группу, а сумма вероятностей событий, образующих полную группу,

равна единице.

Док-во. Рассмотрим три события А, В и С.

Совмещение событий А, В и С равносильно

совмещению событий АВ и С, поэтому

Остается вычислить каждое из слагаемых. По теореме умножения вероятностей

зависимых событий имеем

P( ABC) P( AB C)

P(B1A) P(B1) PB1( A); P(B2A) P(B2) PB2 ( A);

Т.к. события А, В и С независимы в совокупности, то независимы, в частности,

события АВ и С, а также А и В. По теореме

умножения двух независимых событий

имеем:

P( AB C) P( AB) P(C) и P( AB) P( A) P(B)

Итак, окончательно получим

P( ABC) P( A) P(B) P(C)

Для произвольного n док-во проводится

методом мат. индукции.

Вероятность появления хотя бы

одного события

Теорема. Вероятность появления хотя

бы одного события A1, A2,..., An , независимых в совокупности, равна разности м/у

единицей и произведением вероятностей

противоположных событий A1, A2,..., An :

P ( A) 1 q1 q2 ... qn

1.2 Теорема умножения вероятностей

Произведением двух событий А и В

называется событие АВ, состоящее в

совместном появлении (совмещении) этих

событий.

Произведением нескольких событий

называют событие, состоящее в совместном появлении всех этих событий.

Условной вероятностью PA (B ) называют вероятность события В, вычисленную

в предположении, что событие А уже

наступило.

Условная вероятность события В при

условии, что событие А уже наступило, по

определению равна

PA (B ) P ( AB) P ( A) (P ( A) 0)

Теорема умножения вероятностей.

Вероятность совместного появления

двух событий равна произведению вероятности одного из них на условную вероятность другого, вычисленную в предположении, что первое событие уже наступило:

P ( AB) P ( A) PA (B )

Док-во. По определению условной вероятности,

PA (B ) P ( AB) P ( A)

Отсюда

P ( AB) P ( A) PA (B )

Следствие. Вероятность совместного

появления нескольких событий равна

произведению вероятности одного из них

на условные вероятности всех остальных, причем вероятность каждого последующего события вычисляется в предположении, что все предыдущие события

уже появились:

P( A1A2A3...An ) P( A1) PA1( A2 ) PA1A2 ( A3 ) ...

PA1A2...An 1( An ),

где PA1A2...An 1( An ) – вероятность события

An

, вычисленная в предположении, что

события A1, A2, ..., An 1 уже наступили

Событие В называют независимым

от события А, если появление события А

не изменяет вероятность события В, т.е.

если условная вероятность события В

равна его безусловной вероятности:

PA (B ) P (B )

Если событие В не зависит от события А,

то и событие А не зависит от события В,

это означает, что свойство независимости событий взаимно.

Для независимых событий теорема

умножения имеет вид

P( AB) P( A) P(B)

Два события называются независимыми, если вероятность их совмещения

равна произведению вероятностей этих

событий; в противном случае события

называются зависимыми.

Несколько событий называют попарно независимыми, если каждые два из

них независимы.

Несколько событий называют независимыми в совокупности (или просто

независимыми), если независимы каждые

два из них и независимы каждое событие и

все возможные произведения остальных.

Если несколько событий независимы

попарно, то отсюда еще не слкдует их

независимость в совокупности.

Следствие из теоремы умножения.

Вероятность совместного появления

нескольких событий, независимых в совокупности, равна произведению вероятностей этих событий:

P ( A1A2...An ) P ( A1) P ( A2 ) ... P ( An )

Док-во. Обозначим ч/з А событие, состоящее в появлении хотя бы одного из событий A1, A2,..., An . Событие А и события A1, A2,..., An (ни одно из событий не

наступило) противоположны, следовательно сумма их вероятностей равна единице:

P( A) P( A1, A2,..., An ) 1

Отсюда, пользуясь теоремой умножения,

получим:

P( A) 1 P( A1, A2,..., An ) 1 P( A1) P( A2 ) ... P( An )

или

P ( A) 1 q1 q2 ... qn

.

Частный

случай.

Если

события

имеют одинаковую вероятность,

равную p, то вероятность появления хотя

A1, A2, ..., An

бы одного их этих событий P( A) 1 q n

1.3 Следствия теорем сложения и

умножения

1.3.1 Теорема сложения вероятностей

совместных событий

Два события называют совместными,

если появление одного из них не исключает появление другого в одном и том же

испытании.

Теорема. Вероятность появления хотя

бы одного их двух совместных событий

равна сумме вероятностей этих событий

без вероятности их совместного появления:

P(A+B) = P(A) +P(B) – P(AB)

Док-во. Поскольку события А и В, по

условию, совместны, то событие А+В

наступит, если наступит одно из следующих

трех

несовместных

событий:

AB , A B или AB. По теореме сложения вероятностей несовместных событий,

(1)

P( A B) P( AB ) P( A B) P( AB).

Событие А произойдет, если наступит

одно из двух несовместных событий:

AB или AB. По теореме сложения вероятностей несовместных событий имеем:

P(A) P(AB ) P(AB).

Отсюда

P(AB ) P(A) P(AB).

Аналогично имеем

2. ДИСКРЕТНЫЕ СЛУЧАЙНЫЕ ВЕЛИЧИНЫ

2.1 Дискретные и непрерывные случайные величины

Случайной называют величину, к-рая в

рез-те испытаний примет одно и только

одно возможное значение, наперед не

известное и зависящее от случайных

причин, к-рые заранее не могут быть учтены.

Дискретной (прерывной) называют

случайную вел-ну, к-рая принимает отдельные,

изолированные

возможные

значения с определенными вероятностями.

Число возможных значений дискретной

вел-ны м.б. конечным или бесконечным.

Непрерывной называют случайную величину, к-рая м. принимать все значения из

некоторого конечного или бесконечного

промежутка. Очевидно, число возможных

значений непрерывной случайной вел-ны

бесконечно.

2.2 Закон распределения вероятностей

дискретной случайной вел-ны

Законом распределения дискретной

случайной вел-ны называют соответствие

м/у возможными значениями и их вероятностями; его можно задать таблично,

аналитически (в виде формулы) и графически.

При табличном задании закона распределения дискретной случайной вел-ны

первая строка таблицы содержит возможные значения, а вторая – их вероятности.

Приняв во внимание, что в одном испытании случайная вел-на принимает одно и

только одно возможное значение, заключаем, что события X=x1, X=x2, …, X=xn образуют полную группу; следовательно сумма

вероятностей второй строеи таблицы равна

единице.

В целях наглядности закон распределения дискретной случайной вел-ны можно

изобразить графически, для чего в прямоугольной с-ме координат строят точки (xi,

pi), а затем соединяют их отрезками прямых. Полученную фигуру называют многоугольником распределения.

2.3 Функции от случайной величины

Пусть случайная вел-на ξ задается своим

законом распределения:

x x ... xn

: 1 2

p1 p2 ... pn

pn P { xn }

Пусть g(x) – некоторая ф-ция

η g( )

η:

g ( x1) g ( x2 ) ... g ( xn )

p1

p2

...

pn

P {η g(xn )} P {g ( ) g(xn )} P { xn } pn

(2)

P(B) P( A B) P( AB).

Отсюда

(3)

P( A B) P(B) P( AB).

Подставив (2) и (3) в (1), окончательно

получим:

P(A+B) = P(A) +P(B) – P(AB)

1.3.2 Формула полной вероятности

Теорема. Вероятность события А, крое может наступить лишь при условии

появления одного из несовместных событий B1, B2, ...,Bn , образующих полную группу, равна сумме произведений вероятностей каждого из этих событий на соответствующих условную вероятность

события А:

P( A) P(B1) PB1( A) P(B2 ) PB2 ( A) ...

P(Bn) PBn ( A)

P(BnA) P(Bn ) PBn (A).

Подставив правые части этих равенств в

соотношение (1), получим формулу полной

вероятности.

Эту формулу называют «формулой

полной вероятности».

Док-во. По условию, событие А может

наступить, если наступит одно из несовместных событий B1, B2, ...,Bn . Другими

словами, появление события А означает

осуществление одного, безразлично какого,

из несовместных событий B1A, B2A, …,

BnA. Пользуясь для вычисления вероятности события А теоремой сложения, получим

P ( A) P (B1A) P (B2A) ... P(Bn A).

(1)

2.4 Мат. ожидание случайной величины

Пусть

x x ... xn

: 1 2

p1 p2 ... pn

Тогда мат. ожидание ξ:

M

xn pn

,

n 1

если ряд сходится, т.е. если

xn pn

n 1

Если ряд расходится, мат. ожидания не

существует.

Мат. ожиданием называется среднее

случайной вел-ны.

Мат. ожидание – не случайная вел-на.

Свойства мат. ожидания:

1) Мат. ожидание const-ты = const-те:

Mc c

2) Mc c M

3) M ( η) M Mη

4) Если ξ и η – независимы, то

M ( η) M Mη

2.5 Дисперсия случайной величины

D M ( M )2

Дисперсия – среднее квадратичное отклонение случайной вел-ны от своего

среднего.

D M 2 (M )2

Свойства дисперсии:

1) D 0

2) D 0 тогда и только тогда, когда ξ =

const

3) D(c ) c 2D

4) D( η) D Dη 2 Cov( , η) ,

где Cov – коввариация

Cov( , η) M( , η) - M Mη

Пусть

ξ

Cov( , η) 0

и η – независимы,

и D( η) D Dη

тогда

2.6 Классические случайные величины

2.6.1 Биномиальное распределение

(распределение Бернулли)

Пусть производится n независимых испытаний, в каждом из к-рых событие А может

появиться, либо не появиться. Вероятность

наступления события во всех испытаниях

постоянна и равна p (следовательно,

вероятность непоявления q = 1 – p). Рассмотрим в качестве случайной вел-ны ξ

число появлений события А в этих испытаниях.

Требуется найти закон распределения

вел-ны ξ. Для этого требуется определить

возможные значения ξ и их вероятности.

Очевидно, событие А в n испытаниях

может либо не появиться, либо появиться 1

раз, либо 2 раза, …, либо n раз. Т.о., возможные значения ξ:

ξ1 = 0, ξ2 = 1, ξ3 = 2, …, ξn+1 = n.

Остается найти вероятности этих возможных значений, для чего достаточно

воспользоваться формулой Бернулли:

Pn (k ) Cnk pk q n k

,

где k=0, 1, 2, …, n.

Эта формула и является аналитическим

выражением искомого закона распределения.

Биномиальным называется распределение вероятностей, определяемое формулой Бернулли.

Напишем биномиальный закон в виде

таблицы:

n

n 1

...

k

...

0

: n

k pk q n k ... q n

p

npn 1q ... Cn

Математическое ожидание

M np

Дисперсия

D npq

2.6.2 Геометрическое распределение

А – событие

P(A) = p к каждом испытании

Испытания независимы и проводятся до

тех пор, пока событие А не наступило

ξ={число испытаний до появления

события А}

:

0 1

2 ... n

p qp q2p ... qn p

Математическое ожидание

M

q

D

q

p2

p

Дисперсия

2.6.3 Пуассоновское распределение

Случайная вел-на ξ имеет пуассоновское

распределение, если принимает значения

0, 1, 2, …, n с вероятностью

Pn e λ

λn

, λ0

n!

где λ – параметр распределения.

0

: λ

e

1

...

k

λk

λe λ ... e λ

k!

...

...

Математическое ожидание

M λ

Дисперсия

D λ

2.7 Независимые случайные величины

Пусть случайная вел-на ξ задается:

x x ... xn

: 1 2

p1 p2 ... pn

а случайная вел-на η –

y y

... y k

η: 1 2

p1 p2 ... pk

Случайные вел-ны ξ и η называются независимыми, если для любых n и k независимы явления

{ xn } и {η y k } :

P {( xn ) (η y k )} P { xn } P {η y k }

3. НЕПРЕРЫВНЫЕ СЛУЧАЙНЫЕ ВЕЛИЧИНЫ

3.1 Функции и плотность распределения

Ф-цией распределения называют ф-цию

F(x), определяющую вероятность того, что

случайная вел-на X в рез-те испытаний

примет значение, меньшее x, т.е.

F(x) = P(X < x)

Геометрически это равенство можно истолковать так: F(x) есть вероятность того,

что случайная вел-на примет значение, крае изображается на числовой оси точной,

лежащей левее точки x.

Теперь можно дать более точное определение непрерывной случайной вел-ны:

Случайную вел-ну называют непрерывной, если ее ф-ция распределения

есть

непрерывная,

кусочнодифференцируемая ф-ция с непрерывной

производной.

Свойства ф-ции распределения:

Свойство 1. Значение ф-ции распределения принадлежит отрезку [0; 1]:

0 <= F(x) <= 1

Свойство 2. F(x) – неубывающая ф-ция,

т.е.

F(x2) >= F(x1), если x2 > x1.

Следствие 1. Вероятность того, что

случайная вел-на примет значение, заключенное в интервале (a, b), равна приращению ф-ции распределения на этом интервале:

P(a <= X < b) = F(b) – F(a)

Следствие 2. Вероятность того, что непрерывная случайная вел-на X примет

одно определенное значение, равна нулю.

Свойство 3. Если возможные значения

случайной вел-ны принадлежат интервалу

(a, b), то:

1) F(x) = 0 при x <= a

2) F(x) = 1 при x >= b

Следствие. Если возможные значения

непрерывной случайной вел-ны расположены на всей оси x, то справедливы следующие предельные соотношения:

lim F ( x ) 0

lim F( x ) 1

x

x

Непрерывную случайную вел-ну можно

также задать, используя другую ф-цию, крую называют плотностью распределения

или плотностью вероятности.

Плотность распределения вероятностей непрерывной случайной вел-ны Х

называют ф-цию f(x) – первую производную

от ф-ции распределения F(x):

f(x) = F’(x)

Для описания распределения дискретной

случайной вел-ны плотность распределения неприменима.

Теорема. Вероятность того, что непрерывная случайная вел-на Х примет

значение, принадлежащее интервалу (a,

b), равна определенному интегралу от

плотностей распределения, взятому в

пределах от a до b:

b

P(a X b) f ( x )dx

a

Геометрически теорему м. истолковать

так: вероятность того, что непрерывная

случайная вел-на примет значение, принадлежащее интервалу (a, b), равна площади криволинейной трапеции, ограниченной осью Ox, кривой распределения f(x) и

прямыми x = a и x = b.

Зная плотность распределения f(x), можно найти ф-цию распределения F(x) по

формуле:

x

F(x)

f ( x )dx

Свойства плотности распределения

Свойство 1. Плотность распределения

– неотрицательная ф-ция:

f (x) 0 .

Геометрически это св-во означает, что

точки, принадлежащие графику плотности

распределения, располагаются либо над

осью Ox, либо на этой оси.

Свойство 2. Несобственный интеграл от

плотности распределения в пределах от –∞

до ∞ равен единице:

f ( x )dx 1

3.2 Мат. ожидание и дисперсия

Математическим ожиданием непрерывной случайной величины X, возможные

значения к-рой принадлежат отрезку [a, b],

называют определенный интеграл

b

M( X ) x f ( x )dx.

a

Если возможные значения принадлежат

всей оси Ox, то

M( X )

x f ( x )dx.

Дисперсией непрерывной случайной

величины называют математическое ожидание ее отклонения.

Если возможные значения Х принадлежат отрезку [a, b], то

b

D( X ) [ x M( X )]2 f ( x )dx;

a

если возможные значения принадлежат

всей оси Х, то

D( X )

2

[x M( X )] f ( x )dx.

Среднее квадратичное отклонение непрерывной случайной величины определяется равенством:

( X ) D( X )

3.3 Показательное распределение

Показательным (экспоненциальным)

называют распределение вероятностей,

которое описывается дифференциальной

ф-цией

0,

x0

f (x)

λx , x 0

λe

где λ – постоянная положительная вел-на.

Математическое ожидание

M

1

λ

Дисперсия

D

1

λ2

3.4 Нормальное распределение

N (a, b2 ) имеет нормальное распределе-

ние, если

f (x)

1

e

( x a )2

2b 2

2b2

Математическое ожидание

M a

Дисперсия

D b 2

4. СТАТИСТИЧЕСКАЯ ОБРАБОТКА ОДНОМЕРНЫХ И ДВУМЕРНЫХ ВЫБОРОК

Выборочной совокупностью или просто выборкой называют совокупность

случайно отобранных объектов.

Генеральной совокупностью называют совокупность объектов, из к-рых производится выборка.

Объемом совокупности (выборочной

или генеральной) называют число объектов

этой совокупности.

Повторной называют выборку, при крой отобранный объект (перед отбором

следующего) возвращается в генеральную

совокупность.

Бесповторной называют выборку, при

к-рой отобранный объект в генеральную

совокупность не возвращается.

4.1 Статическое распределение выборки

Пусть из генеральной совокупности извлечена выборка, причем х1 наблюдалось

n1 раз, x2 – n2 раз, xk – nk раз и ∑ni = n –

объем выборки.

Наблюдаемые значения xi называются

вариантами, а последовательность вариант, записанных в возрастающем порядке,

– вариационным рядом.

Числа наблюдений называются частотами, а их отношение к объему выборки ni

/ n = Wi – относительными частотами.

Статистическим

распределением

выборки называют перечень вариант и

соответствующих им частот или относительных частот. Статистическое распределение можно задать также в виде последовательности интервалов и соответствующих им частот (в качестве частоты, соответствующей интервалу, принимают сумму

частот, попавших в этот интервал).

4.2 Эмпирическая функция распределения

Эмпирической ф-цией распределения

(ф-цией распределения выборки) называют

ф-цию F*(x), определяющую для каждого

значения х относительную частоту события

Х < х:

F * ( x ) nx n ,

где nx – число вариант, меньших х; n –

объем выборки.

В отличие от эмпирической ф-ции распределения выборки ф-цию распределения

F(x) генеральной совокупности называют

теоретической ф-цией распределения.

Свойства ф-ции F*(x):

1) значения эмпирической ф-ции принадлежат отрезку [0, 1];

2) F*(x) – неубывающая ф-ция;

3) если х1 – наименьшая варианта, то

F*(x)=0 при x<=x1; если xk – наибольшая

варианта, то F*(x)=1 при x>xk.

Итак, эмпирическая ф-ция распределения выборки служит для оценки теоретической ф-ции распределения генеральной

совокупности.

4.3 Полигон и гистограмма

Полигоном частот называют ломанную, отрезки к-рой соединяют точки (x1;

n1), (x2; n2), …, (xk; nk). Для построения

полигона частот на оси абсцисс откладывают варианты xi, а на оси ординат – соответствующие им частоты ni. Точки (xi; ni)

соединяют отрезками прямых и получают

полигон частот.

Полигоном относительных частот

называют ломанную, отрезки к-рой соединяют точки (x1; W1), (x2; W2), …, (xk; Wk).

Для построения полигона относительных

частот на оси абсцисс откладывают варианты xi, а на оси ординат – соответствующие им относительные частоты Wi. Точки

(xi; Wi) соединяют отрезками прямых и

получают полигон относительных частот.

В случае непрерывного признака целесообразно строить гистограмму, для чего

интервал, в к-ром заключены все наблюдаемые значения признака, разбивают на

несколько частичных интервалов длиной h

и находят для каждого частичного интервала ni – сумму частот вариант, попавших в iй интервал.

Гистограммой частот называют ступенчатую фигуру, состоящую из прямоугольников, основаниями к-рых случат

частичные интервалы длиной h, а высоты

равны отношению ni / h (плотность частоты).

Для построения гистограммы частот на

оси абсцисс откладывают частичные интервалы, а над ними проводят отрезки,

параллельные оси асцисс на расстоянии ni

/ h.

Площадь i-го частичного прямоугольника

равна h*ni/h = ni – сумме частот i-го интервала; следовательно, площадь гистограммы частот равна сумме всех

частот, т.е. объему выборки.

Гистограммой относительных частот называют ступенчатую фигуру,

состоящую из прямоугольников, основаниями к-рых случат частичные интервалы

длиной h, а высоты равны отношению Wi /

h (плотность относительно частоты).

Для построения гистограммы частот на

оси абсцисс откладывают частичные интервалы, а над ними проводят отрезки,

параллельные оси асцисс на расстоянии

Wi / h. Площадь i-го частичного прямоугольника равна h*Wi/h = Wi – относительной частоте вариант, попавших в i-й интервал.

Следовательно, площадь гистограммы относительных частот равна

сумме всех относительных частот,

т.е. единице.

4.4 Выборочные моменты

Пусть имеются экспериментальные данные x1, x2, …, xn. Первый выборочный

момент:

m1

1 n

n

1 n

1 n

xi x ; m2 n xi2 ; m3 n xi3 ;

i 1

i 1

i 1

mk

1 n k

xi

n

i 1

4.5 Выборочная дисперсия

1 n 2

Sn2 m2 ( x )2

xi ( x )2

n

i 1

Выборочная дисперсия всегда положительна.

4.6 Введение ложного нуля при вычислении среднего

Экспериментальные данные х1, х2, …, хn

Вводим новые переменные

x C

,

yi i

h

где С – ложный нуль (новое начало отсчета); h – шаг, т.е. разность м/у любыми

двумя соседними первоначальными вариантами (новая ед-ца масштаба.

Формула связи м/у x и y следующая:

x hy C

4.7 Введение ложного нуля при вычислении дисперсии

Экспериментальные данные х1, х2, …, хn

Вводим новые переменные

x C

,

yi i

h

где С – ложный нуль (новое начало отсчета); h – шаг, т.е. разность м/у любыми

двумя соседними первоначальными вариантами (новая ед-ца масштаба.

Формула

щая:

м/у Sn2( x ) и Sn2( y ) следую-

связи

Sn2 ( x ) h2 Sn2 ( y )

4.8 Неравенство Чебышева

Вероятность того, что случайная вел-на ξ

по модулю больше чем C, меньше или

M 2

M 2

равняется

: P { C}

C2

C2

4.9 Оценки параметров и их свойства

Дан какой-то параметр Θ (м.б. случайным, а м.б. постоянным), к-рый надо измерить.

ξ1, ξ2, …, ξn – случайная вел-на, описывающая 1, 2, …, n наблюдение.

Θn(ξ1, ξ2, …, ξn) – ф-ция от случайных

вел-н; всегда случайная, т.к. построена на

наблюдениях.

Свойства оценок:

1) Несмещенность. Оценка Θn для параметра Θ называется несмещенной, если

математическое ожидание Θn равно Θ, т.е.

MΘn = Θ.

2) Состоятельность. Оценка Θn для параметра Θ называется состоятельной, если

для любого ε > 0

Пример. Геометрическое распределение, p

–?

M

q

p

Оценка Sn2 является смещенной:

n 1 2

MSn2

σ , т.е. MSn2 σ 2

n

но она является состоятельной.

4.12 Подправленная выборочная дисперсия

M

n

n 1

2 σ2 ; Sˆ 2

Sn

n

n

n 1

2 ; MSˆ 2 σ 2

Sn

n

Sˆn2

– подправленная оценка. Она является несмещенной и состоятельной.

4.13 Статистическая вероятность

P(A) = p – ?

Проводим эксперименты и смотрим

наступило событие А или нет:

ξ1, ξ2, …, ξn

n ( A)

– статистическая вероятность

p*

n

n (A ) – число экспериментов, в к-рых

событие А наступило.

n (A ) = 0,1,2, …, k, …, n

pk Cnk pk q n k

Математическое ожидание и дисперсия

x;

p

(1,...,k )

Dn ( A) npq

:

0 1 ...

n

F ( x, p)

pqn

p – ? (требуется оценить)

2) ξ – пуассоновское

0 1 ...

б) ξ – непрерывная с плотностью f(x):

:

3) ξ – равномерное

1

: f (x) b a

, x [a, b]

F ( x, a, b)

0, x [a, b]

5.1 Метод моментов

– если 1 параметр неизвестен

M m1

M 2 m2

– если 2 параметра неизвестны

Предположим, что наша гипотеза верна.

Тогда

α – уровень значимости, тогда

n

lnf ( xi )

i 1

η

P{

методу максимального правдоподобия.

Пример. ξ – пуассоновское распределение

1 2Ф(Cα ) α

λ xi λ

P { xi }

e

(xi )!

Ф(Cα )

( Ф( x )

2

x y

e 2 dy

1

xy x y

;

kˆ

x 2 ( x )2

)

2 0

2

Wn {i , ηi :

1 n

1 n

λ

λ

xi n 0

i 1

1 n

n

Y ( x) kˆ( x x ) y

6.1 Проверка гипотезы о законе распределения

По наблюдениям (ξ1, ξ2, …, ξn) мы делаем предположение, что ξ есть F(x).

6.1.1 Критерий Колмогорова

По экспериментальным данным строим

F*(x). Затем строим

n sup F ( x ) F * ( x ) Dn

x

где F(x) –теоретическая ф-ция распределения,

sup – максимальная разница.

n

P {Dn C } P {D C }

Находим по таблице пороговое число Сα:

P {D C } α

nSn2( )

~ 2

n 1

σ2

1

2 (η)

mSm

~ 2

m 1

σ2

2

η

2 (η)

1

nS2( ) mS m

( n

)

nm2

σ12

σ2

2

что

~ Sn m 2

σ2 σ2 σ2 ,

1

2

тогда

сократим σ2. Остается

η

(

1

1

1

2 (η))

)

(nSn2( ) mSm

n m nm2

~ Sn m 2

P { Sn m 2 Cα } α ; Cα – находится по таб-

це

η

Cα }

W :{

(

1 1

1

2 (η))

)

(nSn2 ( ) mS m

n m nm2

2) H {σ12 σ22}

nSn2( )

~ 2

n 1

σ2

1

2 (η)

mSm

~ 2

m 1

σ2

2

Поделим одну дробь на другую:

nSn2 ( )

σ2

1

~ Fn 1, m 1 – распределение Фи2 (η)

mS m

2

σ

2

шера

Предположим, что наша гипотеза верна,

тогда сократим σ2. Остается

nSn2( )

~ Fn 1, m 1

k (n np )2

i

i

i 1

Свойства коэффициента регрессии:

1) 1 rxy 1

σ12 σ 2

2

n

m

Предположим,

2 (η)

mS m

npi

Пусть F(x) содержит несколько параметров (пусть r), тогда

lim P {Pn x} P {k2 r 1 x}

n

где P {k2r 1 Cα} α

6.2 Проверка гипотез о равенстве параметров распределения

Пусть имеются экспериментальные данные ξ1, ξ2, …, ξn, независимые м/у собой и

имеющие нормальный закон распределения с параметрами i ~ N(a1, σ21 ) .

Имеются величины η1, η2, …, ηm, независимые от ξ и ηi ~ N(a2, σ22) .

1) H = {a1 = a2} – гипотеза

P {Fn 1, m 1 Cα} α ; Cα – находится по таб-

це

W :{

xy x y

Sn2( x ) Sn2( y )

2 (η)

nSn2( ) mSm

2

n

m 1

σ12

σ2

2

ni n

Составим сумму

rxy

По свойству χ2-распределения имеем

A1 A2 ... Ak

n1 n2 ... nk

p1 p2 ... pk

H = {ξ ~ F(x)} – гипотеза

Cα }

а) σ12, σ22 – неизвестны

Wn {(1,...2 ) {Dn Cα }}

6.1.2 Критерий Пирсона ( 2 )

Вся область возможных значений разбита на множества A1, А2, …, Аk:

η

σ2 σ2

1 2

n

m

xi x

i 1

6. ПРОВЕРКА СТАТИСТИЧЕСКИХ ГИПОТЕЗ

К статистическим гипотезам относятся гипотезы, основанные на наблюдениях.

α – уровень значимости – это вероятности тех событий, к-рыми для данного

эксперимента можно пренебречь.

Wn – критическая область – это область, при попадании наблюдений в к-рую

сделанную гипотезу нужно отвергнуть.

Pn

xy x y

bˆ y (

) x

x 2 ( x )2

Коэффициент регрессии:

n

n

( λ) ln λ xi ( xi )! nλ

i 1

i 1

xi 0 n ;

i 1

– частные производ-

Y ( x ) kˆx bˆ

Y ( x ) kˆx y kˆx

1- α

ln P { xi } xi ln λ ln(xi )!( λ)

( λ)

минимум – оценки, полученные по методу

наименьших квадратов.

Существует минимум в определенном

классе зависимостей, например линейная

зависимость.

ные

Отсюда находим (ˆ 1, ˆ 2,..., ˆ k ) .

7.1 Уравнение линейной регрессии

Y(x) = kx + b

Cα } α

σ2 σ2

1 2

n

m

*1,...,*k – оценка параметров 1,...,k по

min

1,...,k

ˆ

ˆ ,...,

ˆ ) – точка, в к-рой достигается

(1,

2

k

0

1 0

1

...

...

0

k

0

k

~ N (0,1)

σ2 σ2

1 2

n

m

max (1,...,k ) ;

1,...,k

Wn { xi : Pn Cα }

n

λn λ F ( x, λ)

e

n!

σ2 σ2

η ~ N(a1 a2, 1 2 )

n

m

η

ln p{ xi }

i 1

(1,...,k )

σ2

η ~ N(a2, 2 )

m

η 0

pk P { Ak }

5. МЕТОДЫ ОЦЕНКИ ПАРАМЕТРОВ

Пусть ф-ция распределения F(x, Θ1, …,

Θk) зависит от нескольких параметров.

1) Предположим, что случайная вел-на, крую мы наблюдаем имеет геометрическое

распределение:

2

n

n

n

(Y ( x, 1, 2,..., k ) yi )2

i 1

ˆ ,

ˆ

ˆ

(1, 2,...,k ) (

1 2,...,k ) min

(1, 2, ..., k )

σ

~ N(a1, 1 )

1 x

pk p{ zk }

Mn ( A) np

p* – несмещенная и состоятельная оценка

x; 1 p px; p*

Тогда составляется ф-ция

λ*

4.11 Свойства выборочной дисперсии

p

а) σ12, σ22 – известны

1

z z ... zk

: 1 2

4.10 Свойства выборочного среднего

lim P { n a ε} 0

n

;

1 p

5.2 Метод максимального правдоподобия

а) ξ – дискретная

lim P { n ε} 0

n

1) Оценка несмещенная: M a

2) Оценка состоятельна:

q

nSn2( )

Cα }

2 (η)

mS m

7. ПОДБОР ЗАВИСИМОСТЕЙ. МЕТОД

НАИМЕНЬШИХ КВАДРАТОВ

x1 x2 ... xn

y1 y 2 ... y n

Y(x) – теоретическая зависимость y от x.

Подбираем Y, чтобы следующая сумма

была минимальной:

n

(Y ( xi ) yi )2 min

i 1

Y(x) = kx + b – подбираем k и b

Y(x) = ax2+bx+c – подбираем a, b, c

Y ( x, 1, 2, ..., k )

2) rxy 1 зависимость м/у x и y в точности линейная

Коэффициент регрессии служит критерием линейной зависимости. Если по модулю

он близок к 1, то линейная зависимость

хорошо аппроксимирует данное явление.