Количество информации Информация Виды информации:

advertisement

Количество информации

Информация - это сведения об окружающем нас мире.

Виды информации:

1. Текстовая - представленная на каком-либо из существующих языков, например, book английский язык.

2. Числовая - представленная в виде цифр, например, 1,2,3...

3. Графическая - картины, фотографии, чертежи, схемы и т.д.

4. Звуковая - все, что слышит человек, например, человеческая речь, музыка, пение птиц.

5. Видеоинформация - последовательность изображений, например, фильмы,

мультфильмы.

Требования к информации:

1. Понятна.

2. Полезна.

3. Точна.

4. Достоверна.

5. Актуальна.

6. Полная.

Количество информации как мера уменьшения неопределенности знания.

(Содержательный подход к определению количества информации)

Процесс познания окружающего мира приводит к накоплению информации в форме

знаний (фактов, научных теорий и т. д.). Получение новой информации приводит к

расширению знаний или, как иногда говорят, к уменьшению неопределенности знания.

Если некоторое сообщение приводит к уменьшению неопределенности нашего знания, то

можно говорить, что такое сообщение содержит информацию.

Например, после сдачи зачета или выполнения контрольной работы вы мучаетесь

неопределенностью, вы не знаете, какую оценку получили. Наконец, учитель объявляет

результаты, и вы получаете одно из двух информационных сообщений: "зачет" или

"незачет", а после контрольной работы одно из четырех информационных сообщений: "2",

"3", "4" или "5".

Информационное сообщение об оценке за зачет приводит к уменьшению

неопределенности вашего знания в два раза, так как получено одно из двух возможных

информационных сообщений. Информационное сообщение об оценке за контрольную

работу приводит к уменьшению неопределенности вашего знания в четыре раза, так как

получено одно из четырех возможных информационных сообщений.

Ясно, что чем более неопределенна первоначальная ситуация (чем большее

количество информационных сообщений возможно), тем больше мы получим новой

информации при получении информационного сообщения (тем в большее количество раз

уменьшится неопределенность знания).

Количество информации можно рассматривать как меру уменьшения

неопределенности знания при получении информационных сообщений.

Рассмотренный выше подход к информации как мере уменьшения неопределенности

знания позволяет количественно измерять информацию. Существует формула, которая

связывает между собой количество возможных информационных сообщений N и

количество информации I, которое несет полученное сообщение:

N = 2i

(1.1)

Бит. Для количественного выражения любой величины необходимо сначала

определить единицу измерения. Так, для измерения длины в качестве единицы выбран

метр, для измерения массы - килограмм и т. д. Аналогично, для определения количества

информации необходимо ввести единицу измерения.

За единицу количества информации принимается такое количество информации,

которое содержится в информационном сообщении, уменьшающем неопределенность

знания в два раза. Такая единица названа битом.

Если вернуться к рассмотренному выше получению информационного сообщения о

результатах зачета, то здесь неопределенность как раз уменьшается в два раза и,

следовательно, количество информации, которое несет сообщение, равно 1 биту.

Производные единицы измерения количества информации. Минимальной

единицей измерения количества информации является бит, а следующей по величине

единицей - байт, причем:

1 байт = 8 битов = 23 битов.

В информатике система образования кратных единиц измерения несколько отличается

от принятых в большинстве наук. Традиционные метрические системы единиц, например

Международная система единиц СИ, в качестве множителей кратных единиц используют

коэффициент 10n, где n = 3, 6, 9 и т. д., что соответствует десятичным приставкам "Кило"

(103), "Мега" (106), "Гига" (109) и т. д.

В компьютере информация кодируется с помощью двоичной знаковой системы, и

поэтому в кратных единицах измерения количества информации используется

коэффициент 2n

Так, кратные байту единицы измерения количества информации вводятся следующим

образом:

1 килобайт (Кбайт) = 210 байт = 1024 байт;

1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт;

1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

Контрольные вопросы

1. Приведите примеры информационных сообщений, которые приводят к уменьшению

неопределенности знания.

2. Приведите примеры информационных сообщений, которые несут 1 бит информации.

Определение количества информации

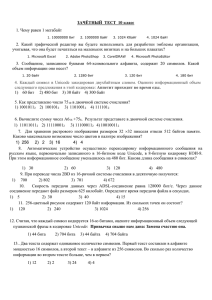

Определение количества информационных сообщений. По формуле (1.1) можно

легко определить количество возможных информационных сообщений, если известно

количество информации. Например, на экзамене вы берете экзаменационный билет, и

учитель сообщает, что зрительное информационное сообщение о его номере несет 5 битов

информации. Если вы хотите определить количество экзаменационных билетов, то

достаточно определить количество возможных информационных сообщений об их

номерах по формуле (1.1):

N = 25 = 32.

Таким образом, количество экзаменационных билетов равно 32.

Определение количества информации. Наоборот, если известно возможное

количество информационных сообщений N, то для определения количества информации,

которое несет сообщение, необходимо решить уравнение относительно I.

Представьте себе, что вы управляете движением робота и можете задавать

направление его движения с помощью информационных сообщений: "север", "северовосток", "восток", "юго-восток", "юг", "юго-запад", "запад" и "северо-запад" (рис. 1.11).

Какое количество информации будет получать робот после каждого сообщения?

Рис. 1.4. Управление роботом с использованием информационных сообщений

Всего возможных информационных сообщений 8, поэтому формула (1.1) принимает

вид уравнения относительно I:

8 = 2I.

Разложим стоящее в левой части уравнения число 8 на сомножители и представим его

в степенной форме:

8 = 2 × 2 × 2 = 23 .

Наше уравнение:

23 = 2I.

Равенство левой и правой частей уравнения справедливо, если равны показатели

степени числа 2. Таким образом, I = 3 бита, т. е. количество информации, которое несет

роботу каждое информационное сообщение, равно 3 битам.

Алфавитный подход к определению количества информации

При алфавитном подходе к определению количества информации отвлекаются от

содержания информации и рассматривают информационное сообщение как

последовательность знаков определенной знаковой системы.

Информационная емкость знака. Представим себе, что необходимо передать

информационное сообщение по каналу передачи информации от отправителя к

получателю. Пусть сообщение кодируется с помощью знаковой системы, алфавит которой

состоит из N знаков {1, ..., N}. В простейшем случае, когда длина кода сообщения

составляет один знак, отправитель может послать одно из N возможных сообщений "1",

"2", ..., "N", которое будет нести количество информации I (рис. 1.5).

Рис. 1.5. Передача информации

Формула (1.1) связывает между собой количество возможных информационных

сообщений N и количество информации I, которое несет полученное сообщение. Тогда в

рассматриваемой ситуации N - это количество знаков в алфавите знаковой системы, а I количество информации, которое несет каждый знак:

N = 2I.

С помощью этой формулы можно, например, определить количество информации,

которое несет знак в двоичной знаковой системе:

N = 2 => 2 = 2I => 21 = 2I => I=1 бит.

Таким образом, в двоичной знаковой системе знак несет 1 бит информации.

Интересно, что сама единица измерения количества информации "бит" (bit) получила свое

название ОТ английского словосочетания "Binary digiT" - "двоичная цифра".

Информационная емкость знака двоичной знаковой системы составляет 1 бит.

Чем большее количество знаков содержит алфавит знаковой системы, тем большее

количество информации несет один знак. В качестве примера определим количество

информации, которое несет буква русского алфавита. В русский алфавит входят 33 буквы,

однако на практике часто для передачи сообщений используются только 32 буквы

(исключается буква "ё").

С помощью формулы (1.1) определим количество информации, которое несет буква

русского алфавита:

N = 32 => 32 = 2I => 25 = 2I => I=5 битов.

Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном

подходе к измерению количества информации).

Количество информации, которое несет знак, зависит от вероятности его получения.

Если получатель заранее точно знает, какой знак придет, то полученное количество

информации будет равно 0. Наоборот, чем менее вероятно получение знака, тем больше

его информационная емкость.

В русской письменной речи частота использования букв в тексте различна, так в

среднем на 1000 знаков осмысленного текста приходится 200 букв "а" и в сто раз меньшее

количество буквы "ф" (всего 2). Таким образом, с точки зрения теории информации,

информационная емкость знаков русского алфавита различна (у буквы "а" она

наименьшая, а у буквы "ф" - наибольшая).

Количество информации в сообщении. Сообщение состоит из последовательности

знаков, каждый из которых несет определенное количество информации.

Если знаки несут одинаковое количество информации, то количество информации Ic в

сообщении можно подсчитать, умножив количество информации Iз, которое несет один

знак, на длину кода (количество знаков в сообщении) К:

Ic = Iз × K

Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит.

Следовательно, две цифры несут информацию в 2 бита, три цифры - в 3 бита и т. д.

Количество информации в битах равно количеству цифр двоичного компьютерного кода

(табл. 1.1).

Задачи по теме "Количество информации"

Пример 1. В коробке 32 карандаша, все карандаши разного цвета. Наугад вытащили

красный. Какое количество информации при этом было получено?

Решение.

Так как вытаскивание карандаша любого цвета из имеющихся в коробке 32 карандашей

является равновероятным, то число возможных событий равно 32.

N = 32, I = ?

N = 2I, 32 = 25, I = 5 бит.

Ответ: 5 бит.

Пример 2.В коробке 50 шаров, из них 40 белых и 10 чёрных. Определить количество

информации в сообщении о вытаскивании наугад белого шара и чёрного шара.

Решение.

Вероятность вытаскивания белого шара

P1 = 40/50 = 0,8

Вероятность вытаскивания чёрного шара

P2 = 10/50 = 0,2

Количество информации о вытаскивании белого шара I1 = log2(1/0,8) = log21,25 =

log1,25/log2 = 0,32 бит

Количество информации о вытаскивании чёрного шара I2 = log2(1/0,2) = log25 = log5/log2 »

2,32 бит

Ответ: 0,32 бит, 2,32 бит

Пример 3. В озере живут караси и окуни. Подсчитано, что карасей 1500, а окуней 500. Сколько информации содержится в сообщениях о том, что рыбак поймал карася,

окуня, поймал рыбу?

Решение.

События поимки карася или окуня не являются равновероятными, так как окуней в озере

меньше, чем карасей.

Общее количество карасей и окуней в пруду 1500 + 500 = 2000.

Вероятность попадания на удочку карася

p1 = 1500/2000 = 0,75, окуня p2 – 500/2000 = 0,25.

I1 = log2(1/p1), I1 = log2(1/p2), где I1 и I2 – вероятности поймать карася и окуня

соответственно.

I1 = log2(1 / 0,75) = 0,43 бит, I2 = log2(1 / 0,25) = 2 бит – количество информации в

сообщении поймать карася и поймать окуня соответственно.

Количество информации в сообщении поймать рыбу (карася или окуня) рассчитывается

по формуле Шеннона

I = - p1log2p1 - p2log2p2

I = - 0,75*log20,75 - 0,25*log20,25 = - 0,75*(log0,75/log2)-0,25*(log0,25/log2) =

= 0,604 бит = 0.6 бит.

Ответ: в сообщении содержится 0,6 бит информации.

Пример 4. Какое количество информации несет в себе сообщение о том, что нужная вам

программа находится на одной из восьми дискет?

Решение.

Количество информации вычисляется по формуле: 2i = N, где i - искомая величина, N количество событий. Следовательно, 23 =8.

Ответ:3 бита.

Пример 5. Заполнить пропуски числами:

а) 5 Кбайт = __ байт = __ бит,

б) __ Кбайт = __ байт = 12288 бит;

в) __ Кбайт = __ байт = 2 13 бит;

г) __Гбайт =1536 Мбайт = __ Кбайт;

д) 512 Кбайт = 2__ байт = 2__ бит.

Решение.

а) 5 Кбайт = 5120 байт =40 960 бит,

б) 1,5 Кбайт = 1536 байт = 12 288 бит;

в) 1 Кбайт = 210 байт = 213 бит;

г) 1,5 Гбайт = 1536 Мбайт = 1 572 864 Кбайт;

д) 512 Кбайт = 219 байт = 222 бит.

Пример 6. Какова мощность алфавита, с помощью которого записано сообщение,

содержащее 2048 символов, если его объем составляет 1/512 часть одного мегабайта?

Решение.

1) 1/512 Мб * 1024 = 2 Кб * 1024 = 2048 байт

2) К = 2048 символов, следовательно, i = 1 байт = 8 бит

3) 2i = N; 28 = 256 символов

Ответ:1) 1/512 Мб * 1024 = 2 Кб * 1024 = 2048 байт

2) К = 2048 символов, следовательно, i = 1 байт = 8 бит

3) 2i = N; 28 = 256 символов.

Пример 7.Книга, набранная с помощью компьютера, содержит 150 страниц; на

каждой странице - 40 строк, в каждой строке - 60 символов. Каков объем информации в

книге?

Решение.

Мощность компьютерного алфавита равна 256. Один символ несет 1 байт информации.

Значит, страница содержит 40*60=2400 байт информации. Объем всей информации в

книге: 2400*150 = 360 000 байт.

Ответ:360 000 байт.

Пример 8. Для передачи секретного сообщения используется код, состоящий из

десяти цифр. При этом все цифры кодируются одним и тем же (минимально возможным)

количеством бит. Определите информационный объем сообщения длиной в 150 символов.

Решение.

Для кодировки одной из 10 цифр необходимо 4 бита. Это получаем из 23 < 10 < 24. Объём

150 символов получим 150*4=600(бит).

Ответ:600 бит.

Пример 9.В кодировке Unicode на каждый символ отводится два байта. Определите

информационный объем слова из двадцати четырех символов в этой кодировке.

Решение.

I= K*i; I = 24*2 байт = 48 байт = 48*8бит = 384 бит.

Ответ:384 бита.

Пример 10.В рулетке общее количество лунок равно 128. Какое количество

информации мы получаем в зрительном сообщения об остановке шарика в одной из

лунок?

Решение.

Количество информации вычисляется по формуле: 2i = N, где i - искомая величина, N количество событий.

2i=128. Следовательно, i=7.

Ответ:7 бит.