МЕТОД ПОВЫШЕНИЯ ЧУВСТВИТЕЛЬНОСТИ НЕЙРОННЫХ

advertisement

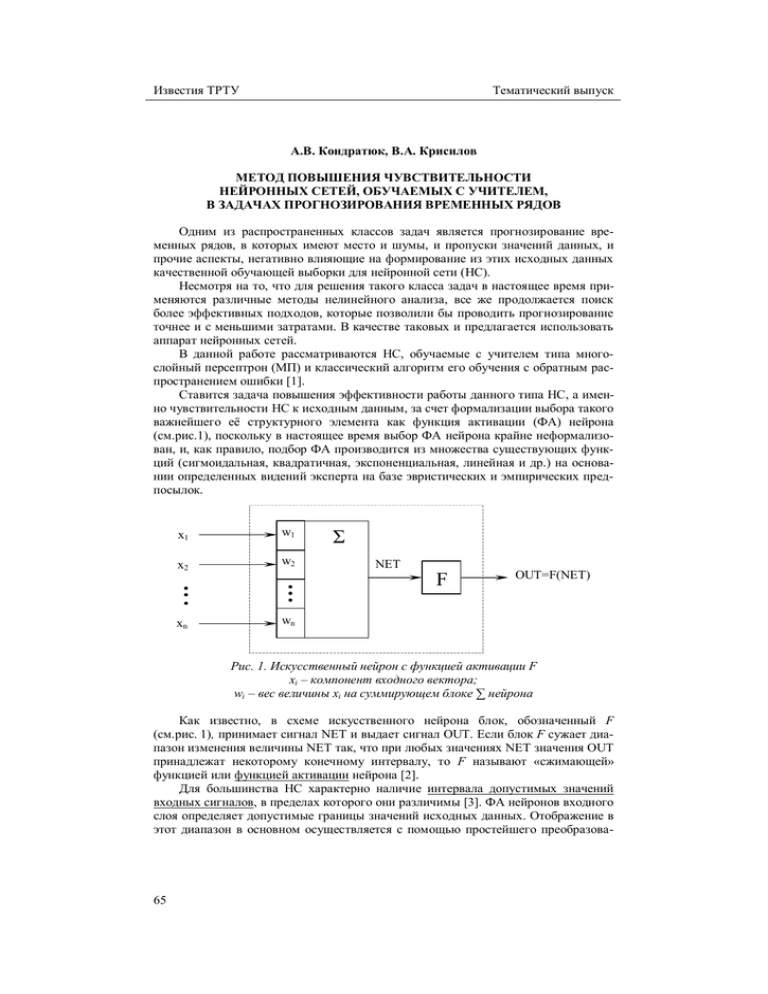

Известия ТРТУ Тематический выпуск А.В. Кондратюк, В.А. Крисилов МЕТОД ПОВЫШЕНИЯ ЧУВСТВИТЕЛЬНОСТИ НЕЙРОННЫХ СЕТЕЙ, ОБУЧАЕМЫХ С УЧИТЕЛЕМ, В ЗАДАЧАХ ПРОГНОЗИРОВАНИЯ ВРЕМЕННЫХ РЯДОВ Одним из распространенных классов задач является прогнозирование временных рядов, в которых имеют место и шумы, и пропуски значений данных, и прочие аспекты, негативно влияющие на формирование из этих исходных данных качественной обучающей выборки для нейронной сети (НС). Несмотря на то, что для решения такого класса задач в настоящее время применяются различные методы нелинейного анализа, все же продолжается поиск более эффективных подходов, которые позволили бы проводить прогнозирование точнее и с меньшими затратами. В качестве таковых и предлагается использовать аппарат нейронных сетей. В данной работе рассматриваются НС, обучаемые с учителем типа многослойный персептрон (МП) и классический алгоритм его обучения с обратным распространением ошибки [1]. Ставится задача повышения эффективности работы данного типа НС, а именно чувствительности НС к исходным данным, за счет формализации выбора такого важнейшего её структурного элемента как функция активации (ФА) нейрона (см.рис.1), поскольку в настоящее время выбор ФА нейрона крайне неформализован, и, как правило, подбор ФА производится из множества существующих функций (сигмоидальная, квадратичная, экспоненциальная, линейная и др.) на основании определенных видений эксперта на базе эвристических и эмпирических предпосылок. x1 w1 x2 w2 xn wn Σ NET F OUT=F(NET) Рис. 1. Искусственный нейрон с функцией активации F xi – компонент входного вектора; wi – вес величины xi на суммирующем блоке ∑ нейрона Как известно, в схеме искусственного нейрона блок, обозначенный F (см.рис. 1), принимает сигнал NET и выдает сигнал OUT. Если блок F сужает диапазон изменения величины NET так, что при любых значениях NET значения OUT принадлежат некоторому конечному интервалу, то F называют «сжимающей» функцией или функцией активации нейрона [2]. Для большинства НС характерно наличие интервала допустимых значений входных сигналов, в пределах которого они различимы [3]. ФА нейронов входного слоя определяет допустимые границы значений исходных данных. Отображение в этот диапазон в основном осуществляется с помощью простейшего преобразова- 65 Известия ТРТУ Тематический выпуск ния на этапе предобработки [3] – нормализации, однако при этом не учитываются статистические характеристики исходных данных, что уменьшает информативность исходных данных, а это ведет к большим значениям погрешности. В случае игнорирования статистических характеристик исходных данных допустимый диапазон используется неэффективно [4]. В нем присутствуют как слабо заполненные участки, так и участки скученности значений исследуемой случайной величины (СВ). Слабо заполненные участки приводят к тому, что в процессе обучения НС плохо «запоминает» эти значения. А участки скученности, где на относительно небольших отрезках располагается значительное количество значений исходной величины, оказываются слабо различимыми. Точки как бы сливаются на этих участках, что также приводит к снижению качества обучения. Таким образом, происходит снижение чувствительности НС к значениям исходных данных, следовательно, и их информативности, а это в свою очередь негативно сказывается на точности получаемого результата. На основании вышесказанного можно обозначить следующие пути решения данной проблемы. 1. Повышение чувствительности НС за счет изменения параметров ФА нейронов входного и выходного слоёв НС. 2. Повышение чувствительности НС за счет преобразования самих значений исходных данных с целью «подгонки» их закона распределения к необходимому, определяемому ФА нейрона. Перечисленные пути по своей сути подходят к решению описанной проблемы с противоположных сторон. Целесообразность первого обуславливается тем, что изменение параметров ФА нейронов является однократным вмешательством в структурный синтез НС на этапе настройки перед этапом обучения НС, в то время как второй повлечет за собой необходимость вмешательства в структуру исходных данных, что само по себе требует веских обоснований правомочности, а также (после окончания работы НС) процедуры восстановления исходного формата данных (обратного преобразования), при котором не избежать ошибки дискретизации, поскольку чаще всего имеем дело с дискретными значениями исходных данных. Таким образом, возникла необходимость в разработке метода, учитывающего статистические характеристики исследуемой СВ на этапе её предобработки. Данный метод направлен на то, чтобы «сжать» с помощью измененной ФА нейронов входного слоя весь диапазон значений исходного временного ряда (ВР) в заданный интервал. При этом учитывается закон распределения исходного ВР, что позволит сохранить информативность значений исходных данных в большей степени, чем при стандартных подходах, не учитывающих статистические характеристики. Было замечено некоторое соответствие между ФА нейрона и функцией закона распределения СВ. К примеру, наиболее часто применяемая в задачах прогнозирования ВР сигмоидальная (1) ФА нейрона (см. рис.2) при определенных значениях коэффициента α повторяет график функции нормального распределения некоторой СВ c достаточно высокой точностью (см. рис.3). Однако наблюдается некоторое смещение по координатной сетке. Интервал допустимых значений входных сигналов должен соответствовать интервалу зоны чувствительности функции активации нейрона, которая определяется эмпирически как [a, b] (см. рис.2). 66 Известия ТРТУ Тематический выпуск f (x) F0 (x) 1 1/2 0,5 0 x x a 0 Рис. 2. График сигмоидальной ФА нейрона b - 1/2 Рис. 3. График функции нормального распределения некоторой СВ Отсюда можно сделать предположение о том, что сигмоидальная ФА нейрона будет обладать максимальной чувствительностью к значениям ВР только в том случае, если исходный ВР имеет нормальный закон распределения. Продолжая аналогию между видом распределения значений исходного ВР и соответствующим ему типом ФА, можно логически заключить, что линейная ФА нейрона будет обладать максимальной чувствительностью к значениям ВР только в том случае, если данный ВР имеет равномерный закон распределения. На основании вышеизложенного выдвинута гипотеза о том, что в роли ФА нейронов входного слоя НС должна выступать функция распределения значений исходного ВР, определенным образом отмасштабированная под специфику тех или иных исходных данных. В этом случае появляется возможность с максимальной чувствительностью НС к исходным данным «сжать» с помощью ФА весь диапазон значений исходного ВР в заданный интервал с учетом статистических характеристик исходного ВР. Предлагаемый на базе данной гипотезы метод заключается в том, чтобы перед началом обучения НС подстроить параметры ФА нейронов входного слоя к конкретным исходным данным, учитывая функцию закона распределения значений этого исходного ВР, поскольку она является исчерпывающей статистической характеристикой любой СВ. Данное действие является однократным вмешательством в структурный синтез НС на этапе настройки. Метод позволяет гибко подстраивать параметры ФА нейрона под функцию распределения конкретного ВР. Суть метода можно изложить в следующих принципах. 1. Для сокращения потерь информативности исходных данных на этапе их предобработки необходимо учитывать их статистические характеристики. 2. Учёт статистических характеристик исходных данных необходимо производить однократно на этапе настройки перед этапом параметрического синтеза НС путем применения в нейронах входного слоя специальным образом подготовленной ФА. 3. Подготовку ФА следует производить на основании анализа статистических характеристик исходных данных. Необходимо выявить функцию распределения исследуемой СВ, а затем уже в соответствии с ней подстроить ФА нейронов входного слоя. 67 Известия ТРТУ Тематический выпуск 4. Под подстройкой ФА следует понимать её масштабирование и сдвиг в соответствии с полученной функцией распределения с целью её соответствия требованиям рабочего диапазона ФА нейрона. 5. Для каждой отдельной задачи подбор ФА выполняется индивидуально, что позволяет не потерять информативность данных по сравнению с применением одной унифицированной ФА для целого класса задач (например, сигмоидальной), как это происходит в настоящее время в подавляющем большинстве случаев [1]. 6. В случае работы с дискретными СВ следует производить дополнительную обработку при подготовке ФА, используя вместо функции распределения СВ многоугольник ее распределения, в соответствии с положениями теории вероятностей [5]. Формализация выбора ФА нейрона подразумевает формализацию трех её основных характеристик: - вид ФА нейрона; - кривизну (наклон) ФА нейрона; - ограничения области значений ФА нейрона. В данной работе сделана попытка формализовать первую характеристику ФА нейронов для всех слоев НС типа МП. Рекомендации по выбору ФА в нейронах входного слоя НС заключаются в использовании специальным образом подготовленной уникальной для каждой отдельной задачи ФА, учитывающей распределение значений исходных данных конкретной задачи с целью учета их статистических характеристик, и, следовательно, сохранения их информативности. Как было сказано выше, для исходных данных, имеющих нормальный закон распределения значений, наиболее эффективной является сигмоидальная ФА f ( x) = 1 , 1 + e - ax (1) где α – коэффициент, определяющий кривизну функции. Из выражения (1) очевидно, что выходное значение нейрона лежит в диапазоне (0,1). Что касается скрытого и выходного слоев НС, то исходят из рассуждений о том, что на выходе каждого нейрона входного слоя НС наблюдается некоторое неизвестное нам распределение, которое изменяется динамически на каждой итерации обучения НС. Кроме того, в многослойной НС с последовательными связями, которой и является МП, данные, пройдя ФА нейронов нескольких слоев, видоизменяют распределения своих значений от нейрона к нейрону во времени и в неизвестной последовательности. Поэтому однозначно указать в пользу выбора той или иной ФА для нейронов скрытого или выходного слоев представляется весьма затруднительной задачей. Однако, учитывая вышесказанное, заметим, что с высокой долей вероятности можно утверждать, что ФА для нейронов этих слоев должны быть одинаковы, поскольку процессы видоизменения распределений величин в них одни и те же. Итак, относительно выбора вида ФА для скрытого и выходного слоев выдвинем следующее предположение, проведя некоторую аналогию с известным принципом теории вероятностей. Нормальное распределение возникает в тех случаях, когда складывается много независимых (либо слабо зависимых) случайных величин Х1, Х2, ... , Хп (на практике более 7-10), причём эти величины сравнимы по порядку своего влияния на рассеивание суммы 68 Известия ТРТУ Тематический выпуск X = n åX i . (2) i=1 Тогда, каковы бы ни были законы распределения отдельных величин Х1, Х2,..., Хп, закон распределения их суммы Х будет близок к нормальному (причём тем ближе, чем больше число слагаемых п). Последнее заключение представляет собой, в грубых чертах, содержание центральной предельной теоремы теории вероятностей [6]. Понимая под величиной Хi распределение на выходе некоторого i-го нейрона, который независим от других и, в то же время, входит в состав многослойной НС с последовательными связями типа МП и сравним по порядку своего влияния на результат с остальными нейронами в этой НС, можно выдвинуть гипотезу о том, что вид распределения на выходе каждого отдельного нейрона, а тем более слоя, будет стремиться к нормальному, причем более приближаясь к нормальному при возрастании количества слоев, т.е. на выходе нейронов выходного слоя будет распределение, максимально близкое к нормальному. Следовательно, наиболее эффективной ФА в нейронах скрытого и выходного слоёв будет сигмоидальная ФА (1). Эффективность предложенных нововведений была подтверждена предварительными экспериментальными исследованиями в задачах прогнозирования финансовых временных рядов на международном валютном рынке FOREX и показала выигрыш в скорости обучения НС в среднем на 19-23% при сохранении качества обучения. Предложенные особенности настройки ФА позволили повысить чувствительность НС к исходным данным, а следовательно, и различающую способность, что способствует лучшему сохранению информативности исходных данных, благодаря чему получены лучшие показатели качества работы НС в целом. Итак, в работе подведен некоторый итог по формализации выбора основной характеристики ФА нейрона относительно всех слоев НС, обучаемой с учителем. Формализация основана на выявлении и учете статистических характеристик исходных данных с целью обеспечения сохранности их информативности для минимизации погрешности результата в задачах прогнозирования временных рядов. БИБЛИОГРАФИЧЕСКИЙ СПИСОК 1. 2. 3. 4. 5. 6. 69 Хайкен С. Нейронные сети: полный курс, 2-е изд., испр. / Пер. с англ.– М.: ООО «И.Д.Вильямс», 2006.- 1104 с.: ил. С.219-225. Уоссерман Ф. Нейрокомпьютерная техника: теория и практика. М.: Мир, 1992. С.42. Миркес Е.М. Нейроинформатика: Учеб. пособие для студентов. Красноярск: ИПЦ КГТУ, 2002. Крисилов В.А., Кондратюк А.В., Чумичкин К.В. Преобразование входных данных нейросети с целью повышения информативности их значений в задачах прогнозирования временных рядов // Інтелектуальні системи прийняття рішень та прикладні аспекти інформаційних технологій // Матеріали науково-практичної конференції. Том 5. Херсон: Видавництво Херсонського морського інституту, 2005. С.46-49. http://www.chair36.msiu.ru/education/hf/1-hf/slides/04/slide_013.html http://mschool.kubsu.ru/ms/1.htm