анализ ограничений традиционных искусственных нейронных

advertisement

АНАЛИЗ ОГРАНИЧЕНИЙ ТРАДИЦИОННЫХ ИСКУССТВЕННЫХ

НЕЙРОННЫХ СЕТЕЙ ПРИ ОБРАБОТКЕ ИЗОБРАЖЕНИЙ И

РАСПОЗНАВАНИИ ОБРАЗОВ

Потапов А.С.*, Свитенков А.И.**

* ГОИ им. С.И. Вавилова, Санкт-Петербург, e-mail: pas.aicv@gmail.com

** СПбГУ ИТМО, Санкт-Петербург

Проведено рассмотрение искусственных нейронных сетей (ИНС) как представления

алгоритмов, а их обучения – как поиска в пространстве алгоритмов, которое для

существующих ИНС оказывается неполным. Установлено свойство «гладкости

метрики» в этом пространстве как основное преимущество ИНС в машинном обучении.

Благодаря использованию критерия минимальной длины описания выявлена связь

обучаемости и компактности представления алгоритмов инвариантной и адаптивной

обработки изображений, обуславливающая поиск новых нейросетевых представлений.

Введение

Искусственные нейронные сети (ИНС) являются популярным подходом в

области машинного обучения и восприятия. Традиционно им приписываются свойства

самообучения, самоорганизации, способности к обработке образной информации в

противовес обычным алгоритмам, которые также традиционно считаются жестко

заданными, необучаемыми и предназначенными для обработки символьной

информации. Казалось бы, в иконике должны превалировать нейросетевые методы,

однако ИНС систематически используются лишь в признаковом распознавании

образов, а их применение при обработке и распознавании изображений весьма

эпизодично. При этом они больше используются не столько в прикладных системах,

сколько для моделирования отдельных элементов зрительного тракта. Широко

распространены, например, модели клеток зрительной коры в приложении к

текстурной сегментации, нейросетевые модели стереопсиса, выделения контуров и т.д.

Однако все эти модели зачастую не обладают основной декларируемой особенностью

ИНС – обучаемостью (исключение составляет разве что неокогнитрон Фукусимы).

Интересно, что многие архитектуры ИНС имеют предпосылки в области

восприятия. Даже первая ИНС – перцептрон Розенблатта – исходно предназначалась

для распознавания изображений и была предложена как модель сетчатки. Создание

модели ИНС в рамках теории адаптивного резонанса Гроссберга также было

мотивировано исследованиями в области зрительного и слухового восприятия. Однако

эти, как и другие архитектуры ИНС не решили общей проблемы распознавания

изображений, а применяются в основном в признаковом распознавании образов.

В настоящее время все более пристальное внимание в области автоматического

анализа изображений уделяется проблемам обучения. В связи с этим снова актуальным

становится вопрос о возможности создания (обучаемых) нейросетевых алгоритмов

обработки и распознавания изображений. Для ответа на этот вопрос требуется понять

причины как предыдущих неудач нейросетевого подхода в иконике, так и

популярности ИНС в области машинного обучения и распознавания образов, что и

составляет предмет рассмотрения в настоящей статье.

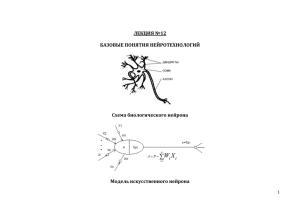

Эквивалентность ИНС и УМТ

Принципиальный вопрос, возникающий при реализации (обучаемых)

алгоритмов обработки и распознавания изображений с помощью ИНС, заключается в

том, является ли формализм ИНС столь же выразительным, как и формализм машины

323

Тьюринга (или любое эквивалентное ему математическое определение алгоритма). Еще

МакКаллоком и Питтсом в 1943 году была доказана возможность реализации любой

логики высказываний с помощью предложенной ими модели нейронов. В 1956 году

Клини также было дано доказательство возможности построения эквивалента любого

конечного автомата (КА) с помощью ИНС. Конечные автоматы, однако, являются

наиболее ограниченным (из широко используемых) подклассом алгоритмов.

Впоследствии большее внимание уделялось возможности функциональной

аппроксимации с помощью ИНС. В частности, А.Н. Колмогоровым в 1957 году была

доказана теорема о представлении функций многих переменных композицией функций

одной переменной. Позднее была доказана возможность аппроксимации любой

(гладкой) функции трехслойным перцептроном с достаточным числом нейронов [1].

Данные теоремы, однако, напрямую не указывают на эквивалентность ИНС и МТ.

Сравнительно недавно были предложены доказательства такой эквивалентности

[2]. Существуют даже свидетельства о том, что множество ИНС мощнее, чем МТ.

Необходимо понять, за счет чего достигается эквивалентность или превосходство.

Расширение класса КА до уровня МТ возможно только за счет введения

неограниченного хранилища данных (потенциально бесконечной ленты, стека и т.д.).

Действительно, эквивалентность ИНС и МТ обычно достигается двумя путями [2]:

либо рассмотрением ИНС, содержащих бесконечное число нейронов, либо

рассмотрением конечных ИНС, нейроны которых обладают бесконечной

(неограниченной) памятью. Рассмотрим оба варианта.

Неограниченная память формального нейрона может достигаться в

предположении, что уровень текущей активности может представляться рациональным

числом p/q, где p и q – натуральные числа. Неограниченное возрастание значений p и q

при сохранении ограничения на значение их отношения создает возможность

"хранения" в значении активности нейрона битовой стоки неограниченной длины.

Интересно, что операции над p и q как над стеками можно реализовать с помощью

практически традиционных моделей формальных нейронов в рекуррентных ИНС [2].

Более высокая мощность ИНС по сравнению с УМТ может быть достигнута,

если величину активности нейрона считать вещественным числом, определяемым с

бесконечной точностью. При этом каждый нейрон за один такт оказывается способным

обрабатывать бесконечно длинные бинарные строки. Оба этих варианта, хотя и

представляют теоретический интерес, являются биологически и технически

неправдоподобными, поскольку требуют неограниченной или бесконечной точности

воспроизведения сигналов нейронов. Любой минимальный шум будет приводить к

полному изменению функционирования сети, что существенно затруднит ее обучение.

Нейронные сети бесконечного размера также выглядят неправдоподобно.

Следует подчеркнуть принципиальную разницу между неограниченной (но фактически

конечной для любого конечного алгоритма, функционирующего конечное время)

лентой МТ и актуально бесконечным числом нейронов в ИНС, эквивалентных МТ.

Интересно, что в указанных двух случаях реализуется эквивалентность МТ и

ИНС без обучения при фиксированной архитектуре. Можно было бы связать

достижение этой эквивалентности именно с процессом обучения, в ходе которого не

просто происходит модификация имеющихся связей в ИНС, но также и установление

новых связей с нейронами из некоторого неограниченного пула. Если, однако,

алгоритм обучения является произвольным и внешним по отношению к ИНС, то факт

эквивалентности МТ и ИНС (как надстройки над МТ) не представляет интереса.

Следует заметить, что возможность реализации с помощью ИНС произвольной

МТ означает и возможность реализации с их помощью универсальной МТ (УМТ). По

сути, это означает, что такая "универсальная" ИНС может эмулировать работу любой

324

другой ИНС по ее описанию. Вполне естественно, чтобы универсальность ИНС

достигалась добавлением обучения. Тогда это будет просто означать, что в процессе

обучения может быть построена любая ИНС.

При обсуждении ИНС и МТ мы наталкиваемся на два противоречия. Во-первых,

"самообучаемые" ИНС обучаются зачастую внешними традиционными (и

биологически неправдоподобными) алгоритмами, что вызывает вопрос, в чем же

именно преимущество ИНС перед обычными (символьными) алгоритмами. Во-вторых,

если обеспечивать эквивалентность МТ и ИНС без обучения, то не вполне понятно, что

именно дает обучение. Оба этих противоречия, видимо, нужно устранять

одновременно, для чего нужно разобраться, в чем именно привлекательность ИНС в

задачах обучения.

Обучение как поиск в алгоритмическом пространстве

Нас интересует такой процесс обучения, в ходе которого строится алгоритм

обработки или распознавания изображений. Мы рассматриваем данный процесс как

поиск в пространстве алгоритмов. В теории искусственного интеллекта вводится

понятие эвристики как приема или метода сокращения перебора, и рассматриваются

различные алгоритмы от "жадных" (в которых перемещение от некоторого начального

решения осуществляется в направлении его наискорейшего локального улучшения) до

полного перебора. "Жадный" поиск является наиболее быстрым, однако из-за

немонотонности критерия качества решения имеет тенденцию "застревать" в

локальных экстремумах. Если в качестве решения выступает некоторый алгоритм,

малое изменение которого приводит к существенному изменению его

функционирования, любой критерий качества (например, качества распознавания)

будет существенно немонотонным (и даже не будет непрерывным). Для построения

практически пригодных методов обучения осуществляется параметризация

алгоритмов. При этом малое изменение параметров ведет к малому изменению

функционирования алгоритма, что делает оптимизируемые критерии почти всюду

непрерывными. Такая параметризация, однако, выполняется человеком ad hoc, а

параметрические семейства алгоритмов оказываются очень узкими.

ИНС, по сути, являются "тотально параметризованным" представлением

алгоритмов с достаточно гладкой метрикой. Именно это свойство ИНС, по нашему

мнению, и создает впечатление способности ИНС к обучению. В этом смысле,

достижение алгоритмической полноты ИНС путем кодирования неограниченных

битовых строк в значениях активности нейронов хотя и формально возможно, но

практически бессмысленно, поскольку оно разрушает "гладкость метрики". Таким

образом, при достижении эквивалентности ИНС и МТ, равно как и при других

модификациях ИНС следует стремиться сохранить это свойство.

Например, возможность построения некоторой "универсальной" ИНС, которая

бы могла формировать конкретные ИНС по их описанию, равно как добавление в ИНС

некоторой способности к самоинтерпретации, означает возможность перевода

информации с уровня активности нейронов на уровень управления весами их связей.

Традиционно для этих целей используется внешний алгоритм обучения, имеющий

доступ к глобальной информации об ИНС. Более правдоподобны локальные правила

обучения типа правила Хебба, однако их возможности сильно ограничены.

Напрашивается идея вводить идентификаторы нейронов, по которым можно было бы

осуществлять адресацию этих нейронов и связей между ними. Введение таких

идентификаторов предлагается, в частности, в модели семантических нейронных сетей.

При этом, однако, может заметно уменьшиться "гладкость метрики", в связи с чем

возможность адресации нейронов следует вводить с большой осторожностью.

325

Другой подход к реализации "внутреннего" обучения ИНС развивается в рамках

формализма нейроглиальных сетей (ИНГС), в которых рассматривается модель

трехстороннего синапса, образованного не только пре- и постсинаптическими

нейронами, но также и глиальной клеткой, управляющей проводимостью синапса. В

отличие от модулирующих нейронов влияние активности глиальной клетки на синапс

не мгновенно, что можно связать с действием механизмов обучения, а не адаптации. С

помощью глиальных клеток можно реализовать многие классические алгоритмы

обучения ИНС. При этом сохраняется "гладкость метрики" в пространстве

искусственных нейроглиальных сетей, о чем свидетельствует эффективность методов

построения таких сетей генетическими алгоритмами. Однако сама структура ИНГС в

ходе обучения остается неизменной, что накладывает очевидные ограничения на

гибкость этого подхода: обучение здесь оказывается поиском в узком параметрическом

семействе нейросетевых алгоритмов.

Если ИНС уже задают такую "гладкую метрику", облегчающую сходимость к

глобальному оптимуму процесса обучения, пусть даже и реализованного внешним

алгоритмом (в совокупности с которым ИНС эквивалентна УМТ), то в чем тогда цель

модификации формализма ИНС? Для ответа на этот вопрос нужно уточнить смысл

критерия оптимальности результата обучения.

Нейросетевые представления алгоритмов анализа изображений

Распознавание – одна из традиционных областей применения ИНС. Однако еще

сам Розенблатт, хотя и доказал возможность обучения перцептрона за конечное число

шагов распознаванию любых различимых стимулов, но отметил его ограниченную

обобщающую способность. Позднее Минский и Паперт показали, в чем именно

заключается такая ограниченность: перцептрон не может обнаружить инварианты (за

исключением тривиальных). К примеру, если распознаваемый символ меняет свое

положение на сетчатке, то для успешного распознавания в обучающую выборку

необходимо включить все положения этого символа. При этом существенно

увеличивается размер не только обучающей выборки, но и самого перцептрона. На

практике это часто проявляется как эффект переобучения.

Конечно, поиск произвольных инвариантов означает обучение в алгоритмически

полном пространстве, что в настоящее время недоступно никаким методам обучения.

Однако большой размер ИНС характерен и для более простых задач. Рассмотрим, к

примеру, сопоставление наборов ключевых точек, найденных на двух изображениях.

Пусть {(xi, yi)}и {(x'i, y'i)} – соответствующие наборы. Если между точками допускается

только преобразование сдвига, то эту задачу несложно решить с помощью следующей

рекуррентной сети. Пусть сеть состоит из нейронов ni,j, каждый из которых поставлен в

соответствие некоторой паре (xi, yi) – (x'j, y'j), которая задает преобразование сдвига

между изображениями ∆x = x'j – xi, ∆y = y'j – yi. Между парой нейронов будет

возбуждающая связь, если они задают близкие значения преобразования сдвига, в

противном случае связь будет тормозящей. При правильном подборе весов связей сеть

будет сходиться к состоянию, в котором останутся активными нейроны, задающие

непротиворечивые сопоставления наибольшего подмножества точек. Как обобщить эту

ИНС для случая, когда координаты точек связаны преобразованием подобия? Здесь

уже соответствия между парами точек задают преобразование. Можно каждому

парному соответствию назначить свой нейрон, но размер такой сети будет уже

чрезвычайно большим (для ста точек это будет полносвязная сеть из 108 нейронов и

1016 связей). Придумать компактную ИНС, которая бы решала эту задачу, непросто.

Если же оставить нейроны ni,j, то для двух нейронов нельзя будет определить характер

их влияния друг на друга, так как возбуждать или тормозить данный нейрон другие

326

нейроны смогут только попарно. Это можно реализовать, например, сделав нейрон не

линейным, а квадратичным сумматором (со смешанными произведениями). Небольшое

усложнение нейрона может приводить к существенному упрощению сети.

В качестве еще одного примера можно привести задачу адаптивной фильтрации

изображения. В частности, давно существуют нейрофизиологические данные,

подтверждающие возможность модифицировать веса связей «на лету», без обучения.

Это т.н. "синапсы на синапсах", характерные для модулирующих нейронов.

Использование модулирующих нейронов позволяет существенно уменьшить ИНС,

исключив дублирование реализации фильтра при разных значениях его управляющего

параметра.

Размер сети напрямую связан с обучением. Это, в частности, следует из

принципа минимальной длины описания (МДО): лучшей моделью является модель, для

которой достигается минимум суммы длины описания данных с помощью этой модели

и длины самой модели. Данный принцип непосредственно применяется при обучении

ИНС (в качестве примера см. [3]). Увеличение размера ИНС может приводить к

улучшению ее работы на обучающей выборке и ухудшению – на новых образах, чего

можно избежать при использовании принципа МДО.

Нами был предложен принцип репрезентационной МДО, согласно которому

критерий длины описания зависит от способа представления данных, а оптимальное

представление находится путем минимизации суммарной длины описаний множества

объектов (например, изображений) и самого представления [4]. В контексте настоящей

статьи в качестве представления может трактоваться та или иная модификация

формализма ИНС. Следовательно, поиск формализма, обеспечивающего построение

компактных ИНС для решения задач обработки и распознавания изображений,

необходим для достижения эффективного обучения.

Заключение

Основное ограничение традиционных ИНС при распознавании изображений

заключается в их низкой обобщающей способности – слабом обучении, в ходе которого

не выявляются инварианты. Это ограничение связано с тем, что инвариантные

алгоритмы неэффективно (экспоненциально по размеру) представляются с помощью

ИНС, и на практике обучение как поиск происходит не в алгоритмически полном

пространстве. Тем не менее, ИНС задают «гладкую метрику» в пространстве

алгоритмов, что делает их удобными для обучения.

В настоящее время существует большое число модификаций формализма ИНС,

которое можно увеличивать и дальше. В дальнейшем при рассмотрении этих

модификаций необходимо учитывать 1) компактность ИНС, решающих требуемые

задачи; 2) алгоритмическую полноту пространства поиска при обучении;

3) сохранность «гладкой метрики».

Литература

1. Hornick, Stinchcombe, White. Multilayer Feedforward Networks are Universal

Approximators. Neural Networks, 1989, v. 2, № 5.

2. Siegelmann H.T., Sontag E.D. On the Computational Power of Neural Nets // Journal

of Computer and System Sciences. 1995. V. 50. P. 132–150.

3. Small M., Tse C.K. Minimum description length neural networks for time series

prediction // Physical Review E. 2002. V. 66. P. 066701(1-12).

4. Potapov A.S., Malyshev I.A., Puysha A.E., Averkin A.N. New paradigm of learnable

computer vision algorithms based on the representational MDL principle // Proc.

SPIE. 2010. V. 7696. P. 769606.

327