ВВЕДЕНИЕ Однофакторные эксперименты, где

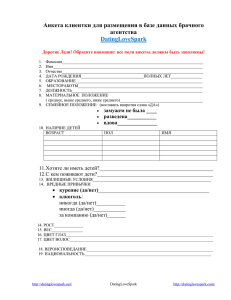

advertisement

ВВЕДЕНИЕ

Однофакторные эксперименты, где варьируется один параметр при

фиксированных значениях других, требуют выполнение большого числа

опытов, и что не менее важно, не всегда дают возможность выявить общую

картину влияния факторов на объект оптимизации. Применение методов

планирования экспериментов позволяет не только обоснованно сократить

число опытов, и что самое главное, без потери информации, но и выявить

взаимодействие факторов, их суммарное взаимное влияние на объект

оптимизации. Планирование эксперимента позволяет без больших

материальных, временных затрат определить пути дальнейшего продолжения

исследований.

Для ознакомления студентов с основами планирования эксперимента,

усвоения основных понятий и методов, разработано данное методическое

указание.

При изложении данной дисциплины в связи с ограниченностью по

времени, трудно организовать и получить экспериментальные данные, и с

учетом того, что данную дисциплину изучают студенты старших курсов,

имеющие понятия, представления о проведении опытов, то в данной работе

предлагаются задачи связанные непосредственно с организацией опытов, а

затем дальнейшее продолжение работы с результатами опытов, выдаваемых

преподавателем. Такой подход позволяет достаточно полно изучить общие

методы планирования эксперимента и обеспечить возможность для

дальнейшего самостоятельного углубленного изучения данной проблемы.

Цель и задачи практических работ

Цель выполнения практических работ - приобретение навыков

составления планов, обработки и анализа результатов экспериментов.

Практическую работу следует выполнять на стандартных листах формата А4

или в ученической тетради, оставляя на страницах поля 20 мм. Титульный

лист должен быть оформлен по установленным в СФУ правилам, остальной

материал - в соответствии с требованиями стандарта предприятия по

оформлению письменных студенческих работ. Исправлять незачтенную

работу следует так, чтобы рецензент мог сопоставить первоначальный и

новый тексты. Переработки большого объема можно проводить на отдельных

листах.

Для успешного выполнения и защиты работы студент должен

Знать: технологию производства, устройство, характеристики

измерительных средств, методы измерения и т.д.

Иметь представление: о факторах, их уровнях варьирования, методах

2

их измерения и т.д.

Уметь объяснить: методы исключения незначимых факторов, методы

построения матрицы планирования.

1 Практические задания по курсу ЭППАР

1.1 Практические задания

На основании полного факторного плана (ПФП) эксперимента

проведено исследование влияния трех факторов Xi (напряжение питания), Х2

(напряжение смещения рабочей точки), Х3 (температура окружающей среды)

на отклик (выходная мощность генератора) y=f(Xi,X2,X3), где X, нормированные значения факторов. Основные уровни факторов:

xi = 15В; х2 = 4В; х3 =10°

Интервалы варьирования факторов:

j =3B; A 2x =1,5В ; А 3x =10° С.

В каждой точке (1=1,2, ..., N) спектра ПФП было проведено по два

дублирующих опыта. Результаты измерений отклика уii и уil в этих опытах

приведены в таблице, где Ш - сумма четырех последних цифр шифра

Стьюдента.

Результаты измерений отклика

Таблица 1

1

1

2

3

4

5

6

7

8

Yii

0,661111 0,754111 0,556111 0,711111 0,743111 0,786111 0,688111 0,830111

Yil

0,651111 0,736111 0,548111 0,693111 0,721111 0,764111 0,668111 0,802111

1.2 Практическая работа № 1:

Построить матрицу-таблицу плана эксперимента.

Пояснить организацию проведения эксперимента. Указать реальные

значения факторов в точках спектра плана эксперимента.

Вычислить оценки дисперсии отклика в точках спектра плана и

проверить их однородность.

1.3 Практическая работа № 2:

Найти математическую модель объекта исследования в виде линейного

полинома с учетом возможных взаимодействий между факторами.

Оценить значимость коэффициентов уравнения регрессии.

3

Проверить адекватность полученной модели.

Указание. Перед выполнением контрольной работы следует изучить

основные теоретические положения. Для проверки однородности дисперсий

следует использовать критерий Кохрена. При оценке значимости

коэффициентов уравнения регрессии необходимо использовать критерий

Стьюдента (t - критерий). Для проверки адекватности полученной модели

следует использовать критерий Фишера.

1. 4 Практическая работа № 3

Тема: Выбор факторов, уровней их варьирования и нулевой точки

Цель работы: закрепление знаний, умений и навыков по выбору

факторов, их уровней варьирования.

Общие положения

Фактором называется управляемая независимая переменная,

соответствующая одному из возможных способов воздействия на объект

исследования. Фактор считается заданным, если указаны его название и

область определения. В выбранной области определения он может иметь

несколько значений, которые соответствуют числу его различных состояний.

Выбранные для эксперимента количественные и качественные состояния

фактора носят название уровней фактора.

В планировании эксперимента значения факторов, соответствующие

определенным уровням их варьирования, выражаются в кодированных

величинах. Под интервалом варьирования подразумевается разность между

двумя именованными его значениями, принятая за единицу при его

кодировании. При выборе факторов рекомендуется учитывать ряд

требований. В качестве факторов рекомендуется выбирать такие независимые

переменные, которые соответствуют одному из разумных в рассматриваемом

случае воздействии на объект исследований, могут быть измерены

имеющимися средствами с достаточно высокой гарантированной точностью,

являются управляемыми и однозначными, совместимы один с другим, не

связаны между собой линейными корреляционными связями, Желательно,

чтобы факторы оценивались количественно, хотя возможно применение

факторов, характеризующихся только качественно.

После выбора факторов устанавливают нулевую точку и выбирают

интервалы варьирования для установления верхних и нижних уровней

факторов, которые в кодированном обозначении соответствуют +1 и –1.

Интервал варьирования фактора выбирают с учетом того, что значение

факторов, соответствующие уровням +1 и –1, должны быть достаточно

отличимы от значения, соответствующего нулевому уровню. Поэтому во всех

случаях величина интервала варьирования должна быть больше удвоенной

квадратичной ошибки фиксирования данного фактора.

Здесь необходимо учитывать, что чрезмерное увеличение интервалов

4

варьирования может привести к снижению эффективности поиска оптимума,

а малый интервал варьирования уменьшает область эксперимента, что

замедляет поиск оптимума.

Выбор факторов завершается составлением списка всех факторов,

которые заслуживают внимания. При этом указываются наименования и

обозначения факторов, их интервалы и уровни варьирования, координаты

нулевой точки. Перечисленные данные фиксируются в таблицах.

В качестве примера приведена таблица 2.

Таблица 2

Наименование и обозначение

факторов

t – температура, ˚C (X1)

p – давление, кгс/см2 (X2)

c – концентрация, г/л (X3)

τ – время, мин (X4)

g – масса, кг (X5)

Уровни

варьирования

-2

-1

0

140

0

0

30

100

150

2,5

10

60

160

160

5

20

90

200

Интервалы

варьирования

(ε)

+1 +2

170

7,5

30

120

250

180

10

40

150

300

10

2,5

10

30

50

План работы

1.

Выбрать объект исследования (машина, прибор, процесс и т.д.)

2.

Определить факторы, дать их описание, характер влияния на

исследуемый объект, методы и способы регулирования, измерения и т.д.

3.

Выбрать нулевой уровень и интервалы варьирования.

4.

Заполнить таблицу факторов.

1. 5 Практическая работа № 4

Тема: Априорное ранжирование факторов (психологический

эксперимент)

Цель работы: закрепление знаний, умений и навыков априорного

ранжирования факторов (психологический эксперимент).

Здесь рассматриваются методы, которые применяют при обработке

литературных данных на первой стадии экспериментальной работы в тех

случаях, когда из большего числа факторов нужно выделить наиболее важные

для дальнейшего изучения и отсеять остальные.

На стадии предварительного изучения объекта исследования при

формализации

априорных

сведений

иногда

полезно

проведение

психологического эксперимента, заключающегося в объективной обработке

данных, полученных в результате опроса специалистов или из исследований,

5

опубликованных в литературе. Такой эксперимент позволяет более правильно

спроектировать объект исследования, принять или отвергнуть некоторые

предварительные гипотезы, дать сравнительную оценку влияния различных

факторов на параметры оптимизации и тем самым правильно отобрать

факторы для последующего активного эксперимента, обоснованно исключив

некоторые из них из дальнейшего рассмотрения.

При решении подобных задач можно использовать метод априорного

ранжирования факторов.

Особенность метода априорного ранжирования факторов заключается

в том, что факторы, которые согласно априорной информации могут иметь

существенное влияние, ранжируются в порядке убывания вносимого ими

вклада. Вклад каждого фактора оценивается по величине ранга – места,

которое отведено исследователем (специалистом при опросе, автором статьи

и т.п.) данному фактору при ранжировании всех факторов с учетом их

предполагаемого (количественно неизвестного) влияния на параметры

оптимизации. При сборе мнений путем опроса специалистов каждому из них

предлагается заполнить анкету, в которой перечислены факторы, их

размерность и предполагаемые интервалы варьирования. Заполняя анкету,

специалист определяет место факторов в ранжированном ряду.

Одновременно он может включить дополнительные факторы или высказать

мнение об изменении интервалов варьирования.

Результаты опроса специалистов (или ранжирования по литературным

данным) обрабатываются следующим образом. Сначала определяют сумму

m

рангов по факторам ( ∑

aij ) , а затем разность ( ∆ i ) между суммой каждого

1

фактора и средней суммой рангов и сумму квадратов отклонений (s) :

∆i=

m

∑

aij −

k

m

1

1

∑∑

aij

k

1

s=

m

∑

=

m

∑

aij − T ;

(1)

1

(∆ i ) 2 ;

(2)

1

где aij – ранг каждого i-го фактора у j-го исследователя; m – число

исследователей; k – число факторов; Т – средняя сумма рангов. Полученные

данные позволяют построить среднюю априорную диаграмму рангов, но

предварительно необходимо оценить степень согласованности мнений всех

исследователей с помощью коэффициента конкордации ω:

ω =

12 s

m

m ( k − k ) − m∑ T j

2

3

;

(3)

1

6

где T j = ∑ (t j − t j ) ; t j – число одинаковых рангов в j-м ранжировании.

Использовать коэффициент конкордации можно после оценки его

значимости, которая возможна с помощью специальных таблиц или

известных статистических распределений, например, величина m( k − 1)ω

имеет χ 2 – распределение с числом степеней свободы f=k–1. Значение χ 2 –

критерия определяют по формуле:

3

χ

2

=

12 s

1 m

mk (k + 1) −

∑ Tj

k−1 1

.

(4)

Гипотеза о наличии согласия исследователей может быть принята, если

при заданном числе степеней свободы табличное значение χ 2 меньше

расчетного для 5 %-ного уровня значимости.

Оценив согласованность мнений всех исследователей, строят среднюю

диаграмму рангов, откладывая по одной оси факторы, а по другой –

соответствующие суммы рангов. Чем меньше сумма рангов данного фактора,

тем выше его место на диаграмме. С помощью последней оценивается

значимость факторов. В случае неравномерного экспоненциального убывания

распределения часть факторов можно исключить из дальнейшего

рассмотрения, отнеся их влияние к шумовому полю. Если же распределение

равномерное, то в эксперимент рекомендуется включать все факторы.

В ситуациях с очень большим числом факторов, кроме общей

согласованности мнений исследователей, рассматривают с помощью χ 2 распределения и согласованность по каждому фактору в отдельности.

Построение средней априорной диаграммы рангов по известным

литературным данным полезно с той точки зрения, что она по существу

является сокращенным литературным обзором по объекту исследования.

Остановимся на особенностях априорного ранжирования факторов.

В текстильной промышленности в процессе некоторого исследования

на стадии предварительного изучения объекта исследования были опрошены

четыре специалиста, знакомых с изучаемой технологией (m = 4). Данные

опросы были использованы для априорного ранжирования факторов с целью

выделения наиболее существенных из них. Проводился опрос с помощью

анкеты, содержащей 12 факторов (k = 12), которые нужно было

проранжировать с учетом степени их влияния на разрывную нагрузку

текстильного материала (факторы характеризовали условия изготовления

материала).

Матрица рангов, полученная из анкет, приведена в таблице 3.

Таблица 3

7

Исследователи

(m)

X1

X2

1

2

3

4

m

∑

aij

Факторы (k =12)

Tj =

3

j

tj)

29

•Χ3

Χ4

Χ5

Х6

Χ7

X8

Χ9

Χ10

Х11

Χ12

10,5 10,5 10,5 1

2,5

2,5

10,5

5

4

7

6

60+6

9

7,5

4

10

7,5

8

11 1

11 2

10,5 2

6,5 6,5

4,5 4,5

10,5 10,5

12

12

10,5

2

1

1

3

3

3

4

9,5

9,5

5

9,5

5,5

8-2

=6

6+6+6= 18

60+6 = 66

31

36

43

24

45

9

13

26

26

6

24

1

4

∑

= 66

T j = 156

1

∆i

(∆i)

∑ (t

2

29-2 5

10

17

-20

-2

6=3

9

25

100 289 400 4

-2

19

-17

-13

0

0

4

361

289 169 0

0

s = 1650

По данным таблицы 3 рассчитывали, используя формулу (3),

коэффициент конкордации

4

∑ T j = 156; T = 26; s = 1650 :

1

Т1 =

∑ (t

3

j

) (

)

− t j = 43 − 4 + ( 23 − 2) = 60 + 6 = 66 .

T2 = ( 23 − 2) = 6.

(

) (

)

T3 = 23 − 2 + 23 − 2 + (23 − 2) = 18.

T4 = ( 4 − 4) + (2 − 2) = 66 .

3

3

4

∑

T j = 66 + 6 + 18 + 66 = 156.

1

4

T=

∑

Tj

1

jmax

=

156

= 26.

6

Сумма квадратов отклонений

s=

m

∑

(∆ i ) 2 = 9+25+100+289+400+4+4+361+289+169+0+0=1650.

1

ω =

12 ⋅ 1650

= 0,738

16 ⋅ (1728 − 12 ) − 4 ⋅ 156

Так как величина коэффициента конкордации существенно отличается

8

−

от нуля, можно считать, что между мнениями исследователей имеется

существенная связь. Тем не менее, исследователи неодинаково ранжируют

факторы (найденное значение заметно отличается от единицы).

Значимость коэффициента конкордации проверяли по χ 2 - критерию с

учетом формулы (4):

χ

2

=

12 ⋅ 1650

= 32,3.

1

4 ⋅ 12 ⋅ 13 −

⋅ 156

11

Из справочной литературы находим, что для 5%-ного уровня

значимости при числе степеней свободы f = 12–1 = 11 χ 2 = 19,75. В связи с

тем, что табличное значение χ2-критерия меньше расчетного, можно с 95%ной доверительной вероятностью утверждать, что мнение исследователей

относительно степени влияния факторов согласуется в соответствии с

коэффициентом конкордации ω =0,738. Это позволяет построить среднюю

диаграмму рангов для рассматриваемых факторов (рис.1). Из диаграммы

видно, что распределение – равномерное, убывание – немонотонное.

По результатам проведенного психологического эксперимента было

отобрано для дальнейших исследований восемь факторов, занимающих по

диаграмме восемь первых мест. Средняя априорная диаграмма рангов

Рис. 1.

Рассматриваемый метод полезен при оценке потребительной стоимости

текстильных и других товаров.

1.

План работы

Составить анкету для опроса специалистов, где исследуемые

9

факторы взять из практического занятия №1.

2.

Заполнить анкету, привлекая в качестве специалистов студентов

данной учебной группы.

3.

Выполнить статистическую обработку результатов опроса.

1. 6 Практическая работа № 5

Тема: Полный факторный эксперимент

Цель работы: закрепление знаний, умений и навыков по полному

факторному эксперименту.

Рассматривается полный факторный эксперимент (ПФЭ) типа 23, матрица

планирования которого и результаты эксперимента приведены в табл.4.

–

+

–

+

–

+

–

+

–

–

+

+

–

–

+

+

–

–

–

–

+

+

+

+

+

–

–

+

+

–

–

+

+

–

+

–

–

+

–

+

+

+

–

–

–

–

+

+

–

+

+

–

+

–

–

+

Концентрация C, %

5

15

5

15

5

15

5

15

0,5

0,5

1,5

1,5

0,5

0,5

1,5

1,5

75

75

75

75

95

95

95

95

Результаты

эксперимента (yu), %

+

+

+

+

+

+

+

+

Температура t, oC

1

2

3

4

5

6

7

8

Рабочая матрица

Матрица

планирования

x0

x1

x2

x3

x1x2

x1x3

x2x3

x1x2x3

Время t, мин

Номер опыта

Таблица 4

81,08

85,65

82,27

90,40

84,95

89,95

85,25

88,25

Уравнение математической модели

y = b0 +

∑ bx

i

i

+

∑b

ij

xi x j

(5)

Значение коэффициентов регрессии рассчитываются по выражениям:

N

b0 =

∑

N

N

bi =

yn

1

∑

(6)

,

xin yn

1

N

,

(7)

10

N

∑

bij =

xin x jn yn

1

N

(8)

.

Дисперсия воспроизводимости определяется по формуле:

S{2y} =

N

n

1

1

∑∑

( yni − yn ) 2

N (n − 1)

,

(9)

где

N – число опытов в эксперименте; n – число повторных наблюдений в

каждом опыте.

В данном случае число повторных наблюдений n = 5 и дисперсия

воспроизводимости S{2y} = 0,652.

Приняв доверительную вероятность 95% определяются границы

доверительных интервалов для коэффициентов регрессии

∆ bi = ±

t ⋅ S{ y}

N⋅n

(10)

Получив значения границы доверительных интервалов, исключаются

незначимые коэффициенты регрессии, а значимые коэффициенты регрессии

подставляются в уравнение математической модели и рассчитываются

теоретические значения отклика (параметра оптимизации).

Работа завершается проверкой адекватности математической модели.

Дисперсия адекватности вычисляется по выражению:

N

2

S ад

=

∑

1

n( yn − yˆ n ) 2

(11)

N− λ

где

λ = k + 1 при линейном моделировании;

ŷn – теоретическое значение отклика в n-том опыте. Гипотезу об

адекватности модели проверяют с помощью критерия Фишера:

F=

2

S ад

S{2y}

(12)

Значение F-критерия, найденное из уравнения (12), сравнивают с

табличным при выбранной доверительной вероятности. Должно выполняться

условие

Fрасч. < Fтабл.

11

Выбирая значение Fтабл. нужно учитывать число степеней свободы для

большей и меньшей дисперсий. Числа степеней свободы – это знаменатели

формул, используемых при определении двух дисперсий – S ад2 и S{2y}

f1 = N (n – 1);

(13)

f2 = N – λ = N – k + 1.

После выполнения работы сделать выводы о дальнейшем направлении

исследования.

План работы

1. Рассчитать коэффициенты регрессии.

2. Выполнить проверку значимости коэффициентов регрессии.

3. Рассчитать теоретические значения параметра оптимизации.

4. Проверить адекватность модели.

5. Выводы, рекомендации.

12

2

Примеры применения планов экспериментов в практических

занятиях

2. 1 Пример применения плана полного факторного эксперимента

(ПФЭ) 22

Пусть в результате проведения экспериментов по плану ПФЭ 22, то есть

при изменении двух факторов, мы получили опытные значения Y1, Y2, Y3, Y4.

Поверхность, уравнение которой нас интересует, имеет вид рис. 2.

Рис. 2. Поверхность функции отклика

Составляем план ПФЭ 22.

Таблица 4

i 0

U x0

1

x1

2

x2

1

+1 –1 –1

2

3 +1 +1 –1

4 +1 –1 +1

+1 +1 +1

5 +1 0 0

3

x3= x1?x2

4 5

Y Yt

Yt

Yˆ tt − Y

t

+1

–1

–1

7

0

6

3

4

7

2

4,5

4,5

5,5

5,5

5

6

3

4

7

5

0

0

0

3

3

Вначале найдем коэффициенты сокращенного линейного полинома вида

13

Yˆ t = b0 + b1 x1 + b2 x2

t

t

t

(14)

t

и результаты вычислений Y1 , Y2 , Y3 , Y4 по нему.

Рассчитываем коэффициенты полинома.

N

b0 =

∑

U−1

4

N

b1 =

∑

U−1

x1U YU

4

N

b2 =

x0U YU

∑

U−1

x2U YU

4

=

1⋅ 6 + 1⋅ 3 + 1⋅ 4 + 1⋅ 7

= 5;

4

=

− 1⋅ 6 + 1⋅ 3 − 1⋅ 4 + 1⋅ 7

= 0;

4

=

− 1⋅ 6 − 1⋅ 3 + 1⋅ 4 + 1⋅ 7

= 0,5

4

Полином имеет вид

t

Yˆ = 5 + 0 ⋅ x1 + 0,5 x2 .

Результаты расчета по нему приведены в соответствующем столбце плана.

Наблюдаются расхождения между Y и Yˆ t . Если точность сокращенного

полинома не удовлетворяет, то по тем же результатам опытов можно

сформировать более полный полином вида

Yˆ tt = b0 + b1 x1 + b2 x2 + b12 x1 x2 .

(15)

При этом ранее определенные коэффициенты остаются без изменений.

Определим коэффициент при дополнительном члене полинома

N

b12 =

∑

U−1

x3U YU

4

=

1⋅ 6 + 1⋅ 3 + 1⋅ 4 + 1⋅ 7

= 1,5

4

Полином имеет вид

Yˆ = 5 + 0 ⋅ x1 + 0,5 x2 + 1,5 x1 x2 .

14

По нему рассчитываем предсказанные значения отклика в точках плана

(столбец Ŷ tt ). Поверхность, построенная по полученному полиному,

tt

проходит точно через четыре точки плана ( Y1, 2,3, 4 − Y1, 2,3, 4 = 0 ), по которым

определены коэффициенты. Однако в других точках области определения

функции, например в центре плана (точка 5 в плане, х1=0, х2=0),

tt

предсказанные и действительные значения, могут не совпадать ( Y5 − Y5 =3).

2. 2 Пример построения плана дробного факторного эксперимента

(ДФЭ)

Построить план ДФЭ 24-1 и определить полином

Y=b0+b1x1+b2x2+b3x3+b4x4+b12x1x2+b13x1x3+b14x1x4+b23x2x3

+b24x2x4+b34x3x4

(16)

Число факторов – 4. Нужно найти 8 коэффициентов полинома.

Выбираем 8 из 16 опытов плана ПФЭ 24 таким образом, чтобы были

определены независимые коэффициенты при самих факторах, смешанные

коэффициенты при парных сочетаниях факторов и в пренебрежении

тройными и четверным сочетаниями факторов и при этом сохранялась

ортогональность плана.

U

ПФЭ 24

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

ДФЭ 24-1

1

–

–

4

–

6

7

–

–

2

3

–

5

–

–

8

x1

x2

x3

–1

+1

–1

+1

–1

+1

–1

+1

–1

+1

–1

+1

–1

+1

–1

+1

–1

–1

+1

+1

–1

–1

+1

+1

–1

–1

+1

+1

–1

–1

+1

+1

–1

–1

–1

–1

+1

+1

+1

+1

–1

–1

–1

–1

+1

+1

+1

+1

Таблица 5

x4

–1

–1

–1

–1

–1

–1

–1

–1

+1

+1

+1

+1

+1

+1

+1

+1

15

Такой выбор позволяет сформировать план ДФЭ 24-1 как и план ПФЭ 23 ,

но с х4=х1х2х3 . План ДФЭ 24-1 представляется в виде

Таблица 6

U

1

2

3

4

5

6

7

8

x0

+1

+1

+1

+1

+1

+1

+1

+1

x1

–1

+1

–1

+1

–1

+1

–1

+1

x2

–1

–1

+1

+1

–1

–1

+1

+1

x3

–1

–1

–1

–1

+1

+1

+1

+1

x4

–1

+1

+1

–1

+1

–1

–1

+1

x1x2

+1

–1

–1

+1

+1

–1

–1

+1

x1x3

+1

–1

+1

–1

–1

+1

–1

+1

x1x4

+1

+1

–1

–1

–1

–1

+1

+1

x2x3

+1

+1

–1

–1

–1

–1

+1

+1

x2x4

+1

–1

+1

–1

–1

+1

–1

+1

x3x4

+1

–1

–1

+1

+1

–1

–1

+1

Y

10

8

8

7

9

8

8

6,5

Yˆ

10

8

8

6,8

9,2

8

8

6,68

Значения коэффициентов полинома составляют:

b123 = b124 = b134 = b234 = b1234 = 0

b0 =

b1 =

10 + 8 + 8 + 7 + 9 + 8 + 8 + 6,5

= 8,06 ;

8

− 10 + 8 − 8 + 7 − 9 + 8 − 8 + 6,5

= − 0,69;

8

b2 = − 0,69 ;

(b12 + b34 ) =

b4 = − 0,19 ; b4 = − 0,19 ;

10 − 8 − 8 + 7 + 9 − 8 − 8 + 6,5

= 0,06

8

b13 + b24 = 0,06

b14 + b23 = 0,06

Если принять, что

1

(b12 + b34 ) = 0,03 ;

2

1

b13 ≈ b24 = (b13 + b24 ) = 0,03

2

1

b14 ≈ b23 = (b14 + b23 ) = 0,03

2

b12 ≈ b34 =

16

то полином имеет вид

Yˆ = 8,06 − 0,69 x1 − 0,69 x2 − 0,19 x4 + 0,03 x1 x2 + 0,03 x1 x3 + 0,03 x1 x4 + 0,03 x2 x 3 + 0,03 x3 x4

Значения полинома в точках плана приведены в последнем столбце

плана ДФЭ 24-1. В нашем случае точность его достаточно высокая.

2. 3 Пример ортогонально центрально-композиционного плана

второго порядка (ОЦКП для n = 2)

Параметры плана N0 = 4, N = 9, a = 1, а = 2/3, 1–а =1/3, –а = –2/3,

a2 − a = − 2 3 .

Использован рассмотренный ранее план ПФЭ 22 с добавленными

опытами 5-9.

Таблица 7

U

x0

x1

x2

x1x

t

2

1

2

3

4

5

6

7

8

9

N

∑

U −1

2

xiU

+1

+1

+1

+1

+1

+1

+1

+1

+1

9

+1

+1

+1

+1 +1

0

+1 0

0

0 +1

0 0

6 6

2

x 3 =x 1

–a

1/3

1/3

1/3

1/3

1/3

1/3

–2/3

–2/3

–2/3

2

+1

0

0

0

0

0

4

t

2

X 4 =x 2

–a

1/3

1/3

1/3

1/3

–2/3

–2/3

1/3

1/3

–2/3

2

Y

6

3

4

7

5

5

1

3

2

Yˆ

5,83

2,83

4,17

5

5

1,33

2,67

2

Yˆ –

Y

0,17

0,17

0,17

0,17

0

0

0,33

0,33

0

Коэффициенты полинома составляют

9

b0 =

∑

x0Y0

∑

x02U

U−1

9

U−1

b1 =

=

6+ 3+ 4+ 7 + 5+ 5+ 3+ 2

= 4;

9

− 6 + 3 − 4 + 7 − 5 + 5 + 0⋅1+ 0⋅ 2

= 0;

6

17

b2 =

− 6 − 3 + 4 + 7 − 0 ⋅ 5 + 0 ⋅ 5 − 1+ 3 + 0 ⋅ 2

= 0,67 ;

6

b12 =

6− 3− 4+ 7

= 1,5 ;

4

b3 =

1 / 3(6 + 3 + 4 + 7 + 5 + 5) − 2 / 3(1 + 3 + 2)

= 3;

6 ⋅ (1 / 3) 2 + 3(2 / 3) 2

b4 =

1 / 3(6 + 3 + 4 + 7 + 1 + 3) − 2 / 3(5 + 5 + 2)

= 0.

2

Полином принимает вид

Yˆ = 4 + 0 ⋅ x1 + 0,67 x2 + 3( x12 − 0,67 ) + 0 ⋅ ( x22 − 0,67 ) + 1,5 x1 x2 = 2 + 0,67 x2 + 3 x12 + 1,5 x1 x2

(Ранее по плану ПФЭ 22 был сформирован полином

Yˆ = 5 + 0,5 x2 + 1,5 x1 x2

).

Рассчитанные значения Ŷ по полиному приведены в плане. Также

приведены величины Yˆ − Y , подтверждающие достаточно высокую

точность полинома. Так в центральной точке плана, в отличие от случая

применения плана ПФЭ 22, расхождений нет.

U

U

2. 4 Пример рототабельного ортогонального центральнокомпозиционного плана (РОЦКП) для n = 2

Параметры плана:

a=

a=

2 = 1,414

,

n0 = 8 ,

N 0 = 22 = 4 ,

N = 2 2 + 2 ⋅ 2 + n0 = 16 ,

N0

= 0,5 ,

,

,

.

1 − a = 0,5 − a = − 0,5 a 2 − a = 2 − 0,5 = 1,5

N

Нет необходимости проводить восемь раз (точки с 9 по 16) опыты в

центре плана. Достаточно провести этот опыт один раз и записать результат

во все восемь строк. Строки сокращать нельзя, так как нарушается свойство

ортогональности, и коэффициенты полинома будут определены неверно.

Коэффициенты квадратичного полинома рассчитаются, как и ранее.

18

Использован рассмотренный ранее план ПФЭ 22 с добавленными

опытами 5-16.

Точки в центре плана Звёздные точки

ПФЭ 22

Таблица 8

∑

U −1

N

∑

U −1

x1 x2 x3t = x12 − a

x4t = x22 − a

Y

Yˆ

–1

+1

–1

+1

–1,414

+1,414

0

0

–1

–1

+1

+1

0

0

–1,414

+1,414

+1

+1

–1

+1

0

0

0

0

0,5

0,5

0,5

0,5

1,5

1,5

–0,5

–0,5

0,5

0,5

0,5

0,5

–0,5

–0,5

1,5

1,5

6

3

4

7

5

5

1

3

5,146

2,146

3,35

6,35

5,75

5,75

1,9

3,6

0,854

0,854

0,65

0,65

0,75

0,75

0,9

0,6

+1

+1

+1

+1

+1

+1

+1

+1

16

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

0

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

–0,5

0

2

2

2

2

2

2

2

2

2

2

2

2

2

2

2

2

0

0

0

0

0

0

0

0

16

8

8

4

8

8

x0

1

2

3

4

5

6

7

8

+1

+1

+1

+1

+1

+1

+1

+1

9

10

11

12

13

14

15

16

N

xiU

2

xiU

Yˆ − Y

x2

U

x1

b0 =

b1 =

6 + 3 + 4 + 7 + 5 + 5 + 1 + 3 + 2 ⋅ 8 50

=

= 3,125 ,

16

16

− 6 + 3 − 4 + 7 − 5 ⋅ 1,414 + 10 ⋅ 0 0

= = 0,

b2 = 0,6035

4 ⋅ 12 + 2(1,414 ) 2 + 10 ⋅ 0 2

8

b12

b11 =

,

6 − 3 − 4 + 7 + 12 ⋅ 0

= 1,5 ,

4 ⋅ 12

0,5(6 + 3 + 4 + 7) + 1,5(5 + 5) − 0,5(1 + 3 + 8 ⋅ 2) 15

=

= 1,875 ,

14 ⋅ 0,52 + 2 ⋅ 1,52

8

19

b22 =

0,5(6 + 3 + 4 + 7) − 0,5(5 + 5) + 1,5(1 + 3) − 0,5 ⋅ 2 ⋅ 8

= 0,375

8

Полином принимает вид

YˆРОЦКП = b0 + b1 x1 + b2 x2 + b12 x1 x2 + b11 ( x12 − a) + b11 ( x22 − a) = 3,125 + 0 ⋅ x1 + 0,6035 x2 + 1,5 x1 x2 +

+ 1,875( x12 − 0,5) + 0,375( x22 − 0,5) = 2 + 0 ⋅ x1 + 0,6035 x2 + 1,5 x1 x2 + 1,875 x12 + 0,375 x22

Рассчитанные значения функции и расхождения с опытными данными

представлены в предпоследнем и последнем столбцах плана.

Ранее для ОЦКП, при несколько отличающейся поверхности функции,

был получен близкий полином в виде

YˆОЦКП = 2 + 0 ⋅ x1 + 0,67 x2 + 1,5 x1 x2 + 3x12 + 0 ⋅ x22 .

Для n=2 число членов квадратичного полинома составляет шесть. В

ОЦКП и РОЦКП необходимо провести девять отличающихся опытов при

пяти уровнях варьирования факторов. Поэтому ОЦКП и РОЦКП ненасыщенные планы. Такое число экспериментальных точек может быть

использовано для построения, например, кубичных полиномов.

2. 5 Пример рототабельного плана на основе правильного

многоугольника при n=2

Параметры рототабельного плана: при n=2 на основе правильного

шестиугольника присутствуют 7 отличающихся точек: N0=6 точек на

единичной окружности и n0=6 совпадающих точек в центре плана (рис. 3).

Рис. 3 Рототабельный план при n =2 на основе правильного шестиугольника.

20

Здесь при построении плана первый фактор варьируется на пяти

уровнях, а второй – на трех уровнях.

Рототабельный план при n=2 на основе шестиугольника (табл.9)

Таблица 9

U

x1

x2

n

∑

i= 1

1

2

3

4

5

6

7

8

9

10

11

12

N0

n0

N

∑

U −1

N

∑

U −1

xiU

2

xiU

1

0,5

–0,5

–1

–0,5

0,5

0

0

0

0

0

0

0

0

0,866

0,866

0

–0,866

–0,866

0

0

0

0

0

0

0

3,0

3,0

1,0

1,0

1,0

1,0

1,0

1,0

0,0

0,0

0,0

0,0

0,0

0,0

2

xiU

= R

R1

R2

x3 = x1 x2

x4 = x − 0,25

x5 = x22 − 0,25

0

0,433

–0,433

0

0,433

–0,433

0

0

0

0

0

0

0

0,75

0

0

0,75

0

0

–0,25

–0,25

–0,25

–0,25

–0,25

–0,25

0

–0,25

0,5

0,5

–0,25

0,5

0,5

–0,25

–0,25

–0,25

–0,25

–0,25

–0,25

0

0,75

1,5

1,5

2

1

Существуют рототабельные планы, где оба радиуса не нулевые. При

этом количество точек на каждой поверхности и отношение радиусов

связаны.

Числа точек окружностей рототабельного плана и отношение их

радиусов (табл. 10)

Таблица 10

Число точек внешней

окружности (N0)

Число точек внутренней

окружности (n0)

Отношение радиусов

окружнoстей (R2/R1)

6

7

8

7

8

8

5

5

5

6

6

7

0,204

0,267

0,304

0,189

0,25

0,176

Пример такого плана при n=2, N0=8, n0=6, R2 / R1=0,25 на рис.4

21

Рис. 4 Рототабельный план с двумя невырожденными окружностями.

3 Пример неравноточных измерений

В практической работе «Изучение вязкости жидкости» определяется

вязкость водного раствора глицерина по результатам измерения

установившейся скорости движения трех шариков с различными радиусами.

Полученные значения для шариков разного радиуса нельзя считать

равноточными. Можно сказать, что в данном примере мы получаем

результаты тремя различными методами. После обычной обработки трех

групп значений (для каждого шарика) было получены следующие значения

средних статистических и абсолютных погрешностей для доверительной

вероятности α = 0,95

η 1 = 0,557

∆η 1

η 2 = 0,508

Па·с;

∆η 2=

= Па·с;

Па·с ;

Па·с;

η3 =

0,513 Па·с

∆η 3

= Па·с

В рассматриваемом примере т = 3. Используя формулы (17) и (18),

2

1

∑k = 1 ∆ a ak

k

a=

2

m

1

∑k = 1 ∆ a

k

m

∆A=

m

1

∑

k − 1 ∆ ak

m

2

(17)

(18)

вычисляем η1 = 0,521 Па·с и ∆ η = 0,0304 Па·с.

Таким образом, окончательный ответ можно записать в виде:

22

= (0,521 ± 0,030) Па·с при доверительной вероятности α = 0,95.

Заметим, что величина η , вычисленная по формуле (17), отличается от

среднего арифметического значений η 1 , η 2 , η 3 из-за различия

статистических весов групп проведенных измерений. Кроме того, величина

заметно меньше среднего арифметического погрешностей ∆ η 1, ∆

∆η

η 2, ∆ η 3. Это значит, что использование статистических весов позволяет

избежать получения неоправданного широкого доверительного интервала для

искомой величины вязкости η .

η

3. 1 Примеры использования относительных погрешностей

Относительной погрешностью ε Z косвенно измеряемой величины Z

является отношение абсолютной погрешности ∆ Z к среднестатистическому

значению Z :

ε Z=

∆Z

Z

(19)

Удобство использования относительных погрешностей для расчета

абсолютной погрешности ∆ Z косвенно измеряемой величины Z

целесообразно продемонстрировать на конкретных, часто встречающихся в

практике зависимостях. Далее будем полагать, что все рассчитанные

абсолютные погрешности соответствуют определенной, заранее выбранной

доверительной вероятности.

1 Пусть косвенно измеряемая величина Z является суммой или

разностью непосредственно измеряемых величин A и B , т.е.

Z=A±B .

Тогда

Z

=

A± B

,

∂Z

= 1,

∂A

(20)

∂Z

= ±1

∂A

Абсолютная погрешность ∆ Z, в данном случае представится простым

выражением:

∆ Z=

Относительная погрешность ε

.

(21)

Z в соответствии с (19) выразится отношением:

( ∆ A) 2 + (∆ B ) 2

εz =

(∆ A) 2 + ( ∆ B ) 2

A± B

(22)

2. Теперь пусть величина Z есть произведение величин A и B.

Z = A·B.

(23)

23

Следовательно, в этом случае: Z

= A⋅B

,

∂Z

= B

∂A

∂Z

= A.

∂B

,

Выразим абсолютную и относительную погрешности величины Z,

причем последнюю преобразуем:

∆Z =

B 2 ( ∆ A) 2 + A 2 ( ∆ B ) 2

B 2 (∆ A) 2 + A 2 (∆ B ) 2

=

A⋅ B

εz=

2

=

(24)

B 2 (∆ A) 2 + A 2 (∆ B ) 2

=

A2 ⋅ B 2

2

∆ A

∆B

+

=

A

B

ε A2 + ε B2

(25)

3. Рассмотрим случай, когда величина Z равна отношению величин A и B:

Z = A/B .

(26)

Определим для этой функциональной зависимости частные производные

∂Z

1

=

∂A

B

,

∂Z

A

= − 2 среднее значение

∂B

B

Z = A B

, абсолютную и относительную

погрешности:

2

∆Z =

εz=

A⋅∆B

∆ A

+

2

B

B

B 2 (∆ A) 2 A 2 (∆ B) 2

=

+

A 2 B 2

B 4

2

ε A2 + ε B2

(27)

.

(28)

Из приведенных примеров можно сделать вывод о том, что если

функциональная зависимость представляет собой сумму или разность, то

легче вначале вычислить абсолютную погрешность ∆ Z, а затем

относительную ε z . Если же функция в правой части содержит произведение

или отношение аргументов, то проще вначале подсчитать относительные

погрешности аргументов, по ним вычислить относительную погрешность ε z

величины Z, и затем - абсолютную погрешность ∆ Z , используя связь (19):

∆ Z=εz− Z

(29)

Эти выводы справедливы для любого количества аргументов

приводимой функции.

Рассмотрим более сложную функциональную зависимость между

функцией Z и аргументами A, B, C :

24

Z= k

AP ⋅ BQ

CR

(30)

где k, P, Q, R - постоянные. Ясно, что среднее значение представится

следующим выражением:

Z= k

A p ⋅ BQ

CR

Теперь найдем выражения для частных производных

∂Z

BQ− 1 P

= kQ

A ,

∂B

CR

∂Z

BQ

= k R PA P − 1 ,

∂A

C

∂Z

BQ

= − kR R + 1 A P

∂C

C

и абсолютной погрешности определяемой величины

2

∆Z =

2

BQ

AP

AP

kP R A P − 1 ( ∆ A) 2 + kQ R B Q − 1 ( ∆ B ) 2 + kR R + 1 B Q ( ∆ C ) 2

C

C

C

Относительную погрешность

аналогичном (25) и (28):

∆Z

εz =

=

Z

2

целесообразно

2

записать

в

виде,

2

∆ A

2 ∆ B

2 ∆ C

P

+ Q

+ R

=

A

B

C

2

P 2ε

2

A

+ Q 2ε B2 + R 2ε c2

Очевидно, что и в данном примере, имея уже вычисленные средние

значения A , B , C и абсолютные погрешности аргументов ∆ A, ∆ B, ∆ C,

гораздо легче вычислить сначала относительную погрешность ε Z , а затем,

используя (27) - абсолютную погрешность ∆ Z. Следует обратить внимание

на то, что показатель степени входит в выражение для относительной

погрешности в качестве сомножителя, причем во второй степени, что

существенно увеличивает вклад погрешности соответствующей величины в

суммарную погрешность. Для увеличения точности результатов необходимо

измерять аргументы, которые входят в функцию в виде степени с показателем

больше единицы, используя наиболее точные методы.

Для иллюстрации работы с функцией типа (30) рассмотрим вычисление

объема прямого кругового конуса V на основе прямых измерений его

диаметра основания d и высоты h :

V =

πd2

h

12

(31)

25

После проведения прямых измерений были вычислены средние значения d и h диаметра и высоты соответственно, а также абсолютные

погрешности ∆ d и ∆ h этих же величин для установленной доверительной

вероятности а. Численное значение объема конуса V вычисляется по формуле

(31) с помощью уже полученных величин d и h .

Принимая во внимание характер зависимости (31) и рассмотренные

выше примеры, сначала выразим относительную погрешность измерения

объема конуса

εV =

∆V

=

V

4ε d2 + ε h2 + ε π2

,

(32)

где среднее значение объема конуса определяется следующим соотношением:

V =

π 0d 2

h,

12

(33)

Символом π 0 здесь обозначено округленное значение числа π . Дело в

том, что число π иррационально и при использовании в расчетах всегда

округляется до необходимого количества значащих цифр. Отбрасываемая

часть определяет относительную погрешность ε π , которая входит в

выражение погрешности определения объема конуса. По своему

смыслу погрешность | π − π 0 | является систематической, но ее оценку

целесообразно проделать нижеизложенным способом, рассматривая

выражение (31) как функцию трех независимых аргументов.

Обычно количество значащих цифр в π 0 берется таким, чтобы

погрешность ε π мало влияла на погрешность результата ε V , т.е. должно

выполняться неравенство:

ε π2 < < 4ε d2 + ε h2

(34)

Тогда в выражении (32) слагаемым ε π 2 можно пренебречь.

Определим необходимое количество значащих цифр в π 0 для конкретного примера. Пусть у нашего конуса получены значения d = 20 мм и h =

40 мм. При выбранной доверительной вероятности α = 0,95 вычислены ∆ d

= 0,05 мм и ∆ h = 0,5 мм. Обратите внимание, что при измерении диаметра d

использовалась более точная методика, чем при измерении высоты h . Затем

были рассчитаны относительные погрешности ε d = 0,0025 и ε h = 0,0125.

Вычисление правой части (34) дает 4ε d2 + ε h2 ≈ 2 ⋅ 10 − 4 . Следовательно, величина

много меньше 2 · 10-4. Положим ε π2 ≤ 2 ⋅ 10 − 6 Тогда

ε π2 должна быть

ε π2 ≤

2 ⋅ 10 − 3 ≈ 0,15%

(округление

с

завышением),

и

соответствующая

26

абсолютная погрешность ∆ π = ε π π ≤ 0,004 . Отсюда следует, что значение числа

π , округленное до тысячных долей 3,142, даст пренебрежимо малый вклад в

погрешность результата ε V .

Теперь, подставляя в (34) численные значения d и h , вычисляем

среднее значение объема конуса V = 4189 мм3. В выражении относительной

погрешности (32) отбросим пренебрежимо малую величину ε π . Тогда

ε V = 4ε d2 + ε h2 ≈ 0,014 .

Затем

вычисляем

абсолютную

погрешность

∆ V = ε V ⋅ V = 56 мм 3 .

Окончательный результат можно записать в виде: V = (4189 ±

± 56) мм3 при доверительной вероятности α = 0,95 .

В заключение заметим, что совершенствование экспериментальной

методики должно проводиться в направлении уменьшения погрешности

измеряемой величины. Для этого иногда приходится выполнять некоторые

предварительные измерения.

3. 2 Определение моментов инерции с помощью трифилярного

подвеса

Рассмотрим в качестве примера ситуацию, с которой студенты

сталкиваются в практической работе «Определение моментов инерции с

помощью трифилярного подвеса».

Трифилярный подвес представляет собой две круглые горизонтальные

платформы: верхнюю, имеющую радиус r и нижнюю с радиусом R . Обе

платформы соединены тремя нитями одинаковой длины L. Нижняя

платформа совершает гармонические крутильные колебания с периодом T

относительно вертикальной оси, проходящей через центры обеих платформ.

Момент инерции J тела, помещенного на нижнюю платформу, может быть

вычислен по следующей формуле, которая выводится студентами перед

выполнением эксперимента:

J=

mgRrT 2

4π 2 L

,

(35)

где m - суммарная масса нижней платформы и лежащего на ней тела.

Перед началом опытов предлагается оценить число колебаний nT,

необходимое для измерения момента инерции J с максимальной точностью.

Измерение периода T является косвенным, т.к. в опыте измеряется

время t, за которое нижняя платформа совершит nT колебаний. Значение

периода определяется отношением: T = t / ∆ nT. Считая величину nT целым

числом, которое определяется точно ( ∆ nT = 0), выразим абсолютную и

относительную погрешности вычисления периода

∆T =

∆t

nT

,

εT =

∆T

∆t

=

T

T ⋅ nt

,

(36)

27

где ∆ t - абсолютная погрешность измерения времени колебаний.

Аналогично вышеприведенным примерам, выразим относительную

погрешность момента инерции ZJ через относительные погрешности величин,

входящих в правую часть (35):

εJ =

ε m2 + ε R2 + ε r2 + ε L2 + 4ε T2 + ε g2 + 4ε π2

Как и в предыдущем примере, оставим в числе π количество знаков,

достаточное для пренебрежения последним слагаемым под корнем по

сравнению с остальными слагаемыми.

Погрешности величин R, r, L, m и g определяются методами их прямых

измерений. Следовательно, для увеличения точности определения момента

инерции нам остается максимально уменьшить погрешность определения

периода крутильных колебаний. Из (36) видно, что для этого необходимо

увеличивать число колебаний nT.

На практике число nT определяют из условия

4ε T2 < < ε m2 + ε R2 + ε r2 + ε L2 + ε g2 .

(37)

Обозначим E2 правую часть неравенства (37) и будем понимать под

словами «много меньше» отличие на два порядка. Тогда неравенство (37)

преобразуется к виду

4ε T2 ≤ E 2 / 100 или ε T2 ≤ E 2 / 400 .

(38)

3. 3 Примеры использования метода наименьших квадратов

Приведем несколько практических примеров.

Пример а. «Определение момента инерции тел относительно

нецентральных осей» используется установка, в конструкцию которой входит

подвешенная на проволоке платформа с тремя центрирующими грузами.

Тело, момент инерции J которого предстоит измерить, помещается на

платформу. Поворот платформы на некоторый угол порождает крутильные

колебания. Измерение периода крутильных колебаний Т позволяет вычислить

момент инерции J исследуемого тела.

Теоретический анализ колебательного процесса показывает, что момент

инерции тела J связан с периодом колебаний платформы T следующим

образом:

J = С·T 2- J0 ,

(39)

28

где J0 - момент инерции платформы с тремя грузами и С - некоторый

постоянный коэффициент.

Следовательно, на начальном этапе работы студентам необходимо

определить две постоянные экспериментальной установки: величины

С

и J0.

Для определения этих неизвестных проводятся измерения периода

крутильных колебаний с использованием в качестве тел дисков, которые

коаксиально помещаются на платформу. Момент инерции однородного диска

относительно собственной оси симметрии определяется его массой и

радиусом. Измерение периода крутильных колебаний было описано в

примере для трифилярного подвеса выше.

Пусть в процессе измерений были получены результаты, приведенные в

первых двух строках таблицы 11.

Номер опыта

(k)

Тk (с)

Jk (кг-м2)

Тk2 (c2)

Тk4 (c4)

Jk-Т k2

(кг.м2.c2)

1

2

3

4

1,41

4,75-10-3

1,988

3,953

9,443-10-3

1,525

9,9-10-3

2,326

5,409

2,302-10-2

1,63

15-10-3

2,657

7,059

3,985-10-2

1,725

20-10-3

2,976

8,854

5,951-10"2

Таблица 11

Число опытов N = 4.

Суммы

4,965-10-2

9,946

25,275

0,1318

Согласно (39), зависимость между квадратом периода колебаний

платформы T 2 и моментом инерции тела J является линейной и формально

совпадает с функцией вида Y = β X + γ . При этом коэффициент С имеет смысл

углового коэффициента β , а момент инерции платформы J0 - смысл

свободного члена γ линейной функции, взятого с обратным знаком.

Естественно, для нахождения неизвестных постоянных С и J0 следует

применить вышеизложенный метод наименьших квадратов.

Квадратичная функция (39) превращается в линейную, если аргументом

полагать квадрат периода колебаний. Поэтому, чтобы применить метод

расчета, следует в качестве величин xk использовать квадраты измеренных

значений периода. Вычисленные значения xk = Тk2 (k =1, …4) записаны в

третьей строке табл. 11.

В остальных строках таблицы указаны произведения, необходимые для

расчета четырех сумм, входящих в формулы. Последний столбец таблицы

содержит эти четыре суммы, приведенные здесь для контроля результатов

промежуточных вычислений.

По данным таблицы 11 проводятся вычисления величин b и g с

помощью формулы

29

N 2 N

N

∑ xk ∑ yk − ∑ xk k =

g = k=1 k=1 k=1 2

N

N

N ∑ xk2 − ∑ xk

k=1

k=1

xk yk

k=1

N

∑

(40)

b = 0,0154 , g = - 0,026 .

Это значит, что искомые параметры имеют следующие значения

С ≈ 0,0154 (кг м 2/c2) , J0 ≈ 0,026 (кг/м2).

(41)

Равенства (41) приближенные, так как результаты измерений Tk и Jk

содержат экспериментальные погрешности. Для расчета погрешностей

искомых параметров С и J0 необходимо сначала вычислить

среднеквадратичные отклонения Sb и Sg для коэффициентов линейной

зависимости по формулам (42) и (43) соответственно.

Sb =

Q

N

( N − 2)∑ ( xk − x ) 2

(42)

k=1

x=

1

N

N

∑

k=1

xk

(43)

Расчеты по данным табл. 11 дают такие результаты:

Sb = 6,8·10-5 (кг·м 2/c2) , Sg = 1,71·10-4 (кг·м2) .

(44)

Теперь следует задать доверительную вероятность α . Выберем

величину α равной 0,95. Так как было проведено только четыре пары

измерений значений Тk и Jk (N = 4), то коэффициент Стьюдента следует брать

для числа степеней свободы (N - 2) = 2. По таблице приложения 2 находим

его значение t0,95 2 = 4,303. Умножим найденный коэффициент Стьюдента на

среднеквадратичные отклонения (44) и получим соответственно абсолютные

погрешности найденных параметров С и J0 функции (39):

∆ С = t0,95 , 2·Sb = 2,9·10-4 (кг·м 2/c2);

∆ J 0 = t0,95 , 2·Sg = 7,4·10-4 (кг ·м2).

Вычисленные абсолютные погрешности ∆ С и ∆ J0 равны

полуширинам доверительных интервалов для искомых постоянных С и J0

30

платформы, используемой в данной лабораторной работе.

Полученные результаты можно записать в интервальной форме: при

доверительной вероятности α = 0,95.

0,0151(кг·м2/с2) ≤ С ≤ 0,0157 (кг·м2/с2),

0,0252 (кг·м2) ≤ J0 ≤ 0,0267 (кг·м2)

Можно дополнительно вычислить относительные погрешности величин

С и J0 , разделив абсолютные погрешности ∆ С и ∆ J0 на соответствующие

числовые значения (41):

ε с = ∆ С / С = 0,019

,

ε J 0 / J 0 = 0,028

(45)

Проделанные расчеты проиллюстрируем графиком зависимости (40)

для значений параметров (41). На том же графике нанесем

экспериментальные данные (см. рис. 5).

Рис. 5 Зависимость момента инерции набора дисков J от квадрата периода

колебаний платформы Т 2.

Черными кружками обозначены экспериментальные результаты.

Сплошной линией изображена линейная аппроксимирующая функция,

полученная методом наименьших квадратов. Из рис. 3 видно, что результаты

измерений очень мало отклоняются от графика линейной зависимости,

полученной методом наименьших квадратов. Кроме того, параметры

линейной зависимости (41) определены с малой относительной

погрешностью (45). Это свидетельствует о грамотной методике проведения

эксперимента и тщательности измерений.

Пример b. В ходе выполнения практической работы «Математический

маятник» студенты исследуют процесс затухания колебаний. Согласно

31

теории, амплитуда колебаний ϕ с течением времени t описывается

монотонно убывающей экспоненциальной функцией

ϕ = ϕ 0 exp( − δ t )

,

(46)

где параметр δ называется коэффициентом затухания, а величина ϕ 0

представляет собой амплитуду в начальный момент времени.

Целью эксперимента является определение коэффициента затухания δ .

Маятник отклоняют на некоторый начальный угол и отпускают с нулевой

начальной скоростью, одновременно включая секундомер. В процессе

затухания колебаний несколько раз одновременно измеряются амплитуда

колебаний (угол отклонения от положения равновесия) и время, прошедшее с

момента начала колебаний.

Результаты одного из подобных экспериментов сведены в табл. 12.

Время t (с)

Амплитуда ϕ (угловые

Ln( ϕ )

Таблица 12

градусы)

4

11

20

36

49

66

83

111

148

199

280

55

50

45

40

35

30

25

20

15

10

5

4,007

3,912

3,807

3,689

3,555

3,401

3,219

2,996

2,708

2,303

1,609

Результаты прямых измерений приведены в первых двух столбцах. В

третьем столбце указаны соответствующие значения натуральных

логарифмов. Положим числа первого столбца значениями xk, а третьего —

значениями zk (k = 1,..., N), где N = 11 — количество выполненных пар

измерений. Следуя методике вычислим величину b* = -8,57·10-3 с–1, а затем по

второй формуле

~

~

A = e x p g( ∗ ),B0 = − b ∗

(47)

получим приближенное значение коэффициента затухания экспоненциальной

функции (46):

δ = − b∗ = 8,57 ⋅ 10 − 3 c − 1

32

Чтобы построить доверительный интервал для искомого коэффициента

затухания, сначала подсчитаем для случайной величины g среднеквадратичное отклонение (42) Sb = 1,21104 с–1 . Выберем доверительную

вероятность α = 0,95. Из таблиц извлечем значение коэффициента

Стьюдента t α 9 = 2,262 для α = 0,95 и числа степеней свободы N - 2 = 9.

Полуширина доверительного интервала для коэффициента затухания равна

Sb·t α

, 9

= 2,73·10-4 с–1.

Таким образом, получим окончательный результат в виде

8,29 ⋅ 10 − 3 с − 1 ≤ δ ≤ 8,84 ⋅ 10 − 3 с − 1

при доверительной вероятности а = 0,95.

Пример c. Одной из задач практической работы «Изучение законов

движения с помощью машины Атвуда» является экспериментальное изучение

характера движения тела под действием постоянной силы. После установки

перегрузка определенной массы m измеряется величина t - время опускания

груза с заданной высоты h . По условиям эксперимента груз начинает

двигаться с нулевой начальной скоростью. Высота отсчитывается от

положения, в котором скорость равна нулю.

Согласно физической теории зависимость высоты h от квадрата времени t является линейной, причем угловой коэффициент равен 0,5·α, где α ускорение тела:

(48)

h = at 2 / 2

На величину времени опускания груза в машине Атвуда влияют различные факторы, которые можно полагать случайными, что приводит к

разбросу измеряемых значений t при неизменных величинах m и h . Следует

отметить, что этот разброс значительно превышает приборную погрешность

используемого электронного секундомера.

По этим причинам в эксперименте при фиксированной массе перегрузка m для каждого значения высоты hi (i = 1,… N) время опускания tis

измеряется несколько раз (s = 1,…K), где N — количество различ-ных высот,

а K — число измерений времени для определенной высоты. Пусть для

перегрузка массой 12 г были получены результаты, при-веденные в табл. 13.

Высота hi (м)

Время опускания груза tis (с)

t

0,3

0,6

0,9

1,2

2,0

2,8

1,293

4,28

7,533

1,0

2,0

3,0

1,2

2,2

2,4

2

i

2

(с )

q

2

i

Таблица 13.

(с )

4

0,129

0,47

5,39

33

1,2

1,5

1,8

2,1

3,2

3,8

3,8

4,0

3,4

4,0

4,0

4,0

3,0

3,8

4,0

4,2

10,267

14,96

15,48

16,547

3,278

1,622

1,622

1,793

В четырех левых столбцах записаны результаты прямых измерений

высоты и времени. Видно, что в данной серии опытов N = 7 и К = 3.

Для вычисления величины ускорения используется вариант метода

наименьших квадратов. Аргументом является высота, функцией - квадрат

времени опускания груза. Значения аргумента h составляют первый столбец

табл. 13. Измеренные времена опускания tis возводятся в квадрат и

усредняются для каждой высоты hi. Полученные средние ti2 записаны в

пятый столбец табл. 13.

Расчет приближенного значения углового коэффициента линейной

зависимости квадрата времени опускания от высоты

t2 = β

⋅h

(50)

проводится по первой формуле. При этом в качестве величин Хк и yk

берутся значения первого и пятого столбцов соответственно табл. 13.

Приближенный угловой коэффициент b получается равным 9,00 (с2/м).

Cвязь ускорения a падающего груза с угловым коэффициентом β

дается сравнением функций (49) и (50):

a = 2/ β .

(51)

Пользуясь полученным числом b = 9,00 (с2/м), вычисляем приближенное значение ускорения падающего груза:

a ≈ 0,22 (м/с2) .

(52)

Для построения соответствующего доверительного интервала необходимо вычислить суммы. В качестве промежуточных результатов в

последнем столбце таблицы 13 приведем характеристики разброса квадрата

времени опускания относительно средних значений ti2 , т.е. величины qi2 .

Расчеты дают следующие значения

Q1 = 8,104 (с 4), Q2 = 14,305 (с4) , Q0 = 38,618 (с4).

Среднее значение аргументов, приведенных в табл. 13, вычисляется

легко: h = 1,2 (м). Среднеквадратичное отклонение SNb высчитывается по

формуле:

34

2

S Nb

=

mQ + Q2

N

( Nm − 2) ∑

k=1

( xk − x ) 2

(53)

SNb = 0,90 (с2/м).

Теперь возьмем доверительную вероятность а = 0,95 и для числа

степеней свободы (N·K - 2) = 19 извлечем из таблицы коэффициент

Стьюдента ta,19 = 2,093. Согласно формуле получаем доверительный интервал

для углового коэффициента β линейной зависимости

7,12 (с2/м)<

β

< 10,88 (с2/м).

(54)

Пользуясь соотношением (52), пересчитаем границы доверительного

интервала (54) в границы доверительного интервала для ускорения.

Окончательно получаем

0,18 (м/с2)<а< 0,28 (м/с2)

(55)

при доверительной вероятности а = 0,95.

Значительная ширина доверительного интервала для ускорения, иначе

говоря, большая абсолютная погрешность рассчитанного значения ускорения

обусловлена разбросом измеренных значений времени опускания груза (см.

табл. 13), что, в свою очередь, вызвано влиянием различных случайных

факторов на исследуемое движение тела.

Примечание. Если построить доверительный интервал для свободного

члена зависимости квадрата времени опускания от высоты, пользуясь

формулами:

N

N N

N ∑ xk y k − ∑ xk ∑ y k

b = k=1 N k= 1 N k=1 ,

N ∑ xk2 − ∑ xk

k=1

k=1

g − tα ,ν S Ng ≤ γ ≤ g + tα ,ν S Ng

2

S Ng

mQ 1 + Q2 1

=

+

( N m − 2) Nm

,

x

N

2

( xk − x )

∑

k=1

2

(56)

(57)

.

(58)

(56), (57), (58), то мы получим граничные значения: (–3,09; 1,60).

35

Полученный результат не противоречит утверждению о том, что свободный

член исследуемой зависимости квадрата времени опускания от высоты имеет

нулевое значение.

4 Перечень тем практических работ:

1

2

3

4

5

6

7

Построение моделей на основании метода наименьших квадратов

Построение нелинейной моделей объекта исследования

Составление ПФП эксперимента, обработка и анализ его результата

Составление ДФП эксперимента, обработка и анализ его результатов

Составление плана эксперимента второго порядка, обработка и анализ

его результатов

Методы оптимизации объекта исследования

8

Построение модели объекта исследования в условиях аддитивного

дрейфа.

5 Список рекомендуемых к изучению книг и методических

материалов

Адлер, Ю.П. Планирование эксперимента при поиске оптимальных

условий / Ю.П. Адлер, Е.В. Маркова, Ю.В. Грановский. – М.: Наука, 1976.

2 Асатурян, В.И. Теория планирования эксперимента: Учеб. пособие для

вузов / В.И. Асатурян. – М.: Радио и связь, 1983. – 243 с.

3

Белай, Г.Е. Организация металлургического эксперимента: Учеб.

пособие / Белай Г.Е., Дембовский В.В., Соценко О.В.. – М.: Металлургия,

1993.

4 Грачев, Ю.П. Математические методы планирования экспериментов /

Ю.П. Грачев. – М.: Пищевая промышленность, 1979.

5 Джонсон, Н. Статистика и планирование эксперимента в технике и науке:

Методы планирования эксперимента / Н. Джонсон, Ф. Лион. – М.: Мир, 1981.

– 520 с.

6 Ивоботенко, Б.А. Планирование эксперимента в электромеханике / Б.А.

Ивоботенко, Н.Ф. Ильинский, И.П. Копылов. – М.: Энергия, 1971. – 185 с.

7

Копылов, И.П. Математическое моделирование электрических машин:

Учебник для вузов / И.П. Копылов. – М.: Высш. шк., 1994. – 318 с.

8 Красовский, Г.И. Планирование эксперимента / Г.И. Красовский, Г.Ф.

Филаретов. – Мн.: Изд-во БГУ, 1982. – 302 с.

9 Мельников, С.В. Планирование эксперимента в исследованиях

сельскохозяйственных процессов / С.В. Мельников. – Л.: Колос, 1980. – 168

с., ил.

10 Монтгомери, Д. К. Планирование эксперимента и анализ данных / Д. К.

1

36

Монтгомери. – Л.: Судостроение, 1980. – 384 с.

11 Романов, В.Н. Планирование эксперимента: Учебное пособие / В.Н.

Романов. – Л.: СЗПИ, 1992.

12 Слотин, Ю.С. Композиционное планирование регрессионного

эксперимента / Ю.С. Слотин. – М.: Знание, 1983. – 52 с.

13 Тихомиров, В.Б. Планирование и анализ эксперимента / В.Б. Тихомиров. –

М.: Легкая индустрия, 1974. – 262 с.

14 Чалый, В.Д. Планы эксперимента высоких порядков для идентификации

объектов: Учеб. пособие / В.Д. Чалый. – М.: Изд-во МИФИ, 1987. – 64 с.

Дополнительная литература:

15

Адлер, Ю.П. Введение в планирование эксперимента / Ю.П. Адлер. –

М.: Металлургия, 1967.

16

Адлер, Ю.П. Планирование эксперимента при поиске оптимальных

условий / Ю.П. Адлер, Е.В. Маркова, Ю.В. Грановский. – М.: Наука, 1971.

17

Алексеев, В.В. Практикум по вероятностным методам в измерительной

технике: Учеб. пособие для вузов / В.В.Алексеев, Р.В.Долидзе,

Д.Д.Недосекин, Е.А.Чернявский. – СПб.: Энергоатомиздат, 1993.

18

Асатурян, В.И. Теория планирования эксперимента / В.И. Асатурян. –

М.: Радио и связь, 1983.

19

Богатырев, А.А. Стандартизация статистических методов управления

качеством / А.А. Богатырев, Ю.Д. Филиппов. – М.: Изд-во стандартов, 1989.

20

Джонсон, Н. Статистика и планирование эксперимента в технике и

науке / Н. Джонсон, Ф. Лион. – М.: Мир, 1981.

21

Математическая теория планирования эксперимента / Под ред.

С.М.Ермакова.– М.: Наука, 1983.

22

Михайлов, В.И. Планирование эксперимента в судостроении / В.И.

Михайлов, К.М. Федосов Л.: Судостроение, 1978.

23

Назаров, Н.Г. Измерения: планирование и обработка результатов / Н.Г.

Назаров. – М.: ИПК Изд-во стандартов, 2000

24

Налимов, В.В. Теория эксперимента / В.В. Налимов. – М.: Мир, 1967.

25

Планирование эксперимента в исследовании технологических

процессов. – М.: Мир, 1977.

26

Хикс, Ч. Основные принципы планирования эксперимента / Ч. Хикс. –

М.: Мир, 1967.

37

ПРИЛОЖЕНИЕ 1.

Вводные замечания

Система MATLAB (матричная лаборатория) была создана

специалистами фирмы Math Works, Inc. как язык программирования высокого

уровня для технических вычислений. Она вобрала в себя не только передовой

опыт развития и компьютерной реализации численных методов, накопленный

за последние десятилетия, но и весь опыт становления математики за всю

историю человечества.

Одним из самых важных достоинств системы MATLAB является

возможность ее расширения с целью решения новых научно-технических

задач. Это достигается прежде всего созданием целого ряда пакетов

расширения системы, охватывающих многие новые и практически полезные

направления компьютерной математики. Однако если по самой системе

MATLAB уже опубликован ряд известных книг, то книг по пакетам

расширения все еще очень мало. Этот пробел и призвано в некоторой степени

восполнить данное приложение.

Данное приложение по системе MATLAB и ключевому пакету

расширения Neural Networks Toolbox, имеющему ярко выраженную

направленность в область экспериментальных исследований, для решения

задач мягкого моделирования и измерения, распознавания образов и

оптимального отображения результатов эксперимента.

При подготовке данного приложения, определённую сложность

представляли отбор и систематизация огромного по объему материала по

системе MATLAB . Фирменное описание только собственно системы

MATLAB, составляет около 4000 страниц, а об объеме описания некоторых

пакетов расширения дают представление следующие данные:

Пакет расширения

Объем описания, с

Simulink

815

Neural Networks

742

Signal Processing

780

Statistics

420

Хотя выше указана лишь небольшая часть наиболее известных пакетов

расширения MATLAB, объем их описания около трех тысяч страниц.

Поэтому материал настоящего приложения никоим образом не является

прямым переводом фирменных описаний. Это материал, содержащий

специально отобранные и практически не повторяющиеся сведения о пакете

расширения системы MATLAB, Neural Networks Toolbox. который имеет ярко

выраженную математическую направленность и служит для реализации

новых направлений компьютерной математики, таких как математическое

моделирование, построение нейронных сетей и нечеткая логика. По

38

рубрикации и характеру описания он существенно отличается от фирменных.

МАТЕМАТИЧЕСКИЙ ПАКЕТ РАСШИРЕНИЯ MATLAB

NEURAL NETWORKS TOOLBOX

Пакет существенно расширяет возможности системы MATLAB при

выполнении массовых математических вычислений и моделировании

сложных объектов и систем — использующий новые подходы: нечеткую

логику и нейронные сети. Особое внимание уделено визуализации

математических вычислений и их теоретическому обоснованию.

Содержание приложения

Пакет расширения по нейронным сетям

Назначение пакета Neural Networks Toolbox

Биологический нейрон

Структура и свойства искусственного нейрона

Классификация нейронных сетей и их свойства

Топология нейронных сетей

Обучение нейронных сетей

Алгоритм обратного распространения

Переобучение и обобщение нейронных сетей

Обучение без учителя

Применение нейросетей

Области применения нейросетей: классификация

Кластеризация и поиск зависимостей :

Прогнозирование

Персептроны

Нейронные сети встречного распространения

Функционирование сети

Обучение слоя Кохонена

Обучение слоя Гроссберга

Модификации

Нейронные сети Хопфилда и Хэмминга

Сеть с радиальными базисными элементами

Вероятностная нейронная сеть

Обобщенно-регрессионная нейронная сеть

Линейные НС

Функции пакета Neural Networks Toolbox

Обзор функций пакета Neural Networks Toolbox

Функции активации (передаточные функции) и связанные с

39

ними

функции

Функции обучения нейронных сетей

Функции настройки слоев нейронов

Функции одномерной оптимизации

Функции инициализации слоев и смещений

Функции создания нейронных сетей

Функции преобразования входов сети

Функции весов и расстояний

Функции размещения нейронов (топологические функции)

Функции использования нейронных сетей

Графические функции

Прочие функции

Примеры создания и использования нейронных сетей

Нейронные сети для аппроксимации функций

Прогнозирование значений процесса

Использование слоя Кохонена

Сеть Хопфилда с двумя нейронами

Классификация с помощью персептрона

Адаптивный линейный прогноз

Использование сети Элмана

Задача классификации: применение сети встречного

распространения

Создание и использование самоорганизующейся карты

Использование Simulink при построении нейронных сетей

Блоки функций активации (Transfer Functions)

Блоки преобразования входов сети

Блоки весовых коэффициентов

Формирование нейросетевых моделей

Глава 6. Пакет нечеткой логики Fuzzy Logic Toolbox

Назначение и возможности пакета Fuzzy Logic Toolbox

Нечеткая информация и выводы

Нечеткие множества

Функции принадлежности нечеткой логики

Операции над нечеткими множествами

Пакет расширения по нейронным сетям

Назначение пакета Neural Networks Toolbox

Пакет Ncura] Networks Toolbox (Нейронные сети) содержит средства

для проектирования, моделирования, обучения и использования множества

известных парадигм аппарата искусственных нейронных сетей (ИНС): от

40

базовых моделей персептрона до самых современных ассоциативных и

самоорганизующихся сетей. Пакет может быть использован для решения

множества разнообразных задач, таких как обработка сигналов, нелинейное

управление, финансовое моделирование и т. п.

Для каждого типа архитектуры и обучающего алгоритма ИНС имеются

функции инициализации, обучения, адаптации, создания, моделирования,

демонстрации, а также примеры применения. Искусственные многослойные

нейронные сети конструируются по принципам построения их биологических

аналогов. Они уже сейчас способны решать широкий круг задач

распознавания образов, идентификации, управления сложными нелинейными

объектами, роботами и т. п. Отметим, что в настоящее время дальнейшее

повышение производительности компьютеров связывают с ИНС, в частности,

с так называемыми нейрокомпьютерами (НК), основу которых составляет

искусственная нейронная сеть.

Термин «нейронные сети» сформировался в 40-х годах XX в. в среде

исследователей, изучавших принципы организации и функционирования

биологических нейронных сетей. Основные результаты, полученные в этой

области, связаны с именами американских исследователей У. Маккалоха,

Д. Хебба, Ф. Розенблатта, М. Минского, Дж. Хопфилда и др. Представим

некоторые проблемы, решаемые в контексте ИНС и представляющие интерес

для пользователей.

• Классификация образов. Задача состоит в указании принадлежности

входного образа (например, речевого сигнала или рукописного символа),

представленного вектором признаков, к одному или нескольким

предварительно определенным классам. К известным приложениям относятся

распознавание букв, распознавание речи, классификация сигнала

электрокардиограммы, классификация клеток крови.

•

Кластеризация/категоризация.

При

решении

задачи

кластеризации, которая известна также как классификация образов «без

учителя», отсутствует обучающая выборка с метками классов. Алгоритм

кластеризации основан на подобии образов и помещает близкие образы в

один кластер. Известны случаи применения кластеризации для извлечения

знаний, сжатия данных и исследования свойств данных.

•

Аппроксимация функций. Предположим, что имеется

обучающая выборка ((х1,у1), (х2,у2)..., (xN,yN)) (пары данных «вход—выход»),

которая генерируется неизвестной функцией F(x), искаженной шумом. Задача

аппроксимации состоит в нахождении оценки неизвестной функции F(x).

Аппроксимация функций необходима при решении многочисленных

инженерных и научных задач моделирования.

•

Предсказание/пропюз. Пусть заданы п дискретных отсчетов {

y(t1)> y(t2), ..., y{tk)} в последовательные моменты времени tlt t2, -, th. Задача

состоит в предсказании значения г/(4м) в некоторый будущий момент

времени 4+,. Предсказание/прогноз имеют значительное влияние на принятие

41

решений в бизнесе, науке и технике. Предсказание цен на фондовой бирже и

прогноз

погоды

являются

типичными

приложениями

техники

предсказания/прогноза.

•

Оптимизация. Многочисленные проблемы в математике,

статистике, технике, науке, медицине и экономике могут рассматриваться как

проблемы оптимизации. Задачей алгоритма оптимизации является

нахождение такого решения, которое удовлетворяет системе ограничений и

максимизирует или минимизирует целевую функцию. Известная задача

коммивояжера является классическим примером задачи оптимизации.

•