комбинаторные алгоритмы - Факультет информационных

advertisement

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РФ

НОВОСИБИРСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ

Факультет информационных технологий

Т. И. Федоряева

КОМБИНАТОРНЫЕ АЛГОРИТМЫ

Учебное пособие

Новосибирск

2011

УДК 519.1+510.52+519.683

ББК В127я73-1

Ф337

Федоряева Т. И. Комбинаторные алгоритмы: Учебное пособие /

Новосиб. гос. ун-т. Новосибирск, 2011. 118 с.

ISBN 978-5-4437-0019-9

Учебное пособие написано на основе курса "Комбинаторные алгоритмы", читаемого автором студентам факультета информационных

технологий НГУ. Наряду с теоретическими знаниями даётся описание

важнейших комбинаторных алгоритмов над объектами дискретной математики, приводится строгое обоснование рассматриваемых алгоритмов и детально изучается их асимптотическая сложность.

Пособие прежде всего ориентировано на студентов программистских

специальностей, которым по роду их занятий приходится заниматься разработкой алгоритмов и анализом их вычислительной сложности.

Изучение комбинаторных алгоритмов также будет полезно любому заинтересованному читателю для развития самостоятельных навыков по

построению и анализу алгоритмов, для решения задач в области дискретной математики и применения методов дискретного анализа в своей

профессиональной деятельности.

Рецензенты:

зав. лабораторией совершенных комбинаторных структур Института

математики им. С. Л. Соболева, канд.физ.-мат.наук С. В. Августинович;

доцент факультета информационных технологий Новосибирского государственного университета, канд.физ.-мат.наук А. Л. Пережогин

Учебное пособие разработано в соответствии с требованиями ФГОС

ВПО к структуре и результатам освоения основных образовательных

программ по профессиональному циклу по направлению подготовки

"Информатика и вычислительная техника". Издание подготовлено в

рамках реализации Программы развития государственного образовательного учреждения высшего профессионального образования "Новосибирский государственный университет" на 2009–2018 годы.

c Новосибирский государственный

⃝

университет, 2011

c Т. И. Федоряева, 2011

⃝

ISBN 978-5-4437-0019-9

Оглавление

Предисловие

4

Глава 1. Введение

7

1. Машинные алгоритмы и их сложность

7

2. Асимптотический формализм оценок времени работы алгоритмов 10

3. Алгоритм нахождения n-факториального представления числа

17

Глава 2. Генерация комбинаторных объектов

20

1. Перестановки и алгоритмы их порождения

21

1.1. Индекс перестановки

23

1.2. Генерация перестановок в лексикографическом порядке

27

1.3. Порождение перестановок через векторы инверсий

32

1.4. Алгоритм Джонсона – Троттера генерации перестановок

36

2. Подмножества конечного множества

46

2.1. Генерация двоичных векторов и подмножеств

47

2.2. Коды Грея и алгоритм их генерации

50

3. Генерация сочетаний в лексикографическом порядке

56

Глава 3. Генерация случайных комбинаторных объектов

60

1. Алгоритм построения случайной перестановки

60

2. Алгоритм генерации случайного подмножества и сочетания

63

Глава 4. Разбиения чисел и множеств

65

1. Упорядоченные и неупорядоченные разбиения числа n

65

2. Генерация разбиений числа n в словарном порядке

67

3. Разбиения конечного множества

72

4. Генерация разбиений n-элементного множества

73

Глава 5. Сортировка комбинаторных объектов

79

1. Задача сортировки

80

2. Нижние оценки сложности алгоритма сортировки сравнением

84

3. Алгоритм сортировки вставками и оценки времени его работы

89

4. Алгоритм пузырьковой сортировки и оценки времени его работы 93

5. Алгоритм быстрой сортировки и оценки времени его работы

95

6. Алгоритм пирамидальной сортировки и оценки его трудоёмкости 105

7. Линейный алгоритм сортировки подсчётом

114

Список литературы

117

3

Предисловие

Комбинаторные алгоритмы предназначены для выполнения вычислений на различного рода объектах, возникающих в прикладных комбинаторных задачах и при исследовании дискретных математических

структур. Необходимость разработки эффективных, быстрых комбинаторных алгоритмов уже давно не вызывает сомнений. На практике

нужны не просто алгоритмы, а хорошие алгоритмы в широком смысле. Одним из основных критериев качества алгоритма является время,

необходимое для его выполнения.

Разработке и анализу вычислительной сложности комбинаторных

алгоритмов над классическими комбинаторными объектами посвящено

настоящее учебное пособие. Наряду с теоретическими знаниями даётся

описание таких важнейших алгоритмов, приводится их строгое обоснование и детально изучается асимптотическая сложность рассматриваемых алгоритмов. Мы познакомим читателя с широким кругом понятий

и сведений из дискретной математики, необходимых практикующему

программисту. Пополним запас примеров нетривиальных алгоритмов

над объектами дискретной математики, помогающих существенно обогатить навыки самостоятельного конструирования алгоритмов и сформировать мышление, позволяющее использовать методы дискретного

анализа при разработке эффективных алгоритмов для решения практических задач и оценке их сложности.

Для понимания материала учебного пособия требуется знание основных понятий и фактов из дискретной математики и математической

логики. Читатель должен обладать минимальным опытом программирования, каждый изучаемый алгоритм снабжен понятным псевдокодом,

позволяющим реализовать рассматриваемый алгоритм на доступном

языке программирования. При изучении отдельных тем используются

основы математического анализа и теории вероятностей.

4

Практически все рассматриваемые задачи и алгоритмы их решения,

разумеется, не являются новыми, однако во многих случаях изложенные доказательства и обоснования оценок сложности оригинальны. Мы

попытаемся изложить каждый алгоритм так, чтобы был понятен путь

его возникновения. Особое внимание уделяется выявлению интуитивных идей, лежащих в основе алгоритмов, и иллюстрации работы изучаемых алгоритмов на примерах.

Материал учебного пособия организован следующим образом. В первой главе обсуждаются понятие сложности машинных алгоритмов и

язык псевдокода, на котором записываются алгоритмы. Даётся асимптотический формализм для оценок времени работы алгоритмов и приводятся примеры асимптотических соотношений. На примере алгоритма n-факториального представления числа изучаются введённые понятия и обозначения, исследуется время работы алгоритма.

Вторая глава посвящена задаче генерации комбинаторных объектов, среди которых перестановки, все подмножества заданного конечного множества, двоичные векторы, коды Грея и сочетания из n элементов по k. Основное внимание уделено линейным алгоритмам генерации объектов в лексикографическом порядке и в порядке минимального изменения. Для перестановок изучаются понятия индекса относительно лексикографического порядка и вектора инверсий. Детально

исследуются линейные алгоритмы генерации перестановок в лексикографическом порядке и Джонсона – Троттера в порядке минимального

изменения. Далее рассматриваются алгоритмы порождения двоичных

векторов и подмножеств n-элементного множества, понятие кода Грея

и линейный алгоритм генерации двоично-отраженных кодов Грея. Наконец, в лексикографическом порядке порождаются все сочетания. Для

всех изучаемых алгоритмов обосновывается их корректность и оценивается асимптотическая сложность.

Третья глава знакомит с алгоритмами генерации случайных комбинаторных объектов с равномерным распределением и даёт начальное

5

представление о теории вероятностных алгоритмов. Она содержит алгоритмы построения случайной перестановки, случайного подмножества

и случайного сочетания.

В четвёртой главе рассматривается задача порождения разбиений

совокупности комбинаторных объектов. Изучаются разбиения чисел и

множеств. Обсуждаются упорядоченные и неупорядоченные разбиения

числа n. Изучаются алгоритмы генерации разбиений числа n в словарном порядке и разбиений n-элементного множества, которые имеют

асимптотически наилучший порядок.

Пятая глава посвящена задаче сортировки комбинаторных объектов. В ней мы знакомим читателя с понятиями минимального, среднего

и максимального времени работы алгоритма. Сначала устанавливаются

нижние оценки сложности произвольного алгоритма сортировки сравнением. Далее изучаются алгоритмы сортировки вставками, пузырьковой, быстрой и пирамидальной сортировки. Для каждого из алгоритмов

устанавливается асимптотический порядок минимального, среднего и

максимального времени их работы. Глава заканчивается изучением линейного алгоритма сортировки подсчётом.

Учебное пособие написано на основе курса "Комбинаторные алгоритмы", читаемого автором студентам факультета информационных

технологий Новосибирского государственного университета. Оно прежде всего ориентировано на студентов программистских специальностей,

которым по роду их занятий приходится иметь дело с разработкой алгоритмов и анализом их вычислительной сложности. Предоставляемые

знания необходимы практикующему программисту, поскольку они существенно обогащают навыки конструирования эффективных алгоритмов. Изучение комбинаторных алгоритмов также будет полезно любому заинтересованному читателю для развития самостоятельных навыков по разработке и анализу алгоритмов, для решения задач в области

дискретной математики и применения методов дискретного анализа в

своей профессиональной деятельности.

6

Глава 1

Введение

1. Машинные алгоритмы и их сложность

Понятие алгоритма, подобно многим фундаментальным понятиям математики, является настолько интуитивно "понятным", насколько и

сложным при его строгой формализации и скорее должно рассматриваться как неопределяемое. С неформальной точки зрения под алгоритмом часто понимается формально описанная вычислительная процедура, получающая исходные данные, называемые входными данными алгоритма, и выдающая результат вычислений на выход . Мы также ограничимся таким подходом, оставляя многочисленные известные

формализации данного понятия вне рамок настоящего пособия.

Алгоритмы строятся для решения тех или иных вычислительных

задач. Формулировка задачи описывает, каким требованиям должны

удовлетворять входные и выходные данные, а алгоритм, решающий эту

задачу, для каждой входной последовательности находит решение задачи, записываемое в выходные данные. Такой алгоритм, когда для каждого допустимого ввода результатом его работы является требуемый

в задаче вывод, называют корректным. Некорректный алгоритм для

некоторых входных данных может вообще не завершить свою работу

или выдать выходные данные, отличные от требуемых в задаче.

При анализе алгоритма решения поставленной задачи нас в первую

очередь будет интересовать его трудоёмкость, под которой мы понимаем время выполнения соответствующей программы на ЭВМ. Ясно,

что этот показатель существенно зависит от типа используемого компьютера. Чтобы сделать наши выводы о трудоёмкости алгоритмов в

достаточной мере универсальными, будем считать, что все вычисления

производятся на некой абстрактной вычислительной машине. Такая машина в состоянии выполнять арифметические операции, сравнения, пересылки и операции условной и безусловной передачи управления. Эти

7

операции считаются элементарными. Мы принимаем, что каждая из

элементарных операций выполняется за единицу времени (т. е. не учитываем продолжительность времени, затраченного на выполнение самих этих операций), и, следовательно, время работы алгоритма равно

числу выполненных им элементарных операций. Память рассматриваемой абстрактной вычислительной машины состоит из неограниченного

числа ячеек, к которым имеется прямой доступ. После того, как всем

входным данным задачи присвоены конкретные значения, они размещаются в памяти компьютера.

С входными данными алгоритма связано некоторое натуральное

число (или набор целочисленных параметров), называемое размерностью данных , которое выражает меру их количества. Как определяется размерность данных? Это зависит от вида рассматриваемой задачи.

В одних случаях размерностью разумно считать число элементов на

входе, например, для задачи сортировки. В других более естественно

считать размерностью общее число ячеек, необходимых для размещения всех входных данных в памяти (такой подход является наиболее

употребительным). Как уже отмечалось, иногда размерность данных

измеряется не одним числом, а несколькими, например, в случае задач

для графов с n вершинами и m рёбрами. При изучении конкретных алгоритмов формализация понятия размерности данных, как правило, не

вызывает трудностей, поэтому мы не будем останавливаться на её детализации (чаще всего это будет длина входных данных). Отметим также,

что в литературе размерность данных иногда называют размерностью

самой задачи, для которой разрабатывается алгоритм её решения.

Определим сложность, или трудоёмкость алгоритма решения

данной задачи как функцию T от размерности данных n, ставящую в

соответствие каждому n наибольшее время T (n) работы алгоритма на

входных данных размерности n. Заданную таким образом сложность

иногда называют временной сложностью, в отличие от сложности по

памяти, определяющей величину объёма памяти, использованного ал8

горитмом, как функцию размерности данных. Анализ эффективности

каждого из представленных алгоритмов заключается в выяснении вопроса: как быстро растёт функция T (n) с ростом n? Иными словами,

нас интересует только асимптотическая сложность, т. е. асимптотическая скорость увеличения времени работы алгоритма, когда размерность данных неограниченно растёт.

Алгоритмы будем записывать на неформальном языке программирования, содержащем обычные общеизвестные конструкции. При этом

мы предполагаем, что читатель знаком с одним из языков программирования высокого уровня. Как правило, будем опускать описание типов и

переменных, использующихся в алгоритме, которое легко восстанавливается при записи окончательного кода программы. Приведем основные

операторы, используемые при написании псевдокода:

• операторные скобки для задания составного оператора

begin

...

end;

• операторы цикла

for i = 0 to n do A(i) (выполнять оператор A(i) последовательно

для i = 0, 1, 2, . . . , n);

for i = n downto 0 do A(i) (выполнять оператор A(i) последовательно для i = n, n − 1, n − 2, . . . , 0);

for x ∈ X do A(x) (выполнять оператор A(x) для всех элементов

x множества X в произвольной последовательности);

while условие A do B (выполнять оператор B до тех пор, пока

выполняется условие A);

• оператор присваивания x := y;

• условный оператор if условие A then B else C (если выполняется

условие A, выполнить оператор B, иначе выполнить оператор C );

9

• оператор x ↔ y (обмен значениями между x и y). В случае отсутствия в используемом языке программирования оператор обмена

↔ реализуется следующей процедурой Swap.

Procedure Swap(x, y);

z := x;

x := y;

y := z

• оператор вывода данных write.

2. Асимптотический формализм оценок

времени работы алгоритмов

Несмотря на то, что функция сложности алгоритма в некоторых случаях может быть определена точно, в большинстве случаев искать её

точное значение не имеет смысла. Дело в том, что для данных достаточно большой размерности постоянные множители и слагаемые низшего

порядка, участвующие в выражении для такой функции, вносят крайне

незначительный вклад и подавляются эффектами, вызванными увеличением размерности данных. Простейший эффект такого рода можно

наблюдать, когда функция T (n) сложности алгоритма представляет собой некоторый многочлен T (n) = am nm + am−1 nm−1 + . . . + a1 n + a0 .

В этом случае роль одночленов ai ni степени, меньшей степени m самого многочлена, несущественна, и ими можно пренебречь при достаточно

большой размерности n.

При анализе алгоритмов такой подход оказывается крайне полезным, так как предлагает наглядную характеристику эффективности

алгоритма — асимптотический порядок роста функции его сложности и

позволяет сравнивать производительность различных алгоритмов. Чтобы сравнить одну величину с другой, во многих случаях достаточно

знать не точные, а приближённые их значения, определяющие поведение роста этих величин. Например, известная формула Стирлинга даёт

10

широко применяемое приближение

n! ≈

√

2πn

( n )n

e

.

Paul Bachmann в 1894 г. ввел очень удобное обозначение O (читается

"o большое") для использования в приближенных формулах, до сих пор

этот формализм применяется во многих математических дисциплинах,

в том числе и при анализе алгоритмов.

Определение 1. Неотрицательная функция f (n) не превосходит

по порядку функцию g(n) (используем запись f (n) = O(g(n)) ), если

существуют положительные константы N и c такие, что f (n) ≤ c g(n)

для любого n ≥ N .

В этом случае функция g(n) является асимптотически верхней оценкой функции f (n)1 . Часто встречающемуся выражению "трудоёмкость

(сложность) алгоритма есть или равна O(g(n))" придаётся именно такой

смысл. Это означает, что для некоторой постоянной c алгоритм на произвольном входе размерности n заканчивает работу не более, чем через

c g(n) элементарных операций для всех достаточно больших n. В частности, трудоёмкость O(1) означает, что время работы соответствующего

алгоритма не зависит от размерности входа и не превосходит некоторой

константы. Алгоритм с трудоёмкостью O(n), где n — размерность входа, называют линейным. Алгоритм сложности O(nc ) называется поли( c)

номиальным. Алгоритм, сложность которого есть O 2 n , называется

экспоненциальным. Здесь c — положительная константа.

Записи с символом O дают верхнюю оценку скорости роста функции, но, вообще говоря, не дают точный порядок роста. Например, если

время работы алгоритма есть O(n2 ), это не означает, что это же время не может составлять O(n). Для нижних оценок применяется другая

запись с символом Ω (читается "омега большое").

1

С точностью до константы.

11

Определение 2. Неотрицательная функция f (n) не меньше по порядку функции g(n) (используем запись f (n) = Ω(g(n)) ), если существуют положительные константы N и c такие, что f (n) ≥ c g(n) для

любого n ≥ N .

В этом случае функция g(n) является асимптотически нижней оценкой функции f (n). И наконец, чтобы точно указать порядок роста функции f (n), не давая точных значений констант, применяется запись с

символом Θ (читается "тэта большое").

Определение 3. Неотрицательная функция f (n) асимптотически равна функции g(n) (используем запись f (n) = Θ(g(n)) ), если существуют положительные константы N, c1 , c2 такие, что выполняются

неравенства c1 g(n) ≤ f (n) ≤ c2 g(n) для всех n ≥ N.

Запись f (n) = Θ(g(n)) включает в себя две асимптотические оценки: верхнюю и нижнюю. Таким образом, начиная с некоторого N рост

функции f (n) полностью соответствует росту функции g(n). В дальнейшем выражению "сложность алгоритма есть Θ(g(n))" будем придавать

именно этот смысл.

Отметим, что для функции многих переменных f (n1 , . . . , nk ) символ

Λ(f (n1 , . . . , nk )), Λ ∈ {O, Ω, Θ} определяется подобным же образом.

Записи с асимптотическими обозначениями O, Ω, Θ очень удобны

и часто употребляются в уравнениях, но при этом требуют некоторой

осторожности. Дело в том, что используемый знак "=" — это не равенство в обычном смысле, а несимметричное (!) отношение включения подмножеств "⊆". В этом случае с формальной точки зрения запись O(g(n)) необходимо рассматривать как множество неотрицательных функций f (n), не превосходящих по порядку функцию g(n), а

функцию f (n) — как одноэлементное множество. Таким образом, запись

f (n) = O(g(n)) означает запись f (n) ∈ O(g(n)), запись O(n) = O(n2 )

означает O(n) ⊆ O(n2 ) и т. д. В случае арифметических операций над

12

такими множествами функций X, Y и функцией f (n) множества X + Y ,

X Y , f X определяются следующим естественным образом:

X + Y = {x + y | x ∈ X & y ∈ Y },

X Y = {x y | x ∈ X & y ∈ Y },

f X = {f x | x ∈ X}.

Аналогично следует трактовать Λ-записи в общем случае, когда Λ ∈

{O, Ω, Θ}. Используя введенные определения асимптотических обозначений, легко доказать справедливость свойств, сформулированных в

следующем утверждении.

Теорема 1. Пусть f (n), g(n), h(n) — неотрицательные функции и

Λ ∈ {O, Ω, Θ}. Тогда

(i) f (n) = Λ(f (n)) (рефлексивность);

(ii) если f (n) = Λ(g(n)) и g(n) = Λ(h(n)), то f (n) = Λ(h(n)) (транзитивность);

(iii) f (n) = O(g(n)) ⇔ g(n) = Ω(f (n)) (обращение);

(iv) f (n) = Θ(g(n)) ⇔ g(n) = Θ(f (n)) (симметричность);

(v) f (n) = Θ(g(n)) ⇔ (f (n) = O(g(n)) & f (n) = Ω(g(n)) (эквивалентность);

(vi) Λ(Λ(f (n))) = Λ(f (n)) (идемпотентность);

(vii) арифметические операции:

Λ(f (n)) Λ(g(n)) = Λ(f (n) g(n)),

f (n) Λ(g(n)) = Λ(f (n) g(n)),

Λ(f (n)) + Λ(g(n)) = Λ(f (n) + g(n)) = Λ(max{f (n), g(n)}),

cΛ(f (n)) = Λ(cf (n)) = Λ(f (n)), если c — положительная константа.

Условимся, что всюду далее при исследовании асимптотических

свойств функций будем использовать символ c, возможно с различными

индексами, для обозначения положительных констант, не зависящих от

аргумента изучаемых функций.

13

Приведем пример, содержащий несколько иллюстраций введенных

понятий и обозначений.

Пример 1.

(i) f (n) = Θ(n2 ), где f (n) = c1 n +

n

∑

c2 i + c3 .

i=1

Действительно, используя теорему 1 и формулу суммы арифметической прогрессии, получаем f (n) = O(n) + c2 (n2 + n)/2 + O(1) = O(n) +

O(n2 )+O(n)+O(1) = O(max{n, n2 }) = O(n2 ). Очевидно, f (n) ≥ c2 n2 /2 .

Поэтому f (n) = Ω(n2 ). Таким образом, f (n) = Θ(n2 ).

√

(ii) c n ̸= O( n).

В самом деле, пусть найдутся положительные константы c′ и N такие,

√

что c n ≤ c′ n для всех n ≥ N. Тогда n ≤ (c′ /c) 2 для всех достаточно

больших n, пришли к очевидному противоречию.

(iii) c nm ̸= Ω(nk ), где k > m.

Доказывается аналогично (ii).

(iv) O(n) + c1 2 n+c2 + c3 = O(2n ).

Следует из теоремы 1 и неравенства 2 n ≥ n.

(v) Hn = ln n + Θ(1) = Θ(ln n), 2 где

n

∑

1

Hn =

i=1

i

.3

Для асимптотических оценок гармонических чисел Hn воспользуемся

аппроксимациями интеграла произвольной интегрируемой убывающей

функции f (x) с помощью конечных сумм:

n+1

∫

f (x) dx ≤

m

2

3

n

∑

∫n

f (i) ≤

i=m

f (x) dx.

m−1

ln n — натуральный логарифм.

Конечные суммы Hn известны как гармонические числа.

14

Функция f (x) = 1/x убывает на интервале (1, +∞). Следовательно,

n+1

∫

ln(n + 1) − ln 2 =

∫

n

∑

1

dx

dx

≤

≤

= ln n.

x

i

x

i=2

n

1

2

Поэтому Hn = ln n + O(1) и Hn ≥ ln n + 1 − ln 2 = ln n + Ω(1). Таким

образом, Hn = ln n + Θ(1) = Θ(ln n).

Отметим, что аналогичные сравнения интеграла и конечной суммы

для произвольной возрастающей функции приводят к неравенствам

∫n

f (x) dx ≤

n

∑

n+1

∫

f (i) ≤

i=m

m−1

f (x) dx.

m

Такие оценки используются в нижеприведенных примерах (vi) и (viii).

(vi) ln(n!) = Θ(n ln n).

Действительно, ln(n!) =

∑n

i=1

ln i. Отсюда очевидно, ln(n!) ≤ n ln n =

O(n ln n). Для доказательства нижней оценки воспользуемся сравнением интеграла и конечной суммы функции ln x, возрастающей и положительной на интервале (1, +∞). Имеем

n

∑

∫n

ln i ≥

i=2

n

ln x dx = x ln x − x = n ln n − n + 1 = Ω(n ln n).

1

1

Следовательно, ln(n!) = Θ(n ln n).

Заметим, что более точные верхнюю и нижнюю оценки величин n!

и ln(n!) можно получить из формулы Стирлинга

( n )n (

√

)

n! = 2 π n

1 + Θ(1/n) .

e

(vii) lg(n!) = Θ(n lg n)4 .

Непосредственно следует из примера (vi) и равенства lg(n!) = lg e ln(n!).

(viii)

n

∑

i=1

4

i ln i =

n2

n2

ln n −

+ O(n ln n) = O(n2 ln n).

2

4

lg n — двоичный логарифм.

15

Действительно, поскольку f (x) = x ln x — возрастающая функция, как

и в примере (v), получаем следующие неравенства:

n−1

∑

∫n

i ln i ≤

i=2

2

n

x2

x2 x ln x dx =

ln x −

=

2

4 2

n2

n2

n2

n2

ln n −

− ln 4 + 1 ≤

ln n −

.

2

4

2

4

=

Осталось заметить, что

n

∑

i ln i = n ln n +

i=1

n−1

∑

i ln i.

i=2

⌈n/c⌉

(ix)

∑

⌊lg i⌋ = Ω(n lg n)5 .

i=1

Доказательство требуемой нижней оценки проведём с помощью метода

разбиения суммы на части. Для n ≥ 2c имеем6

⌈n/c⌉

∑

⌈n/2c⌉−1

⌊lg i⌋

=

i=1

∑

⌈n/c⌉

⌊lg i⌋ +

i=1

∑

⌊lg i⌋ ≥

i=⌈n/2c⌉

⌈n/c⌉

≥

∑

⌈n/c⌉

⌊lg i⌋ ≥

i=⌈n/2c⌉

∑

⌊ lg⌈n/2c⌉ ⌋ ≥

i=⌈n/2c⌉

≥ ( ⌈n/c⌉ − ⌈n/2c⌉ + 1 ) ( lg(n/2c) − 1 ) ≥

≥

n

( lg n − lg(2c) − 1 ) =

2c

= Ω(n) Ω( lg n) = Ω(n lg n).

Несмотря на то, что основное внимание мы уделяем порядку

роста времени работы, нельзя забывать, что бо́льший порядок роста сложности алгоритма может иметь меньшую мультипликативную постоянную7 , чем малый порядок роста сложности другого алгоритма. В таком случае алгоритм с быстро растущей сложностью

5

⌊x⌋ — наибольшее целое число, не превосходящее x;

⌈x⌉ — наименьшее целое число, не меньшее x.

6 Здесь использованы неравенства x − 1 < ⌊x⌋ ≤ x ≤ ⌈x⌉ < x + 1.

7 Константа c в определении O(g(n)).

16

может оказаться предпочтительнее для задачи с малой размерностью

данных и, возможно, для всех интересующих нас задач, например, с

практической точки зрения.

3. Алгоритм нахождения n-факториального

представления числа

Для знакомства с неформальным языком программирования, на котором будем записывать псевдокод, а также с понятием сложности алгоритма и используемой при его анализе асимптотической Λ-символикой

рассмотрим алгоритм нахождения n-факториального представления

числа (при фиксированном неотрицательном целом n).

Определение 4. n-факториальным представлением целого неотрицательного числа m называется последовательность целых чисел

(d0 , d1 , . . . , dn−1 ) такая, что 0 ≤ di ≤ i при i = 0, 1, . . . , n − 1 и

m = dn−1 (n − 1)! + dn−2 (n − 2)! + . . . + d0 0!.

Из курса алгебры известно, что для произвольного целого неотрицательного числа m < n! существует8 n-факториальное представление

числа m, причём единственное. Рассмотрим следующую задачу: пусть

задано значение n, а m может быть любым целым неотрицательным

числом, не превосходящим n!, требуется найти n-факториальное представление числа m. Эта задача легко решается c помощью простого

алгоритма. Неформально опишем его по шагам.

Шаг 0. Полагаем d0 = 0 и q0 = m.

Шаг 1. Делим q0 на 2, находим остаток от деления d1 и частное от

деления q1 = ⌊q0 /2⌋. При этом имеем 0 ≤ d1 < 2.

8

Последовательность (d0 , d1 , . . . , dn−1 ) является записью числа m относительно

одной из разновидностей смешанных систем счисления.

17

Переходим к следующему шагу. К шагу i ≥ 1 будут определены

числа d0 , d1 , . . . , di−1 и q0 , q1 , . . . , qi−1 .

Шаг i. Делим qi−1 на i + 1, полагаем di — остаток от деления и

qi = ⌊qi−1 /(i + 1)⌋. При этом имеем 0 ≤ di < i + 1.

Шаг n − 1. На заключительном шаге находим остаток dn−1 от деления qn−2 на n и частное qn−1 = ⌊qn−2 /n⌋.

Нетрудно доказать, что последовательность (d0 , d1 , . . . , dn−1 ), вычисленная посредством этого алгоритма, является n-факториальным представлением числа m. Заметим, что пошаговый процесс можно закончить, как только будет выполнено равенство qi = 0, все оставшиеся

числа qj при j > i будут также равны 0. Кроме того, можно отказаться от массива из элементов qi , достаточно на каждом шаге записывать

требуемое значение элемента qi в единственную переменную q. Таким

образом, приходим к следующей программной реализации.

Алгоритм F Decomp(n, m) нахождения

n-факториального представления числа m < n!

i := 0;

d0 := 0;

q := m;

while q > 0 do

begin

i := i + 1;

di := q mod i;

q := ⌊q/i⌋

end;

i := i + 1;

while i < n do di := 0.

Чему равна сложность T (n) алгоритма F Decomp(n, m) нахождения

n-факториального представления для произвольного числа m < n! ?

18

Оценим время работы алгоритма. Введем следующие обозначения:

• c1 — число элементарных операций, выполняющихся за одну итерацию первого while-цикла;

• c2 — число элементарных операций, выполняющихся за одну итерацию второго while-цикла;

• c3 — число элементарных операций, выполняющихся при инициализации переменных, вне обоих while-циклов;

• n1 — число итераций первого while-цикла;

• n2 — число итераций второго while-цикла.

Тогда время работы алгоритма F Decomp(n, m) равно c1 n1 + 1 + c2 n2 +

1 + c3 , причём константы c1 , c2 , c3 не зависят от n, а числа n1 , n2 определяются в зависимости от m и n1 + n2 = n − 1. Наибольшее число

операций будет выполняться для такого числа m, когда di > 0 для любого i > 0. Поэтому в худшем случае (по времени работы алгоритма)

n1 = n − 1, n2 = 0 и T (n) = c1 (n − 1) + 2 + c3 = Θ(n). Причём и в

лучшем случае время работы алгоритма F Decomp(n, m) есть Θ(n), так

как выполняется равенство n1 + n2 = n − 1.

При определении n-факториального представления числа m иногда ограничиваются последовательностью (d0 , d1 , . . . , dk ), для которой

dk ̸= 0 и dk+1 = . . . = dn−1 = 0 при m > 0 (k = 0, если m = 0).

В этом случае в алгоритме F Decomp необходимо отказаться от последнего while-цикла, в котором присваивается нулевое значение оставшимся членам последовательности di . Однако это не улучшит сложность

алгоритма, поскольку можно выбрать такое число m, что di > 0 для

n−1

∑

всех i, например, m =

i!. Таким образом, сложность алгоритма

i=1

F Decomp(n, m) есть Θ(n).

19

Глава 2

Генерация комбинаторных объектов

В прикладных задачах часто возникает необходимость порождать все

элементы некоторого класса комбинаторных объектов. Такого рода задачи решаются с помощью алгоритмов генерации. Наряду с обычным

выводом требуемых объектов без повторений, эти алгоритмы позволяют одновременно производить анализ объектов, их обработку, отбор и

т. п. В этой главе мы познакомимся с различными алгоритмами генерации перестановок, двоичных векторов, всех подмножеств конечного

множества, кодов Грея и сочетаний.

Все рассматриваемые методы систематического порождения комбинаторных объектов будут сводиться к выбору начальной конфигурации,

задающей первый генерируемый объект, трансформации полученного

объекта в следующий и проверке условия окончания, которое определяет момент прекращения вычислений. При этом особый интерес будут

представлять алгоритмы генерации объектов в порядке минимального

изменения, когда два "соседних" порождаемых объекта различаются в

подходящем смысле "минимально".

При рассмотрении класса комбинаторных объектов предполагается, что все его объекты имеют некоторую одинаковую количественную

меру, предварительно заданную целочисленным параметром (или набором целочисленных параметров), который передается на вход алгоритма генерации. Нас прежде всего будет интересовать время работы

алгоритма, требующееся для порождения всего класса объектов, как

функция от размерности входных данных. Мы будем стремиться получить асимптотически наилучший алгоритм генерации. В частности,

в некоторых алгоритмах можно порождать множество всех требуемых

объектов за время, пропорциональное его мощности (при этом, естественно, не учитывается время для вывода на печать самого комбинаторного объекта). В этом случае алгоритм имеет сложность O(k), где

k — число порождаемых объектов. Такой алгоритм генерации комби20

наторных объектов в литературе часто называют линейным. Хотя это

название несёт дуализм9 , оно оправдано, поскольку такие алгоритмы

генерации имеют асимптотически наилучшую сложность. Мы также будет придерживаться этой терминологии.

1. Перестановки и алгоритмы их порождения

Определение 5. Перестановкой множества A называется произвольное взаимно-однозначное отображение α : A → A.

Обычно перестановка конечного множества A определяется с помощью таблицы с двумя строками, каждая из которых содержит все элементы множества A, причем элемент α(a) помещается под элементом

a. Например, перестановку α : A → A множества A = {a, b, c, d} такую,

что α(a) = d, α(b) = a, α(c) = c и α(d) = b, можно записать в виде

следующей таблицы

(

α=

abcd

dacb

)

.

Иногда перестановкой называется вторая строка такой таблицы, а

сама функция α : A → A, заданная таблицей, называется подстановкой.

Поскольку порядок элементов множества A будет всегда зафиксирован,

мы используем термин перестановка как для обозначения самой функции α, так и для обозначения нижней строки таблицы, определяющей

это отображение. Таким образом, в указанном примере перестановка

есть последовательность (d, a, c, b). В общем случае для n-элементного

множества A с зафиксированным порядком элементов a1 , . . . , an перестановка — это произвольная последовательность длины n из различных элементов множества A. Так, последовательность (α1 , . . . , αn ), где

все элементы αi ∈ A различны, есть перестановка.

Обычно природа элементов множества A несущественна, поэтому

без уменьшения общности можно считать, что A = {1, 2, . . . , n} (ина9

Cравните с понятием линейного алгоритма из гл. 1.

21

че необходимо перейти к номерам элементов). Обозначим множество

всех перестановок n-элементного множества через Sn . На множестве

Sn определена операция умножения перестановок α ◦ β как суперпозиция отображений α и β : α ◦ β(i) = α(β(i)). Вообще говоря, эта операция

не коммутативна, т. е. α ◦ β ̸= β ◦ α. При этом выполняются следующие

аксиомы группы:

• ∀α ∈ Sn ∀β ∈ Sn ∀γ ∈ Sn α ◦ (β ◦ γ) = (α ◦ β) ◦ γ (ассоциативность);

• ∃ e ∈ Sn ∀α ∈ Sn (α ◦ e = e ◦ α = α) (существование единичного

элемента e);

• ∀α ∈ Sn ∃ α−1 ∈ Sn (α ◦ α−1 = α−1 ◦ α = e) (существование обратного элемента α−1 ).

Тождественная перестановка e является единичным элементом, а для

)

(

12 ... n

e=

12 ... n

нахождения обратной перестановки α−1 достаточно сначала поменять

местами строки в таблице, определяющей перестановку α, а затем упорядочить столбцы в порядке возрастания по верхним элементам. Таким

образом, множество перестановок Sn образует группу относительно операции умножения ◦, называемую симметрической группой степени n.

Её порядок, т. е. число элементов множества Sn , равен n!.

Рассмотрим задачу генерации всех перестановок n-элементного множества. Возникновение этой задачи относят к началу XVII в., когда в

Англии зародилось особое искусство колокольного боя, основанного, если говорить упрощённо, на выбивании на n различных колоколах всех

n! перестановок. Перестановки эти следовало "выбивать по памяти",

что способствовало разработке сторонниками этого искусства первых

простых методов систематического перечисления всех перестановок без

повторений. В Книге рекордов Гиннеса содержится упоминание о вы22

бивании всех 8!=40320 перестановок на 8 колоколах в 1963 г., на это

потребовалось 17 часов 58,5 минут.

Далее в этом разделе мы познакомимся с несколькими алгоритмами

генерации всех перестановок n-элементного множества. Сначала определим лексикографический порядок на множестве Sn , индекс перестановки относительно этого порядка и вектор инверсии. Затем рассмотрим алгоритмы порождения перестановок, связанные с этими понятиями. Наконец, детально изучим линейный алгоритм генерации перестановок в лексикографическом порядке и линейный алгоритм Джонсона –

Троттера генерации перестановок в порядке минимального изменения.

1.1. Индекс перестановки

На множестве всех перестановок n-элементного множества определим

бинарное отношение ≼ следующим образом:

(α1 , α2 , . . . , αn ) ≼ (β1 , β2 , . . . βn ) ⇔ ∃ k ≥ 1 (αk < βk & ∀i < k (αi = βi )).

Очевидно, что отношение ≼ удовлетворяет следующим аксиомам:

• ∀α (α ≼ α) (рефлексивность);

• ∀α∀β (α ≼ β & β ≼ α ⇒ α = β) (антисимметричность);

• ∀α∀β∀γ (α ≼ β & β ≼ γ ⇒ α ≼ γ) (транзитивность);

• ∀α∀β (α ≼ β ∨ β ≼ α) (сравнимость).

Таким образом, отношение ≼ есть линейный порядок на множестве Sn .

Такой порядок называется лексикографическим 10 . Например, последовательность перестановок из S3 , записанная в лексикографическом порядке, имеет вид 123, 132, 213, 231, 312, 321 (здесь перестановки перечислены в порядке возрастания получающихся чисел).

10

В общем случае лексикографический порядок определяется на множестве An

слов конечного алфавита A (с заданным упорядочиванием букв) фиксированной

длины n.

23

Ясно, что тождественная перестановка (1, 2, . . . , n) есть наименьший

элемент в (Sn , ≼) (относительно порядка ≼), а перестановка (n, n − 1,

n − 2, . . . , 1) — наибольший элемент.

В дальнейшем будем использовать следующие очевидные свойства

перестановок. Рассмотрим различные элементы i1 , . . . , ik ∈ {1, . . . , n}

и множество S(i1 , . . . , ik ) всех перестановок k-элементного множества

{i1 , . . . , ik }. На множестве S(i1 , . . . , ik ) можно также рассмотреть лексикографический порядок ≼.

Лемма 1.

(i) (S(i1 , . . . , ik ), ≼) — линейно упорядоченное множество.

(ii) Если α1 , . . . , αk ∈ {i1 , . . . , ik } и α1 > α2 > . . . > αk , то перестановки (α1 , α2 , . . . , αk ) и (αk , αk−1 , . . . , α1 ) являются наибольшим и наименьшим элементами линейно упорядоченного множества (S(i1 , . . . , ik ), ≼)

соответственно.

(iii) Если перестановки α, β, γ ∈ Sn имеют общее начало длины k и

α ≼ γ ≼ β, то αk+1 ≤ γk+1 ≤ βk+1 и (αk+1 , . . . , αn ) ≼ (γk+1 , . . . , γn ) ≼

(βk+1 , . . . , βn ).

Рассмотрим метод вычисления номера заданной перестановки в последовательности всех перестановок из Sn , записанных в лексикографическом порядке, т. е. установим соответствие между целыми числами

0, 1, 2, . . . , n! − 1 и n! перестановками из Sn . Для этого индукцией по n

определим отображение

I n : Sn → {0, 1, . . . , n! − 1}.

При n = 1 полагаем I 1 (α) = 0, где α = (1) и S1 = {α}. Пусть отображения I i : Si → {0, 1, . . . , i! − 1}, i = 1, 2, . . . , n − 1 уже определены. Для

произвольной перестановки α = (α1 , . . . , αn ) ∈ Sn полагаем

I n (α) = (α1 − 1)(n − 1)! + I n−1 (α′ ),

где α′ — последовательность n−1 элементов, полученная из перестанов24

ки α удалением α1 и уменьшением на единицу всех элементов, больших

α1 . Нетрудно доказать, что α′ ∈ Sn−1 и I n (α) ≤ n! − 1.

Теорема 2. Отображение I n : Sn → {0, 1, . . . , n! − 1} есть изоморфизм линейно упорядоченных множеств (Sn , ≼) и ({0, 1, . . . , n! − 1}, ≤).

Доказательство проведем индукцией по n. Базис индукции при

n = 1 очевиден. Предположим, что утверждение теоремы верно для

n − 1, и докажем его для n. Конечные множества Sn и {0, 1, . . . , n! − 1}

равномощны. Поэтому если мы покажем, что I n является разнозначным отображением, то I n есть биекция. Пусть α, β ∈ Sn и I n (α) =

I n (β). Из определения отображения I n имеем

I n (α) = (α1 − 1)(n − 1)! + I n−1 (α′ ),

I n (β) = (β1 − 1)(n − 1)! + I n−1 (β ′ ).

Так как I n−1 (α′ ) < (n − 1)! и I n−1 (β ′ ) < (n − 1)!, числа I n−1 (α′ )

и I n−1 (β ′ ) имеют некоторые (n − 1)-факториальные представления

′

′

′

′

β

α

(d0α , . . . , dn−2

) и (d0β , . . . , dn−2

) соответственно. Тогда последователь′

′

α

ность (d0α , . . . , dn−2

, α1 − 1) является n-факториальным представлени′

′

β

ем числа I n (α), а последовательность (d0β , . . . , dn−2

, β1 − 1) есть n-

факториальное представление числа I n (β). Из единственности такого

представления получаем α1 = β1 . Следовательно, I n−1 (α′ ) = I n−1 (β ′ )

и α′ = β ′ в силу индукционного предположения. Поэтому α = β. Таким

образом, I n есть биекция.

Докажем, что I n — изоморфизм. Достаточно показать, что если

α, β ∈ Sn и α ≼ β, то I n (α) ≤ I n (β) (т. е. I n сохраняет порядок). Пусть

α ≼ β. Тогда α1 ≤ β1 . Если α1 ̸= β1 , то I n (α) ≤ (β1 − 2)(n − 1)! + (n −

1)!−1 = (β1 −1)(n−1)!−1 ≤ I n (β). Пусть теперь α1 = β1 . Тогда α′ ≼ β ′ ,

и по индукционному предположению имеем I n−1 (α′ ) ≤ I n−1 (β ′ ). Следовательно, I n (α) ≤ I n (β). Теорема 2 доказана.

25

Определение 6. Пусть α ∈ Sn . Целое неотрицательное число

I n (α) называется индексом перестановки α.

Теорема 2 показывает, что I n является нумерацией всех перестановок из Sn , упорядоченных в лексикографическом порядке, а индекс

I n (α) есть номер перестановки α ∈ Sn в этой последовательности.

Индуктивное определение индекса перестановки α ∈ Sn фактически

задаёт n-факториальное представление (0, . . . , α1′ −1, α1 −1) числа In (α),

причём по n-факториальному представлению (d0 , . . . , dn−1 ) индекса

I n (α) также восстанавливается и сама перестановка α = (α1 , . . . , αn ).

Опустим формализацию процедуры P ConstrF (d0 , . . . , dn−1 ), осуществляющей такое восстановление перестановки. Теперь мы можем порождать все перестановки из Sn в лексикографическом порядке следующим

образом: изменяя индекс i от 0 до n!−1, находим n-факториальное представление числа i и по нему восстанавливаем перестановку.

Алгоритм P Index(n) генерации

всех перестановок из Sn по индексам

for i = 0 to n! − 1 do

begin

% нахождение n-факториального

F Decomp(n, i);

% представления (d0 , . . . , dn−1 ) числа i;

P ConstrF (d0 , . . . , dn−1 );

% восстановление перестановки α по

write(α1 , . . . , αn )

% n-факториальному представлению

end.

Время работы алгоритма P Index(n) есть Ω(nn!), так как количество

итераций for-цикла равно n!, и алгоритм F Decomp(n, i) требует времени

Θ(n). Такая сложность не является оптимальной, в следующем разделе

мы познакомимся с линейным алгоритмом генерации всех перестановок

из Sn в лексикографическом порядке.

26

1.2. Генерация перестановок

в лексикографическом порядке

Будем говорить, что перестановка β ∈ Sn непосредственно следует за

перестановкой α ∈ Sn относительно лексикографического порядка ≼,

если выполняются следующие условия:

• α ≺ β 11 ,

• не существует такой перестановки γ ∈ Sn , что α ≺ γ ≺ β.

При генерации перестановок в лексикографическом порядке, начиная с тождественной перестановки (1, 2, . . . , n), требуется переходить

от уже построенной перестановки α = (α1 , . . . , αn ) к непосредственно

следующей за ней перестановке β = (β1 , . . . , βn ) до тех пор, пока не

получим наибольшую перестановку (n, n − 1, . . . , 1) (относительно лексикографического порядка).

Рассмотрим способ построения такой перестановки β. Просматриваем справа налево перестановку α = (α1 , . . . , αn ) в поисках самой правой

позиции i такой, что αi < αi+1 . Если такой позиции нет, то α1 > α2 >

. . . > αn , т. е. α = (n, n−1, . . . , 1) и генерировать больше нечего. Поэтому

считаем, что такая позиция i есть. Значит, αi < αi+1 > αi+2 > . . . > αn .

Далее ищем первую позицию j при переходе от позиции n к позиции i

такую, что αi < αj . Тогда i < j. Затем меняем местами элементы αi и αj ,

′

′

, αn′

а в полученной перестановке α′ = (α1′ , . . . , αn′ ) отрезок αi+1

, . . . , αn−1

переворачиваем. Построенную перестановку обозначим через β.

Например, пусть α = (2, 6, 5, 8, 7, 4, 3, 1). Тогда αi = 5 и αj = 7. Поменяем местами эти элементы, перевернём отрезок (8, 5, 4, 3, 1) и получим

перестановку β = (2, 6, 7, 1, 3, 4, 5, 8).

Лемма 2. Перестановка β непосредственно следует за перестановкой α относительно лексикографического порядка.

11

α ≺ β, если α ≼ β и α ̸= β.

27

Доказательство. В силу построения βs = αs′ = αs для любой позиции s < i. Так как βi = αi′ = αj > αi , то α ≼ β.

Предположим, что α ≼ γ ≼ β, и покажем, что γ = α или γ = β.

Так как βs = αs для всех s < i, то из определения лексикографического

порядка получаем γs = αs при s < i. Тогда αi ≤ γi ≤ βi = αj в силу

леммы 1(iii). Предположим, что αi ̸= γi . Тогда γi ∈ {αi+1 , . . . , αn }. Но

αj > αi < αi+1 > αi+2 > . . . > αn . Следовательно, γi ≥ αj в силу

выбора j. Поэтому γi = αj . Таким образом, αi = γi или γi = βi .

Случай 1. αi = γi . Тогда (αi+1 , . . . , αn ) ≼ (γi+1 , . . . , γn ) по лемме

1(iii). В силу леммы 1(ii) имеем (γi+1 , . . . , γn ) ≼ (αi+1 , . . . , αn ). Поэтому

по лемме 1(i) получаем (αi+1 , . . . , αn ) = (γi+1 , . . . , γn ). Таким образом,

справедливо равенство α = γ.

′

Случай 2. γi = βi . Покажем, что αi+1

, . . . , αn′ — убывающая после-

довательность. Действительно, последовательность αi+1 , αi+2 , . . . , αn

убывает в силу выбора i. Причём αj′ = αi , j > i и αs′ = αs для всех

s таких, что s > i и s ̸= j. В силу выбора позиции j получаем

′

αj′ = αi ≥ αj+1 = αj+1

, если j < n;

′

αj−1

= αj−1 > αj > αi = αj′ , если j > i + 1.

′

, . . . , αn′ — убывающая последовательность. ПоСледовательно, αi+1

сле переворота этой последовательности получим возрастающую последовательность βi+1 , . . . , βn . Тогда (βi+1 , . . . , βn ) ≼ (γi+1 , . . . , γn ) по

лемме 1(ii) и (γi+1 , . . . , γn ) ≼ (βi+1 , . . . , βn ) по лемме 1(iii). Поэтому

(βi+1 , . . . , βn ) = (γi+1 , . . . , γn ) по лемме 1(i). Таким образом, β = γ.

Лемма 2 доказана.

Перейдем к рассмотрению алгоритма генерации перестановок, в

котором применяется описанный способ перестроения перестановки в

непосредственно следующую за ней. При программной реализации этого алгоритма используется массив α размерности n + 1. В α1 , . . . , αn

записываем текущую порождаемую перестановку из Sn , первоначально

тождественную. Значение α0 не изменяется и равно 0, поэтому всегда

справедливо неравенство α0 < α1 . Это неравенство гарантирует нахож28

дение самой правой позиции i ≥ 0 такой, что αi < αi+1 . Алгоритм

заканчивает работу, когда значение i становится равным 0.

Алгоритм P Lex(n) генерации всех перестановок

в лексикографическом порядке

for j = 0 to n do αj := j;

i := 1;

while i ̸= 0 do

begin

write (α1 , . . . , αn );

i := n − 1;

while αi > αi+1 do i := i − 1;

j := n;

while αj < αi do j := j − 1;

Swap(αi , αj );

k := i + 1;

m := i + ⌊(n − i)/2⌋;

while k ≤ m do

begin

Swap(αk , αn−k+i+1 );

k := k + 1

end

end.

Пример 2. При n = 3 процесс работы алгоритма P Lex(n) генерации перестановок из S3 в лексикографическом порядке представлен

следующей последовательностью перестроений перестановок αi :

α1 = (1, 2, 3), αi1 = 2, αj1 = 3;

α2 = (1, 3, 2), αi2 = 1, αj2 = 2;

α3 = (2, 1, 3), αi3 = 1, αj2 = 3;

α4 = (2, 3, 1), αi4 = 2, αj4 = 3;

α5 = (3, 1, 2), αi5 = 1, αj5 = 2;

α6 = (3, 2, 1), i = 0.

29

Теорема 3. Алгоритм P Lex(n) корректен и строит все перестановки из Sn без повторений в лексикографическом порядке за время O(n!).

Доказательство. Используя лемму 2, нетрудно обосновать корректность алгоритма P Lex(n).

Оценим сложность T (n) алгоритма P Lex(n). Рассмотрим разбиение

множества Sn на n подмножеств Snk , k = 1, . . . , n. Множество Snk состоит из всех перестановок, на первом месте которых стоит число k. Тогда Snk содержит (n − 1)! перестановок. Относительно лексикографического порядка каждая перестановка из Snk предшествует произвольной

перестановке из Snm при k < m, а упорядочивание на Snk соответствует лексикографическому упорядочиванию множества всех перестановок

S({1, . . . , n} \ {k}). Таким образом, последовательность α1 , α2 , . . . , αn!

всех перестановок из Sn , упорядоченных лексикографически, разбивается на следующие n блоков:

(1, . . .) · · · (1, . . .) · · · (k, . . .) · · · (k, . . .) · · · (n, . . .) · · · (n, . . .) .

{z

} |

{z

}

{z

}

|

|

1

Sn

k

Sn

n

Sn

В силу леммы 1(ii) перестановки (k, 1, 2, . . . , k − 1, k + 1, . . . , n) и (k, n,

n − 1, . . . , k + 1, k − 1, . . . , 1) являются первой и последней перестановкой

из Snk соответственно. Введём следующие обозначения:

• tn0 — число операций, выполняемых в алгоритме P Lex(n) до печати перестановки α1 ;

• tni — число операций, выполняемых в алгоритме P Lex(n), начиная

с печати αi и до печати αi+1 ;

• tnn! — число операций, выполняемых в алгоритме P Lex(n), начиная с печати αn! и до окончания работы программы.

30

Тогда из алгоритма P Lex(n) получаем

T (n)

=

n!

∑

tni = tn0 +

i=0

n!

∑

tni = O(n) +

= O(n) +

∑

tni =

k

k=1 i: αi ∈Sn

i=1

n

∑

n

∑

∑

(tnk(n−1)! +

tni ),

k \{αk(n−1)! }

i: αi ∈Sn

k=1

∑

tni = T (n − 1) − c1 n,

k \{αk(n−1)! }

i: αi ∈Sn

где константа c1 не зависит от n. Подсчитаем tnk(n−1)! — число операций начиная с печати последней перестановки (k, n, n − 1, . . . , k + 1,

k − 1, . . . , 1) из k-го блока Snk до печати первой перестановки (k + 1,

1, 2, . . . , k, k + 2, . . . , n) из (k + 1)-го блока Snk+1 . В этом случае будем

менять местами числа k и k + 1, а затем переворачивать последовательность n, n − 1, . . . , k + 2, k, k − 1, . . . , 1. Теперь понятно, что

tnk(n−1)! = c2 n + c3 k,

где константы c2 , c3 не зависят от n и k. Следовательно,

n

∑

tnk(n−1)! =

k=1

n

∑

(c2 n + c3 k) = O(n2 ).

k=1

Таким образом, получаем

T (n)

= O(n) + O(n2 ) +

n

∑

( T (n − 1) − c1 n) =

k=1

2

= n T (n − 1) + O(n ).

Поскольку мы исследуем асимптотическую оценку сложности алгоритма P Lex(n), можно считать, что T (n) = n T (n − 1) + c n2 для некоторой

константы c. Решим это рекуррентное соотношение. Сделаем замену

T (n) = Pn − c n.

31

Тогда Pn = n Pn−1 + 2 c n. Следовательно,

Pn−1

2c

Pn

=

+

.

n!

(n − 1)! (n − 1)!

Поэтому при n > 1 имеем

∑ 2c

Pn

= P1 +

= O(1).

n!

i!

i=1

n−1

Таким образом, справедливы соотношения Pn = O(n!) и T (n) = O(n!).

Теорема 3 доказана.

1.3. Порождение перестановок через

векторы инверсий

Пусть α = (α1 , α2 , . . . , αn ) есть перестановка из Sn .

Определение 7. Пара (αi , αj ) называется инверсией перестановки

α = (α1 , α2 , . . . , αn ), если i < j и αi > αj .

Инверсию (αi , αj ) будем также называть j-инверсией перестановки α,

тем самым явно указывая номер меньшего элемента в инверсии (αi , αj ).

Определение 8. Вектором инверсий перестановки α ∈ Sn называется последовательность целых чисел (d1 , d2 , . . . , dn ) такая, что dj

есть число j-инверсий перестановки α.

Другими словами, dj есть число элементов перестановки α, бо́льших αj

и находящихся левее αj в последовательности (α1 , . . . , αn ),

dj =| {αi | i < j & αi > αj } | 12 .

Например, для перестановки (4, 3, 5, 2, 1, 7, 8, 6, 9) вектором инверсий будет вектор (0, 1, 0, 3, 4, 0, 0, 2, 0).

12

|X| — мощность множества X.

32

Вектор инверсий содержит информацию о структуре "беспорядка"

перестановки. Такая информация оказывается полезной при разработке различных алгоритмов обработки данных. Именно этим объясняется интерес к алгоритму генерации всех перестановок n-элементного

множества через векторы инверсий, хотя сложность такого алгоритма,

как будет показано далее, хуже сложности рассмотренного алгоритма

P Lex(n) генерации перестановок в лексикографическом порядке.

Пусть (d1 , . . . , dn ) — вектор инверсий перестановки α ∈ Sn . Очевидно, 0 ≤ dj < j. Определим отображение Vn : Sn → Dn , полагая

Vn (α) = (d1 , . . . , dn ), где Dn = {(d1 , . . . , dn ) | 0 ≤ dj < j, j = 1, . . . , n}.

Теорема 4. Отображение Vn : Sn → Dn является биекцией, причём любая перестановка α ∈ Sn однозначно восстанавливается по её

вектору инверсий Vn (α).

Доказательство. Очевидно, что множества Dn , Sn равномощны

и содержат n! элементов. Поэтому достаточно показать, что Vn является сюръективным отображением. Опишем метод, как для произвольного вектора d = (d1 , . . . , dn ) ∈ Dn построить перестановку α =

(α1 , . . . , αn ) ∈ Sn такую, что Vn (α) = d, тем самым всё будет доказано.

Действительно, определим множество In = {1, 2, . . . , n}. Расположим его элементы в порядке возрастания и (dn + 1)-й элемент с конца этой возрастающей последовательности обозначим через αn . Тогда среди чисел из In имеется ровно dn чисел, больших αn . Поэтому

в произвольной перестановке α вида α = (. . . , αn ) число n-инверсий

будет равно dn . Далее определим множество In−1 = In \ {αn }, т. е.

вычеркнем αn . Расположим его элементы в порядке возрастания и

(dn−1 + 1)-й элемент с конца этой возрастающей последовательности

обозначим через αn−1 . Тогда среди чисел из множества In−1 имеется

ровно dn−1 чисел, больших αn−1 . Следовательно, в произвольной перестановке α = (. . . , αn−1 , αn ) чисел, больших αn−1 и не равных αn , будет

33

ровно dn−1 . Поэтому в перестановке α число (n − 1)-инверсий есть dn−1

и число n-инверсий равно dn .

На шаге i уже будут определены множество Ii+1 и вычеркнутые из

множества {1, 2, . . . , n} элементы αn , αn−1 , . . . , αi+1 . Полагаем

Ii = Ii+1 \ {αi+1 } = In \ {αn , αn−1 , . . . , αi+1 }.

Далее снова расположим элементы множества Ii в порядке возрастания и (di + 1)-й элемент с конца этой возрастающей последовательности обозначим через αi . Тогда в произвольной перестановке α вида

(. . . , αi , αi+1 , . . . , αn ) число j-инверсий будет равно dj для всех j ≥ i.

Продолжим этот процесс до шага i = 1. В итоге получим перестановку α = (α1 , . . . , αn ), число i-инверсий которой равно di для любого i.

Теорема 4 доказана.

Пример 3. Процесс восстановления перестановки α = (α1 , . . . , α5 ),

имеющей вектор инверсий d = (0, 0, 2, 1, 1), выглядит так:

i = 5, I5 = {1, 2, 3, 4, 5}, d5 + 1 = 2, α5 = 4;

i = 4, I4 = {1, 2, 3, 5}, d4 + 1 = 2, α4 = 3;

i = 3, I3 = {1, 2, 5}, d3 + 1 = 3, α3 = 1;

i = 2, I2 = {2, 5}, d2 + 1 = 1, α2 = 5;

i = 1, I1 = {2}, d1 + 1 = 1, α1 = 2;

α = (2, 5, 1, 3, 4).

Формализуем данный алгоритм в виде псевдокода. Очевидным образом можно сэкономить используемую память и уменьшить число операций, отказавшись от создания множества Ii и упорядочивания его

элементов на каждом шаге i. Вместо этого достаточно хранить только

лишь метки для уже вычеркнутых чисел из множества {1, 2, . . . , n} и

добавлять на шаге i метку для числа αi . Будем использовать массив

ϕ размерности n с булевыми значениями его элементов true и false для

создания таких меток.

34

Алгоритм P ConstrV (d1 , . . . , dn ) восстановления перестановки

α = (α1 , . . . , αn ) по её вектору инверсий d = (d1 , . . . , dn )

for k = 1 to n do ϕk := true;

for i = n downto 1 do

begin

j := 1;

m := n;

while j ≤ di or ϕ m = false do

begin

if ϕj = true then j := j + 1;

m := m − 1

end;

αi := m;

ϕ m := false

end.

Оценим сложность T (n) алгоритма P ConstrV (d1 , . . . , dn ). Число

итераций for-циклов равно n. Поскольку число итераций while-цикла

не превосходит n, имеем T (n) ≤ n + n(c1 + nc2 + c3 ) = O(n2 ). Значит, T (n) = O(n2 ). Докажем, что T (n) = Θ(n2 ). Действительно, рассмотрим вектор d = (0, 1, . . . , n − 1), являющийся вектором инверсий перестановки α = (n, n − 1, . . . , 2, 1). Из алгоритма следует, что

In = {1, . . . , n}, In−1 = {2, . . . , n}, . . . , Ii = {n − i + 1, . . . , n} и ϕ n−i+1 =

. . . = ϕ n = true. Поэтому для любого i = n, n − 1, . . . , 1 число итераций

while-цикла (при фиксированном i) равно di = i − 1. Следовательно,

T (n) ≥ n +

1

∑

(c1 + di c2 + c3 ) = Ω(n2 ).

i=n

Таким образом, сложность алгоритма P ConstrV (d1 , . . . , dn ) есть Θ(n2 ).

Алгоритм P ConstrV (d1 , . . . , dn ) восстановления перестановки по её

вектору инверсий даёт очевидный способ генерации всех перестановок

35

из Sn . Сначала порождаем вектор инверсий d = (d1 , . . . , dn ) ∈ Dn ,

а затем по вектору инверсий d восстанавливаем перестановку α =

(α1 , . . . , αn ) ∈ Sn . По теореме 4 множество векторов инверсий всех

перестановок из Sn есть Dn . С другой стороны, Dn есть множество

n-факториальных представлений всех целых неотрицательных чисел,

меньших n!. Таким образом, приходим к следующему алгоритму генерации перестановок.

Алгоритм P V Inv(n) генерации всех

перестановок через векторы инверсий

for i = 0 to n! − 1 do

begin

% нахождение n-факториального

F Decomp(n, i);

% представления (d1 , . . . , dn ) числа i;

P ConstrV (d1 , . . . , dn );

% восстановление перестановки α по

write(α1 , . . . , αn )

% вектору инверсий (d1 , . . . , dn )

end.

Очевидно, что время работы алгоритма P V Inv(n) генерации перестановок через векторы инверсий есть Ω(nn!). Поэтому линейный алгоритм P Lex(n) генерации перестановок в лексикографическом порядке

предпочтительнее. Однако алгоритмы, использующие векторы инверсий, представляют интерес, поскольку информация, содержащаяся в

векторе инверсий, настолько богата, что позволяет полностью восстановить саму перестановку.

1.4. Алгоритм Джонсона – Троттера

генерации перестановок

Мы рассмотрели несколько алгоритмов генерации перестановок из Sn .

При этом переход от предыдущей перестановки к следующей требовал,

вообще говоря, большого числа перемещений элементов исходной перестановки. Так, в лучшем из рассмотренных алгоритмов P Lex(n) мы

36

выделяли два элемента, меняли их местами, а затем переворачивали конечный отрезок перестановки. Поэтому естественно желание получить

алгоритм генерации, в котором соседние перестановки будут различаться настолько мало, насколько это возможно. Для того, чтобы такое различие было минимально возможным, любая генерируемая перестановка

должна отличаться от предшествующей транспозицией двух соседних

элементов. Возможно ли таким образом породить все перестановки без

повторений? Оказывается, такую последовательность перестановок легко построить рекурсивно по n.

При n = 1 последовательность из единственной перестановки

(1) будет требуемой. Предположим, что имеется последовательность

σ 1 , . . . , σ i , . . . , σ (n−1)! всех перестановок из Sn−1 такая, что каждая следующая σ i+1 получается из предыдущей σ i перестановкой двух соседних элементов. Построим последовательность π i , i = 1, . . . , n! всех перестановок из Sn с таким же свойством. Расширим каждую перестановку

i

), последовательно вставляя элемент n на каждое из

σ i = (σ1i , . . . , σn−1

i

n возможных мест: перед элементом σ1i , между элементами σji и σj+1

,

i

. При этом элемент n вставляем в σ 1 в направлении

после элемента σn−1

справа налево, а в σ 2 — слева направо:

1

1

(σ11 , . . . , σn−1

, n), . . . , (n, σ11 , . . . , σn−1

),

2

2

(n, σ12 , . . . , σn−1

), . . . , (σ12 , . . . , σn−1

, n)

и т. д., при переходе от σ i к σ i+1 меняем направление вставки элемента

n на обратное. Тогда внутри i-го блока (n перестановок из Sn , построенных из σ i ∈ Sn−1 ) каждая следующая перестановка получается из

предыдущей перестановкой двух соседних элементов, один из которых

есть n. При переходе от последней перестановки в i-м блоке к первой

в следующем (i + 1)-м блоке по индукционному предположению также

переставляются только два элемента. Таким образом, для построенной

последовательности перестановок π i ∈ Sn , i = 1, . . . , n! выполняется

требуемое свойство.

37

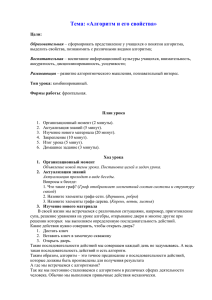

Пример 4. На рис. 1 приведено рекурсивное построение последовательности всех перестановок из S4 в порядке минимального изменения.

(1234)

(1243)

(123)

(1423)

(4123)

(4132)

(1432)

(12)

(132)

(1342)

(1324)

(3124)

(3142)

(312)

(3412)

(4312)

(1)

(4321)

(3421)

(321)

(3241)

(3214)

(2314)

(2341)

(21)

(231)

(2431)

(4231)

(4213)

(2413)

(213)

(2143)

(2134)

Рис. 1. Рекурсивное построение перестановок из S4

Описанный рекурсивный алгоритм, генерирующий последовательность перестановок из Sn , применённый непосредственно, имеет огромный недостаток: последовательность перестановок строится "целиком"

и требует хранения всех перестановок из Sn−1 , Sn−2 , . . . Очевидно, такой

38

алгоритм использовал бы огромный объём памяти, поэтому он неприменим. Мы изучим нерекурсивную модификацию этого метода — алгоритм Джонсона – Троттера.

Получим рассмотренный выше порядок перестановок n элементов

без явной генерации перестановок для меньших значений n. Это можно

сделать, связав с каждой компонентой πi перестановки π = (π1 , . . . , πn )

её направление. Будем указывать направление при помощи стрелки →

("вправо") или ← ("влево") над рассматриваемой компонентой перестановки. Перестановку π вместе с заданными направлениями её ком→

→

→

π . Будем писать −

π =−

σ , если π = σ и направпонент обозначим через −

ления соответствующих компонент совпадают. Если π ∈ Sn , то через

π \ {n} обозначим перестановку из Sn−1 , получающуюся из π удалением элемента n. Для перестановки π ∈ Sn число m ∈ {1, . . . , n} будем

→

называть кандидатом для перемещения, если стрелка над m в −

π указывает на меньшее соседнее число. Такое соседнее число будем называть дублёром числа m и обозначать m∗ . Например, для перестановки π = (5, 3, 4, 2, 1) рассмотрим следующую расстановку направлений

←

− ←

− ←

− −

→ ←

−

−

→

π = ( 5 , 3 , 4 , 2 , 1 ). Тогда числа 4, 2 — кандидаты для перемещения,

а остальные 5, 3, 1 не являются кандидатами. Для числа 4 дублером

является число 3, а число 1 есть дублер числа 2.

−

В рассматриваемом алгоритме в перестановке →

π будем менять местами наибольший кандидат для перемещения m с его дублёром m∗ .

В дальнейшем наибольший кандидат для перемещения в перестановке

−

→

π будем просто называть переставляемым элементом.

→

π число 1 не является канЗамечание 1. Для любой перестановки −

дидатом для перемещения.

→

Замечание 2. Для перестановки −

π , π ∈ Sn число n не является

переставляемым элементом тогда и только тогда, когда первая компо→

− или последняя компонента −

→

→

нента −

π есть ←

n

π есть −

n.

39

Перейдем к описанию алгоритма Джонсона – Троттера генерации

всех перестановок в порядке минимального изменения.

Алгоритм Джонсона – Троттера P M in(n)

←

− ←

−

−

→

−);

π := ( 1 , 2 , . . . , ←

n

m := 0;

while m ̸= 1 do

begin

write(π1 , . . . , πn );

m := n;

while (m не кандидат для перемещения в π and m > 1) do m := m−1;

π: m ↔ m∗ ; (считаем 1∗ = 1)

−

→

π : над всеми элементами перестановки π, большими m, меняем

стрелку на противоположную по направлению

end.

Пример 5. Рассмотрим работу алгоритма P M in(n) при n = 3:

←

− ←

− ←

−

−

→

π 1 = ( 1 , 2 , 3 ), m = 3, m∗ = 2;

←

− ←

− ←

−

−

→

π 2 = ( 1 , 3 , 2 ), m = 3, m∗ = 1;

←

− ←

− ←

−

−

→

π 3 = ( 3 , 1 , 2 ), m = 2, m∗ = 1;

−

→ ←

− ←

−

−

→

π 4 = ( 3 , 2 , 1 ), m = 3, m∗ = 2;

←

− −

→ ←

−

−

→

π 5 = ( 2 , 3 , 1 ), m = 3, m∗ = 1;

←

− ←

− −

→

−

→

π 6 = ( 2 , 1 , 3 ), m = 1.

Лемма 3. Алгоритм P M in(n) корректен и строит все перестановки

из Sn без повторений в порядке минимального изменения.

→

Доказательство. Обозначим через −

π i последовательность чисел

π i = (π1i , . . . , πni ), полученную в результате i-й печати при работе алгоритма P M in(n) вместе с направлениями, определенными в этот момент

←

− ←

−

→

−) и −

→

для компонент π i , . . . , π i . Поскольку −

π 1 = ( 1 , 2 ,...,←

n

π i полу1

n

→

чается из −

π i−1 перестановкой двух соседних элементов, π i ∈ Sn для

всех i. Нам потребуется следующее свойство.

40

→

Лемма 4. Если −

π i имеет переставляемый элемент m ̸= n, то опре→

→

делены перестановки −

π i+1 , . . . , −

π i+n , число n является переставляе→

мым элементом в перестановке −

π j при j = i + 1, . . . , i + n − 1 и не

→

является переставляемым элементом в перестановке −

π i+n . Кроме того,

−

→

→

→

π i+1 \ {n} = −

π i+2 \ {n} = . . . = −

π i+n \ {n}.

Доказательство леммы 4. По замечанию 1 имеем m ̸= 1. По за→

−, . . .) или (. . . , −

→

π i имеет вид (←

мечанию 2 перестановка −

n

n ). В теле

−

→

i

∗

внешнего while-цикла в перестановке π элементы m, m меняются

местами, и над всеми элементами, бо́льшими чем m, стрелка меняет→

ся на противоположную. Полученная перестановка есть −

π i+1 . Так как

→

→

−). По

n > m > m∗ , перестановка −

π i+1 имеет вид (−

n , . . .) или (. . . , ←

n

→

замечанию 2 число n является переставляемым элементом в −

π i+1 . Далее снова по замечанию 2 число n будет переставляемым элементом

→

→

→

в −

π i+2 , . . . , −

π i+n−1 . Поэтому определена перестановка −

π i+n , которая

→

−, . . .). Понятно, что направления всех

будет иметь вид (. . . , −

n ) или (←

n

→

→

чисел в перестановках −

π i+1 , . . . , −

π i+n совпадают. Лемма 4 доказана.

Теперь индукцией по n покажем, что алгоритм P M in(n) корректен,

строит все перестановки из Sn без повторений, и для любого i ̸= n! пере→

→

становка −

π i имеет переставляемый элемент, а −

π n! не имеет кандидата

для перемещения. Базис индукции n = 1 очевиден. Пусть для n − 1 всё

доказано. Рассмотрим работу алгоритмов P M in(n) и P M in(n−1) одновременно. В силу замечания 2 алгоритмом P M in(n) будут напечатаны

следующие n перестановок:

←

− ←

−

←−−− −

−

→

π 1 = ( 1 , 2 , . . . , n − 1, ←

n ),

←

− ←

−

−−−

−

→

−, ←

π 2 = ( 1 , 2 ,...,←

n

n − 1),

..

.

←

−

−

←−−−

−

→

−, 1 , ←

π n = (←

n

2 , . . . , n − 1).

Так как

←

− ←

−

←−−−

−

→

→

π 1 \ {n} = . . . = −

π n \ {n} = ( 1 , 2 , . . . , n − 1)

41

есть первая напечатанная алгоритмом P M in(n−1) перестановка, по ин→

дукционному предположению −

π n \ {n} имеет переставляемый элемент

m1 , при условии (n − 1)! ̸= 1, и m1 ̸= n. Тогда m1 — переставляемый

→

элемент в −

π n , и по лемме 4 определены следующие n перестановок

→

−

→

π n+1 , . . . , −

π 2n ∈ S , причём

n

−

→

→

π n+1 \ {n} = . . . = −

π 2n \ {n}

является второй напечатанной алгоритмом P M in(n − 1) перестановкой.

→

По индукционному предположению −

π 2n \ {n} имеет переставляемый

→

π 2n имеет вид

элемент m2 , при условии (n − 1)! ̸= 2, и перестановка −

−, . . .) или (. . . , −

→

(←

n

n ) по лемме 4 и замечанию 2. Поэтому m является

2

→

переставляемым элементом в −

π 2n и m2 ̸= n. В общем случае в i-м блоке

→

→

определены следующие n перестановок −

π (i−1)n+1 , . . . , −

π (i−1)n+n ∈ S ,

n

−

→

→

π (i−1)n+1 \ {n} = . . . = −

π in \ {n}

→

есть i-я напечатанная алгоритмом P M in(n − 1) перестановка и −

π in

имеет переставляемый элемент mi ̸= n, при условии (n − 1)! ̸= i.

→

При i = (n − 1)! − 1 перестановка −

π in имеет переставляемый элемент mn!−n ̸= n. По лемме 4 определены следующие n перестано→

→

вок −

π n!−n+1 , . . . , −

π n! ∈ Sn , причём число n не является переставляе→

мым элементом в −

π n! . По индукционному предположению перестанов→

ка −

π n! \ {n} из Sn−1 не имеет кандидата для перемещения. Поэтому

→

перестановка −

π n! также не имеет кандидата для перемещения. Таким

→

образом, для любого i ̸= n! перестановка −

π i имеет переставляемый эле−

→

мент, а π n! не имеет кандидата для перемещения. После печати переста→

новки −

π n! и выхода из внутреннего while-цикла переменная m примет

значение 1. Поэтому алгоритм P M in(n) остановит свою работу.

В результате работы алгоритма P M in(n) напечатанные перестановки π i , i = 1, . . . , n! разбиты на (n − 1)! блоков по n штук в каждом.

В любом i-м блоке перестановки различаются между собой положением числа n, причём π in \ {n} является i-й напечатанной перестановкой

42

при работе алгоритма P M in(n−1). По индукционному предположению

′

получаем π in \ {n} ̸= π i n \ {n} при i ̸= i′ . Следовательно, перестановки

в разных блоках различны. Таким образом, мы получили все n! перестановок из Sn без повторений. Лемма 4 доказана.

Перейдём к программной реализации алгоритма Джонсона – Трот→

тера. Чтобы задать перестановку с направлениями её компонент −

π,

введём два массива π и τ , где π — собственно сама перестановка и τ

— массив из чисел −1, +1. Причём τi указывает направление числа πi :

+1 означает стрелку →, а −1 означает стрелку ← . Для формализации условия внутреннего while-цикла по числу m требуется найти его

дублёра m∗ . Если мы знаем number(m), номер позиции числа m в перестановке π и направление τm числа m, то дублёр определяется просто как m∗ = πnumber(m)+τm . Поэтому для хранения номера числа m

в перестановке π введём ещё один массив σ = (σ1 , . . . , σn ) такой, что

σi = number(i) — номер позиции числа i в перестановке π. Другими

словами, σ — обратная перестановка к π. Тогда для любого m имеем

πσm = m и πσm +τm = m∗ . Условие, что m не кандидат для перемещения

→

в−

π , означает, что π

> m, за исключением двух ситуаций, когда

σm +τm

мы находимся в крайних позициях следующего вида:

− . . . ), σ = 1, τ = −1;

π = (←

m,

m

m

→

π = (. . . , −

m), σm = n, τm = +1.

Поэтому нужно доопределить значения π0 и πn+1 так, чтобы в этих

ситуациях число m не являлось кандидатом для перемещения. Например, полагаем π0 = πn+1 = n + 1. Тогда π0 > m и πn+1 > m для для

любого m ≤ n.

В условии внутреннего while-цикла есть неравенство m > 1. Его

можно исключить, если при m = 1 произойдёт выход из этого цикла.

Это означает, что неравенство πσm +τm > m не должно выполняться

при m = 1. Так как πσ1 = 1, для этого достаточно определить τ1 = 0.

При этом ничего не нарушится, поскольку по замечанию 1 число 1 не

→

является кандидатом для перемещения в любой перестановке −

π.

43

Алгоритм P M in(n) генерации всех перестановок

в порядке минимального изменения

for i = 1 to n do

begin

πi := i;

τi := −1;

σi := i

end;

π0 := n + 1;

πn+1 := n + 1;

τ1 := 0;

m := 0;

while m ̸= 1 do

begin

write(π1 , . . . , πn );

m := n;

while πσm +τm > m do

begin

τm := −τm ;

m := m − 1

end;

Swap(πσm , πσm +τm );

Swap(σm , σπσm +τm )

end.

Теорема 5. Алгоритм P M in(n) корректен и строит все перестановки из Sn без повторений в порядке минимального изменения

за время O(n!).

Доказательство. Ввиду леммы 3 остается только оценить сложность T (n) алгоритма P M in(n). Из доказательства леммы 3 вытекает, что последовательность π 1 , π 2 , . . . , π n! всех перестановок из Sn ,

44

напечатанных в ходе работы алгоритма P M in(n), разбивается на nэлементные блоки Snk , k = 1, . . . , (n − 1)!. Введём обозначения:

• In — число сравнений, выполняемых в условии внутреннего whileцикла во время работы алгоритма P M in(n);

• tin — число сравнений, выполняемых в условии внутреннего whileцикла во время работы алгоритма P M in(n), начиная с печати

перестановки π i и до печати π i+1 , i < n!;

• tn!

n — число сравнений, выполняемых в условии внутреннего whileцикла во время работы алгоритма P M in(n), начиная с печати

перестановки π n! и до окончания работы алгоритма.

Индукцией по n докажем, что

n

∑

In =

i!.

i=1

Действительно, базис индукции n = 1 очевиден. Пусть n ≥ 2 и для n − 1

это равенство справедливо. Имеем

In =

n!

∑

∑

(n−1)!

tin =

∑

tin .

k

k=1 i: π i ∈Sn

i=1

Из доказательства леммы 3 следует, что число n является переставляемым элементом в первых n − 1 перестановках каждого блока Snk ,

π kn \ {n} есть k-я напечатанная перестановка во время работы алгоритма P M in(n − 1), причём переставляемые элементы в перестановках π kn

k

и π kn \ {n} совпадают и не равны n. Следовательно, tkn

n = 1 + tn−1 и

tin = 1 для любого i такого, что π i ∈ Snk и i ̸= kn. Учитывая индукционное предположение, получаем

∑

k=1

∑

(n−1)!

(n−1)!

In =

(n − 1 + tkn

n )=

(n + tkn−1 ) = n! + In−1 =

k=1

45

n

∑

i=1

i!.

Очевидно, T (n) = O(n) + O(In ). Так как In =

∑n

i=1

i! = n! + o(n!)13 ,

получаем T (n) = O(n!). Теорема 5 доказана.

Более детальное сравнение сложности линейных алгоритмов генерации P Lex(n) и P M in(n) показывает, что алгоритм P M in(n) быстрее.

Кроме того, алгоритм P M in(n) интересен тем, что перестановки выписываются в порядке минимального изменения, а это очень важно, если

с порождаемой перестановкой в требуемом алгоритме необходимо производить какие-либо вычисления, связанные с элементами самой перестановки. В этом случае имеется возможность использовать результаты

вычислений, полученные для предыдущей перестановки, отличающейся

от следующей только лишь транспозицией соседних элементов.

2. Подмножества конечного множества

Пусть P(A) — множество всех подмножеств n-элементного множества

A = {a0 , a1 , . . . , an−1 }. Мощность множества P(A) равна 2 n . Существует биективное отображение f : P(A) → E n из множества всех подмножеств P(A) в n-мерный единичный куб E n ,14 определяемое по правилу

f (B) = χ B для произвольного подмножества B ⊆ A, где

B

χ B = (χ B

0 , . . . , χ n−1 ),

{

χB

i

=

1, если ai ∈ B,

0, если ai ̸∈ B.

Таким образом, задача генерации всех подмножеств заданного n элементного множества A сводится к задаче порождения всех n-разрядных

двоичных последовательностей. Также отметим, что генерация всех

двоичных векторов длины n по сути есть прохождение всех вершин

n-мерного единичного куба без повторений.

13

14

f (n)

n→∞ g(n)

f (n) = o(g(n)), если lim

Здесь

En

= 0.

— множество вершин единичного куба, т. е. множество всех n-разряд-

ных двоичных последовательностей.

46

Для любого целого положительного числа a существует его единственное двоичное представление (bn−1 bn−2 . . . b1 b0 ) 2 = a, где bi определяются из следующих соотношений: