СТОХАСТИЧЕСКИЕ ПРОЦЕССЫ И СИСТЕМЫ

advertisement

БЕЛОРУССКИЙ ГОСУДАРСТЕННЫЙ УНИВЕРСИТЕТ

ФАКУЛЬТЕТ РАДИОФИЗИКИ И ЭЛЕКТРОНИКИ

Кафедра системного анализа

С. В. Гилевский

СТОХАСТИЧЕСКИЕ

ПРОЦЕССЫ И СИСТЕМЫ

Учебное пособие

для студентов факультета

радиофизики и электроники

специальностей 1-31 04 02 "Радиофизика",

и 1-31 0403 "Физическая электроника"

МИНСК

2004

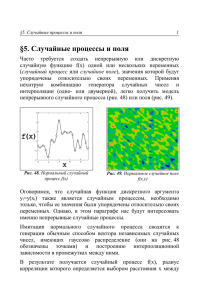

УДК 537.86(075.8)+621.38:53(075.8)

ББК 32.841я73+32.85я73

Г47

Рекомендовано Ученым советом

факультета радиофизики электроники

30 марта 2004 г., протокол № 8

Рецензент

кандидат физико-математических наук,

доцент В. А. Фuраго

Гилевский С. В.

Г47

Стохастические процессы и системы: Учеб. пособие для студентов фак. радиофизики и электроники / С. В. Гилевский. - Мн.: БГУ,

2004. - 112 с.

Излагаются материалы лекций специальных курсов "Стохастические системы" и "Случайные процессы" для студентов факультета радиофизики и электроники Белорусского государственного университета, обучающихся на кафедре

системного анализа по специальностям 1-31 04 02 "Радиофизика" и 1-31 04 03

"Физическая электроника".

Пособие может быть полезным также студентам инженерных специальностей и научно-техническим работникам, деятельность которых связана с изучением стохастических процессов различной природы.

УДК 537.86(075.8)+621.38:53(075.8)

ББК 32.841я73+32.85я73

© Гилевский С. В., 2004

©БГУ, 2004

ПРЕДИСЛОВИЕ

Предлагаемое учебное пособие "Стохастические процессы и системы" содержит материалы лекций по специальным курсам "Стохастические

системы" и "Случайные процессы", которые читаются автором студентам

3-го курса факультета радиофизики и электроники БГУ, проходящих специализацию на кафедре системного анализа. Учебное пособие преследует

собой цель изложить основные понятия теории случайных процессов и

дать неформальное определение основных статистических характеристик,

описывающих обобщенные свойства как отдельных реализаций стационарных случайных процессов, так и пар таких реализаций, а также их

свойства во временной и частотных областях. Выработать у студентов

навыки построения стохастических моделей физических процессов и явлений, оказать помощь в овладении методикой применения аппарата теории случайных функций для решения практических задач инженернофизического содержания.

В первых двух частях приводятся основные определения и модели, а

также дается классификация детерминированных и случайных процессов.

Отличительные свойства стационарных, эргодических и нестационарных

случайных процессов поясняются с помощью классификации по простым

признакам наличия или отсутствия тех или иных свойств. Затем в трех

разделах изложена спектрально-корреляционная теория случайных процессов и подробно рассмотрены методы определения спектральной плотности. Для метода периодограмм приведены статистические характеристики получаемых оценок спектральной плотности. Последняя шестая

часть учебного пособия посвящена краткому изложению теории линейных

физических систем и их динамических характеристик, а также приведены

соотношения между непрерывными и дискретными системами. Подробно

рассмотрен пример стохастической системы и ее динамические характеристики.

Предлагаемое учебное пособие совместно с ранее изданными методическими рекомендациями по выполнению лабораторных работ по специальным курсам "Стохастические системы" и "Случайные процессы"

являются элементами разрабатываемого учебно-методического комплекса,

который может быть использован для организации контролируемой самостоятельной работы студентов.

3

Часть 1

ОСНОВНЫЕ ОПРЕДЕЛЕНИЯ И МОДЕЛИ

Данный раздел содержит основные определения и модели детерминированных и случайных процессов и имеет целью дать основные теоретические предпосылки, составляющие предмет специальных курсов лекций.

1.1. ДЕТЕРМИНИРОВАННЫЕ ПРОЦЕССЫ

Любые данные, полученные в результате наблюдения реального физического явления, можно отнести, вообще говоря, к детерминированному

или недетерминированному типу. Детерминированные процессы – это

процессы, которые можно описать явными математическими формулами.

Рассмотрим пример (рис. 1.1). Жесткое тело подвешено к неподвижной

опоре с помощью линейной пружины.

Пусть масса m – масса тела (предполагается, что оно неупругое), k – коэффиk

циент жесткости пружины (предполагаПоложение

равновесия

ется, что она не имеет массы). Пусть

m

тело смещено от положения равновесия

x(t)

на расстояние a0 и освобождается в

Рис. 1.1. Простая механическая

система

момент времени t 0. С помощью основных законов механики или на основе многократных наблюдений можно установить, что имеет место следующая зависимость:

x(t )

a0 cos

k

t , t 0.

m

(1.1)

Уравнение (1.1) позволяет точно определить положение тела в любой

будущий момент времени. Следовательно, этот процесс, описывающий

движение тела, является детерминированным.

На практике часто встречаются физические явления, протекание которых с разумной точностью можно описать явными математическими

зависимостями. Например, движение спутника на околоземной орбите,

изменение потенциала между обкладками конденсатора по мере его разряда через резистор, колебание несбалансированного вращающегося ме-

4

ханизма, изменение температуры воды по мере ее нагревания, по сути дела своей, являются детерминированными процессами.

Однако многие другие физические явления порождают процессы, которые нельзя считать детерминированными. Например, высота волн при

морском ветровом волнении, акустическое давление, производимое потоком воздуха при его движении по трубе, электрический сигнал на выходе

генератора шума – это процессы, которые невозможно описать во всех

деталях. Совершенно невозможно предсказать и точное значение таких

процессов и в будущие моменты времени. Эти процессы случайны по своей сути и для их описания требуются вероятностные понятия и статистические характеристики.

Отнесение тех или иных физических процессов к детерминированному или случайному типу зачастую не бесспорно. С практической точки

зрения решение о случайности или детерминированности конкретного

физического процесса обычно основывается на нашей способности воспроизвести процесс в ходе контролируемого эксперимента. Если многократное повторение эксперимента, в ходе которого получается интересующий нас процесс, приводит к одним и тем же результатам (в пределах

ошибок эксперимента), то этот процесс обычно можно считать детерминированным. Если же невозможно указать эксперимент, который давал бы

при его повторении идентичные результаты, то такой процесс обычно

считается случайным по своей сути.

Сейчас мы обсудим один из способов классификации детерминированных процессов. Заметим, что принципы классификации выбирались с

точки зрения удобства анализа и не всегда являются наилучшими с других точек зрения. Заметим также, что физические процессы, как обычно

предполагается, представляют собой функции времени, так что далее для

удобства будем пользоваться именно такой интерпретацией. При желании

вместо времени можно взять любую другую независимую переменную.

1.1.1. Классификация детерминированных процессов

Процессы, описывающие детерминированные явления, делятся на

периодические и непериодические. В свою очередь периодические процессы можно разделить на гармонические и полигармонические. Непериодические процессы делятся на "почти периодические" и переходные.

Такая классификация процессов представлена на рис. 1.2.

5

Детерминированные

Периодические

Гармонические

Непериодические

Почти периодические

Полигармонические

Переходные

Рис. 1.2. Классификация детерминированных процессов

1.1.1.1. Синусоидальный периодический процесс. Синусоидальный

процесс – это периодический процесс, поведение которого во времени

математически выражается следующей формулой:

x(t )

X sin( 2 f0t

),

(1.2)

где Х – амплитуда, f0 – циклическая частота в герцах,

– начальный фа-

зовый угол в радианах, x(t) – мгновенное значение в момент времени t.

Синусоидальный процесс, определенный формулой (1.2), обычно называется гармоническим, имеет период T p 1 f 0 . Процесс графически

можно изобразить либо в виде зависимости мгновенного значения от времени, либо в виде зависимости амплитуды от частоты (частотного спектра) (рис. 1.3).

x(t)

Амплитуда

a

X

б

X

t

f0

f

–X

Tp

Рис. 1.3: а – гармонический процесс, б – частотный спектр

Заметим, что частотный спектр, изображенный на рис. 1.3, состоит из

единственной амплитуды, расположенной на определенной частоте, и

этим отличается от спектров, задающих непрерывную зависимость ампли-

6

туды от частоты. Такие спектры называются дискретными, или линейчатыми.

1.1.1.2. Полигармонические процессы. К полигармоническим процессам относятся периодические процессы, которые математически представляются функцией времени, точно повторяющей свои значения через

одинаковые интервалы времени, т. е.

x(t )

x(t nTp ) , n 1, 2, ... ,

(1.3)

где T p – период колебания. Число циклов в единицу времени называется

фундаментальной частотой f1 . Гармонические процессы представляют

собой частный случай полигармонических процессов при f1 f 0 .

За редкими на практике исключениями, полигармонические процессы разлагаются в ряд Фурье по формуле:

x(t )

где f1

a0

2

(an cos 2 nf1t bn sin 2 nf1t ) ,

(1.4)

n 1

1 Tp ;

an

bn

2

Tp

x (t ) cos 2 nf1tdt , n

Tp

2

Tp

0, 1, 2, ... ;

0

Tp

x(t ) sin 2 nf1tdt , n 1, 2, ... .

0

Другое представление полигармонических процессов рядом Фурье

дает формула:

x(t )

X0

X n cos(2 nf1t

n) ,

n 1

где X 0

a0 2 ;

Xn

n

an2 bn2 , n 1, 2, ;

arctg

bn

, n 1, 2, .

an

7

(1.5)

Иначе говоря, формула (1.5) утверждает, что полигармонический

процесс есть сумма постоянной составляющей X 0 и бесконечного числа

гармонических составляющих, называемых гармониками и имеющих амплитуды X n и фазы n . Все частоты гармонических составляющих кратны фундаментальной частоте f1 .

При практическом анализе периодических процессов фазовые углы

часто

игнорируются. В этом случае формулу (1.5) можно охарактериn

зовать дискретным спектром, как показано на рис. 1.4. Иногда полигармонические процессы содержат только конечное число составляющих.

Амплитуды

гармоник

X1

X2

X5

X3

X0

X4

0

f1

2 f1

3 f1

4 f1

5 f1

f

Рис. 1.4. Спектр полигармонического процесса

Физические явления, описываемые полигармоническими процессами,

встречаются намного чаще, чем явления, порождающие простые гармонические процессы. Например, детальный анализ напряжения на выходе

электрического генератора может выявить небольшие составляющие на

высших гармониках. В других случаях физические периодические процессы имеют много мощных гармоник. Например, вибрация многоцилиндрового двигателя внутреннего сгорания обычно содержит значительное число мощных гармоник.

1.1.1.3. Почти периодические процессы. В разделе 1.1.1.2 было отмечено, что периодический процесс обычно представляется в виде ряда,

состоящего из гармонических процессов с соизмеримыми частотами и

наоборот, любой процесс, образованный суммой двух и более гармонических процессов с соизмеримыми частотами, будет периодическим. Однако

если процесс образован суммой двух и более гармонических процессов с

произвольными частотами, то он, как правило, не будет периодическим.

Точнее говоря, сумма двух и более гармонических процессов будет периодическим процессом тогда и только тогда, когда отношение любых

8

двух частот есть рациональное число. В этом случае существуют фундаментальный период, который удовлетворяет выражению (1.4). Поэтому

процесс

x(t )

X1 sin( 2 2t

1)

X 2 sin( 2 3t

2)

X 3 sin( 2 7t

3)

периодический, так как 2/3, 2/7 и 3/7 – рациональные числа (фундаментальный период T p 1 ). С другой стороны, процесс

x(t )

X1 sin( 2 2t

1)

X 3 sin( 2

X 2 sin( 2 3t

50t

2)

3)

(1.6)

не периодический, так как 2 50 и 3 50 не рациональные числа (фундаментальный период бесконечно велик). Реализация такого процесса носит почти периодический характер, но соотношение (1.3) не выполняется

ни при каком конечном значении T p .

На основании этих соображений почти периодические процессы определяются математически как функции времени вида

x(t )

X n sin( 2 f nt

n)

,

(1.7)

n 1

причем f n f m не для всех значений индексов являются рациональными

числами. На практике почти периодические процессы порождаются физическими явлениями, в которых одновременно действуют гармонические

процессы, не связанные между собой. Хороший пример дает вибрация

многомоторного винтового самолета, в котором двигатели не синхронизированы.

Амплитуды

гармоник

X2

X3

X1

0

f1

X4

f2

f3

f4

Рис. 1.5. Спектр почти периодического процесса

9

f

Почти периодические процессы обладают следующим важным свойством. Если исключить из рассмотрения фазовые углы n, то формулу (1.7)

можно охарактеризовать дискретным спектром, подобным спектру полигармонического процесса (рис. 1.5).

Единственное отличие состоит в том, что отношения частот составляющих не являются рациональными числами.

1.1.1.4. Переходные непериодические процессы. По определению

переходные процессы – это все непериодические процессы, за исключением почти периодических процессов, определенных в разделе 1.1.1.3. Другими словами, к переходным относятся все процессы, которые можно задать какой-либо функцией времени, за исключением рассмотренных выше.

К переходным процессам приводят многочисленные и самые разнообразные явления. Например, процесс, показанный на рис 1.6 а, может

представлять температуру воды в чайнике (по отношению к температуре

помещения) после выключения нагревателя. Процесс, изображенный на

рис. 1.6 б, может характеризовать свободные колебания демпфированной

механической системы после прекращения действия вынуждающей силы.

Процесс, представленный на рис. 1.6 в, может описывать напряжение в

тросе с нагруженным концом, который разрывается в момент времени t 0 .

x(t)

x(t)

x(t)

AA

A

A

00

0

0

t

а

t

б

t0

t

в

Рис. 1.6. Примеры переходных процессов

Важная особенность переходных процессов, отличающая их от периодических и почти периодических, состоит в том, что их нельзя охарактеризовать дискретным спектром. В большинстве случаев для переходных

процессов можно получить непрерывное спектральное представление,

используя преобразование Фурье вида

X(f )

x(t )e

j 2 ft

dt .

(1.8)

В общем случае преобразование Фурье X ( f ) является комплексной

величиной, которая записывается в полярной форме

10

X( f )

X( f ) e

j (f)

,

где X ( f ) – модуль, а ( f ) – аргумент X ( f ) .

На рис. 1.7 представлены модули непрерывных спектров трех переходных процессов, изображенных на рис. 1.6.

X(f)

X(f)

X(f)

f

f

1/t0

2/t0

f

Рис.1.7. Спектры переходных процессов

1.2. СЛУЧАЙНЫЕ ПРОЦЕССЫ

1.2.1. Определение случайного процесса

Функция (t ) действительного переменного t называется случайной,

если при каждом значении аргумента t она представляет случайную величину (аргумент t будем считать неслучайной величиной). Иными словами, случайная функция – есть семейство случайных величин (t ) , зависящих от параметра t . Если параметром t является текущее время, то

случайная функция (t ) называется случайным процессом (в литературе

можно встретить – "стохастическим процессом").

Модель случайного процесса можно представить следующим образом. Предположим, что имеется большое число N датчиков (систем), находящихся в одинаковых внешних условиях. К каждому из датчиков подключены одинаковые регистрирующие приборы, которые фиксируют набор (ансамбль) колебаний с течением времени t (рис. 1.8). В отличие от

детерминированного процесса развитие, во времени которого априори

определено, однозначно. Случайный процесс представляет такие изменения во времени физического явления (или состояния технического объекта), которые заранее точно предсказать невозможно.

Если случайная величина определялась множеством ее возможных

значений и распределением вероятностей на этом множестве, то случайный процесс характеризуется множеством функций времени

11

(t ) {

(N)

(t ), t T }

(1.9)

и вероятностной мерой, заданной на множестве функций (1.9).

Каждая отдельная функция времени i (t ) называется реализацией

(траекторией, выборочной функцией) случайного процесса (t ) . Множество T значений параметра t называют областью определения случайного процесса (t ) , а множество X , которому принадлежат возможные

значения

(t ), – пространством значений процесса.

ξ1(t)

x1(t1)

x1(t2)

Д1

t

ξ2(t)

x2(t1)

x2(t2)

Д2

t

ξN(t)

xN(t1)

ДN

t1

xN(t2)

t2

t

Рис. 1.8. Модель случайного процесса

Более общим, чем понятие случайного процесса, является понятие

случайного поля – случайной функции нескольких переменных

(t , x, y, z ) .

Например, случайное поле может представлять изменения состояния

технического объекта в зависимости не только от времени, но и от его положения в пространстве (от координат x, y, z ). В настоящем курсе ограничимся изучением только теории случайных процессов и ее практических приложений.

1.2.2. Описание случайных процессов

Для описания (задания) случайных процессов (t ) применяются те

же вероятностные характеристики, что и для случайных величин, а именно функции распределения вероятностей, плотности вероятностей, харак-

12

теристические функции, моментные и корреляционные функции. Напомним их определения, связи между ними и основные свойства.

1.2.2.1. Функция распределения случайного процесса. Если на

всех регистрирующих приборах (см. рис. 1.8) в один и тот же момент времени t1 отсчитать мгновенные значения, то получим, вообще говоря, отличающиеся друг от друга значения

x1 (t1 ), x2 (t1 ), , xN (t1 ).

Выделим из общего числа N те n1 значений, которые в момент времени t1 меньше заданного числа x1 . При достаточно больших N относительная доля n1 N величин (систем), удовлетворяющих этому условию,

будет обладать статистической устойчивостью (группируется около постоянного числа) и может рассматриваться как вероятность того, что при

t t1 случайная функция (t ) находится ниже уровня x1 :

P{ (t1 )

n1

,N

N

x1} F ( x1 , t1 )

.

(1.10)

Функция F ( x1, t1 ) есть одномерная функция распределения. Слово

"одномерная" подчеркивает тот факт, что рассматриваются значения случайной функции в один фиксированный момент времени.

1.2.2.2. Плотность вероятности случайного процесса. Производная

от функции распределения вероятностей

w( x1 , t1 )

x1

F ( x1 , t1 ) ,

(1.11)

если она существует, есть одномерная плотность вероятности случайного процесса.

К определению одномерной плотности вероятности можно подойти

другим путем. Выделим из общего числа N реализаций случайного процесса (рис. 1.8) те n1 значений, в фиксированный момент времени t1 , которые заключены в достаточно малом интервале [ x1 , x1 dx1 ) . Согласно

теореме Бернулли (из теории вероятностей) следует ожидать, что при достаточно большом N относительная доля (частота) n1 N значений, заключенных в этом интервале, стремится к некоторой определенной величине (сходится по вероятности), пропорциональной dx1 и зависящей от

выбранных x1 и t1 как от параметров, т. е.

13

lim

N

n1

N

p

P{x1

(t1 )

x1 dx1} w( x1 , t1 )dx1 ,

(1.12)

p

где символ

означает сходимость по вероятности.

Функция w( x1 , t1 ) , выражающая пропорциональность вероятности

P{x1

(t1 ) x1 dx1} величине dx1 , называется одномерной плотностью вероятности.

1.2.2.3. Многомерная функция распределения и многомерная

плотность вероятности. Одномерная плотность вероятности, как и функция распределения, является важной, но не полной характеристикой случайного процесса. Она дает представление о процессе лишь в отдельные,

фиксированные моменты времени, не указывая, например, как значения

(t1 ) в момент времени t1 влияют на дальнейшее поведение процесса при

t2

t1 . Можно сказать, что одномерная плотность вероятности характери-

зует процесс "статически" и не дает представление о динамике его развития.

Более полными характеристиками случайного процесса являются

двумерная функция распределения вероятности и двумерная плотность

вероятности, которые характеризуют вероятностную связь между значениями процесса в два произвольных момента времени t1 и t2 . Определим

указанные функции.

Возьмем два момента времени t1 и t2 (рис.1.8). Пусть значения процесса в два момента времени есть:

x1 (t1 ), x2 (t1 ), , xN (t1 ) ;

x1 (t2 ), x2 (t2 ), , xN (t2 ).

Подсчитаем относительную долю систем n2 N , отсчеты которых в момент времени t1 не превышают x1 и в момент времени t2 не превышают

x2 . Тогда для достаточно большого числа N функция

F2 ( x1, t1; x2 , t2 )

P{( (t1 )

x1 ) ( (t2 )

x2 )}

(1.13)

называется двумерной функцией распределения. Производная от этой

функции

2

w( x1 , t1; x2 , t2 )

x1 x2

F ( x1 , t1; x2 , t2 )

называется двумерной плотностью вероятности.

14

(1.14)

Безразмерная величина w( x1, t1; x2 , t2 )dx1dx2 определяет вероятность

совместного

x2

выполнения

двух

неравенств

x1

(t1 ) x1 dx1

и

(t2 ) x2 dx2 , т. е.

n2

lim N

N

p

P{x1

(t1 )

x1

dx1; x2

(t2 )

w( x1, t1; x2 , t2 )dx1dx2 .

x2

dx2 }

(1.15)

Здесь правая часть при больших N представляет собой относительную

долю систем n2 N , отсчеты которых в момент времени t1 попадают в

интервальное окно [ x1, x1

dx1 ) , а в момент времени t2 – в окно

[ x2 , x2 dx2 ) .

В общем случае ни двухмерная функция распределения, ни двухмерная плотность вероятности также не дает исчерпывающего описания случайного процесса. Они позволяют судить о связи между вероятными значениями процесса (случайного) лишь в два момента времени. Более полное и детальное описание случайного процесса дается многомерными

функциями распределения или многомерными плотностями вероятности.

Такие вероятностные характеристики дают возможность сравнить вероятность появления различных реализаций случайного процесса (t ) .

Рассмотрим n моментов времени t1, t2 , , tn . Тогда, по аналогии,

n-мерная функция распределения определится как

n

Fn ( x1 , t1 ; ; xn , t n )

P

(ti )

xi .

(1.16)

i 1

Плотность вероятности w( x1, t1; ; xn , tn ) определяет вероятность

того, что значения случайного процесса (t ) в n моментов времени

заключены

соответственно

в

малых

интервалах

t1, t2 , , tn

[ x1, x1 dx1 ), [ x2 , x2 dx2 ), , [ xn , xn dxn ) . Эта вероятность равна

w( x1, t1; ; xn , tn )dx1 dxn . Плотность w( x1, t1; ; xn , tn ) позволяет судить о связи между вероятными значениями процесса в n произвольных

моментов времени.

Однако при любом конечном значении n n -мерная плотность вероятности еще не полностью характеризует (определяет) процесс с вероят-

15

ностной точки зрения. В самом деле, сквозь n "щелей" могут пройти различные кривые (см. рис. 1.9). В общем случае полную информацию о процессе можно иметь только тогда, когда его конечномерное распределение

w( x1, t1; ; xn , tn ) известно для любого числа n произвольно выбранных

значений t1, t2 , , tn .

ξ(t)

dx3

dx2

dx1

dxn

x3

x2

x1

t1

xn

t2

t3

tn

t

Рис. 1.9. Определение n-мерной плотности

1.2.2.4. Свойства функции распределения и плотности вероятности. Функция распределения случайного процесса должна удовлетворять:

1. Условию симметрии

Fn ( x1 , t1; , xn , t n )

Fn ( xk1 , tk1 ; , xk n , tk n ) ,

где k1, , kn – целые числа от 1 до n, расположенные в произвольном

порядке.

2. Условию согласованности

lim

x k 1 , , x n

Fn ( x1 , t1; , xn , tn )

Fk ( x1 , t1; , xk , tk ) , k

n.

Плотность вероятности случайного процесса должна удовлетворять следующим четырем условиям, которые являются прямым обобщением аналогичных условий и классической теории вероятностей:

1. Положительной определенности

w( x1, t1; ; xn , tn ) 0 .

16

2. Нормировки

(n) w( x1 , t1 ; ; xn , t n )dx1 dxn

1.

3. Симметрии, т. е. функция w( x1, t1; ; xn , tn ) не должна изменяться от

перестановки любых аргументов x1, t1; , xn , tn .

4. Согласованности

w( x1 , t1; ; xm , tm )

(n m) w( x1 , t1; ; xn , tn )dxm 1 dxn

для m n .

Таким образом, не всякая функция 2n переменных может быть интерпретирована как плотность вероятности.

1.2.2.5. Условные плотности вероятности. Для случайных процессов можно ввести условные плотности вероятности. Так, например, случайное значение процесса (t1 ) при известном его значении в другой момент времени (t2 )

x2 описывается условной плотностью вероятности

w( x1, t1 x2 , t2 ) w( x1, t1; x2 , t2 ) w( x2 , t2 ) ,

(1.17)

где согласно условию согласованности

w( x2 , t 2 )

w( x1 , t1; x2 , t 2 )dx1 .

Условная плотность вероятности содержит больше (по крайней мере

не меньше) сведений о (t1 ) , чем безусловная плотность вероятности

w( x1 , t1 ) . Насколько именно увеличилась информация о (t1 ) в результате того, что стало известным значение (t2 ) x2 , зависит от конкретных

условий. В некоторых случаях информация о (t1 ) вообще не прибавляется, каким бы не оказалось значение x2 . Это значит, что

w( x1, t1 x2 , t2 ) w( x1, t1 ) ,

(1.18)

при этом

w( x1, t1; x2 , t2 )

w( x1, t1 )w( x2 , t2 ) .

(1.19)

Эта формула выражает необходимое и достаточное условие независимости значений случайного процесса (t1 ) в два момента времени

t1 и t2 .

17

Формулы (1.17–1.19) легко можно обобщить на различные многомерные условные плотности вероятности, которые по "левым" переменным должны удовлетворять указанным выше четырем условиям.

1.2.3. Моменты случайных функций (процессов)

Для полного описания случайных процессов необходимо задать конечномерные функции распределения либо плотности вероятности. Однако в практических применениях многомерные (и даже одномерные) распределения вероятностей чаще всего оказываются слишком громоздкими

для использования. К тому же теоретическое определение одномерных и

тем более многомерных распределений вероятностей случайных процессов возможно лишь в исключительных случаях, например для гауссовых

процессов. Экспериментальное нахождение таких распределений в большинстве реальных физических и технических задач оказывается сложным

и дорогостоящим.

В качестве характеристик случайных процессов, более простых, чем

плотность вероятности, можно использовать моментные и корреляционные функции. При этом различают начальные и центральные моментные

функции.

Под начальными моментными функциями случайного процесса (t ) ,

заданного на некотором интервале, понимают математические ожидания

соответствующих произведений:

k

k ,m

(t1 , t2 )

(t )

M { k (t )}

M { k (t1 )

m

x k w( x, t )dx ;

x1k x2m w( x1 , t1; x2 , t2 )dx1dx2 .

(t2 )}

Существенное состоит в том, что моменты случайных функций представляют собой регулярные не случайные функции времени, поскольку

функции распределения зависят от параметра t.

Вместо начальных моментов можно рассматривать центральные моменты, которые определяются формулами:

k

(t )

k ,m

M {[ (t ) m (t )]k }

(t1 , t2 )

[ x m (t )]k w( x, t )dx ;

M {[ (t1 ) m (t1 )]k [ (t2 ) m (t2 )]m } .

18

В дальнейшем особую роль будут играть первый начальный момент

(математическое ожидание)

m

1

(t )

M { (t )}

xw( x, t )dx

(1.20)

и второй центральный момент, называемый дисперсией

M {[ (t ) m (t )]2 }

D (t )

а также начальный момент

цией случайного процесса

K (t1, t2 )

[ x m (t )]2 w( x, t )dx ,

11 (t1 , t2 ) ,

1,1

(t1, t2 )

называемый корреляционной функ-

M { (t1 ) (t2 )}

x1 x2 w( x1 , t1 ; x2 , t 2 )dx1dx2 .

Центральный момент

цией случайного процесса

R (t1, t2 )

1,1

(t1, t2 )

(1.21)

11 (t1 , t2 ) называется

(1.22)

ковариационной функ-

M {[ (t1 ) m (t1 )][ (t2 ) m (t1 )]}

[ x1 m (t1 )][ x2 m (t2 )]w( x1 , t1; x2 , t2 )dx1dx2 .

(1.23)

Из выражений (1.22) и (1.23) следует связь между ковариационной и

корреляционной функциями случайного процесса:

R (t1 , t2 ) K (t1 , t2 ) m (t1 )m (t2 ) .

(1.24)

Большое значение имеет смешанный центральный момент второго

порядка, называемый взаимной ковариационной функцией процессов (t )

и ( )

R (t , )

M {[ (t ) m (t )][ ( ) m ( )]}

[ x m (t )][ y m ( )]w( x, t ; y, )dxdy .

При

(t )

( ) получают автоковариационную функцию R (t , ) .

19

(1.25)

Часто рассматривают нормированную автоковариационную и нормированную взаимную ковариационную функции, которые называют коэффициентами корреляции:

r (t1, t2 ) R (t1, t2 )

D (t1 ) D (t2 ) ;

r (t , ) R (t , )

D (t ) D ( ) .

Раздел теории, посвященный изучению лишь тех свойств случайных

процессов, которые определяются этими характеристиками, называют

корреляционной теорией. Корреляционная теория дает полное описание

очень важного класса случайных процессов, называемых гауссовыми.

1.2.4. Характеристическая функция случайного процесса

Иногда вместо плотности вероятности для описания случайного процесса проще использовать характеристическую функцию, которая в одномерном случае определяется следующим образом

v ( ,t)

M {e j

(t )

w( x, t )e j x dx .

}

(1.26)

Из определения интеграла Фурье следует, что характеристическая

функция случайного процесса (t ) является преобразованием Фурье от

плотности распределения вероятностей этого случайного процесса. Поэтому при соответствующих условиях можно применить обратное преобразование Фурье и выразить плотность распределения вероятностей через

характеристическую функцию

w( x, t )

1

v ( , t )e

2

j x

d .

Нередко оказывается более простым не вычислять непосредственно

плотность распределения случайного процесса, а найти сначала характеристическую функцию и лишь, затем вычислить плотность распределения,

используя преобразование Фурье.

Важным свойством характеристической функции является то, что

дифференцирование ее по параметру " " доставляет начальные моменты

соответствующего случайного процесса

k (t )

j

k

d k v (t , )

d

.

k

0

(1.27)