Document 2021789

advertisement

Вершинин Н.Н., Авдонина Л.А., Волчихина Н.И.

КАТЕГОРИИ УПРАВЛЕНИЯ В КОНТЕКСТЕ ИНФОРМАЦИОННО-ВЕРОЯТНОСТНОГО ПОДХОДА

Обобщенная функция управления представляет собой иерархическую систему, под которой понимается

ансамбль взаимодействующих частей, состоящий из последовательности вложенных одна в другую взаимосвязанных субъединиц. Способы (стратегии), обеспечивающие качественную реализацию функций управления, связаны с проведением определенных мероприятий, вызывающих расходование различных видов ресурсов (активных средств).

С формальной точки зрения стратегия не может считаться заданной, если цель не описана математически, т.е. не сформирована целевая функция. Поэтому необходимо осуществить переход от содержательного

уровня формирования цели к уровню, обеспечивающему математическую экспликацию. В настоящее время

глубоко познать законы развития невозможно без такой научной абстракции, к которой относится понятие

«информация». Отправной точкой к познанию понятия «информация» служит понятие «неопределенность».

История развития понятия «неопределенности» долгое время не раскрывала его подлинного смысла, поэтому и в науке, и в практике оно не играло никакой существенной роли. В настоящее время выяснение общенаучного статуса понятия «неопределенность» в основном обусловлено тем, что оно непосредственно

выводится из взаимосвязи философских категорий. При этом понятию «неопределенность» прямой противоположностью является понятие «определенность», которая исторически всегда была на первом плане философского анализа. Философский анализ связи категорий определенности и неопределенности позволяет

выделить аспект этих понятий, отображающих направленность развития.

Многие авторы указывают на связь категории неопределенности с категорией движения.

Проведенный анализ состояния вопроса, связанного с категорией «неопределенность», позволил перейти к рассмотрению такой категории, как «энтропия» [1].

Энтропия – одно из важнейших и фундаментальных понятий, выдвинутых наукой за последнее столетие.

Сегодня энтропия заняла прочное место в самых различных областях человеческой деятельности и является одним из краеугольных камней научного миропонимания.

Следует отметить, что понятие «энтропия» возникло задолго до появления математической теории информации. Появление данного понятия связано с изобретением тепловой машины, когда вопрос о природе и

свойствах тепла перешел в разряд практических проблем. Исследования данного вопроса в трудах Майера,

Джоуля, Геймгольца, Карно, Томпсона, Максвелла и других ученых привели к созданию оснований термодинамики. В это время (в середине XVIII столетия) Р. Клаузиусом была введена в науку функция энтропии.

Первоначальное введение связано лишь с целью удобного описания принципов работы тепловых машин.

Клаузиус термин «энтропия» образовал от греческого «тропэ», означающего «превращение», к которому им

добавлена приставка «эн». Этой приставкой подчеркивалось родство введенного им в науку понятия с

общепризнанным понятием «энергия». «Обе величины, названные этими словами, – писал Р. Клаузиус, –

настолько близки друг другу по физической значимости, что известное сходство в названиях кажется мне

целесообразным». Корень «тропэ» Клаузиус употребил потому, что с помощью энтропии удалось проанализировать процессы превращения одних форм энергии в другие, в частности, превращение тепловой энергии

в полезную механическую.

Создателем вероятностного фундамента теории энтропии был австрийский ученый Людвиг Больцман. Заслуга его заключалась не только в привлечении аппарата теории вероятностей к исследованию энтропийных процессов. Главная идея Л. Больцмана заключалась в том, что сущность энтропии отражает невидимое

состояние микроскопических тел. Так, если предположить, что в сосуде с газом молекулы, обладающие

большей энергией, собрались с одной стороны, а молекулы с низким значением энергии – с другой, то

внутренняя энергия системы будет такой же, как и в случае, когда молекулы равномерно перемешаны по

всему объему. Не существует закона сохранения, который запрещал бы описание мгновенного распределения молекул, но вероятность его реализации очень мала. Таким образом, энтропия состояния системы и

есть в некотором смысле мера ее неопределенности.

В [2] на простых примерах ряда свойств энтропии, показана целесообразность ее выбора в качестве

характеристики степени неопределенности. В рамках единого подхода к степени (мерам) неопределенности

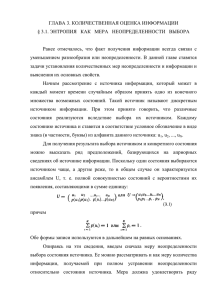

[3] обозначим класс функций f(x), заданных на интервале [0, 1] и удовлетворяющих следующим условиям:

1) функция f(x) – непрерывная и ограничена в интервале [0, 1] и имеет производную во всех внутренних точках этого интервала;

2) функция f(x) неотрицательная при всех х [0, 1];

3) функция f(x)/x монотонно убывает на интервале [0,1].

Будем называть функцию f(x) функцией неопределенности. Пусть (y) – непрерывная монотонно

возрастающая функция от y (0, ∞). Введем обобщенную меру неопределенности H x ,

x 0, 1 с помощью равенства:

H x f x / x,

f x ,

x 0,1 .

(1)

Физический смысл (1) раскрывается экспериментом с x равновероятными состояниями. Не вызывает сомнения, что степень неопределенности каждого исхода эксперимента определяется числом x. Так, если

при x = 1 событие не является случайным и его неопределенность равна нулю, то в случае большого числа x предсказать исход эксперимента в общем случае становится затруднительным.

Из приведенных рассуждений следует, что мера степени неопределенности зависит от x, при этом для

x = 1 эта мера равняется нулю, а с ростом числа x она должна возрастать. Следовательно, формально

данная мера является функцией от числа x, т.е. – f(x). Класс функций H{x} поставляет различные меры

неопределенности в зависимости от выбора конкретного вида функций f(x) и φ(х).

Как уже отмечалось, функция f(x) – непрерывная и ограничена в интервале [0, 1], существует производная во всех внутренних точках интервала [0, 1], функция f{x} неотрицательная при всех x 0, 1 .

Однако, перечисленных условий недостаточно, чтобы f(x) . Возникает необходимость в выяснении

такого дополнительного условия, при котором f(x)/x — монотонно убывающая функция на интервале [0,

1]. Предположим, что функция f(x) удовлетворяет также условию:

f `(x) ≤ f (x)/x, x 0, 1 .

(2)

Условие (2) является необходимым и достаточным, чтобы функция f(x)/x монотонно убывала на интервале [0, 1].

По поводу возможной корреляции между энтропией и информацией в литературе можно встретить различные точки зрения, начиная от того, что эти аналогии интересны и заслуживают изучения, до того, что

информация и энтропия, по-видимому, связаны друг с другом. Информация измеряет вероятность опреде-

ленного выбора элементов кода, на котором зашифровано сообщение. Энтропия измеряет вероятность определенного термодинамического состояния и, следовательно, его тенденцию к эволюции – (спонтанному)

переходу к более вероятному состоянию.

В настоящее время замечается тенденция, стимулированная сближением «двух культур» применять концепции физической и информационной энтропии к лингвистическим и биологическим, финансовым и налоговым, числовым и экономическим, социальным и военным системам. Энтропия в качестве меры эволюции характеризует как изолированные физико-химические системы (в которых она растет вместе с беспорядком,

достигая максимума при термодинамическом равновесии), так и неизолированные, обменивающиеся с окружающей средой потоками энергии (замкнутые системы) и потоками вещества (открытые системы). В таких

системах она может локально уменьшаться, сопровождаясь процессами перестройки структуры, ведущими к

увеличению пространственно-временной организации, информации и порядка, иными словами, к возрастанию

сложности системы.

Способ, описания возможности осуществления определенного распределения взаимодействующих частиц

системы, Больцман выразил с помощью введенной им вероятностной формулы энтропии:

HP

p j log p j . (3)

Пусть k есть некоторый эксперимент с исходами L1, L 2, ..., L n , которые осуществляются с вероятностями

p1, p2, ..., pn .

Информация,

полученная

в

результате

этого

эксперимента

k,

есть

J K J K l , принимающая значение log p j , где j = 1, 2, ..., n на множестве

случайная

, , P ,

величина

соответствую-

щем эксперименту k, если совпадает с множеством L1, L 2, ..., L n , то J K l I l . При этом математическое ожидание MJ K

n

pj log pj

называется энтропией эксперимента. Данная величина имеет свое сим-

j 1

вольное обозначение:

H P H k

n

pj log pj .

(4)

j 1

Энтропия — это теоретико-информационная мера степени неопределенности случайной величины. Мера

информации определяется через ее диалектическую противоположность, в качестве которой выступает неопределенность. Дать формальное определение интуитивно ясного понятия «информация» чрезвычайно трудно, да в этом и нет необходимости, так как фундаментальное значение понятия «информации» общеизвестно и, употребляя это слово по существу, имеют в виду одно и то же. В естественных науках понятие

информации связывается со свойством сложности, упорядоченности, организации структуры и разнообразия.

Количество информации (в вероятностной концепции) – это теоретико-информационная мера величины

информации, содержащейся в одной случайной величине относительно другой. Таким образом, принята следующая количественная мера информации: пусть А и В – события некоторого вероятностного пространства

, , P ,

тогда количество информации I

A

B , которое заключено в событии (сообщении) В относи-

тельно А, является число:

I A B log

P A B

P A

. (5)

При этом, если появление события А = В можно интерпретировать как сообщение о том, что наступило

событие А, то число

I A B

= I(A) количеством информации I(A), заключающимся в сообщении А:

I(A) = – log P(A). Если события А и В независимы, то I(A | B) = 0. Это означает, что событие В не

несет в себе никакой информации относительно А, и наоборот. Следует заметить, что всегда I

A B

=

I B A . В этом случае I A B I A I B .

Рассматривая энтропию как меру неопределенности состояния некоторой системы, становится очевидным, что в результате получения сведений неопределенность системы может быть уменьшена. Чем больше

объем полученных сведений, тем больше будет информация о системе, тем менее неопределенным будет ее

состояние. Естественно поэтому количество информации измерять уменьшением энтропии той системы, для

уточнения состояния которой предназначены сведения. Следовательно, формула определения информации

имеет вид

I p H max H p,

где

(6)

H MAX – максимальная энтропия системы;

H P – энтропия, описывающая состояние системы после получения количества информации, равного p.

Таким образом, во многих процессах, приводящих к увеличению порядка в структуре формирующих систем, происходит накопление информации, количество которой определяется с помощью функции

p log p.

Тенденция развития данного научного направления такова, что можно прогнозировать невозможность игнорирования логической связи между физической энтропией статистической механики и термодинамики и информацией или информационной энтропией теории сообщений. При этом, если энтропия используется как

информационная мера, то ее принято называть энтропией Шеннона.

Определение понятия «неопределенность», имеет фундаментальное значение для построения информационно – вероятностной модели. При решении специфических задач теории принятия решений неопределенность проявляется: во-первых, как неопределенность, генерированная общим числом объектов и элементов

(включенных в ситуацию выбора); во-вторых, как неопределенность, порождаемая недостаточной полнотой,

а также искажениями информации, обусловленными внутренними факторами (сложностью структур, новизной

принимаемых решений, трудностями передачи информации с одного уровня иерархической структуры на другой и т.п.); в-третьих, как неопределенность, вызванная разнообразием условий применения сложных

систем, неоднозначностью условий, в которых проявляются заложенные в систему свойства. Преодоление

такого рода трудностей связано с решением проблемы диалектического «снятия» неопределенности, которое реализуется с помощью информационно-вероятностного подхода.

ЛИТЕРАТУРА

1. Волчихин В.И., Вершинин Н.Н., Тихомиров А.В. Управление сложными производственными и технологическими системами. Монография. – Пенза: Изд-во Пенз. гос. ун-та, 2004.

2.Яглом А.М., Яглом И.М. Вероятность и информация. –М.: Наука, 1973.

3. Косенко Г.Г. Критерии информативности при разрешении сигналов. – М.: Радио и связь, 1982.

4. Мартыщенко Л.А., Тихомиров В.А. Вероятностно-статистические методы праксеологического анализа

разработок и оценки технических решений. Л.: МО РФ, 1992.