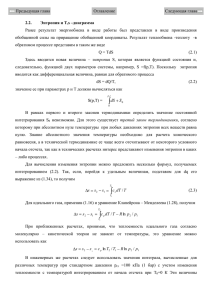

Лекция 2 - Свойства энтропии

advertisement

Лекция 2 Свойства энтропии Энтропия отражает степень неопределенности состояния системы и одновременно является количественной мерой информации (см. Теоретическая информатика: курсе лекций / Т. А. Тушко, Е. А. Вейсов, Н. А. Богульская; Сиб. федерал. ун-т. Политехн. ин-т. – 2007 http://files.lib.sfu-kras.ru/ebibl/umkd/324/u_lectures.pdf (свободный доступ)). Основные свойства энтропии как математической функции следующие: Свойство 1. Энтропия является неотрицательной ограниченной функцией, определенной на отрезке от 0 до 1. Это следует из того, что для pi (0 ≤ pi ≤ 1) функция log2 pi ≤ 0 и ограничена, а значит, ограничены и неотрицательны hi = – pi log2 pi (1 ≤ i ≤ N). Найдем предел hi при pi → 0: Таким образом, H ( ) ≥ 0 и ограничена. Свойство 2. Энтропия является монотонно возрастающей функцией от числа состояний N , если все состояния равновероятны. Для доказательства этого свойства покажем, что при Шеннона вырождается в формулу Хартли: формула Как известно, логарифм является монотонно возрастающей функцией своего аргумента, в данном случае N. Свойство 3. Энтропия равна 0 лишь в том случае, когда вероятность одного из состояний равна 1, а вероятности остальных состояний нулевые. Информатика 1 Эта ситуация возникает тогда, когда заведомо известен исход события, т. е. N = 1. Обоснование свойства 3 также может базироваться на выкладках, по лученных при доказательстве свойства 1. Свойство 4. Энтропия максимальна, когда все состояния источника равновероятны. Этот случай соответствует максимальной неопределеннос ти состояния источника (непредсказуемости возможного исхода). Доказательство свойства 4 нетривиально. В качестве упражнения можно провести доказательство для N = 2. Заметим, что при равновероятных исходах энтропия вычисляется по формуле Хартли Свойство 5. Энтропия не зависит от пути выбора состояния источника. Выбор может быть как непосредственным, так и многоступенчатым. В последнем случае неопределенность выбора состояния складывается из не определенностей выбора группы состояний и неопределенностей выбора со стояния в каждой группе. Примеры такого рода рассматривались при обосновании формулы Хартли ранее. Свойство 6. Энтропия обладает свойством аддитивности. Смысл этого свойства заключается в следующем . Если два источ ника U и V принимают соответственно состояния и независимо друг от друга, то их можно рас сматривать как один источник UV, состояния которого определяются парами при i = 1,…, N; j = 1,…, M. В этом случае H(UV) = H(U) + H(V). Завершая изучение основных свойств энтропии, отметим следующий факт. Доказано, что функционал вида является единственным, удовлетворяющим всем сформулированным выше свойствам. Здесь c – некоторая константа. В нашем случае c = 1. Термин "энтропия" выбран не случайно. Он заимствован из термодинамики, впервые его ввел Больцман для описания статистических свойств газа. Информатика 2 Здесь М – число молекул в некотором замкнутом объеме газа, т i – число молекул, движущихся со скоростью vi + ∆v. Тогда (тi/М) представляет собой вероятность того, что наугад выбранная молекула имеет скорость vi + ∆v. Мы видим, что структура формул совпадает. Совпадение это не случайно, поскольку существует не только формальная, но и смысловая аналогия энергетических и информационных процессов. Можно отметить еще два содержательных аспекта относительно свойств энтропии: 1. Согласно модели Шеннона, энтропия зависит только от вероятностных характеристик исследуемой системы и полностью игнорируют их содержательную сторону. Поэтому энтропия не может служить универсальным средством для решения любых задач, связанных с неопределенностью. Например, при использовании этой меры для оценки неопределенности действия лекарства, приводящего в 90% случаев к выздоровлению и в 10% случаев к улучшению состояния, энтропия будет такой же, как и для яда, приводящего в 90% случаев к смерти и в 10% случаев к ухудшению состояния. 2. Энтропия как мера неопределенности согласуется с экспериментальными данными, полученными при изучении реакции человека в ситуации выбора. Установлено, что время безошибочной реакции человека на появление беспорядочных случайных раздражителей (например, загорающихся лампочек) растет при увеличении энтропии. Чем больше энтропия, тем больше времени требуется человеку, чтобы правильно отреагировать. Замена равновероятных раздражителей на неравновероятные влечет за собой уменьшение времени реакции пропорционально уменьшению энтропии. Алфавит. Энтропия и избыточность алфавита. Рассмотрим еще раз алфавитный источник информации с учетом свойств энтропии. Энтропия алфавита – это количество информации, приходящееся на один символ. Или информационная нагрузка, которую несет один символ алфавита. Установлено, что энтропия достигает максимума, когда все состояния источника равновероятны. Следовательно, символы равновероятного алфавита несут максимальную информационную нагрузку где N – объем алфавита. Информатика 3 Однако алфавиты природных языков этим свойством не обладают, так как не являются равновероятными. Например, относительная частота появления отдельных символов русского языка изменяется от 0,175 до 0,002 (см. табл. 1). Используя данные таблицы, вычислим энтропию алфавита: Получается, что вследствие статистических свойств алфавита информационная нагрузка на один символ снижена на Информатика 4 Таблица 1 – Вероятности появления и коды Морзе для букв русского алфавита Буквы Вероятность Коды Буквы Вероятность Коды О 0.090 −−− Ы 0.016 Е,Ё 0.072 ∙ З 0.016 А 0.062 ∙− Ь,Ъ 0.014 И 0.062 ∙∙ Б 0.014 Т 0.053 − Г 0.013 Н 0.053 −∙ Ч 0.012 С 0.045 ∙∙∙ Й 0.010 Р 0.040 ∙−∙ Х 0.009 В 0.038 ∙−− Ж 0.007 Л 0.035 ∙−∙∙ Ю 0.006 К 0.028 −∙− Ш 0.006 М 0.026 −− Ц 0.004 Д 0.025 −∙∙ Щ 0.003 П 0.023 ∙−−∙ Э 0.003 У 0.021 ∙∙− Ф 0.002 Я 0.018 ∙−∙− ПРОБЕЛ 0.175 ∙−−− −−∙∙ −∙∙− −∙∙∙ −−∙ −−−∙ −−− ∙∙∙∙ ∙∙∙− ∙∙−− −−−− −∙−− −−∙− ∙∙−∙− ∙∙−∙ Для характеристики этого явления введено понятие избыточности алфавита. Избыточностью алфавита называется уменьшение информационной нагрузки на один символ вследствие неравновероятности и взаимозависимости появления его символов. Информационная избыточность, характеризующая относительную недогруженность алфавита, является безразмерной величиной (часто ее выражают в процентах) и рассчитывается так: Информатика 5 (1) В рассмотренном выше примере: Очевидно, D = 0 когда H = Hmax . Это соответствует случаю равновероятного алфавита. Однако относительные частоты отдельных букв не являются статистически независимыми. В формуле (1) никак не отражено влияние взаимозависимости символов, о которой говорится в определении. Избыточность Ds, вызванная статистической связью между символами, возникает вследствие наличия определенных закономерностей появления одних символов непосредственно после других. Например, в русском языке буквы О, А имеют наибольшую вероятность появления, в то время как вероятность появления сочетания ОА весьма мала по сравнению, допустим, с биграммой ЫЙ. Для вычисления Ds необходимо знать для всех пар символов ai и bj условные вероятности их появления р(bj /ai), то есть вероятность появления символа bj при условии, что непосредственно перед ним появился символ ai. Не вдаваясь в подробности вычисления условных вероятностей р(bj /ai), приведем для сведения формулу вычисления Ds, которой можно пользоваться, если условные вероятности оказываются известными: Полная информационная избыточность тогда выражается через свои составляющие Dp и Ds по формуле D = Ds + Dp – Ds Dp. Вернемся к вопросу энтропии русского алфавита. Учет относительной частоты двух- и трехбуквенных сочетаний приводит к уменьшению энтропии до 3.01 бит/символ, а учет сочетаний до восьми букв снизит эту цифру до 1.19 бит/символ (это меньше, чем для трехбуквенного равновероятного алфавита). Информатика 6 В дальнейшем, если не оговорено особо, будем пользоваться формулой избыточности без учета составляющей Ds, полагая D = Dp. Явление избыточности влечет за собой как отрицательные, так и положительные последствия. Отрицательные последствия вызваны тем, что наличие "лишних" символов увеличивает затраты ресурсов (время, память) при хранении, передаче и обработке сообщений. Важнейший положительный момент заключается в том, что наличие избыточности в алфавите повышает его помехоустойчивость. Наиболее наглядно это проявляется при использовании естественных языков, избыточность которых исключительно высока. Помехоустойчивость природных языков. Было бы неправильным рассматривать избыточность природных языков как их недостаток. Именно вследствие столь высокой избыточности речь на естественных языках остается понимаемой даже при сильных искажениях – акценте, дефекте речи, ошибках и сокращениях. В то же время случайные искажения нескольких или даже одного символа при использовании равновероятного алфавита (технического) может существенно изменить содержание всего сообщения. Количество информации в сообщении. Информация передается, как правило, в виде сообщений, представляющих собой некоторую последовательность символов. Зная длину сообщения и энтропию алфавита, в символах которого этого сообщение составлено, количество информации можно подсчитать по формуле I=m×H где I – количество информации в сообщении; m – число символов в сообщении; H – энтропия алфавита. Информатика 7