Лекция 1 - ПГАТИ – Кафедра Высшая математика

advertisement

ФЕДЕРАЛЬНОЕ АГЕНСТВО СВЯЗИ

Государственное образовательное учреждение

высшего профессионального образования

ПОВОЛЖСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ

ТЕЛЕКОММУНИКАЦИЙ И ИНФОРМАТИКИ

Кафедра высшей математики

КОНСПЕКТ ЛЕКЦИЙ

ПО УЧЕБНОЙ ДИСЦИПЛИНЕ

Теория вероятностей и

математическая статистика

Самара, 2010

УДК 519.2

Блатов И.А., Старожилова О.В. Теория вероятностей и

математическая статистика. Конспект лекций.- Самара:

ГОУВПО ПГУТИ, 2010.-286

Конспект лекций затрагивает такие разделы высшей

математики как: теория вероятностей, элементы комбинаторики,

математическая статистика, регрессионный, корреляционный

анализ.

Каждая лекция заканчивается контрольными вопросами,

которые помогут проверить теоретическое освоение курса,

содержит большое количество задач для самостоятельного

решения и ответы для проверки.

Рецензент:

Асташкин С.В. – д.ф.м.н., проф., зав.кафедрой Самарского

государственного университета

Государственное образовательное учреждение высшего

профессионального образования

Поволжский

государственный

телекоммуникаций и информатики

©Блатов И.А., Старожилова О.В., 2010

2

университет

Введение ........................................................................................ 8

Лекция 1......................................................................................... 10

Случайные события, классификация ..................................... 10

Парадокс игры в кости ............................................................ 12

Классификация событий ......................................................... 13

Классическое определение вероятности ............................... 15

Ошибка Даламбера .................................................................. 17

Контрольные вопросы............................................................. 18

Элементы комбинаторики ...................................................... 19

Формула Стирлинга ................................................................ 24

Лекция 2........................................................................................ 26

Геометрическая вероятность .................................................. 26

Статическая вероятность ........................................................ 28

Условная вероятность ............................................................. 31

Парадокс Монти Холла........................................................... 33

Контрольные вопросы............................................................. 34

Задачи для самостоятельно решения ..................................... 35

Лекция 3......................................................................................... 37

Алгебра событий - сумма двух событий ............................... 37

Алгебра событий – произведение двух событий .................. 37

Вероятность появления хотя бы одного из событий............ 39

Диаграммы Эйлера-Венна ...................................................... 41

Принцип практической невозможности................................ 43

Контрольные вопросы............................................................. 44

Формула Бейеса ....................................................................... 45

Физический смысл и терминология формулы Бейеса ......... 49

Формула полной вероятности события ................................. 50

Метод фильтрации спама ....................................................... 52

Контрольные вопросы............................................................. 52

Задачи для самостоятельно решения ..................................... 53

Лекция 4......................................................................................... 56

Случайные величины, классификация .................................. 56

Законы распределения случайной величины ........................ 57

Интегральный закон распределения ...................................... 60

3

Числовые

характеристики

дискретной

случайной

величины .................................................................................. 62

Характеристики положения ................................................... 62

Характеристики рассеивания ................................................. 67

Параметры формы ................................................................... 70

Вероятность попадания дискретной случайной величины

в заданный интервал ............................................................... 72

Контрольные вопросы............................................................. 72

Лекция 5......................................................................................... 74

Законы распределения дискретной случайной величины ... 74

Двухточечное распределение ................................................. 74

Распределение выборочного значения признака.................. 75

Биноминальное распределение (закон Бернулли) ................ 76

Наивероятнейшее значение случайной величины ............... 81

Закон Пуассона ........................................................................ 84

Числовые характеристики пуассоновского распределения 85

Контрольные вопросы............................................................. 90

Лекция 6......................................................................................... 91

Непрерывные случайные величины ...................................... 91

Функция

распределения

непрерывной

случайной

величины .................................................................................. 91

Функция плотности непрерывной случайной величины ..... 92

Числовые характеристики непрерывной случайной

величины .................................................................................. 95

Контрольные вопросы............................................................. 100

Задачи для самостоятельного решения ................................. 100

Лекция 7......................................................................................... 102

Основные законы непрерывных случайных величин .......... 102

Равномерный закон распределения ....................................... 102

Экспоненциальное распределение ......................................... 106

Задачи для самостоятельного решения ................................. 108

Закон Вейбулла ........................................................................ 109

Нормальное распределение (закон Гаусса)........................... 111

Доска Гальтона ........................................................................ 112

Функция Лапласа..................................................................... 116

Правило трех сигм ................................................................... 118

Контрольные вопросы............................................................. 120

4

Задачи для самостоятельного решения ................................. 122

Лекция 8......................................................................................... 124

Дискретные двумерные случайные величины...................... 124

Числовые характеристики двумерных случайных величин 126

Плотности вероятности составляющих двумерной

случайной величины ............................................................... 132

Условные

законы

распределения

составляющих

двумерной случайной величины ............................................ 132

Корреляционный момент системы двух случайных

величин ..................................................................................... 134

Контрольные вопросы............................................................. 141

Лекция 9......................................................................................... 142

Функция одного случайного аргумента ................................ 142

Математическое ожидание функции одного аргумента ...... 143

Функция двух случайных величин ........................................ 144

Лекция 10....................................................................................... 147

Равномерный закон распределения на плоскости ................ 147

Нормальный закон распределения на плоскости ................. 148

Вероятность попадания в прямоугольник............................. 149

Лекция 11....................................................................................... 150

Закон больших чисел .............................................................. 150

Неравенство Чебышева ........................................................... 151

Теоремы Чебышева и Бернулли ............................................. 154

Практическое значение теоремы Чебышева ......................... 157

Предельные теоремы............................................................... 159

Характеристические функции ................................................ 159

Контрольные вопросы............................................................. 167

Лекция 12....................................................................................... 168

Математическая статистика ................................................... 168

Виды выборки .......................................................................... 170

Способы отбора ....................................................................... 173

Табличное представление статистических данных.............. 175

Графическое представление статистических данных .......... 180

Выборочная функция распределения .................................... 183

Числовые характеристики вариационного ряда ................... 184

Меры разброса опытных данных ........................................... 189

Контрольные вопросы............................................................. 191

5

Лекция 13....................................................................................... 192

Проверка статистических гипотез ......................................... 192

Критическая область ............................................................... 197

Распределение ................................................................... 198

Критерий Пирсона................................................................... 199

Схема применения критерия .................................................. 202

2

Схема применения критерия для непрерывных

2

случайных величин ................................................................. 203

Контрольные вопросы............................................................. 206

Задачи для самостоятельного решения ................................. 206

Лекция 14...................................................................................... 208

Регрессивный анализ............................................................... 208

Метод наименьших квадратов для получения уравнения

выборочной линии регрессии ................................................. 210

Линейный регрессионный анализ .......................................... 212

Проблемы применения метода линейной регрессии ........... 217

Основные предпосылки статистической модели линейной

регрессии .................................................................................. 218

Задачи регрессионного анализа ............................................. 219

Многомерная нормальная регрессионная модель ................ 222

Вариация зависимой переменной и коэффициент

детерминации ........................................................................... 223

Контрольные вопросы............................................................. 225

Лекция 15....................................................................................... 226

Статистические оценки параметров распределения ............ 226

Метод наибольшего правдоподобия...................................... 230

Метод моментов ...................................................................... 231

Бейесовский подход к получению оценок ............................ 233

Контрольные вопросы............................................................. 234

Лекция 16....................................................................................... 235

Доверительные интервалы ..................................................... 235

Доверительный интервал для оценки математического

ожидания нормального распределения при известной

дисперсии ................................................................................. 236

6

Доверительный интервал для оценки математического

ожидания нормального распределения при неизвестной

дисперсии ................................................................................. 237

Доверительные интервалы для оценки среднего

квадратического отклонения нормального распределения . 239

Контрольные вопросы............................................................. 241

Лекция 17....................................................................................... 242

Случайные процессы и их характеристики .......................... 242

Классификация случайных процессов .................................. 243

Законы распределения случайного процесса........................ 246

Моментные характеристики случайного процесса .............. 247

Корреляционная функция ....................................................... 249

Глоссарий ...................................................................................... 255

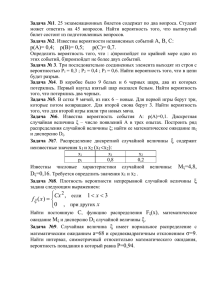

К лекции 1 ..................................................................................... 255

К лекции 2 ..................................................................................... 256

К лекции 3 ..................................................................................... 257

К лекции 4 ..................................................................................... 258

К лекции 4 ..................................................................................... 259

К лекции 5 ..................................................................................... 261

К лекции 6 ..................................................................................... 262

К лекции 7 ..................................................................................... 263

К лекции 8 .................................................................................... 264

К лекции 9 ..................................................................................... 266

К лекции 10 ................................................................................... 267

К лекции 11 ................................................................................... 267

К лекции 12 ................................................................................... 267

К лекции 13 ................................................................................... 270

К лекции 14 ................................................................................... 270

К лекции 16 ................................................................................... 271

К лекции 17 ................................................................................... 271

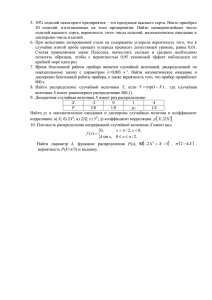

Список основных формул ............................................................ 277

Список литературы....................................................................... 286

7

Введение

"Случай играет в мире столь

большую роль, что и без моей

помощи он позаботится о себе."

A. Дюма

345 лет назад, в 1657 году, было опубликовано сочинение

выдающегося голландского ученого Христиана Гюйгенса "О

расчетах при игре в кости", которое является одним из первых

исследований в области теории вероятностей.

Трудно установить, кто впервые поставил вопрос о

возможности

количественного

измерения

возможности

появления случайного события. Ясно только, что более или

менее удовлетворительный ответ на этот вопрос потребовал

большого времени и значительных усилий выдающихся

исследователей целого ряда поколений.

Обычно считают, что теория вероятностей возникла в

середине XVII столетия, причем ее появление связывают с

именами П. Ферма (1601-1665), Б. Паскаля (1623-1662) и Х.

Гюйгенса (1629-1695). Отправным пунктом исследований

являлись задачи, связанные с азартными играми, особенно

играми в кости, поскольку при их изучении можно

ограничиваться простыми и понятными математическими

моделями. Игра в карты –тоже азартная игра. потому, что в ней

главную роль играет случай - от него зависит, какие именно

карты окажутся у партнеров. С азартных игр математики и

начали изучать его величество Случай.

―Математика случая‖ — так еще в XVII в. назвал теорию

вероятностей один из ее основателей, французский ученый Блез

Паскаль

Классическая

теория

вероятностей

рассматривает

вероятность как отношение числа благоприятствующих случаев

ко всем возможным. При этом предполагается, что все

рассмотренные

случаи

являются

равновозможными,

равновероятными.

8

Гюйгенс в сочинении "О расчетах при игре в кости" писал:

"...думаю, при внимательном изучении предмета читатель

заметит, что имеет дело не только с игрой, но что здесь

закладываются основы очень интересной и глубокой теории".

Одной из задач, давших начало теории вероятностей,

является знаменитый парадокс игры в кости, разрешенный еще в

"Книге об игре в кости" Д. Кардано (1501-1576), которая вышла

лишь в 1663г.

Значительное влияние на развитие теории вероятностей

оказали Д. Бернулли (1654-1705), А. Муавр (1667-1754), Т. Байес

(1702-1763), П. Лаплас (1749-1827), К. Гаусс (1777-1855), С.

Пуассон (1781-1840).

Например, Д. Бернулли принадлежит первое доказательство

одного из важнейших положений теории вероятностей - так

называемого "закона больших чисел". Теорема, которую он

доказал, устанавливает связь между вероятностью события и

частотой его появления.

Развитие теории вероятностей тесно связано с традициями и

достижениями русской науки. Фундаментальные результаты

были получены П. Л. Чебышевым (1821-1894), А. М. Ляпуновым

(1857-1918), позже большой вклад в ее развитие внесли Е. Е.

Слуцкий (1903-1987) и ряд других.

Курс

построен

в

соответствии

с

требованиями

Государственного образовательного стандарта России к

дисциплине

«Теория

вероятностей

и

математическая

статистика». Учебная программа разработана на основе учебных

планов специальностей 230105 «Программное обеспечение

вычислительных и автоматизированных систем», 230201

«Информационные системы и технологии».

Каждая лекция заканчивается контрольными вопросами,

которые помогут проверить теоретическое освоение курса,

содержит большое количество задач для самостоятельного

решения и ответы для проверки

9

Лекция 1

Случайные события, классификация

Теория вероятностей (ТВ) изучает закономерности,

возникающие в случайных экспериментах, раскрывает

объективные закономерности, присущие массовым явлениям. Ее

методы не дают возможности предсказать исход отдельного

случайного явления, но позволяют предсказать средний

суммарный результат массы однородных случайных явлений.

Одна из важнейших задач любой науки – найти

закономерности

в

водовороте

«случайных»

явлений

окружающей нас жизни. Основатель теории вероятностей как

строгой математической дисциплины – Колмогоров Андрей

Николаевич (1903 –1988). В 1933г. он опубликовал

аксиоматическое построение этой теории.

Одно из основных понятий теории вероятностей – понятие

случайного события. Его работа «Основные понятия теории

вероятностей»(1933) новый этап в развитии теории вероятностей

как науки.

Для изучения физических явлений производят наблюдение и

опыты, их результаты обычно регистрируют в виде значений

некоторых наблюдаемых величин. При повторении опытов

обнаруживается разброс их результатов. Говорят, что результат

измерения есть величина случайная. Математический аппарат

для изучения таких случайностей и закономерностей в них дает

теория вероятностей.

Определение Случайные события – любые события или

факты, относящиеся к результату эксперимента, которые могут

происходить или не происходить.

Название объясняется тем, что именно случай определяет,

произойдет данное событие или не произойдет.

Отдельные случайные события в ТВ обозначают прописными

латинскими буквами, например, A , B и т.д. Accident

(французский) – случайность.

Случайные события – результаты эксперимента, его исходы.

10

Пример

Компания Н занимает целый этаж. В конце коридора

расположена комната отдыха, в ней аппарат для приготовления

кофе. В среднем работник фирмы выпивает в день n чашек

кофе. Спрашивается:

Какова вероятность, что когда сотрудник идет с кофе к

себе в комнату, он получит удар по лбу открывающейся

дверью?

Какова вероятность, что при резком открытии двери

сотрудник даст по лбу коллеге, несущему кофе?

И что же теперь, кофе не пить?

Даже если до сих пор Вы не любили кофе, Вы полюбите его с

нашими кофейными аппаратами

Не все случайные явления можно изучать методами

теории вероятностей, а лишь те, которые могут быть

воспроизведены в одних и тех же условиях

Основной числовой характеристикой случайного события

является его вероятность.

Пример

Испытание – подбрасывание монеты; события – монета

упала «орлом» или «решкой».

Случайное событие – выпадение решки или орла.

Замечание Решка - лицевая сторона монеты (аверс),

орел - обратная сторона монеты (реверс).

Пример

Игральная кость - маленький кубик, грани которого

помечены цифрами 1,2,3,4,5,6 или точками.

Бросание игральной кости - выпадение цифр 1,2,3,4,5,6.

Пусть производится серия из n испытаний, в каждом из

которых может появиться или не появиться событие A . Если в

результате испытания наблюдалось (появилось) событие A , то

такой исход испытания называется благоприятным исходом.

Определение Элементарное событие – событие или

каждый отдельный возможный результат испытания.

Определение Набор элементарных событий - набор

всех возможных отдельных результатов испытаний.

11

Парадокс игры в кости

Правильная игральная кость при бросании с равными

шансами падает на любую из граней 1, 2, 3, 4, 5, 6.

В случае бросания двух костей сумма выпавших чисел

заключена между 2 и 12.

Как 9, так и 10 из чисел 1, 2, ..., 6 можно получить двумя

разными способами: 9=3+6= или 9=4+5 и 10=4+6 или 10=5+5.

Почему 9 появляется чаще, когда бросают две кости, а 10 когда бросают три?

Решение

В случае двух костей 9 и 10 могут получиться следующим

образом:

=3+6, или 9=6+3, или 9=4+5, или =5+4

10=4+6, или 10=6+4, или 10=5+5.

Это значит, что при двух костях 9 можно "выбросить"

четырьмя способами, а 10 - лишь тремя.

Следовательно, здесь шансы получить 9 предпочтительней.

В

случае

трех

костей

ситуация

меняется

на

противоположную:

9 можно "выбросить" 25 способами,

а 10 - уже 26 способами.

Потому 10 получается чаще, чем 9.

(Проверьте!!!)

Определение Генератор случайных чисел - устройство

для получения наборов случайных чисел.

Различают три типа генераторов:

урны,

кости,

рулетки.

Замечание Ящик с шарами представляет собой одну из

разновидностей урн

Теория вероятностей как наука раскрывает объективные

закономерности, присущие массовым явлениям.

Методы не дают возможности предсказать исход отдельного

случайного явления, но позволяют предсказать средний

суммарный результат массы однородных случайных явлений

12

Классификация событий

Различные события различают по степени возможности их

проявления и бывают взаимно связаны.

Типы событий:

случайное,

достоверное,

невозможное.

Определение Достоверное событие – событие, которое

в результате опыта обязательно должно произойти.

Пример

Выпадение не менее одного очка при бросании

игральной кости,

отказ радиоэлемента при работе долгого времени,

появление непрерывно действующей помехи в

некотором заданном интервале времени.

Определение Невозможное событие – событие, которое

не может иметь место в данном опыте.

Пример

Выпадение более 6 очков при бросании игральной

кости,

появление напряжения, большего порога ограничения,

на выходе ограничителя.

В партии все изделия стандартны, извлечение из нее

стандартного изделия – событие достоверное.

Если событие в данном опыте невозможно, то говорят, что

вероятность его равна P( A) 0 , если достоверно, т.е.

обязательно должно появиться, то его вероятность равна

P( A) 1 .Чем ближе вероятность события к 1, тем больше

объективная возможность появления его в опыте.

Определение Два или несколько событий называются

равновозможными, если нет оснований утверждать, что одно из

них имеет больше данных появиться в итоге опыта по

сравнению с другими.

Равновозможность исходов – основная гипотеза

классической теории вероятностей.

13

Пример

Выпадение герба и цифры при однократном бросании

монеты,

выход из строя любой из радиоламп, работающих в

одинаковых условиях

извлечение туза, валета, короля или дамы из колоды

карт.

По характеру совместной связи события подразделяются на

совместные и несовместные.

Определение События, называются несовместными,

если появление какого-нибудь одного из них в данном опыте

исключает возможность появления других.

Пример

Выпадение 3 и 5 вместе при однократном бросании монеты.

Определение События, называются совместными, если

появление одного из них в данном опыте не исключает

возможность появления других.

Замечание События несовместны, если они не могут

произойти одновременно в одном и том же опыте.

Пример

Выпадение 3 и 5 вместе при двукратном бросании монеты,

искажение различных знаков при передаче телеграмм.

Получение студентом на экзамене по одной дисциплине

оценок «5», «4»,»3» – события несовместные, а получение тех

же оценок на экзамене по трем дисциплинам – события

совместные.

Определение Полная группа событий – группа событий,

сумма которых есть достоверное событие

Замечание Полная группа событий -группа

событий, из которых хотя бы одно непременно должно

произойти в данном опыте.

Пример

Попадание и непопадание в мишень при выстреле,

выпадение 1,2,3,4,5,6 при бросании кости.

Подавление и неподавление радиоимпульса помехой,

искажение и неискажение какого-либо знака при

передаче,

14

Определение Вероятность события – численная мера,

принимающая значения между 0 и 1 и характеризующая степень

возможности

появления

события

в

данном

опыте.

Обозначается: P( A) , где А - случайное событие.

Обозначение P происходит от первой буквы французского

слова probabilite – вероятность.

Замечание Этим определением предполагается, что все

элементарные события равновероятны (не всегда можно

определить

равновероятность

наступления

отдельных

элементарных событий).

Пример

Какова вероятность выпадения четного числа очков при

бросании кости P( A)

3 1

6 2

Определение Противоположные события - два

единственно возможных и несовместных события, для которых

справедливо, что А наступает, когда не наступает А и наоборот.

q( A) 1 P( A)

Замечание Противоположные события – частный случай

событий, образующих полную группу.

Классическое определение вероятности

Классическое определение вероятности дал еще Лаплас, но

тогда ее приложение не выходило за сферу азартных игр.

Пьер-Симон Лаплас (1749

1827) — французский

математик; один из создателей теории вероятностей.

Классическое определение вероятности несовершенно и

имеет много недостатков.

применимо лишь в тех случаях, когда число

элементарных событий конечно, но на практике не всегда имеет

место;

предполагается, что все элементарные события

равновероятны (не всегда можно определить равновероятность

наступления отдельных элементарных событий).

15

Определение (классическое по Лапласу определение)

Вероятность случайного события А - число элементарных

событий, благоприятствующих появлению события

А,

деленному на все число элементов в наборе элементарных

событий.

P A

m

,

n

0 P( A) 1

Пример

Какова вероятность выпадения четного числа очков при

бросании кости

Решение

n 6 , m 3 , P A

3 1

6 2

Пример

Петя забыл последнюю цифру номера телефона знакомой и

набрал ее наугад.

Какова вероятность того, что он поговорит с ней по

телефону?

Решение

n 10 , m 1 , P A

1

10

Пример

Буквы

образующие

слова

«Теория

вероятностей»

перемешаны и наугад извлекается

одна буква. Найти

вероятность того, что эта буква гласная

Решение

Общее число исходов n 18 (число букв в словах). Число

благоприятствующих исходов m 9

P A

16

m 9 1

n 18 2

Ошибка Даламбера

Классическое определение вероятности справедлива только в

случае с равновозможными исходами. Пренебрежение этим

требованием приводит к ошибкам при решении простых

вероятностных задач.

Рассмотрим знаменитую задачу о бросании обычной монеты,

связанную с именем знаменитого математика Ж.Даламбера.

Жан Лерон Д’Аламбер (1717 —1783) — французский

учѐный-энциклопедист. Широко известен как философ,

математик и механик, вошел в историю теории вероятностей со

своей знаменитой ошибкой, суть которой в том, что он неверно

определил равновозможность исходов в опыте всего с двумя

монетами!

Опыт. Подбрасываем две одинаковые монеты. Какова

вероятность того, что они упадут на одну и ту же сторону?

Решение Даламбера:

Опыт имеет три равновозможных исхода:

1) обе монеты упадут на «орла»;

2) обе монеты упадут на «решку»;

3) одна из монет упадет на «орла», другая на «решку».

Из них благоприятными будут два исхода.

n 3, m 2, P A

m 2

n 3

Правильное решение:

Опыт имеет четыре равновозможных исхода:

1) обе монеты упадут на «орла»;

2) обе монеты упадут на «решку»;

3) первая монета упадет на «орла», вторая на «решку»;

4) первая монета упадет на «решку», вторая на «орла».

Из них благоприятными будут два исхода.

n 4, m 2, P A

m 2 1

n 4 2

Замечание Классическое определение вероятности с 17

до 19 века было как определение, в настоящее время

17

определение не дается, а используют понятие относительной

частоты события.

Замечание События, вероятности которых малы или

очень велики, называются практически невозможными или

практически достоверны.

Контрольные вопросы

1. Что изучает теория вероятностей?

2. Кто основатель теории вероятностей как строгой

математической дисциплины?

3. Основная числовая характеристика случайного события.

4. Как определяются случайное, достоверное и

невозможное события?

5. В чем недостатки классического определения

вероятностей?

6. Как подразделяются события по характеру совместной

связи ?

7. Классификация событий по степени возможности их

проявления

8. Что такое генератор случайный чисел?

9. Приведите классификацию генераторов случайных

чисел.

10. Приведите примеры полной группы событий.

11. С какой вероятностью монета, брошенная дважды, по

крайней мере один раз выпадет гербом?

12. Докажите, что события A, B, A B образуют полную

группу.

18

Элементы комбинаторики

Комбинаторика как раздел математики появилась в трудах

Блеза Паскаля и Ферма по теории азартных игр. Эти труды,

составив основу теории вероятностей, одновременно содержали

принципы нахождения числа комбинаций элементов данного

конечного множества.

С появлением работы Лейбница и Бернулли «Искусство

предположений»

посвященной

теории

вероятностей

комбинаторные схемы выделились в отдельную часть

математики.

Возрождение интересов к комбинаторике относится к 50

годам ХХ века. Этот интерес связан с развитием кибернетики.

Большой развивающийся раздел комбинаторики это теория

блок-схем. Основные проблемы этого раздела связаны с

вопросами классификации, условиями существования и

методами построения некоторых классов блок-схем.

Определение Комбинаторика - раздел математики,

изучающий комбинации конечных множеств элементов

различной природы.

Предположим вначале, что все элементы рассматриваемых

множеств различны и будем изучать комбинации этих элементов

различающихся

количеством

и/или

порядком.

Будем

рассматривать такие множества, в которых каждый элемент

входит не более одного раза. Такие соединения называются без

повторений.

Предположим, что требуется подсчитать количество

комбинаций из конечного числа элементов. Предположим, что

построение

этой

комбинации

мы

разбили

на

k

последовательных шагов, причем первой шаг можно

осуществить b1 вариантами, независимо от результата действия

на первом шаге 2-й шаг можно реализовать одним из

b2 вариантов; независимо от результатов первых двух шагов

третий шаг можно осуществить b3 способами и т.д.; наконец,

19

независимо от решений принятых на предыдущих шагах

имеется bk возможноcтей осуществить k -й шаг.

Тогда общее количество комбинаций равно произведению

b1 b2 b3 bk .

Пример.

Найти

число

делителей

числа

64800 25 52 34 .

Решение

Общий вид делителя исходного числа: 2a3b5c . В состав

делителя

"2"

-можно

включить

6-ю

вариантами

a 0,1,2,3,4,5 ,"5" -3-мя способами b 0,1,2 ,"3" - 5-ю

споcобами c 0,1,2,3,4 .

В силу независимости включения каждой цифры 2, 5 и 3

общее число делителей равно 6 3 5 90 .

При вычислении вероятности приходится использовать

формулы комбинаторики. Рассмотрим основные.

Определение Размещения из n по m - соединения,

различающиеся самими элементами или их порядком.

Anm

n!

n m !

Пример

Расписание состоят из 4 пар. Определить число вариантов

расписания при выборе из 11 предметов.

Решение

Каждый вариант расписания

представляет набор

4

дисциплин из 11, отличающийся от других вариантов как

составом дисциплин, так и порядком их следования. Т.е.

размещение из 11 по 4.

4

A 11

11!

8 9 10 11 7920

7!

Пример

На четырех карточках написаны цифры 1,2,3,4. Карточки

перевернули

и

перемешали.

Затем

открыли

наугад

последовательно три карточки и положили в ряд. Какова

вероятность того, что в результате получилось: число 123.

20

Решение

Исходами опыта являются все возможные размещения

четырех карточек на трех местах (порядок расположения важен).

Общее число исходов:

n A

4!

2 3 4 24

4 3!

.

Рассмотрим события и их вероятности:

Событие А={из трех карточек образовано число 123},

P A

m 1

n 24 .

Пример Пусть даны шесть цифр: 1;2;3;4;5;6. Определить

сколько трехзначных чисел можно составить из этих цифр.

Решение

Если цифры могут повторяться, то количество трехзначных

чисел будет m n k 6 3 216 .

Если цифры не повторяются, то

m A63 6 5 4 120 .

Определение Перестановками из n элементов называются соединения, различающиеся только порядком

входящих в них элементов.

Pn Ann n!

Замечание Перестановки комбинации, отличающиеся

порядком, но не составом входящих элементов.

Пример

Порядок выступления определяется жеребьевкой. 7

участников. Сколько вариантов возможно.

Решение

Каждый вариант жеребьевки отличается порядком

участников конкурса, т.е. перестановка из 7 элементов.

P7 7! 5040

Пример

На четырех карточках написаны буквы О, Т, К, Р. Карточки

перевернули и перемешали.

21

Затем открыли наугад последовательно эти карточки и

положили в ряд. Какова вероятность того, что получится слово

«КРОТ»?

Решение

Исходы – все возможные перестановки из четырех элементов

(О, Т, К, Р); общее число исходов:

n P 4! 24, m 1 ,

Событие А = {после открытия карточек получится слово

«КРОТ»}:

P A

m 1

n 24

Замечание В комбинаторике факториал натурального

числа

интерпретируется как количество

n ! 1 2 3 n

перестановок множества из n элементов.

Например, для множества {A,B,C,D} из 4-х элементов

существует 4!=24 перестановок

Определение Сочетаниями из n элементов по m называются соединения, различающиеся только своими

элементами

n!

С nm

m! n m !

Сочетания (выборки) из n по m различных элементов

комбинации, отличающиеся лишь составом входящих

элементов.

Замечание Число различных сочетаний (выборок) из n

по m элементов C nm - число способов, которыми можно

выбрать из n группу по m элементов (порядок выбора

безразличен).

Свойства сочетаний

1. 0!=1

22

2.

Сn0 1

3.

Сnm Cnn m

4.

Сnm Cnm11 Сnm11

Замечание Числа Сn называют так же биномиальными

коэффициентами по причине использования их в формуле

разложения бинома Ньютона.

m

x y

n

n

Cnm x m y n m

m0

Пример

В ящике лежат 1 белый и три черных шара.

Наугад вынимаются 2 шара.

Какова вероятность того, что вынуты:

1) 2 черных шара; 2) белый и черный шар?

Решение

Исходы – все возможные пары шаров. Общее число исходов

C 42

4!

3 4

6

2!4 2 ! 1 2

1) Событие А={вынуты два черных шара};

m C32

3!

m 3 1

3; P A

2!1!

n 6 2

2) Событие В={вынуты белый и черный шары};

m C31 1 3 3, PB

m 3 1

n 6 2

Пример

Из урны, в которой K белых и N K чѐрных шаров,

наудачу и без возвращения вынимают n шаров, n N .

Термин «наудачу» означает, что появление любого набора из

шаров равновозможно. Найти вероятность того, что будет

выбрано k белых и n k чѐрных шаров.

Решение

C Kk C Nn kK

P A

C Nn

23

Формула Стирлинга

Формула Стирлинга дает приближенное выражение

произведения n первых натуральных чисел (факториала):

n ! 1 2 3 n , когда число n сомножителей велико, получена

Джеймсом. Стирлингом.

Джеймс. Стирлинг(1692-1770) шотландский математик.

Труды по теории рядов и исчислению конечных разностей,

рассмотрел бесконечные произведения.

По определению полагают 0! 1 .

Факториал определѐн только для целых неотрицательных

чисел. Эта функция часто используется в комбинаторике, теории

чисел и функциональном анализе.

Формула Стирлинга

n ! nn e n 2 n

Приближенное равенство носит асимптотический характер,

т.е. уточняется с ростом n .

Для

краткости

удовлетворимся

правдоподобным

рассуждением (не выдавая его однако за строгое

доказательство), но удобное для запоминания.

По определению факториал

n ! 1 2 3 n

Заменим n! произведением такого ж количества одинаковых

сомножителей: n! x x x x x n ,где x - своего рода "среднее

факториальное" первых n натуральных чисел. Оно разумеется

растет вместе с n .

Сделаем простейшее предположение, что при больших n это

среднее факториальное приблизительно пропорционально n :

x

n

,

a

где a - почти постоянная величина.

n

n

n!~

a

и характерное тождество для факториала

Тогда

24

n 1 ! n 1 n !

запишется в виде

n 1

a

n 1

n

n

n 1 .

a

n

1

Поскольку известно, что 1 e при n так, что

n

n

среднее факториальное близко к .

e

Ясно, что формула Стирлинга приближенная и нужна

поправка, учитывающая не постоянство a при малых n .

Поправка 2 n t n эта зависит от n , но далеко не так сильно

как сам факториал,

пределах 0 t n

2 n t n , величина t n заключена в

1

.

12n

25

Лекция 2

Геометрическая вероятность

Паскаль впервые употребил слово вероятность. Он был

математик, философ, писатель, физик (1623-1662). В письме к

Ферма он писал:

«Я буду пользоваться термином вероятность для

обозначения числа, обозначающего степень уверенности».

Одним

из

недостатков

классического определения

вероятности, ограничивающим его применение, является то, что

оно предполагает конечное число возможных исходов

испытания.

Этот недостаток преодолен в классическом геометрическом

определении вероятности, т.е. находя вероятность попадания

точки в некоторую область (отрезок, часть плоскости и т.д.)

Пусть плоская фигура g составляет часть плоской фигуры G .

На фигуру G наудачу бросается точка.

Это означает, что все точки области G «равноправны» в

отношении попадания туда брошенной случайной точки. Фигуру

g называют благоприятствующей событию A .

Sg

P A

SG

Геометрическая вероятность имеет различное значение в

зависимости от определения элементарных событий и от метода

отбора в случайном порядке.

Имеется отрезок ОА. Разделим его пополам в точке В и

найдем вероятность того, что точка отрезка ОА, выбранная в

случайном порядке находится на ОВ.

Р

длинаОВ 1

ДлинаОА 2

на практике может быть меры длины, площади, объемы.

26

Область,

на

которую

распространятся

понятие

геометрической вероятности, может быть одномерной (прямая,

отрезок), двумерной и трехмерной.

Пример В некоторой ограниченной области случайно

выбирается точка. Какова вероятность, что точка попадет в

область А? На прямую L?

Решение

S A

P A

L

S Ω

A

0

S ( L) 0 ; PL

0

S

Ω

Ω

Область, на которую распространятся

понятие геометрической вероятности, может быть одномерной

(прямая, отрезок), двумерной и трехмерной.

Определение Геометрическая вероятность события A

- отношение меры области, благоприятствующей появлению

события A к мере всей области

P A

mes g

mesG

Пример В квадрат со стороной 4см «бросают» точку.

Какова вероятность, что расстояние от

этой точки до ближайшей стороны

квадрата будет меньше 1 см?

Решение

Закрасим в квадрате множество

точек, удаленных от ближайшей стороны

меньше,

чем

на

1см.

Площадь

закрашенной части квадрата

16см 2 4см 2 12см 2 . Значит, P A

12 3

0.75

16 4

Обобщением классического определения вероятности на

случайный эксперимент с бесконечным числом равновозможных

случайных

исходов,

изображаемых

точками,

прямой,

плоскостью, пространством и т.д. служит геометрическое

определение вероятности. Пример Два лица A и B условились

27

встретиться в определенном месте между 11 и 12 ч. и ждать друг

друга 30 мин. Если партнер к этому времени не пришел или уже

ушел встреча не состоится. Найти вероятность того, что встреча

состоится.

Решение

Обозначим моменты прихода в определенное место лиц A и

B - соответственно через x и y .

За начало отсчета возьмем 11 ч., а за единицу измерения 1 ч.

По условию 0 x 1 , 0 y 1 . Это квадрат со стороной 1.

Событие C - встреча двух лиц произойдет, если разность

между x и y не превзойдет 0.5 ч, т.е. y x 0.5 .

PC

1 2 1 / 2 0.52

0.75

12

( площадь области g равна площади квадрата G без суммы

площадей двух угловых треугольников).

Статическая вероятность

Недостатком классического определения вероятности

является то, что не всегда удается узнать, являются исходы

испытания равновозможными или не являются. Число

равновозможных исходов конечно. Результат испытаний не

всегда можно представить в виде совокупности элементарных

событий. Введем понятие статической вероятности.

Если производить многократно повторение одного и того же

опыта, то относительное число появлений данного события во

всей серии опытов, или частота его появления, будет близка к

значению его вероятности. Оказывается, что при большом числе

испытаний n, относительная частота появления события А в

различных сериях отличается друг от друга мало и это отличие

тем меньше, чем больше испытаний в сериях.

Пример

28

Выпадение герба. При небольшом количестве опытов

относительное число появлений герба будет отличаться от 0.5,

но если увеличить число до несколько десятков тысяч, то

небольшие отклонения не могут оказать влияния на общий

результат.

Такие опыты проводились Бюффоном (Франция), и

Пирсоном (Англия), при этом получены следующие результаты.

Число бросаний

4040

12000

24000

Частота появления герба

0,50693

0,5016

0,5005

Французский естествоиспытатель Бюффон (XVIII в.) бросил

монету 4040 раз, и при этом герб выпал в 2048 случаях.

Следовательно, частота выпадения герба в данной серии

испытаний равна

2048

0,50693

4040

Английский математик Карл Пирсон (1857-1936) бросал

монету 24000 раз, причем герб выпал 12012 раз.

Следовательно, частота выпадения герба в данной серии

испытаний равна:

12012

0,5005

24000

Расхождение с математической вероятностью в четвертом

знаке после запятой. Это закон больших чисел.

Определение Абсолютной частотой случайного

события A в серии из N случайных опытов называется число

N A , которое показывает, сколько раз в этой серии произошло

событие A .

Определение Относительной частотой случайного

события называют отношение числа появлений этого события к

общему числу проведенных экспериментов:

29

W A

NA

N

где A – случайное событие по отношению к некоторому

испытанию, N - раз проведено испытание и при этом событие

A наступило в N A случаях.

Замечено,

что

будучи

числом

неотрицательным,

относительная частота обладает определенной устойчивостью,

то есть ее значение изменяясь, колеблется около некоторого

неотрицательного числа, к которому она стремится при n→ ∞,

(неограниченном возрастании числа испытаний).

Определение

При

статистическом

определении

вероятностью события называют относительную частоту

события при большом числе испытаний или число близкое к

ней:

P( A) lim W ( A) .

n

P A выражает количественную меру

Вероятность

появления события в данных сериях испытаний.

Пример

Наблюдения показывают, что в среднем среди 1000

новорожденных детей 515 мальчиков. Какова частота рождения

мальчика в такой серии наблюдений?

Решение

W A

515

0.515

1000

Пример

Демографы утверждают, что вероятность рождения

близнецов равна 0,012. В скольких случаях из 10 000

рождений можно ожидать появление близнецов?

Решение

P( A) 0.012, N 10000

N

P( A) A 0.012 , N 0.012 10000 120

N

Ответ в 120 случаях можно ожидать появление близнецов.

30

Пример

За лето на Черноморском побережье было 67 солнечных

дней. Какова частота солнечных дней на побережье за лето?

Частота пасмурных дней?

Решение

1.

W A

67

0.728

92

побережье за лето, W B

частота

солнечных

дней

на

25

0.272 - частота пасмурных

92

дней.

Условная вероятность

Пусть имеем два последовательных случайных событий, то

какова вероятность наступления второго события, если первое

событие уже произошло.

Пример

Пусть в урне было 5 шаров, (2 белых+ 3 черных).

Найти вероятность извлечь белый шар во втором испытании.

Решение

После извлечения первого шара в ней останется 4 шара

и один белый в их числе (если извлекли белый)

или 2 белых ( если в первый раз извлечен не белый шар).

В первом случае вероятность извлечь белый шар во второй

раз будет

1

1

, во втором .

4

2

Таким образом вероятность извлечь белый шар во втором

испытании зависит от результата первого испытания.

Понятия условной вероятности и независимости введены

А.Муавром в 1718 г. Абрахам де Муавр (1667 -1754) —

английский математик французского происхождения. Провѐл

вероятностное исследование азартных игр.

Определение Условная вероятность- вероятность

одного события, вычисленная в предположении, что другое

событие произошло.

31

Вероятность события A1 в предположении, что произошло

событие A 2 обозначаем P A1 / A2

Определение Два события называются независимыми,

если вероятность появления каждого из них не зависит от того,

имели ли место другие.

Определение Два события называются зависимыми,

если появление одного из них влияет на вероятность

наступления другого

Если P A1 / A2 P A1 , то говорят, что A1 независимо от

A 2 , т.к. его вероятность не зависит от того, произошло ли

событие A 2 или нет.

Аналогично, если P A2 / A1 P A2 , то говорят, что A 2

независимо от A1

Независимость двух событий – свойство симметричное.

Пример

A – извлечение из колоды туза, B – то, что и вторая

вынутая из колоды карта туз. Тогда, если после первого раза

карта была возвращена в колоду, то вероятность вынуть

вторично туз не меняется:

PB P A

4 1

0.125

32 8

Если же первая карта в колоду не возвращается, то

осуществление события A приводит к тому, что в колоде

осталась 31 карта, из которых только 3 туза.

Поэтому

B 3

P

0.097 .

A 31

Пример К экзамену надо подготовить 25 вопросов.

Студент пришел на экзамен, зная 20. Какова вероятность

того, что студент ответит на все три вопроса билета?

Решение

Пусть события: A – студент знает первый вопрос;

32

B – студент знает второй вопрос;

C – студент знает третий вопрос.

Тогда нужная вероятность будет

20 19 18 57

B

.

P ABC P AP PC. AB

25 24 23 115

A

Парадокс Монти Холла

Задача формулируется как

описание гипотетической игры,

основанной на американском

телешоу «Let’s Make a Deal», и

названа в честь ведущего этой

передачи.

Вы стали участником игры, в

которой нужно выбрать одну из трех дверей. За одной из дверей

находится автомобиль, за двумя другими дверями — козы.

Вы выбираете одну из дверей, например, номер 1, после

этого ведущий, который знает, где находится автомобиль, а

где — козы, открывает одну из оставшихся дверей, например,

номер 3, за которой находится коза.

Вопрос: не желаете ли вы изменить свой выбор и выбрать

дверь номер 2.

Увеличатся ли ваши шансы выиграть автомобиль, если вы

примете предложение ведущего и измените свой выбор?

Решение

Построим дерево принятия решений.

33

Когда игрок сначала выбрал дверь, за которой находится

коза, изменение выбора приводит к выигрышу.

В двух последних случаях, когда игрок сначала выбрал дверь

с автомобилем, изменение выбора приводит к проигрышу.

Суммарная вероятность того, что изменение выбора

приведѐт к выигрышу, эквивалентна сумме вероятностей первых

двух исходов, то есть

1 1 2

.

3 3 3

Соответственно, вероятность того, что отказ от изменения

выбора приведѐт к выигрышу, равна

1 1 1

6 6 3

Вывод Изменение первоначального выбора приводит к

выигрышу в двух случаях из трѐх в среднем!!!!

Контрольные вопросы

2.

Дайте статическое определение вероятности.

3.

В чем отличие от классического определения

вероятности

В чем разница абсолютной и относительной частоты?

34

Задачи для самостоятельно решения

1. В ящике имеется 50 одинаковых деталей, из них 5

окрашенных. Наудачу вынимают одну деталь. Найти

вероятность того, что извлеченная деталь окажется окрашенной.

Отв. p 0.1 .

2. Брошена игральная кость. Найти вероятность того, что

выйдет четное число очков. Отв. p 0.5 .

3. Участники жеребьевки тянут из ящика жетоны с номерами

от 1 до 100. Найти вероятность того, что номер первого, наудачу

извлеченного жетона, не "содержит цифры 5. Отв. p 0.81 .

4. В мешочке имеется 5 одинаковых кубиков. На всех гранях

каждого кубика написана одна из следующих букв: о, п, р, с, т.

Найти вероятность того, что на вынутых по одному из

расположенных «в одну линию» кубиках можно будет прочесть

слово «спорт». Отв. p

1

.

120

5. На каждой из шести одинаковых карточек напечатана одна

из следующих букв: а, т, м, р, с, о. Карточки тщательно

перемешаны, Найти вероятность того, что на четырех, вынутых

по одной и расположенных «в одну линию» карточках, можно

будет прочесть слово «трос» Отв. `p = 1/А_6^4=1/360.

6. Куб, все грани которого окрашены, распилен на тысячу

кубиков одинакового размера, которые затем тщательно

перемешаны. Найти вероятность того, что наудачу извлеченный

кубик будет иметь окрашенных граней: а) одну; б) две; в) три.

Отв. а) 0,384; б) 0,096; в) 0,008.

7. Из тщательно перемешанного полного набора 28 костей

домино наудачу извлечена кость. Найти вероятность того, что

вторую наудачу извлеченную кость можно приставить к первой,

если первая кость: а) оказалась дублем, б) не есть дубль. Отв. (а)

2

4

(б)

9

9

8. В замке на общей оси пять дисков, каждый из которых

разделен на шесть секторов с различными написанными на них

35

буквами. Замок открывается, только в том случае, если каждый

диск занимает одно определенное положение относительно

корпуса замка. Найти вероятность того, что при произвольной

установке дисков замок можно будет открыть Отв. `р =1/6^5`.

9. Восемь различных книг расставляются наудачу на одной

полке. Найти вероятность того, что две определенные книги

окажутся поставленными рядом. Отв. 0.25

10. Библиотечка состоит из десяти различных книг, причем

пять книг стоят по 4 рубля каждая, три книги — по одному

рублю и две книги — по 3 рубля Найти вероятность того, что

взятые наудачу две книги стоят 5 рублей. Отв. 5 /12 `

11. В партии из 100 детален отдел технического контроля

обнаружил 6 нестандартных деталей. Чему равна относительная

частота появления нестандартных деталей?Отв. w 0.06 .

12. При стрельбе из винтовки относительная частота

попадания в цель оказалась равной 0,85 Найти число попаданий,

если всего было произведено 120 выстрелов. Отв. 102

попадания.

36

Лекция 3

Алгебра событий - сумма двух событий

Определение Суммой двух событий A1 и A2 называется событие, состоящее в появлении хотя бы одного из

этих событий.

A A1 A2

Теорема Вероятность суммы двух

событий равняется сумме их вероятностей.

несовместных

P A1 A2 P A1 P A2

Если события A1 и A2 взаимно не исключают друг друга, то

теорема будет другая.

Заметим, что сформулированная теорема справедлива для

любого числа несовместных событий:

n

n

P A i P A i

i 1 i 1

Следствие теоремы сложения Сумма вероятностей

полной группы несовместимых событий равна единице.

Доказательство

Пусть несовместимые события A, B, C , , N - образуют

полную группу событий, следовательно они единственно

возможные и несовместные.

При испытании хотя бы одно их этих событий появится, т.к.

оно достоверно

P A 1 или РB 1 или Р N 1

но события по условию являются несовместимыми и

следовательно, на основании теоремы сложения что и т.д.

Алгебра событий – произведение двух событий

Определение Произведением нескольких событий

называется событие, состоящие в совместном наступлении всех

этих

событий в результате испытания. Обозначают

A B, A B, A и B

37

Замечание Произведение означает союз «и» (АВС, это

означает, что наступило событие A и B и C ).

Пример A – «из колоды карт вынута дама», B – «из

колоды карт вынута карта пиковой масти». A B означает

«вынута дама пик».

Пример A – « число выпавших очков < 5», B – «число

выпавших очков > 2», C – «число выпавших очков четное».

Тогда A B C – «выпало 4 очка».

Теорема Вероятность суммы двух совместных событий

равняется сумме их вероятностей, уменьшенная на вероятность

произведения этих событий.

P A1 A2 P A1 P A2 P A1 A2

Теорема

Вероятность

произведения

взаимно

независимых событий равна произведению их вероятностей.

P A1 A2 P A1 P A2 .

Теорема Вероятность произведения зависимых событий

равна произведению вероятности одного события на условную

вероятность другого события, вычисленную в предположении,

что первое случайное событие уже произошло

P A 1 A 2 P A 1 P A 2 P A 1 A 2

Свойства операций сложения и умножения

1.

2.

3.

4.

5.

38

A B B A коммутативность сложения.

A B C A B C - ассоциативность сложения.

A B B A коммутативность умножения.

A B C A B C ассоциативность умножения

A B C A B A C закон дистрибутивности.

Вероятность появления хотя бы одного из событий

Теорема Вероятность появления хотя бы одного из

событий A1 , A 2 , , A n , независимых в совокупности, равна

разности между единицей и произведением вероятностей

противоположных событий

P A 1 P A1 P A 2 P A n 1 q1 q2 qn

Следствие. При производимых

n одинаковых

независимых испытаниях, в каждом из которых события A

появляется с вероятностью p , вероятность появления

события A хотя бы один раз равна

P A 1 1 p n

Пример В урне 30 шаров: 10 красных, 5 синих и 15

белых. Найти вероятность появления цветного шара.

Решение

Появление цветного шара означает появление либо красного,

либо синего шара. Вероятность появления красного шара

(событие A )

P A

10 1

30 3

Вероятность появления синего шара (событие B )

P B

5 1

30 6

События A и B несовместны (появление шара одного цвета

исключает появление шара другого цвета), поэтому теорема

сложения применима. Искомая вероятность

P A B P A P B

1 1 1

3 6 2

Пример На стеллаже в библиотеке стоит 15 учебников,

причем 5 из них в переплете. Библиотекарь берет три учебника.

Найти вероятность того, что хотя бы один из взятых учебников

окажется в переплете.

Решение

39

Первый способ. Пусть события A – хотя бы один учебник в

переплете; B – один из взятых учебников в переплете, два – без

переплета; C – два в переплете, один без переплета; D – все

три учебника в переплете.

Очевидно, A B C D .

Найдем вероятности событий B , C , и D .

C 51C102

45 ,

3

C15

91

3

C

2 .

P( D ) 53

C15 91

P (C )

P( B )

Тогда

P( A) P( B ) P(C ) P( D )

C 52 C101

20 ,

3

C15

91

67 .

91

Второй способ. Вновь A – хотя бы один учебник в

переплете; A - ни один из взятых учебников не имеет переплета.

Так как события A и A противоположные, то

C103

24 67

.

P( A) 1 P( A) 1 3 1

C15

91 91

Пример Студент разыскивает нужную ему формулу в

трех справочниках. Вероятности того, что формула содержится в

первом, втором и третьем справочниках равны 0,6; 0,7 и 0,8.

Найти вероятности того, что формула содержится 1) только в

одном справочнике; 2) только в двух справочниках;

Решение

A – формула содержится в одномсправочнике;

B – формула содержится в двух справочниках;

Воспользуемся теоремами сложения и умножения

вероятностей.

P ABC ABC ABC P ABC P ABC P ABC

0,6 0,3 0,2 0,4 0,7 0,2 0,4 0,3 0,8 0,188

P ABC ABC ABC 0,6 0,7 0,2 0,6 0,3 0,8 0,4 0,7 0,8 0,452

40

Диаграммы Эйлера-Венна

Основные действия над событиями можно интерпретировать

с помощью диаграмм Венна.

Леонард Эйлер (1707-1783) — российский и швейцарский

математик, внѐсший значительный вклад в развитие теории

вероятностей и ряда прикладных наук. Эйлер — автор более чем

800 работ. Почти полжизни провѐл в России, где внѐс

существенный вклад в становление российской науки.

Диаграммы Венна- Эйлера используется в математике,

логике, менеджменте и других прикладных направлениях,

обычно изображается в виде кругов одинакового радиуса.

Особенного расцвета графические методы достигли в

сочинениях английского логика Джона Венна (1843—1923),

подробно изложившего их в книге «Символическая логика»,

изданной в Лондоне в 1881 году. Поэтому такие схемы иногда

называют диаграммы Эйлера — Венна. На диаграмме ЭйлераВенна сумму событий можно изобразить в виде кругов

(прямоугольник – изображение множества всех возможных

исходов опыта). Диаграммы Венна нашли применение в

современной логико-математической теории «формальных

нейронных сетей».

Диаграмма, иллюстрирующая

совместных событий.

сумму

Диаграмма,

иллюстрирующая

сумму несовместных событий

41

Диаграмма,

иллюстрирующая

сумму трех совместных событий.

A

B

C

Диаграмма,

произведение

событий.

42

иллюстрирующая

совместных

Принцип практической невозможности

При решении многих практических задач приходится иметь

дело с событиями, вероятность которых весьма мала, т. е. близка

к нулю.

Можно ли считать, что маловероятное событие A в

единичном испытании не произойдет? Такого заключения

сделать нельзя, так как не исключено, хотя и мало вероятно, что

событие A наступит.

Казалось бы, появление или не появление маловероятного

события в единичном испытании предсказать невозможно.

Однако длительный опыт показывает, что маловероятное

событие в единичном испытании в подавляющем большинстве

случаев не наступает.

На основании этого факта принимают следующий «принцип

практической невозможности маловероятных событий»:

если случайное событие имеет очень малую вероятность, то

практически можно считать, что в единичном испытании это

событие не наступит.

Естественно возникает вопрос: насколько малой должна

быть вероятность события, чтобы можно было считать

невозможным его появление в одном испытании?

На этот вопрос нельзя ответить однозначно. Для задач,

различных по существу, ответы будут разными.

Например, если вероятность того, что парашют при прыжке

не раскроется, равна 0,01, то было бы недопустимым применять

такие парашюты. Если же вероятность того, что поезд дальнего

следования прибудет с опозданием, равна 0,01, то можно

практически быть уверенным, что поезд прибудет вовремя.

Определение Достаточно малую вероятность, при

которой событие можно считать практически невозможным,

называют уровнем значимости. На практике обычно принимают

уровни значимости, заключенные между 0,01 и 0,05.

Уровень

значимости,

равный

0,01,

называют

однопроцентным; уровень значимости, равный 0,02, называют

двухпроцентным и т. д.

43

Подчеркнем, что рассмотренный здесь принцип позволяет

делать предсказания не только о событиях, имеющих малую

вероятность, но и о событиях, вероятность которых близка к

единице.

Действительно, если событие A имеет вероятность близкую

к нулю, то вероятность противоположного события близка к

единице. С другой стороны, не появление события A означает

наступление противоположного события A .

Таким образом, из принципа невозможности маловероятных

событии вытекает следующее важное для приложении

следствие: если случайное событие имеет вероятность очень

близкую к единице, то практически можно считать, что в

единичном испытании это событие наступит.

Разумеется, и здесь ответ на вопрос о том, какую

вероятность считать близкой к единице, зависит от существа

задачи.

Контрольные вопросы

1. Что относится к основным понятиям теории

вероятностей?

2. Назовите действия над событиями.

3. Виды случайных событий.

4. Дайте классическое определение вероятности.

5. Дайте статистическое определение вероятности.

6. Чему равна вероятность суммы двух несовместных

событий?

7. Дайте определение произведения двух событий

8. Как определяется вероятность появления хотя бы одного

события

9. Как определяется условная вероятность?

10. Сформулируйте теорему совместного появления двух

событий.

11. Приведите формулу для вычисления вероятностей

совместных событий.

44

Следствием двух основных теорем теории вероятностей –

теоремы сложения и умножения – являются формула полной

вероятности и формула Бейеса.

Формула Байеса, дает возможность оценить вероятность

событий эмпирическим путѐм, играет важную роль в

современной математической статистике и теории вероятностей.

Томас Байес (Бейес, Reverend Thomas Bayes]) (1702 —1761)

— английский математик. Математические интересы Байеса

относились к теории вероятностей. Он сформулировал и решил

одну из основных задач этого раздела математики (теорема

Байеса). Работа, посвящѐнная этой задаче, была опубликована в

1763 году, уже после его смерти. Формула Байеса — одна из

основных теорем элементарной теории вероятностей, которая

определяет вероятность того, что произошло какое-либо

событие (гипотеза), имея на руках лишь косвенные тому

подтверждения (данные), которые могут быть неточны. Названа

в честь ее автора, преп. Томаса Байеса (посвященная ей работа

впервые опубликована в 1763 году, уже после его смерти).

Полученную по формуле вероятность можно далее уточнять,

принимая во внимание данные новых наблюдений.

Изучение какого-либо объекта исследователь начинает с

предположений ( версии, гипотезы).Например: экзаменатор,

предлагающий студенту билет, выдвигает гипотезы, что студент

учил материал и т.д.

Определение Гипотезы Н1, Н 2 , Н s - события, в

условиях которых только и может появиться событие A ,

обозначим Н1, Н 2 , Н s

Вычисляя

вероятность

выдвигаем

различные

A

предположения (гипотезы) относительно обстоятельств,

которые могут привести к событию A .

Определение Априорные гипотезы – гипотезы,

полученные до предстоящего опыта, апостериорные - после.

Формула Бейеса

45

После выдвижения гипотезы исследователь ставит опыты,

результат опыта фиксируют. На их основании надо высказать

новое мнение о первоначальной гипотезе. Какая из них

подтвердилась, какая нет. Стоит ли продолжать опыты? Как

долго?

Томас Бейес изложил свой подход к решению таких задач.

Томас Бейес (1702-1761) – английский математик, был

священником.

Его формула позволяет эмпирически оценить вероятность

события, работа была опубликована после его смерти. Она

применяется, когда событие А , которое может появиться только

с одной из гипотез A1, A2 An образующих полную группу

событий, произошло и необходимо произвести количественную

переоценку априорных вероятностей этих гипотез, т.е. найти

апостериорные условные вероятности .

Рассмотрим полную группу несовместных событий,

вероятности появления которых PH1 , PH 2 ,…, PH s .

Считаем, что они известны.

Событие А может наступить только вместе с каким-либо из

событий H1 , H 2 , H s

Вероятность появления события А по формуле полной

вероятности будет

P A P H1 P A H1 P H 2 P A H 2

P H s P A H s

Пусть событие А произошло, тогда это изменит вероятности

гипотез PH1 , PH 2 ,, PH s .

Тогда определим условные вероятности осуществления этих

гипотез в предположении, что событие А произошло, т.е

определим Р Н A , Р Н 2 A , Р Н s A

1

Тогда P A H1 PH1 P A H1 P A P H1 A

PH1 A

46

PH1 PA H1

P A

Или

P H i A

P H i P A H i

P A

Формула называется – формулой Бейеса

Значение формулы Бейеса состоит в том, что при

наступлении события А , т.е. по мере получения новой

информации, мы можем проверять и корректировать

выдвинутые до испытания гипотезы.

Такой подход называемый бейесовским, дает возможность

корректировать управленческие решения в экономике, оценки

неизвестных параметров распределения изучаемых признаков в

статистическом анализе.

Замечание Формула Бейеса предназначена для

вычисления апостериорных вероятностей гипотез после

проведения опыта с учетом полученной информации (событие

А уже произошло.

Замечание Психологические эксперименты показали,

что люди при оценках вероятности игнорируют различие

априорных вероятностей (ошибка базовой оценки), и потому

правильные результаты, получаемые по теореме Бейеса, могут

очень отличаться от ожидаемых.

Пример. После двух выстрелов двух стрелков,

вероятности попаданий которых равны 0,6 и 0,7, в мишени

оказалась одна пробоина. Найти вероятность того, что попал

первый стрелок.

Решение

Пусть событие А – одно попадание при двух выстрелах, а

гипотезы: H1 – первый попал, а второй промахнулся, H 2 –

первый промахнулся, а второй попал, H 3 – оба попали, H 4 –

оба промахнулись. Вероятности гипотез:

47

pH1 0,6 0,3 0,18 ,

pH 2 0,4 0,7 0,28 ,

, pH 4 0,4 0,3 0,12 .

Тогда

p H 3 0,6 0,7 0,42

A

A

A

A

p

p

1 , p

0 .

p

H1

H2

H4

H3

Следовательно, полная вероятность

p A 0,18 1 0,28 1 0,42 0 0,12 0 0,46 .

Применяя формулу Бейеса, получим:

Пример Студент подготовил к экзамену 20 билетов из

25. В каком случае шансы взять известный билет больше - когда

студент пришел на экзамен первым или вторым?

Решение

20 4

P1

25 5

Выбор 1-го

20

25

20

20

25

+

5

20

25

20

25

Найдем вероятность P2 взять известный билет, придя на экзамен

вторым, учитывая, что первый может взять как известный, так и

неизвестный второму билет.

P2

20 19 5 20 4

25 24 25 24 5

Пример Студент приходит в медпункт и жалуется на

плохое самочувствие. У медсестры две гипотезы H1 - он

действительно болен, H 2 - он здоров, но хочет получить

справку. По внешнему виду она оценивает априорные

48

вероятности PH1 0,3 , PH 2 0,7 и ставит ему градусник.

Измеренная температура 37.5 (событие А ).

A

0,9

P

H1

Предположим,

повышается

температура),

(не

при

A

0,05

P

H2

всякой

(у

болезни

некоторых

здоровых людей нормальная температура немного повышена

или студент мог незаметно натереть градусник).

Теперь апостериорная вероятность того, что студент болен:

0.3 0.9

H

P 1

0.885

A 0.3 0.9 0.7 0.05

и у медсестры есть все основания направить студента к

врачу.

Физический

смысл

и

терминология

формулы

Бейеса

Формула Бейеса позволяет «переставить причину и

следствие»: по известному факту события вычислить

вероятность того, что оно было вызвано данной причиной.

События, отражающие действие «причин», в данном случае

обычно называют гипотезами, так как они — предполагаемые

события, повлекшие данное.

Безусловную

вероятность

справедливости

гипотезы

называют априорной, а условную - с учетом факта

произошедшего события — апостериорной (насколько вероятна

причина оказалась с учетом данных о событии).

Можно также уточнять вероятность гипотезы, учитывая

другие имеющиеся данные (другие произошедшие события).

Для учета каждого следующего события нужно в качестве

априорной вероятности гипотезы подставлять ее апостериорную

вероятность с предыдущего шага.

Формулу Бейеса иногда называют формулой переоценки

гипотез. Она позволяет дать оценку вероятности гипотез после

49

того, как произошло событие. Томас Бейес формулу не выводил,

она названа в честь признания его работ по теории вероятностей.

Формула полной вероятности события

Важным следствием формулы Байеса является формула

полной вероятности события, зависящего от нескольких

несовместных гипотез (и только от них!).

Следствием двух основных теорем теории вероятностей –

теоремы сложения и умножения – являются формула полной

вероятности.

Теорема Полная вероятность события A равна сумме

произведений вероятностей гипотез на условные вероятности

события вычисленные соответственно при каждой из гипотез.

is

P A PH i PA H i

i 1

Доказательство

Пусть А - событие, вероятность которого надо вычислить.

Полагаем, что это события несовместимы, а их совокупность

охватывает всевозможные события, которые могут привести к

А , т.е. они образуют полную группу несовместимых событий.

Вероятности их обозначим P H 1 , P H 2 ,, P H s

На основании следствия из теоремы сложения

PH1 PH 2 PH s 1

Введем условные вероятности осуществления А при каждой

из гипотез P A H1 , P A H 2 ,, P A H s

Найдем полную вероятность события А

Событие А может наступить, если наступит событие

Вероятность наступления

умножения равна

H 1 и затем А

на основании теоремы

PH1 и A PH1 PA H1

50

H1 .

Но событие А может наступить, если наступит событие H 2 .

и т.д. Для определения полной вероятности события А

безразлично каким образом появится А

На основании теоремы сложения о несовместных событиях

получим

P A PH1 и A PH 2 и A PH s и A

Заменяя слагаемые их значениями, имеем

P A PH1 P A | H1 PH 2 P A | H 2

PH s P A | H s

is

Или

P A PH i PA H i .

i 1

Пример Имеются три одинаковые урны с шарами. В

первой из них 3 белых и 4 черных шара, во второй – 2 белых и 5

черных, в третьей – 10 черных шаров. Из случайно выбранной

урны наудачу вынут шар. Найти вероятность того, что он белый.

Решение

Будем считать гипотезами H1 , H 2 и H 3 выбор урны с

соответствующим номером. Так как по условию задачи все

гипотезы равновозможны, то

PH1 PH 2 PH 3

1

3

Найдем условную вероятность А при реализации каждой

гипотезы:

A

A 3

A 2

0 .

, P

, P

P

H

7

H

H

7

1

2

3

Тогда

1 3 1 2 1

P A 0 0.238 .

3 7 3 7 3