В.И. БУЛКИН ПРЕДСТАВЛЕНИЕ ЗНАНИЙ С ИСПОЛЬЗОВАНИЕМ НАПРАВЛЕННЫХ РЕЛЯЦИОННЫХ СЕТЕЙ Макеевский экономико-гуманитарный институт, Украина

advertisement

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

В.И. БУЛКИН

Макеевский экономико-гуманитарный институт, Украина

bulkin01@mail.ru

ПРЕДСТАВЛЕНИЕ ЗНАНИЙ С ИСПОЛЬЗОВАНИЕМ

НАПРАВЛЕННЫХ РЕЛЯЦИОННЫХ СЕТЕЙ

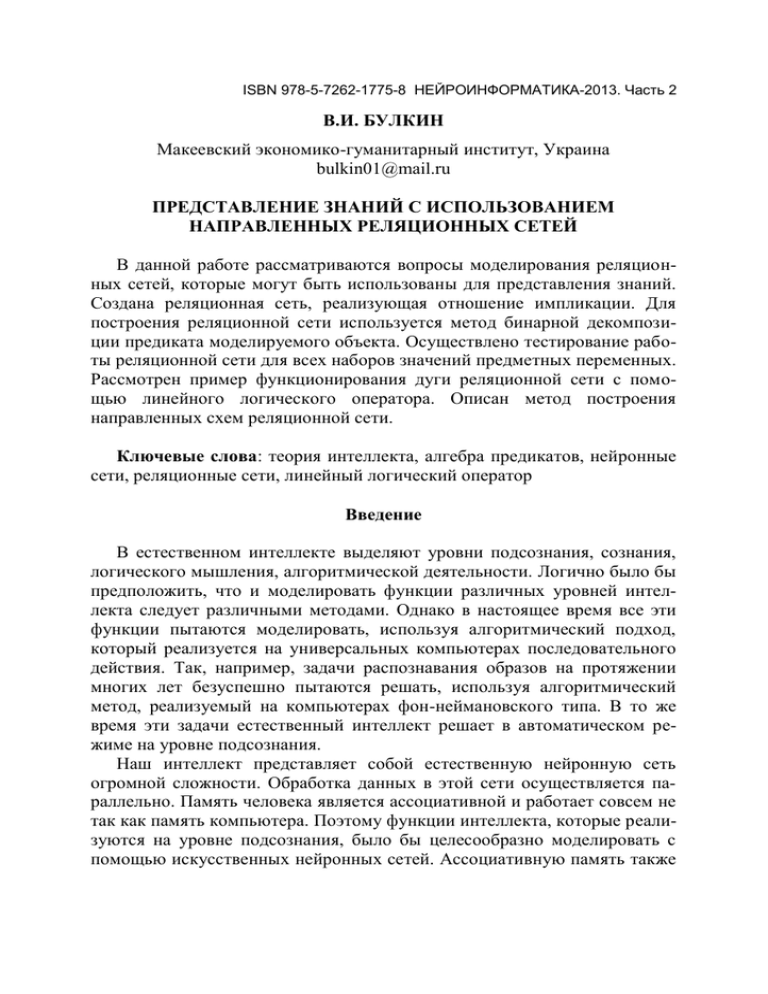

В данной работе рассматриваются вопросы моделирования реляционных сетей, которые могут быть использованы для представления знаний.

Создана реляционная сеть, реализующая отношение импликации. Для

построения реляционной сети используется метод бинарной декомпозиции предиката моделируемого объекта. Осуществлено тестирование работы реляционной сети для всех наборов значений предметных переменных.

Рассмотрен пример функционирования дуги реляционной сети с помощью линейного логического оператора. Описан метод построения

направленных схем реляционной сети.

Ключевые слова: теория интеллекта, алгебра предикатов, нейронные

сети, реляционные сети, линейный логический оператор

Введение

В естественном интеллекте выделяют уровни подсознания, сознания,

логического мышления, алгоритмической деятельности. Логично было бы

предположить, что и моделировать функции различных уровней интеллекта следует различными методами. Однако в настоящее время все эти

функции пытаются моделировать, используя алгоритмический подход,

который реализуется на универсальных компьютерах последовательного

действия. Так, например, задачи распознавания образов на протяжении

многих лет безуспешно пытаются решать, используя алгоритмический

метод, реализуемый на компьютерах фон-неймановского типа. В то же

время эти задачи естественный интеллект решает в автоматическом режиме на уровне подсознания.

Наш интеллект представляет собой естественную нейронную сеть

огромной сложности. Обработка данных в этой сети осуществляется параллельно. Память человека является ассоциативной и работает совсем не

так как память компьютера. Поэтому функции интеллекта, которые реализуются на уровне подсознания, было бы целесообразно моделировать с

помощью искусственных нейронных сетей. Ассоциативную память также

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

можно строить с использованием ИНС. При создании ИНС вначале создается структура, а затем ее обучают воспроизводить те или иные функции

интеллекта. Такой подход к созданию интеллектуальных систем называют

структурно-функциональным [1].

Альтернативой этому методу может служить функциональноструктурный подход. При использовании этого подхода моделируемая

функция интеллекта вначале описывается системой логических уравнений, записанных на языке алгебры предикатов [2-6], а затем каждому

уравнению ставится в соответствие алгебропредикатная структура, реализующая аппаратно данное уравнение. Таким образом, получают структуру, моделирующую соответствующую функцию интеллекта. Используя

этот способ, можно воспроизводить такие функции интеллекта, как понимание текстов естественного языка, хранение и обработка знаний, логическое мышление. Функции интеллекта, связанные с реализацией алгоритмической деятельности человека можно возложить на универсальный

компьютер последовательного действия. Следовательно, интеллектуальную систему можно представить в виде комплекса технических средств,

состоящего из ИНС, моделирующих деятельность подсознания, алгебропредикатных структур, моделирующих логическое мышление, а также

способность владеть языком и обрабатывать знания. Управление этими

устройствами и решение задач алгоритмического характера может взять

на себя универсальный компьютер фон неймановского типа.

Постановка задачи и описание моделирования реляционной сети

В данной работе ставится задача создания моделей направленных реляционных сетей, которые могут быть использованы для представления

знаний в интеллектуальных системах параллельного действия. В рамках

теории интеллекта [2-5] в процессе развития алгебры логики и многозначной логики была разработана алгебра предикатов. Последние разработки в области теории интеллекта связаны с моделированием реляционных сетей [7]. Одним из важных отношений, используемых при описании

интеллектуальных процессов в рамках теории интеллекта, является отношение импликации. Логическая функция импликации задается уравнением

z = x y,

(1)

где x, y и z – это логические переменные, x, y, z = {0, 1}. Функция импликации может быть представлена следующей формулой:

z = x y = x y,

(2)

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

Построим реляционную сеть на основе уравнения (2). Метод построения реляционных сетей изложен в [8]. Построение реляционных сетей

состоит из нескольких этапов. На первом этапе выявляют предметные

переменные x1, x2,…, xn моделируемого объекта и отношения заданные на

множествах их значений. Значения функции импликации можно представить в виде отношения Р, заданного таблицей истинности (табл. 1).

На втором этапе осуществляют запись выявТаблица 1. Отношеленных отношений на языке алгебры предикание

тов. В результате получается предикат, соответимпликации

ствующий отношению Р, которое представляет

собой множество всех наборов предметов

х

у

z

x1, x2,…, xn,

удовлетворяющих

уравнению

0

0

1

Р(x1, x2,…, xn) = 1. Предикат Р(x, y, z) соответ0

1

1

ствующий отношению импликации Р = {(0, 0, 1),

1

0

0

(0, 1, 1), (1, 0, 0), (1, 1, 1)} на языке алгебры пре1

1

1

дикатов записывается в виде следующего предиката:

Р(x, y, z) = x0y0z1 x0y1z1 x1y0z0 x1y1z1.

Затем производят бинарную декомпозицию предиката Р(x, y, z) с помощью дополнительной переменной t {0,1, 2, 3}. В результате получаем

полную (развернутую) бинаризацию предиката Р(x, y, z):

R(x, y, z, t) = x0y0z1t0 x0y1z1t1 x1y0z0t2 x1y1z1t3.

(3)

Предикату (3) соответствует отношение R, которое можно представить в

виде табл. 2.

Если применить квантор существования по

Таблица 2. Отношение

переменной t, то из предиката R(x, y, z, t) мы

R

вновь получим исходный предикат Р(x, y, z)

х

у

z

t

t R(x, y, z, t) = x0y0z1 x0y1z1 x1y0z0 x1y1z1.

Исключая с помощью кванторов суще0

0

1

0

ствования последовательно по одной пере0

1

1

1

менной, сформируем бинарные предикаты:

1

0

0

2

Р1(x, t) = x0t0 x0t1 x1t2 x1t3 = x0(t0 t1) x1(t2

1

1

1

3

t3),

Р2(у, t) = у0t0 у1t1 у0t2 у1t3 = у0(t0 t2) у1(t1 t3),

Р3(z, t) = z1t0 z1t1 z0t2 z1t3 = z1(t0 t1 t3) z0t2.

Бинарные отношения Р1, Р2, Р3, соответствующие предикатам Р1(x, t),

Р2(у, t), Р3(z, t) представлены в табл. 3.

Таким образом, построена математическая модель решения исходного

булевого уравнения (1). Она представляет собой систему бинарных отно-

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

шений Р1, Р2, Р3, которые задаются соответствующими предикатами Р1(x,

t), Р2(у, t), Р3(z, t) и двудольными графами (рис. 1).

Таблица 3. Отношения Р1, Р2, Р4

Р1

х

0

0

1

1

x

Р2

у

0

1

0

1

t

0

1

2

3

t

y

0

0

1

1

2

0

1

3

Р3

t

0

1

2

3

t

z

1

1

0

1

t

0

1

2

3

z

t

0

1

2

0

1

3

0

1

2

3

Рис. 1. Двудольные графы бинарных отношений реляционной сети

Если образовать конъюнкция этих предикатов, то получим предикат

модели (3)

R(x, y, z, t) = Р1(x, t)Р2(у, t)Р3(z, t) = x0y0z1t0 x0y1z1t1 x1y0z0t2 x1y1z1t3.

Рис. 2. Реляционная сеть

для вычисления импликации

Графическое изображение результата бинарной декомпозиции

предиката Р(x, y, z) представляет собой реляционную сеть, которая показана на рис. 2.

На схеме реляционной сети показаны переменные x, y, z, t (x, y, z =

={0, 1}, t T = {0, 1, 2, 3}) и связывающие их отношения Р1, Р2, Р3.

Наборы (x, ), (у, ), (z, ), (t, T), состоящие из переменных и множеств, на которых они заданы, рассматриваются как полюсы сети, а отношения Р1, Р2, Р3 – как ветви сети, соединяющие полюсы сети.

Тестирование модели реляционной сети

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

Функция z = x у вычисляется однозначно по набору значений переменных (x, у). Рассмотрим работу сети для всех наборов значений переменных x, у по тактам [9].

1. x = 0, у = 0. Аналитически связь между переменными сети запишется так: x0y0z1 = t0. На первом шаге заданные значения переменных x, у порождают соответствующие им множества значений переменной t – {0, 1}

и {0, 2} (рис. 3). На втором шаге вычисляется пересечение этих множеств

{0, 1}{0, 2} = {0}. В результате получаем значение дополнительной переменной t = 0. Из отношения Р3 получаем значение переменной z = 1 (см.

рис. 3). Результат работы реляционной сети на наборе x = 0, у = 0 представлен на рис. 3.

Рис. 3. Результат работы реляционной сети на наборе x = 0, у = 0

Аналогично получают результаты работы реляционной сети на наборах x = 0, у = 1; x = 1, у = 0; x = 1, у = 1.

Рассмотрим вычисление функции импликации в обратном направлении от значений переменной z к значениям переменным x, у. Для того

чтобы по значению переменной z определить значения переменных x, у,

необходимо уточнить значение промежуточной переменной t.

1. z = 0. Аналитическая связь между переменными сети: z0 = x1y0t2. На

первом шаге заданное значение переменной z порождает множество значений промежуточной переменной t – {2}. На втором шаге по значению

промежуточной переменной t = 2 однозначно определяем значения переменных x = 1 у = 0 из отношений P1 и P2 соответственно.

Результат работы реляционной сети для значения переменной z = 0

представлен на рис. 4.

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

Рис. 4. Результат работы реляционной сети на наборе x = 1, у = 0

Аналогично получают результат работы реляционной сети для значения переменной z = 1. На этом анализ работы реляционной сети в прямом

и обратном направлениях можно считать завершенным.

Обработка знаний в ветвях реляционной сети осуществляется линейными логическими операторами. Каждая ветвь реляционной сети представляет собой двунаправленную дугу, которая описывается парой линейных логических операторов. С теоретической точки зрения реляционная

сеть может рассматриваться как система взаимодействующих линейных

логических операторов. Вопросам разработки теории линейных логических операторов посвящены работы [10, 11]. Линейными логическими

операторами L(A) = B и L(B) = A с ядром F(x, y) называют преобразования

B(y) = xМ(F(x, y) A(х)),

(4)

A(х) = yN(F(x, y) B(y)).

(5)

Преобразование вида (4) – это образ множества AМ относительно некоторого отображения f(x) = y, т.е. множество BN, образованное из всех

образов предметов, принадлежащих множеству A. Преобразование вида

(5) представляет собой прообраз множества BN относительно некоторого отображения f(x) = y т.е. множество AМ, образованное из всех прообразов предметов, принадлежащих множеству B.

Для того чтобы построенная модель реляционной сети функционировала так, чтобы из нее можно было извлекать некоторые знания, необходимо решать систему предикатных уравнений

P1 ( x, t ) 1,

P2 ( y, t ) 1,

P ( z, t ) 1.

3

Рассмотрим пример функционирования модели реляционной сети для

дуги, которая описывается предикатом P1(x, t) = x0t0 x0t1 x1t2 x1t3. Решим предикатное уравнение

P1(x, t) = 1.

(6)

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

Решение этого предикатного уравнения можно свести к нахождению

образа или прообраза некоторого множества

относительно отображения f(x) = t (рис. 5).

Рассмотрим примеры решения предикатного

уравнения (6).

1. Дано x = 1. Найти все возможные значения

переменной t. Это значит, что необходимо найти

Рис. 5. Отображение образ одноэлементного множества A = {1} отноf(x) = t

сительно отображения f(x) = t (рис. 6):

B={2, 3}.

A = {1}

f

Если использовать формулу (4),

то получим следующий результат:

B(t) = x{1}(F(x, t) A(х)) =

= F(1, t) A(1) = F(1, t)1 =

=10t010t111t211t3 = t2t3.

Рис. 6. Образ множества

f

A = {1}

B={2, 3}

2. Решим теперь обратную задачу. Дано t = 3. Найти всевозможные

значения переменной x. Это значит, что для решения этой задачи необходимо найти прообраз одноэлементного множества В = {3} относительно

отображения f(x) = t (рис. 7):

A = {1}.

B={3}

Подставляя в формулу (5) значение переменной t = 3, получим следующий результат:

A(х)=t{3}(F(x, t)B(t))=F(x, 3) B(3)=

= F(x, 3)1=x 0t0x031x132x133 = x1.

Аналогичным способом можно отыскать

остальные образы и прообразы подмножеств

A и B множеств М и N.

f

Рис. 7. Прообраз множества

f

B = {3}

A = {1}

Построение направленных схем реляционной сети

Запишем связь переменных x y и t в виде следующих предикатных

уравнений:

x0y0 = t0, x0y1 = t1, x1y0 = t2, x1y1 = t3.

Построим на основе этих уравнений прямую направленную схему связей

переменных x, y и t (рис. 8).

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

x

0

1

y

0

1

0

1

t

2

3

Рис. 8. Направленная схема связей переменных x, y и t (прямая)

Обратная связь переменных t и x, y может быть записана в виде следующих предикатных уравнений:

t0 t1 = x0, t2 t3 = x1, t0 t2 =y0, t1 t3 = y1.

На основе этих уравнений можно построить обратную направленную

схему связей переменных t и x, y (рис. 9).

0

t 1

2

3

0

1

x

0

1

y

Рис. 9. Направленная схема связей переменных t и x, y (обратная)

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

Прямая связь между предметной переменной z и дополнительной переменной t записывается с помощью следующих предикатных уравнений:

z1 = t0, z1 = t1, z0 = t2, z1 = t3.

На основе этих уравнений построим

Рис. 10. Направленная схема прямую направленную схему связей песвязей переменных z и t

ременной z и дополнительной перемен(прямая)

ной t (рис. 10).

Обратная связь между дополнительной переменной t и предметной переменной z может быть представлена следующими предикатными уравнениями:

t0 t1 t3= z1, t2 = z0.

На основе этих уравнений строим обратную направленную схему связей переРис. 11. Направленная схема

менных t и z (рис. 11).

связей переменных t и z

Если объединить схемы, представ(обратная)

ленные на рис. 8 и 10, то получим

направленную схему реляционной сети (прямую) (рис. 12).

Аналогичным образом, объединив схемы, показанные на рис. 9 и 11,

получим направленную схему реляционной сети (обратную) (рис. 13).

0

1

0

1

0

1

2

3

x

y

t

0 z

1

Рис. 12. Направленная схема реляционной сети (прямая)

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

0 x

1

0 y

1

0

1

2

3

t

0 z

1

Рис. 13. Направленная схема реляционной сети (обратная)

Выводы

Построенные реляционные сети для операции импликации можно использовать при моделировании знаний для построения правил продукции

вида «если А, то В». Операция импликации используется для записи таких

правил продукции на языке алгебры предикатов. Направленные схемы

реляционной сети могут стать основой построения баз знаний, реализованных аппаратно в виде программируемой матрицы FPGA [12].

Список литературы

1. Булкин В.И. Шаронова Н.В. Математические модели знаний и их

реализация с помощью алгебропредикатных структур. Донецк: Изд.

Дмитренко Л.Р., 2010.

2. Бондаренко М. Ф., Шабанов-Кушнаренко Ю. П. Теория интеллекта.

Учебник. Харьков: СМИТ, 2006.

3. Шабанов-Кушнаренко Ю.П. Теория интеллекта. Математические

средства. Харьков: Вища шк., 1984.

4. Шабанов-Кушнаренко Ю.П. Теория интеллекта. Технические средства. Харьков: Вища шк., 1986.

5. Шабанов-Кушнаренко Ю.П. Теория интеллекта. Проблемы и перспективы. Харьков: Вища шк., 1987.

6. Бондаренко М.Ф., Шабанов-Кушнаренко Ю.П. Об алгебре предикатов// Бионика интеллекта. Харьков: ХНУРЭ, 2004. № 1(61). С.15-26.

7. Бондаренко М.Ф., Дударь З.В., Ефимова И.А., Лещинский В.А.,

Шабанов-Кушнаренко С.Ю. О мозгоподобных ЭВМ// Радиоэлектроника и

информатика. Харьков: ХНУРЭ, 2004. № 2. С.89–105.

ISBN 978-5-7262-1775-8 НЕЙРОИНФОРМАТИКА-2013. Часть 2

8. Ефимова И.А., Лещинский В.А. О методе построения моделей бинарных логических сетей// Восточно-Европейский журнал передовых

технологий. Харьков, 2005. № 4. С.121-124.

9. Лещинский В.А. Модели бинарных логических сетей и их применение в искусственном интеллекте: Дис. ... канд. техн. наук. Харьков,

2006.

10.Ротин И.М. Линейные и билинейные логические операторы и их

применение в автоматизированных информационных системах: Дис. …

канд. техн наук. Харьков, 1994.

11. Вечирская И.Д. Линейные логические преобразования и их применение в искусственном интеллекте: Дис. … канд. техн. наук. Харьков,

2007.

12. Bondarenko M.F., Hahanova I.V. Logic networks application for computing process organization// Радиоэлектроника и информатика. Харьков:

ХНУРЭ, 2003, № 3. С.150-156.